Einführung in Computational Intelligence und AI: Unterschied zwischen den Versionen

| Zeile 8: | Zeile 8: | ||

<div id="fig:Expert_System" class="figure"> | <div id="fig:Expert_System" class="figure"> | ||

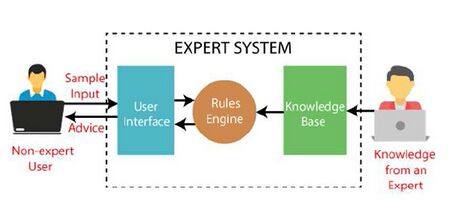

[[Datei:Expert_System.jpg|460px|thumb|center|Abbildung 1: Expertensystem (Quelle: [https://www.javatpoint.com/expert-systems-in-artificial-intelligence Expertensystem])]] | [[Datei:Expert_System.jpg|460px|thumb|center|Abbildung 1: Expertensystem (Quelle: [https://www.javatpoint.com/expert-systems-in-artificial-intelligence Expertensystem]).]] <span id="fig:Expert_System" label="fig:Expert_System"></span> | ||

</div> | </div> | ||

Mit der rasanten Entwicklung der Rechengeschwindigkeit und -fähigkeiten der Computer entstanden spätestens in den 1990er Jahren rechenintensive Zweige der KI. Computational Intelligence (CI) umfasst die biologisch motivierten Bereiche der Informationsverarbeitung, wie z.B. evolutionäre Algorithmen. | Mit der rasanten Entwicklung der Rechengeschwindigkeit und -fähigkeiten der Computer entstanden spätestens in den 1990er Jahren rechenintensive Zweige der KI. Computational Intelligence (CI) umfasst die biologisch motivierten Bereiche der Informationsverarbeitung, wie z.B. evolutionäre Algorithmen. | ||

| Zeile 17: | Zeile 20: | ||

<div id="fig:LVSRS" class="figure"> | <div id="fig:LVSRS" class="figure"> | ||

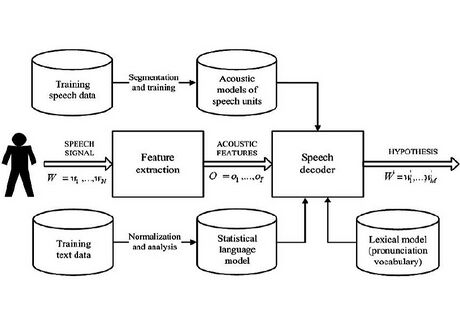

[[ | [[Datei:LVSRS.jpg|460px|thumb|center|Abbildung 2: Large Vocabulary Speech Recognition System - Architektur (Quelle: [https://www.researchgate.net/figure/Architecture-of-a-state-of-the-art-automatic-speech-recognition-system-and-its-components_fig1_259118437 LVSRS]).]] <span id="fig:LVSRS" label="fig:LVSRS"></span> | ||

</div> | </div> | ||

Mittlerweile führte die Entwicklung von Ideen zur Wissensdarstellung zu fortgeschritteneren Ansätzen wie Ontologie oder Wissensgraphen, WG (Knowledge Graph - KG). | Mittlerweile führte die Entwicklung von Ideen zur Wissensdarstellung zu fortgeschritteneren Ansätzen wie Ontologie oder Wissensgraphen, WG (Knowledge Graph - KG). | ||

| Zeile 26: | Zeile 32: | ||

<div id="fig:AI_subsets" class="figure"> | <div id="fig:AI_subsets" class="figure"> | ||

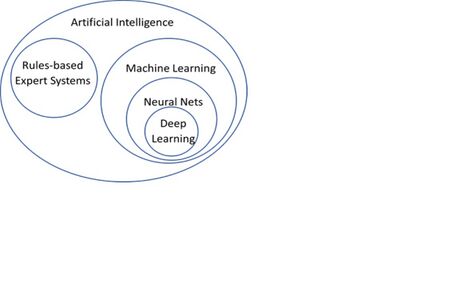

[[ | [[Datei:AI_subsets.jpg|460px|thumb|center|Abbildung 3: Funktionale Teilmengen der KI und ihre Beziehung zueinander (Quelle: [https://1spatial.com/news-events/2021/why-a-rules-based-plus-a-machine-learning-hybrid-approach/ Teilmengen der KI]). | ||

]] <span id="fig:AI_subsets" label="fig:AI_subsets"></span> | |||

</div> | </div> | ||

Die jüngste Entwicklung im Bereich der KI ist die Anwendung spezifischer großer Sprachmodelle (Large Language Model) und fortschrittlicher Techniken wie beispielweise generatives Transformer (generative transformer), die zu Produkten führen, wie z. B. ChatGPT 3.5. | Die jüngste Entwicklung im Bereich der KI ist die Anwendung spezifischer großer Sprachmodelle (Large Language Model) und fortschrittlicher Techniken wie beispielweise generatives Transformer (generative transformer), die zu Produkten führen, wie z. B. ChatGPT 3.5. | ||

| Zeile 91: | Zeile 100: | ||

Die Auswirkung der jüngsten Entwicklung von NN auf andere KI-Konzepte führte zu modernen KI-Modellkombinationen. Die beiden wichtigsten sind vielleicht die neuronale Sprachmodellierung und das große Sprachmodelle. | Die Auswirkung der jüngsten Entwicklung von NN auf andere KI-Konzepte führte zu modernen KI-Modellkombinationen. Die beiden wichtigsten sind vielleicht die neuronale Sprachmodellierung und das große Sprachmodelle. | ||

Neuronale Sprachmodelle (Neural LM - NLM) sind Sprachmodelle, die auf rekurrentes NN basieren. Sie werden auch als kontinuierlicher Raum-Sprachmodelle (continuous space LMs) bezeichnet. Sie transformieren die Sprachmodell Darstellung von Wörtern durch Einbettung in einen kontinuierlichen niedrigdimensionalen Vektorraum, den sogenannten Embedding Space. Dies hat den Vorteil, dass die semantisch ähnlichen Einheiten im Einbettungsraum näher beieinander liegen. Solche Einheiten können Korpusteile, Sätze, Wortteile oder Zeichen sein. Durch dieser Beziehungen können Sollche Sprachmodelle die unsichtbaren Grams gut abschätzen und daher mit dem Problem von unsichtbaren Grams von SLMs gut umgehen. Darüber hinaus stellen NLMs die Wörter als nichtlineare Kombinationen von Gewichten in einem neuronalen Netz dar [ | Neuronale Sprachmodelle (Neural LM - NLM) sind Sprachmodelle, die auf rekurrentes NN basieren. Sie werden auch als kontinuierlicher Raum-Sprachmodelle (continuous space LMs) bezeichnet. Sie transformieren die Sprachmodell Darstellung von Wörtern durch Einbettung in einen kontinuierlichen niedrigdimensionalen Vektorraum, den sogenannten Embedding Space. Dies hat den Vorteil, dass die semantisch ähnlichen Einheiten im Einbettungsraum näher beieinander liegen. Solche Einheiten können Korpusteile, Sätze, Wortteile oder Zeichen sein. Durch dieser Beziehungen können Sollche Sprachmodelle die unsichtbaren Grams gut abschätzen und daher mit dem Problem von unsichtbaren Grams von SLMs gut umgehen. Darüber hinaus stellen NLMs die Wörter als nichtlineare Kombinationen von Gewichten in einem neuronalen Netz dar [Bengio(2008)]. Die NLMs können entweder als nicht-kontextuelle Einbettungen (Non-contextual Embeddings) oder als kontextuelle Einbettungen (Contextual Embeddings) kategorisiert werden. Nicht-kontextuelle Einbettungen wenden dieselben Einbettungen für eine bestimmte semantische Einheit an, unabhängig vom gegebenen Kontext. Beispiele für nicht-kontextuelle Einbettungen sind Word2Vec [Mikolov et al.(2013)] oder Wikipedia2Vec [Yamada et al.(2018)]. Im Gegensatz dazu können kontextuelle Einbettungen unterschiedliche Semantiken der semantischen Einheiten in unterschiedlichen Kontexten darstellen. Beispiele für kontextuelle Einbettungen sind die von Google [Devlin et al.(2019)] eingeführten BERT (Bidirectional Encoder Representations from Transformers) oder Sentence-BERT (SBERT), eine verfeinerte Version von BERT. Das Transformer (transformer model) ist eine spezifische NN-Architektur, die von Vaswani et al. eingeführt wurde [Vaswani et al.(2017)]. | ||

Große Sprachmodelle (Large Language Models - LLM) sind Transformers-basierte LMs, die durch selbstüberwachtes Lernen vorab trainiert werden. LLMs lernen Milliarden von Parametern während des Trainings und benötigen große Rechenressourcen sowohl für das Training als auch während des Betriebs. Sie scheinen ein allgemeines Sprachverständnis erreichen zu können und können Antworten in Form von menschenähnlichem Text generieren. Diese LLMs werden in generativen KI-Systemen eingesetzt. Aktuelle Versionen können bestimmte Aufgaben mittels Promt Engineering erledigen. Promt Engineering ermöglicht eine Gestaltung von Eingaben für das System mittels Eingabeaufforderungen (promts), die vom LLM interpretiert werden können, und dadurch wird das Aufmerksamkeitsmechanismus des Modells auf das nähere Einschränken der Aufgabe gesteuert. Die bekanntesten Beispiele sind das GPT-3.5- und GPT-4-Modell von Open AI (verwendet in ChatGPT) und Googles PaLM (verwendet in Bard). | Große Sprachmodelle (Large Language Models - LLM) sind Transformers-basierte LMs, die durch selbstüberwachtes Lernen vorab trainiert werden. LLMs lernen Milliarden von Parametern während des Trainings und benötigen große Rechenressourcen sowohl für das Training als auch während des Betriebs. Sie scheinen ein allgemeines Sprachverständnis erreichen zu können und können Antworten in Form von menschenähnlichem Text generieren. Diese LLMs werden in generativen KI-Systemen eingesetzt. Aktuelle Versionen können bestimmte Aufgaben mittels Promt Engineering erledigen. Promt Engineering ermöglicht eine Gestaltung von Eingaben für das System mittels Eingabeaufforderungen (promts), die vom LLM interpretiert werden können, und dadurch wird das Aufmerksamkeitsmechanismus des Modells auf das nähere Einschränken der Aufgabe gesteuert. Die bekanntesten Beispiele sind das GPT-3.5- und GPT-4-Modell von Open AI (verwendet in ChatGPT) und Googles PaLM (verwendet in Bard). | ||

| Zeile 137: | Zeile 146: | ||

\nabla_{{\bf w}} \left( \lVert {\bf X}{\bf w} - {\bf y} \rVert_2^2 \right) &= \nabla_{{\bf w}} \left({\bf X}{\bf w} - {\bf y} \right)^T \left({\bf X}{\bf w} - {\bf y} \right) \\ | \nabla_{{\bf w}} \left( \lVert {\bf X}{\bf w} - {\bf y} \rVert_2^2 \right) &= \nabla_{{\bf w}} \left({\bf X}{\bf w} - {\bf y} \right)^T \left({\bf X}{\bf w} - {\bf y} \right) \\ | ||

&= \nabla_{{\bf w}} \left( {\bf w}^T {\bf X}^T{\bf X}{\bf w} - 2 {\bf w}^T {\bf X}^T {\bf y} + {\bf y}^T {\bf y}\right) | &= \nabla_{{\bf w}} \left( {\bf w}^T {\bf X}^T{\bf X}{\bf w} - 2 {\bf w}^T {\bf X}^T {\bf y} + {\bf y}^T {\bf y}\right) | ||

= 2 {\bf X}^T{\bf X}{\bf w} - 2 {\bf X}^T {\bf y} = 0, | = 2 {\bf X}^T{\bf X}{\bf w} - 2 {\bf X}^T {\bf y} = 0, | ||

\end{aligned}</math> | \end{aligned}</math> | ||

| Zeile 179: | Zeile 188: | ||

&= \arg \max_{\bf \hat{y}} \left(-K \log(\sigma) -\frac{K}{2} \log(2 \pi) - \sum_{k=1}^{K} \frac{(y_k-\hat{y_k})^2}{2\sigma^2} \right) \\ | &= \arg \max_{\bf \hat{y}} \left(-K \log(\sigma) -\frac{K}{2} \log(2 \pi) - \sum_{k=1}^{K} \frac{(y_k-\hat{y_k})^2}{2\sigma^2} \right) \\ | ||

&= \arg \max_{\bf \hat{y}} \left(-\sum_{k=1}^{K} (y_k-\hat{y_k})^2\right) | &= \arg \max_{\bf \hat{y}} \left(-\sum_{k=1}^{K} (y_k-\hat{y_k})^2\right) | ||

= \arg \min_{\bf \hat{y}} \sum_{k=1}^{K} (y_k-\hat{y_k})^2 = \arg \min_{\bf \hat{y}} \lVert {\bf \hat{y}} - {\bf y} \rVert_2^2 | = \arg \min_{\bf \hat{y}} \sum_{k=1}^{K} (y_k-\hat{y_k})^2 = \arg \min_{\bf \hat{y}} \lVert {\bf \hat{y}} - {\bf y} \rVert_2^2. | ||

\end{aligned}</math> | \end{aligned}</math> | ||

| Zeile 188: | Zeile 197: | ||

<span>''<math display="inline">\mathrm{\ \ \ \ \ \ }</math> Allgemeine Diskriminanzfunktionen''</span> | <span>''<math display="inline">\mathrm{\ \ \ \ \ \ }</math> Allgemeine Diskriminanzfunktionen''</span> | ||

Eine allgemeine Möglichkeit, einen Klassifikator (classifier) darzustellen, besteht darin, ihn durch eine Menge von Diskriminanzfunktionen (discriminant functions) <math display="inline">d_i({\bf x})</math> für <math display="inline">i=1,\ldots,C</math> anzugeben. Der Klassifikator entscheidet, die Klasse <math display="inline">c_i</math> dem Feature Vektoren <math display="inline">{\bf x}</math> als Eingabe zuzuweisen, wenn <math display="block">d_i({\bf x}) > d_j({\bf x}) \mathrm{ | Eine allgemeine Möglichkeit, einen Klassifikator (classifier) darzustellen, besteht darin, ihn durch eine Menge von Diskriminanzfunktionen (discriminant functions) <math display="inline">d_i({\bf x})</math> für <math display="inline">i=1,\ldots,C</math> anzugeben. Der Klassifikator entscheidet, die Klasse <math display="inline">c_i</math> dem Feature Vektoren <math display="inline">{\bf x}</math> als Eingabe zuzuweisen, wenn <math display="block">d_i({\bf x}) > d_j({\bf x}) \mathrm{fuer~alle~} j \neq i.</math> | ||

Also der Klassifikator entscheidet die Klasse mit dem höchsten Diskriminanzfunktionswert, was die Benennung Diskriminanzfunktion erklärt. Ein Beispiel für den Klassifikator ist der Klassifikator des minimalen Fehlerrates (minimum error-rate classifier). Sei <math display="inline">p(c_j|{\bf x})</math>, <math display="inline">j=1,\ldots,C</math> die Wahrscheinlichkeit der Klasse <math display="inline">c_j</math>, gegeben der Feature Vector <math display="inline">{\bf x}</math>. Dann die Klasse <math display="inline">c_i</math> mit der höchsten <math display="inline">p(c_i|{\bf x})</math> ist gleichzeitig auch die Klasse mit dem minimalen Fehlerrate <math display="inline">(1-p(c_i|{\bf x}))</math>. Daher kann die Diskriminanzfunktion für den Klassifikator des minimalen Fehlerrates durch <math display="block">d_i({\bf x}) = p(c_i|{\bf x})</math> angegeben werden. Dies kann weiter vereinfacht werden, indem verwendet wird, dass der Nenner von <math display="block">p(c_i|{\bf x})= \frac{p({\bf x}|c_i ) p(c_i)}{\sum_{j=1}^{C} p({\bf x}|c_j ) p(c_j) }</math> unabhängib von <math display="inline">i</math> ist, was zu einer alternativen Diskriminanzfunktion als <math display="block">d_i({\bf x}) = p({\bf x}|c_i ) p(c_i)</math> führt. Auf Diskriminanzfunktionen kann jede monotone Funktion angewendet werden, da sie die zur Maximalfunktion gehörende Klasse nicht verändert. Daher kann mit Hilfe der monotonen Funktion <math display="inline">\log()</math> as eine weitere Diskriminanzfunktion für den Klassifikator der minimalen Fehlerrate als <math display="block">d_i({\bf x}) = \log~ p({\bf x}|c_i ) + log p(c_i))</math> definiert werden. | Also der Klassifikator entscheidet die Klasse mit dem höchsten Diskriminanzfunktionswert, was die Benennung Diskriminanzfunktion erklärt. Ein Beispiel für den Klassifikator ist der Klassifikator des minimalen Fehlerrates (minimum error-rate classifier). Sei <math display="inline">p(c_j|{\bf x})</math>, <math display="inline">j=1,\ldots,C</math> die Wahrscheinlichkeit der Klasse <math display="inline">c_j</math>, gegeben der Feature Vector <math display="inline">{\bf x}</math>. Dann die Klasse <math display="inline">c_i</math> mit der höchsten <math display="inline">p(c_i|{\bf x})</math> ist gleichzeitig auch die Klasse mit dem minimalen Fehlerrate <math display="inline">(1-p(c_i|{\bf x}))</math>. Daher kann die Diskriminanzfunktion für den Klassifikator des minimalen Fehlerrates durch <math display="block">d_i({\bf x}) = p(c_i|{\bf x})</math> angegeben werden. Dies kann weiter vereinfacht werden, indem verwendet wird, dass der Nenner von <math display="block">p(c_i|{\bf x})= \frac{p({\bf x}|c_i ) p(c_i)}{\sum_{j=1}^{C} p({\bf x}|c_j ) p(c_j) }</math> unabhängib von <math display="inline">i</math> ist, was zu einer alternativen Diskriminanzfunktion als <math display="block">d_i({\bf x}) = p({\bf x}|c_i ) p(c_i)</math> führt. Auf Diskriminanzfunktionen kann jede monotone Funktion angewendet werden, da sie die zur Maximalfunktion gehörende Klasse nicht verändert. Daher kann mit Hilfe der monotonen Funktion <math display="inline">\log()</math> as eine weitere Diskriminanzfunktion für den Klassifikator der minimalen Fehlerrate als <math display="block">d_i({\bf x}) = \log~ p({\bf x}|c_i ) + log p(c_i))</math> definiert werden. | ||

| Zeile 224: | Zeile 233: | ||

<div id="fig:LinDiscrFuncHyperProp" class="figure"> | <div id="fig:LinDiscrFuncHyperProp" class="figure"> | ||

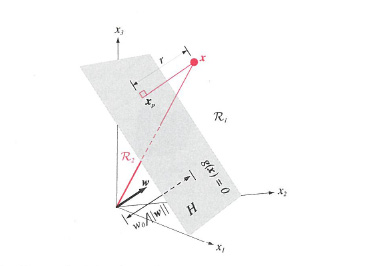

[[ | [[Datei:LinDiscrFuncHyperProp.jpg|460px|thumb|center|Abbildung 4: Lineare Entscheidungsgrenze und ihre Eigenschaften. (In der Abbildung wird die Diskriminanzfunktion mit <math display="inline">g({\bf x})</math> statt <math display="inline">d({\bf x})</math> kennengezeichnet.) (Quelle: [Duda et al.(2001)]).]] <span id="fig:LinDiscrFuncHyperProp" label="fig:LinDiscrFuncHyperProp"></span> | ||

</div> | </div> | ||

Wenn wir <math display="inline">0 = d({\bf x}_p) = {\bf w}^T {\bf x}_p + w_0</math>, für <math display="inline">d({\bf x})</math> verwenden, erhalten wir | Wenn wir <math display="inline">0 = d({\bf x}_p) = {\bf w}^T {\bf x}_p + w_0</math>, für <math display="inline">d({\bf x})</math> verwenden, erhalten wir | ||

| Zeile 243: | Zeile 255: | ||

Die Entscheidungsregel ist dieselbe wie für die allgemeinen Diskriminanzfunktionen: | Die Entscheidungsregel ist dieselbe wie für die allgemeinen Diskriminanzfunktionen: | ||

<math display="block">\mathrm{~Entscheide~} c_i \mathrm{~wenn~} d_i({\bf x}) > d_j({\bf x}) \mathrm{~ | <math display="block">\mathrm{~Entscheide~} c_i \mathrm{~wenn~} d_i({\bf x}) > d_j({\bf x}) \mathrm{~fuer~alle~} j \neq i.</math> | ||

Wenn die Werte zweier oder mehrerer Diskriminanzfunktionen für ein bestimmtes <math display="inline">{\bf x}</math> gleich sind, was (wie in der Statistik) Bindungen genannt wird, ist die Entscheidung undefiniert. Der Klassifikator mit linearen Diskriminanzfunktionen <math display="inline">C</math> wird auch als lineare Maschine (linear machine) bezeichnet. Es unterteilt den d-dimensionalen Feature Space in <math display="inline">C</math> disjunkte Entscheidungsregionen. Für die Grenze zwischen zwei benachbarten Entscheidungsregionen <math display="inline">{\mathcal{R}_i}</math> und <math display="inline">{\mathcal{R}_j}</math> gilt <math display="inline">d_i({\bf x}) = d_j({\bf x})</math>, oder gleichwertig | Wenn die Werte zweier oder mehrerer Diskriminanzfunktionen für ein bestimmtes <math display="inline">{\bf x}</math> gleich sind, was (wie in der Statistik) Bindungen genannt wird, ist die Entscheidung undefiniert. Der Klassifikator mit linearen Diskriminanzfunktionen <math display="inline">C</math> wird auch als lineare Maschine (linear machine) bezeichnet. Es unterteilt den d-dimensionalen Feature Space in <math display="inline">C</math> disjunkte Entscheidungsregionen. Für die Grenze zwischen zwei benachbarten Entscheidungsregionen <math display="inline">{\mathcal{R}_i}</math> und <math display="inline">{\mathcal{R}_j}</math> gilt <math display="inline">d_i({\bf x}) = d_j({\bf x})</math>, oder gleichwertig | ||

| Zeile 300: | Zeile 312: | ||

ausgedrückt werden, wobei wir in der ersten Gleichung den Multiplikationssatz der Wahrscheinlichkeit (multiplication theorem of probability) und in der zweiten Gleichung die Markov-Eigenschaft (Markov property) verwendet haben. | ausgedrückt werden, wobei wir in der ersten Gleichung den Multiplikationssatz der Wahrscheinlichkeit (multiplication theorem of probability) und in der zweiten Gleichung die Markov-Eigenschaft (Markov property) verwendet haben. | ||

Dies kann durch die Einführung einer Indikatorvariablen wie <math display="block">\log~ p(\overrightarrow{\bf z})=\sum_{i=1}^{|\mathcal{S}|}\sum_{j=1}^{|\mathcal{S}|}\sum_{t=1}^{T} \ | Dies kann durch die Einführung einer Indikatorvariablen wie <math display="block">\log~ p(\overrightarrow{\bf z})=\sum_{i=1}^{|\mathcal{S}|}\sum_{j=1}^{|\mathcal{S}|}\sum_{t=1}^{T} \mathbf{1}_{\{z_{t-1} = s_i, z_{t} = s_j\} } \log~ {\bf A}_{i,j} + \log~ p(z_0)</math> | ||

weiter umgestaltet werden. Das Weglassen des Terms <math display="inline">\log~ p(z_0)</math> hat keinen Einfluss auf den Ort des Maximums der Log-Likelihood, da dieser nicht von der Matrix <math display="inline">{\bf A}</math> abhängt. Darüber hinaus müssen bei der Optimierung einige Einschränkungen der Matrix <math display="inline">{\bf A}</math> berücksichtigt werden. Die Matrix <math display="inline">{\bf A}</math> ist stochastisch und daher | weiter umgestaltet werden. Das Weglassen des Terms <math display="inline">\log~ p(z_0)</math> hat keinen Einfluss auf den Ort des Maximums der Log-Likelihood, da dieser nicht von der Matrix <math display="inline">{\bf A}</math> abhängt. Darüber hinaus müssen bei der Optimierung einige Einschränkungen der Matrix <math display="inline">{\bf A}</math> berücksichtigt werden. Die Matrix <math display="inline">{\bf A}</math> ist stochastisch und daher | ||

| Zeile 310: | Zeile 322: | ||

<math display="block">\begin{aligned} | <math display="block">\begin{aligned} | ||

&\arg\max_{{\bf A}} \sum_{i=1}^{|\mathcal{S}|}\sum_{j=1}^{|\mathcal{S}|}\sum_{t=1}^{T} \ | &\arg\max_{{\bf A}} \sum_{i=1}^{|\mathcal{S}|}\sum_{j=1}^{|\mathcal{S}|}\sum_{t=1}^{T} \mathbf{1}_{\{z_{t-1} = s_i, z_{t} = s_j\}} \log~ {\bf A}_{i,j}, ~ \\ | ||

&\mathrm{~mit~Nebenbedingungen~}~\sum_{j=1}^{|\mathcal{S}|} {\bf A}_{i,j} = 1, \mathrm{~ | &\mathrm{~mit~Nebenbedingungen~}~\sum_{j=1}^{|\mathcal{S}|} {\bf A}_{i,j} = 1, \mathrm{~fuer~} i = 1, \ldots, |\mathcal{S}| | ||

\end{aligned}</math> formuliert werden. | \end{aligned}</math> formuliert werden. | ||

| Zeile 318: | Zeile 330: | ||

Die Anwendung des Verfahrens der Lagrange-Multiplikatoren erfordert die Einführung von <math display="inline">|S|</math>-fachen Lagrange-Multiplikatoren (Lagrange multipliers), <math display="inline">\alpha_i</math> für <math display="inline">i = 1, \ldots, |\mathcal{S}|</math>, die in einem Vektor <math display="inline">{\boldsymbol{\alpha}}</math> angeordnet werden können. Somit kann die Lagrange-Funktion (Lagrange function) als | Die Anwendung des Verfahrens der Lagrange-Multiplikatoren erfordert die Einführung von <math display="inline">|S|</math>-fachen Lagrange-Multiplikatoren (Lagrange multipliers), <math display="inline">\alpha_i</math> für <math display="inline">i = 1, \ldots, |\mathcal{S}|</math>, die in einem Vektor <math display="inline">{\boldsymbol{\alpha}}</math> angeordnet werden können. Somit kann die Lagrange-Funktion (Lagrange function) als | ||

<math display="block">\mathcal{L}({\bf A}, {\boldsymbol{\alpha}}) = \sum_{i=1}^{|\mathcal{S}|}\sum_{j=1}^{|\mathcal{S}|}\sum_{t=1}^{T} \ | <math display="block">\mathcal{L}({\bf A}, {\boldsymbol{\alpha}}) = \sum_{i=1}^{|\mathcal{S}|}\sum_{j=1}^{|\mathcal{S}|}\sum_{t=1}^{T} \mathbf{1}_{\{z_{t-1} = s_i, z_{t} = s_j\}} \log~{\bf A}_{i,j} + \sum_{i=1}^{|\mathcal{S}|} \alpha_i \left(1 - \sum_{j=1}^{|\mathcal{S}|} {\bf A}_{i,j} \right)</math> angegeben werden. | ||

Wenn man die erste Ableitung der Lagrange-Funktion nach <math display="inline">{\bf A}_{i,j}</math> nimmt und gleich 0 macht, erhält man | Wenn man die erste Ableitung der Lagrange-Funktion nach <math display="inline">{\bf A}_{i,j}</math> nimmt und gleich 0 macht, erhält man | ||

<math display="block">\frac{\partial \mathcal{L}}{\partial {\bf A}_{i,j}} = \frac{1}{{\bf A}_{i,j}}\sum_{t=1}^{T} \ | <math display="block">\frac{\partial \mathcal{L}}{\partial {\bf A}_{i,j}} = \frac{1}{{\bf A}_{i,j}}\sum_{t=1}^{T} \mathbf{1}_{\{z_{t-1} = s_i, z_{t} = s_j\}} - \alpha_i = 0, ~ i,j = 1, \ldots, |\mathcal{S}|,</math> woraus <math display="inline">{\bf A}_{i,j}</math> als <math display="block">{\bf A}_{i,j} = \frac{1}{\alpha_i}\sum_{t=1}^{T} \mathbf{1}_{\{z_{t-1} = s_i, z_{t} = s_j\}}, ~ i,j = 1, \ldots, |\mathcal{S}|</math> | ||

ausgedrückt werden kann. Nimmt man nun die erste Ableitung der Lagrange-Funktion nach <math display="inline">\alpha_i</math>, macht sie gleich 0 und wendet die obige Formel <math display="inline">{\bf A}_{i,j}</math> an, erhält man <math display="block">\frac{\partial \mathcal{L}}{\partial \alpha_i} = 1 - \sum_{j=1}^{|\mathcal{S}|} {\bf A}_{i,j} = 1 - \sum_{j=1}^{|\mathcal{S}|} \frac{1}{\alpha_i}\sum_{t=1}^{T} \ | ausgedrückt werden kann. Nimmt man nun die erste Ableitung der Lagrange-Funktion nach <math display="inline">\alpha_i</math>, macht sie gleich 0 und wendet die obige Formel <math display="inline">{\bf A}_{i,j}</math> an, erhält man <math display="block">\frac{\partial \mathcal{L}}{\partial \alpha_i} = 1 - \sum_{j=1}^{|\mathcal{S}|} {\bf A}_{i,j} = 1 - \sum_{j=1}^{|\mathcal{S}|} \frac{1}{\alpha_i}\sum_{t=1}^{T} \mathbf{1}_{\{z_{t-1} = s_i, z_{t} = s_j\}} = 0,</math> woraus wir die Lösung für <math display="inline">\alpha_i</math> als <math display="block">\alpha_i = \sum_{j=1}^{|\mathcal{S}|} \sum_{t=1}^{T} \mathbf{1}_{\{z_{t-1} = s_i, z_{t} = s_j\}} = \sum_{t=1}^{T} \mathbf{1}_{\{z_{t-1} = s_i\}}, ~ i = 1, \ldots, |\mathcal{S}|</math> | ||

erhalten. Wenn wir die Formel von <math display="inline">\alpha_i</math> in der Formel von <math display="inline">{\bf A}_{i,j}</math> anwenden, erhalten wir die Schätzung für <math display="inline">{\bf A}_{i,j}</math> als <math display="block">{\bf A}_{i,j} = \frac{\sum_{t=1}^{T} \ | erhalten. Wenn wir die Formel von <math display="inline">\alpha_i</math> in der Formel von <math display="inline">{\bf A}_{i,j}</math> anwenden, erhalten wir die Schätzung für <math display="inline">{\bf A}_{i,j}</math> als <math display="block">{\bf A}_{i,j} = \frac{\sum_{t=1}^{T} \mathbf{1}_{\{z_{t-1} = s_i, z_{t} = s_j\}}}{\sum_{t=1}^{T} \mathbf{1}_{\{z_{t-1} = s_i\}}} ~ i,j = 1, \ldots, |\mathcal{S}|.</math> | ||

Diese Schätzung von <math display="inline">{\bf A}_{i,j}</math> kann als die Anzahl der Übergange <math display="inline">s_i \rightarrow s_j</math> geteilt durch die Anzahl der der Beobachtungen, die die DTMC im Zustand <math display="inline">s_i</math> finden, interpretiert werden. Diese Schätzung passt auch zur unserer menschlichen Intuition. | Diese Schätzung von <math display="inline">{\bf A}_{i,j}</math> kann als die Anzahl der Übergange <math display="inline">s_i \rightarrow s_j</math> geteilt durch die Anzahl der der Beobachtungen, die die DTMC im Zustand <math display="inline">s_i</math> finden, interpretiert werden. Diese Schätzung passt auch zur unserer menschlichen Intuition. | ||

| Zeile 347: | Zeile 359: | ||

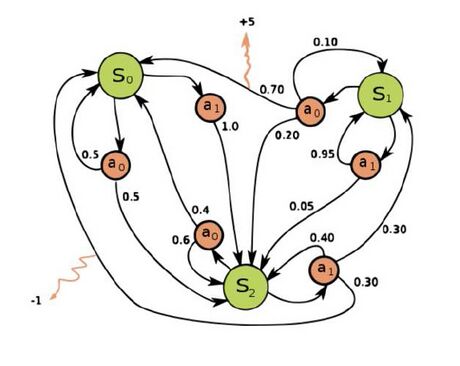

<div id="fig:MDP_example" class="figure"> | <div id="fig:MDP_example" class="figure"> | ||

[[ | [[Datei:MDP_example.jpg|460px|thumb|center|Abbildung 5: Beispieldiagramm eines MDPs (Quelle: [https://en.wikipedia.org/wiki/Markov_decision_process MDP_Beispiel]).]] <span id="fig:MDP_example" label="fig:MDP_example"></span> | ||

</div> | </div> | ||

MDP ist eine Erweiterung des DTMC, indem ihm Aktionen (die Auswahlmöglichkeiten ermöglichen) und Belohnungen (Feedback aus der Umgebung zum Lernen Lernzwecken) hinzugefügt werden. Dies impliziert, dass ein MDP mit nur einer Aktion und einer gemeinsamen Belohnung auf einen DTMC reduziert wird. MDP kann zur Lösung von Optimierungsaufgaben eingesetzt werden und wird üblicherweise durch dynamische Programmierung (dynamic programming) umgesetzt. | MDP ist eine Erweiterung des DTMC, indem ihm Aktionen (die Auswahlmöglichkeiten ermöglichen) und Belohnungen (Feedback aus der Umgebung zum Lernen Lernzwecken) hinzugefügt werden. Dies impliziert, dass ein MDP mit nur einer Aktion und einer gemeinsamen Belohnung auf einen DTMC reduziert wird. MDP kann zur Lösung von Optimierungsaufgaben eingesetzt werden und wird üblicherweise durch dynamische Programmierung (dynamic programming) umgesetzt. | ||

| Zeile 359: | Zeile 374: | ||

<span>'''''<math display="inline">\mathrm{\ \ \ \ }</math> Definition von CI'''''</span> | <span>'''''<math display="inline">\mathrm{\ \ \ \ }</math> Definition von CI'''''</span> | ||

Es gibt keine allgemein akzeptierte eindeutige Definition von CI. Die erste Definition stammt aus dem Jahr 1994 von Bezdek (siehe in ) und definiert CI durch die folgenden Merkmalen: | Es gibt keine allgemein akzeptierte eindeutige Definition von CI. Die erste Definition stammt aus dem Jahr 1994 von Bezdek (siehe in [Siddique et al.(2013)]) und definiert CI durch die folgenden Merkmalen: | ||

* befasst sich mit numerischen Daten, | * befasst sich mit numerischen Daten, | ||

| Zeile 394: | Zeile 409: | ||

<div id="fig:CI" class="figure"> | <div id="fig:CI" class="figure"> | ||

[[ | [[Datei:CI.jpg|460px|thumb|center|Abbildung 6: Computational Intelligence (Quelle: [https://botpenguin.com/glossary/computational-intelligence Computational_Intelligence]).]] <span id="fig:CI" label="fig:CI"></span> | ||

</div> | </div> | ||

<span>'''''<math display="inline">\mathrm{\ \ \ \ }</math> Evolutionäre Algorithmen (EA)'''''</span> | <span>'''''<math display="inline">\mathrm{\ \ \ \ }</math> Evolutionäre Algorithmen (EA)'''''</span> | ||

| Zeile 584: | Zeile 602: | ||

* AI Now Institute: Eine gemeinnützige Organisation an der New York University (https://ainowinstitute.org/), die sich mit der sozialen Auswirkungen der KI beschäftigt. | * AI Now Institute: Eine gemeinnützige Organisation an der New York University (https://ainowinstitute.org/), die sich mit der sozialen Auswirkungen der KI beschäftigt. | ||

Laut Luciano Floridi und Josh Cowls herrscht eine weitgehende Übereinstimmung darüber, dass es möglich ist, die ethischen Prinzipien für gesellschaftlich nützlichen Einsatz von KI basierend auf die vier Prinzipien der Medizinethik und ein zusätzliches fünftes Prinzip, Erklärbarkeit aufzubauen : | Laut Luciano Floridi und Josh Cowls herrscht eine weitgehende Übereinstimmung darüber, dass es möglich ist, die ethischen Prinzipien für gesellschaftlich nützlichen Einsatz von KI basierend auf die vier Prinzipien der Medizinethik und ein zusätzliches fünftes Prinzip, Erklärbarkeit aufzubauen [FloridiCowls(2019)]: | ||

,,1. Fürsorge (Benefizienz): KI-Technologie soll der Menschheit nützen, das Wohlergehen fördern, die Menschenwürde wahren und der Erhaltung des Planeten dienen.<br /> | ,,1. Fürsorge (Benefizienz): KI-Technologie soll der Menschheit nützen, das Wohlergehen fördern, die Menschenwürde wahren und der Erhaltung des Planeten dienen.<br /> | ||

Version vom 14. September 2024, 22:07 Uhr

Einführung in Computational Intelligence und AI

Die Idee hinter der künstlichen Intelligenz, KI (Artificial Intelligence - AI), bestand darin, die Prozesse der menschlichen Wahrnehmung wie Denken, Lernen oder Mustererkennung (pattern recognition) nachzubilden. Das Erscheinen der KI in der akademischen Welt begann mit der Simulation des Verhaltens neuronaler Netze bei IBM im Jahr 1955. Dies führte zu einer Konferenz zu diesem Thema, die heute als Dartmouth-Konferenz bekannt ist und als Geburtsstunde der künstlichen Intelligenz gilt.

Die Geschichte der KI als akademische Disziplin hat einen langen, weitreichenden und abenteuerlichen Weg zurückgelegt, der optimistische und zweifelhafte, verrufene Phasen durchquerte und durch viele wissenschaftliche Bereiche führte. Es begann mit dem Studium der ,,formalen“Argumentation, das unter anderem zu Alan Turings Berechnungstheorie oder zur Programmiersprache Lisp sowie zum kommerziellen Erfolg von Expertensystemen (Abbildung 1) in den frühen 1980er Jahren führte. Es folgte eine eher zweifelhafte Zeitraum, während andere Ansätze wuchsen, wie z.B. Bewegen von technischen Maschinen.

Mit der rasanten Entwicklung der Rechengeschwindigkeit und -fähigkeiten der Computer entstanden spätestens in den 1990er Jahren rechenintensive Zweige der KI. Computational Intelligence (CI) umfasst die biologisch motivierten Bereiche der Informationsverarbeitung, wie z.B. evolutionäre Algorithmen.

Maschinelles Lernen (Machine Learning - ML) ist ein umfassender Zweig der KI, der viele rechenintensive Teilbereiche umfasst. Eine davon ist die auf statistischen Ansätzen basierende Mustererkennung, die Ende der 1990er Jahre zu einem großen kommerziellen Erfolg bei Befehls- und Kontrollsystemen (Command&Control Systems), Spracherkennungssystemen mit großem Vokabular (Large Vocabulary Speech Recognition Systems - LVSRS) und ihren Anwendungen in Callcentern und in der Radiologie führte. Diese technologische Ansätze haben sich in den 2000er Jahren abgeflacht, als sie die Rahmen des angewandten statistischen Ansatzes ausgeschöpft haben..

Mittlerweile führte die Entwicklung von Ideen zur Wissensdarstellung zu fortgeschritteneren Ansätzen wie Ontologie oder Wissensgraphen, WG (Knowledge Graph - KG).

Die wichtigste Entwicklung war jedoch die Wiederbelebung der neuronalen Netzwerkforschung, die zu vielen erfolgreichen Anwendungen führte, wie z.B. Erkennung handgeschriebener Ziffern (handwritten digit recognition). Der eigentliche Durchbruch bei der Verwendung neuronaler Netze (Neural Networks - NNs) kam mit Deep Learning, das erfolgreich auf die Klassifizierung großer Datenmengen angewendet werden kann, wie z.B. Bilder. Der Erfolg von Deep Learning führte zu einem enormen Anstieg des Interesses an und der Finanzierung von KI. Deep Reinforcement Learning ermöglicht die erfolgreiche Umsetzung automatischer Steuerungsaufgaben. Die Abbildung 3 zeigt mehrere funktionale Teilmengen der KI und ihre Beziehung zueinander.

Die jüngste Entwicklung im Bereich der KI ist die Anwendung spezifischer großer Sprachmodelle (Large Language Model) und fortschrittlicher Techniken wie beispielweise generatives Transformer (generative transformer), die zu Produkten führen, wie z. B. ChatGPT 3.5.

Im Wesentlichen soll KI die unterschiedlichen Fähigkeiten der menschlichen Intelligenz umsetzen. Dazu gehören Lernen, Wahrnehmung, logisches Denken, Abstraktion sowie komplexere Fähigkeiten wie z.B. Zusammenfassung, Kontrolle, Aufgabenlösungsfähigkeiten und vieles mehr. Eines der langfristigen Ziele ist die Schaffung einer allgemeinen Intelligenz, der sogenannten Künstlichen Allgemeinen Intelligenz (Artificial General Intelligence - AGI), die eine Vielzahl von Problemen ähnlich der menschlichen Intelligenz lösen könnte.

Raymond Kurzweil, Pionier unter anderen der optischen Texterkennung, (auch optische Zeichenerkennung genannt, Optical Character Recognition - OCR),

Sprachsynthese (speech synthesis), Spracherkennung, ein Visionär der künstlichen Intelligenz hat vorhergesagt, dass (einfach formuliert) spätestens im Jahr 2029 die KI Systeme klüger sein werden als das Mensch. Kritiker sagen, dass in der Richtung der Entwicklung zukünftiger Technologien er wahrscheinlich Recht hat, aber die prognostizierte Zeitspanne stimmt nicht, er ist zu optimistisch.

KI ist eine unvermeidliche zukünftige Entwicklungsrichtung und eine der Kernfachgebiete der Wissenschaftsfeld Data Science.

Grundlagen von Computational Intelligence und AI

Es gibt keine Einheitliche Definition von KI. Eine mögliche ausdrucksvolle Definition kann wie folgt angegeben werden: KI ist das Teilgebiet der Informatik, das sich mit Entwicklung und Untersuchung von intelligenten Maschinen beschäftigt. Allerdings unter KI ist auch die ,,intelligente Maschine“ selbst zu verstehen.

Mathematische Grundkonzepte von KI

Die Ziele von KI sind Teilmenge möglicher Arten menschlicher intelligenter Aktivitäten zu implementieren. Dazu gehört Argumentation (reasoning), Planung (planning), Wissensrepräsentation (knowledge representation), Lernen (learning), Wahrnehmung (perception), Unterstützung für Robotik (support for robotics) und Verarbeitung natürlicher Sprache (natural language processing).

Im Folgenden geben wir eine kurze mathematische Beschreibung einiger ausgewählten grundlegender Konzepte der KI. Das beinhaltet

- Wissensrepräsentation,

- Linear regression,

- Klassifikation - lineare Diskriminanzfunktionen,

- Lernen aus Beispiele und

- Learning durch Steuereung - MDP.

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \mathrm{\ \ \ \ }} Wissensrepräsentation

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \mathrm{\ \ \ \ \ \ }} Sprachmodellierung

Die Darstellung von Wissen auf Wortebene kann durch ein probabilistisches Modell natürlicher Sprache realisiert werden, das als Sprachmodell (Language Model - LM) bezeichnet wird. Normalerweise wird ein LM verwendet, um die Wahrscheinlichkeit einer bestimmten Wortfolge Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle w_1,w_2,...,w_n} abzuschätzen. Die Wahrscheinlichkeit Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle p(w_1,w_2,...,w_n)} kann als Produkt der bedingten Wahrscheinlichkeiten als

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle p(w_1,w_2,...,w_n) =p(w_1)p(w_2|w_1)...p(w_n|w_{n-1},...,w_2,w_1)}

angegeben werden. Im N-Gram-Sprachmodell (N-gram LM) wird angenommen, dass das Wort Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle w_n}

einer Wortfolge, in der bedingten Wahrscheinlichkeit Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle p(w_n|w_{n-1},...,w_2,w_1)}

näherungsweise nur von Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle (N-1)}

Vorgengewörtern abhangig ist. Für Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle N=1}

, Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle N=2}

und Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle N=3}

wird das N-Gram Sprachmodell als Unigram-Sprachmodell, Bigram-Sprachmodell bzw. Trigram-Sprachmodell genannt. Im

Bigram-Sprachmodell is est angenommen, dass das Wort Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle w_n}

nur vom Vorgängewort Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle w_{i-1}}

abhängt: Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle p(w_n|w_{n-1},...,w_2,w_1) \approx p(w_n|w_{n-1}).}

In ähnlicher Weise wird in Trigram-Sprachmodell angenommen dass das Wort Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle w_n}

einer Wortfolge nur von zwei Vorgängewörtern abhängig wird: Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle p(w_n|w_{n-1},...,w_2,w_1) \approx p(w_n|w_{n-1},w_{n-2}).}

Die bedingten Wahrscheinlichkeiten Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle p(w_i|w_{i-1},w_{i-2},...,w_{i-N+1})} eines N-Gram Sprachmodells können aus den relativen Häufigkeiten als

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \begin{aligned} p(w_i|w_{i-1},w_{i-2},...,w_{i-N+1}) &= \frac{p(w_{i},w_{i-1},...,w_{i-N+1})}{p(w_{i-1},w_{i-2},...,w_{i-N+1})} \\ &\approx \frac{c(w_{i},w_{i-1},...,w_{i-N+1})}{c(w_{i-1},w_{i-2},...,w_{i-N+1})} \end{aligned}}

geschätzt werden, wobei Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle c(x_1,\ldots,x_k)}

für die Anzahl der Vorkommen der Zeichenfolge Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle x_1,\ldots,x_k}

steht, die auch als count von Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle x}

bezeichnet wird. Entsprechend wird Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle w_{i},w_{i-1},...,w_{i-N+1}}

und die count Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle c(w_{i},w_{i-1},...,w_{i-N+1})}

als N-Gram bzw. N-Gram-count bezeichnet. Die bedingten Wahrscheinlichkeiten

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle p(w_i|w_{i-1},w_{i-2},...,w_{i-N+1})}

eines N-Gram Sprachmodells werden als N-Gram Wahrscheinlichkeiten bezeichnet.

Das N-Gram Sprachmodell ist ein rein statistisches Sprachmodell (statistical LM - SLM), da es auf N-Gram-Statistiken der Trainingskorpora (wie N-Gram-count) trainiert wird. Zuverlässige Schätzungen der bedingten Wahrscheinlichkeiten des N-Gram Sprachmodells Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle p(w_i|w_{i-1},w_{i-2},...,w_{i-N+1})} erfordern das Auftreten der entsprechenden N-Grams und (N-1)-Grams in den Trainingskorpora. Das Vorhandensein aller N-Grams und (N-1)-Grams in den Trainingskorpora ist jedoch praktisch nicht möglich, da hierfür ein sehr großer Trainingskorpus erforderlich wäre, um alle Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle |V|^N} mögliche N-Grams in den Trainingskorpora vorkommen haben. So große Trainingskorpora sind normalerweise nicht verfügbar. Die unsichtbaren N-Grams führen zu fehlenden Schätzungen, da der SLM den N-Grams, die nicht im Trainingskorpus erscheinen, keine Wahrscheinlichkeit zuordnen kann. Dieses Problem wird normalerweise durch die Anwendung von Glättung (smoothing) gelöst, bei denen ein kleiner Teil des Wahrscheinlichkeitsmaßes auf die unsichtbaren Grams aufgeteilt wird.

Die effektivste Glättungsmethode ist die Kneser-Ney-Glättung, bei der ein fester Rabattwert, Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \delta} , von der Schätzung der bedingten Bigram-Wahrscheinlichkeiten mit niedrigeren Häufigkeiten abgezogen wird und werden die so gewonnenen Wahrscheinlichkeiten über alle nicht erscheinenden N-Gram Wahrscheinlichkeiten verteilt werden. Die Berechnungsformel der Bigram-Wahrscheinlichkeiten lautet:

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \begin{aligned} &p_{KN}(w_i|w_{i-1}) = \frac{max(c(w_{i-1},w_i)-\delta,0)}{\sum_{w_j} c(w_{i-1},w_j)} + \lambda_{w_{i-1}}p_{KN}(w_i) \mathrm{~and~} \\ &p_{KN}(w_i) = \frac{|{w_j: 0 < c(w_j,w_i)}|}{|{(w_j,w_k): 0 < c(w_j,w_k)}|}. \end{aligned}}

Hier ist Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \lambda_{w_{i-1}}} eine Normalisierungskonstante, die so eingestellt ist, dass die Summe von Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle p_{KN}(w_i|w_{i_1})} über alle Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle w_i} gleich eins ist. Die unsichtbaren Bigram-Wahrscheinlichkeiten werden durch den ungewöhnlichen Term Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle p_{KN}(w_i)} bestimmt, der eine Schätzung für eine unsichtbare Bigram-Wahrscheinlichkeit aus anderen Bigram-counts verbunden mit Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle w_i} realisiert. Genauer gesagt es ist die Bigram-count anderer Wörter Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle w_j} gesehen mit dem betrachteten Wort Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle w_i} dividiert durch die Summe der gesehenen Bigram-counts dieser Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle w_j} -s mit anderen Wörtern.

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \mathrm{\ \ \ \ \ \ }} Fortgeschrittene Sprachmodelle

Die Auswirkung der jüngsten Entwicklung von NN auf andere KI-Konzepte führte zu modernen KI-Modellkombinationen. Die beiden wichtigsten sind vielleicht die neuronale Sprachmodellierung und das große Sprachmodelle.

Neuronale Sprachmodelle (Neural LM - NLM) sind Sprachmodelle, die auf rekurrentes NN basieren. Sie werden auch als kontinuierlicher Raum-Sprachmodelle (continuous space LMs) bezeichnet. Sie transformieren die Sprachmodell Darstellung von Wörtern durch Einbettung in einen kontinuierlichen niedrigdimensionalen Vektorraum, den sogenannten Embedding Space. Dies hat den Vorteil, dass die semantisch ähnlichen Einheiten im Einbettungsraum näher beieinander liegen. Solche Einheiten können Korpusteile, Sätze, Wortteile oder Zeichen sein. Durch dieser Beziehungen können Sollche Sprachmodelle die unsichtbaren Grams gut abschätzen und daher mit dem Problem von unsichtbaren Grams von SLMs gut umgehen. Darüber hinaus stellen NLMs die Wörter als nichtlineare Kombinationen von Gewichten in einem neuronalen Netz dar [Bengio(2008)]. Die NLMs können entweder als nicht-kontextuelle Einbettungen (Non-contextual Embeddings) oder als kontextuelle Einbettungen (Contextual Embeddings) kategorisiert werden. Nicht-kontextuelle Einbettungen wenden dieselben Einbettungen für eine bestimmte semantische Einheit an, unabhängig vom gegebenen Kontext. Beispiele für nicht-kontextuelle Einbettungen sind Word2Vec [Mikolov et al.(2013)] oder Wikipedia2Vec [Yamada et al.(2018)]. Im Gegensatz dazu können kontextuelle Einbettungen unterschiedliche Semantiken der semantischen Einheiten in unterschiedlichen Kontexten darstellen. Beispiele für kontextuelle Einbettungen sind die von Google [Devlin et al.(2019)] eingeführten BERT (Bidirectional Encoder Representations from Transformers) oder Sentence-BERT (SBERT), eine verfeinerte Version von BERT. Das Transformer (transformer model) ist eine spezifische NN-Architektur, die von Vaswani et al. eingeführt wurde [Vaswani et al.(2017)].

Große Sprachmodelle (Large Language Models - LLM) sind Transformers-basierte LMs, die durch selbstüberwachtes Lernen vorab trainiert werden. LLMs lernen Milliarden von Parametern während des Trainings und benötigen große Rechenressourcen sowohl für das Training als auch während des Betriebs. Sie scheinen ein allgemeines Sprachverständnis erreichen zu können und können Antworten in Form von menschenähnlichem Text generieren. Diese LLMs werden in generativen KI-Systemen eingesetzt. Aktuelle Versionen können bestimmte Aufgaben mittels Promt Engineering erledigen. Promt Engineering ermöglicht eine Gestaltung von Eingaben für das System mittels Eingabeaufforderungen (promts), die vom LLM interpretiert werden können, und dadurch wird das Aufmerksamkeitsmechanismus des Modells auf das nähere Einschränken der Aufgabe gesteuert. Die bekanntesten Beispiele sind das GPT-3.5- und GPT-4-Modell von Open AI (verwendet in ChatGPT) und Googles PaLM (verwendet in Bard).

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \mathrm{\ \ \ \ \ \ }} Auf semantischen Relationen basierende Wissensrepräsentationen

Neben LMs gibt es noch andere Möglichkeiten der Wissensrepräsentation

- Semantisches Netzwerk (Semantic network) – ein Diagramm, das semantische Relationen zwischen Konzepten darstellt. Die Konzepte werden durch die Knoten repräsentiert und die Kanten spezifizieren die semantischen Relationen Ein Grund für den Entwurf semantischer Netzwerke besteht darin, Wissen in maschinenlesbarer Form darzustellen. Wissensgraphen sind semantische Netzwerke mit begrenzten semantischen Relationen.

- Ontology (ontology) – hierarchische Darstellung von Konzepten und ihren Relationen, die durch eine Standard-Ontologiesprache (standard ontology language) wie Web Ontology Language (OWL, Web Ontology Language) oder Resource Description Framework (RDF, Resource Description Framework) verwaltet werden kann.

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \mathrm{\ \ \ \ }} Lineare Regression mit MSE-Framework

Die Aufgabe der linearen Regression (linear regression) besteht darin, eine lineare Vorhersage für die zufällige skalare Ausgabe Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle y \in \mathbb{R}} aus dem zufälligen Eingabevektor Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {\bf x}} zu geben. Sei Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \hat{y}} der vorhergesagte Wert von Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle y} . Es wird angenommen, dass Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle y} linear vom Vektor Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {\bf x}} abhängt, daher kann der vorhergesagte Wert Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \hat{y}} als Linearkombination von Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {\bf x}} als Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \hat{y}= w_1*x_1 + \ldots + w_n*x_n} angegeben werden. Mit anderen Worten, in Vektorform gilt

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \hat{y}= {\bf w}^T {\bf x},}

wobei Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {\bf w} = (w_1,\ldots,w_n)^T} ein Spaltenvektor von Parametern ist. Hier steht Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle ^T} für die Transponieren und die Vektoren sind standardmäßig Spaltenvektoren.

Die Parameter Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle w_i} können als Gewichte angesehen werden. Wenn der Eingabewert Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle x_i} ein positives Gewicht hat, erhöht eine Erhöhung von Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle x_i} auch den vorhergesagten Wert Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \hat{y}} . Wenn Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle x_i} ein negatives Gewicht hat, verringert eine Erhöhung von Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle x_i} den vorhergesagten Wert Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \hat{y}} . Wenn Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle w_i} ein großer Wert ist, dann hat Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle x_i} einen großen Einfluss auf Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \hat{y}} . Wenn Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle w_i=0} , dann hat Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle x_i} keinen Einfluss auf Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \hat{y}} .

Nehmen wir an, dass Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle K} Beispiele des Vektors Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {\bf x}} und der korrekte Wert der Ausgabe Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle y} für jeden von ihnen angegeben sind. Wir ordnen die Eingabevektoren in einer Matrix Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {\bf X}} so an, dass der Vektor Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {\bf x}_k^T} in der Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle k} -ten Zeile der Matrix Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {\bf X}} platziert wird, Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle k=1,\ldots,K} . Die Ausgabewerte und die vorhergesagten Werte werden ebenfalls in einem Spaltenvektor Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {\bf y}} und Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {\bf \hat{y}}} angeordnet, sodass der korrekte Wert Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle y_k} und der vorhergesagte Wert Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \hat {y}_k} , das zum Eingabevektor Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {\bf x}_k} gehört, kommt an die Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle k} -te Position jeweils im Vektor Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {\bf y}} und Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {\bf \hat{y}}} .

Die Aufgabe, die Gewichte zu finden kann als Optimierungsaufgabe aufgestellt werden. Diese Optimierungsaufgabe wird durch das Extremum eines Leistungsmaßes, das die Qualität der Vorhersage quantifiziert, angegeben werden.

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \mathrm{\ \ \ \ \ \ }} Lineare Regression mit mittlerer quadratischen Abweichung

Eine mögliche Wahl um die Qualität der Vorhersage zu quantifizieren, ist die mittlere quadratische Abweichung, MQA (mean squared error - MSE), die auch als mittlere quadratische Fehler (MQF) genannt ist. Die MSE wird durch

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle MSE = \frac{1}{K} \sum_{k} ({\hat{y}}_k - y_k)^2 = \frac{1}{K} \lVert {\bf \hat{y}} - {\bf y} \rVert_2^2}

gegeben, wobei Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \lVert {\bf z} \rVert_2} für die Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \mathbb{L}_2} -Norm von Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle z} steht.

Der optimale Wert des Parametervektors Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {\bf w}} wird durch Minimieren des MSE erhalten. Die notwendige Bedingung für ein lokales Minimum von MSE ist die Existenz eines Wertes des Parametervektors Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {\bf w}} , für den der Gradient von MSE 0 ist. Es kann gezeigt werden, dass in unserem Fall MSE als Funktion von Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {\bf w}} eine konvexe Funktion ist, und daher gibt es nur einen solchen Wert von Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {\bf w}} und daher ist es auch der globale Minimalpunkt. So wird der beste Wert des Parametervektors Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {\bf w}} durch Lösen der Gleichung

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \nabla_{{\bf w}} MSE = \nabla_{{\bf w}} \left( \frac{1}{K} \lVert {\bf \hat{y}} - {\bf y} \rVert_2^2 \right) = 0}

erhalten, wobei Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \nabla_{{\bf w}}} für den Gradienten bezüglich Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {\bf w}} steht. Die vorhergesagten Ausgaben können in Vektormatrixform als Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {\bf \hat{y}} = {\bf X}{\bf w}} angegeben werden. Wenn man es in der obigen Beziehung anwendet, erhält man die Gleichung für Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {\bf w}} als

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \nabla_{{\bf w}} MSE = \nabla_{{\bf w}} \left( \frac{1}{K} \lVert {\bf X}{\bf w} - {\bf y} \rVert_2^2 \right) = 0.}

Wenn wir die Konstante Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \frac{1}{K}} weglassen, den Gradienten auswerten und mehrere Umordnungen durchführen, erhalten wir

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \begin{aligned} \nabla_{{\bf w}} \left( \lVert {\bf X}{\bf w} - {\bf y} \rVert_2^2 \right) &= \nabla_{{\bf w}} \left({\bf X}{\bf w} - {\bf y} \right)^T \left({\bf X}{\bf w} - {\bf y} \right) \\ &= \nabla_{{\bf w}} \left( {\bf w}^T {\bf X}^T{\bf X}{\bf w} - 2 {\bf w}^T {\bf X}^T {\bf y} + {\bf y}^T {\bf y}\right) = 2 {\bf X}^T{\bf X}{\bf w} - 2 {\bf X}^T {\bf y} = 0, \end{aligned}}

wobei wir in der zweiten Gleichung verwendet haben, dass Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {\bf y}^T {\bf X} {\bf w} = {\bf w}^T {\bf X}^T {\bf y}} , da Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {\bf y}^T {\bf X} {\bf w}} ein Skalar ist und entspricht daher seiner Transponierten. Zusätzlich haben wir in der letzten Gleichung verwendet, dass Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \nabla_{{\bf w}}\left( {\bf w}^T {\bf X}^T{\bf X}{\bf w}\right)} kann als Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle 2 {\bf X}^T{\bf X}{\bf w}} ausgewertet werden, da die Matrix Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {\bf X}^T{\bf X}} symmetrisch ist.

Schließlich kann die Lösung für den Parametervektor Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {\bf w}} aus der obigen Gleichung als Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle {\bf w} = \left({\bf X}^T{\bf X}\right)^{-1} {\bf X}^T {\bf y}}

ausgedrückt werden. Die Matrix Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {\bf X}^T{\bf X}} ist quadratisch und daher im Prinzip invertierbar. Dennoch existiert die Inverse nur, wenn die Matrix Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {\bf X}^T{\bf X}} nicht singulär ist, was normalerweise gilt, da die Matrix Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {\bf X}} aus unabhängigen Eingabebeispielen erstellt wird.

Die obigen Gleichungen in Skalarform führen zu einem System linearer Gleichungen, die als Normalgleichungen bezeichnet werden.

Die lineare Regression wird auch für ein leicht erweitertes Vorhersagemodell verwendet, das durch

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \hat{y}= {\bf w}^T {\bf x} + b}

angegeben wird. Hier wird der Skalar Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle b} Bias genannt und führt dazu, dass die durch die multivariate Funktion Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \hat{y}({\bf w})} beschriebene Hyperebene nicht durch den Ursprung verläuft. Dieser erweiterte Fall kann auf den Basisfall zurückgeführt werden, indem die erweiterten Vektoren Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {{\bf x}^*}^T = ({\bf x}, 1)^T} und Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {{\bf w}^*}^T = ({\bf w}, b)^T} eingeführt werden, was eine äquivalente Beschreibung ergibt.

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \hat{y}= {\bf w}^{*T} {\bf x}^*.}

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \mathrm{\ \ \ \ \ \ }} Verbindung zwischen linearen Regression mit MSE und Maximum-Likelihood-Schätzung

Sei Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {\bf z} = (z_1,\ldots,z_M)} eine Folge von Stichproben aus der Grundgesamtheit, die unabhängige Stichproben ergeben. Jede Stichprobe wird durch derselbe Zufallsvariable Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle Z} mit einer Likelihood-Funktion (likelihood function) Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle p({\bf z}|{\boldsymbol{\theta}})} aus einer bekannten Verteilungsfamilie mit unbekanntem Parametervektor Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {\boldsymbol{\theta}}} erzeugt. Die Likelihood-Funktion entspricht der Wahrscheinlichkeitsfunktion (probability mass function - pmf) und der Wahrscheinlichkeitsdichtefunktion (probability density function - pdf) mit dem Parametervektor als Variable, für diskrete bzw. stetige Verteilung. Die Maximum-Likelihood-Schätzung, kurz ML-Schätzung (Maximum Likelihood Estimation - ML estimation or MLE) des Parametervektors Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle {\bf \theta}} ist der Wert, der die Wahrscheinlichkeit der beobachteten Stichprobenfolge maximiert. Mit anderen Worten

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle {\boldsymbol{\theta}}_{ML} = \arg \max_{{\boldsymbol{\theta}}} p({\bf z}|{\boldsymbol{\theta}}) = \arg \max_{{\boldsymbol{\theta}}} p(z_1,\ldots,z_M|{\boldsymbol{\theta}}) = \arg \max_{{\boldsymbol{\theta}}} \prod_{m=1}^{M} p(z_m|{\boldsymbol{\theta}}),}

wobei wir verwendet haben, dass die Ziehungen aus der Grundgesamtheit unabhängig von einander sind und die Stichproben werden von derselben Zufallsvariablen Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle Z} erzeugt.