Webserver Infrastructures - Gesamt: Unterschied zwischen den Versionen

(Die Seite wurde neu angelegt: „{{:UrheberrechtDefault}}<br> {{:Benutzer:_KOPICA_Franz}}<br> {{:Webserver Grundlagen}}<br> {{:Lastausgleich und Skalierbarkeit}}<br> {{:Leistungsoptimierung (Webserver)}}<br> {{:Hochverfügbarkeit und Ausfallsicherheit (Webserver)}}<br> {{:Quellen}}“) |

Markierung: Manuelle Zurücksetzung |

| (Eine dazwischenliegende Version desselben Benutzers wird nicht angezeigt) | |

(kein Unterschied)

| |

Aktuelle Version vom 1. Oktober 2024, 06:09 Uhr

1. Webserver - Allgemein

Ein Webserver ist ein Computer, welcher Rechenleistung, Speicher, Daten und Dienste in oder zu einem Netzwerk (WICHTIG: Netzwerk ist nicht nur die Netzwerkart LAN) bereitstellt und auch Zugriffsrechte verwaltet. Auf diese Informationen, die in Form von Text, Bild, Video, etc.etc. vorliegen wird mittels eines Software-Clients ("Webbrowser" bzw. in Kurzform "Browser" ) zugegriffen. dabei handelt es sich um ein Programm, also Software für ein bestimmtes Bertiebssysten, dessen Aufgabe darin besteht dierKommunikation zwischen einem Client und einem Host, also Server zu ermöglichen.

Ein Webserver kann aus Software, Hardware oder beidem zusammen bestehen. Was die Software betrifft, so besteht ein Webserver aus Teilen, die steuern, wie Webnutzer auf gehostete Dateien zugreifen. Was die Hardware betrifft, so handelt es sich um Computer, auf denen die Webserver-Software und die Komponentendateien einer Website wie z.B. HTML-Dokumente oder JavaScript-Dateien.

Im Minimum versteht ein Webserver, das HTTP(s)-Protokoll, das der Browser zur Anzeige von Webseiten verwendet und URLs (Uniform Resource Locator) versteht. Der Server ist so via Domänennamen der Websites(welche er auch speichert) erreichbar und transferiert die Inhalte der gehosteten Web-Sites zum User. Der Webbrowser und der Webserver arbeiten auf dem Client- und Server-Computer und dem Netzwerk.

Die Auswahl eines Webservers ist ein entscheidender Schritt bei der Entwicklung und Bereitstellung einer Web-Anwendung. Ein Webserver hostet diese Anwendung und ist meistens auch gleich die erste Verteidigungslinie gegen Sicherheitsbedrohungen. Die Entscheidung welches Betriebssystem, welches Produkt zum Einsatz kommt sollte daher mit äußerster Sorgfalt getroffen werden, wobei viele Faktoren wie Leistung, Sicherheit, Skalierbarkeit und Kosten zu berücksichtigen sind. Eine simple Formel einen Webserver zu beschreiben wäre folgende:

'

Webserver = Plattform + Software + Information

Nachstehend eine Abbildung einer allgemeinen Client/Server-Architektur:

1.1 Webserver - Überblick

Das Webserverprogramm läuft ununterbrochen und wartet auf Benutzeranfragen, die über das Internet kommen. Das Webserverprogramm stellt dann eine Netzwerkverbindung her,um die Anfrage des Benutzers zu empfangen. Der Webdienst interagiert mit dem Netz auf die gleiche Weise wie viele andere Netzdienste im Internet. Die Betriebssystemsoftware des Computers verbirgt die Komplexität und Vielfalt des zugrunde liegenden Netzwerks, indem es einfache Abstraktionen bereitstellt, die es Menschen und Programmen ermöglichen, ihre Arbeit leichter zu erledigen. So kommunizieren Programme beispielsweise über das Netz, indem es eine Verbindung von einem Port zu einem anderen herstellen.

Ein Port ist eine Abstraktion, welcher die eine einfache, generische Möglichkeit bietet, Netzwerkverbindungen herzustellen und zu nutzen. Der Port ist in etwavergleichbar mit einer Telefondurchwahl. Wenn ein Computerprogramm eine Verbindung zu einem anderen Programm im Netzwerk herstellt, fordert es den Port des empfangenden Programms an. Dieser Port gibt genau an, mit welchem Programm das Ursprungsprogramm eine Verbindung herstellen möchte.

Daten, die an einen ausgehenden Port (auf dem Computer des Absenders) geschrieben werden, kommen am eingehenden Port des empfangenden Programms an, wo es gelesen werden. Jedem Webserver wird ein Port zugewiesen, der durch eine Nummer gekennzeichnet ist. Dieser Port stellt eine Netzwerkverbindung zur Systemplattform des Computers her. Das Web-Client-Programm, der Browser, sieht den Port des Web-Servers als seinen Zugangspunkt im Netzwerk.

Wenn das Webbrowser-Programm eine Anfrage an das Webserver-Programm stellen möchte, sendet es die Anfrage an den zugewiesenen Port des Webservers. Bei der Webserver-Software kommen die Daten an ihrem Port an. Die Webserver-Software liest die Anfrage, und schließlich sendet der Webserver Daten aus, indem er es über denselben Port schreibt. Die Webserver-Software muss nur wissen, wie es den Netzwerkanschluss lesen und beschreiben kann; es muss nichts weiter über die Übertragung der Nachricht über das Netzwerk wissen. Ein Großteil der Komplexität der Verwaltung der Netzwerkverbindung zwischen dem Client und dem Server ist im Betriebssystem und in der Netzwerksoftware von Client und Server verborgen.

1.2 Geschichtlicher Hintergrund

Die Entwicklung des Webservers ist eng mit dem britischen Physiker und Informatiker Tim Berners-Lee verbunden. Bereits 1989 regte dieser an, den Informationsaustausch des CERN (der Europäischen Organisation für Kernforschung) über ein Hypertext-System einfacher und schneller zu gestalten. Das Projekt nannte Berners-Lee anfänglich “Mesh”. Zusammen mit Robert Cailliau legte er 1990 einen Projektplan vor, aus dem im Laufe der Zeit neben dem ersten Webserver namens „CERN httpd“ auch der erste Webbrowser und einige weitere Grundlagen des Webs (wie HTML und HTTP) hervorgingen. Am 06. August 1991 war es soweit Tim Berners-Lee veröffentlichte in verschiedenen Newsgruppen im Internet eine Beschreibung seines Projekts “World Wide Web”.Berners-Lee gilt daher heute als Begründer des World Wide Web. Im April 1993 legte das CERN dann mit einem wichtigen formalen Akt das Fundament und gab das Web für die Öffentlichkeit frei(kein Patent und keine Lizenzzahlung).

Zu Popularität weit über den Kreis von Physikern und Informatikern hinaus verhalf dem WWW der Browser “Mosaic”, den der damalige Student Marc Andreessen 1993 entwickelte.[1]

Webserver werden durch drei wichtige Technologien ermöglicht [5]:

- 1.Das Adressensystem, Universal Resource Locators (URLs), das es ermöglicht, fast jede Art von Information von fast überall im Internet abzurufen

- 2.Das HyperText Transfer Protocol (HTTP), die Verkehrssprache von Webbrowsern und Webservern, die es vielen verschiedenen Programmen ermöglicht, zusammenzuarbeiten

- 3.Die HyperText Markup Language (HTML), die es ermöglicht, multimedialen Hypertext zu erstellen, der von jedem Webbrowser verwendet werden kann

1.3 Webserver - Technologien

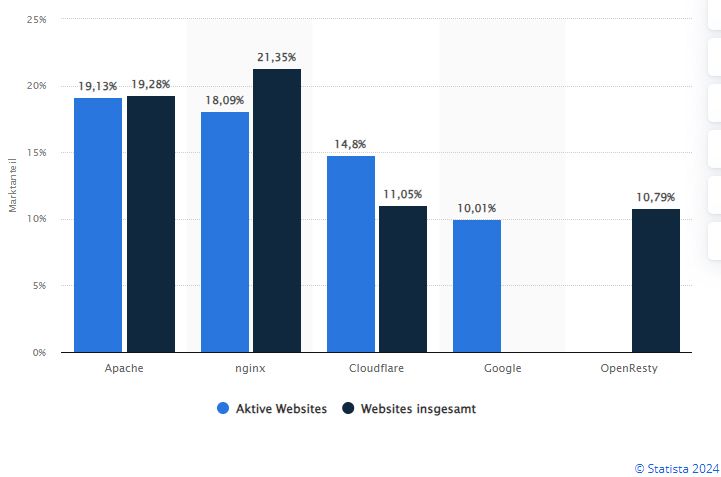

Auch bei dieser Technologie gibt es unterschiedliche Ansätze hinsichtlich Open Source bzw. freie Software(Apache, nginx) und properitäre Software (z.B. Microsoft-IIS). In einer Umfrage vom Mai 2023 seitens NETCRAFT [3] lieferten 1.109.384.426 Websites mit 271.534.718 Domains und 12.037.194 Computern mit Internetanschluss einen Response. Somit ist es nicht einfach, "das Produkt" hinsichtlich Webservertechnologie zu benennen.

Microsoft verzeichnete die deutlichste Veränderung in allen drei Kennzahlen; es verlor 495.099 (-1,88%) Websites, 210.670 Domains (-2,93%) und 12.303 Computer (-1,02%). Microsoft macht nun 2,33% der von Netcraft erfassten Websites und 2,57% der Domains aus, ein Rückgang um 0,03 bzw. 0,07 Prozentpunkte.

LiteSpeed konnte in diesem Monat 202.283 Domains (+2,16%) hinzugewinnen, was mit einem Anstieg der Gesamtzahl der Websites um 388.293 (+0,69%) einherging.

OpenResty wuchs ebenfalls um 325.880 (+0,38%) Websites, verlor aber 349.276 Domains (-0,91%).

nginx verzeichnete einen großen Verlust von 5,7 Millionen Websites (-1,94%), 1,0 Millionen Domains (-1,36%) und 33.970 Computern (-0,72%). Im Gegensatz dazu gewann.

Cloudflare 1,1 Millionen Websites (+1,03%) und 203.491 Domains (+0,79%). Trotzdem hat nginx einen größeren Anteil (25,86 % der Websites im Vergleich zu 9,51 % von Cloudflare), aber Cloudflare hat immer noch die Oberhand bei den ersten Millionen Websites.

Bei den Top-Millionen-Websites behielt Cloudflare seinen ersten Platz und gewann 0,38 Prozentpunkte auf seinen führenden Marktanteil von 22,07 % hinzu. Sowohl nginx als auch Apache mussten Verluste hinnehmen: Ihre Marktanteile sanken um 0,12 Prozentpunkte auf 21,18 % bzw. 0,04 Prozentpunkte auf 21,16 %, während OpenResty um 0,02 Prozentpunkte auf 1,00 % zurückfiel. In der Zwischenzeit konnten LiteSpeed, Google und Microsoft ihre jeweiligen Marktanteile leicht steigern: Microsoft um 0,06 Prozentpunkte, LiteSpeed um 0,05 Prozentpunkte und Google um 0,003 Prozentpunkte.

In Bezug auf die Anzahl der Computer, die mit dem Internet verbunden sind, verzeichneten nginx, Apache und Microsoft einen Rückgang ihrer jeweiligen Marktanteile um 0,11 Prozentpunkte, 0,22 Prozentpunkte und 0,06 Prozentpunkte. nginx hält immer noch den größten Marktanteil von 38,77 % (4,6 Millionen), während Apache an zweiter Stelle mit einem Anteil von 26,80 % (3,2 Millionen Computer) und Microsoft an dritter Stelle mit einem Anteil von 9,99 % (1,2 Millionen Computer) steht.

Nachstehend eine Übersicht der Marktanteile[4] von 6/2024:

1.4 Webserver - Kommunikation

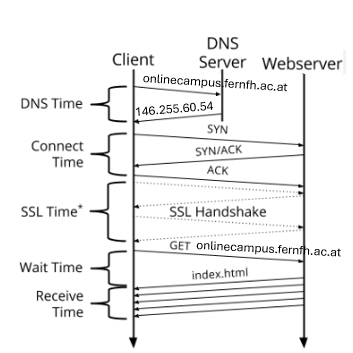

Die Kommunikation läuft von der Anforderung bis zur Auslieferung wie folgt ab:

Ein Browser parst die URL und teilt diese in Schema, Hostname, Portnummer und Ressourcenpfad/Resourssenteil. Die IP-Adresse zum Hostnamen wird durch das "Telefonbuch des Internet", dem Domain Name Service kurz DNS ermittelt und stellt eine TCP-Verbindung her. Sollte keine Portnummer mitgeliefert werden, wird je nach Schema der Port 80 (http:) oder 443 (https:) gewählt.

Bei der URL https://onlinecampus.fernfh.ac.at/mod/resource/view.php ist das Schema https erkennbar und dadurch ist Port 443 (siehe Liste der standardisierten Ports) ableitbar. Der Hostname ist /onlinecampus.fernfh.ac.at sowie der Pfad eben /mod/resource/view.php --> php ist eine Skriptsprache zur Erstellung dynamischer Webseiten oder Webanwendungen.

Über die TCP-Verbindung sendet der Browser eine HTTP-Anfrage. Diese besteht aus HTTP-Method, Path und Protocolversion. Eine Anfrage im Browser durch eingage einer URL löst die Methode GET aus. Das hat zur folge, dass eine Ressource angeliefert werden soll. Die Methode POST wird zum Versenden von z.B. Formulardaten verwendet.

Der Server empfängt die Clientanfrage und reagiert darauf:

1.) Bei einer GET-Anfrage wird die angeforderte Datei dem Browser ausgeliefert.

2.)Bei einem serverseitiges Skript wird dieses vom zuständigen Servermodul ausgeführt und erst anschließend wird die Ausgabe als Antwort dem Browser übermittelt.

Anmerkung: Secure Sockets Layer(SSL) war das ursprüngliche Sicherheitsprotokoll, welches für HTTP entwickelt wurde.SSL-Handshakes heißen jetzt TLS-Handshakes.

1.5 Betriebssysteme von Webservern

Die wesentliche Aufgabe des Betriebssystems ist also die Betriebsmittelverwaltung. Als Betriebsmittel versteht man Hardware- und Software-Ressourcen und zwar u. a. die Prozessoren, die Prozesse (Software), Speicher, Dateien und Geräte. Dies sind reale

Betriebsmittel, aber auch sog. virtuelle Betriebsmittel wie virtueller Speicher, virtuelle Prozessoren und virtuelle Koprozessoren werden durch das Betriebssystem verwaltet. [6]

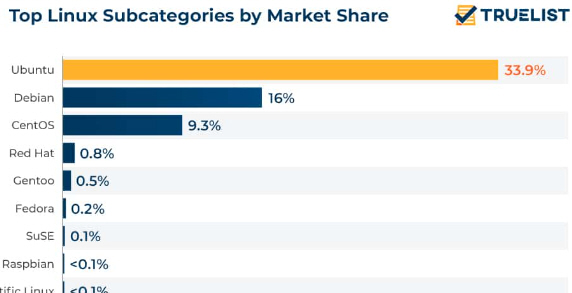

Die tragende Rolle spielt das Betriebssystem Linux. Das System ist seit 1992 als freie Software für jeden verfügbar und kann durch seinen einfachen modularen Aufbau mit dem entsprechenden Wissen den eigenen Vorstellungen angepasst werden.

In etwa zwei Drittel aller Webprojekte die zum Einsatz kommen werden Linux-Distributionen verwendet. Beliebte Distributionen sind z.B.:

- Ubuntu

- Red Hat

- Debian

- Fedora

- SUSE

- CentOS

- Uvm.

Truelist [7] zeigt einen Status von 6/2024:

Unix/Linux-Server-Betriebssysteme haben einen namhaften Konurenten -- Microsoft, mit dem vormals Internet Information Server genanten Webserver, der auf Internet Information Services (IIS) umbenannt wurde.

Eine Möglichkeit, mehr aus einem System herauszuholen, besteht darin, mehr als einen Webdienst auf demselben Computer laufen zu lassen. Eine beliebige Anzahl von Webserver kann auf einem einzigen System laufen..

Der Webdienst befindet sich standardmäßig am TCP-Port 80. Das bedeutet, auf Port 80 wird gelauscht und der Client eine Verbindung zu diesem Port auf dem Serverrechner anfordern sollte. Ein Webserver kann jedoch auch an fast jedem anderen Port als 80 lauschen, wenn es dafür einen Grund gibt.

Das Einrichten eines Webdienstes an Port 80 erfordert beispielsweise Administrator bzw. Superuser-Rechte auf dem Server-Computer. Wenn Benutzer ohne Administratorrechte einen eigenen Dienst einrichten und warten wollen, müssen diese eine unbeschränkte, eingeschränkte Portnummer wählen, die höher als 1024 sein muss,

B. 8080 oder 8081 (siehe Liste der Standardisierten Ports https://de.wikipedia.org/wiki/Liste_der_Portnummern)

So kann ein Exemplar des Webservers die Standard-Portnummer 80 verwenden und vom Superuser verwaltet werden, während Server, die die Ports 8080 und 8081 verwenden, den Benutzern gehören und von ihnen betrieben werden. Die verschiedenen Server werden unterschieden, indem die Portnummer in die URL aufgenommen wird: http://www.mydomain.at/index.html (port80) http://www.mydomain.at:8080/index.html (port:8080) http://www.mydomain.at:8081/index.html (port:8081) Diese URLs sind Anfragen an verschiedene Webdienste auf demselben Computer (www.mydomain.at ).

Mit z.B. einem Apache oder nginx Webserver können mit sogenannten Virtual Hosts diverse Einstellungen vorgenommen werden, damit mehrere Webseiten auf einem Server betrieben werden können.

Dazu bedarf es folgender Unterschiede:

- Unterschiedliche Domainnamen

- Unterschiedliche Portangaben

- Unterschiedlicher Verzeichnisnamen

- '

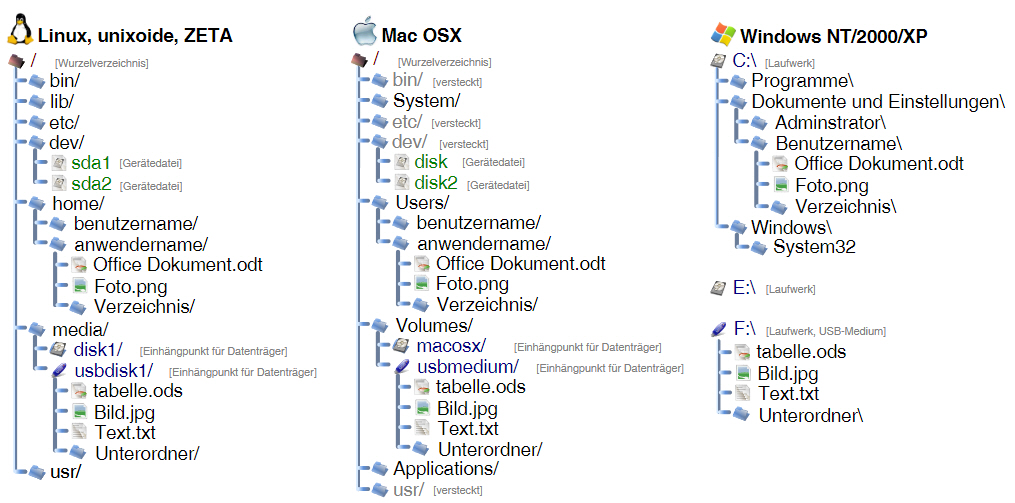

1.5.1 Dateisysteme

Bei der Auswahl der Betriebssysteme ist es von Vorteil die Grundfunktionen dieser Dateisysteme zu kennen. Es erleichtert den Umgang mit dem System aber auch die Konfiguration diverser Subsysteme und Applikationen.

1.6 Webserver – Statischer Zugriff

Ein statischer Zugriff [8] läuft wie folgt ab:

1. Beim statischen Zugriff gibt der User Nutzer in der Adressleiste, nicht in der Suchleiste seines Browsers die Zieladresse ein

2. Der Browser sendet einen HTTP-Request, also eine Anfrage an den zur Zieladresse gehörenden Webserver.

3. Der Webserver sucht nach der angefragten HTML-Datei

4. Ist die HTML-Datei vorhanden, wird diese via HTTP an den Client gesandt, das ist ein HTTP-Response

4a. falls nicht vorhanden = Fehlermeldung 404– file not found

5. Der Webbrowser zeigt die angefragte Datei an

1.7 Webserver – Dynamischer Zugriff

Ein dynamischer Zugriff [8] läuft wie folgt ab:

- 1.) Der User gibt einen Suchbegriff in ein Eingabefeld ein

- 2.) Der Inhalt wird mittels http an den Webserver überreicht

- 3.) Der Webserver ruft z.B. ein PHP-Skript **) auf.

- 4.) Ein PHP-Interpreter wertet die Suchanfrage aus

- 5.) Der PHP-Interpreter startet eine Anfrage an eine Datenbank (z.B MySQL)

- 6.) Die Datenbank wird nach dem Inhalt durchsucht

- 7.) Die Datenbank liefert den gesuchten Inhalt zurück

- 8.) Der PHP-Interpreter wandelt den Inhalt in HTML-Code

( Der Webbrowser kann mit PHP nichts anfangen)

- 9.) Der HTML-Code wird mittels HTTP an den Webserver gesandt

10.Der Webbrowser zeigt den HTMLCode an

**) PHP wird gerne zur Erstellung dynamischer Webseiten verwendet

2 Installation und Konfiguration von Webservern

Webseiten entstehen dynamisch, d. h., dass sie mit Hilfe einer Programmiersprache erst erzeugt werden, wenn ein Nutzer eine Suchanfrage stellt. Die Software im Hintergrund wird immer „intelligenter“, daher wird von einem semantischen Web gesprochen. der webbasierten Programmierung

Sogenannte RIAs (Rich Internet Application) am Webserver sind De-facto-standards. Das bedeutet, dass diese Software nicht mehr auf dem eigenen Computer installiert werden muss, sondern im Browser gestartet werden kann. Beispiele hierfür sind die Office-Pakete Google Docs oder Microsoft

Office 365.

Größeren Websites werden heute mit Hilfe von Content-Management-Systemen erstellt. Dabei handelt es sich um Softwarepakete, die den gesamten Inhalt der Website mit Hilfe einer Datenbank verwalten. Für das Design stellt jedes CMS zahllose Templates zur Verfügung.

Die Installation und Administration eines Webservers ist alles andere als einfach. Glücklicherweise gibt es Zugang zur Technik. Gängige Webtechnologien in einem Paket sind unter www.apachefriends.org zu finden.

XAMPP ist eine vollständig kostenlose, leicht zu installierende Apache-Distribution, die MariaDB, PHP und Perl enthält. Das XAMPP Open-Source-Paket wurde für eine extrem einfache Installation und Nutzung eingerichtet. [9]

• X ist der Platzhalter für das Betriebssystem **) --> Windows-Server werden als WAMPP, Linux-Server als LAMPP und MAC-Server als MAMPP bezeichnet.

• A steht für Apache.

• M sehr für das Datenbankmanagementsystem MySQL bzw. MariaDB

• P steht für die Skriptsprache PHP.

• P steht für Perl (alternativ zu PHP) einer Skriptsprache

**)diese Unterscheidung findet man im Sprachgebrauch bzw. in der Literatur, aber auf www.apachefriends.org sind die drei Applikationen unter dem Brandname XAMPP zu finden.

Neben den obgenannten Modulen sind je nach Betriebssystem je nach Betriebssystem auch andere Werkzeuge wie den Mailserver Mercury, die Datenbank-Administrationsanwendung phpMyAdmin, die Web-Analytics-OpenSSL, Apache Tomcat sowie die FTP-Server FileZilla oder ProFTPd im Installationsbundle vorhanden

2.1 Der Editor

Ein Editor ist unerlässlich hinsichtlich Änderung/Anpassung von Konfigurationsdateien wobei jeder beliebiger Texteditor oder falls es komfortabler sein soll greift man auf eine Entwicklungsumgebung (Integrated Development Environment, IDE) zurück.

Eine IDE hat den Vorteil, dass ggf. Programmcode automatisch vervollständigt wird und zusammengehörige Elemente farbig dargestellt werden. Dies erleichtert die Fehlersuche und ist übersichtlicher, als z.B. der Standardeditor von Microsoft.

Anmerkung: Eine Auflistung textbasierter HTML-Editoren ist auf Wikipedia zu finden.

2.2 Installation eines Testsystemes

Dafür gibt es mehrere Möglichkeiten:

- 1) Native Installation am eigenen Rechner

- 2) Einrichtung eines Dual-Boot-System

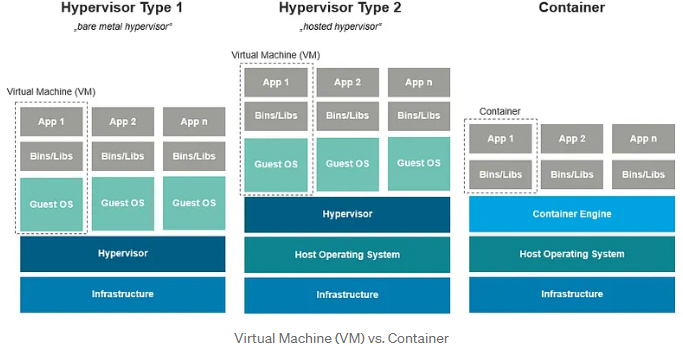

- 3) Installation eines Typ-2-Hypervisor(eine Anwendung am Host-Betriebssystem)

Der Vorteil hinsichtlich der Installation einer VM ist der, dass ein anderes OS verwendet werden kann.

Anmerkung: VirtualBox [11] ist ein Allzweck-Virtualisierungsprogramm für x86-Hardware, das für Server, Desktops und Embedded-Systems geeignet ist, dass auf Windows, Linux und MAC läuft.

2.3 'Installation von Linux(Ubuntu) in einer VM unter Windows'

Ein ISO-File wird benötigt, deshalb https://ubuntu.com/download/desktop ansurfen und die ISO-Datei herunterladen,dort findet man die Neueste vor. Ubuntu-Linux oder nur Ubuntu genannt basiert auf Debian.

Anmerkung: Wenn eine ältere Version von Ubuntu installiert wird, z.B. Ubuntu 22.04.3 LTS, ist die visuelle Darstellung des Installationsprogramms ggf. etwas anders ist, aber der allgemeine Ablauf ist ähnlich.

- ) Installation auf einer VM (Virtualbox 7),

Virtual-Box herunterladen und am Windowsrechner installieren

Nach der Installation sollten auch sämtliche Updates für Windows durchgeführt werden.

TIPP: Einen Kaltstart durchführen

Des Weiteren einTutorial zum Einrichten einer VM https://ubuntu.com/tutorials/how-to-run-ubuntu-desktop-on-a-virtual-machine-using-virtualbox#1-overview

Installation von Ubuntu(Virtualbox 7), siehe z.B. https://ubuntu.com/tutorials/install-ubuntu-desktop#1-overview

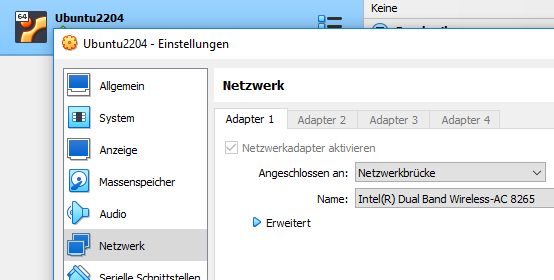

TIPP: Bei der Konfiguration des Netzwerk die Option Netzwerkbridge verwenden, damit sich die VM die IP vom DHCP Server holt.

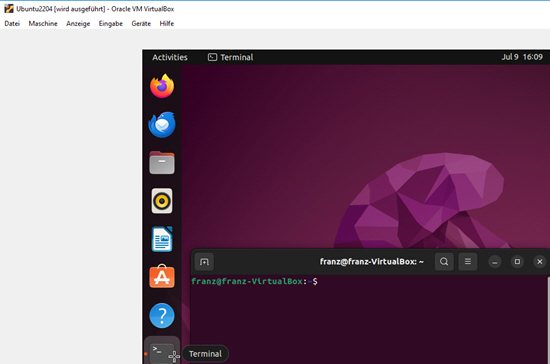

Aktualisieren des System

Ein Terminal öffnen

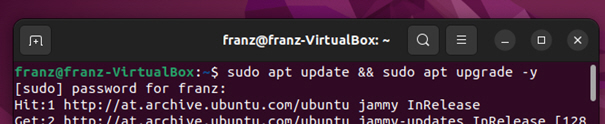

Folgenden Befehl im Terminal eingeben, damit das System aktuell wird:

sudo apt update && sudo apt upgrade -y

Anmerkung: && verbindet 2 Befehle

-y bestätigt automatisch die Ausführung

Die Ausführung kann etwas länger dauern.

2.3.1 Den Apache2-WebServer installieren

Vorab Parameter für den Umgang mit Apache.

enable- aktiviert den Dienststart- startet den Webserverstop- stoppt den Serverrestart- startet den Server neu, bestehende Verbindungen auf den Server werden gekapptreload- lädt die Konfigurationsdateien neu, ohne dass Verbindungen getrennt werdenstatus- gibt den aktuellen Status des Server-Dienstes ausIm Terminal nachstehenden Befehl eingeben:

sudo apt install apache2 -y

Während der Installation registriert sich der Apache bei der UFW(= 'uncomplicated firewall)' und stellt einige Anwendungsprofile zur Verfügung, mit denen der Zugriff auf den Apache über die Firewall aktiviert oder deaktiviert wird.

Starten und aktivieren des Apache-Dienst

Nachstehenden Befehl verwenden, um sicherzustellen, dass er bei jedem Systemstart der Dienst automatisch geladen wird:

sudo systemctl enable apache2

Starten des Apache-Dienst erfolgt mit dem folgenden Befehl:

sudo systemctl start apache2

Zur Vorsicht wird überprüft, ob der Server fehlerfrei läuft:

sudo systemctl status apache2

Der Hostname bzw. die Server-IP ist im Terminal mit

sudo hostname -I oder ifconfig

abrufbar.

Anmerkung: sollte hostname -I mehrere IP zurückliefern, so liefert der Befehl sudo nmcli -p device show exakte Informationen

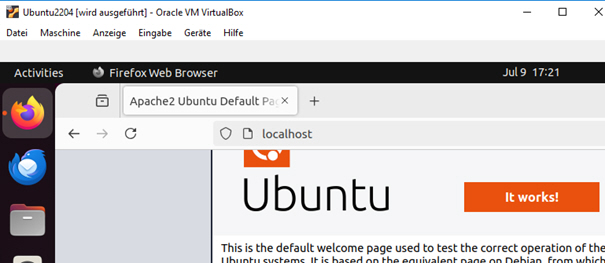

Nun sollte der Web-Server in einem Webbrowser durch Eingabe des Protokolls und einer Domain oder einer IP

http://localhost/ bzw. http://SERVER-IP

erreichbar sein und die default welcome page von Ubuntu aufrufen.

ANMERKUNG: Diese Seite liefert Informationen über die Konfiguration !

Diese Seite ist im Verzeichnis /var/www/html/ unter dem Namen index.html gespeichert und kann mit dem Editor nano bearbeitet werden(s.2.3.1.1)

sudo nano /var/www/html/index.html

2.3.1.1 Der Editor nano

Nano ist ein sehr einfacher Editor der intuitiv zu bedienen ist.

Die Kombinationen mit der STRG Taste sind im unteren Bereich des Editor-Bildschirms mittels ^ dargestellt bzw. M für die ALT-Taste.

Hier ein Link für den raschen Umgang mit nano https://www.howtoforge.de/anleitung/linux-nano-editor-fuer-anfaenger-erklaert-10-beispiele/

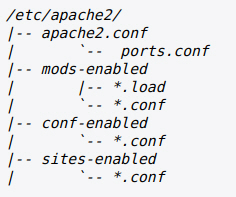

2.3.2 Die Dateistruktur des Apache-Webserver

Nachstehend die Dateistruktur der Konfiguration eines Apache2-Webserver unter Ubuntu.

Die Datei apache2.conf ist die Spitze der Konfigurationsdateien Es beziehts alle in der Struktur nachgelagerten Konfigurationsdateien beim Starten des Webservers ein.

Die Datei ports.conf ist immer in der apache2.conf (mittels include-Anweisung) enthalten. Es wird verwendet, um die zu überwachenden Ports für eingehende Verbindungen zu bestimmen, und diese Datei kann jederzeit angepasst werden.

Die Konfig-Dateien in den Verzeichnissen mods-enabled/, conf-enabled/ und sites-enabled/ enthalten spezielle Konfigurationsausschnitte, die Module, globale Konfigurationsfragmente bzw. virtuelle Hostkonfigurationen. In den *-enabled/ Verzeichnissen stehen die aktivierten Konfigurationen und in den *-available/ Verzeichnissen die editierten Dateien.

Tools wie, a2enmod, a2dismod, a2ensite, a2dissite und a2enconf, a2disconf dienen dem Handlich der Konfigurationsdateien. Detaillierte Informationen findet man in den jeweiligen Man Pages.

Apache2 und wird mit systemd (das ist ein System- und Dienstmanager für Linux) verwaltet Der Befehl systemctl ist das wichtigste Werkzeug zur Verwaltung von

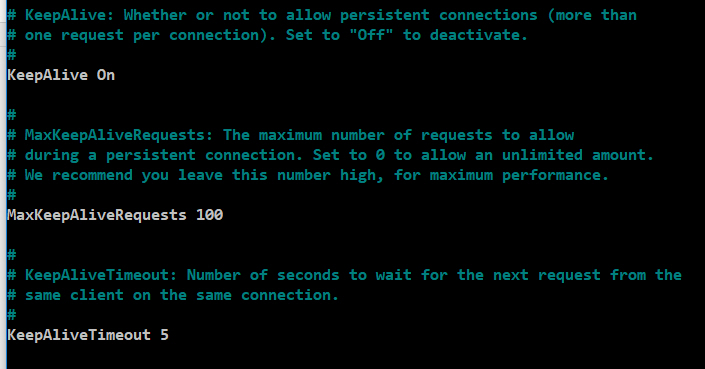

Nachstehende Abbildung zeigt ein Snippet der apache2.conf. Jeder Parameter wurde dabei kommentiert.

2.3.2.1 Wichtige Dateien und Verzeichnisse

Für eine effiziente Bedienung des Apache-Webservers ist es hilfreich, einige häufig gebrauchte Dateien und Verzeichnisse zu kennen:

- /var/www/html: In diesem Verzeichnis stellt Apache standardmäßig Dokumente bereit. Dies kann in den Konfigurationsdateien geändert werden.

- /etc/apache2: Hier werden alle Konfigurationsdateien von Apache aufbewahrt.

- /etc/apache2/apache2.conf: Dies ist die Hauptkonfigurationsdatei. Damit man die die globale Konfiguration ändern.

- /etc/apache2/ports.conf: In dieser Datei sind die geöffneten Ports gelistet. Dies sind in der Regel Port 80 und/oder Port 443.

- /etc/apache2/sites-available/: In diesem Ordner befinden sich eingerichtete virtuelle Hosts. Konfigurationsdateien, die hierin abgelegt werden, müssen mit dem Verzeichnis „site-enabled“ verknüpft werden, damit es funktioniert.

- /etc/apache2/conf-available/, /etc/apache2/conf-enabled/: Diese Verzeichnisse speichern zusätzliche Konfigurationsdateien, die nicht zu virtuellen Hosts gehören. Die Aktivierung der Konfiguration können man mit „a2enconf“ und die Deaktivierung mit „a2disconf“ vornehmen.

- /etc/apache2/mods-available/, /etc/apache2/mods-enabled/: In diesen Verzeichnissen werden verfügbare und aktivierte Module aufbewahrt. Ein Modul kann mit „a2enmod“ aktiviert und mit „a2dismod“ deaktiviert werden.

- /var/log/apache2/access.log: Diese Logdatei zeichnet alle Anfragen an den Webserver auf.

- /var/log/apache2/error.log: In dieser Datei werden alle Fehlermeldungen protokolliert. Die LogLevel-Information gibt den Schweregrad der Ereignisse an.

2.3.3 Anpassen der Firewall

Zuerst die Firewall einschalten:

'''sudo ufw enable

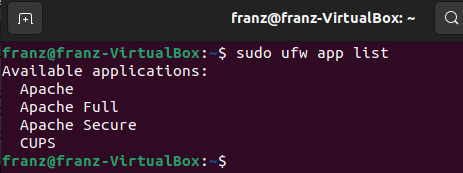

Danach die Anzeige der UFW Applikationen auflisten:

sudo ufw app list

Diese liefert uns drei Profile von Apache:

- Apache: Dieses Profil öffnet nur Port 80 (normaler, unverschlüsselter Webtraffic)

- Apache Full: Dieses Profil öffnet sowohl Port 80 (normaler, unverschlüsselter Webfraffic) als auch Port 443 (TLS/SSL-verschlüsselter Traffic)

- Apache Secure: Dieses Profil öffnet nur Port 443 (TLS/SSL-verschlüsselter Datenfraffic)

Da noch kein SSL für den Server konfiguriert wurde, wird der Datenverkehr auf Port 80 mit nachstehendem Befehl zugelassen:

sudo ufw allow apache

Nun wird der Status auch überprüft:

sudo ufw status

2.3.4 Verzeichnisstruktur für den Web-server

Der erste Schritt besteht darin, eine Verzeichnisstruktur zu erstellen, welche die Website-Dateien enthält,d ie zur Verfügung gestellt werden sollen.

Unter dem Verzeichnis /var/www/html/ wird der Verzeichnisname z.B. shop festgelegt. Für jeden virtuellen Host wird ein eigenes Verzeichnis angelegt um dieses für die Besucher der Site freizugeben.

Innerhalb jedes dieser Verzeichnisse wird ein Verzeichnis public_html. Das public_html-Verzeichnis enthält den Inhalt, der den Besuchern angezeigt wird. Die übergeordneten Verzeichnisse, hier shop und wiki genannt **), enthalten die Skripte und den Anwendungscode zur Unterstützung der Webinhalte.

Befehle um Verzeichnisse zu erstellen:

sudo mkdir -p /var/www/html/shop/public_html

sudo mkdir -p /var/www/html/wiki/public_html

**) es kann auch eine Domain sein z.B. myhomepage.at

2.3.4.1 Berechtigung erteilen

Soll ein normaler Benutzer die Dateien in diesen Webverzeichnissen ändern können, ist die Egentümerschaft mit diesen Befehlen ändernzu :

sudo chown -R $USER:$USER /var/www/html/wiki/public_html

sudo chown -R $USER:$USER /var/www/html/shop/public_html

Anmerkung:Die Variable $USER nimmt den Wert des Benutzers an, als der man gerade angemeldet ist, damit ist der reguläre Benutzer nun Eigentümer der public_html.

Auch die Berechtigungen sind zu ändern, um sicherzustellen, dass Lesezugriff auf das allgemeine Webverzeichnis und alle darin enthaltenen Dateien und Ordner erlaubt ist, damit die Seiten korrekt ausgeliefert werden können:

sudo chmod -R 755 /var/www

Der Webserver verfügt nun über die erforderlichen Berechtigungen, um Inhalte bereitzustellen, und der Benutzer sollte in der Lage sein, Inhalte in den erforderlichen Ordnern zu erstellen.

2.3.4.2 Virtual Host - Webseite

Nachdem eine Verzeichnisstruktur eingerichtet wurde, kann man sich nun auf die einzelnen virtuellen Hostseiten und deren Inhalte konzentrieren. Dazu erstellt man eine Datei

index.html

Anmerkung: es kann auch ein anderer Name wie z.B. test.html sein, aber in der Standardkonfiguration sucht dieser automatisch nach der index.html

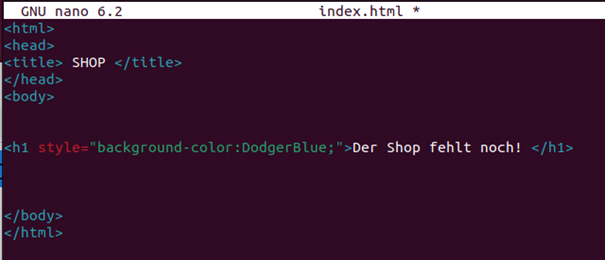

Eine Datei index.html mit einem bevorzugten Texteditor erstellen. Nachstehend wird nano verwendet:

nano /var/www/html/shop/public_html/index.html

In diese Datei ganz werden einfache HTML-Tags für Testzwecke verwendet. Siehe nachstehendes Beispiel:

2.3.4.3 Virtual Host - Konfiguration

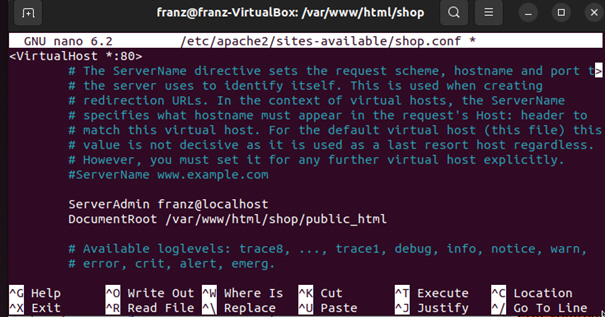

Virtuelle Hostdateien sind jene Dateien, welche die tatsächliche Konfiguration der virtuellen Hosts beschreiben und wie der Apache-Webserver auf verschiedene Domain-Anfragen reagieren soll. Apache wird mit einer Standarddatei für virtuelle Hosts mit dem Dateinamen 000-default.conf ausgeliefert.

Diese Datei ist im Verzeichnis /etc/apache2/sites-available/ zu finden.

Am Besten ist die Standardkonfiguration zu kopieren:

sudo cp /etc/apache2/sites-available/000-default.conf /etc/apache2/sites-available/shop.conf

Somit ist sichergestellt, dass die zusätzlichen Informationen der Originaldatei erhalten bleiben

Die Kopie wurde mit nano editiert und angepasst (siehe ServerAdmin und DocumentRoot).

sudo nano /etc/apache2/sites-available/shop.conf

Erklärung [16] - Beispiel für ein Kursmanagementsystem:

<VirtualHost *:80>

…..…..

DocumentRoot /var/www/html/moodle/course

1 ) <Directory /var/www/html/moodle/course>

2) Options Indexes FollowSymLinks MultiViews

3) AllowOverride All

4) Order allow,deny

5) allow from all

6) Require all granted

</Directory>

……..

1)Der Container <Directory> </Directory> definiert eine Gruppe von Konfigurationsanweisungenfür ein bestimmtes Verzeichnis mit sämtlichen Unterverzeichnissen.

2)Optionen

2a) Wenn eine URL anfordert wird, die auf ein Verzeichnis verweist, und dort keine index.html vorhanden ist, kann mit dieser Option die Reihe von Indizierungsbefehlen verwendet werden, und es wird eine formatierte Liste zurückgegeben

2b) FollowSymLinks ist eine Direktive der Webserver-Konfiguration, die den Webserver anweist, so genannten symbolischen Links zu folgen. Wie zu erwarten, ist FollowSymLinks ein Akronym für Follow Symbolic Links. FollowSymLinks ist eine sehr wichtige Einstellung, die eine Rolle für die Sicherheit derWebsite spielt.

2c) Die beste Darstellung einer Ressource auf der Grundlage der vom Browser angegebenen Präferenzen für Medientyp, Sprachen, Zeichensatz und Kodierung auswählen.

3) Wenn diese Anweisung auf All gesetzt wird, dann ist jede Direktive in den .htaccess-Dateien erlaubt.

4)Die Reihenfolge allow,deny sagt Ihrem Webserver, dass die Allow-Regeln vor den Deny-Regeln verarbeitet werden. Wenn der Client nicht auf die Allow-Regel oder auf die Deny-Regel zutrifft, wird dem Client der Zugriff verweigert.

5) Der Apache liefert jede Datei ohne Einschränkung aus (Apache 2.x)

6) Der Apache liefert jede Datei ohne Einschränkung aus (Apache 2.4)

2.3.4.4 Virtual Host - Aktivieren der neuen Datei /ausschalten der alten Datei

Zuerst deaktivieren wir die „alte“ Config-Datei:

sudo a2dissite 000-default.conf

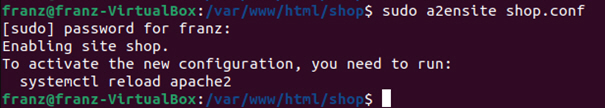

Nachdem nun die virtuelle Hostdatei erstellt wurde, muss diese aktiviert werden.. Der Apache-Server enthält einige Werkzeuge, mit denen dies gemacht wird.

Das Tool a2ensite wird verwendet, um eine Site zu aktivieren. Details dazu ist in den man pages im Terminal nachzulesen.

man a2ensite

Anmerkung: man pages gibt es zu vielen Themen

Den folgenden Befehl verwenden, um die virtuellen Host-Site zu aktivieren:

sudo a2ensite shop.conf

Die Information weist darauf hin den Apache zu reloaden:

sudo systemctl reload apache2

Danach wird zu Sicherheit die Konfiguration getestet:

sudo apache2ctl configtest

um Syntax OK zu erhalten.

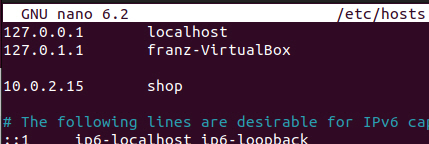

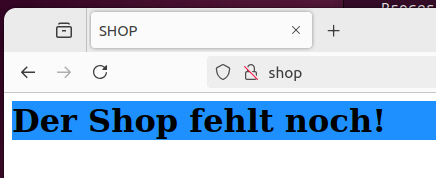

Annahme: shop ist eine Domain. Damit diese im Webbrowser aufgerufen werden kann ist zu Testzwecken die Datei hosts zu editieren:

sudo nano /etc/hosts

Hier wurde der Hostname und die Pseudo-Domain shop hinzugefügt

Einen Restart durchführen und danach den Status kontrollieren

sudo systemctl restart apache2

sudo systemctl status apache2

Am Webclient die Pseudo-Domain shop eingeben, um zu sehen ob alles richtig eingegeben wurde und der Inhalt der Datei index.html angezeigt wird.

2.4 'Installation von XAMPP unter Windows'

XAMPP ist (subjektiv betrachtet) für eine Testumgebung im eigenen Netz dienlich, da es einen sehr einfachen Weg zum eigenen Apache-Webserver ermöglicht..

Betreffend der Installation ist es ratsam, zuerst den Antivieren-Scanner für einige Zeit deaktivieren. Es könnten Fehermeldungen bezüglich Antivirenprogrammen oder UAC (User Account Control) erscheinen, oder zur Vorsicht diese Dienste temporär deaktivieren bis die Installation abgeschlossen ist.

1)Die Installations-Applikation für Windows herunterladen --> fhttps://www.apachefriends.org/de/download.html

2) Selektieren und als Administrator mittels Doppelklick starten

3) Am einfachsten ist es bei der Ausahl der Software-Komponenten alles zu belasse, also den Funktionsumfang mit allen verfügbaren Anwendungen (Web-Server, FTP-Server, Mail-Server) zu implementieren.

4) Auch das Installationsverzeichnis „C:\xampp“ und bestätigen

Anmerkung: Hinsichtlich Re-Installation das Verzeichnis löschen oder umbenennen

5) Sollten wärend der Installation, Berechtigungsabfragen des Betriebssystems erscheinen, die gewünschte Genehmigung erteilen.

Im Web sind zahlreiche Installationsanleitungen zu finden z.B. https://www.ionos.at/digitalguide/server/tools/xampp-tutorial-so-erstellen-sie-ihren-lokalen-testserver/

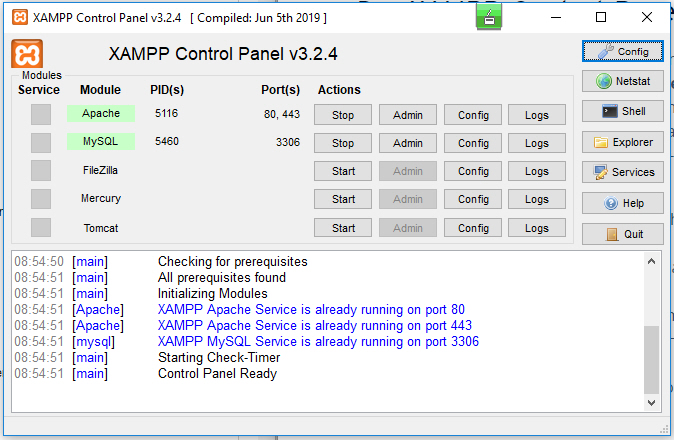

6) Die Applikation zum Starten des Controlpanel ist C:\xampp\xampp-control.exe

In der Abbildung wurden Webserver und Datenbankmanagementsystem korrekt gestartet. Sollt sich links neben dem Modulname ein X befinden, einfach mittels Doppelklick nachinstallieren

7) In der Befehlszeile des Webbrowser localhost eingeben und die Standardapplikation, das Dashboard von Achache Friends wird gestartet

[File:14XAMPPwin.jpg]]

2.4.1 Konfiguration - Änderung

Sollte z.B.ein Port belegt sein und der Webserver startet nicht, kann dieser geändert werden .

Beispiel:

a) In der Zeile von apache auf „Config“ klicken und die Option Apache(httpd.conf) auswählem

b) in der Konfig-Datei "Listen" suchen

Hier wurde localhost der Port 80 zugeweisen und der lokalen Netzwerkkarte, für z.B. das Heimnetz der Port 81

A merkung: Beim Aufruf muss Port 80 nicht angegeben werden.

[File:15XAMPPallg.jpg]]

WICHTIG: Nach einer Konfigurationsänderung den Webserver stoppen und starten

3 Sichere Bereitstellung des Webserver

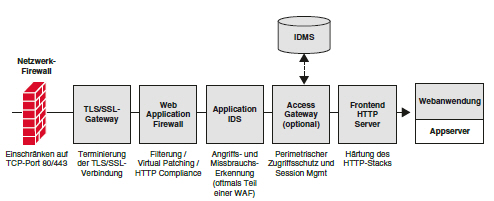

Die Sicherheitsarchitektur einer über das Internet (oder jedes andere nicht-vertrauenswürdige Netzwerk) erreichbaren Webinfrastruktur setzt sich aus verschiedenen funktionalen Komponenten zusammen, denn auch eine Webanwendung, die selbst keinerlei Schwachstellen besitzt, kann schnell von einem Angreifer kompromittiert werden, wenn die zugrunde liegende Plattform Sicherheitsmängel besitzt. Gleichzeitig lassen sich auch auf Plattformebene eine ganze Reihe weiterer Sicherheitsmechanismen implementieren, mit denen sich die darauf ausgeführten Anwendungen zusätzlich schützen lassen. [13]

Nachstehend eine mögliche allgemeine Architektur hinsichtlich Sicherheit:

Eine Web Application Firewall, betreffend der Umsetzung unterschiedlicher Sicherheitsfunktionen: z. B. Input Validation, Virtual Patching, Application Intrusion Detection System etc.

- SSL/TLS-Gateway hinsichtlich der Terminierung der SSL/TLS-Verschlüsselung; oftmals Bestandteil einer Web Application Firewall, eines Webservers oder eines Loadbalancers

- Access Gateway zur Authentifizierung und Zugriffskontrolle zur Absicherung interner Programme und zur Vorschaltung einer Mehrfaktorauthentifizierung

- Vorgelagerter Frontend-Webserver zur Sicherstellung von HTTP-Compliance,

URL-Accsess Control, HTTP-Headern setting, etc. [13]

3.1. SSL/TLS-Zertifikat

TLS-Zertifikate (Transport Layer Security)-Zertifikate und SSL-Zertifikate (Secure Sockets Layer) sind unverzichtbar, um mithilfe von Verschlüsselung sichere Verbindungen zu einem Browser zu ermöglichen und dort Transaktionen abzusichern. TLS/SSL ist der Standard der Sicherheitstechnik, der im Hintergrund für die Absicherung Ihrer Online-Transaktionen und Anmeldevorgänge sorgt. Und so funktioniert er:

Für den Endanwender unsichtbar läuft ein Prozess namens „TLS/SSL-Handshake“ ab und erzeugt nahezu ohne Zeitverzug eine geschützte Verbindung zwischen Ihrem Webserver und dem Web-Browser, über den die Website aufgerufen wird. Bei Websites, die von einem TLS/SSL-Zertifikat geschützt sind, werden das Kürzel HTTPS und ein kleines Schloss-Symbol in der Adresszeile des Browsers angezeigt. TLS/SSL-Zertifikate dienen dazu, sowohl die Daten des Endanwenders bei der Übertragung zu schützen als auch die Identität des zur Website gehörenden Unternehmens zu überprüfen, damit der Anwender sicher sein kann, dass er auch wirklich die Website des legitimen Eigentümers besucht.

Damit ein SSL-Zertifikat auf einer Webseite installiert werden kann muss es zunächst von einer Zertifizierungsstelle, dem Anbieter, validiert werden. Auf SSL.de bieten wir Ihnen viele verschiedene SSL-Zertifikate von verschiedenen Anbietern. Zum Beispiel sind Comodo, Thawte, RapidSSL, GeoTrust Symantec u.v.m. solche Zertifizierungsstellen (CA) bzw.freie**) wie Let’s Encrypt https://letsencrypt.org/de/getting-started/

**) Jeder, der einen Domainnamen besitzt, erhält sichere Zertifikate kostenfrei.

Kategorien von SSL-Zertifikaten

Bei Domain-validierten SSL Zertifikaten (DV) prüft der Herausgeber nur, ob der Antragsteller die Domain besitzt. Beispielsweise sendet er eine Test-Mail, um zu schauen, ob die E-Mail-Adresse des Antragstellers mit der in der Whois-Datenbank eingetragenen E-Mail-Adresse übereinstimmt. Die Whois-Liste ist eine Datenbank, die einem Telefonbuch ähnelt. Sie enthält Informationen zu den existierenden Domains und ihren Inhabern. Hat die Webseite ein Domain-validiertes SSL-Zertifikat erhalten, erscheint in der Browserleiste ein Schloss.

Bei Organisation-validierten SSL Zertifikaten (OV) überprüft die ausstellende Organisation auch das Unternehmen, das die Domain besitzt. Dafür benötigt man in der Regel Dokumente wie den Handelsregisterauszug oder die Gewerbeanmeldung.

Die Extended-Validation Zertifizierung (EV) ist die aufwändigste SSL-Zertifizierung und bestimmten Zertifizierungsstellen vorbehalten. Hier verifiziert der Herausgeber nicht nur das Unternehmen, sondern auch die Identität der Geschäftsführer. Auch prüft er, ob der Antragsteller befugt ist, das SSL-Zertifikat im Namen des Unternehmens zu beantragen.

Hauptzweck eines SSL-Zertifikats ist die Authentifizierung der Webseite. Dafür enthält es folgende Daten:

Domain-Name der Webseite, für die das Zertifikat erstellt wurde, und wer sich hinter dem Namen verbirgt.

Namen und digitale Signatur der Organisation, die das Zertifikat erstellt hat.

Ausstellungs- und Verfalldatum des Zertifikats.

Public Key, der zur Webseite gehört, damit eine asymmetrisch verschlüsselte Verbindung (Public-Private-Key Verschlüsselung) aufgebaut werden kann.

Je nach Art des SSL-Zertifikats auch mit der Hauptdomain verknüpfte Subdomains und Informationen über das Unternehmen, dem die Webseite gehört.

3.2 dynDNS

Dynamic DNS (DDNS oder dynDNS) ist ein Dienst , der DNS-Einträge automatisch[RFC2136] aktualisieren kann, wenn sich eine IP-Adresse ändert. Domänennamen konvertieren Netzwerk-IP-Adressen in menschenlesbare Namen, um diese leichter erkennen und verwenden zu können. Die Informationen, die den Namen der IP-Adresse zuordnen, werden tabellarisch auf dem DNS-Server aufgezeichnet. Netzwerkadministratoren weisen IP-Adressen jedoch dynamisch zu und ändern diese häufig. Ein DDNS-Dienst aktualisiert die DNS-Servereinträge jedes Mal, wenn sich IP-Adressen ändern. Mit DDNS wird die Domänennamenverwaltung einfacher und effizienter. In der Vergangenheit waren IP-Adressen statisch und änderten sich selten. Aufgrund der Ausbreitung des Internets und der massiven Zunahme der Anzahl von Servern, intelligenten Sensoren und Endgeräten kam es jedoch zu einem Mangel an IP-Adressen. Um die Anzahl der IP-Adressen zu erhöhen, wurde ein neues System namens IPv6 eingeführt. Die Zuweisung statischer IP-Adressen war jedoch nicht mehr kosteneffizient. Stattdessen verwenden Netzwerkadministratoren das Dynamic Host Configuration Protocol (DHCP), um IP-Adressen dynamisch zuzuweisen.Die meisten WLAN-Router bzw. DSL-Router bieten eine solche Option an. [31]

3.2.1 Vorteil - dynDNS

Mit Dynamic DNS kann man remote auf interne Netzwerkressourcen wie Dateiserver, Webserver oder Remotedesktopdienste zugreifen. So, der Vorteil, können z.B. Mitarbeiter über einen Domänennamen, der mit der wechselnden IP-Adresse verknüpft ist, außerhalb des Netzwerks ihrer Organisation auf diese Ressourcen zugreifen. Dies ist besonders nützlich für Organisationen mit Remote-Mitarbeitern, Zweigstellen oder Mitarbeitern, die unterwegs sind. Eine statischen IP-Adresse für das Hosting ist teuer bzw. ergibt für Testzwecke**) wenig Sinn. Startups in der Anfangsphase und kleine Unternehmen verwenden dynamisches DNS, um Dienste oder Anwendungen auf der internen Infrastruktur zu hosten. Damit kann man Websites, FTP-Server, Spieleserver oder andere Dienste hosten, die einen konsistenten und zugänglichen Domänennamen erfordern.

**) Z.B.. No-IP bietet sowohl kostenlose(2024) als auch kostenpflichtige Dienste an: https://my.noip.com/

1. Allgemein

Die Skalierbarkeit und der Lastausgleich sind zwei entscheidende Aspekte in It-Systemen. Skalierbarkeit bezieht sich auf die Fähigkeit eines Systems, mit steigender Last oder Anforderungen umzugehen, ohne dass die Leistung beeinträchtigt wird. D.h. die IT-Infrastruktur ist ggf. flexibel anzupassen und zu erweitern, um mit dem Wachstum und den Anforderungen an die IT Schritt zu halten.Skalierbarkeit bezeichnet die Fähigkeit eines Systems, wachsende quantitative Anforderungen durch Hinzuügen von Ressourcen auszugleichen, ohne dasseine Änderung von Systemkomponenten notwendig wird. Zentrale Lösungen stoßen hier in der Regel schnell an ihre Grenzen( .z.B.Bestell- oder Buchungssysteme) [11]

Der Lastausgleich hingegen verteilt die Arbeitslast gleichmäßig auf mehrere Ressourcen, um die Leistung und Verfügbarkeit zu verbessern und Ausfälle zu vermeiden.

1.1 Skalierung

- Skalierung von einem Serversystem ist notwendig, da der Server ein Bottleneck und Single Point of Failure ist. Ein Client kann bei Systemen mit mehreren Servern auf verschiedene Weisen an die Daten

kommen: [12]

• rekursiv --> Client fragt einen Server, dieser fragt rekursiv andere Server.etc., etc. bis der Zielserver erreicht ist, der Client erhält die Antwort vom befragten Server

• transitiv --> Client bekommt die Antwort direkt vom Zielserver - Server können klassifiziert werden als:

• Proxy --> Schnittstelle zwischen Client und anderen Servern, die die Anfragen cached, geeignet für sich wiederholende Anfragen

• Broker --> Teilt Clients einem Server entsprechend der geforderten Aufgaben zu

– Vorteil: Location/Replication transparency

– Nachteil: Single-Point-Of-Failure

• Trader --> wählt den passenden Server aus, falls mehrere Server denselben Service in unterschiedlicher Qualität anbieten

• Balancer --> Verteilt Workload gleichmäßig auf alle Server

• Agent --> Splittet komplexe Anfragen auf, sendet die simpleren Anfragen an andere Server und kombiniert die Antworten zu einer Antwort

1.1.1 Web-Caching

Web-Caching dient der Skalierbarkeit und bereitet geringe Latenz.Das definierende Merkmal aller Web-Caches ist, dass diese HTTP-Caching-Metadaten transparent als Read-Through-Caches interpretieren. Das bedeutet, dass bei einem Cache-Miss die Anfrage an den nächsten Cache oder den Ursprungsserver

weitergeleitet und dann die Antwort gemäß der bereitgestellten TTL zwischengespeichert wird. Web-Caches leiten immer Schreibanfragen weiter, da diese in Form von undurchsichtigen POST, PUT und DELETE-Anfragen kommen, deren Semantik implizite Eigenschaften einer REST/HTTP-API sind.

Globale Netze von Web-Caches können in CDNs auf Inter-Cluster Austausch hinsichtlich Geo-Replikation vertrauen. In der Praxis nutzen CDN-Anbieter die Tatsache, dass eine Cache-Suche nach einer URL gut zu einer Schlüssel-Wert-Schnittstelle passt. Dies ermöglicht das Skalieren von Cache-Clustern, indem Web-Caches als Proxy auf einem verteilten Key Value gespeichert bereitgestellt werden.[13

1.2 Loadbalancing (Lastenausgleich)

Ein Load Balancer verteilt die Arbeitslast Ihres Systems auf mehrere Einzelsysteme oder eine Gruppe von Systemen, um die Belastung eines einzelnen Systems zu verringern, was wiederum die Zuverlässigkeit, Effizienz und Verfügbarkeit Ihrer Unternehmensanwendung oder Website erhöht.

Er fungiert als Vermittler/Regler, der vor den Servern sitzt und Anfragen an alle Server weiterleitet, die in der Lage sind, diese Anfragen in einer Weise zu erfüllen, welche die Geschwindigkeit und die Kapazitätsauslastung maximieren und sicherstellen. Somit wird sichergestellt, dass kein einzelner Server überlastet wird, und die Performance beeinträchtigt werden könnte.

Falls ein einzelner Server ausfällt, leitet der Load Balancer den Datenverkehr auf die verbleibenden Online-Server um. Wenn ein neuer Server zur Servergruppe hinzugefügt wird, beginnt der Load Balancer automatisch, Anfragen an ihn zu senden.

Load Balancer verwenden Algorithmen wie Round-Robin, Sticky Sessions und inhaltsbasiertes Routing, um den Datenverkehr zu verteilen. Dadurch wird sichergestellt, dass kein einzelner Server mit Anfragen überlastet wird, was zu einer verbesserten Leistung und Skalierbarkeit führt.

Die aufgaben des Load Balancer:

- a) Verteilt Client-Anfragen bzw.r die Netzwerklast effizient auf einen weiteren oder mehrere Server.

- b) Überwacht den Zustand, die Verfügbarkeit und die Ausfallzeiten der Server

- c) Sorgt für hohe Verfügbarkeit und Zuverlässigkeit, indem er Anfragen nur an Server sendet, die online sind.

- d) Bietet die Flexibilität, je nach Bedarf Server hinzuzufügen oder zu entfernen

Vorteile des Lastausgleichs:

- Verringerung der Arbeitslast auf einem einzelnen Server.

- Durch Gleichzeitigkeit wird eine größere Menge an Arbeit in der gleichen Zeit erledigt.

- Gesteigerte Leistung Ihrer Anwendung durch schnellere Reaktion.

- Kein einzelner Ausfallpunkt. In einer Umgebung mit Lastausgleich ist die Anwendung bei Ausfall eines Servers immer noch verfügbar und wird von den anderen Servern im Cluster bedient.

- Wenn ein geeigneter Lastausgleichsalgorithmus verwendet wird, führt dies zu einer optimalen und effizienten Nutzung der Ressourcen, da das Szenario, dass einige Serverressourcen mehr genutzt werden als andere, vermieden wird.

- Skalierbarkeit: Wir können die Anzahl der Server im laufenden Betrieb erhöhen oder verringern, ohne die Anwendung zu beeinträchtigen.

- Lastausgleich erhöht die Zuverlässigkeit Ihrer Unternehmensanwendung

- Erhöhte Sicherheit, da die physischen Server und IPs in bestimmten Fällen abstrakt sind.

Es gibt zwei Arten von Load Balancern, die unterschiedliche Planungsalgorithmen und Routing-Mechanismen implementieren.

Der Software Load - Balancer läuft auf virtuellen Maschinen (VMs) oder White-Box-Servern, meist als Application-Delivery-Controller-Funktion (ADC). ADCs bieten in der Regel zusätzliche Funktionen, darunter Caching, Komprimierung und Traffic Shaping. Der in Cloud-Umgebungen beliebte virtuelle Lastenausgleich bietet ein hohes Maß an Flexibilität. Er ermöglicht es den Benutzern beispielsweise, den Datenverkehr automatisch nach oben oder unten zu skalieren, um Verkehrsspitzen oder einen Rückgang der Netzwerkaktivität zu spiegeln.

Der Hardware - Load-Balancer ist ein Gerät mit spezieller und meist proprietär integrierter Software, welche zum Bewältigen großer Datenmengen des Anwendungsverkehrs ausgelegt ist. Diese Art des Load Balancer verfügt u.a. über eine Virtualisierungsfunktion und ermöglicht die Verwendung von Instanzen eines virtuellen Load Balancers.

2. Verwendung von Reverse Proxies und Content Delivery Networks (CDNs)

2.1 Reverse Proxy

Reverse Proxies fungieren als Vermittler zwischen Clients und Webservern, verbessern die Leistung von Websites durch Caching und bieten zusätzliche Sicherheit, indem diese die IP-Adresse des Ursprungs-Servers verbergen.

Ein Reverse Proxy ist ein Server, der sich zwischen das Internet und einen Webserver schaltet, Anfragen von Clients entgegennehmen und sie an den entsprechenden Server weiterleitet. Dies kann in verschiedenen Situationen nützlich sein, z. B. wenn man mehrere Webserver hat, die unterschiedliche Arten von Inhalten anbieten (z. B. statische Dateien gegenüber dynamischen Inhalten), oder wenn diese die SSL-Verschlüsselung vom Webserver auf den Reverse-Proxy verlagern wollen.

Einer der Hauptvorteile eines Reverse-Proxys besteht darin, dass er die Leistung einer Website verbessern kann, indem er häufig angeforderte Inhalte zwischenspeichert und die direkt ausliefert, ohne diese vom Webserver anfordern zu müssen. Dies kann die Belastung des Webservers erheblich verringern und die Antwortzeiten für die Kunden verbessern.

=== 2.1.1 Funktionsweise ===

Wenn ein Client eine Anfrage für den Zugriff auf eine Website sendet, durchläuft dieser zunächst den Reverse Proxy. Der Proxy prüft in seinem Zwischenspeicher, ob er den vom Client angeforderten Inhalt bereits hat. Ist dies der Fall, kann er den Inhalt direkt an den Client ausliefern. Ist dies nicht der Fall, leitet er die Anfrage an den Ursprungsserver weiter, um die Inhalte abzurufen. Sobald der Inhalt abgerufen wurde, speichert der Reverse-Proxy ihn im Zwischenspeicher, so dass künftige Anfragen schneller bedient werden können.

Reverse Proxys können auch dazu verwendet werden, den Datenverkehr auf mehrere Server zu verteilen. Dieser Prozess wird als Lastausgleich bezeichnet und ist ein wesentlicher Bestandteil der Netzwerkarchitektur.

Darüber hinaus kann ein Reverse-Proxy auch zusätzliche Sicherheit bieten, indem er die IP-Adresse des Ursprungs-Servers verbirgt und vor DDoS-Angriffen schützt. Indem er als Schutzschild zwischen dem Internet und dem Webserver fungiert, kann der Reverse-Proxy Angreifer daran hindern, direkt auf den Webserver zu zielen und möglicherweise sensible Daten zu kompromittieren.

2.2 Reverse-Proxy Funktionen versus Load-Balancer Funktionen

- Hochverfügbarkeit sowie Skalierbarkeit

Einer der Hauptvorteile von Load Balancern besteht darin, dass sie den Datenverkehr und die Ressourcen auf mehrere Server verteilen können, was die Skalierung bei Bedarf erleichtert. Dies ist besonders nützlich in Umgebungen, in denen ein hohes Verkehrsaufkommen zu bewältigen ist. Reverse Proxies hingegen sind nicht für eine einfache Skalierung ausgelegt, da sie den Datenverkehr im Allgemeinen an einen einzigen Server leiten. Sie können jedoch häufig angeforderte Inhalte im Cache speichern, um die Leistung zu verbessern.

One of the main benefits of load balancers is their ability to distribute traffic and resources across multiple servers, making it easier to scale up as needed. This is particularly useful in environments where there is a high volume of traffic that needs to be handled. Reverse proxies, on the other hand, are not designed for easy scaling since they generally direct traffic to a single server. However, they can still cache frequently requested content to improve performance.

- SSL-Terminierung

Sowohl Load Balancer als auch Reverse Proxies können die SSL-Terminierung durchführen, bei der SSL-verschlüsselter Datenverkehr entschlüsselt und an den entsprechenden Server weitergeleitet wird. In einer Load-Balancing-Umgebung kann die SSL-Terminierung auf dem Load Balancer durchgeführt werden, während in einer Reverse-Proxy-Umgebung die SSL-Terminierung in der Regel auf dem Proxy-Server selbst erfolgt.

- Security

Load Balancer und Reverse Proxys können beide zum Schutz vor DDoS-Angriffen beitragen, aber Reverse Proxys haben den zusätzlichen Vorteil, dass diese Anonymität bieten. Sie können nämlich die IP-Adresse des Ursprungs-Servers verbergen, indem diese den gesamten externen Datenverkehr zunächst an den Reverse-Proxy weiterleiten. Dadurch wird es für Angreifer schwieriger, den Ursprungsserver zu identifizieren.

- Datenverkehr im Netz

Nochmals die bereits erwähnten Fakten. Die Hauptfunktion eines Load Balancer darin, den Netzwerkverkehr gleichmäßig auf mehrere Server zu verteilen. Dies ist besonders in Umgebungen nützlich, in denen mehrere Server ein hohes Verkehrsaufkommen bewältigen müssen. Reverse Proxies hingegen sind darauf ausgelegt, Inhalte zwischenzuspeichern und diese effizient an die Clients zu liefern. Daher eignen sie sich besser für die Bearbeitung von Anfragen nach statischen Inhalten von einem einzigen Server.

2.3 Apache Webserver als Reverse Proxy

Der Apache HTTP Server bietet eine breite Palette von Modulen und Erweiterungen, die speziell für die Unterstützung verschiedener Proxy-Funktionen entwickelt wurden.

Mit dem Modul mod_proxy kann der Apache-Webserver als Reverse-Proxy fungieren, indem er Anfragen an einen anderen Server weiterleitet und die Antwort an den Client zurückgibt. Dies erweist sich als nützlich in Szenarien, in denen mehrere Webserver vorhanden sind und die Arbeitslast auf diese verteilt werden muss. Es verbessert die Leistung und baut eine Hochverfügbarkeitsarchitektur für die Web-Infrastruktur auf.

Apache mod_proxy besteht aus mehreren Modulen, von denen jedes seine eigene Funktionalität hat. Hier sind einige der wichtigsten Module:

- mod_proxy: Stellt die Kernfunktionalität des Reverse-Proxys bereit und leitet Anfragen an einen anderen Server weiter.

- mod_proxy_http: Bietet Proxy-Funktionalität für HTTP- und HTTPS-Protokolle.

- mod_proxy_ftp: Bietet Proxy-Funktionen für das FTP-Protokoll.

- mod_proxy_connect: Für SSL-verschlüsselte Verbindungen.

- mod_proxy_ajp: Dient der Weiterleitung von Anfragen an AJP-fähige Anwendungsserver.

- mod_proxy_wstunnel: Für die Verwendung von Web-Sockets

- mod_proxy_balancer: Bietet Lastausgleichsfunktionen.

- mod_cache: Unterstützt verschiedene Cache-Methoden.

- mod_headers: Zur Änderung von HTTP-Header-Zeilen.

- mod_deflate: Komprimiert HTTP-Antworten.

2.4 Content Delivery Network

Ein Content Delivery Network (CDN) ist ein System von Servern, welches via verschiedener Rechenzentren weltweit verteilt(vgl. Adrew. S Tanenbaum - Distributed Systwms) sind. EinProxy-Server-Netzwerk ist optimal, um die Reichweite von Webseiten zu erhöhen. Die Verwendung eines solchen Netzwerks bedeutet, dass ein Webserver in Verbund mit einigen/vielen Servern verbunden ist. Mit Hilfe eines Verteilungssystems können die statischen Inhalte des Webserver auf Replikationsserver übertragen werden. Ein Anforderungsroutingsystem bestimmt, welcher Replikationsserver im CDN am Besten dafür geeignet ist, um die Daten/Dateien rasch auszuliefern, wenn Benutzer auf bestimmte Inhalte Ihrer Website zugreifen. Je nach Anbieter unterscheiden sich CDNs in mehreren Punkten: Die Verteilung und Anzahl der Server sowie der Grad der Integration leistungsstarker Backbone-Netzwerke sind nur einige Beispiele dafür, wie sie sich unterscheiden können.

Der Hauptzweck eines CDN besteht darin, die Latenzzeit zu verringern und die Zeit zu minimieren, die es dauert, bis die Inhalte die Nutzer erreichen. Dies wird durch die Platzierung von Servern in mehreren Datenzentren auf der ganzen Welt erreicht, die sich strategisch in der Nähe der wichtigsten Internetaustauschpunkte befinden. Wenn ein Benutzer Inhalte anfordert, leitet das CDN die Anforderung an den Server weiter, der dem Benutzer geografisch am nächsten liegt, wodurch die Entfernung, die die Daten zurücklegen müssen, verringert und somit die Antwortzeiten verbessert werden. CDNs tragen auch dazu bei, die Last auf Webservern zu verteilen, indem sie Inhalte in ihrem Netzwerk zwischenspeichern und vervielfältigen. Wenn Inhalte angefordert werden, kann der CDN-Server, der dem Nutzer am nächsten ist, die zwischengespeicherte Version der Inhalte bereitstellen, anstatt diese jedes Mal vom Ursprungsserver abzurufen. Dadurch wird der Ursprungsserver entlastet und die Skalierbarkeit verbessert. Darüber hinaus bieten CDNs weitere Funktionen wie Lastausgleich, SSL/TLS-Terminierung, DDoS-Schutz und Sicherheitsmaßnahmen zum Schutz vor bösartigen Angriffen. Sie können die Bereitstellung von Inhalten optimieren, indem sie Dateien komprimieren, Code minifizieren und Techniken wie Bildoptimierung und Browser-Caching nutzen. Durch den Einsatz eines CDN können Websites und Anwendungen von einer verbesserten Leistung, schnelleren Seitenladezeiten, höherer Verfügbarkeit und besserer Skalierbarkeit profitieren. Sie sind besonders nützlich für Websites mit einem globalen Publikum oder solchen, die große Mengen an medienintensiven Inhalten bereitstellen. [16]

Der Originserver in einem CDN dient als zentrales Repository für die Originalinhalte und interagiert mit der CDN-Infrastruktur, um Inhalte bereitzustellen und zu aktualisieren. Er spielt eine wichtige Rolle bei der Bereitstellung von Inhalten, bei Caching-Richtlinien, bei der Ungültigkeitserklärung von Inhalten und bei der Handhabung der dynamischen Inhaltsgenerierung. Der Originserver arbeitet mit den Edge-Servern im CDN zusammen, um eine effiziente und zuverlässige Bereitstellung der Inhalte für die Endbenutzer zu gewährleisten.

2.4.1 Originserver in CDNs

In einem Content-Delivery-Network (CDN) ist der Originserver, sprich der Ursprungsserver, der zentrale Server, auf dem das Original oder die maßgebliche Kopie des Webinhalts gespeichert ist. Der Originserver spielt eine entscheidende Rolle bei der Bereitstellung von Inhalten und interagiert mit der CDN-Infrastruktur.

2.4.1.1 Aufgaben/Funktion des Origin

Quelle der Inhalte: Der Originserver ist die Hauptquelle der Inhalte, die über das CDN verbreitet werden. Er speichert die Originaldateien, z. B. HTML-Seiten, Bilder, Videos, Skripte und andere Medieninhalte, aus denen eine Website oder Anwendung besteht.

Verteilung von Inhalten: Wenn ein CDN eine Inhaltsanforderung erhält, prüft es, ob der angeforderte Inhalt im Cache des Edge-Servers verfügbar ist, der dem Benutzer am nächsten ist. Wenn der Inhalt im Cache nicht verfügbar oder abgelaufen ist, holt das CDN den Inhalt vom Originserver ab.

Bereitstellung von Inhalten: Der Originserver ist dafür verantwortlich, dem CDN die erforderlichen Inhalte zur Verteilung bereitzustellen. Dazu gehört das Hochladen und Aktualisieren der Inhalte auf dem Originserver, sobald Änderungen oder Aktualisierungen auftreten. Die Anbieter von Inhalten interagieren in der Regel direkt mit dem Originserver, um ihre Inhalte zu verwalten.

Caching-Richtlinien: Der Originserver kann Caching-Richtlinien oder -Regeln angeben, die das CDN befolgen soll. Dazu gehören Informationen wie Cache-Kontroll-Header, Cache-Ablaufzeiten und Cache-Validierungsmechanismen. Mit Hilfe der Caching-Richtlinien wird festgelegt, wie lange der Inhalt im Cache der Edge-Server gespeichert werden kann, bevor er vom Originserver aktualisiert werden muss.

Inhaltsvalidierung: Wenn Inhalte auf dem Originserver geändert, aktualisiert oder gelöscht werden, kann der Originserver die Invalidierung der Inhalte im CDN auslösen. Dadurch wird sichergestellt, dass die zwischengespeicherten Kopien des Inhalts auf den Edge-Servern gelöscht und durch die aktualisierte Version ersetzt werden. Dynamisch

Generierung von Inhalten: CDNs eignen sich zwar hervorragend für die Bereitstellung statischer Inhalte, können aber auch dynamische, vom Originserver generierte Inhalte verarbeiten. Dazu gehören Inhalte, die auf der Grundlage von Benutzerinteraktionen oder Echtzeitdaten personalisiert werden. CDNs können mit dem Originserver zusammenarbeiten, um die Bereitstellung dynamischer Inhalte zu optimieren, indem sie Techniken wie Edge-Side Scripting (ESS) oder Dynamic Content Caching einsetzen.

2.4.2 EdgeServer in CDNs

In einem Content-Delivery-Network (CDN) bezieht sich ein Edge-Server auf die Server, die sich am Rande des Netzes befinden, näher an den Endnutzern. Diese Server spielen eine entscheidende Rolle bei der effizienten Bereitstellung von Inhalten und sind eine Schlüsselkomponente der CDN-Infrastruktur.==== 2.3.2.1 Aufgaben/Funktion des Edge: ====

Zweck von Edge-Servern: Der Hauptzweck von Edge-Servern besteht darin, zwischengespeicherte Kopien von Webinhalten zu speichern und den Endnutzern bereitzustellen. Durch die Platzierung von Servern an verschiedenen geografisch verteilten Standorten verringern CDNs die Entfernung zwischen den Inhalten und den Nutzern, wodurch die Latenzzeit minimiert und die Leistung verbessert wird.

Zwischenspeicherung von Inhalten: Edge-Server speichern häufig aufgerufene Inhalte vom Ursprungsserver im Cache. Wenn ein Benutzer Inhalte anfordert, prüft das CDN, ob der Inhalt im Cache des Edge-Servers verfügbar ist. Ist dies der Fall, kann der Edge-Server den Inhalt direkt an den Benutzer liefern und muss ihn nicht erst vom Ursprungsserver abrufen. Dieser Caching-Mechanismus entlastet den Ursprungsserver und verbessert die Antwortzeiten.

Routing: CDNs verwenden intelligente Routing-Algorithmen, um den besten Edge-Server für die Bearbeitung einer Benutzeranfrage zu ermitteln. Dabei werden Faktoren wie der geografische Standort des Benutzers, die Netzwerkbedingungen, die Serverauslastung und die Verfügbarkeit berücksichtigt. Ziel ist es, die Anfrage an den Edge-Server zu leiten, der den Inhalt am effizientesten bereitstellen kann, wodurch die Latenzzeit minimiert und die Leistung maximiert wird.

Lastausgleich: Edge-Server spielen auch eine Rolle beim Lastausgleich innerhalb der CDN-Infrastruktur. CDNs verteilen Benutzeranfragen auf mehrere Edge-Server, um die Ressourcennutzung zu optimieren und Skalierbarkeit zu gewährleisten. Dadurch wird verhindert, dass ein einzelner Server überlastet wird, und es wird sichergestellt, dass der Prozess der Inhaltsbereitstellung effizient und zuverlässig ist.

2.4.3 Routing in CDNs

Die Weiterleitung von Inhalten ist ein wichtiger Aspekt von Content Delivery Networks (CDNs), der bestimmt, wie Benutzeranfragen nach Inhalten an die entsprechenden Edge-Server für eine effiziente Bereitstellung weitergeleitet werden. Content-Routing-Algorithmen helfen bei der Optimierung der Auswahl des am besten geeigneten Edge-Servers auf der Grundlage von Faktoren wie Nähe, Netzwerkbedingungen, Serverauslastung und Verfügbarkeit.

Load-Balancing: CDNs verteilen die Last auf mehrere Edge-Server, um eine effiziente Ressourcennutzung zu gewährleisten. Der Routing-Algorithmus berücksichtigt die aktuelle Last und Verfügbarkeit der Edge-Server und leitet die Anfrage an einen Server mit geringerer Last und höherer Kapazität weiter. Echtzeit-

Zeit-Überwachung: CDNs überwachen kontinuierlich die Leistung und Verfügbarkeit von Edge-Servern. Wenn ein bestimmter Edge-Server Probleme hat oder nicht mehr verfügbar ist, kann der Routing-Algorithmus die Anfragen dynamisch an andere geeignete Server umleiten.

Anycast-Routing: CDNs verwenden häufig Anycast-Routing, eine Technik, die es mehreren Edge-Servern ermöglicht, dieselbe IP-Adresse zu nutzen. Anycast ermöglicht die Weiterleitung von Anfragen an den nächstgelegenen Edge-Server auf der Grundlage der Netzwerktopologie. Wenn ein Benutzer eine Anfrage stellt, wählt die Routing-Infrastruktur den nächstgelegenen Anycast-Node aus und stellt so sicher, dass die Anfrage an den in Bezug auf die Netzwerkentfernung nächstgelegenen Edge-Server geleitet wird.

2.4.4 Caching

In einem Content Delivery Network (CDN) werden Caching-Algorithmen verwendet, um zu bestimmen, welche Inhalte in den Edge-Servern zwischengespeichert werden sollen und wie der Cache verwaltet werden soll. Diese Algorithmen spielen eine entscheidende Rolle bei der Optimierung der Cache-Nutzung, der Sicherstellung der Verfügbarkeit von häufig abgerufenen Inhalten und der Verbesserung der Gesamtleistung des CDN. Im Folgenden werden einige gängige Caching-Algorithmen vorgestellt, die in CDNs verwendet werden:´. Cache ist eine grundlegende Komponente von Content Delivery Networks (CDNs). Im Zusammenhang mit CDNs bezieht sich Caching auf den Prozess der Speicherung von Kopien von Webinhalten auf den Edge-Servern des CDN-Netzwerks.

Nachstehend einige Caching Algorithmen:

Least Recently Used (LRU)

Least Frequently Used (LFU)

First-In-First-Out (FIFO)

Random Replacement

Adaptive Replacement Cache (ARC)

Greedy Dual-Size Frequency (GDSF)

Multi-Level Caching

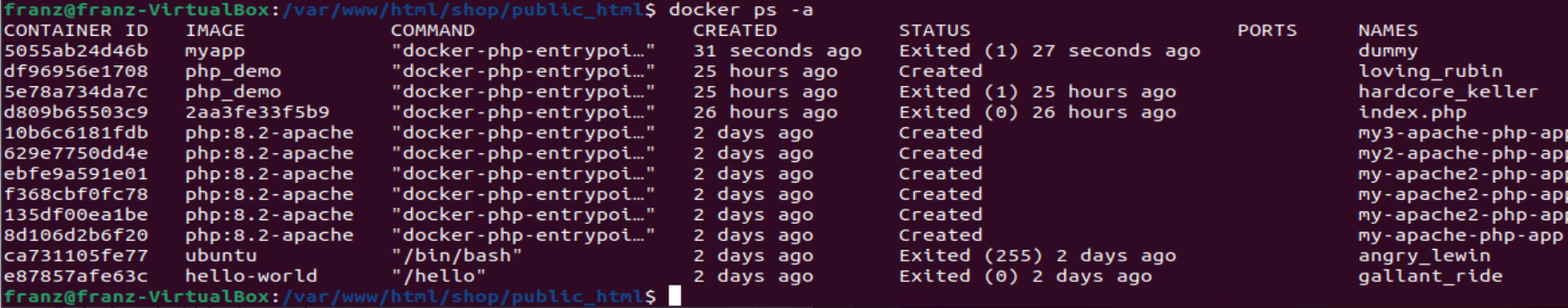

3. Grundlagen von Docker

Docker ist eine zentrale Plattform für das Verpacken, Bereitstellen und Ausführen von Anwendungenund bedients sich des Containering. Containervirtualisierung bzw Containeringist eine Methode, um mehrere Instanzen eines Betriebssystems als Host isoliert voneinander den Kernel des Hostbetriebssystem nutzen zu lassen. Die Idee von Docker ist es, dass Entwickler auf einfache Weise Anwendungen entwickeln und die auf Container packen können, welche dann überall eingesetzt werden können. Die Container stellen sicher, dass unsere Anwendung in jeder Umgebung wie Entwicklung, Test oder Produktion funktioniert Docker ermöglicht es , Software einfach zu installieren und auszuführen, ohne sich um die Einrichtung oder Abhängigkeiten zu kümmern. Docker ist ein Dienst zur Verwaltung von Containern. Die Docker Container sind nicht für die Ausführung von typischen Client-Anwendungen wie Excel oder Word gedacht. In Dockercontainern laufen nur Server-Applikationen, welche über interfaces mit Protokollen interagieren/kommunizieren.[25] Dabei können Anwendungen mit verschiedenen Programmiersprachen, wie Java, PHP. Perl, Ruby, Python, Scala, etc. erstellen und ausführen (siehe das Beispiel unter 3.1.7.2).

Anmerkung: Da Webserver zu 75-80 auf Linux/Unix-Derivaten laufen[4], basieren ggf. darauf nachstehende Beispiele

Die offizielle Website für Docker ist https://www.docker.com/. Die Website enthält alle Informationen und Dokumente über die Docker-Software und auch die Download-Links für verschiedene Betriebssysteme.

ABGRENZUNG zu einer VM siehe Kapitel Docker Container in . 3.1.4.2

'

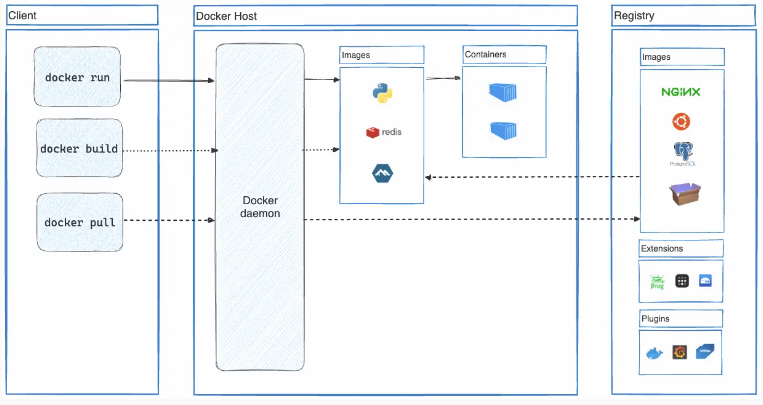

3.1 Die Architektur

Docker folgt der Client-Server-Architektur. Die Archıtektur besteht aus drei Teilen. [26]

- 1) Clıent: Docker stellt dem Client Command Lıne Interface (CLI) Tools zur Verfügung, um mit dem Docker-Daemon zu interagieren. Clıent kann Anwendungen erstellen, ausführen und stoppen. Clıent kann auch aus der Ferne mit dem Dockerhost interagieren.

- 2) Host: Er enthält Contaıner, Images und Docker-Daemon. Er bietet eine vollständige Umgebung für die Ausführung und den Betrieb Ihrer Anwendung.

- 3) Regıstry: Es ist ein globales Reposıtory von Images.

Der Docker-Client kommuniziert mit dem Docker-Daemon, der das Erstellen, Ausführen und Verteilen der Docker-Container übernimmt. Der Docker-Client und -Daemon können auf demgeichen System ausgeführt werden.Der Docker-Client und -Daemon kommunizieren über eine REST-API, über UNIX-Sockets oder eine Netzwerkschnittstelle. Ein weiterer Docker-Client ist Docker Compose, mit demmit Anwendungen gearbeitet werden können, die aus einer Folge von Containern bestehen.

[27]=== 3.1.1 Der Docker-Daemon ===

[27]=== 3.1.1 Der Docker-Daemon ===

3.1.2 Der Docker-Client

3.1.3 Docker-Registry

=

3.1.4 Docker-Objekte

===

==

3.1.4.1 Docker-Image

====

Image-Registrierung

Docker-Images können entweder in öffentlichen oder privaten Registern gespeichert werden, z. B. Azure Container Registry (ACR), Google Container Registry (GCR), Amazon Elastic Container Registry (ECR) und Docker Hub.

Tagging

Ein Repository-Name und ein Tag bilden zusammen eine eindeutige Identifikation für Docker-Images. Tags werden verwendet, um zwischen verschiedenen Image-Versionen zu unterscheiden. Wenn kein Tag angegeben wird, verwendet Docker standardmäßig das neueste“ Tag.

Image Pulling und Pushing

Der Befehl docker pull wird verwendet um Docker-Images von der Registry auf ein lokales System herunterzuladen --> docker push , um Images von einem lokalen Rechner zu einer Registry zu pushen.

Layer-Caching

Zur Leistungsoptimierung verwendet Docker beim Erstellen von Images das Layer-Caching.==

3.1.4.2 Docker Container

====

Ein Container ist eine ausführbare Instanz eines Images. Container können mithilfe der Docker-API oder CLI erstellt, gestartet, gestoppt, verschoben oder gelöscht werden. Er kann sich mit einem oder mehreren Netzwerken verbinden, Speicher an ihn anhängen oder sogar basierend auf dem aktuellen Status ein neues Image erstellen.Standardmäßig ist ein Container relativ gut von anderen Containern und seinem Hostcomputer isoliert und können steuern, wie isoliert das Netzwerk, der Speicher oder andere zugrunde liegende Subsysteme eines Containers von anderen Containern oder vom Hostcomputer sind. Ein Container wird durch sein Image sowie alle Konfigurationsoptionen definiert, die ihm beim Erstellen oder Starten zur Verfügung gestellt/angegeben werden. Wenn ein Container entfernt wird, entschwinden alle Änderungen an seinem Status, die nicht im permanenten Speicher gespeichert sind.

Vorteile von Container: [35]

-- Container nutzen im Vergleich zu virtuellen Maschinen deutlich weniger Systemressourcen, da sie ohne vollständiges Betriebssystem auskommen.

-- Dank der Containerisierung lassen sich Anwendungen mühelos über verschiedeneBetriebssysteme und Hardwareumgebungen hinweg einsetzen.

-- Durch den Einsatz von Containern lassen sich Anwendungen schneller ausrollen,aktualisieren und skalieren.

-- Sie beschleunigen auch den Entwicklungsprozess, und durch die Portabilitätder Images können sie auf jedem Entwicklerrechner ausgeführt werden.

3.1.4.3 Docker-Container Ausführung

Backgroundcontainer - Dafür sind insbesonders Webserver und DB-Server geeignet, da diese über einen "Dauerloop" verfügen. Der vorteil ist, dass ein Programm im Container nich automatisch beendet wird, da socnst auch der Container gestoppt wird Interactivecontainer - Dieser eignet sich zum Testen, da man sich interactiv über das z.B. CLI mit einer Anwendung im Container verbinden kann.

Taskcontainer - Dieser enthält den Code mit sämtlichen Abhängigkeiten, der gekapselt ist und dazu verwendet wird, diesen code auszuführen, In lartext z.B. ein Shellscript befindet, mit ggf. vielen Paketabhängihkeiten, der eine Umgebung aufbaut. Nach der Ausführung wird dieser Container wieder beendet. Der Vorteil dieses Conainer ist, dass er sich gut zur Automatisierung eignet.3.1.5 Docker-Desktop

- Docker Desktop umfasst:

- Docker-Daemon ( dockerd),

- den Docker-Client ( docker),

- Docker Compose,

- Docker Content Trust,

- Kubernetes,

- Credential Helper.

3.1.6 Docker-Netzwerk

Zum Verinden richtet Docker standardmäig drei Neetzwerke ein:

BRIDGE --> es wirch auch manchmal als docker 0 bezeichnet. Darin wird jeder Container, falls nicht anders definiert, eingehängt.

HOST --> ist der Host selbst, er wird direkt an die IP-Adresse gebunden

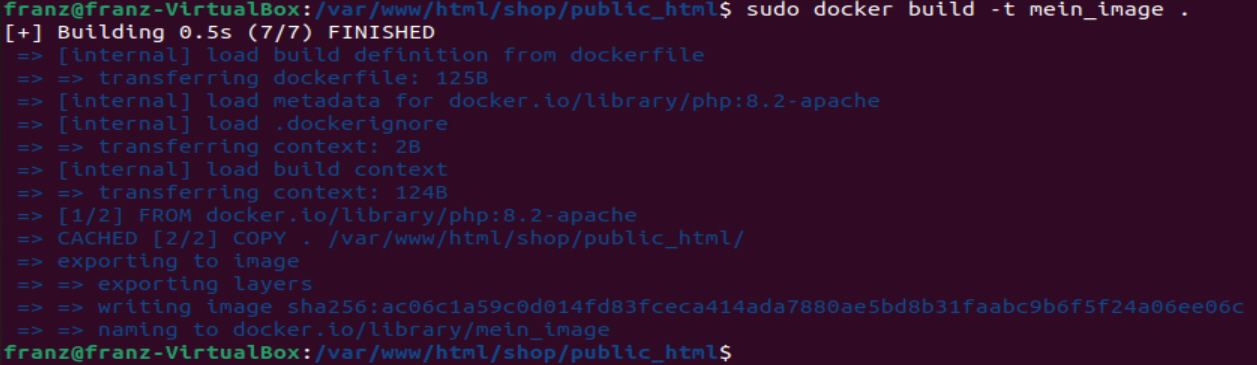

NONE --> ist eigentlich keine Netzwerkverbindung 3.1.7 Docker-File

Docker kann Images automatisch erstellen, indem es die Anweisungen aus einem Dockerfile liest.3.1.7.1 Docker-File Referenz

Diese gibt einen Überblick über die Befehle und Anweisungen [30]

3.1.7.1 Docker-File Referenz

Diese gibt einen Überblick über die Befehle und Anweisungen [30]$count++;

}3) In diesem das Docker-File erstellen mit dem Namen dockerfile

COPY . /var/www/html/shop/public_html/

CMD [ "php", "./index.php"]

Einfache Scripte können auch ohne ein Dockerfile ausgeführt werden docker run -it --rm --name dummy_php_demo -v "$PWD":/var/www/html/shop/public_html -w /var/www/html/shop/public_html php:8.2-cli php index.php

Anmerkung: der Parameter --rm löscht den Container wieder3.1.8 Docker-Hub

Docker Hub ist ein cloudbasierter Repository-Dienst, der von Docker angeboten wird und eine Fülle von Funktionen bietet[31]:

- Centralized Repository − Es ermöglicht die Suche, den Zugriff und die gemeinsame Nutzung von containerisierten Anwendungen und Diensten.

- Vast Library of Images − Es bietet Zugriff auf eine riesige Bibliothek von vorgefertigten Docker-Images. Dazu gehören beliebte Webserver, Datenbanken, Programmiersprachen und Frameworks sowie andere Software und Dienste.

- Open Collaboration − Es fördert eine Umgebung der offenen Zusammenarbeit. Es ermöglicht Entwicklern, ihre eigenen Docker-Images mit der Community zu teilen.

- Automation Tools − Es bietet Tools für die Automatisierung von Build, Test und Bereitstellung von Docker-Images, u.a. Funktionen wie die Integration mit CI/CD-Pipelines für reibungslose kontinuierliche Integrations- und Bereitstellungsabläufe. Darüber hinaus bietet es Unterstützung für automatisierte Builds, die automatisch gestartet werden, sobald Änderungen an einem Repository vorgenommen werden.

- Versioning & Tagging − Es ermöglicht die Versionierung und das Tagging von Docker-Images. Dies vereinfacht die Verwaltung und Verfolgung der verschiedenen Iterationen eines Dienstes oder einer Anwendung im Laufe der Zeit. Dies macht es einfacher, bei Bedarf auf frühere Versionen zurückzugreifen, und garantiert Konsistenz und Reproduzierbarkeit in verschiedenen Umgebungen.

- Access Control & Permissions − verfügt über einige leistungsstarke Funktionen zur Verwaltung von Zugriffskontrolle und Berechtigungen. Damit kann man regeln, wer Docker-Images anzeigen, bearbeiten und freigeben darf. Dies ist vor allem für Teams von Vorteil, die an vertraulichen oder proprietären Anwendungen arbeiten, da so die Sicherheit und Integrität von containerisierten Bereitstellungen gewährleistet werden kann.

- Scalability & Performance − Dieser Cloud-basierter Dienst, ermöglicht eine leistungsstarke Infrastruktur und Skalierbarkeit für das Hosting und die Verteilung von Docker-Images.

Integration - Docker Ecosystem − Es bietet eine einheitliche Plattform für die Entwicklung, den Start und die Überwachung von containerisierten Anwendungen von der Entwicklung bis zur Produktion. Dies geschieht durch die nahtlose Integration in das größere Docker-Ökosystem, das Docker Engine, Docker Compose und Docker Swarm umfasst.

3.1.9 Docker-Compose

In Docker Compose stellt einige grundlegende Konzepte vor. Dazu gehören die Architektur einer in YAML geschriebenen Docker Compose-Datei, Dienste, Netzwerke, Volumes und Umgebungsvariablen. Es ist ein Werkzeug, um die Dienste unserer Anwendung zu konfigurieren. und für die Entwicklung, den Test und die Inszenierung von Umgebungen. Es stellt die folgenden Befehle für die Verwaltung des gesamten Lebenszyklus unserer Anwendung zur Verfügung:

- Starten, Stoppen und Wiederherstellen von Diensten

Anzeige des Status laufender Dienste

Streamen der Protokollausgabe von laufenden Diensten

Ausführen eines einmaligen Befehls auf einem Dienst

- Starten, Stoppen und Wiederherstellen von Diensten

Anmerkung: Hinsichtlich eines konstrktivistischen Ansatzes, gibt es im Web gibt es Anleitungen dazu. So z.B. Ubuntu 22.04 u. Docker --> https://www.digitalocean.com/community/tutorials/how-to-install-and-use-docker-on-ubuntu-22-04

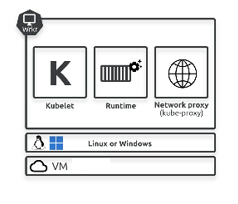

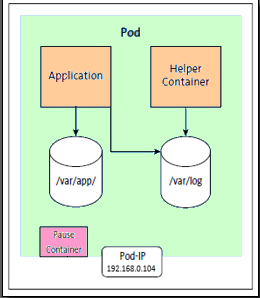

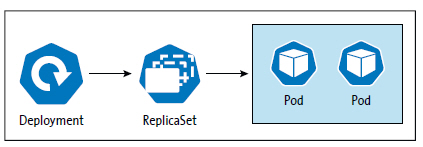

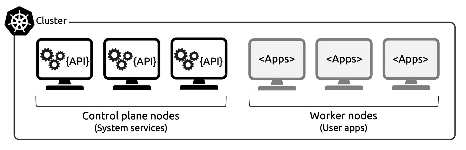

4. Kubernetes

Kubernetes oder kurz k8s, wurde von Google-Ingenieuren auf der Grundlage der Erfahrungen entwickelt, diese beim jahrelangen Betrieb von Containern in großem Maßstab gesammelt haben. Es wurde der Community als Open-Source-Projekt zur Verfügung gestellt und ist heute die Standardplattform für die Bereitstellung und Verwaltung von Cloud-nativen Anwendungen. Es läuft in jeder Cloud und in jedem Rechenzentrum vor Ort und abstrahiert die zugrunde liegende Infrastruktur. Dies ermöglicht den Aufbau hybrider Clouds sowie die Migration in, aus und zwischen verschiedenen Clouds. Es steht unter der Apache 2.0-Lizenz als Open Source zur Verfügung und wird von der Cloud Native Computing Foundation (CNCF) betrieben und verwaltet. Kubernetes ist ein Orchestrator für containerisierte, cloud-native Microservices-Anwendungen. Ein Orchestrator ist ein System oder eine Plattform, die Anwendungen bereitstellt und dynamisch auf Änderungen reagiert. Um eine Microservices-Anwendung zu erstellen, muss jede Funktion als eigene kleine Anwendung entworfen, entwickelt, bereitstellt und verwaltet werden. Diese kleinen Anwendungen werden als Microservice bezeichnet.[28]. Es begann als einfaches Container-Orchestrierungstool, hatsich aber zu einer Cloud-nativen Plattform entwickelt.

Kubernetes ist der "key enabler" für:

Hybride Cloud

Multi-Cloud

Cloud-Migrationen

Kubernetes ist sowohl Cluster, als auch Orchestrator. Bei beiden Typen kann es sich um physische Server, virtuelle Maschinen oder Cloud-Instanzen handeln, und beide können auf ARM und AMD64/x86-64 laufen. Control-Plane-Knoten müssen Linux sein, Worker-Knoten können jedoch Linux oder Windows sein.

4.1 Kubernetes und Docker