Verteilte Systeme - Grundlagen: Unterschied zwischen den Versionen

| Zeile 290: | Zeile 290: | ||

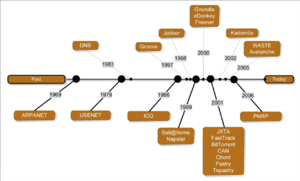

In den 90-er Jahren des letzten Jahrhunderts hat ein Paradigmenwechsel eingesetzt der Peer-to-Peer Systeme den traditionellen Client/Server Lösungen bevorzugte. P2P Systeme sind autonom, skalierbar, dynamisch, anonym, dezentral und selbst-organisierend. Peer-to-Peer Datenverkehr macht mittlerweile mehr als die Hälfte des Internet Verkehrsvolumens aus. | In den 90-er Jahren des letzten Jahrhunderts hat ein Paradigmenwechsel eingesetzt der Peer-to-Peer Systeme den traditionellen Client/Server Lösungen bevorzugte. P2P Systeme sind autonom, skalierbar, dynamisch, anonym, dezentral und selbst-organisierend. Peer-to-Peer Datenverkehr macht mittlerweile mehr als die Hälfte des Internet Verkehrsvolumens aus. | ||

Man unterscheidet heute mindestens drei Generationen von Peer-to-Peer Netzwerken: 1. Generation – zentralisierte P2P Netze, 2. Generation reine P2P und hybrid P2P Netzwerke und 3. Generation – 3. Generation DHT (Distributed Hash Tables) P2P Netzwerke a la Bittorrent. | Man unterscheidet heute mindestens drei Generationen von Peer-to-Peer Netzwerken: 1. Generation – zentralisierte P2P Netze, 2. Generation reine P2P und hybrid P2P Netzwerke und 3. Generation – 3. Generation DHT (Distributed Hash Tables) P2P Netzwerke a la Bittorrent. | ||

Version vom 13. Jänner 2022, 05:32 Uhr

Grundlagen Verteilter Systeme

Ziele der Lektion

- Erkennen, was über die ”bloße“ Verkabelung von Rechnern hinausgeht

- Erfahren, welchen Schwerpunkt Middleware dabei besitzt

- Verteilte Systeme aus Sicht der Systementwicklung beleuchten

- Ermöglichen, ein verteiltes System zu entwickeln

- Tieferes Verständnis für verteilte Systeme entwickeln

- Schwierigkeiten bei der Replikation von Systemen erkennen

Einführung, Konzepte und Technologien

Nach Coulouris et. Al., sozusagen nach der Bibel der Verteilten Systeme kann ein solches definiert werden als:

„Ein Verteiltes System ist ein System in dem (Hardware oder Software) Komponenten in einem Computernetzwerk Ihre Aktionen kommunizieren und koordinieren, einfach durch den Austausch von Nachrichten.“

- Coulouris, Dollimore, Kindberg [1]

oder etwas weniger formell und eher pessimistisch ausgedrückt:

Eine verteiltes System ist eines in dem ich keinerlei Arbeit zustande bringe, weil irgendein mir unbekannter Rechner von dem ich nie gehört habe abgestürzt ist.“

- Leslie Lamport [2]

Verteilte Systeme ergeben sich aus der Notwendigkeit Rechner an unterschiedlichen Standorten miteinender zu verbinden; sie können eingeführt werden, um die Leistung (Performance) eines Server Systems zu erhöhen (siehe Cluster Computing) und sie erfüllen oftmals den Zweck, meist auch auf Server Systemen, Die Fehlertoleranz mit Hilfe von unterschiedlichen Backup Systemen zu gewährleisten.

Verteilte Systeme charakterisieren sich durch parallele Aktivitäten, indem autonome Komponenten gleichzeitig unterschiedliche Aufgaben abarbeiten. Die Kommunikation der einzelnen Komponenten findet statt, indem sie Nachrichten miteinander austauschen. Verteilte Systeme unterscheiden sich somit von Shared Memory Architekturen weil sie auf keinen gemeinsam benutzten Speicher zugreifen (können). Ein Einsatzgebiet von Verteilten Systemen ist auch die gemeinsame Nutzung von Ressourcen oder Geräten wie Drucker, Scanner, Telefonanlagen oder andere.

Dabei besitzt kein einziger Prozess in so einem System das Wissen über den globalen Status des Gesamtsystems. Es gibt auch keine gemeinsamen Zeitgeber, somit nur begrenzte Möglichkeiten die Taktgeber der einzelnen Prozesse zu synchronisieren.

Man unterscheidet bei verteilten Architekturen zwischen Multiprozessor und Multicomputer Systemen. Multiprozessor Systeme besitzen einen gemeinsamen Speicher, wie z.B. die z.Zt. aktuellen dual oder Quad Core Prozessor Architekturen. Multicomputer Systeme besitzen keinen gemeinsamen Adressraum (Speicher) und sind homogen in Hard- und Software aufeinander abgestimmt. Dies können „Massively Parallel Prozessoren (MPP)“ Systeme oder Workstation-Cluster sein. Solche Systeme führen dem allseits bekannten Szenario für Betriebssysteme die in verteilter Umgebung Einsatz finden.

Die größte Bedeutung ist allerdings den heterogenen Multicomputer Systemen zuzuordnen. Diese sollen auch im Rahmen dieses Studienheftes betrachtet werden. Dabei müssen in Bezug auf die Computerpraxis oft folgende Fragen beantwortet werden:

- Was wenn komplett unterschiedliche Hardware verwendet wird, z.B. Intel CISC vs. PowerPC RISC Chips von IBM?

Wie kommunizieren Programme auf unterschiedlichen Betriebssystemen miteinander?

Was geschieht, wenn die Daten verschiedener Systeme unterschiedlich repräsentiert werden, z.B. EBCDIC vs. ASCII vs. UTF8 oder LATIN Zeichensätze?

Was geschieht oder muss geschehen, wenn Sie Ihr Büro in die Südsee verlegen?

Wie behalten sie die Übersicht über die vielen Aufgaben die auf einer Anzahl von Rechnern laufen?

Was, wenn zwei Ihrer Kunden gleichzeitig das selbe Produkt bestellen wollen (Concurrency oder Gleichzeitigkeit)?

Was, wenn die Datenbank mit den Informationen zu Ihrem Lagerbestand abstürzt?

Was, wenn jemand den Stecker zieht während sie im Internet eine Bestellung aufgeben?

Was tun, wen jemand in Ihre Server eindringen will?

Was, wenn der Kunde behauptet, er hätte gar keine Bestellung aufgegeben?

Was, wenn Ihr Laden so berühmt wird, dass Millionen von Kunden zur gleichen Zeit auf Ihre Webseite zugreifen?

All dies lässt sich zu den Herausforderungen der Heterogenität, transparenten Verteilung, Fehlertoleranz, Skalierbarkeit, Gleichläufigkeit, Offenheit und Sicherheit zusammenfassen. Diese müssen von verteilten Systemen im täglichen Gebrauch gemeistert werden.

Kommunikation in Verteilten Systemen

Gegeben sei das Beispiel eines Onlineshops entsprechend dem UML Usecase Diagramm in Abb. 1. Der Benutzer sich (1) das Inventar (alle Waren ansehen), (2) nach bestimmten Waren suchen und (3) Waren bestellen.

Dabei gilt, dass der Online-Store Computer das „Shop-Programm“ und der Kunde das „Shopping-Programm“ einsetzt. Beide Computer sind über ein Netzwerk miteinander verbunden. Die unterschiedlichen Prozesse der Computer tauschen dabei folgende Nachrichten aus:

- „Sende mir die Warenliste aller Waren“

„Hier ist die Liste der Waren: ...“

„Ich möchte diese bestimmte Ware bestellen“

„Die Bestellung der Ware wurde angenommen“

Dabei müssen Sender und Empfänger der Nachrichten sich über bestimmte Dinge einig werden. Dies sind z.B.: Die Art und Weise wie die Nachrichten transportiert werden, Welcher Spannungswert für 1 oder 0 verwendet werden soll, welches das letzte Bit sein soll und was im Fall von Fehlern geschehen muss. Darüber hinaus muss klar sein, welche Bedeutung die Bits haben, also handelt es sich um Text oder Binärdaten, welcher Zeichensatz soll gelten oder gibt es andere speziell zugeschneiderte Formate. Viele andere Vereinbarungen müssen auch noch auf anderer Ebene getroffen werden. Die Summe dieser Vereinbarungen bezeichnet man als Protokoll.

Ein Protokoll ist eine bestimmte definierte Menge von Konventionen die es Computern erlauben Information auszutauschen. Dabei müssen sowohl Syntax und Semantik vereinbart werden. Gemeinsame Regeln müssen eingeführt werden, um die Interaktion zwischen den Computern zu Steuern und Administrieren und es müssen die Formate der auszutauschenden Daten bestimmt werden.

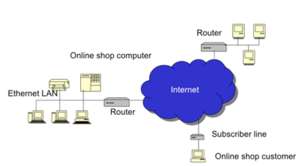

Dabei kann nicht davon ausgegangen werden, dass alle beteiligten Rechner am gleichen Netz angeschlossen sind, viel mehr kommunizieren diese über INTERconnected NETworks, also Computer sind an Netze angeschlossen die wiederum über ein übergeordnetes Netz miteinander verbunden werden. Dadurch entstehen komplexe Interaktionen zwischen und mit verschiedenen Kommunikationsprotokollen (siehe Abb. 2)

Zur Bewältigung dieser Komplexität gibt es mehrere Strategien. Eine Einteilung des Systems in Sub-Systeme (nach dem Motto „Devide et conquere“) kann vorgenommen werden. Dabei werden die zu entwickelnden Komponenten kleiner und können anderweitig wiederverwertet werden. Das System wird leichter wartbar und kann besser portiert werden.

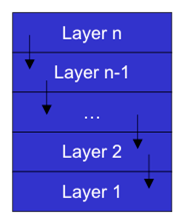

Die Einteilung des Systems kann auch in Layern/Leveln und Partitionen vorgenommen werden. Dabei baut ein Layer auf den anderen auf und unterschiedliche Partitionierung eines Layers dient zur Behandlung unterschiedlicher Funktionalitäten.

Wie zu sehen in Abb. 3 werden Layer übereinander gestapelt und mit wohl definierten Schnittstellen (Interfaces) miteinander verbunden. Dabei bietet ein Layer n Services für den darüberliegenden Layer n+1 an indem er seinerseits Services des darunterliegenden Layers n-1 annimmt.

Die Schnittstellen (Interfaces) definieren dabei die Syntax des Service und beinhalten die Namen der zur Verfügung stehenden Funktionen die Namen und Typen von Parametern. Die Typen der Ergebniswerte und eine Definition der möglichen Ausnahmen, ähnlich dem Aufruf einer Funktion oder Methode in einem Programm. Ein wichtiger Aspekt, von dem häufig Gebrauch gemacht wird, ist dabei die Möglichkeit, dass ein bestimmtes Interface mehrmals und auf verschiedne Weise implementiert werden kann. So können logisch identische Funktionalitäten in verschieden ausgeprägtem Umfeld gleichermaßen bestimmt werden. So kann z.B. ein Layer 2 der Daten paketiert mit beliebigen Layer 1 Komponenten zusammenarbeiten, gleich ob diese die Pakete dann über Luft oder Kupfer übertragen.

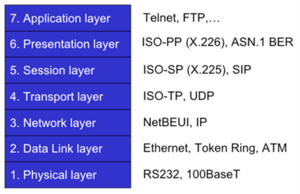

Die wohl berühmteste Layer Architektur auf dem Gebiet der Computer-Kommunikation ist das sog. ISO/OSI Referenzenmodell. ISO = „International Standard Organization“ und OSI = „Open Systems Interconnect“ haben eine geschichtete Architektur für Netzwerk Protokolle verabschiedet, den sog. „Protokoll-Stack“ (Protokollstapel?). Beim Senden wird dabei der Stapel der einzelnen Layer (Schichten) von oben nach unten durchgegeben, wobei der obere Layer die Daten verändert und/oder erweitert und and den darunter liegenden Layer weitergibt.

ATM hier in den 2. Layer zu geben ist eher spekulativ, ursprünglich ware es eher ein Paketnetzwerk auf Layer 1, da es sich wuasio als Draht dargestellt hat, aber wer kümmert sich heute noch um ATM?

Die unterste Schicht versendet dann die Nachricht als physische (elektromagnetische) Signale. Beim Empfang wird der Stapel in umgekehrter Reihenfolge durchlaufen. Die Signale werden vom untersten Layer aufgegriffen und dann Layer für Layer nach oben weitergegeben. Dabei kommunizieren zwei identische Layer auf unterschiedlichen Computern mit demselben Protokoll. Über alle Layer hinweg entsteht somit eine Verschachtelung von Layer- spezifischen Protokollen. Alle sieben Layer sind in Abb. 4 zu sehen.

Die Layer/Schichten im einzelnen:

- Physical Layer: Zur physikalischen Übertragung der Bits und Bytes, elektronische Signale

- Data Link Layer: Zum Transport zwischen zwei Punkten im Netzwerk, Media Access Control Prüfsummen Flow-Control etc.

- Network Layer: End-to-End Datenübertragung zwischen Computern über alle verbundenen Netzwerke, Packet-Forwarding und Routing

Transport Layer: End-to-End Datenübertragung zwischen einzelnen Prozessen auf verschiedenen Computern, Ports, Flow-Control

Session Layer: Stellt eine virtuelle Verbindung zwischen Prozessen her, Z.B. Auf- und Abbau von Verbindungen

Presentation Layer: Definiert, wie die gesendeten oder empfangenen Daten interpretiert werden sollen, d.h. was die 1-en und 0-en bedeuten und in welcher Reihenfolge sie zu lesen sind

Application Layer: Die Verbindung zwischen zwei Applikationen, z.B. File Transfer nach OSI etc.

Im Internet hat sich allerdings ein vereinfachtes Modell durchgesetzt, eine vier-schichten Architektur die as ISO/OSI Model vereinfacht, siehe

Die Layer sind:

- Hosts-to-Network oder PHY Layer: Physikalische Datenübertragung zwischen zwei Stationen

- Internet oder IP Layer: End-to-End Datenübertragung zwischen Computern über alle Netzwerke hinweg

- Transport Layer: End-to-End Übertragung zwischen einzelnen Prozessen auf den Computern, z.B. Vom Browser am Client zu Port 80 auf dem Server

- Application Layer: Appliklationsspeziefische Protokolle wie HTTP oder FTP, SSH etc.

Das ISO/OSI Modell ist definiert und verabschiedet von einem anerkannten Standardgremium. In dem Standard hat das Modell an sich immer Vorrang vor den Protokollen, welche sich in der Regel auf einen bestimmten Layer beziehen und nicht Layer-überschreitend angewendet werden. Ein Layer kann mehrere Protokolle beheimaten. Das Modell ist universell einsetzbar und ist daher sehr Komplex in der Implementierung. Außerdem wurde es vielleicht zum falschen Zeitpunkt, also zu früh, verabschiedet.

Die dargestellten Layer, wie sie im Internet Verwendung finden, sind aus der Erfahrung und der aktuellen Nutzung der Protokolle heraus gewachsen. Vice versa zum ISO/OSI Modell stehen hier die Protokolle im Mittelpunkt und nicht die Kommunikationsschichten (Layer). Das Internet Layer-Modell ist einfach gehalten und daher robust; es existieren viele gut funktionierende Applikationen.

Auch wenn die meisten Applikationen basierend auf dem Internet Modell implementiert werden, so wird doch immer wieder das ISO(OSI Modell herangezogen, um Kommunikationsverfahren zu beschreiben. Man spricht und plant Kommunikation indem man die ISO/OSI Layer referenziert, wenn es dann zur Implementierung kommt werden dann diese Modelle auf das Internet-Kommunikationsmodell reduziert.

Dabei werden Layer 1 und 2 des ISO/OSI Modells, also Physical und Datalink Layer auf den Layer 1 des Internet Modells also auf den Host-to-Network Layer abgebildet. Der Layer 3 des ISO(OSI Modells, also der Network Layer, wird auf Layer 2 im Internet Modell abgebildet, den Internet Layer. Die beiden Transport Layer werden 1:1 zugeordnet, also Layer 4 im ISO/OSI Modell auf Layer 3 im Internet. Die restlichen Layer im ISO/OSI Modell werden im Internet zu dem Application Layer zusammengefasst.

Wie werden nun aber die Daten, auf dem Netzwerk Layer (Layer 3 im OSI Modell) übertragen? Hierbei gibt es zwei grundverschiedene Ansätze, das sog. „Circuit Switching“ (Leitungsvermittlung), also die Leitungsvermittlung und das „Packet Switching“ also die Paketvermittlung.

Die Leitungsvermittlung fand Ihre Anwendungsgebiete bisher immer in der Sprachkommunikation und wird vor allem in der Telekommunikation angewandt. Auch heute in den Zeiten von SIP und IMS wird z.B. die Sprache in einem modernen Mobilfunknetz bis zur Basisstation immer noch leitungsvermittelt (im RAN). Bei der Leitungsvermittlung gibt es eine fest zugeordnete Leitung (entweder einen physikalischen Draht, oder einen fest reservierten Zeitschlitz im Backbone Netzwerk) für eine Kommunikationsverbindung. Ein dedizierter Aufbau und Abbau der Verbindung ist notwendig. Die Leitungsvermittlung eignet sich besonders gut für Echtzeit-Datenverkehr wie Sprach oder Video Übertragung. Die Übertragung ist zuverlässig und von hoher Qualität, kann aber Ressourcen verschwenden, da z.B. Leitungen in beide Richtungen fix reserviert wurden, unabhängig davon, ob nun gerade gesprochen wird oder ob sich das Bild eines Videos nun verändert oder nicht.

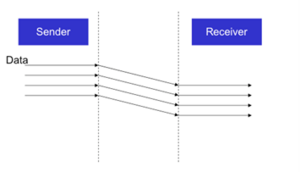

Die Paketvermittlung ist eine Erfindung aus der Welt de Internets und geht auf das Amerikanische Verteidigungsministerium und dessen DARPA Net zurück. Ein sehr interessanter geschichtlicher Hintergrund, auf den hier aber nicht weiter eingegangen werden kann. Im Zentrum dieses Vermittlungsverfahrens steht die Datenübertragung bei der die Datenströme in diskrete Teilstücke eingeteilt und dann auf den Weg zum Empfänger geschickt werden. Dies sind die sog. Datenpakete nach denen dieses Verfahren Ihren Namen bekommen hat. Die Pakete werden dabei unabhängig voneinander, nach dem „store-and-forward“ Prinzip über mehrere Konten hinweg durch das Netzwerk transportiert (sie werden „geroutet“). Der ursprüngliche Datenstrom mit seiner Information in richtiger Reihenfolge wird dann beim Empfänger aufgrund von Zusatzdaten, die den einzelnen Paketen angefügt wurden, wieder rekonstruiert. Anders als in der Leitungsvermittlung kann hier die Nachricht Ihr Ziel über mehrere Wege erreichen. Und im Falle eine Übertragungspause werden auch keine Ressourcen benötigt.

Vorteile der Leitungsvermittlung sind eine fixe Bandbreite und somit garantierter Kapazität und niedrige Signalverzögerungen und Verzögerungsvariation. Als Nachteile können extra Overhead durch Verbindungsauf- und Abbau und die Verschwendung von Ressourcen bei geringer Nutzung genannt werden.

Vorteile der Paketvermittlung sind die effiziente Ausnützung von Ressourcen, die hohe Flexibilität bei Übertragungsweg und Übertragungsart und die Tatsache, dass auf Netzwerk-Layer Ebene kein Setup und Teardown der Verbindung notwendig ist. Ein wesentlicher Nachteil ist die fehlende Garantie über geringe Signalverzögerungen und effektiver Bandbreite, also die wichtigsten Quality of Service Parameter.

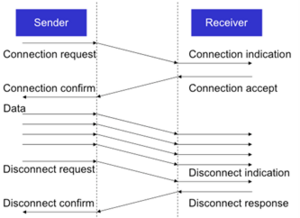

Auf dem Transport Layer unterscheidet man zwischen „Connection-oriented“ (Verbindungsorientiert), also verbindungsorientierter und „connectionless“, also verbindungsloser Kommunikation. Verbindungsorientierte Kommunikation gewährleistet eine (nahezu) fehlerfreie Kommunikation und garantiert die korrekte Reihenfolge der Daten für den der das jeweilige Transport Protokolle verwendet. Weiters wird Flusskontrolle durchgeführt und Datenverlust oder Duplizierung sind ausgeschlossen. Das TCP (Transmission Control Protocol) Ist dafür das wohl bekannteste Beispiel.

Verbindungslose Protokolle verschicken nach bestem Vermögen sogenannte Datagramme, das sind Datenpakete die für sich abgeschlossen und ohne Zusammenhang mit anderen Paketen losgeschickt werden. Dabei gilt die Prämisse von „Abgeschickt ist gleich Angekommen“. Pakete die verlorengegangen sind werden nicht erneut gesendet. Diese Datagramme kann man am besten mit Postkarten vergleichen. Das Berühmteste Beispiel dafür ist das UDP (User Datagram Protocol) Protokoll. Es wird immer dann eingesetzt wenn Daten schnell und mit geringer Verzögerung übertragen werden müssen, wobei die darüberliegenden Applikationen auf das ein oder andere verlorengegangene Datenpaket verzichten können. UDP stellt z.B. die Basis von RTP (Realtime Transmission Protocol) dar welches zur Übertragung in Echtzeit (z.B. VOIP oder Video Streaming) verwendet wird. Diese Übertragungprotokolle haben nichts mit den angewandten Kodierungsverfahren wie MPEG2 oder H.264 zu tun.

Auf der Application-Layer Ebene ist das wohl bekannteste Protokoll HTTP, also Hypertext Transfer Protokoll, welches für World Wide Web implementiert wurde. Es wurde definiert unter IETF RFC 1945 und RFC 2616 (siehe www.ietf.org). Es ist ein „stateless“ Protokoll, also zwischen zwei gesendeten Nachrichten besteht kein Zusammenhang und basiert auf dem Request/Response, also dem Frage/Antwort Schema.

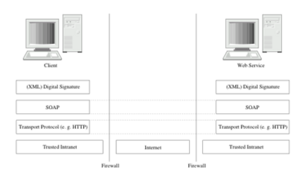

HTTP steht auf allen Plattformen zur Verfügung, wird oft auch schon von kleinen Geräten wie 4-Port Routern oder ähnliches zur Konfigurationsanbindung verwendet. Das Protokoll ist sehr einfach gehalten und die Nachrichten sind textbasiert. Entsprechende Nachrichten können also auch von Menschen gelesen und manuell eingetippt werden, meist zum Testen. Es kennt darüber hinaus einfache aber effektive Sicherheitsmechanismen und wird von Firewalls eher freundlich behandelt. Ein Grund dafür, warum SOAP meist über HTTP übertragen wird, was aber wiederum bedeutet, dass Firewalls eigentlich doch nicht so freundlich sein sollten was HTTP Verkehr anbelangt.

Eine HTTP Nachricht besteht aus einer Request oder Status Zeile (1. Zeile der Nachricht) gefolgt von mehreren Zeilen mit Name-Value-Pair (name=wert) einträgen die als Header bezeichnet werden. Darauf folgt eine Leerzeile mit der Zeichenkombination (<CR><LF>), also die art und weise, wie in Windows in der Regel Leerzeichen gespeichert werden. Darauf folgt der Sogenannte Body, welcher dann die Nutzdaten enthält.

Die erste Zeile einer HTTP Request Nachricht enthält die HTTP Methode (GET, HEAD, POST oder PUT, abhängig von der HTTP Version) und die angeforderte Ressource, also die URL der zu liefernden Daten (z.B. eine HTML Datei). Die Möglichen Header Werte kann man dem Standard entnehmen. Bei einer HTTP Response Nachricht enthält die erste Zeile den Status-Kode und eine kurze Beschreibung (z.B. „200 OK“, oder „404 Not Found“. Im Body der Nachricht sind dann die gewünschten Daten enthalten.

Nachrichtenkodierung

Daten, die über das Netzwerk übertragen werden sind einfach nur Bits und Bytes, Nullen und Einsen. Sie können verschiedenste Information und Formate repräsentieren. Z.B: Text wie ASCII, UTF8, UTF16, etc., oder einfache Datentypen wie byte, int , long, float etc. Sie können aber auch bedeuten, dass Objekte, Klassen, Bilder oder Dokumente über die Leitung geschickt werden.

Weiters, besteht ein Netzwerk aus einer Vielzahl verschiedenartiger, heterogener Systeme und Computer. Manche Computer interpretieren die Bytes in Bitreihenfolge von rechts nach links (Intel), andere von links nach rechts (PPC auf G5 Macs oder die CPU der XBOX360). Die Art der Zeichencodierung (UTF vs. LATIN) oder die Breite der Register, 8, 16, 32 oder 64 Bit, der verwendeten CPUs können sich unterscheiden. Einen Transformation der Daten oder ein „allgemein“ verständlicher Kode ist erforderlich, um nicht nur Bits sondern auch Information übertragen zu können. Dies ist theoretisch recht einfach, hat aber einen starken Einfluss auf die Performance und somit die Übertragungsrate.

Wenn man nun für jeden Code auf jeden beliebigen anderen Code ein Mapping definieren will, dann würde man bei n Codes n2 Transformationen implementieren müssen; das berühmte n-Quadrat Problem. Viel besser wäre es also, vor der Übertragung, die vorliegenden Daten in ein kanonisches Format umzuschreiben, die Daten dann über das Netz zu schicken und auf der Empfangsseite dieses allgemein verständliche Format auf die Präsentation der Daten im lokalen System wieder zurück zu codieren. Dadurch wird eine Reduzierung der Komplexität auf 2*n statt n2 erreicht.

Bei der Textcodierung werden dabei Character und Charactersets definiert wie früher ASCII oder EBSDIC Kodierung und in heutzutage im Sinne der globalen Familie des Internets Zeichenmengen und Kategorisierungen wie UTF oder LATIN.

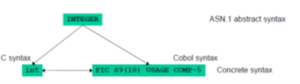

Es braucht aber auch eine kanonisierte Form, um die Bits die in die Leitung fließen und am anderen Ende wieder ausgelesen werden zu interpretieren. Diese Form wird definiert in der Abstract Syntax Notation, ASN.1 der ISO (International Standard Organization). Der Standard besteht aus vier Hauptelementen:

- Die Abstract Syntax beschreibt die Struktur von Daten unabhängig von anderen Programmiersprachen

- Die Concrete Syntax beschreibt die Struktur der Daten bezogen auf eine bestimmte Programmiersprache.

- Die Transfer Syntax beschreibt die Struktur der Daten auf dem Übertragungsweg

- Die Encoding Rules (z.B. die Basic Encoding Rules BER) beschreiben die Transformation von der Concrete Syntax in die Transfer Syntax

Im Folgenden werden nun einige Beispiele für die Notierung in ASN.1 und die Kodierung in BER gegeben.

ASN.1 Deklaration eines Datentypen (hier “BookType”):

BookType ::= INTEGER {

paperback(0)

hardcover(1)

}

Beispiel Wertedefinition:

hardcover BookType ::= hardcover(1)

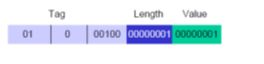

Die Standard Kodierungsregeln von ASN.1 besagen, dass:

- Datentypen-Information wird via TAGs übertragen

- Es werden keine Typennamen übertragen

- TAGs werden annotiert, um Typen zu beschreiben.

Dabei gibt es vier verschiedene TAG Klassen:

UNIVERSAL, APPLICATION, CONTEXT-SPECIFIC, PRIVATE

Die Daten werden dann via TLV Kodierung (Tag, Length, Value) übertragen

Beispiel Definition:

BookType ::= [APPLICATION 4] INTEGER {

paperback(0)

hardcover(1)

}

hardcover BookType ::= hardcover(1)

Die Daten hardcover werden nun in codiert wie in Abb. 11.

Die Kombination aus ASN.1 und BER ist sehr effektiv. Beliebige Datenstrukturen können kanonisiert übertragen werden. Der Preis für die Perfektion ist jedoch hoch. Die Kodierung ist aufwendig und ineffizient, z.B. beim Zugriff auf bestimmte Bits. Viele Applikationen kennen die Typen ihrer zu übertragenden Daten ohnehin, was diese Information überflüssig macht. ASN.1 ist ein Kind der Telekommunikationsstandardgremien und wird auch heute noch in diesem Bereich eingesetzt, z.B. bei UMTS oder Intelligent Networks. Mittlerweile hat sich allerdings XML als Standard bei der Übertragung von typisierten Daten etabliert.

XML, die Extended Markup Language ist eine textbasierte Meta Sprache mit einer selbstbeschreibenden Datenpräsentation: Daten und Typinformation zu den Daten erscheinen zusammen. XML ist plattformunabhängig und jede Menge Tools und APIs zum Generieren und Lesen von XML stehen zur Verfügung (SAX, DOM, etc.). Man könnte XMLD als die Sprache der Maschinen in Internet bezeichnen. Es gibt zur Zeit kaum datenorientierte Applikationen, die diesen Standard nicht unterstützen würden. XML ist adaptier- und erweiterbar, via sogenannter Extensible Stylesheets (XSLT). XML wurde standardisiert von der W3C.

Auf XML, XLINK, XPATH, XPOINTER und XSLT wird unter Kapitel 4.2.4 näher eingegangen.

XML ist eine Metasprache mit dem Zweck, konkrete Sprachen zu definieren, also im Falle der Datenübertragung das Vokabular zur Typenbeschreibung. Dabei werden die aktuellen Daten mit Tags versehen, die die Bedeutung der Daten bestimmen. Die Möglichkeiten, welche Daten wie getagged werden können, werden durch die XML Stylesheets bestimmt.

Ein durch XML beschriebenes Set an Daten in einer Datei wird als Dokument bezeichnet. Diese Dokumente sind hierarchisch geordnet, indem mit Anfangs- und Endtaggs versehene Datensegmente ineinander verschachtelt werden.

XML ist sehr erfolgreich aber man sollte sich nicht von dem Mythos blenden lassen, dass XML einfach zu handhaben und von Menschen lesbar sei (Beweis: Speichern Sie ein MS-Word Dokument als XML ab und öffnen sie diese mit einem einfachen Texteditor).

Es gibt noch andere Methoden zur Serialisierung von Daten, vor allem objektorientierte Laufzeitumgebungen wie .Net oder Java definieren eigene über die jeweilige Sprache hinaus nicht standardisierte Formate um , z.B. Objekte zu speichern oder zu übertragen.

Remote Procedure Calls, Middleware und verteilte Objekte

Bevor wir auf RPC eingehen sollten wir einen kurzen Ausflug in die Welt der Clients und Server machen. Gegeben sei dabei der schon unter 1.2 vorgestellte Usecase eines Online-Store.

Der Online Store stellt den Dienst, Waren über das Internet anzubieten und zu vertreiben bereit. Die notwendigen Prozesse die dabei ablaufen werden dabei unter dem Begriff „Server“ zusammengefasst. Oft wird damit auch der ganze Computer bezeichnet, auf dem diese Prozesse oder Aufgaben abgearbeitet werden.

Der Prozess der diesen Service benutzt, wird als Client bezeichnet. Dabei kann ein Server der Client eines anderen Servers sein, z.B. in einer Multi-Tier Architektur moderner Business-Anwendungen.

Den gesamten Service jetzt aber nur auf Basis von Requests und Responds die via TCP über das Netz geschickt werden, wäre sehr zeitaufwendig, fehleranfällig und kaum wieder verwertbar für viele verschiedene Online-Stores.

| Datei:Media/image15.png |

|---|

| Datei:Media/image16.png |

Es gibt dazu einen eleganteren Ansatz. Dabei tut man auf der Seite des Clients einfach so, als würde man eine Prozedur oder Funktion aufrufen, ohne dass dem Aufrufenden dabei klar ist, ob die Funktion nun auf dem eigenen lokalen Rechner oder auf einem anderen irgendwo im Internet abgearbeitet wird. In unserem Beispiel könnte man dann einfach zwei C-Funktionsprototypen definieren wie etwa:

public Receipt order(Books] books);

public Book[] suche(String keyword);

Totale Transparenz und absolute Ununterscheidbarkeit von lokalen und entfernten Aufrufen von Funktionen auf einem beliebigen Computer wird allerdings immer ein Ideal bleiben. Faktoren wie Laufzeitverzögerung, parallele Abarbeitung, Speicherzugriff oder teilweise Ausfälle von Geräten wird von Programmierern immer gesondert behandelt werden müssen. Man kann Ihnen das Leben dabei allerdings wesendlich vereinfachen, indem man notwendiges Expertenwissen über Sockets, Session-Management, Datenrepräsentation oder das Auffinden von Services (Funktionen) vereinfacht oder abstrahiert.

Der erste Versuch dies zu erreichen ist die Einführung von sogenannten Remote Procedure Calls. Diese Technologie setzt auf dem Transport Layer auf und entbindet damit den Applikationsprogrammierer von der Verantwortung Netzwerkprotokolle oder Sockets selbst ansteuern zu müssen.

Naming Services

„It’s all in a name.“

Diese im Englischen oft verwendete Redewendung deutet auf die Wichtigkeit der Namensvergabe für das was wir tun und geschaffen haben hin. Dies gilt um so mehr für verteilte Systeme, denn was man nicht benennen kann existiert letztlich nur für sich selbst und ist somit nutzlos in der Welt der anderen. Und verteilte Systeme sind vom Benutzer aus betrachtet nun mal nichts anderes als: „Die Welt der Anderen“. Damit Computer mit Namen gut umgehen können müssen diese systematisiert werden. Dadurch entstehen Namenssysteme und in verteilten Systemen Namensdienste zur Auffindung von Ressourcen im Netz.

Jede logische Einheit eines Naming-Service, jeder Eintrag den man dort ablegen kann, besteht aus drei Elementen:

- NAME:

Dieser beschreibt das Objekt um das es geht (welches eingetragen oder gesucht wird)

- ADRESSE:

Der Ort an dem sich das Objekt befindet

- PFAD

Beschreibt, wie man am Ort des Objektes zu dem Objekt selbst findet.

Die oben genanten Elemente lassen sich z.B. auch in dem HTML Address-Tag wieder finden: <a ref=http://ffh.online-campus.at/Dokumente/AIT2/Studienheft.pdf> Skriptum zu GridComputing </a> mit NAME=“Skriptum zu GridComputing“, ADRESSE=ffh.online-campus.at und PFAD=Dokumente/AIT2/Studienheft.pdf.

Man braucht Naming Services, um Objekte (oder anders gesagt Ressourcen) im Netz zu identifizieren. Objekte können sein: Dateien, Benutzer, Datenbanken, Variablen, Kommunikationsverbindungen o.ä. Man nutzt Namenssysteme auch, um Daten und Information mit anderen zu teilen und um eine Indirektion zwischen Objekt und Zugriffsmethode zu schaffen. Die Bindung von Namen an Objekte ist dadurch dynamisch und kann jederzeit geändert werden Ein einziger Name kann eine gesamte Menge an Objekten bezeichnen und man kann einem Objekt gleich mehrere Namen geben. Außerdem ist die Namensvergabe eine Voraussetzung für die Transparenz eines Systems. So können WWW Server irgendwo auf der Welt aufgestellt werden, die Server können beliebig umgezogen werden und es kann mehrere replizierte Server geben, die auf der ganzen Welt verteilt laufen und den gleichen Namen haben, z.B.: um von einer Adresse www.millisoft.com, Antworten von europäischen oder amerikanischen Servern zu bekommen, je nach Konfiguration.

Naming Services stehen folgenden Problemen gegenüber: Dem Management von Kontextinformation, die ständige Verfügbarkeit der Namensauflösung - vom Namen zum wirklichen Objekt, dem riesigen Umfang an Namen und Objekten in einem (weltweiten) System und der Heterogenität unterschiedlicher Namensysteme welche miteinander verschränkt werden müssen.

Dabei ist Kontextmanagement der zentrale Aspekt, da die Bedeutung von Namen in der Regel abhängig vom Kontext ist in dem Sie gebraucht werden. SO kann z.B. das englische Wort „state“ einen Staat in den USA wie Kansas oder Kalifornien bezeichen und in einem anderen Kontext den momentanen Zustand eines laufenden Computerprogramms beschreiben.

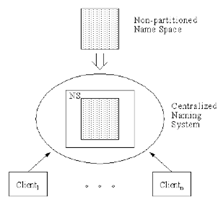

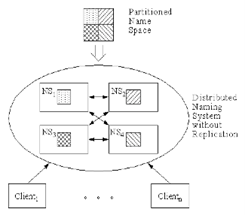

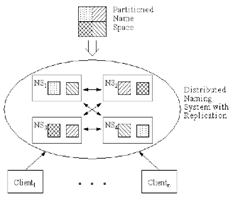

Es gibt verschiedene Möglichkeiten, diese Probleme zu lösen:

- Zentralisiertes Kontextmanagement hat den Vorteil, dass es einfach zu implementieren ist aber die Nachteile, dass es einen „Single Point of Failure“ und einen weiteren Performance Engpass darstellt

- Verteiltes Kontextmanagement hat den Vorteil, dass es keinen „Single Point of Failure“ gibt und Loadsharing zwischen den Servern betrieben werden kann. Nachteile sind, dass es sehr komplex zu implementieren ist und der Ausfall eines Servers bedeutet, dass der Namensbereich für den dieser zuständig ist nicht mehr bedient werden kann.

- Verteiltes Kontextmanagement mit Replikation bietet hohe Verfügbarkeit, effizienten Zugriff und Loadsharing zwischen den Servern. Nachteile sind, dass nun auch Replikationsmanagement betrieben werden muss und dass laufzeitbedingt Inkonsistenzen in der Namensverwaltung auftauchen können.

Die Namen selbst können flach oder strukturiert sein. Beispiele für flache Namen oder Identifier sind die Reisepassnummer oder die ISBN eines Buches. Beispiele von strukturierten Namen sind Pfadangaben in einem hierarchischen Dateisystem, die Namespaces in C# oder die Paketnamen in Java, sowie die Domain Namen für Internet Adressen.

Die Funktionen eines Naming Services, ganz gleich ob dieser nur einen einzigen Application Server oder das ganze Internet abdeckt, lassen sich, abgesehen von den administrativen Aufgaben, in zwei Gruppen zusammenfassen: Die Manipulation von Kontext- und Namensinformation, sowie das Beantworten von Nachfragen.

Die Schreibfunktionen des Services sind: ADD – zum Erstellen eines Bezugs zwischen Name und Objekt, DELETE – zum Löschen des selben und MODIFY zum Verändern einer zuvor erstellten Referenz. Die Lesefunktionen sind: READ – das Auflösen eines Namens auf das konkrete damit verknüpfte Objekt, SEARCH – das Finden von Namen oder Objekten bezogen auf bestimmte Attribute und LIST – das Auflisten aller Namen in einem bestimmten Namensraum.

Beispiele für Naming Services sind, im Bereich der Programmierung von verteilten Systemen das JNDI „Java Naming Directory Interface“ zum Auffinden von lokalen oder entfernten Objekten und im Bereich großer Netzwerke das X.500 Directory oder der DNS „Domain Name Service“ des WWW.

Die Hauptaufgabe des DNS ist das Umwandeln (LOOKUP) von symbolischen Computernamen auf Internet Adressen (und vice versa REVERSE-LOOKUP). Der Namensraum des DNS ist hierarchisch gegliedert und ortsunabhängig organisiert. Die Aufteilung erfolgt in Domains die in einer Baumstruktur miteinander verbunden sind. Im Gegensatz zum wenig verwendeten X.500 Directory baut der Domain Name Service auf einem einfachen Datenmodell auf, arbeitet mit einfachen Filter-Abfragen und ist Weltweit anerkannt (ICANN).

Peer-to-Peer Netzwerke

Peer-to-Peer Netzwerke sind ein fester Bestandteil des Web2.0 in den Bereichen Messaging (ICQ, Jabber), Groupware (Groove, Wave?), Internettelefonie (Skype), Media-Streaming (Hulu, Zatoo), Hosting/Filesharing (Bittorrent, Avalanche) oder auch bei Suchmaschinen (YaCy) (vergleiche auch [I4]).

In den 90-er Jahren des letzten Jahrhunderts hat ein Paradigmenwechsel eingesetzt der Peer-to-Peer Systeme den traditionellen Client/Server Lösungen bevorzugte. P2P Systeme sind autonom, skalierbar, dynamisch, anonym, dezentral und selbst-organisierend. Peer-to-Peer Datenverkehr macht mittlerweile mehr als die Hälfte des Internet Verkehrsvolumens aus. Man unterscheidet heute mindestens drei Generationen von Peer-to-Peer Netzwerken: 1. Generation – zentralisierte P2P Netze, 2. Generation reine P2P und hybrid P2P Netzwerke und 3. Generation – 3. Generation DHT (Distributed Hash Tables) P2P Netzwerke a la Bittorrent.

Bei der ersten Generation von Peer-to-Peer Netzwerken, den zentralisierten P2Ps speichert ein Server den Index zum Auffinden der Daten im Netz. Der Datenaustausch findet dann Peer-to-Peer also direkt von Rechner zu Rechner statt. Wie bei allen zentralisierten Systemen ist auch hier der Schwachpunkt der zentrale Server dessen Ausfall zu einem Totalausfall des Dienstes führen würde. Außerdem skaliert ein System schlecht dessen Hauptlast auf einem einzigen Rechner liegt.

Bei reinen P2P Systemen der 2. Generation sind alle Peers (Rechner) gleich. Queries und Pings werden weitergeleitet und es existiert keinerlei „globales Wissen“. Solche Systeme sind sehr robust. Dadurch ergeben sich allerdings Performance Probleme verursacht durch Message-flooding (hohe Anzahl von Nachrichten) und Daten-Kollisionen. Es gibt z.B. bei Gnutella auch keine Garantie alle Daten aufzufinden. Bei der hybriden P2P Variante wie Fasttrack unterscheidet man zwischen „normalen“ Peers und „Super“ Peers. Dadurch entsteht eine gewisse Hierarchie im Netz. Super-peers nutzen Ihre lokale Information bei einer Query und leiten diese nur weiter, wenn auf dem Peer Rechner selbst nichts gefunden wird.

In der 3. Generation der Peer-to-Peer Netzwerke wird das Konzept der verteilten Hashtabellen angewendet (DHT). Auch hier sind alle Peers gleich und es gibt keinerlei hierarchische Struktur. Die Last wird gleich verteilt auf alle Peers und Knoten und Objekte im Netz werden alle auf im gleichen Schlüsselraum (Anzahl möglicher Schlüssel) abgebildet.

Eine detaillierte Diskussion des Themas Peer-to-Peer Netzwerke würde eine ganze Vorlesung ausfüllen. Auch die Behandlung anderer wichtiger Aspekte zum Thema verteilte Systeme wie Zeitsynchronisation von Netzwerken, die Integration von globalen Daten und Datenreplikation sowie Parallelität und Transaktionsmanagement, würden den Rahmen dieses Studienheftes sprengen und können daher hier nicht weiter ausgeführt werden. Dem interessierten Leser bleibt es überlassen, diese Themen in der im Anhang angegeben Literatur selbst nachzulesen.

Praxis Verteilter Systeme

„Was ist anders an verteilten Systemen?

Nun, sie sind eben nicht zentralisiert.“ [3]

Das Client Server Modell

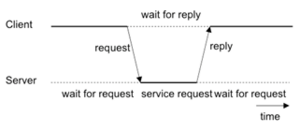

In diesem Modell unterscheidet man zwei verschiedene Arten miteinander kooperierender Prozesse: die Server, die einen Dienst (Service) bereitstellen und die Clients, die Nutzer eines Dienstes. Ein Client sendet eine Anfragenachricht, in der er einen bestimmten Dienst nachfragt, an einen Server. Dieser erfüllt den Dienst, indem er die nachgefragten Daten oder eine Fehlermeldung zurückliefert, die den Grund des Versagens beinhaltet (siehe auch [I5]).

Es ist aber auch möglich, dass ein Prozess gleichzeitig sowohl Client als auch Server ist. Wenn ein Server für die Bereitstellung eines Dienstes den Dienst eines anderen Servers benötigt, wird er zum Client bezüglich des anderen Servers.

Interprozess-Kommunikation

Zwischen Threads: Alle Threads eines Prozesses befinden sich im selben Adressraum. Dadurch ist es möglich, Daten im Hauptspeicher abzulegen, auf die jeder von ihnen zugreifen kann. Die Kommunikation zwischen den Threads erfolgt also am effektivsten über globale Variablen. Allerdings bildet der Zugriff auf die gemeinsam genutzten Daten einen kritischen Abschnitt, der zu synchronisieren ist. Dies kann mit Hilfe von Semaphoren, Monitoren oder ähnlichen Mitteln erfolgen. Durch sie wird garantiert, dass ein Thread einen kritischen Abschnitt ohne Unterbrechung durch einen anderen ausführt.

Zwischen Prozessen: Mehrere Prozesse können nicht über globale Variablen miteinander kommunizieren, da jeder Prozess seinen eigenen Adressraum besitzt. Betriebssysteme bieten jedoch für Prozesse andere Mittel der Kommunikation an. Laufen zwei Prozesse im selben Rechner ab, so kann bei der Implementierung der Interprozesskommunikation (IPC) der physisch vorhandene gemeinsame Speicher genutzt werden. In UNIX System V werden dafür Bibliotheksroutinen zum expliziten Einblenden vom shared memory oder dem Austausch von Nachrichten angeboten. Besitzen zwei Prozesse Zugriff auf das selbe Filesystem, so kann die Kommunikation auch darüber erfolgen (named pipes in UNIX). Ein allgemein anwendbares Verfahren der IPC ist jedoch der Nachrichtenaustausch. Er funktioniert sowohl zwischen Prozessen, die sich auf dem lokalen Rechner befinden als auch zwischen Prozessen, die sich auf unterschiedlichen Rechnern befinden.

Synchrone Middleware

Geht man vom OSI-Schichtenmodell für Netzwerke aus, positioniert sich die Middleware in den obersten drei Schichten: „Applikation, Präsentation und Sitzung“. Sie definiert dabei auf Grundlage des darunter liegenden Netzwerkes die Kommunikationsmechanismen zwischen den einzelnen Applikationen.

Zum Einsatz einer Middleware-Lösung muss diese auf den zu integrierenden Systemen überhaupt zur Verfügung stehen, es muss die Funktionalität der entsprechenden Schnittstelle im Mittelpunkt der Spezifikation bzw. des Design stehen und sie sollte über ausreichende Mechanismen zur Transaktionssicherung verfügen bzw. Möglichkeiten zur Verschlüsselung und Authentifizierung anbieten.

Bei der synchronen Kommunikation ist der Sender (Client) von der Anforderung einer Verbindung zum Empfänger (Server) bis zum Erhalt der gewünschten Informationen oder Ergebnisse blockiert (blocking), was bedeutet, dass die Ausführung des entsprechenden Programms für die Dauer der Kommunikation und der Bearbeitung der Anfrage durch den Server ausgesetzt wird. Hat der Server den Wunsch eines Verbindungsaufbaues bestätigt, können keine weiteren Verbindungen zu ihm aufgebaut werden (siehe auch [P9] und [P10]).

Asynchrone Middleware

Das asynchrone Kommunikationsprinzip beinhaltet die Unabhängigkeit der internen Verarbeitung und Kommunikation beim Sender und Empfänger. Nach Übergabe des zu sendenden Datenstroms an das Kommunikationssystem fährt der Sender mit weiteren Prozeduren fort, ohne zu blockieren. Er wartet demzufolge nicht auf eine Quittierung oder ein Bearbeitungsresultat des Empfangssystems. Dieses Konzept bietet den Vorteil, dass der Server weder direkt mit dem Client verbunden noch überhaupt verfügbar sein muss, damit eine Kommunikationsanforderung im Netzwerk abgesetzt werden kann (non-blocking) und trotzdem erfolgreich bearbeitet wird (siehe auch [I5]).

Bei asynchroner Kommunikation, auch Message Passing genannt, arbeitet der Sender nach dem Abschicken einer Nachricht bereits weiter, ohne auf eine Antwort zu warten. Die Anfrage verbleibt dann unter Umständen längere Zeit in der Anfrageschlange beim Empfänger, ohne den Prozess komplett zu blockieren. Eine solche Entkopplung ermöglicht eine sehr flexible Arbeitsweise der Anwendungen. Neben dem Begriff Message Passing wird dies auch als „fire and forget“ bezeichnet. Die beiden hier in Frage kommenden Varianten sind die Broadcasting- und Publish/Subscribe-Kommunikation.

Beim Broadcasting schickt der Sender die Nachricht über einen öffentlichen Kanal ab. Jeder Empfänger, der Zugang zu diesem Nachrichtenmedium hat, kann die Nachrichten verwerten oder nicht. Die grundsätzliche Idee hinter der Publish/Subscribe-Kommunikation ähnelt der des Broadcastings mit dem Unterschied, dass die Nachricht nur an Empfänger zugestellt wird, die im Vorhinein diese Nachricht oder das Thema der Nachricht abonniert (siehe auch [P9]).

Nachrichtenorientierte Middleware

Die in den vorhergehenden Abschnitten beschriebenen Middleware-Ansätze gehen in ihrer praktischen Umsetzung weitgehend von einer synchronen Kommunikation zwischen zwei Applikationen oder zwischen einer Applikation und einer Datenbank aus. Solange kommuniziert wird, sind der Sender und der Empfänger in allen Fällen blockiert. Erst in jüngster Zeit existieren Bestrebungen, beispielsweise bei der OMG mit CORBA, asynchrone Kommunikationsmechanismen in die Standards zu implementieren. Ein weiterer Nachteil ist die strenge Peer-to-Peer Ausrichtung der Middleware-Ansätze. Dadurch wird eine Einbindung neuer Applikationen aufgrund der hohen Kopplung zwischen den Systemen wesentlich erschwert.

Message-orientierte Middleware (MOM) geht einen anderen Weg. Die Kommunikation zwischen zwei Applikationen erfolgt hier ausschließlich über den Austausch von Nachrichten, d.h. dass nach Übertragung einer Nachricht an die Middleware-Schicht die Applikation sofort weiterarbeiten kann. Der Transport und das Routing der Informationen werden von der MOM-Software übernommen. Somit kann über message-orientierte Middleware asynchron kommuniziert werden. Allerdings werden auch synchrone Mechanismen zum Datenaustausch angeboten (siehe auch [P9]).

Enterprise Applikationen und e-Business

Um Komponentenorientierte Middleware beschreiben zu können, muss zunächst einmal geklärt werden, was Komponenten überhaupt sind. Allgemein versteht man unter einer Komponente einen ausführbaren Programmkode, der eine bestimmte Funktionalität beinhaltet und diese in Form von Diensten über definierte Schnittstellen den Clientanwendungen oder anderen Komponenten bereitstellt. Im Unterschied zur objektorientierten Programmierung ist ein Zugriff auf Funktionalitäten und Daten nur über diese Schnittstellen möglich. Die strikte Kapselung ermöglicht es, die Implementation auszutauschen ohne das Gesamtsystem zu beeinflussen solange Funktionalität und Schnittstellen gleich bleiben. Der Zugriff auf Komponenten ist dabei nicht auf einzelne Prozesse oder auf einzelne Computer beschränkt. Verteilung und Kommunikation werden durch eine Middleware-Schicht realisiert, wodurch Modifikationen am Quellcode der Clientprogramme wegfallen können. Komponenten sind somit insbesondere für n-Tier Applikationen geeignet. Ziel der Entwicklung ist es, durch die lose Kopplung und das Black-Box-ähnliche Verhalten die Wiederverwendung zu fördern und den Prozess der Softwareentwicklung mit der Unterstützung von Drag-und-Drop basierter Zusammenstellung von Applikationen aus Softwarekomponenten zu beschleunigen.

Mit der 1997 vorgestellten Enterprise Java Beans (EJB) Technologie stellt die Firma Sun ein entsprechendes Komponentenmodell für die Entwicklung und das Deployment von serverseitigen Unternehmensanwendungen zur Verfügung (siehe auch [P8] und [P10]). Die Veröffentlichung der Modell-Spezifikation ermöglicht es Drittanbietern, die Implementation von Laufzeit- und Entwicklungsumgebungen selbst umzusetzen. Lösungen existieren beispielsweise von Bea Systems, Iona Technologies und IBM.

Der EJB-Container stellt die Laufzeitumgebung für die Enterprise Java Beans zur Verfügung. Dazu gehören eine Anzahl von Diensten, die durch die EJB-Spezifikation festgelegt oder vorgeschlagen werden (siehe Tabelle unten). Die Infrastruktur für den EJB-Container wird wiederum durch den EJB- Server bereitgestellt. Zu seinen Aufgaben gehören u.a. das Pooling von Datenverbindungen und die Thread-Verwaltung.

Tab. 1: Strukturbilanz EJB Dienste und Spezifikationen (Quelle [P10])

| Ressourcenverwaltung | Verwaltung und Zuteilung von benötigten Ressourcen. Dazu gehören beispielsweise der Hauptspeicher und die Kommunikationsverbindungen |

|---|---|

| Life Cycle Management | Kreierung, Initiierung und Zerstörung von Bean-Instanzen |

| Transaktionsmanagement | Bereitstellung von Mechanismen für die Transaktionsverwaltung |

| Security | Dazu gehört u.a. Verschlüsselung von Kommunikation und Daten und die Authentifizierung von Nutzern und Nutzergruppen |

| Persistenz | Lokales Speichern von EJB-Komponenten und Wiederherstellung nach Ausfällen (beispielsweise des Server-Rechners) |

| Distribution | Verteilung der Enterprise Beans und Entkopplung von der zugrunde liegenden Netzwerkschicht. |

| Load balancing | Aufteilung von Anfragen durch Clients auf gleichartige Enterprise-Beans |

Die Enterprise Beans enthalten die Implementation der Business-Prozess Logik und die zugehörigen Daten. Sie existieren in drei Ausprägungen:

- Session Beans enthalten die Anwendungslogik. Sie sind nicht persistent. In der Applikationsintegration werden sie oft benutzt, um den Zugriff auf bestehende Unternehmensanwendungen zu realisieren.

- Entity Beans dienen zur Modellierung von Unternehmensdaten und dem Zugriff auf diese. Sie repräsentieren eine objektorientierte Sicht auf die zugrunde liegenden persistenten Daten.

- Message driven Beans enthalten, wie die Session Beans, die Anwendungslogik mit dem Unterschied, dass die Kommunikation hier über Nachrichten abgewickelt wird.

Komponentenorientierte Middleware bietet umfassende Lösungen für die Probleme der EAI. Durch sie wird eine Integration auf Geschäftsprozess Ebene (Business-Prozess Level EAI) wesentlich vereinfacht oder erst ermöglicht (siehe [P10]).

Praktische Übungen 1: Parallel-Quicksort

Implementieren Sie ein Quicksort Programm in einem verteilten System. Das Prinzip des Quicksort Algorithmus basiert darauf, dass eine lange Liste von Daten in mehrere Teillisten unterteilt wird und diese Teillisten dann sortiert und wieder zusammengeführt werden. Wenn diese Teillisten nun parallel zueinander sortiert werden können, dann kann der Sortiervorgang weiter beschleunigt werden.

Beim „gewöhnlichen“ seriellen Quicksort geschieht folgendes: Um eine Folge F = k1,...,kN von N Elementen anhand des Quicksort Algorithmus der Größe nach zu sortieren, wählt man als erstes ein beliebiges Element k = {k1,...,kN}, das als Pivotelement verwendet wird. Anhand dieses Elements wird die Folge F in zwei Teilfolgen geteilt, wobei die erste Teilfolge nur Elemente beinhaltet die kleiner oder gleich k sind, die zweite Teilfolge nur Elemente die größer oder gleich k sind. Nun wird dieses Verfahren für die beiden Teilfolgen rekursiv wiederholt. Zuletzt werden alle Teilfolgen zusammengesetzt.

Der erste Schritt des parallelen Quicksorts ist identisch mit dem des seriellen. Man wählt aus der Folge F = k1,...,kN ein beliebiges Element k = {k1,...,kN} das als Pivotelement dient. Jetzt werden die Teilfolgen Subset 1 und Subset 2 nicht vom gleichen Prozess weiterverarbeitet, sondern jede Teilfolge wird an einen anderen Prozess geschickt. Dort werden die Teilfolgen wieder in Teilfolgen unterteilt und an weitere Prozesse verschickt. Dies geschieht so lange bis jeder Prozess im System in dem man sich befindet eine Teilfolge zur weiteren Verarbeitung zur Verfügung hat. Diese CPUs führen dann den seriellen Quicksort durch bis ihre Teilfolge sortiert ist und schicken dieses Ergebnis an die erste CPU. Sobald alle Ergebnisse zur Verfügung stehen ergeben diese dann die geordnete Folge F.

Details und weitere Erklärungen zum Quicksort Algorithmus finden Sie unter:

Die folgenden Übungsvarianten sollen mit Hilfe der Programmiersprache Java gelöst werden. Beantworten Sie auch die Frage, unter welchen Bedingungen Ihre Implementation eines Parallelen Algorithmus dem eines seriellen überlegen ist, also: Unter welchen Bedingungen ist ein verteilter Quicksort schneller als ein lokal-serieller. Die zu sortierende Liste soll aus einer Reihe zufällig erzeugter Zahlen bestehen. Beschreiben Sie Ihre Implementierung auf 3-5 Seiten.

Parallel Quicksort Implementierung mit Threads

Implementieren Sie den oben beschriebenen parallelen Quicksort Algorithmus in einem Java Programm. Dabei soll jede Teilliste in einem eigenen Thread implementiert werden. Am Ende der Sortiervorgänge sollen die Teillisten wieder zusammengeführt werden.

Information zu Java Threading finden unter anderem unter:

Parallel Quicksort Implementierung mit TCP/Sockets

Implementieren Sie den oben beschriebenen parallelen Quicksort Algorithmus in einem Java Programm. Dabei soll jede Teilliste in einem eigenen Java Programm sortiert werden. Die Java Programme sollen dabei die Teillisten mit Hilfe von einfachen TCP-Sockets verschicken. Am Ende der Sortiervorgänge sollen die Teillisten wieder zusammengeführt werden.

Information zur Java Socket Programmierung und Objekt-Serialisierung finden unter anderem unter:

Parallel Quicksort Implementierung via HTTP GET/POST

Implementieren Sie den oben beschriebenen parallelen Quicksort Algorithmus in einem Java Programm. Dabei soll jede Teilliste in einem eigenen Java Programm sortiert werden. Die Java Programme sollen dabei die Teillisten mit Hilfe von HTTP GET oder POST Requests verschicken. Am Ende der Sortiervorgänge sollen die Teillisten wieder zusammengeführt werden. Die fertig sortierten Teillisten können in der 200 OK Antwort-Nachricht zurückgegeben werden.

Bibliotheken und Dokumentation zur Verwendung von HTTP in Java finden unter anderem unter:

Parallel Quicksort Implementierung via XML-RPC

Implementieren Sie den oben beschriebenen parallelen Quicksort Algorithmus in einem Java Programm. Dabei soll jede Teilliste in einem eigenen Java Programm sortiert werden. Die Java Programme sollen dabei die Teillisten mit Hilfe des XML-RPC Protokolls austauschen. Am Ende der Sortiervorgänge sollen die Teillisten wieder zusammengeführt werden.

Bibliotheken und Dokumentation zur Verwendung von XML-RPC in Java finden unter anderem unter:

Parallel Quicksort Implementierung via Java RMI

Implementieren Sie den oben beschriebenen parallelen Quicksort Algorithmus in einem Java Programm. Dabei soll jede Teilliste in einem eigenen Java Programm sortiert werden. Die Java Programme sollen dabei die Teillisten mit Hilfe des XML-RPC Protokolls ausgetauscht werden. Am Ende der Sortiervorgänge sollen die Teillisten wieder zusammengeführt werden.

Informationen zur Verwendung von Java RMI finden unter anderem unter:

Praktische Übungen 2: Verteilte Datenspeicherung

Im Angesicht von populären Filesharing Diensten und P2P Netzwerken soll in dieser Übung eine sehr einfache Variante von verteilter Datenspeicherung implementiert werden. Dabei soll ein beliebiger Knoten in einem Netzwerk zwei verschiedene Befehle implementieren:

- put_data(key, data)

- data = get_data(key)

Dabei stellt der Parameter „key“ eine Zeichenkette (einen String) dar, welche Schlüssel benutzt, um die Daten, beschrieben durch die Variable „data“, ab zuspeichern und wiederzufinden. Der Schlüssel soll eindeutig sein. Der Einfachheit halber sollen auch die Daten durch eine Zeichenkette repräsentiert sein (für Fortgeschrittene könnte man dies erweitern, sodass ein beliebiges Objekt abgespeichert werden kann). Diese beiden Funktionen sollen in etwa so funktionieren wie die allseits bekannten Hashtables, assoziativen Arrays oder die sog. Dictionaries.

Nun sollen aber nicht alle Daten auf dem selben Rechner gespeichert werden. Dazu soll ein einfacher Verteilalgorithmus herangezogen werden, um die zu speichernden Daten auf verschiedene Rechner zu verteilen. Der einfachste Form eines sogenannten Hashalgorithmus könnte so aussehen:

Speichere alle Daten deren Schlüssel „key“ Zeichenkette beginnt mit

- A,B,C, auf Rechner 1 abspeichern

- D,E,F, auf Rechner 2

- G,H,I auf Rechner 3 und so weiter bis Z

Sie können aber auch einen anderen Hash-Algorithmus verwenden, um die Daten zu verteilen.

Beim Implementieren müssen Sie nicht 8 Rechner einsetzen Es reicht, wenn alle Programm-Instanzen auf einem Rechner laufen, aber an verschiedenen Adressports lauschen. Dabei sollten 4 Instanzen ausreichend sein.

Sie müssen die zu Speichernden Daten dabei nicht persistieren, d.h. wenn Sie Ihr Programm beenden sind auch die Daten verloren (bei einem richtigen Produkt dürfte so was natürlich nicht passieren).

Verteilte Datenspeicherung via XML-RPC

Implementieren Sie die oben beschriebene verteilte Datenspeicherung in einem Java Programm. Die Java Programme sollen dabei die get_data() und put_data() Funktionen mit Hilfe des XML-RPC Protokolls realisieren.

Bibliotheken und Dokumentation zur Verwendung von XML-RPC in Java finden unter anderem unter:

Verteilte Datenspeicherung via Java RMI

Implementieren Sie die oben beschriebene verteilte Datenspeicherung in einem Java Programm. Die Java Programme sollen dabei die get_data() und put_data() Funktionen mit Hilfe von Java RMI realisieren.

Informationen zur Verwendung von Java RMI finden unter anderem unter:

Verteilte Datenspeicherung via SOAP

Implementieren Sie die oben beschriebene verteilte Datenspeicherung in einem Java Programm. Die Java Programme sollen dabei die get_data() und put_data() Funktionen mit Hilfe des SOAP Protokolls realisieren.

Bibliotheken und Dokumentation zur Verwendung von SOAP in Java finden unter anderem unter:

Grid Computing – Computer im Raster

In dieser Lektion werden die Grundbegriffe wie sie im Grid Computing verwendet werden erklärt und dargestellt. Dieser Teil / diese Lektion des Studienheftes gilt als Ergänzung zu den anderen Lektionen die auch die theoretischen Grundlagen der praktischen Übungen darstellen.

Das „Grid“ wurde Mitte der 90er Jahre erfunden und bezeichnet eine verteilte Rechner Infrastruktur die für wissenschaftliche und ingenieurtechnische Problemstellungen konzipiert ist. Was Grid Computing auszeichnet bzw. von anderen Technologien wie z.B. dem Internet, enterprise, verteiltem und Peer-to-Peer Computing unterscheidet ist das zugrundeliegende Konzept. Damit ist das koordinierte Teilen von Ressourcen und Lösen von Problemen in dynamischen, multi-institutionellen Virtuellen Organisationen (VO). Dieses Teilen ist nicht auf den Austausch von Files beschränkt sondern fokussiert vielmehr auf den direkten Zugriff auf Computer, Software, Daten und anderen Ressourcen. Zur Frage was geteilt werden darf, die entsprechenden Befugnisse und die Bedingungen unter denen dies geschehen darf werden von Ressourcen Providern und Verbrauchern gleichermaßen streng kontrolliert. Dazu notwendige Regeln werden durch eine Menge bestehend aus Individuen und/oder Institutionen definiert und als VO bezeichnet.

Was ist das Grid?

Die „Erfinder“ Ian Foster und Carl Kesselman beschreiben Grid Computing als

| „A computational grid is a hardware and software infrastructure that provides dependable, consistent, pervasive, and inexpensive access to high-end computational capabilities.“ |

|---|

und weisen darauf hin, dass Grid die angesprochenen Themen wie z.B. on-demand access auf Rechenleistung, Daten und Dienste bereits in den späten 60ern des vorigen Jahrhunderts erörtert wurden.

So schreibt Len Kleinsrock 1969:

| „We will probably see the spread of ‚computer utilities‘, which, like present electric and telephone utilities, will service individual homes and offices across the country.“ |

|---|

Im Jahr 2000 verfeinern Ian Foster und Steve Tuecke im Paper „The Anatomy of the Grid“ diese Definition, um soziale und Policy Aspekte einzubinden. Grid Computing behandelt demnach „coordinated resourse sharing and problem solving in dynamic, multi-institutional virtual organizations“. Der Schlüssel dazu ist das Verhandeln von Ressourcen-Sharing Maßnahmen zwischen einer Menge unterschiedlicher teilnehmender Partnern wie z.B. Providers und Customers. Dieser so entstehende Ressourcen-Pool kann dann für unterschiedliche Zwecke genutzt werden.

Folgende weitere Definition dazu von Foster und Tuecke:

| „The sharing that we are concerned with is not primarily file exchange but rather direct access to computers, software, data and other resources, as is required by a range of collaborative problem-solving and resource-brokering strategies emerging in industry, science, and engineering. This sharing is, necessarily, highly controlled, with resource providers and consumers defining clearly and carefully just what is shared, who is allowed to share, and the conditions under which sharing occurs. A set of individuals and/or institutions defined by such sharing rules form what we call a virtual organization.“ |

|---|

Auf die speziellen Aspekte der hier erwähnten virtuellen Organisation wird noch genauer eingegangen. Die nun folgende Checkliste fasst den Kern der obigen Definition in drei Punkten zusammen:

- Koordinierte Ressourcen, jedoch nicht zentral kontrolliert

- Verwendung von offenen Standard-, Mehrzweckprotokollen und Interfaces

- Erfüllen von nichttrivialem Quality-of-Service Anforderungen. Dazu zählen allgemein Security, verteilte Workflow- und Ressourcen Management Performance, koordinierte Ausfallsicherung, Services zur Erkennung von Problemen.

Nun stellt sich die Frage, ob nicht auch das Internet selbst ein Grid ist? Schließlich ist es auch offen, verwendet entsprechende Protokolle und erlaubt den Zugriff auf verteilte Ressourcen. Einzig, die Koordination der Ressourcen, um QoS bereitstellen zu können fehlt, zumindest derzeit.

Was aber ist das Grid nun? Was zeichnet Grid Computing aus und wie ist es aufgebaut? Um diese Frage beantworten zu können, zunächst das Konzept der sog. Virtuellen Organisation.

Virtual Organizations (VOs)

Wie bereits eingangs erwähnt ist das Konzept der VO im Grid von zentraler Bedeutung. Um besser zu verstehen worum es sich hierbei handelt, wie sie sich bilden und welches Ziel VO haben, wird anhand der folgenden vier Beispiele exemplarisch dargestellt.

Eine neue Fabrik soll entstehen. Um eine Entscheidung treffen zu können, wird zunächst ein umfangreiches Finanzprognosemodell eines ASPs benötigt. Dieses Modell soll Zugriff auf einschlägige und proprietäre historische Daten einer gemeinsamen Datenbank haben die auf Speichersystemen eines SSP betrieben werden.

In einem Meeting das während der Definitionsphase stattfindet, werden kollaborativ und interaktiv what-if Szenarien durchgespielt. Die in dieser Phase involvierten Abteilungsleiter können dabei auch in unterschiedlichen Städten sein. Der ASP nimmt einen Cycle Provider (CP) [4] unter Vertrag, um für bestimmte Szenarien mehr „Schwung“ zur Verfügung zu haben. Jeder Zyklus muss natürlich den notwendigen Sicherheits- und Performanceansprüche genügen.

Ein Industriekonsortium wurde gegründet mit dem Ziel eine Durchführbarkeitsstudie für ein neues Überschallflugzeug zu erstellen. Es wird dazu eine hochpräzise multidisziplinäre Simulationen des gesamten Flugzeugs durchgeführt. Die Simulation integriert proprietäre Softwarekomponenten die von unterschiedlichen Partnern entwickelt wurden, auf deren Rechnern betrieben werden und Zugriff auf entsprechende Design Datenbanken und andere Daten die durch das Konsortium zur Verfügung gestellt wurden, haben.

Ein Krisenmanagementteam reagiert auf einen chemischen Unfall und benutzt dazu lokale Wetter- und Bodenmodelle, um die Verbreitung der chemischen Substanzen in der Umwelt abzuschätzen. Dabei werden auch die Auswirkungen auf die Bevölkerung sowie geographische Eckdaten wie z.B. Flüsse, Trinkwasserversorgung udgl. einbezogen. Das Ergebnis ist ein vorläufiger Plan zur Entschärfung akuter Gefahrensituationen und beinhaltet Aufgaben für Katastropheneinsätze, Evakuierungsmassnahmen sowie die Verständigung von Spitälern um einige der wichtigsten Maßnahmen zu nennen.

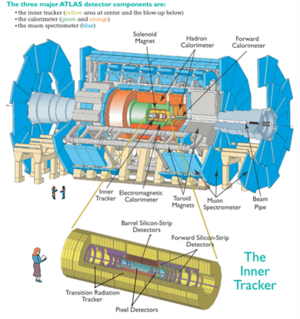

Tausende Physiker in hunderten Laboratorien und Universitäten weltweit kommen zusammen, um den LHC [5] am CERN zu entwerfen, zu bauen und zu betreiben sowie die Ergebnisse aus den kollidierenden Teilchen auszuwerten und unter anderem die Existenz des Higgs-Bosons zu beweisen was einen weiteren Durchbruch zum Verständnis des Standardmodells der Elementarteilchenphysik bewirkt.

Während der Analysephase werden Rechen-, Speicher- und Netzwerkressourcen konzentriert, um ein sog. „Data Grid“ zu erstellen mit dem es möglich ist Petabytes [6] an Daten zu analysieren.

Die vier hier dargestellten Beispiele unterscheiden sich in vielen Punkten. Die Anzahl der Mitwirkenden, die unterschiedlichen Aktivitäten, die Dauer und der Umfang der verschiedenen Aktivitäten und die verschiedenen Ressourcen die geteilt werden. Trotz dieser zum Teil sehr großen Unterschiede gibt es auch viele Gemeinsamkeiten. So kann eine Organisation in einer oder mehreren VO mitwirken indem sie alle oder nur einige ihrer Ressourcen teilt. Dabei entscheidet jeder Besitzer von Ressourcen wann, wo und welche Ressourcen benutzt werden können. So könnte z.B. eine VO Partnern erlauben ihre Simulationsdienste nur für sehr einfache Aufgaben zu nutzen. Ebenso können die Verbraucher von Ressourcen Bedingungen stellen. So könnte der Nutzer einer Ressource verlangen, dass nur solche Ressourcen bereitgestellt werden, die auch als sicher gelten.

Zur Umsetzung solcher Bedingungen werden entsprechende Mechanismen benötigt, die Policies ausdrücken, die Identität eines Nutzers oder einer Ressource herstellen (Authentisierung) und entscheiden, ob eine Operation für die eingesetzten Beziehungen konsistent ist (Authorisation).

Grid Architektur Allgemein

Die Einrichtung, das Management und die Nutzung von dynamischen, über mehrere Organisationen agierende VO und der somit entstehenden Beziehungen bedingt eine Reihe neuer Technologien. Als Ausgangsbasis wird angenommen, dass eine VO Beziehungen zu jeglichen potentiellen Nutzern aufbauen können muss, um bestmöglich zu funktionieren. Damit sind Fragen rund um die Interoperabilität und somit die Verwendung gemeinsamer Protokolle in einer vernetzten Umgebung von besonderer Wichtigkeit und einer der Kernpunkte. Eine Grid Architektur lässt sich deshalb auch als eine Protokollarchitektur verstehen. Diese definieren die Grundmechanismen mittels derer Benutzer von VO und Ressourcen Beziehungen untereinander ausverhandeln, managen und diese auch nutzen. Solche Standard Protokolle erlauben die Erstellung von (Application Programming Interface) APIs und Software Development Kits (SDK), um die notwendigen Abstraktionen zu schaffen, die eben für ein brauchbares Grid notwendig sind. Die Summe dieser Technologien wird auch als Middleware („the services needed to support a commmon set of applications in a distributed network“) [7] bezeichnet.

Interoperabilität

Interoperabilität ist deswegen so wichtig, um sicher zu stellen, dass Beziehungen zwischen den unterschiedlichsten Beteiligten hergestellt, neue Teilnehmer aufgenommen werden können werden, und dies über verschiedene Plattformen, Sprachen und Programmierumgebungen hinweg. Dementsprechend müssen diese Mechanismen so implementiert sein, dass sie über die organisatorischen Grenzen, operationalen Policies und Arten von Ressourcen hinweg agieren können. Andernfalls müssten Anwendungen und Nutzer von VOs bilaterale Beziehungen eingehen da sonst nicht sichergestellt werden kann, dass die genutzten Mechanismen auch auf andere anwendbar ist. Universell eingesetzte Protokolle wie HTTP und HTML sind Beispiele die zeigen, wie der Austausch von Informationen weltweit ermöglicht wurde. Ebensolche Protokolle und Syntax werden im Grid benötigt, um die Möglichkeit des Austausches von Informationen zwischen Ressourcen im Grid zu ermöglichen.

Protokolle

Interoperabilität hängt also stark von den verwendeten Protokollen ab die definieren, wie die unterschiedlichen Elemente in verteilten Systemen miteinander interagieren, um ein bestimmtes gewünschtes Verhalten zu erreichen. Der Fokus liegt damit auf den externen Interaktionen anstatt auf internen Aspekten wie z.B. Software und Charakteristika von Ressourcen was Vorteile mit sich bringt. VOs benötigen Mechanismen die neue Ressourcen finden, Identitäten erstellen, Autorisationen feststellen und neue Aufteilungen initiieren. Die dazu notwendigen Protokolle müssen flexibel und leichtgewichtig sein, um Ressourcenteilungen so schnell als möglich herzustellen und auch wieder abbauen zu können.

Da VOs sich eher ergänzen anstatt existierende Institutionen zu ersetzen dürfen solche Mechanismen zum Austausch von Ressourcen keine Änderungen der lokal verwendeten Policies erzwingen. Weiters muss gewährleistet sein, dass jede Institution weiterhin die Kontrolle über ihre Resourcen bewahren kann.

Services

sind ausschließlich durch das Protokoll definiert und das Verhalten das es implementiert. Die Definition von Standard Services für Zugriffe auf Berechnungen, Daten, dem Finden von Ressourcen, Co-scheduling, Replizieren von Daten usw. erlaubt Services die von VO angeboten werden zu erweitern, um so weiters ressourcenspezifische Details zu abstrahieren die sonst für die Entwicklung von VO Anwendungen hinderlich wären.

APIs

dienen dazu, die Entwicklung von anspruchsvollen Anwendungen in komplexen und dynamischen Umgebungen zu ermöglichen. Anwender wiederum müssen diese wiederum bedienen können. Robustheit, Richtigkeit, Entwicklungs- und Wartungskosten sind dabei wichtige Anliegen. Standard Abstraktionen, APIs und SDKs können die Entwicklung beschleunigen, verteilte Nutzung von Code ermöglichen und somit die portable Anwendungen ermöglichen. APIs und SDKs sind also ein Zusatz statt Alternative zu den Protokollen. Ohne Standard Protokolle kann Interoperabilität nur auf API Level erreicht werden und das nur durch eine einzige Implementierung die überall eingesetzt wird oder indem jede Implementierung die Details aller anderen Implementierungen kennt. Das ist jedoch für viele interessante VOs undurchführbar. So ist z.B. der Jini Ansatz wo Protokoll Code von remote sites geladen wird keine Lösung. [8]

Zusammenfassend ist es wichtig festzuhalten, dass für die Betrachtung einer Grid Architektur zunächst die Identifikation und Definition von Protokollen und Services im Vordergrund stehen, dann die der APIs und SDKs.

Überblick über internationale, europäische und nationale Forschungsprojekte im Grid Computing Bereich

Es existieren eine Vielzahl unterschiedlicher Grid Projekte auf internationaler, europäischer und nationaler Ebene. Im Folgenden wird auf einige dieser Pojekte kurz eingegangen.

Internationale Grid Projekte

Globus/Globus Alliance: Globus Toolkit

Das Globus Toolkit wurde von der Globus Alliance entwickelt. Es ist ein Open Source Software toolkit zur Erstellung von Grid Systemen und Anwendungen.

Die drei Hauptfunktionen sind Execution, Data und Information Services. Diese basieren auf einer Public Key Infrastrukture (PKI).

Die erste produktive und somit weit verbreitete und eingesetzte Version war die Version 2. Diese implementierte drei Funktionen durch drei unabhängige TCP/IP Server die via Sockets über selbst definierte Protokolle kommunizierten. Globus Ressource Allocation Manager (GRAM) stellt eine Laufzeitumgebung zur Verfügung. GridFTP ist ein hochperformantes, sicheres und verlässliches Datentransferprotokoll das für wide-ares Netzwerke mit hoher Bandbreite optimiert ist. Das Monitoring und Discovery Service (MDS) ist ein LDAP Verzeichnisdienst und stellt die Informationsservicekomponente des Globus Toolkit 2 (GT2) dar. Die von Foster vorgestellte Grid Protokoll Architektur, die die Wichtigkeit der Standardprotokolle herausstreicht, um VO zu realisieren, wird in dieser Implementierung der Protokolle umgesetzt. Viele andere Grid Projekte wenden diese Version des Toolkits an.

Die Open Grid Service Architecture (OGSA) beschreibt einen Service Bus, um die Grid Infrastruktur mit allgemeinem Verhalten und Semantik erstellen zu können, während die Open Grid Service Infrastructure (OGSI) Spezifikation die Schnittstellen eines Grid Services definiert. Da OGSI zu proprietär war, um in größerem Rahmen verwendet zu werden, wurde sie durch die Web Services Resource Framework (WSRF) neu spezifiziert. WSRF sind im Globus Toolkit Version 4 (GT4) verfügbar und sind als reine Web Services spezifiziert.

Gridbus

Dieses Projekt ist ein technisch orientiertes Entwicklungsprojekt für Next-Generation Cluster und Grid Technologien die echtes Utility-driven Service Oriented Computing unterstützen. Der Name leitet sich vom Forschungsthema ab, Next-Generation GRID Computing and BUsiness Technologien.

Das Gridbus Projekt bietet, ähnlich wie Globus, Komponenten, um ein Grid zu erstellen. Zusätzlich werden ausgeklügelte Services angeboten:

- .NET basiertes Grid Framework (Alchemi)

- Grid Market Directory (GMD)

- Resource Usage Accounting (GridBank)

- Grid Portals (G-monitor, Gridscape)

Legion

Hierbei handelt es sich um ein objektbasiertes Metasystem, entwickelt an der University of Virginia. Es wurde designed, um Millionen Hosts und Trillionen Objekte miteinander über Hochgeschwindigkeitsleitungen zu verbinden.

Im Gegensatz zu Globus, dessen Architektur als Summe von Services verstanden werden kann, stellt Legion eine integrierte Architektur dar, d.h. die Struktur der höheren Ebenen basiert auf einem einzigen vereinten Objektmodell.

Die Firma Avaki bietet Legion Software kommerziell an und integriert auch Enterprise Information Systems. Im Jahr 2005 wurde Avaki von Sybase gekauft.

UNICORE

Uniform Interface to Computing Resources ist eine Middleware, um transparenten und sicheren Zugriff auf High Performance Computing Resourcen zu erlauben. Die Entwicklung von UNICORE wurde bereits 1997 als deutsches Forschungsprojekt gemeinsam mit Siemens, IBM und Hitachi HP gestartet. Weitere Entwicklungen wurden in European Grid Project EUROGRID, GRIP und OpenMolGRID unternommen.

Die Software ist als Open Source Software via SourceForge verfügbar und wird vom UNICORE Form vorangetrieben.

Europäische Grid Projekte

Die europäische Forschung im Grid begann mit der Deklaration der Lissabon Strategie im Jahr 2000. Ziel war Europa bis 2010 in die am meisten kompetitive, wissensbasierte Ökonomie zu transformieren. Dazu wurden die sog. Framework Programs (FP) initiiert, um die Forschung und Entwicklung in den unterschiedlichen zu stärken. Diese Programme laufen üblicherweise einige Jahre lang.

Die ersten Grid Projekte die von der EU unterstützt wurden liefen unter FP5. Die folgenden drei Projekte stehen repräsentativ für FP5, stellen also zugleich einen kurzen historischen Abriss dieser Zeit dar.

GRIA

In diesem Projekt standen die Entwicklung von Geschäftsmodellen und Prozessen die eine kosteneffiziente und effektive Nutzung von Rechenzeit in einem offenen Grid Marktplatz zur Verfügung stehen, im Vordergrund. Dieser Grid Marktplatz und die dazu entwickelten Modelle sollten weiters helfen, die Nachfrage nach Ressourcen besser zu nutzen und zu verwalten. Da die Grid Middleware zu dieser Zeit noch nicht ausgereift genug war, um verlässliche Anwendungen anbieten zu können, wurden Web Services entwickelt, die diese Funktionalitäten anboten. Zu den weiteren Entwicklungen gehörten Performance Abschätzung, QoS, Workflows, Cluster Management, Security sowie die Semantik für Interoperabilität.

EU Data Grid

Hier standen die Entwicklung von Techniken zur Verarbeitung und Datenspeicherung wie sie für Next Generation Scientific Research benötigt werden im Vordergrund. Die dazu notwendige Infrastruktur sollte rechenintensive Analysen von groß angelegten shared Datenbanken ermöglichen. Die Dimensionen bewegten sich im Bereich von mehreren hundert TerraBytes bis PetaBytes, verteilt über unterschiedliche wissenschaftliche Communities.

Es mussten drei unterschiedliche Typen von Ressourcen verwaltet werden. Computing, Storage und Network wofür 12 WPs eingerichtet wurden.

GEMSS

Die Entwicklung von neuen sog. Grid-enabled Werkzeugen zur Verbesserung der Diagnose, der operativen Planung und chirurgischer Prozeduren.

Dazu wurde eine innovative Middleware entwickelt die benutzt werden kann, um Medizinern und Forschern bei Zugriff auf hochentwickelte Simulationen und Bildverarbeitungsdiensten, eine verbesserte vor-operative Planung und Unterstützung bei chirurgischen Eingriffen in nahezu Echtzeit zu ermöglichen.

Dazu wurde auf existierende Grid und Web Technologien gebaut die den notwendigen Standards entsprechen, somit künftige Erweiterungen und Interoperabilität ermöglichen bzw. gewährleisten. Dazu wurde auch eine Testumgebung entwickelt, die die Evaluierung und Validierung der GEMMS Umgebung ermöglichte und auch die Einbindung der Arbeitsumgebungen der damit arbeitenden Leute erlaubte. Des weiteren berücksichtigte GEMSS Fragen rund um Privacy, Sicherheit, Fehlererkennung und Wiederherstellung im Fehlerfall. Auch rechtliche Aspekte wurden berücksichtigt, also aktuelle gesetzliche Entwicklungen und EU Regulationen.

Nationale Grid Projekte

UK eScience

Unter der UK Regierung finanziert ist das UK eScience Schirmprojekt für verschiedene Grid Projekte für unterschiedlichen Anwendungen und Use Cases. Dazu zählen Projekte in den Bereichen Astronomie, Physik, Biologie, Chemie, dem Ingenieurswesen, Finanz und Gesundheit.

OGSA-DAI

Der Fokus richtet sich hier auf die Entwicklung entsprechender Middleware, um den Zugriff und die Integration von Daten aus unterschiedlichen Quellen für das Grid zu ermöglichen. Hierbei stehen im Vordergrund die Identifikation von Rahmenbedingungen, Designentscheidungen, und die Erstellung bzw. Bereitstellung von Software um dies zu erreichen.

TeraGrid

wurde bereits 2004 abgeschlossen und stellte 40 Teraflops Rechenleistung und knapp 2 Petabyte an Speicher dar. Es stellte spezielle Datenanalyen, Visualisierungsressourcen sowie 10-30 Gigabits/s Netzwerkverbindungen zur Verfügung. TeraGrid wurde durch die Grid Infrastructure Group (GIG) an der University of Chicago koordiniert.

Austrian Grid

Dieses Konsortium vereint führende Forscher in unterschiedlichen Bereichen wo fortgeschrittene Computertechnologien mit Partnern im Bereich Grid-abhängiger Anwendungen vereint werden.

Ziel ist die Forschung im Bereich Grid-Computing in Österreich ganz allgemein zu unterstützen und Entwicklungen sowie Kooperationen zwischen verschiedenen Forschungsinstitutionen zu koordinieren.

Das Austrian Grid Projekt wird vom Ministerium für Wissenschaft und Forschung gefördert.

Webservices – Anbieten, Verhandeln und Abarbeiten

In den letzten 10 Jahren hat das Web die Art und Weise verändert wie wir leben. Das war aber erst der Anfang. Das Web ist eine einfache, allgegenwärtige aber bis dahin wenig beachtete Plattform für verteilte Programmierung. Warum wenig beachtet? Nun, die meisten heutigen Webservices haben eigentlich nicht sehr viel mit dem Web zu tun. Im krassen Gegensatz zu seiner Einfachheit bringen diese eine schwergewichtige Architektur für einen verteilten Objektzugriff wie einst COM oder CORBA zu Tage. Viele Webservice Architekturen erfinden die Funktionalitäten des Web neu oder ignorieren diese die das Web so erfolgreich gemacht hat.

Aber das muss nicht so sein. Die nutzvollen Funktionen die Remote Services erfolgreich machen sind uns bekannt. Diese Services existieren bereits und wir benutzen sie jeden Tag. Und diese Services können riesig werden, z.B. die Google Suchmaschine. Was ist das anderes als ein Remote Service, um eine Datenbank abzufragen und eine schön formatierte Antwort zurückzubekommen? Wir denken über Webservices normalerweise nicht als „Services“, weil das Programmierer-vokabular ist und der letztendliche Client einer Web Seite ein Mensch ist, aber ein Service ist es immerhin.

Jede Web Applikation, jede Webseite, ist ein Service. Diese Macht kann man für programmierbare Applikationen nutzen, wenn man anstatt gegen das Web mit Web arbeitet und wenn man es nicht begräbt unter zahllosen Ebenen der Abstraktion. So sollte man dem Web die Webservices zurückgeben (siehe O’Reilly RESTful Services [B4]).

REST

Web Services werden meist mit SOAP oder XML-RPC in Verbindung gebracht. Aber auch mit dem sogenannten REpresentational State Transfer oder kurz REST, einem Architekturstil, können Web Services auf einfache und effektive Weise entwickelt werden.