Lernunterlage - Gesamt: Unterschied zwischen den Versionen

(Die Seite wurde neu angelegt: „{{:UrheberrechtDefault}} <br><hr><br> {{:Benutzer:VOELKL_Peter}} <br><hr><br> {{:Benutzer:EDLER_Johannes}} <br><hr><br> {{:Benutzer:HAYDN_Franziska}} <br><hr><br> {{:Lernunterlage_-_Einleitung}} {{:Lernunterlage_-_Grundlagen_der_Informationssicherheit}} {{:Lernunterlage_-_Betriebliche_Informationssysteme}} {{:Lernunterlage_-_Objekte_der_Beschaffung_betrieblicher_Informationssysteme}} {{:Lernunterlage_-_Formen_des_wissenschaftlichen_Arbeitens}} {{:Lernunte…“) |

|||

| (5 dazwischenliegende Versionen desselben Benutzers werden nicht angezeigt) | |||

| Zeile 1: | Zeile 1: | ||

{{:UrheberrechtDefault}} | {{:UrheberrechtDefault}} | ||

<br><hr><br> | <br><hr><br> | ||

{{:Lernunterlage_-_Einleitung}} | {{:Lernunterlage_-_Einleitung}} | ||

{{: | {{:Computer-_und_Netzwerksicherheit_-_Grundlagen}} | ||

{{:Lernunterlage_-_Betriebliche_Informationssysteme}} | {{:Lernunterlage_-_Betriebliche_Informationssysteme}} | ||

{{:Lernunterlage_- | {{:Lernunterlage_-_Netzwerkommunikaton}} | ||

{{:Lernunterlage_-_Weitere_Schichten}} | |||

{{:Lernunterlage_-_Formen_des_wissenschaftlichen_Arbeitens}} | {{:Lernunterlage_-_Formen_des_wissenschaftlichen_Arbeitens}} | ||

{{:Lernunterlage_-_Literaturverzeichnis}} | {{:Lernunterlage_-_Literaturverzeichnis}} | ||

Aktuelle Version vom 24. Februar 2025, 07:18 Uhr

Vorwort

Sehr geehrte Bewerber*innen des Masterstudiengangs Informationstechnologie!

Die digitale Transformation und der technologische Fortschritt stellen hohe Anforderungen an zukünftige IT-Expert*innen. Unser Masterstudiengang Informationstechnologie vermittelt Ihnen das notwendige Wissen und die praktischen Fähigkeiten, um innovative Lösungen zu entwickeln, komplexe IT-Herausforderungen zu bewältigen und zukunftsweisende Technologien erfolgreich in Unternehmen zu integrieren.

Mit den im Studium erworbenen Kompetenzen in den Spezialisierungen Wirtschaftsinformatik, Data Science & AI, Web Software Engineering & E-Commerce Technology, Security sowie Resilience & Sustainability eröffnen sich für Sie vielfältige Karrierechancen – sowohl auf nationaler als auch auf internationaler Ebene.

Diese Lernunterlage wurde von unseren Lehrenden erstellt und dient Ihnen als Vorbereitung auf den Eignungstest, der ein zentraler Bestandteil des Aufnahmeverfahrens ist. Sie vermittelt Ihnen einen ersten Einblick in die Themenbereiche des Studiengangs und stellt zugleich grundlegendes Wissen bereit, auf das Sie im weiteren Studienverlauf aufbauen werden. Gleichzeitig lernen Sie die didaktische Struktur des Fernstudiums kennen und können sich mit dem selbstständigen und flexiblen Lernen an der Ferdinand Porsche FERNFH vertraut machen.

Im Namen des gesamten Teams wünsche ich Ihnen viel Erfolg und freue mich darauf, Sie bald als Studierende an der Ferdinand Porsche FERNFH begrüßen zu dürfen!

Martin Setnicka, BA MA MSc PhD

Studiengangsleitung Informationstechnologie

Grundlagen der Informationssicherheit

Einleitung

Die Sicherheit der Informationstechnologie ist ein wesentlicher Bestandteil der Unternehmenssicherheit, da viele Prozesse einer intensiven IT-Unterstützung bedürfen und ohne sie nicht mehr, oder nur teilweise, funktionieren können. Es ist daher enorm wichtig, die möglichen Risiken zu kennen und diese, bezugnehmend auf die einzelnen Unternehmensprozesse, bewerten zu können. So umfangreich die Informationssysteme eines Unternehmens sind, so umfangreich sind auch die zu beachtenden Angriffsvektoren, sowie die Szenarien für Datenverlust, Nichtverfügbarkeit und Datendiebstahl. Die Computer- und Netzwerksicherheit ist ein wesentlicher Bestandteil der Informationssicherheit und greift in jede erdenkliche Materie der Informationstechnologie ein.

Die Zwischenfälle im IT-Sicherheitsbereich nahmen in den letzten Jahren immer mehr zu. Einer Statistik der Internet-Sicherheitslage in Österreich von CERT.at und GovCERT.gv.at zufolge ist die Anzahl der IT-Sicherheitszwischenfälle von unter 10 pro Monat im Jahr 2009 auf konstant über 500 pro Monat ab Ende des Jahres 2012 gestiegen. Gegen Ende 2013 kann sogar von 1000 Zwischenfällen pro Monat ausgegangen werden, die Tendenz ist weiterhin steigend. [Ni13, 13]

Informations- und IT-Sicherheit

Rund um den Bereich der IT-Sicherheit gibt es viele, oft falsch verstandene Begrifflichkeiten wie Datenschutz, Datensicherheit und Informationssicherheit [Ha12, 28]. Nachfolgend werden diese Begriffe nun kurz beschrieben, um einen Überblick über die Materie zu verschaffen.

Informationssicherheit

Bei der Informationssicherheit handelt es sich um die ganzheitliche Betrachtung der Sicherheit und den Schutz aller Art von Informationen. Dabei ist es nicht relevant, ob diese Informationen in elektronischer oder nicht elektronischer Form vorliegen.

IT-Sicherheit

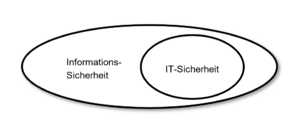

Die IT-Sicherheit ist Teil der Informationssicherheit (siehe Abbildung "Schnittmenge Informations-Sicherheit und IT-Sicherheit"). Sie beschäftigt sich mit dem Schutz aller Art von elektronischer Information. Das beinhaltet alle EDV und Kommunikationssysteme, wie Computer, Internetverbindungen und Netzwerke, Telefonie und die für den Betrieb der Systeme zugrundeliegende Infrastruktur wie beispielsweise die Stromversorgung.

Datenschutz und Datensicherheit

Der Datenschutz regelt den Schutz personenbezogener Daten, welche in elektronischer oder manueller - nicht elektronisch geführter - Form vorliegen. In Österreich ist der Datenschutz sowohl in einem Bundesgesetz (DSG), als auch in 9 Landesgesetzen geregelt.

Jedermann hat, insbesondere auch im Hinblick auf die Achtung seines Privat- und Familienlebens, Anspruch auf Geheimhaltung der ihn betreffenden personenbezogenen Daten, soweit ein schutzwürdiges Interesse daran besteht. Das Bestehen eines solchen Interesses ist ausgeschlossen, wenn Daten infolge ihrer allgemeinen Verfügbarkeit oder wegen ihrer mangelnden Rückführbarkeit auf den Betroffenen einem Geheimhaltungsanspruch nicht zugänglich sind. [Bg19, § 1. (1)]

Die Einhaltung des Datenschutzes ist Teil der Informationssicherheit bzw. IT-Sicherheit und damit des IT-Sicherheitsmanagements. Die beiden Begrifflichkeiten werden jedoch oft vermischt oder verwechselt. So ist der Datenschutz selbst nur ein kleiner Teilbereich. IT-Sicherheit betrachtet wesentlich mehr als den Schutz personenbezogener Daten und bezieht sich auf alle Unternehmensprozesse und ihre IT-Unterstützung.

Säulen der Informationssicherheit - CIA Triade

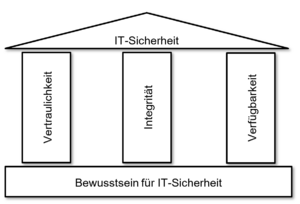

Die IT-Sicherheit und damit das IT-Sicherheitsmanagement basieren auf drei Säulen, welche den zu betrachtenden Rahmen aller durchzuführenden Analysen und den damit verbundenen Maßnahmen darstellen. Sie tragen somit bildlich das Dach der IT-Sicherheit und sorgen nur in ihrer gemeinsamen Betrachtung für die Stabilität und Sicherheit des gesamten IT-Sicherheits-Systems. Ihr Fundament ist das IT-Sicherheitsbewusstsein und die damit verbundene Bewusstseinsbildung ist die notwendige Maßnahme (siehe Abbildung "Aufbau der IT-Sicherheit").

Die drei Säulen sind:

- Vertraulichkeit (Confidentiality),

- Integrität (Integrity) und

- Verfügbarkeit (Availability).

Die drei Säulen der IT-Sicherheit werden oft auch als „CIA-Triade“ [1] oder „AIC-Principles“ bezeichnet, da die englischen Bezeichnungen mit den Buchstaben C, I und A beginnen.

Vertraulichkeit (Confidentiality)

Unter Vertraulichkeit wird die Einschränkung der Datenzugriffe auf einen bestimmten Anwenderkreis verstanden. Unberechtigte dürfen keinen Zugriff auf die IT-Systeme und Daten haben. Dies sind beispielsweise die Absicherung des gesamten Systems vor IT-Zugriffen unberechtigter Dritter und aber auch die Definition unterschiedlicher Berechtigungsstufen innerhalb der berechtigten Anwender. So sollte es beispielsweise einem Anwender erlaubt sein, die benötigten Programme zu starten, nicht jedoch neue Software zu installieren oder die gesamte Datenbank zu kopieren.

Je nach System kann die Vertraulichkeit über Benutzer- und Programm-Berechtigungen und auch physische Zutrittskontrolle sichergestellt werden. Die hier gesetzten Maßnahmen sind jene Maßnahmen, welche am häufigsten mit IT-Sicherheit in Zusammenhang gebracht werden, jedoch ohne Betrachtung der anderen beiden Bereiche Integrität und Verfügbarkeit nicht vollständig sind.

Integrität (Integrity)

Die Integrität ist die Betrachtung des Datenbestandes im Zusammenhang mit allen verfügbaren, und nicht verfügbaren, Daten. Innerhalb des Datenbestandes muss sichergestellt werden, dass die Daten selbst vollständig, unverfälscht, korrekt zusammenhängend und nicht widersprüchlich sind. Das bedeutet, dass der Datenbestand lückenlos sein muss und das Fehlen von Daten ersichtlich sein muss. Auch darf durch die Nichtverfügbarkeit einzelner Daten keine Kettenreaktion auf andere Daten ausgelöst werden, welche wiederum zu weiteren falschen Daten führen würde.

Ein Beispiel hierfür ist das Fehlen von Messwerten eines über das Netzwerk angebundenen Medizinproduktes, welches für eine gewisse Zeit durch eine Störung nicht korrekt angebunden war. Wird dieses Lückenproblem nicht korrekt vom darüberlegenden IT-System behandelt, könnten hierbei falsche Durchschnittswerte entstehen, welche wiederum zu einem falschen Diagnosevorschlag führen würden.

Verfügbarkeit (Availability)

Bei der Verfügbarkeit wird die Funktionsbereitschaft der IT-Systeme zu den Zeitpunkten bezeichnet, zu denen sie benötigt werden. Dabei handelt es sich um alle Maßnahmen gegen Ausfälle oder Datenverlust. Hierbei ist es auch erforderlich den Zusammenhang zwischen den Systemen zu betrachten, da der Ausfall eines als unwichtig erscheinenden Systems andere wichtige Systeme beeinträchtigen könnte.

So kann beispielsweise der Ausfall eines Dateiservers als wenig wichtig eingestuft werden, da die Daten in den Kernprozessen nicht unmittelbar im Zugriff sein müssen. Wenn hingegen eine wichtige Software des Kernprozesses seine Logdateien auf genau diesen Dateiserver ablegen muss, wird die anfangs als unwichtig eingestufte Dateiablage auf einmal zu einer kritischen Komponente, da sonst wiederum die Integrität gefährdet wäre.

Kontrollmechanismen

Rund um die CIA-Triade sind drei Kontrollmechanismen definiert, um ihre grundsätzlichen Ziele im Detail analysieren zu können [Fr13, 29]:

- Physische Kontrolle: Schutz der IT-Systeme vor physischem Zugriff durch Maßnahmen wie Zäune, Schlösser und Wachpersonal.

- Technische Kontrolle: Schutz der IT-Systeme und Daten vor technischen Zugriffen über Netzwerke und Anwenderzugriffe. Beispielsweise durch Benutzerberechtigungen, Firewalls, Datenverschlüsselung und das Verhindern des Betriebs von unerlaubten IT-Komponenten im eigenen IT-System.

- Administrative Kontrolle: Installation, Schulung und Kontrolle von IT-Sicherheitsprozessen und IT-Sicherheitsmanagement und allen damit verbundenen Richtlinien und Vorgaben und die Einhaltung der damit verbundenen Gesetzlichen Vorgaben.

Risiko- und Schwachstelleneinteilung der Schutzziele

Um eine einheitliche Betrachtung und Maßnahmensetzung zu ermöglichen sollten alle Risiken gemäß der Schutzziele der CIA-Triade kategorisiert werden. Eine Einteilung in mehrere Kategorien ist in einigen Fällen möglich, jedoch nicht immer voll abgrenzbar [Ha12, 267]. Im Rahmen der Analyse sollte jedoch stets darauf geachtet werden, eine mögliche Einstufung in jeder der drei Säulen zu bedenken. So kann beispielsweise das Risiko einer Schadsoftware mehr als einem Schutzziel zugeordnet werden, da sie sowohl die Integrität als auch die Verfügbarkeit und die Vertraulichkeit gefährden kann [Ha12, 268].

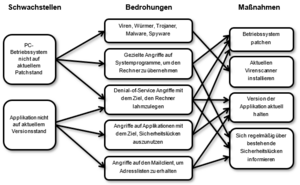

Bei der Analyse der Risiken werden mögliche Schwachstellen der Schutzziele aufgedeckt, welche wiederum zu möglichen Bedrohungen führen. Daraus ergeben sich dann die dafür notwendigen Maßnahmen. Zwischen diesen drei Bereichen bestehen nun einige direkte Abhängigkeiten, die sich jedoch auch oft überschneiden können. Das bedeutet, dass eine Schwachstelle mehrere Risiken bedingen kann und mehreren Risiken durch eine einzelne Maßnahme begegnet werden kann. Abbildung "Zusammenhang von Schwachstellen, Bedrohungen und abgeleiteten Maßnahmen" beschreibt die hier erwähnten Zusammenhänge anhand einiger Beispiele aus dem Softwarebereich:

Die möglichen Bedrohungen durch das Ausnutzen von Schwachstellen werden oft auch als Angriffsvektoren bezeichnet. Ein Angriffsvektor ist dabei der Weg, den ein Angreifer wählen kann um sein jeweiliges Angriffsziel zu erreichen.

Informationssicherheits-Standards

Die IT-Sicherheit und die Einführung und der Aufbau von IT-Sicherheits-Management-Systemen sind in unterschiedlichen Normen und Standards geregelt, die teilweise aufeinander aufbauen oder referenzieren.

Die wesentlichen drei Standards sind:

- die ISO/IEC 2700x Reihe,

- IT-Grundschutz-Standards des Bundesamtes für Sicherheit in der Informationstechnik (BSI) und

- das Österreichische Informationssicherheitshandbuch.

ISO/IEC 2700x Reihe

Eine Reihe verbreiteter internationaler Informationssicherheits-Standards ist die ISO/IEC 2700x Reihe. Sie wurde von der International Organization for Standardization (ISO) und der International Electrotechnical Commission (IEC) begründet und wird stetig ausgebaut.

Das Basisdokument der Reihe ist die ISO/IEC 27000 [Is14] (Informationstechnologie, Sicherheitstechnik, Informationssicherheits-Managementsysteme). Sie definiert die Grundbegriffe und bietet einen Gesamtüberblick. Einige Teile der Reihe wurden von Standards der British Standards Institution (BSI) abgeleitet.

Die grundlegenden Teile der ISO/IEC 2700x sind:

- ISO/IEC 27001 bis 27004: Definition, Betrieb und Kontrolle von Informationssicherheits-Managementsystemen (ISMS) und

- ISO/IEC 27005: Informationssicherheits-Risikomanagement.

Die weiteren Teile beschäftigen sich mit dem Audit und branchenspezifischen und technischen Ausprägungen der ersten fünf Standards. Ein Beispiel dafür ist die EN ISO 27799, welche sich auf das Sicherheitsmanagement im Gesundheitswesen bezieht.

IT-Grundschutz-Standards des Bundesamtes für Sicherheit in der Informationstechnik (BSI)

Der BSI IT-Grundschutz Standard teilt sich in mehrere Dokumente. Er wird durch das Bundesamt für Sicherheit in der Informationstechnik (BSI) der Bundesrepublik Deutschland stetig weiterentwickelt und herausgegeben.

Die Teile des IT-Grundschutz sind:

- BSI-Standard 100-1: Managementsysteme für Informationssicherheit (ISMS) [Bu08a],

- BSI-Standard 100-2: IT-Grundschutz-Vorgehensweise [Bu08b],

- BSI-Standard 100-3: Risikoanalyse auf der Basis von IT-Grundschutz [Bu08c] und

- BSI-Standard 100-4: Notfallmanagement [Bu08d].

Bei allen BSI Standards handelt es sich um Empfehlungen zu Methoden, Prozessen und Verfahren der Informationssicherheit. Die Standards dienen der fachlichen Unterstützung von Anwendern der Informationstechnik und bieten die Möglichkeit, entweder die Empfehlungen direkt zu verwenden oder diese erforderlichenfalls an die eigenen Bedürfnisse anzupassen. [Bu15]

Österreichisches Informationssicherheitshandbuch

Beim Österreichisches Informationssicherheitshandbuch [Ze13] handelt es sich um ein vom Österreichischen Bundeskanzleramt herausgegebenes Werk, welches teilweise auf bestehenden Standards und Normen wie den BSI IT-Grundschutz und die ISO/IEC 2700x aufbaut und Vorgehensweisen für den Aufbau und Betrieb von Informationssicherheit-Management-Systemen. Die Struktur entspricht dabei derer der ISO/IEC 27001 und ISO/IEC 27002.

Das Informationssicherheitshandbuch beschreibt seine eigene Ausrichtung und Umfang wie folgt: Von der Ausrichtung versteht sich das Informationssicherheitshandbuch […] als Sammlung von Leitlinien und Empfehlungen für die Praxis, die entsprechend den spezifischen Anforderungen und Bedürfnissen in einer Einsatzumgebung angepasst werden müssen. Dies wird auch durch die Online-Funktionalitäten wie Checklisten unterstützt. Es soll eine Ergänzung zu den bestehenden Regelungen und Vorschriften (Datenschutzgesetz, Informationssicherheitsgesetz, Verschlusssachenvorschriften, Amtsgeheimnis, …) darstellen und setzt diese weder außer Kraft noch steht es zu ihnen im Widerspruch. [Ze13, 27]

Informationssicherheits-Management

IT-Security ist keine Software, kein Werkzeug und auch kein Zustand. IT-Security ist ein Prozess! [KRS08, 401]

Dieser Satz beschreibt die grundlegende Definition bereits ganz gut. Um IT-Sicherheit einzuführen benötigt es keiner einzelnen Produkte oder reiner persönlicher Ansichten, sondern einen unterstützenden Unternehmensprozess des IT-Sicherheitsmanagements. Es kann dabei nicht als eigenständiges Vorhaben betrachtet werden, sondern gliedert sich in die Betrachtung aller Geschäftsprozesse mit ein. Ein wesentlicher Fehler wäre es, sie Einführung von IT-Sicherheit als zeitlich begrenztes Projekt abzuwickeln, ohne danach einen funktionierenden Managementprozess zu haben, der sich um die Aufrechterhaltung und stetige Verbesserung des IT-Sicherheitsstatus kümmert.

Der Schutz von Informationen und Daten ist auch für kleine und mittlere Unternehmen von großer Bedeutung, da für diese ein entsprechender Verlust von Daten oder deren Manipulation, sehr rasch, ein existenzbedrohendes Potential annehmen kann. [Fr13, 8]

Die Implementierung eines durchgängigen und effizienten IT-Sicherheitsmanagements bedarf detailliertes Wissen über das betreffende Unternehmen und Fachkompetenz im Bereich der IT und IT-Sicherheit. Durch standardisierte Methoden und vormodellierte interne Kontrollsysteme kann es jedoch ermöglicht werden, den operativen Teil des IT-Sicherheitsmanagements durch Spezialisten der Geschäftsprozesse mit IT-Basiswissen durchzuführen.

Um IT-Sicherheitsmanagement in einem Unternehmen zu implementieren, wird ein IT-Sicherheitsmanagement-System (ISMS) aufgesetzt. Dieses System ist die Grundlage des IT-Sicherheitsprozesses, welcher, als Managementprozess, wiederum durch entsprechende Prozessnahtstellen Teil aller Unternehmensprozesse ist.

Ein ISMS ist ein Teil eines allgemeineren, umfassenderen Management-Systems, das andere Teile der Organisation, möglicherweise die gesamte Organisation, und weitere Themen umfasst. Das ISMS baut auf der Einschätzung der Geschäftsrisiken auf. Ein ISMS sollte daher als ein Mittel verstanden werden, mit dem das Management einer Organisation auf erkannte Risiken im Geschäft der Organisation reagiert. [KRS08, 45f]

Die Vorgehensweise für die Installation eines ISMS ist im BSI-Standard folgendermaßen beschrieben [Bu08a, 24ff]:

- Festlegung des Geltungsbereiches, für den das ISMS gelten soll

- Ermittlung von Rahmenbedingungen

- Formulierung von Sicherheitszielen und einer Leitlinie zur Informationssicherheit

- Aufbau einer Informationssicherheitsorganisation

Darüber hinaus ist die Einrichtung eines ISMS ein stetig andauernder Prozess, welcher sich in einen Plan-Do-Check-Act Kreiskauf darstellen lässt. Nach der Planung und Implementierung muss das ISMS regelmäßig inhaltlich überprüft werden und die aus der Überprüfung resultierten Erkenntnisse wiederum in die ursprüngliche Planung und damit in die eigentliche Umsetzung integriert werden. In der ISO 27001 ist dieser Kreislauf folgend ausformuliert [II08, 6]:

- Planen (Einrichten eines ISMS): Einrichten einer ISMS-Politik sowie von Zielen, Prozessen und Verfahren, die für das Risikomanagement und die Verbesserung der Informationssicherheit notwendig sind, um Ergebnisse im Einklang mit den übergeordneten Grundsätzen und Zielen der Organisation zu erreichen.

- Durchführen (Umsetzen und Durchführen des ISMS): Umsetzen und Durchführen der ISMS-Politik, Maßnahmen, Prozesse und Verfahren.

- Prüfen (Überwachen und Überprüfen des ISMS): Bewerten und gegebenenfalls Messen der Prozessleistung an der ISMS-Politik, den ISMS-Zielen und der praktischen Erfahrungen, sowie Berichten der Ergebnisse an das Management zur Überprüfung.

- Handeln (Instandhalten und Verbessern des ISMS): Ergreifen von Korrektur- und Vorbeugemaßnahmen, basierend auf den Ergebnissen interner ISMS-Audits und Management-Überprüfungen oder anderer wesentlicher Informationen, um eine ständige Verbesserung des ISMS zu erreichen.

Wichtige Teile eines ISMS sind daher auch das IT-Business Continuity Management und das IT-Risikomanagement, sowie die sich daraus ergebenden IT-Maßnahmenziele. Für die laufende Analyse, Kontrolle und Weiterentwicklung maßgebend ist das interne Kontrollsystem, welches mit geeigneten Methoden und Checklisten für die Schaffung und Einhaltung des gewünschten IT-Sicherheitsstandards sorgt.

Business Kontinuität und Sicherheitszwischenfälle

Das IT-Business Continuity Management besteht aus dem IT-Notfallmanagement und dem IT-Verfügbarkeitsmanagement [Ha12, 149]. Seine Grundlage ist ein funktionierendes IT-Risikomanagement und entsprechende Risikoanalysen, welche wiederum auf den Geschäftsprozessen basieren.

Das IT-Business Continuity Management (IT BCM) konzentriert sich als Teilbereich des Unternehmens-Business Continuity Managements auf diejenigen Arbeitsabläufe und Prozesse, die maßgeblich von IT-Systemen unterstützt werden. [Ha12, 151]

Der Output des IT-Business Continuity Managementprozesses ist der Business Continuity Plan (BCP). In diesem Plan werden konkrete Maßnahmenziele für die jeweiligen Prozesse der Business Impact Analyse (BIA) und den dazugehörigen Risiken aus der Analyse des Notfallmanagements und des Verfügbarkeitsmanagements definiert.

Business Impact Analyse (BIA)

Im Rahmen der Business Impact Analyse werden alle Geschäftsprozesse hinsichtlich ihrer Auswirkungen bei teilweisen, oder gänzlichen Ausfällen analysiert. Dadurch wird festgestellt, auf welche Prozesse im Business Continuity Plan ein besonderes Augenmerk gelegt werden muss und welche vernachlässigbar sind. Sie betrachtet noch keine Risiken im Detail, sondern nur die Auswirkungen des Ausfalls von Prozessen. Dabei werden alle Geschäftsprozesse und Prozessschritte analysiert und entsprechend bewertet.

Harich beschreibt die Durchführung einer Business Impact Analyse in 7 Phasen, welche der Prozessanalyse, sollten die Prozesse noch nicht bekannt sein, nachgestellt sind [Ha12, 156ff]:

- Phase 1 - Vorauswahl der Geschäftsprozesse: Anfertigung einer priorisierten Liste der wichtigsten Prozesse, um weniger wichtige Prozesse aus der Betrachtung auszunehmen, insbesondere die Aussortierung von Prozessen, welche ohne Auswirkungen auf den Unternehmenserfolg für längere Zeit ausfallen dürfen.

- Phase 2 - Schadensanalyse: Entstehender Schaden, wenn der analysierte Prozess die Prozessziele nicht erreicht. Es empfiehlt sich eine Staffelung nach Ausfallszeit, da die entstehenden Schäden meist von der Ausfallsdauer abhängen.

- Phase 3 - Festlegung Prozess Service Level Agreements: Festlegung der maximal tolerierten Ausfallzeit und dem minimalen Wiederanlaufniveau, das ist die minimale Funktionalität die für den Bereich erforderlich ist, je Prozess.

- Phase 4 - Berücksichtigung von Abhängigkeiten: Wenn Prozesse voneinander abhängig sind, dann müssen diese Abhängigkeiten erfasst werden und in die Analyse mit einfließen. So kann ein Prozess einen höheren Service Level benötigen, da ein anderer wichtigerer Prozess von ihm abhängig ist.

- Phase 5 - Priorisierung der Geschäftsprozesse: Aufgrund der Erkenntnisse aus den Phasen 2 bis 4 werden nun die Prozesse erneut priorisiert und gegebenenfalls aus der weiteren Betrachtung ausgenommen. Auch wird definiert, ob in der weiteren Betrachtung ein komplettes Notfallmanagement, oder lediglich die Definition simpler Arbeitsabläufe im Rahmen des BCP notwendig ist.

- Phase 6 - Zuordnung von Werten: Unter Werten werden hier die IT-Systeme verstanden, welche für das Funktionieren des Prozesses benötigt werden beziehungsweise verantwortlich sind. Da diese Zuordnung oft sehr komplex und aufwändig ist, wird empfohlen, sie nur für die wichtigsten Prozesse im Detail durchzuführen.

- Phase 7 - Festlegung Asset Service Level Agreements: In der letzten Phase werden nun die maximalen Ausfallszeiten und Wiederanlaufzeiten für die in Phase 6 zugeordneten IT-Systeme bestimmt. Die Klassifizierung erfolgt dabei über die zugrundeliegenden Prozesse und deren definierten Parametern und Zeiten.

Für die Schadensanalyse in Phase 2 sind im BSI Standard folgende Schadenskategorien definiert [13, p. 37]:

- „niedrig“: Ausfall hat eine geringe, kaum spürbare Auswirkung

- „normal“: Ausfall hat spürbare Auswirkungen

- „hoch“: Ausfall hat erhebliche Auswirkungen

- „sehr hoch“: Ausfall oder Beeinträchtigung führen zu existenziell bedrohlichen Auswirkungen

IT-Notfallmanagement

Das IT-Notfallmanagement hat die grundsätzliche Aufgabe, Methoden und Maßnahmen bereitzustellen, die zur schnellen Lösung einer Krisensituation dienen. Das IT-Notfallmanagement ist ein Sammelbegriff für alle Schritte von der Notfallvorsorge, Notfallübungen über den Notbetrieb bis hin zur Bewältigung eines Notfalls. Es umfasst die Definition von Verantwortlichkeiten, die Erstellung und Pflege von Notfallplänen und aller Maßnahmen, die im Rahmen von Notfällen abzuarbeiten sind. [Ha12, 163f]

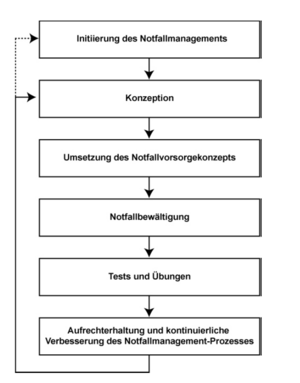

Der Umfang des IT-Notfallmanagements ist ein sehr weitreichender. Die tatsächliche Anwendung ist hier jedoch stark von der Unternehmensgröße abhängig. So ist es in kleinen Unternehmen zwar ebenfalls erforderlich, Überlegungen zu allen Teilbereichen, wie beispielsweise der Notfallorganisation, zu treffen, die Komplexität ist jedoch wesentlich geringer. Es können daher einige Aspekte zusammengefasst betrachtet werden. Die Prozessschritte des Notfallmanagementprozesses laut IT-Grundschutz des BSI [Bu08d] sind in Abbildung "Notfallmanagement-Prozess" entsprechend ihrer Reihenfolge und ihrer Zusammenhänge dargestellt.

Die in der Konzeption des Notfallmanagements zu erarbeitenden Punkte sind:

- Ablauforganisation,

- Krisenkommunikation und

- Notfallhandbuch (Maßnahmenplan, Checklisten).

IT-Risikomanagement

Genauso wie das IT-Sicherheitsmanagement ist das IT-Risikomanagement ein stetiger Prozess. Auch nach Einführung eines Risikomanagementsystems für Informationssicherheit wird es keinen Tag X geben, an dem der CISO [Chief Information Security Officer] verkündet, ab jetzt sei alles sicher. Er wird höchstens sagen können, dass man auf Unsicherheit gezielt und planvoll reagieren kann und genau weiß, auf welche Risiken man sich einlassen will und auf welche lieber nicht. [Kl11, 25]

Das IT-Risikomanagement beschäftigt sich mit der Analyse und Bewertung der IT-Risiken innerhalb der Geschäftsprozesse. Grundlage des IT-Risikomanagements ist somit die Prozessanalyse und die Business-Impact-Analyse, da nicht nur die Eintrittswahrscheinlichkeit, sondern auch die möglichen Auswirkungen wesentlicher Bestandteil der Risikoanalyse sind.

Um die Risiken einzuschätzen ist Erfahrung mit den Geschäftsprozessen und den notwendigen IT-Systemen notwendig. Denn nur durch das aus dieser Erfahrung resultierende Wissen lässt sich die Existenz der Schwachstellen und Bedrohungen feststellen und die zugehörigen Risiken abschätzen. Obwohl die Einschätzung grundsätzlich mit entsprechender Prozess- und Technologieerfahrung möglich ist, werden viele Risiken ohne eine entsprechende Risikoanalyse oft nicht erkannt, da es zusätzlich zu dem möglichen Wissen notwendig ist, sich im Rahmen der Risikoanalyse lückenlos mit dem Prozess auseinanderzusetzen.

Bei dieser Art der Risikoanalyse handelt es sich um den kombinierten Ansatz nach dem Österreichischen Informationssicherheitshandbuch [Ze13, 97]. Hier wird anhand der Schutzbedarfsfeststellung der Business-Impact-Analyse festgelegt, welche Risiken einer detaillierten Analyse (hohe Auswirkung) bedürfen und bei welchen auf einen hohen Detaillierungsgrad verzichtet werden kann (niedrige und mittlere Auswirkung) und eine Grundschutzanalyse ausreichend ist. Die Vorgehensweisen bei diesen beiden Analysearten werden nachfolgend genauer beschrieben.

Detaillierte Risikoanalyse

Die betroffenen Prozesse aus der Business-Impact-Analyse werden nun einer Bedrohungsanalyse und einer Schwachstellenanalyse unterzogen. Dabei wird betrachtet, welche möglichen Bedrohungen zu einer Störung des Prozesses führen können und welche Schwachstellen im Prozess oder seiner IT-Unterstützung diese Bedrohungen begünstigen können. Danach werden die bereits bestehenden Sicherheitsmaßnahmen analysiert und ihr aktueller Nutzen und die korrekte Funktion bewertet. Sobald alle Risiken bekannt sind, werden sie hinsichtlich ihrer Eintrittswahrscheinlichkeit und des möglichen Schadens bewertet und ein Gesamtrisiko berechnet. [Ze13, 97ff]

Um keine mögliche Bedrohung zu übersehen empfiehlt es sich, mit einer Checkliste zu arbeiten, die eine lückenlose Betrachtung aller möglichen Bedrohungstypen oder Kategorien ermöglicht.

Um mit den bewerteten Risiken nun vergleichbare Berechnungen durchführen zu können, werden die Faktoren dabei mit nummerischen Werten für beispielsweise „Niedrig“ bis „Sehr hoch“ beschrieben [Ha12, 304]:

- Niedrig (Wert 1)

- Mittel (Wert 2)

- Hoch (Wert 3)

- Sehr hoch (Wert 4)

Die gängigste und gleichzeitig einfachste Formel zur Berechnung der Risiken ist:

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle Risiko = Schaden*Eintrittswahrscheinlichkeit}

Da jedoch auch die bestehenden Maßnahmen in die Analyse einfließen, wird die Formel in der detaillieren Risikoanalyse um den Faktor Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle Ma\text{ß}nahmen} erweitert, welcher die Eintrittswahrscheinlichkeit wieder verringert:

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle Risiko = Schaden*(Eintrittswahrscheinlichkeit - Ma\text{ß}nahmen)}

Hier wird nicht das bloße Vorhandensein, sondern die Qualität der Maßnahmen bewertet. [Ha12, 301]

Die oben genannte Formel berücksichtigt nur Maßnahmen, welche die Eintrittswahrscheinlichkeit minimieren. Es kann jedoch auch Maßnahmen geben, mit denen der entstehende Schaden gesenkt werden kann. So senkt beispielsweise eine unterbrechungsfreie Notstromversorgung die Eintrittswahrscheinlichkeit eines stromausfallbedingten IT-Systemausfalls, eine automatische Löschanlage in einem Serverraum minimiert hingegen den möglichen Schaden bei einem Brand, nicht aber die Eintrittswahrscheinlichkeit des Brandes. Die endgültige Formel wird daher noch um den Faktor der Schadensminimierenden Maßnahmen erweitert:

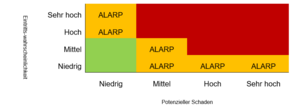

Um nun die Risikoanalyse übersichtlich und gut sortiert darzustellen, können, die Risiken auch in Form einer Risikomatrix dargestellt werden. Dabei empfiehlt sich die Risikomatrix gemäß der ALARP (As Low As Reasonably Practicable) [Kl11, 150f] Methode darzustellen. Die Achsen der Matrix sind hierbei die Eintrittswahrscheinlichkeit und der Schaden, welche in der hier angeführten Analyse noch um die Qualität der jeweiligen Maßnahmen reduziert wurden. Die daraus entstehende Matrix ist in Tabelle "ALARP Risikomatrix" dargestellt. Sie orientiert sich an der von Klipper [Kl11, 151] beschrieben Darstellung und berücksichtigt die Werte Niedrig bis Hoch der oben genannten Bewertung. Der grün dargestellte Bereich ist dabei der „akzeptable Bereich“. Alle hier eingeordneten Risiken müssen nicht weiter behandelt werden. Die Risiken im „ALARP-Bereich“ werden nur behandelt, wenn sie mit sehr einfachen Maßnahmen in den grünen Bereich gebracht werden können. Sie sind somit vorhanden, können aber noch akzeptiert werden. Eine besondere Betrachtung erfordern nur die Risiken im roten „inakzeptablen“ Bereich. Hier müssen Maßnahmen gesetzt werden, die dafür geeignet sind, die Faktoren so weit zu beeinflussen, damit die Risiken in den ALARP Bereich wechseln.

Grundschutzansatz Risikoanalyse

Ziel des Grundschutzansatzes ist es, den Aufwand für die Erstellung eines Informationssicherheitskonzeptes angemessen zu begrenzen. [Ze13, 110]

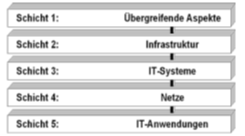

Bei der Grundschutzanalyse wird das IT-System anhand von vorhandenen Bausteinen möglichst genau nachmodelliert. Danach werden die vorhanden Maßnahmen mit den empfohlenen Maßnahmen in Form eines Soll-Ist-Vergleichs verglichen und daraus das weitere Vorgehen abgeleitet. Die einzelnen Bausteine für die Modellierung definieren sich durch die IT-Grundschutz Standards des BSI [Bu13]. Die einzelnen Module sind, der einfacheren Betrachtung halber, in einzelne Schichten gegliedert. Die unterschiedlichen Schichten und der aus Ihnen abgeleitete Aufbau des IT-Systems sind in Abbildung "Schichten des IT-Grundschutz Modells" dargestellt.

Aus den empfohlenen Maßnahmen des jeweiligen Bausteines ergeben sich die Soll-Parameter für das IT-System. Es wird dabei grundsätzlich nicht auf die beiden Faktoren Schaden und Eintrittswahrscheinlichkeit eingegangen, da dies bereits durch die Konzeption des Grundschutzstandards global berücksichtigt wurde. Bei Abweichungen des Ist-Systems müssen entweder Maßnahmen getroffen werden um die Lücke zu füllen, oder die Abweichung mit einer entsprechenden Begründung akzeptiert werden.

IT-Maßnahmenziele

Anhand der Ergebnisse der Risikoanalyse werden nun Maßnahmenziele abgeleitet, um entweder das jeweilige Modul des TI-Grundschutz-Modells zu erfüllen, oder um die in der detaillierten Risikoanalyse ermittelten Risiken auf einen akzeptierten Level zu bringen.

Bevor eine vollkommen neue Maßnahme eingeführt wird, empfiehlt es sich mögliche bereits vorhandene Maßnahmen hinlänglich ihrer Erweiterbarkeit und Verbesserbarkeit zu überprüfen [Ha12, 314], da es sich dabei meist um die schnellste und günstigste Lösung handeln wird.

Die ISO/IEC 27001 definiert im Anhang B [II08, 20ff] folgende Kategorien möglicher Maßnahmenziele:

- Sicherheitspolitik,

- Organisation der Informationssicherheit,

- Management von Vermögenswerten,

- Personelle Sicherheit,

- Physische und umgebungsbezogene Sicherheit,

- Management der Kommunikation des Betriebes,

- Zugriffskontrolle,

- Beschaffung, Entwicklung und Wartung von Informationssystemen,

- Management von Informationssicherheits-Vorfällen,

- Betriebliches Kontinuitätsmanagement (Business Continuity Management) sowie

- Einhaltung von Verpflichtungen.

Die Maßnahmenziele müssen für die eigenen Prozesse ausdefiniert werden und stehen dann als Maßnahmenkatalog zur Begegnung mit den festgestellten Risiken zur Verfügung.

Wiederholungsaufgaben/Übungen

1 Erklären Sie, worin sich die Begriffe Informationssicherheit, IT-Sicherheit und Datenschutz unterscheiden.

2 Was ist die CIA-Triade? Erklären Sie kurz was genau unter C, I und A verstanden wird.

3 Welche Kontrollmechanismen gibt es, um die Ziele der CIA-Triade analysieren zu können?

4 Was versteht man unter Schwachstellen, Bedrohungen und Maßnahmen und wie hängen sie zusammen?

5 Zählen Sie wesentliche Standards der Informationssicherheit auf und erläutern Sie kurz ihre Herkunft und ihren Zweck.

6 Sie sind mit der Durchführung eines Projektes zur Einführung von Informationssicherheit im Unternehmen beauftragt. Welches System werden Sie dazu einführen und was muss nach Projektende unbedingt beachten werden und warum?

7 Erklären Sie kurz den Begriff des IT-Business Continuity Managements. Welche Analysemaßnahmen müssen darin durchgeführt werden und wie hängen sie zusammen?

8 Wie funktioniert eine Risikoanalyse nach dem Grundschutzansatz?

Betriebliche Informationssysteme

Einführung

Informationstechnologie und die darauf aufbauenden betrieblichen Informationssysteme sind aus dem Geschäftsleben nicht mehr wegzudenken. Die zunehmende globale Vernetzung erhöht die Transparenz des Waren- und Dienstleistungsangebots aller Marktteilnehmer*innen. Kund*innen sind heute in der Lage in Sekundenschnelle weltweit Angebote zu vergleichen, die für ihren jeweiligen Bedarf am besten passende Lösung auszuwählen und hürdenfrei Kaufentscheidungen zu treffen.

In den vergangenen Jahrzehnten reduzierten sich die mit dem weltweiten Informationsaustausch und Gütertransport verbundenen Kosten mittlerweile in einem Ausmaß, dass sie in vielen Fällen keinen entscheidenden Einfluss auf die Preisbildung und damit auf die Kaufentscheidung mehr spielen. Dadurch werden Märkte weltweit transparent, und Barrieren, die einzelnen Marktteilnehmer*innen in der Vergangenheit geschützte Marktbereiche gewährten, gehen immer weiter zurück.

Aus diesen Fakten resultiert für Unternehmen die Erfordernis, dem zunehmenden Wettbewerbsdruck durch geeignete Maßnahmen zu begegnen – Maßnahmen, die sich einerseits an die Innenwelt des Unternehmens (wie Verbesserung der innerbetrieblichen Abläufe, Hebung von Rationalisierungspotenzial und Optimierung des Ressourceneinsatzes) und andererseits an die Außenwelt richten (wie etwa eine optimierte Darstellung des eigenen Waren- und Dienstleistungsportfolios, reibungslose Kommunikationsmöglichkeiten mit Kund*innen und Lieferant*innen sowie eine optimale Betreuung von Interessent*innen und Kund*innen).

Der nutzenbringenden Anwendung der Informationstechnologie durch den passenden Einsatz betrieblicher Informationssysteme kommt somit eine erfolgskritische Bedeutung zu, und in diesem Zusammenhang ist auch das einleitende Zitat zu verstehen: Informationstechnologie im Unternehmenseinsatz soll den Menschen dienen und sie von Routineaufgaben freispielen.

Wir wollen uns nachfolgend mit den typischen informationstechnischen Bedarfen eines modernen Unternehmens beschäftigen und damit, wie diesen Aufgabenstellungen durch den Einsatz moderner betrieblicher Informationssysteme begegnet werden kann.

Wir beginnen unsere Betrachtung mit einem kurzen Überblick über die daraus resultierenden Anforderungen an betriebliche Informationssysteme und wie diese gegliedert werden können.

Anforderungen an Betriebliche Informationssysteme

Betriebliche Informationssysteme (BIS) dienen in erster Linie der Aufgabenstellung, die Geschäftstätigkeit des Unternehmens optimal zu unterstützen. Im Kontext dieser Aufgabe unterscheidet man zwischen den Erfordernissen, die durch die Unterstützung der primären Geschäftsprozesse (Kernprozesse) und der sekundären Geschäftsprozesse (administrative Prozesse oder Supportprozesse) entstehen.

Informationslogistisch betrachtet umfasst diese Unterstützungserfordernis die Notwendigkeiten, Informationen und Hilfsmittel in folgender Form anzubieten:

Sie müssen

- in richtiger (d.h. formal und sachlich korrekter) Weise, Form und Qualität – also frei von Fehlern und Interpretationsspielräumen,

- zum richtigen Zeitpunkt - also nur die für die gerade anstehende Aufgabe maßgeblichen Daten, Dokumente und Anwendungen,

- im richtigen Umfang – also nicht mehr als die tatsächlich benötigten Hilfestellungen und Informationen, und

- am richtigen Ort – also an jener Stelle, an der sich der/die Mitarbeiter*in zur Aufgabenbewältigung aufhält

bereitgestellt werden bzw. bereitstehen.

Informationssysteme, die solchen Anforderungen gerecht werden, bestehen im Regelfall aus folgenden voneinander abtrennbaren Teilsystemen:

- Einer Methode und/oder einem Ort der Datenhaltung,

- einem System zur Bearbeitung der Daten, d.h. einer Sammlung von Methoden, um die Daten gemäß der wirtschaftlichen Aufgabenstellung wiederzugeben, zu bearbeiten und aufzuzeichnen, und

- einem Konzept zur betriebswirtschaftlich zielgerichteten Anwendung, also Vorschriften, Regelungen und/oder Modellsammlungen darüber, wie mit Hilfe dieses Datenbearbeitungssystems die Aufgabenstellung sachlich richtig und effizient gelöst werden kann.

Typischerweise werden diese drei Teilsysteme durch folgende informationstechnologische Komponenten abgebildet:

- Datenbanken (z.B. Datentabellen, logische und physische Zugriffspfade und –mechanismen, Datenverwaltungs-, -prüf- und –sicherungsalgorithmen,…)

- Programme (z.B. Dialogbearbeitung, Listendrucke, Auswertungen, Batchprogramme,…)

- Bearbeitungsvorschriften (z.B. integrierte Programmabfolgen, parametrierbare Programme oder Geschäftsprozesse,…)

Die vielfältigen Aufgabenstellungen, denen betriebliche Anwendungssysteme genügen müssen, führten zu der Ausbildung unterschiedlicher Arten an Informationssystemen. Eine mögliche Einteilung wird im nächsten Kapitel vorgestellt.

Einteilung der BIS

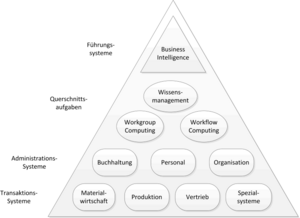

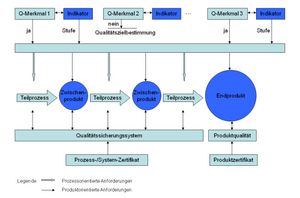

Betriebliche Informationssysteme können nach verschiedenen Aspekten eingeteilt werden, eine übliche Darstellung ist die Einteilung bzw. Gliederung nach dem Anwendungsgebiet (siehe dazu Abbildung "Gliederung nach Anwendungsgebieten") [3] .

Transaktionssysteme

Die Aufgabe von Transaktionssystemen liegt in erster Linie in der Unterstützung der Geschäftstransaktionen, d.h. in der möglichst effizienten Abwicklung des Tagesgeschäfts. In diese Kategorie fallen etwa Produktionsplanungs- und Produktionssteuerungssysteme, Warenwirtschaftssysteme und andere branchenspezifische Anwendungssysteme, welche die jeweiligen Kernprozesse optimal unterstützen. Diese Systeme werden auch operative Anwendungssysteme genannt, eine allgemein übliche Abkürzung dafür ist OLTP (Online Transaction Processing Systems).

Wesentliche Merkmale von Transaktionssystemen sind:

- Rasche Antwortzeiten: Kurze Zeiträume vom Absetzen einer Verarbeitungs-anfrage bis zur Ermittlung und Präsentation des Verarbeitungsergebnisses,

- Transaktionssicherheit: Sichere Verarbeitung parallellaufender Prozesse, Absicherung gegen Datenfehler bei unerwarteten Systemzuständen durch Implementierung von Datensicherheitskonzepten (z.B. Commitment Control) und

- Hohe Durchsatzraten: Möglichkeit der gleichzeitigen Bearbeitung vieler Geschäftsvorfälle pro Zeiteinheit.

Administrationssysteme

Der Aufgabenbereich der Administrationssysteme besteht in der Unterstützung der Verwaltung eines Unternehmens, also der Aufzeichnung, Steuerung und Berichtsbildung aller im Bereich der Finanzbuchhaltung, dem Personalmanagement, der Unternehmensorganisation und der Informationstechnologie resultierenden Aufgaben.

Administrationssysteme entsprechen im Regelfall der Abbildung von sekundären Geschäftsprozessen (Supportprozessen) und sind deshalb typischerweise branchenneutral ausgelegt.

Querschnittssysteme

Dieser Systemtyp ist in nahezu allen Bereichen eines Unternehmens anzutreffen und dient dazu, Kommunikations- und Berichtsaufgaben von Mitarbeiter*innen zu unterstützen. Dazu zählen neben Officesystemen (Textverarbeitung, Tabellenkalkulation, Präsentationstools) auch E-Mail-Systeme und Systeme, welche die Gruppenzusammenarbeit unterstützen.

In diesen Anwendungsbereich fallen auch Methoden des Wissensmanagements und der künstlichen Intelligenz, mit deren Hilfe menschliches Expertenwissen aufbereitet und informationstechnologisch nutzbar gemacht wird.

Business Intelligence

In den Bereich der Business Intelligence fallen Systeme, die aus der großen Menge täglich anfallender Daten entscheidungs- und führungsrelevante Informationen generieren.

Dazu gehören Data Warehouse-Systeme, Data Mining Systeme und Führungs- und Entscheidungsunterstützungssysteme.

Unter Führungssystemen versteht man alle Anwendungen und Hilfsmittel, die einem/r Mitarbeiter*in mit Führungsaufgaben Unterstützung bei der Ausübung seiner/ihrer Tätigkeit bieten. Dazu zählen Abfragesysteme, Kontrollsysteme, Planungs- und Berichtstools, die interne und externe Daten in einer für die Führungsaufgabe sinnvollen Weise verknüpfen.

Die Gruppe der Entscheidungsunterstützungssysteme soll Mitarbeiter*innen bei der Durchführung herausfordernder Planungs- und Entscheidungsaufgaben helfen, in dem komplexe Sachverhalte unter Zuhilfenahme von Modellrechnungen und maßgeschneiderten Algorithmen analysiert und Alternativen in vereinfachter Weise durchgespielt werden können.

Netzwerkkommunikation

Schichtenmodell

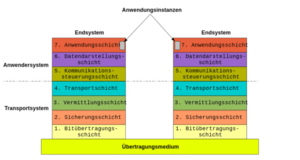

Schichtenmodelle dienen zur Beschreibung der Kommunikation in Rechnernetzen. Jede Schicht löst hierbei einen klar spezifizierten Teil der Problemstellung und bietet Lösungen als Dienst der nächsthöheren Schicht an. Dabei greift die höhere Schicht auf die Dienste der darunterliegenden Schichten zu und muss sich nicht um deren Aufgaben kümmern.

Zur Verdeutlichung betrachten wir das berühmte Beispiel nach Tanenbaum der Kommunikation zweier Philosophen:

„Zwei Philosophen, einer in Kenia, der zweite in Indonesien, wollen Informationen austauschen. Der kenianische Philosoph möchte dem indonesischen Philosoph mitteilen, "dass er Kaninchen liebt". Er kennt aber die indonesische Sprache nicht und auch die genaue Zieladresse ist ihm nicht bekannt. Er übergibt daher seine Nachricht, die in Französisch formuliert ist „J’aime les lapins“, an sein Sekretariat, das sich um alles "Notwendige" zu kümmern hat. Das Sekretariat übersetzt die Nachricht ins Englische, da man weiß, dass man in Indonesien des Französischen nicht mächtig ist. Die übersetzte Nachricht „I love rabbits“ wird an die Poststelle weitergegeben, die die Adresse des Indonesischen Philosophen feststellt und die Nachricht übermittelt. In Indonesien wird die Nachricht von der dortigen Poststelle empfangen und an das Sekretariat zur Übersetzung gegeben, welches die Nachricht ins Holländische (der Sprache des indonesischen Philosophen) übersetzt „Ik hou van konjnen“. Somit kann der indonesische Philosoph die Nachricht verstehen.“

Diese Vorgangsweise entspricht im Wesentlichen der Situation der Kommunikation in einem Rechnernetz. Die unterste Schicht entspricht dem Transportprotokoll, die Nachricht wird über das "Übertragungsmedium" der Post ausgetauscht. Die nächsthöhere Schicht repräsentiert die Adressierung und die nächste Schicht die einheitliche Darstellung. Schließlich ist die oberste Schicht für die Anwendung zuständig, die Interpretation der Daten.

Schichtenkommunikation

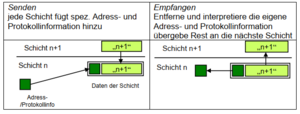

Alle Schichten kommunizieren miteinander, wobei jede Schicht weitere Informationen zur ursprünglichen Nachricht hinzufügt, die nur für den direkten Kommunikationspartner auf der gleichen Schicht relevant sind.

Beispiel:

Sekretariat empfängt Brief, entfernt Information des Sekretariats (den Umschlag mit der Adresse) an der Gegenstelle und reicht den Inhalt (die Briefseiten) übersetzt weiter.

Für jede Schicht existiert eine Steuerinformation, die nur auf der jeweiligen Schicht relevant ist und nicht darüber.

Beim Senden wird daher die Information „eingepackt“ und beim Empfangen „ausgepackt“ (siehe Abbildung).

Ein Kommunikationsprotokoll (communication protocol) ist eine standardisierte Sprache zwischen gleichrangigen Partnern. Sie regelt den Aufbau (Syntax, Inhalte, …) von Meldungen und deren Steuerinformation (Nachrichtenkopf, header) und legt notwendige Antworten fest. Dabei gelten folgende Regeln für die Funktionsweise des Schichtenmodells:

1. Erfüllung der Anforderung der darüber liegenden Schicht

2. Vorhandensein/Inanspruchnahme der Dienstleistungen der darunter liegenden Schicht

3. Einhaltung der Kommunikationsvereinbarung (Protokolle) mit gleichrangigen Kommunikationspartnern im anderen Endsystem

Ein Schichtenmodell (layer model) definiert vereinheitlichte Verfahren und Regeln für den Austausch von Daten durch eine hierarchische Zusammenstellung von Kommunikationsdiensten. Die Dienste einer Schicht kommunizieren mit gleichrangigen Partnern über Protokolle, wobei sie über definierte Schnittstellen auf Dienste der darunterliegenden Schicht zugreifen.

ISO/OSI Referenzmodell

Das ISO/OSI Referenzmodell (International Standardization Organization/Open Systems Interconnection) ist ein allgemeines abstraktes Schichtenmodell für die Kommunikation zwischen Datenstationen in einem offenen, heterogenen Netzwerk.

Es wurde von der ISO in Zusammenarbeit mit internationalen und nationalen Normungsgremien entwickelt.

Es bietet eine Erklärung und Einordnung der wichtigsten Funktionen und Eigenschaften von Kommunikationssystemen und definiert sieben Funktionsschichten (siehe Tabelle 4).

Tabelle 4: OSI-Schichten

| OSI-Schicht | Einordnung | Funktion | |

|---|---|---|---|

| 7 | Anwendungsschicht (Application Layer) | Anwendungssystem | Netzwerkschnittstelle zur Anwendung |

| 6 | Darstellungsschicht (Presentation Layer) |

|

Daten Repräsentation und Verschlüsselung |

| 5 | Sitzungsschicht (Session Layer) |

|

Kommunikation zwischen Rechnern |

| 4 | Transportschicht (Transport Layer) | Transportsystem | Ende-zu-Ende Verbindungen und Verlässlichkeit |

| 3 | Vermittlungsschicht (Network Layer) |

|

Pfad Bestimmung und logische Adressierung |

| 2 | Sicherungsschicht (Data Link Layer) |

|

Physische Adressierung |

| 1 | Bitübertragungssschicht (Physical Layer) |

|

Medium, Signal und binäre Übertragung |

Bitübertragungsschicht (Schicht 1, physical layer)

Die Bitübertragungsschicht legt die physikalisch-technischen Eigenschaften des Übertragungsmediums bei der Übertragung der einzelnen Bits zwischen 2 Datenstationen über ein konkretes Medium fest.

Beispiel: Wie ist die Darstellung der Zustände 0 und 1 durch bestimmte Spannungen, wie lange ist die Signaldauer für ein Bit, welche Modulationsverfahren werden eingesetzt, usw.

Sicherungsschicht (Schicht 2, data link layer)

Die Aufgabe der Sicherungsschicht ist die physische Adressierung der (benachbarten) Kommunikationspartner auf der gemeinsamen Teilstrecke und einen möglichst fehlerfreien Übertragung zwischen zwei benachbarten Datenstationen bereitzustellen, sowie den Zugriff auf das Übertragungsmedium zu regeln. Dazu wird der Bitdatenstrom in Blöcke, sogenannte „Frames“, oder Rahmen aufgeteilt. Die Sicherungsschicht verwendet hierbei die Dienste der Bitübertragungsschicht.

Die Sicherungsschicht besteht aus zwei Teilschichten (Sublayer), der Verbindungskontrollschicht und der Zugangsschicht.

Verbindungskontrollschicht (logical link control, LLC)

Die Aufgaben der Verbindungskontrollschicht sind:

Synchronisation

Hierbei ist das Ziel der Gleichlauf von zwei Datenstationen. Die Grenzen der Übertragungseinheiten (Bits, Bytes) müssen gleich interpretiert werden.

Man unterscheidet dabei Asynchronverfahren, wo der Gleichlauf zwischen Sender und Empfänger für eine Bitfolge (meist ein Byte) durch die Datenendeinrichtung hergestellt wird und die Übertragung jedes Zeichens mit einem Startsignal beginnt und mit einem Stoppsignal (Start/Stopp-Bit) endet. Es ist ein einfaches und robustes Verfahren, wobei aber zusätzlich Start/Stopp-Bits übertragen werden müssen. Typische Protokolle sind X-, Y-, Z-Modem und Kermit.

Beim Synchronverfahren herrscht zwischen Sender und Empfänger ständiger Gleichlauf, der über einen regelmäßigen Taktimpuls (meist durch die Datenübertragungseinrichtung) realisiert wird. Zeichen werden zu Übertragungsblöcken (Rahmen, Frames) zusammengefasst. Es ergibt sich eine höhere Übertragungsleistung, da keine Start/Stop Bits gesendet werden müssen. Protokollevertreter sind BSC (zeichenorientiert), PPP und HDLC (bitorientiert).

Fehlererkennung

Ziel ist die Erkennung von Übertragungsfehlern und dadurch die Wahrung der Datenintegrität (Unverändertheit der gesendeten Daten). Bitfehler werden hierbei durch Prüfbits erkannt. Bei einem 7-Bit ASCII Zeichen werden die sieben Datenbits addiert und das Prüfbit bei einer geraden Zahl von 1en auf 0, sonst auf 1 gesetzt, d.h. die Anzahl der 1en im korrekt übertragenen Zeichen (mit dem Prüfbit) ist immer gerade.

Beispiel: Prüfbit bei ASCII Zeichen

| Zeichen | ASCII-Wert | Bitfolge | Prüfbit mit Bitfolge |

|---|---|---|---|

| A | 65 | 1000001 | 0 1000001 |

| B | 66 | 1000010 | 0 1000010 |

| C | 67 | 1000011 | 1 1000011 |

Komplexere CRC Methoden (cyclic redundancy check) erlauben die Erkennung von mehreren Bitfehlern und nicht nur die Erkennung, sondern auch die Korrektur von Fehlern.

Verlorene Pakete werden mittels Durchnummerieren der Pakete und Vorgabe von Zeitintervallen erkannt, wobei verlorene Pakete erneut übermittelt werden.

Flusssteuerung

Die wichtigste Aufgabe der Flusssteuerung (data flow control) ist die Koordination bzw. Synchronisation der Übertragungs- und Verarbeitungsgeschwindigkeit zwischen zwei Datenstationen. Dabei synchronisieren sich Sender und Empfänger mit einem einfachen Protokoll durch Versenden von Bestätigungen für empfangene Pakete (send and wait protocol, ACK positive Bestätigung, NAK negative Bestätigung bei fehlerhaften Prüfbits).

Zugangsschicht (media access control, MAC)

Die Zugangsschicht ist für zwei wichtige Aufgaben zuständig: die physische Adressierung der Datenstationen und das Zugangsverfahren zum Medium (z.B. ATM, Ethernet, …).

Datenstationen, die an das gleiche Übertragungsmedium angeschlossen sind, werden über ihre eindeutige MAC Adresse (Media Access Control) identifiziert. MAC Adressen werden im Normalfall durch den Netzwerkadapter bestimmt und sollten weltweit eindeutig sein.

Abhängig von der Anzahl der Empfänger unterscheidet man die folgenden Kommunikationsmuster:

- Punkt-Adressierung (singlecast, unicast)

Bezeichnet die eindeutige Adressierung einer Datenstation.

- Mehrpunkt-Adressierung (multicast)

Bezeichnet die gleichzeitige Adressierung mehrerer Datenstationen. Ein Paket wird von allen bezeichneten Datenstationen empfangen.

- Broadcast-Adressierung sendet ein Datenpaket an alle angeschlossenen Datenstationen.

Durch das Zugangsverfahren wird der Zugang einer Datenstation zum gemeinsam genutzten Übertragungsmedium geregelt. Prinzipiell werden zwei Verfahren unterschieden

- Bei streng koordinierten (deterministischen) Verfahren wird durch eine Vorschrift exakt festgelegt, zu welchem Zeitpunkt jede Datenstation senden darf.

- Bei konkurrierenden (stochastischen) Zugangsverfahren ist jede Station prinzipiell zu jedem Zeitpunkt berechtigt ein Paket zu senden. Versuchen zwei Stationen gleichzeitig zu senden, tritt ein Fehler (Kollision) auf und nach bestimmten Wartezeiten starten die Stationen einen neuen Versuch

Bei koordinierten Zugangsverfahren darf zu einem Zeitpunkt nur eine Station senden. Das Senderecht wird gleichmäßig zwischen den Stationen aufgeteilt. Beim Tokenverfahren (token passing) wird der Datenrahmen (token) von Station zu Station (meist in einem Ringnetz) weitergegeben und kann „beladen“ werden oder „frei“" sein. Eine Station, die ein freies Token empfängt, kann Token laden und senden. Ein Token wird weitergegeben und Empfängerstationen können Daten entnehmen. Wenn ein Token beim Sender ankommt, wird es von ihm entleert. Der bekannteste Vertreter ist der IBM Tokenring. Ein weiteres Verfahren ist ATM (asynchronous transfer mode) das ursprünglich für Punkt-zu-Punkt Verbindungen verwendet wurde und heute bei Weitverkehrsnetzen im Einsatz ist.

Die Vorteile von Tokenverfahren sind die garantierte Zeitspanne, nach der ein Sender senden kann, daher werden sie in Echtzeitsystemen und System mit zu garantierenden Prioritäten eingesetzt. Im Hochlastbereich zeigen sie eine bessere Auslastung als konkurrierende Verfahren, da sich dort die Kollisionen ab einer gewissen Anzahl von angeschlossenen Stationen häufen.

Bei konkurrierenden Zugriffsverfahren kann prinzipiell jede Station jederzeit senden. Es ist daher keine explizite Berechtigung zum Senden notwendig. Deren wichtigster Vertreter ist CSMA/CD (Carrier Sense Multiple Access with Collision Detection). Eine Station die Datenpakete senden will, prüft hierbei, ob eine andere Station aktiv ist. Wenn ja, wartet sie, bis das Medium frei ist, sonst sendet sie. Wichtig ist, dass sie auch beim Senden das Medium abhört. Wenn jetzt 2 Stationen erkennen, dass sie gleichzeitig senden (man spricht von einer Kollision), stellen sie das Senden ein. Die Stationen starten einen neuerlichen Sendeversuch nach einer für jede Station zufälligen Wartezeit. Dies verhindert endlose Kollisionen. Der berühmteste Vertreter der CSMA/CD Verfahren ist das Ethernet.

CSMA/CD zeigen bei einer geringeren Stationszahl eine bessere Leistung als Tokenverfahren, da es kaum zu Kollisionen kommt und kein voller Zyklus für Token abgewartet werden muss. Sie sind auch deutlich einfacher in Hardware zu realisieren und daher auch bedeutend kostengünstiger.

Aus den oben genannten Gründen ist festzustellen, dass in den letzten Jahren die Kollisionsverfahren (hier vor allem das Ethernet) die Tokenverfahren fast vollständig verdrängt haben.

Zusammenfassung

Das Schichtenmodell erlaubt eine klare Abgrenzung von Aufgaben bei der Kommunikation von Daten und hilft die Komplexität des Übermittlungsprozesses durch Aufgabenteilung zu reduzieren. Das ISO/OSI Modell ist ein international standardisiertes Referenzmodell, das eine Schablone für die Entwicklung von Protokollen und darauf aufbauenden Diensten darstellt. Die Bitübertragungsschicht beschreibt die physikalischen übertragungstechnischen Verfahren und die Sicherungsschicht garantiert die korrekte Übertragung der Daten auf einer Teilstrecke.

Weitere Schichten des ISO/OSI Referenzmodells

Vermittlungsschicht (Schicht 3, network layer)

In der Vermittlungsschicht (der dritten Schicht des ISO/OSI Modells) werden Nachrichten zwischen zwei Rechnern übertragen, die durch ein Netzwerk verbunden sind. Die wichtigsten Aufgaben dieser Schicht sind die Wegfindung (Routing) und die Adressierung, die Definition der Vermittlungstypen, die Netzlaststeuerung und die Dienstqualität.

Wegwahl und Adressierung

In einem Maschennetzwerk sind prinzipiell mehrere Wege zwischen Knoten möglich, wobei sich Teilstrecken auf diesen Wegen in den Protokollen, Zugangsverfahren (Ethernet, Tokenring) und Übertragungsmedien unterscheiden können. Ein offenkundiges Problem ist die unterschiedliche Adressierung auf der physischen Ebene bei den verschiedenen Protokollen der Sicherungsschicht (Ethernet-Adressierung von Tokenring-Adressierung unterschiedlich). Es ist daher eine logische Adressierungsebene über der Sicherungsschicht notwendig, die es erlaubt in der Vermittlungsschicht die einzelnen Knoten zu identifizieren und zu finden. Die bekannte IP-Adressierung ist eine Lösung zu diesem Problem und wird in der Lektion 9 ausführlich behandelt.

Die Wegwahl ist ein wichtiges Optimierungsproblem bei Netzwerken, das die Leistungsfähigkeit eines Netzes stark beeinflussen kann. In einem relativ kleinen Netz kann man den besten (z.B. kürzesten) Weg zwischen Knoten durch Optimierung berechnen. Dieser kann dann in einer (statischen) Tabelle gespeichert werden. Diese Vorgehenswiese ist aber in großen Netzen impraktikabel, da diese Tabellen viel zu groß werden würden (Beispiel: Internet wächst und wächst) und auch der Aufwand der Optimierung zu groß wäre.

In großen Netzen wird daher die Wegwahl dynamisch realisiert, wobei dieser Ansatz von geeigneten Protokollen, z.B. BGP (border gateway protocol), unterstützt wird. Die Wegwahl basiert auf Heuristiken („Faustregeln“), wie kürzeste Wartezeit, bester Durchsatz, Leitungsauslastung, geringste Zwischenknotenzahl, geringste Fehlerrate, geringste Kosten, Politik usw.

Vermittlungstypen

Zwei kommunizierende Knoten im Netz können prinzipiell durch zwei unterschiedliche Verfahren eine Verbindung aufbauen und erhalten: durch Leitungsvermittlung oder Paketvermittlung.

Die Leitungsvermittlung ist ein Verfahren der Vermittlungsschicht, bei dem einer Nachrichtenverbindung zeitweilig ein durchgeschalteter Übertragungskanal mit konstanter Bandbreite zugeordnet wird, der dieser Verbindung dann zur exklusiven Nutzung zur Verfügung steht. Das bedeutet, dass zwischen Endpunkten eine dedizierte physische Verbindung hergestellt wird.

Ein typisches Beispiel ist der analoge Telefondienst, bei dem eine exklusive bidirektionale Sprechverbindung zwischen den Kommunikationspartnern besteht.

Bei der Paketvermittlung (engl. packet swiching) werden längere Nachrichten in einzelne Datenpakete unterteilt (Datagramm, mit Absender- und Zieladresse versehene Pakete) oder über eine vorher aufgebaute virtuelle Verbindung übermittelt. Dabei werden die Datagramme von Vermittlungsknoten (Router) kurzfristig gespeichert und weitergeleitet. Der Vermittlungsknoten besitzt einen Speicherbereich für die Pakete, ermittelt den Weg zur nächsten Station und sendet das Paket weiter.

Statt einer physischen Verbindung wird eine logische Verbindung hergestellt. Dies erlaubt, dass durch den Einsatz des Multiplex-Verfahrens tausende Verbindungen gleichzeitig über ein einziges Medium mit hoher Leitungskapazität realisiert werden können.

Beispiel ist hier der digitale Telefondienst, der tausende Telefonverbindungen über ein Glasfaserkabel erlaubt.

Beispiel: Transport von Öl (nach Hansen)

Ein anschauliches Beispiel für die Unterscheidung der beiden Vermittlungstypen bietet die Aufgabe, Öl von einem Ort zum anderen zu transportieren. Es stehen hierbei grundsätzlich zwei Möglichkeiten für den Transport zur Verfügung: Pipelines und Tankwagen.

Eine Pipeline steht dem Benutzer exklusiv zur Verfügung, wobei aber Güter nicht gemischt werden können: Dies entspricht dem Prinzip der Leitungsvermittlung.

Tankwagen benutzen mit anderen Lastwagen, die andere Güter transportieren, dasselbe Straßennetz. Tankwagen können auch unterschiedliche Wege zum Ziel nehmen. Dies entspricht dem Prinzip der Paketvermittlung.

Bei der Paketvermittlung unterscheidet man zwischen zwei Dienstarten:

- Verbindungsorientiertem Dienst (connection based service), bei dem für ein Zeitintervall eine logische Verbindung zwischen Endpunkten hergestellt wird. Das bedeutet, dass zusammengehörige Pakete erkannt und einfach in der richtigen Reihenfolge wieder zusammengesetzt werden können. Ein Beispiel ist TCP.

- Verbindungslosem Dienst (connection less service), bei dem keine explizite Verbindung aufgebaut wird. Jedes Paket wird (physisch und logisch) unabhängig von anderen übermittelt. Ein Beispiel ist UDP.

Weitere Funktionen

Die Vermittlungsschicht ist noch für die Netzlaststeuerung zuständig, bei der „Staus“ im Netzwerk erkannt und behoben werden sollen. Dies geschieht durch geeignete Wegwahl, Zwischenspeicherung von Paketen und Reservierung von Kapazitäten (Einsatz von QoS, Dienstqualität). Manchmal bleibt auch nichts Anderes übrig, als Pakete zu terminieren (sie werden einfach weggeschmissen), wobei auf die Dienste höherer Schichten vertraut wird, dass die fehlenden Pakete der Übertragung erkannt und nochmals gesendet werden (Eigenschaft des Schichtenmodells).

Im Folgenden werden die weiteren Schichten des ISO/OSI Modells nur kurz beleuchtet, da in den nächsten Kapiteln bei der Betrachtung des Internets genau auf sie eingegangen wird.

Transportschicht (Schicht 4, transport layer)

Die Transportschicht stellt den transparenten Transfer von Daten zwischen beteiligten Systemen zur Verfügung, wobei der verlässliche Transport der Daten als Dienst (wie z.B. richtige Reihenfolge der Pakete, Anforderung verloren gegangener Nachrichten, Verbindungstrennung bei zu vielen Fehlern) für die oberen Schichten gewährleistet wird. Sie kontrolliert die Verlässlichkeit einer eingerichteten Verbindung durch Flusskontrolle, Segmentierung/De-Segmentierung und Fehlerkontrolle. Einige Protokolle sind hierzu zustands- und verbindungsorientiert (TCP). Die Transportschicht bietet den höheren, anwendungsorientierten Schichten einen standardisierten Zugriff an und versteckt die Eigenschaften des Kommunikationsnetzes.

Beispiel:

Man kann sich die Transportschicht wie ein Postamt vorstellen, das dafür sorgt, dass Briefe und Pakete klassifiziert, weitergeleitet und ausgeliefert werden. Hierbei werden die Sendungen nur nach den Adressen auf der äußeren Hülle bearbeitet, nicht nach den Inhalten.

Bekannte Protokolle sind TCP und UDP.

Sitzungsschicht (Schicht 5, session layer)

Die Sitzungsschicht kontrolliert die Kommunikationsverbindungen (Auf- und Abbau) zwischen den beteiligten Systemen. Sie richtet die Verbindungen ein, bedient und beendet sie. Sie stellt halbduplex oder vollduplex Verbindungen her und stellt Dienste für einen organisierten und synchronisierten Datenaustausch zur Verfügung. Diese Schicht ist auch verantwortlich für die korrekte Beendigung einer Sitzung und für die Einrichtung von Wiederaufsetzpunkten (checkpointing), um nach dem Ausfall einer Transportverbindung Sitzungen wieder synchronisieren zu können, ohne dass die Übertragung wieder von vorne beginnen muss.

Darstellungsschicht (Schicht 6, presentation layer)

Die Darstellungsschicht transformiert die systemabhängige Darstellung der Daten in eine unabhängige Form und ermöglicht somit den syntaktisch korrekten Datenaustausch zwischen unterschiedlichen Systemen. Hierbei standardisierte die Darstellungsschicht die Daten, um der Anwendungsschicht eine einheitliche Schnittstelle anzubieten. Es werden Formate konvertiert (z.B. Umwandlung zwischen EBCDIC-kodierte und ASCII-kodierten Dateien, zwischen Grafiken-Formaten, usw.), Ver-/Entschlüsselung und Datenkompression/-dekompression, MIME Kodierung und ähnliche Manipulationen durchgeführt.

Anwendungsschicht (Schicht 7, application layer)

Die Anwendungsschicht ist die oberste Schicht des ISO/OSI Modells. Sie kommuniziert direkt mit den Anwendungsprozessen und stellt ihnen Anwendungsdienste zur Verfügung. Sie wiederum selbst verwendet die Darstellungsschicht. Es ist zu beachten, dass die Anwendungsschicht ihre Dienste den Anwendungsprozessen und nicht den Endbenutzern zur Verfügung stellt, d.h., zwischen Benutzer und Netzwerkmodell stehen noch die Anwendungen. So wird in der Anwendungsschicht zum Beispiel ein Datei-Transfer-Protokoll (FTP, TFTP) definiert, das aber vom Benutzer nur indirekt über seine Applikation (z.B. FTP-Client, Web-Browser) verwendet werden kann. Das ISO/OSI Modell enthält also keine direkte Benutzerschnittstelle für den Anwender. Protokolle dieser Schicht sind FTP, Telnet, SMTP, HTTP und viele mehrBeachten Sie:

OSI Referenz-Modell - https://www.itwissen.info/OSI-Referenzmodell-OSI-reference-model.html

Es gibt einige Eselsbrücken, um sich die einzelnen OSI-Schichten zu merken. Einer der populärsten Sprüche lautet “Please Do Not Throw Salami Pizza Away” (Physical Layer, Data Link Layer, usw.). Weitere Sprüche finden Sie unter http://de.wikipedia.org/wiki/Merkspr%C3%BCche#Informatik .

Zusammenfassung

Die Vermittlungsschicht ist für den effizienten Datenverkehr im Netz zuständig. Die Transportschicht für die ordnungsgemäße Zustellung von Daten. Die höheren Schichten des OSI Modells dienen zur korrekten Abwicklung von Verbindungen und bieten Anwendungen netzwerkbasierte Unterstützung.

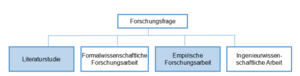

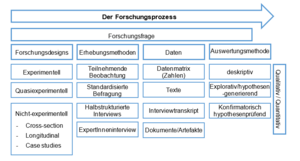

Formen des wissenschaftlichen Arbeitens

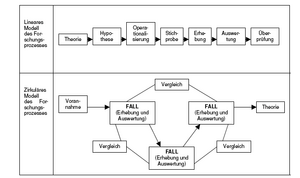

Das Ziel der unterschiedlichen Wissenschaften ist, Erkenntnis und Wissen systematisch zu gewinnen und zu ordnen. Wissenschafter*innen können grundsätzlich auf zwei Wegen neues Wissen erschließen, indem sie sich ausschließlich auf vorhandene Theorien beziehen, die bereits publiziert oder auf eine andere Art und Weise dokumentiert sind, oder indem sie versuchen, für wissenschaftliche Probleme und Fragestellungen innovative Lösungen und Antworten zu finden. Die literaturbasierte wissenschaftliche Arbeit steht damit einer wissenschaftlichen Arbeit gegenüber, die neue Erkenntnisse, aber auch den Prozess der Forschung oder Entwicklung dieser Erkenntnisse dokumentiert. In den folgenden zwei Abschnitten sollen die Literaturstudie sowie die empirische Forschungsarbeit genauer beschrieben werden.

Prinzipien für die wissenschaftliche Arbeit

Der bekannte Philosoph und Schriftsteller Umberto Eco beantwortet die Frage nach Prinzipien für das wissenschaftliche Arbeiten folgendermaßen. Ec03, 39ff.

- Die Untersuchung behandelt einen erkennbaren Gegenstand, der so genau umrissen ist, dass er auch für Dritte erkennbar ist.

- Die Untersuchung muss über diesen Gegenstand Dinge sagen, die noch nicht gesagt worden sind.

- Die Untersuchung muss für andere von Nutzen sein.

- Die Untersuchung muss jene Aufgaben enthalten, die es ermöglichen nachzuprüfen, ob ihre Hypothesen falsch oder richtig sind.

Wichtig ist hierbei auch, darauf zu achten, dass das Problem versachlicht wird. Das heißt, dass für die Beschreibung des Problems eine sachliche Fachsprache verwendet wird und das Problem theoretisch eingebettet ist, sei es nun durch Verwendung einer mathematischen Sprache oder durch eine Verknüpfung mit anderen in der Disziplin vorhandenen Theorien. Die Gütekriterien für wissenschaftliche Arbeiten müssen eingehalten werden.

Folgende Aufzählung von Aufgaben für Wissenschafter*innen ist praxis- und handlungsorientierter und bezieht die Arbeit in der und für die „Scientific Community“ mit ein:

- Hinterfragen und Überprüfen der eigenen Forschungs- und Auswertungsmethoden auf Zweckmäßigkeit, Wahrheitsgehalt und ethische Qualität;

- Aussagen, Hypothesen und Schlussfolgerungen müssen überprüfbar und widerlegbar sein;

- Beachtung der für das Wissensgebiet als „wissenschaftlich“ anerkannten Theorien, Methoden und der Fachsprache (Nomenklatur);

- Erbringen von Beiträgen zur Grundsubstanz des Wissens (z.B. durch Lehrbücher);

- Mitwirkung an fachtypischen Wissensvermittlungsmethoden (Lehre);

- Weiterentwicklung der akademischen Abschlüsse und Qualifikationen des Wissensbereichs;

- Teilnahme am Wissensaustausch zwischen Wissenschafter*innen des Fachbereichs und darüber hinaus („Scientific Community“, Publizieren, Konferenzen etc.). Ne03

Der Soziologe Max Weber stellte für die Wissenschaften das Postulat der Werturteilsfreiheit auf. Wissenschafter*innen haben frei von Werten zu sein. Sie sollen nichts als böse oder gut klassifizieren. Da aber jeder Mensch selbst Werte hat, müssen diese vorab klargelegt werden. Wichtig ist, dass die Erkenntnisse intersubjektiv überprüfbar sind, das heißt, dass andere die Erkenntnisschritte nachvollziehen können. Die Analyse muss immer wieder hinterfragt werden. Nun ist ein Wissenschaftler, eine Wissenschaftlerin nicht amoralisch, sondern positioniert sich, wie Max Weber unterscheidet, in einer Verantwortungsethik und nicht in einer Gesinnungsethik. Die Politik beispielsweise verpflichtet sich einer Gesinnungsethik und ist damit weltanschaulich gebunden.

Die Wissenschafter*innen sind der Rationalität verpflichtet.

Die Forschungsfrage

Aus den genannten Prinzipien leitet sich auch die Forschungsfrage ab. Sie ist der Ausgangspunkt jeglicher Art von Forschung. Es gibt keine wissenschaftlichen Methoden zur Auswahl einer Forschungsfrage. Sie kann entweder dem Interesse des/der einzelnen Wissenschafter*in entspringen oder als Auftrag an die Wissenschafter*innen ergehen.

Bevor sich Wissenschafter*innen einzelnen Forschungsfragen zuwenden, sollten sie jedoch einige Punkte berücksichtigen:

- gesellschaftliche Relevanz,

- wissenschaftliche Relevanz und

- kritische Überprüfung der Forschungsfrage auf ihre Herkunft.

Das wissenschaftliche Literaturstudium

Eine Literaturstudie befasst sich mit bereits publizierter wissenschaftlicher Literatur über ein bestimmtes Thema bzw. eine bestimmte Fragestellung. Im Rahmen des Studiums und auch bei Abschlussarbeiten [4] ist dies eine oft gewählte Form des wissenschaftlichen Arbeitens. Oft fällt es schwer, Methoden des Literaturstudiums zu finden, meistens sind Erklärungen auf die Beschaffung von Literatur beschränkt. Wie jedoch mit der vorhandenen Literatur umgegangen wird, wird methodisch von vielen Wissenschafter*innen nicht dokumentiert, sondern basiert auf informell (z.B. im Laufe des Studiums) erworbenem Erfahrungswissen.

Ein wichtiger Punkt bei der Bearbeitung von wissenschaftlichen Texten ist, zu welchem Zeitpunkt im Prozess des wissenschaftlichen Arbeitens diese stattfindet. Sinnvoll ist eine intensive Auseinandersetzung mit Literatur erst dann, wenn bereits eine Forschungsfrage formuliert wurde, also klar ist, welches Problem im Vordergrund steht und im Laufe der Arbeit beantwortet werden soll. Diese Forschungsfrage bildet sowohl den roten Faden für die Literaturrecherche als auch für die Bearbeitung der Literatur. Nur jene Literatur, die zur Beantwortung der Fragestellung beitragen kann, ist relevant. Das Literaturstudium kann also als die Bearbeitung relevanter wissenschaftlicher Literatur in Bezug auf die eigene Fragestellung bezeichnet werden.

Diese relevante Literatur wird im Forschungsstand bzw. State of the Art dargestellt. Mit dem Erfassen des Forschungsstandes wird ein Überblick über die Diskursträger*innen des gewählten Themas geschaffen, also über die Aussagen jener Autor*innen, die zum wissenschaftlichen Diskurs mit wesentlichen Erkenntnissen beigetragen haben. Sie können hierbei beschreibend vorgehen, verschiedene Beiträge zusammentragen und komprimieren oder diese vergleichen und kontrastieren und damit zur Verdichtung bisheriger Erkenntnisse beitragen und neue Erkenntnisse gewinnen.

Aufbauend auf diesem Fundament werden in einer Literaturstudie nun die eigenen Erkenntnisse, die neu erkannten Zusammenhänge, Interpretationen und mögliche Kritik formuliert. Eine Literaturstudie besteht somit darin, die eigene Fragestellung mit Hilfe von bereits publizierten wissenschaftlichen Texten zu bearbeiten und im Laufe der Arbeit zu beantworten.

Wissenschaftlich Forschen

Methode: logisches, planmäßiges, systematisches Verfahren wissenschaftlicher Forschung, Untersuchungsweise, Art der Wahrheitsfindung. Ei04, 665-668

Das Wort Methode stammt aus dem Altgriechischen (methodos) und bedeutet so viel wie „Nachgehen“, „Verfolgen“ oder „der Weg zu etwas hin“. Eine Methode bietet uns die Möglichkeit, bei der Entwicklung wissenschaftlicher Probleme, Fragen, Aussagen sowie deren empirischer Überprüfung durch Realitätsanalysen einen bereits von anderen Forscher*innen entwickelten und erprobten Weg „nachzugehen“. Das heißt, eine Methode gibt ein systematisches Vorgehen bzw. Verfahren vor, um Informationen zu beschaffen und auszuwerten. Methoden helfen damit, zwischen Empirie und Theorie zu vermitteln. Methoden müssen wissenschaftlichen Kriterien entsprechen, um überzeugend zu sein. Sie helfen aber auch dabei, die Intersubjektivität des Forschungsprozesses sicherzustellen. Indem sich ein Forscher, eine Forscherin auf eine bestimmte Methode bezieht und zum Beispiel in der Einleitung seines/ihres Artikels angibt, welche Methode er/sie für das Forschungsvorhaben verwendet hat, können die Leser*innen des Artikels Rückschlüsse auf den Forschungsprozess des Autors, der Autorin ziehen. Zu unterscheiden sind besonders naturwissenschaftliche, sozialwissenschaftliche, formalwissenschaftliche und philosophische Methoden.

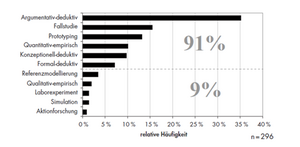

Überblick über die Methoden der Wirtschaftsinformatik

Die Wirtschaftsinformatik versteht sich als Wissenschaft mit einer methoden-pluralistischen Erkenntnisstrategie. Sie bedient sich der Instrumente der

Erfahrungs-, Formal- und Ingenieurwissenschaften.

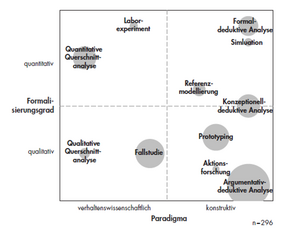

Die Wirtschaftsinformatik arbeitet innerhalb zweier erkenntnistheoretischer Pardigmen. Einerseits will sie mit sozialwissenschaftlichen Methoden die Ausgestaltung und Wirkung verfügbarer IT-Lösungen, Unternehmen und Märkte analysieren. Neben rein an der Erkenntnis orientierten, sozialwissenschaftlichen Forschungsmethoden spielen in der Wirtschaftsinformatik vor allem auch konstruktionsorientierte Methoden (Erstellen und Evaluieren von Prototypen) und Methoden der Informationssystemgestaltung (Entwicklungsmethoden) eine wesentliche Rolle. Im Rahmen von „Design Science“ bzw. dem konstruktionswissenschaftlichen Paradigma will die Wirtschaftinformatik nützliche IT-Lösungen entwickeln, die durch das Schaffen und Evaluieren verschiedener Artefakte in Form von Modellen, Methoden oder Systemen untersucht werden sollen.

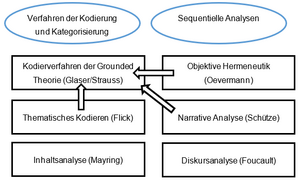

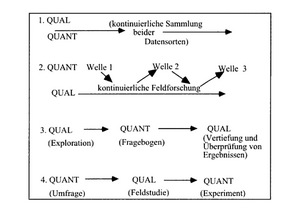

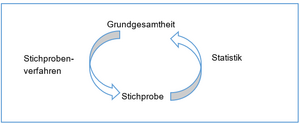

Grundsätzlich können wissenschaftliche Methoden in zwei Gruppen eingeteilt werden: in quantitative und qualitative Methoden. Die Unterscheidungsmerkmale sollen nachfolgend anhand der Methoden der Sozialforschung in ihren Grundzügen beschrieben werden. Diese können vor allem aufgrund ihres Formalisierungsgrades unterschieden werden. Wilde & Hess WH07, 282 hingegen ergänzen diese zwei Kategorien um „semi-formale Gegenstandsrepräsentationen“, zu denen sie beispielsweise Petrinetze oder UML-Modelle zählen.

Einen ersten Einblick in die Vielfalt der Methoden der Wirtschaftsinformatik gibt folgende Tabelle, die auf Basis einer Inhaltsanalyse verschiedener facheinschlägiger Artikel in der Fachzeitschrift „Wirtschaftsinformatik“ erstellt wurde. WH07

In dieser Auflistung sind sowohl formalwissenschaftliche, anwendungsorientierte technische Methoden als auch Methoden der empirischen Sozialforschung enthalten.

| Methode | Beschreibung |

|---|---|

| Formal-/konzeptionell- und argumentativ-deduktive Analyse | Logisch-deduktives Schließen kann als Forschungsmethode auf verschiedenen Formalisierungsstufen stattfinden: entweder im Rahmen mathematisch-formaler Modelle (z.B. in semi-formalen Modellen) oder rein sprachlich (argumentativ). |

| Simulation | Die Simulation bildet das Verhalten des zu untersuchenden Systems formal in einem Modell ab und stellt Umweltzustände durch bestimmte Belegungen der Modellparameter nach. Sowohl durch die Modellkonstruktion als auch durch die Beobachtung der endogenen Modellgrößen lassen sich Erkenntnisse gewinnen. |

| Referenzmodellierung | Die Referenzmodellierung erstellt induktiv oder deduktiv meist vereinfachte und optimierte Abbildungen von Systemen, um so bestehende Erkenntnisse zu vertiefen und daraus Gestaltungsvorlagen zu generieren. |

| Aktionsforschung | Es wird ein Praxisbeispiel durch einen gemischten Kreis aus Wissenschaft und Praxis gelöst. Hierbei werden mehrere Zyklen aus Analyse-, Aktions-, und Evaluationsschritten durchlaufen, die jeweils gering strukturierte Instrumente wie Gruppendiskussionen oder Planspiele vorsehen. |

| Prototyping | Es wird eine Vorabversion eines Anwendungssystems entwickelt und evaluiert. Beide Schritte können neue Erkenntnisse generieren. |

| Ethnographie | Die Ethnographie möchte durch partizipierende Beobachtung Erkenntnisse generieren. Der Unterschied zur Fallstudie liegt in dem sehr hohen Umfang, in dem sich ein Forscher in das untersuchte soziale Umfeld integriert. Eine objektive Distanz ist kaum vorhanden. |