Private und Public Cloud Security: Unterschied zwischen den Versionen

(Die Seite wurde neu angelegt: „<span id="private-public-cloud-security"></span> = Private & Public Cloud Security = Der Unterschied zwischen der Sicherheit in privaten und öffentlichen Clouds kann im Wesentlichen auf die unterschiedlichen Rahmenbedingungen und Ansätze zurückgeführt werden. Während sich die Sicherheit in der Private Cloud stark an traditionellen Sicherheitskonzepten orientiert, die aus den Bereichen Rechenzentrums- und Netzwerksicherheit stammen, erfordert die…“) |

K |

||

| Zeile 12: | Zeile 12: | ||

=== Technische Grundlage === | === Technische Grundlage === | ||

[[File:CLOUDSEC | [[File:CLOUDSEC-media-image14.png|336x403px|thumb|center|Grundlegender Aufbau eines Rechenzentrums (vereinfacht)]] | ||

Diese Grafik veranschaulicht den grundlegenden Aufbau eines Rechenzentrums für eine Private Cloud-Infrastruktur. Im vereinfachten Modell bilden mehrere zentrale Komponenten das Fundament für den Betrieb einer Private Cloud: | Diese Grafik veranschaulicht den grundlegenden Aufbau eines Rechenzentrums für eine Private Cloud-Infrastruktur. Im vereinfachten Modell bilden mehrere zentrale Komponenten das Fundament für den Betrieb einer Private Cloud: | ||

| Zeile 95: | Zeile 95: | ||

Der Betrieb einer Private Cloud ist ein anspruchsvolles Unterfangen, das sorgfältige Planung und den Einsatz von Hypervisor-Technologie erfordert. Je nach Größe der Infrastruktur und Wahl des Hypervisors kann die genaue Hardwarekonfiguration variieren. Hersteller von Hypervisoren bieten in der Regel Best Practices und Referenzarchitekturen an, um die Implementierung und den Betrieb zu erleichtern. | Der Betrieb einer Private Cloud ist ein anspruchsvolles Unterfangen, das sorgfältige Planung und den Einsatz von Hypervisor-Technologie erfordert. Je nach Größe der Infrastruktur und Wahl des Hypervisors kann die genaue Hardwarekonfiguration variieren. Hersteller von Hypervisoren bieten in der Regel Best Practices und Referenzarchitekturen an, um die Implementierung und den Betrieb zu erleichtern. | ||

[[File:CLOUDSEC | [[File:CLOUDSEC-media-image15.png|468x539px|thumb|center|Sample Infrastruktur in einer private Cloud]] | ||

Die dargestellte Abbildung zeigt eine stark vereinfachte Infrastruktur, die den grundsätzlichen Aufbau einer Private Cloud veranschaulicht. Diese Darstellung dient dazu, die Funktionsweise einer Private Cloud grundlegend zu verstehen, ohne dabei auf alle technischen Details einzugehen. | Die dargestellte Abbildung zeigt eine stark vereinfachte Infrastruktur, die den grundsätzlichen Aufbau einer Private Cloud veranschaulicht. Diese Darstellung dient dazu, die Funktionsweise einer Private Cloud grundlegend zu verstehen, ohne dabei auf alle technischen Details einzugehen. | ||

| Zeile 124: | Zeile 124: | ||

<span id="einsatz-von-private-clouds-allgemeine-überlegungen"></span> | <span id="einsatz-von-private-clouds-allgemeine-überlegungen"></span> | ||

==== | ==== Einsatz von Private Clouds – Allgemeine Überlegungen ==== | ||

Es gibt zahlreiche Ansätze, eine Private Cloud zu betreiben, und die Möglichkeiten haben sich in den letzten Jahren stark erweitert, insbesondere durch Technologien wie Containerisierung und Container-Orchestrierung. Diese bieten zusätzliche Abstraktionsschichten, die mehr Flexibilität und Effizienz ermöglichen. Für Organisationen ist es jedoch entscheidend, den Ansatz zu wählen, der am besten zu ihrem bestehenden Know-how passt. | Es gibt zahlreiche Ansätze, eine Private Cloud zu betreiben, und die Möglichkeiten haben sich in den letzten Jahren stark erweitert, insbesondere durch Technologien wie Containerisierung und Container-Orchestrierung. Diese bieten zusätzliche Abstraktionsschichten, die mehr Flexibilität und Effizienz ermöglichen. Für Organisationen ist es jedoch entscheidend, den Ansatz zu wählen, der am besten zu ihrem bestehenden Know-how passt. | ||

Aktuelle Version vom 17. September 2024, 12:53 Uhr

Private & Public Cloud Security

Der Unterschied zwischen der Sicherheit in privaten und öffentlichen Clouds kann im Wesentlichen auf die unterschiedlichen Rahmenbedingungen und Ansätze zurückgeführt werden. Während sich die Sicherheit in der Private Cloud stark an traditionellen Sicherheitskonzepten orientiert, die aus den Bereichen Rechenzentrums- und Netzwerksicherheit stammen, erfordert die Public Cloud einen anderen Ansatz. In der Public Cloud sind Ressourcen plötzlich bei einem fremden Unternehmen auf einer geteilten Plattform verfügbar. Aus Sicherheitsaspekten stehen hier Themen wie Vertrauen in den Cloud Service Provider (CSP), das Sicherheitsniveau des CSP, die klare Abgrenzung der Ressourcen in der Cloud (Schaffung eines „Perimeters“) und das Bewusstsein darüber, welche Cloud-Service-Modelle im Einsatz sind und wie diese bestmöglich abgesichert werden können, im Vordergrund.

Private Cloud Security

Um eine sichere Private Cloud zu betreiben, ist es entscheidend, sich über den hohen Aufwand bewusst zu sein, der mit dem Betrieb verbunden ist. Es erfordert die Bereitstellung, Konfiguration, Instandhaltung, den Betrieb und regelmäßige Aktualisierung der notwendigen Komponenten in einem Rechenzentrum. Das OSI-Referenzmodell kann hier als Leitfaden dienen, denn alle sieben Schichten dieses Modells müssen vom Betreiber der Private Cloud adressiert und konfiguriert werden. Dies umfasst nicht nur die Netzwerkinfrastruktur, sondern auch physische Aspekte wie die Stromversorgung und die physische Sicherheit des Rechenzentrums. Für den weiteren Verlauf nehmen wir an, dass die Private Cloud in einem sicheren, vorhandenen oder angemieteten Rechenzentrumsbereich aufgebaut wird. Der Betrieb des Rechenzentrums selbst wäre ansonsten ebenfalls Teil der Verantwortung.

Technische Grundlage

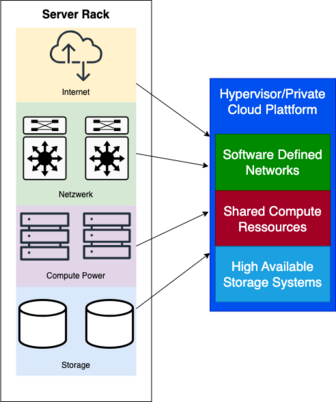

Diese Grafik veranschaulicht den grundlegenden Aufbau eines Rechenzentrums für eine Private Cloud-Infrastruktur. Im vereinfachten Modell bilden mehrere zentrale Komponenten das Fundament für den Betrieb einer Private Cloud:

- Internetzugang: Dieser ermöglicht die Anbindung des Rechenzentrums an externe Netzwerke, einschließlich der öffentlichen Cloud und des Internets.

- Netzwerkinfrastruktur: Hierzu gehören wesentliche Netzwerkkomponenten wie Switches, Firewalls und Router, die den Datenverkehr innerhalb des Rechenzentrums steuern und absichern.

- Rechenressourcen (Compute Power): Mehrere Server, auch als Compute Nodes bezeichnet, stellen die benötigte Rechenleistung zur Verfügung.

- Speicherlösungen: Hochverfügbare Speichersysteme gewährleisten die sichere und effiziente Speicherung und Verwaltung von Daten.

Auf dieser physischen Infrastruktur wird ein Hypervisor installiert, der als zentrale Verwaltungsschicht fungiert. Der Hypervisor bietet Zugriff auf die gesamten Rechenressourcen, das Speichersystem und die Netzwerkinfrastruktur. Dadurch ermöglicht er die Virtualisierung und Verwaltung der verschiedenen Komponenten, die für den Betrieb einer Private Cloud notwendig sind.

Storage

Die Grundlage jeder Cloud-Infrastruktur ist ein zuverlässiges und skalierbares Speichersystem. In einer Private Cloud muss der Speicher lokal verwaltet werden, was bedeutet, dass alle Sicherheitsmaßnahmen wie Datenverschlüsselung, Zugriffskontrollen und regelmäßige Backups intern organisiert werden müssen. Der Speicher muss nicht nur sicher, sondern auch performant sein, um die Anforderungen der Virtualisierung und der Workloads in der Cloud zu erfüllen.

Beispiele für Speichertechnologien in der Private Cloud sind Network Attached Storage (NAS) und Storage Area Networks (SAN). Diese Technologien ermöglichen es Unternehmen, große Mengen an Daten effizient zu speichern und gleichzeitig die Verfügbarkeit und Sicherheit dieser Daten zu gewährleisten. Eine typische Herausforderung bei der Verwaltung von Speicherressourcen in einer Private Cloud besteht darin, eine Balance zwischen Performance und Sicherheit zu finden. So müssen Unternehmen sicherstellen, dass sensible Daten verschlüsselt und vor unberechtigtem Zugriff geschützt sind, während sie gleichzeitig dafür sorgen, dass die Performance nicht durch übermäßige Sicherheitsmaßnahmen beeinträchtigt wird.

Ein weiteres Beispiel ist die Implementierung von dedizierten Backup-Systemen innerhalb der Private Cloud. Diese Systeme müssen so konzipiert sein, dass sie nicht nur regelmäßige Backups erstellen, sondern auch schnelle Wiederherstellungszeiten bieten, um im Falle eines Datenverlusts oder einer Sicherheitsverletzung den Betrieb schnell wieder aufnehmen zu können. Hierbei kann die Kombination von lokalen und cloud-basierten Backup-Lösungen (Hybrid Backup) dazu beitragen, die Datensicherheit zu erhöhen und das Risiko eines vollständigen Datenverlusts zu minimieren.

Software Defined Networking

Software Defined Networking ist ein essenzieller Bestandteil moderner Private Clouds. SDN ermöglicht eine flexible, zentrale Steuerung des Netzwerks, was eine dynamische Anpassung der Netzwerkkonfigurationen an sich ändernde Anforderungen erlaubt. Im Kontext der Sicherheit bedeutet dies, dass Netzwerksicherheitsrichtlinien zentral implementiert und durchgesetzt werden können. Dies ermöglicht eine schnellere Reaktion auf Bedrohungen und eine bessere Kontrolle über den Netzwerkverkehr.

In einer Private Cloud bietet SDN die Möglichkeit, Netzwerkressourcen unabhängig von der physischen Infrastruktur zu konfigurieren und zu verwalten. Dies ist besonders wichtig, wenn es darum geht, verschiedene Sicherheitszonen innerhalb des Netzwerks zu erstellen und zu verwalten. Beispielsweise können über SDN spezifische Sicherheitsrichtlinien für den Datenverkehr zwischen verschiedenen Abteilungen innerhalb eines Unternehmens festgelegt werden, sodass sensible Datenströme streng überwacht und geschützt werden können.

Ein praktisches Beispiel für den Einsatz von SDN in der Private Cloud ist die Implementierung von dynamischen Firewalls und Intrusion Prevention Systems (IPS), die in Echtzeit auf Sicherheitsvorfälle reagieren können. Durch die zentrale Verwaltung dieser Sicherheitslösungen über SDN kann das Netzwerk schnell an neue Bedrohungen angepasst werden, ohne dass umfangreiche manuelle Konfigurationsänderungen erforderlich sind. SDN ermöglicht es auch, schnell auf Änderungen im Netzwerkverkehr zu reagieren, wie z.B. bei einem plötzlichen Anstieg des Datenverkehrs, der auf einen DDoS-Angriff hinweisen könnte. In solchen Fällen kann das SDN die Netzwerkkapazität automatisch anpassen und den verdächtigen Datenverkehr isolieren, um die Auswirkungen auf die Gesamtinfrastruktur zu minimieren.

Hypervisor

Der Hypervisor ist die Schicht, die die Virtualisierung in der Private Cloud ermöglicht. Er sorgt dafür, dass mehrere virtuelle Maschinen (VMs) auf einem physischen Server sicher und effizient betrieben werden können. Die Sicherheit des Hypervisors ist von größter Bedeutung, da eine Kompromittierung dieser Schicht zu einem unkontrollierten Zugriff auf alle virtuellen Maschinen führen könnte. Daher müssen Hypervisoren regelmäßig gepatcht und nach bewährten Sicherheitspraktiken konfiguriert werden.

Es gibt zwei Haupttypen von Hypervisoren: Typ-1-Hypervisoren (Bare-Metal) und Typ-2-Hypervisoren (Hosted). Typ-1-Hypervisoren, wie VMware ESXi oder Microsoft Hyper-V, werden direkt auf der Hardware installiert und bieten dadurch eine höhere Performance und Sicherheit, da sie weniger Angriffsflächen bieten als Typ-2-Hypervisoren. Typ-2-Hypervisoren, wie VMware Workstation oder Oracle VirtualBox, laufen auf einem bestehenden Betriebssystem und sind daher in der Regel weniger sicher und performant.

Ein wesentlicher Sicherheitsaspekt bei der Verwendung von Hypervisoren in einer Private Cloud ist die Isolation der VMs. Durch die strikte Trennung der Ressourcen zwischen verschiedenen VMs kann verhindert werden, dass ein Angriff auf eine VM auf andere VMs oder die darunterliegende Hardware übergreift. Dies wird durch Funktionen wie Virtual Machine Introspection (VMI) erreicht, die es ermöglichen, das Verhalten von VMs in Echtzeit zu überwachen und verdächtige Aktivitäten zu erkennen.

Ein weiteres Beispiel für den Einsatz von Hypervisoren in der Private Cloud ist die Nutzung von Snapshots und Cloning-Funktionen. Diese ermöglichen es, Zustände von VMs zu einem bestimmten Zeitpunkt zu speichern und bei Bedarf wiederherzustellen. Dies ist besonders nützlich für die Durchführung von Updates oder Konfigurationsänderungen, da im Falle eines Fehlers die VM schnell in ihren vorherigen Zustand zurückversetzt werden kann. Solche Funktionen tragen zur erhöhten Betriebszeit und Sicherheit der Cloud-Umgebung bei.

Security Maßnahmen

Die Sicherheitsmaßnahmen in einer Private Cloud umfassen verschiedene Technologien und Strategien, um die Integrität, Verfügbarkeit und Vertraulichkeit der Ressourcen zu gewährleisten. Diese Maßnahmen müssen sorgfältig implementiert und kontinuierlich überwacht werden, um den spezifischen Sicherheitsanforderungen einer Private Cloud gerecht zu werden.

Macro Segmentation (Layer 3 Segementation)

Die Macro-Segmentierung, auch bekannt als Layer-3-Segmentierung, ist eine Technik zur Unterteilung des Netzwerks in größere, logisch getrennte Subnetze. Diese Segmente isolieren unterschiedliche Netzwerkzonen, wie zum Beispiel Entwicklungs-, Test- und Produktionsumgebungen, voneinander. Der Hauptvorteil der Macro-Segmentierung besteht darin, dass sie den Datenverkehr zwischen verschiedenen Netzwerkzonen kontrolliert und begrenzt. Dadurch wird das Risiko eines seitlichen (lateralen) Bewegens eines Angreifers innerhalb des Netzwerks erheblich verringert.

In einer Private Cloud ist dies besonders wichtig, da verschiedene Anwendungen und Workloads oft unterschiedliche Sicherheitsanforderungen haben. Durch die Aufteilung in separate Subnetze können Organisationen sicherstellen, dass sensible Daten und kritische Systeme von weniger geschützten oder potenziell gefährdeten Bereichen getrennt bleiben. Ein praktisches Beispiel wäre die Trennung von Finanzdatenbanken von allgemeinen Webanwendungen, um zu verhindern, dass ein Angreifer, der eine Webanwendung kompromittiert, auf die Finanzdaten zugreifen kann.

Macro-Segmentierung hilft auch bei der Einhaltung von Compliance-Anforderungen, indem sie klare Grenzen für den Datenfluss zwischen verschiedenen Systemen zieht. Zum Beispiel könnte ein Unternehmen, das Kreditkartendaten verarbeitet, ein separates Subnetz für diese Daten einrichten, um die Einhaltung von PCI-DSS-Standards sicherzustellen. In diesem Subnetz könnten dann strengere Sicherheitskontrollen und Zugriffsrichtlinien angewendet werden, um die sensiblen Daten besser zu schützen.

Micro Segmentation (Layer 2 Segementation)

Micro-Segmentierung geht einen Schritt weiter als die Macro-Segmentierung, indem sie Sicherheitsrichtlinien auf einer noch feiner abgestimmten Ebene durchsetzt – nämlich auf der Ebene der virtuellen Maschinen oder sogar einzelner Anwendungen. Im Gegensatz zur Macro-Segmentierung, die große Netzwerkbereiche voneinander trennt, sorgt die Micro-Segmentierung dafür, dass jeder Host, jede Anwendung oder jede Instanz innerhalb eines Segments individuell abgesichert ist.

Diese feinkörnige Kontrolle über den Datenverkehr innerhalb des Netzwerks ist besonders effektiv, um die seitliche Bewegung von Angreifern zu verhindern. Selbst wenn ein Angreifer in eine VM oder eine Anwendung eindringen kann, wird es ihm durch die Micro-Segmentierung extrem erschwert, sich weiter im Netzwerk zu bewegen oder auf andere Ressourcen zuzugreifen.

Ein Beispiel für die Implementierung von Micro-Segmentierung in einer Private Cloud könnte die Nutzung von VMware NSX oder Cisco ACI sein, die es ermöglichen, detaillierte Sicherheitsrichtlinien für jede einzelne VM festzulegen. Diese Richtlinien könnten den Datenverkehr auf Basis von Anwendungstyp, Nutzerrollen oder sogar spezifischen Sicherheitsanforderungen der jeweiligen VM steuern. So könnte beispielsweise eine Regel festlegen, dass eine Web-Server-VM nur mit einem bestimmten Datenbankserver kommunizieren darf, und jede andere Kommunikation blockiert wird.

Ein weiteres Beispiel ist die Nutzung von Micro-Segmentierung in einer DevOps-Umgebung, in der verschiedene Entwicklungsumgebungen strikt voneinander isoliert werden. Entwickler könnten so sicherstellen, dass Änderungen an einer Anwendung nur innerhalb der vorgesehenen Umgebung getestet werden, ohne das Risiko, andere Anwendungen oder Systeme zu beeinträchtigen. Dies erhöht nicht nur die Sicherheit, sondern auch die Stabilität und Zuverlässigkeit der gesamten Cloud-Umgebung.

Perimeter Firewall

Die Perimeter-Firewall stellt die äußere Verteidigungslinie einer Private Cloud dar und kontrolliert den gesamten ein- und ausgehenden Datenverkehr. Sie ist ein kritischer Bestandteil der Sicherheitsarchitektur, da sie das Netzwerk vor externen Bedrohungen schützt und gleichzeitig den Zugang zu internen Ressourcen regelt.

In einer Private Cloud muss die Perimeter-Firewall so konfiguriert sein, dass sie nicht nur klassische Bedrohungen wie unbefugten Zugriff oder Denial-of-Service-Angriffe abwehrt, sondern auch flexibel auf neue und unbekannte Bedrohungen reagieren kann. Dazu gehört die Implementierung von Funktionen wie Intrusion Prevention Systems (IPS), die aktiv nach verdächtigen Aktivitäten im Netzwerk suchen und diese blockieren können, bevor sie Schaden anrichten.

Ein Beispiel für den Einsatz von Perimeter-Firewalls in einer Private Cloud könnte der Schutz eines Webportals sein, das Kundendaten verarbeitet. Die Firewall würde dabei sicherstellen, dass nur autorisierter Datenverkehr zum Webserver gelangt, während potenziell schädlicher Verkehr, wie etwa SQL-Injection-Versuche oder DDoS-Angriffe, abgeblockt wird. Moderne Perimeter-Firewalls sind oft auch mit Deep Packet Inspection (DPI) ausgestattet, die den Inhalt des Datenverkehrs analysiert und Bedrohungen auf Anwendungsebene erkennt.

Ein weiteres Beispiel ist die Verwendung von Application Layer Gateways (ALG), die spezifische Protokolle wie FTP, SIP oder H.323 überwachen und schützen. ALG kann tief in den Datenverkehr dieser Protokolle eindringen und potenzielle Angriffsversuche erkennen, die bei einer einfachen Paketfilterung nicht auffallen würden. Dies bietet eine zusätzliche Schutzschicht, insbesondere für Anwendungen, die über das Internet zugänglich sind.

Insgesamt spielen diese Sicherheitsmaßnahmen eine zentrale Rolle im Schutz einer Private Cloud. Sie helfen dabei, den Netzwerkverkehr zu kontrollieren, Bedrohungen zu identifizieren und abzuwehren, sowie die Vertraulichkeit, Integrität und Verfügbarkeit der Cloud-Ressourcen zu gewährleisten.

Referenzinfrastruktur – Vereinfacht

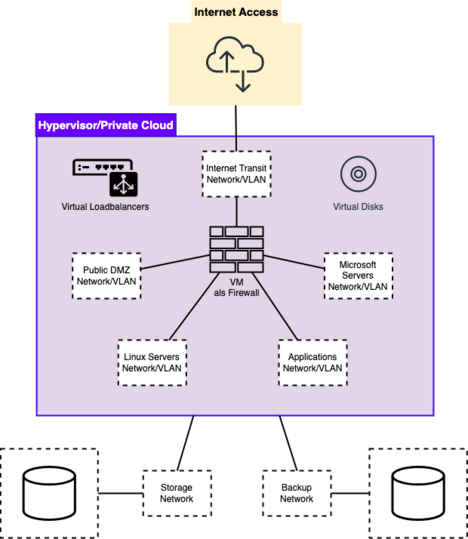

Der Betrieb einer Private Cloud ist ein anspruchsvolles Unterfangen, das sorgfältige Planung und den Einsatz von Hypervisor-Technologie erfordert. Je nach Größe der Infrastruktur und Wahl des Hypervisors kann die genaue Hardwarekonfiguration variieren. Hersteller von Hypervisoren bieten in der Regel Best Practices und Referenzarchitekturen an, um die Implementierung und den Betrieb zu erleichtern.

Die dargestellte Abbildung zeigt eine stark vereinfachte Infrastruktur, die den grundsätzlichen Aufbau einer Private Cloud veranschaulicht. Diese Darstellung dient dazu, die Funktionsweise einer Private Cloud grundlegend zu verstehen, ohne dabei auf alle technischen Details einzugehen.

Grundlegende Komponenten:

- Rack-Infrastruktur:

- Die Basis dieser Infrastruktur bildet ein Server-Rack, das zentrale Elemente wie Netzwerkgeräte (Switches, Firewalls, Router), Speicherlösungen und Rechenressourcen (Compute Nodes) beherbergt. Diese Komponenten sind für die Verbindung mit dem Internet und anderen Teilen der Infrastruktur entscheidend.

- Compute Power und Hypervisor:

- Auf den Compute Nodes wird ein Hypervisor installiert, der in der Abbildung durch die violette Komponente dargestellt wird. Der Hypervisor stellt die zentrale Verwaltungsschicht dar und ermöglicht die Virtualisierung der physischen Ressourcen. Die Compute Nodes sind über Netzwerkgeräte mit dem Internet, den Speichersystemen und den anderen Compute Nodes verbunden.

- Netzwerkkonfiguration:

- Eine korrekte Konfiguration der Netzwerkkomponenten ist unerlässlich, um eine stabile und sichere Kommunikation innerhalb der Infrastruktur und mit externen Netzwerken zu gewährleisten. Diese Netzwerke müssen sowohl außerhalb der Virtualisierungsumgebung als auch innerhalb des Hypervisors eingerichtet werden.

Aufbau der Private Cloud im Hypervisor:

- Virtuelle Netzwerke:

- Innerhalb des Hypervisors können verschiedene virtuelle Netzwerke erstellt werden, um unterschiedliche Funktionsbereiche voneinander zu trennen. Diese Netzwerke dienen dazu, den Datenverkehr zwischen den virtuellen Maschinen (VMs) und den physikalischen Ressourcen zu steuern und abzusichern.

- Virtuelle Maschinen und Ressourcen:

- Der Hypervisor ermöglicht die Erstellung und Verwaltung von virtuellen Maschinen, virtuellen Loadbalancern, virtuellen Disks und weiteren virtuellen Ressourcen. Diese Ressourcen können je nach Bedarf dynamisch angepasst werden, was eine hohe Flexibilität bietet.

- Firewall und Sicherheitsmaßnahmen:

- Eine virtuelle Maschine im Hypervisor wird oft als Firewall eingesetzt, um den Datenverkehr innerhalb der Private Cloud zu kontrollieren. Diese Firewall schützt die verschiedenen virtuellen Netzwerke und sorgt dafür, dass nur autorisierter Datenverkehr zugelassen wird.

Schematischer Aufbau der Private Cloud:

- Die Abbildung zeigt eine vereinfachte Private Cloud-Architektur, in der zwei Speichersysteme an den Hypervisor angebunden sind. Ein Speichersystem dient der normalen Datenverarbeitung, während das andere für Backups der virtuellen Maschinen und Disks vorgesehen ist.

- Für die Kommunikation mit dem Internet wird ein Transit-Netzwerk eingerichtet. Die im Hypervisor erstellten virtuellen Netzwerke ermöglichen eine feingranulare Segmentierung und Kontrolle des Datenverkehrs, was besonders wichtig für die Sicherheit und Effizienz der Cloud-Infrastruktur ist.

- Der schematische Aufbau zeigt, wie klassische Rechenzentrums-Infrastrukturen virtuell nachgebildet werden können, um die Netzwerksicherheits-Best-Practices zu erfüllen. Die Flexibilität des Hypervisors ermöglicht es, die Infrastruktur an spezifische Anforderungen anzupassen und gleichzeitig ein hohes Sicherheitsniveau aufrechtzuerhalten.

Einsatz von Private Clouds – Allgemeine Überlegungen

Es gibt zahlreiche Ansätze, eine Private Cloud zu betreiben, und die Möglichkeiten haben sich in den letzten Jahren stark erweitert, insbesondere durch Technologien wie Containerisierung und Container-Orchestrierung. Diese bieten zusätzliche Abstraktionsschichten, die mehr Flexibilität und Effizienz ermöglichen. Für Organisationen ist es jedoch entscheidend, den Ansatz zu wählen, der am besten zu ihrem bestehenden Know-how passt.

Ein wichtiger Aspekt bei der Implementierung einer Private Cloud ist die Nachhaltigkeit des Wissens im Unternehmen. Wenn beispielsweise eine einzelne Mitarbeiterin oder ein einzelner Mitarbeiter die gesamte Private Cloud-Infrastruktur aufbaut und dabei die Dokumentation vernachlässigt, kann dies zu erheblichen Problemen führen, wenn diese Person das Unternehmen verlässt. Daher muss der Fokus nicht nur auf einer sauberen Implementierung, sondern auch auf einer gründlichen Dokumentation liegen, insbesondere bei solch einer geschäftskritischen Komponente.

Private Clouds können in vielfältigen Architekturen und Größen realisiert werden, wie auch die in der Referenzarchitektur dargestellte einfache Struktur zeigt. Die Wahl der Technologien und die Größe der Cloud bestimmen dabei, welche Sicherheitsmaßnahmen ergriffen werden müssen. Diese Maßnahmen sollten stets maßgeschneidert und auf die spezifischen Anforderungen der jeweiligen Infrastruktur abgestimmt sein, um den Schutz und die Effizienz der Cloud bestmöglich zu gewährleisten.

Anbindung zu anderen Clouds/Datacentern

Die Integration einer Private Cloud mit anderen Rechenzentren oder Cloud-Umgebungen, wie einer Public Cloud oder einer Community Cloud, ist ein entscheidender Aspekt moderner IT-Infrastrukturen. Diese hybriden oder Multi-Cloud-Architekturen bieten Unternehmen die Flexibilität, Workloads effizient zu verteilen, Ressourcen zu skalieren und Sicherheitsanforderungen besser zu managen. Die Anbindung muss jedoch sorgfältig geplant und umgesetzt werden, um Performance, Sicherheit und Zuverlässigkeit zu gewährleisten.

Hier sind einige der gängigen Methoden und Best Practices für die Anbindung von Cloud-Umgebungen:

1. Anbindung über SD-WAN (Software-Defined Wide Area Network)

SD-WAN ist eine moderne Technologie, die die Vernetzung von verschiedenen Standorten, Rechenzentren und Clouds über softwaregesteuerte Netzwerklösungen optimiert. Es ermöglicht eine flexible, kosteneffiziente und sichere Verbindung zwischen verschiedenen Cloud-Umgebungen und dem Unternehmensnetzwerk.

Best Practices für SD-WAN:

- Zentrale Verwaltung und Kontrolle: SD-WAN ermöglicht die zentrale Verwaltung aller Netzwerkelemente und Traffic-Policies. Dadurch können Netzwerkverbindungen dynamisch und je nach Anwendungsanforderungen optimiert werden.

- Optimierung des Traffics: SD-WAN nutzt intelligente Algorithmen, um den Traffic über die besten verfügbaren Verbindungen zu leiten. Das führt zu einer verbesserten Performance und Zuverlässigkeit, insbesondere bei der Anbindung an Public Clouds wie AWS, Azure oder Google Cloud.

- Integrierte Sicherheitsfunktionen: SD-WAN bietet integrierte Sicherheitsmechanismen wie Verschlüsselung und Firewall-Funktionalitäten, die helfen, den Datenverkehr zwischen Cloud-Umgebungen zu schützen.

- Quality of Service (QoS): QoS-Funktionen innerhalb von SD-WAN ermöglichen die Priorisierung von kritischen Anwendungen und sorgen dafür, dass diese immer die benötigte Bandbreite und niedrige Latenzzeiten erhalten.

Ein praktisches Beispiel: Ein Unternehmen könnte seine Private Cloud, die in einem eigenen Rechenzentrum läuft, über SD-WAN mit einer Public Cloud verbinden, um rechenintensive Analysen in der Public Cloud durchzuführen, während sensible Daten in der Private Cloud verbleiben.

2. Anbindung über MPLS (Multiprotocol Label Switching)

MPLS ist eine traditionelle Netzwerktechnologie, die in vielen Unternehmensnetzwerken zur Anbindung von Rechenzentren und Standorten verwendet wird. Es bietet hohe Zuverlässigkeit, niedrige Latenzzeiten und die Möglichkeit, Verkehrsströme basierend auf vorgegebenen Prioritäten zu steuern.

Best Practices für MPLS:

- Service Level Agreements (SLAs): MPLS-Dienste werden oft mit strengen SLAs angeboten, die garantierte Latenzzeiten, Verfügbarkeit und Paketverlustraten umfassen. Dies macht MPLS ideal für geschäftskritische Anwendungen, die eine stabile und zuverlässige Verbindung benötigen.

- Traffic Engineering: MPLS ermöglicht die Priorisierung und Steuerung von Netzwerkverkehr, sodass geschäftskritische Anwendungen bevorzugt behandelt werden und ausreichend Bandbreite erhalten.

- Interoperabilität mit SD-WAN: Viele Unternehmen kombinieren MPLS mit SD-WAN, um die Flexibilität und Kosteneffizienz von SD-WAN mit der Zuverlässigkeit und Qualität von MPLS zu verbinden.

Ein Beispiel: Ein globales Unternehmen könnte MPLS nutzen, um seine Private Cloud in einem zentralen Rechenzentrum mit mehreren internationalen Standorten zu verbinden. Diese Standorte könnten über MPLS direkt miteinander kommunizieren, während die Verbindungen zu Public Clouds über SD-WAN optimiert werden.

3. Anbindung über VPN (Virtual Private Network)

VPN ist eine weit verbreitete Methode, um sichere Verbindungen über öffentliche Netzwerke herzustellen. VPNs werden häufig genutzt, um sichere Tunnels zwischen verschiedenen Cloud-Umgebungen, Rechenzentren oder Remote-Benutzern zu erstellen.

Best Practices für VPN:

- Verschlüsselung: Stellen Sie sicher, dass der gesamte VPN-Datenverkehr stark verschlüsselt ist, um die Vertraulichkeit und Integrität der übertragenen Daten zu gewährleisten.

- Redundante VPN-Tunnel: Um Ausfallsicherheit zu gewährleisten, sollten mehrere VPN-Tunnel zwischen den Standorten eingerichtet werden. Falls einer der Tunnel ausfällt, kann der Verkehr automatisch über die verbleibenden Tunnel umgeleitet werden.

- Automatische Failover: Nutzen Sie VPN-Lösungen, die ein automatisches Failover unterstützen, um sicherzustellen, dass bei einem Ausfall des primären Tunnels der Datenverkehr nahtlos über einen Backup-Tunnel umgeleitet wird.

- Integration mit Cloud-Diensten: Viele Public Cloud-Anbieter bieten native VPN-Dienste, die einfach in bestehende Netzwerke integriert werden können, um eine sichere Verbindung zwischen der Private Cloud und der Public Cloud zu gewährleisten.

Ein Beispiel: Ein mittelständisches Unternehmen könnte VPNs einsetzen, um die Verbindung zwischen seiner Private Cloud im Hauptrechenzentrum und einer Public Cloud, die für Disaster-Recovery-Zwecke verwendet wird, zu sichern. Im Falle eines Ausfalls im Hauptrechenzentrum könnte der VPN-Tunnel den Datenverkehr automatisch zur Public Cloud umleiten.

4. Anbindung über Direct Connect (Dedicated Cloud Connections)

Direct Connect ist eine Methode, bei der dedizierte, private Verbindungen zwischen einem Unternehmensrechenzentrum und einer Public Cloud eingerichtet werden. Diese Verbindungen bieten eine höhere Bandbreite, geringere Latenzzeiten und eine bessere Sicherheit als herkömmliche Internet-basierte Verbindungen.

Best Practices für Direct Connect:

- Dedizierte Bandbreite: Nutzen Sie dedizierte Leitungen mit garantierter Bandbreite, um sicherzustellen, dass die Verbindung zuverlässig und performant ist.

- Sicherheitsüberlegungen: Auch wenn Direct Connect eine physische Verbindung darstellt, sollten zusätzliche Sicherheitsmaßnahmen wie Verschlüsselung des Datenverkehrs implementiert werden, um das Risiko von Abhörversuchen zu minimieren.

- Redundanz und Failover: Richten Sie redundante Direct-Connect-Verbindungen ein, um Ausfallsicherheit zu gewährleisten. Wenn eine Verbindung ausfällt, kann der Datenverkehr über eine alternative Route geleitet werden.

- Kosten-Nutzen-Abwägung: Direct Connect ist in der Regel teurer als andere Anbindungsmethoden. Daher sollte diese Lösung für geschäftskritische Anwendungen reserviert werden, bei denen Performance und Sicherheit oberste Priorität haben.

Ein Beispiel: Ein großes Finanzinstitut könnte Direct Connect verwenden, um seine Private Cloud sicher mit einer Public Cloud zu verbinden, die für Hochfrequenzhandel und Datenanalysen genutzt wird. Die direkte Verbindung gewährleistet niedrige Latenzzeiten und eine hohe Datenübertragungsrate, die für solche Anwendungen erforderlich sind.

5. Community Cloud Anbindung

Eine Community Cloud wird von mehreren Organisationen genutzt, die ähnliche Anforderungen an Sicherheit, Datenschutz und Einhaltung gesetzlicher Vorgaben haben. Die Anbindung einer Community Cloud an eine Public Cloud oder ein anderes Rechenzentrum erfordert eine sorgfältige Planung, um die gemeinsamen Sicherheitsrichtlinien einzuhalten.

Best Practices für Community Cloud Anbindung:

- Gemeinsame Sicherheitsrichtlinien: Alle Mitglieder der Community Cloud sollten sich auf einheitliche Sicherheitsrichtlinien einigen, um sicherzustellen, dass die Anbindung an andere Clouds den gemeinsamen Anforderungen entspricht.

- Transparente Governance: Die Governance-Strukturen sollten klar definiert sein, einschließlich der Verantwortung für die Verwaltung der Verbindungen und der Einhaltung von Sicherheitsstandards.

- Zugriffssteuerung: Strenge Zugriffssteuerungen sollten implementiert werden, um sicherzustellen, dass nur autorisierte Nutzer und Dienste auf die angebundenen Clouds zugreifen können.

- Einsatz von SD-WAN oder VPN: Abhängig von den spezifischen Anforderungen der Community Cloud kann SD-WAN oder VPN als Verbindungstechnologie eingesetzt werden, um eine sichere und flexible Anbindung an Public Clouds zu ermöglichen.

Ein Beispiel: Eine Gruppe von Krankenhäusern könnte eine Community Cloud betreiben, um Patientendaten zu teilen und gemeinsam genutzte Anwendungen zu nutzen. Die Anbindung dieser Community Cloud an eine Public Cloud, die für Big Data Analysen und Machine Learning genutzt wird, könnte über VPN erfolgen, um den Datenschutz und die Einhaltung von Gesundheitsvorschriften sicherzustellen.

Public Cloud Security

Das Public Cloud Computing hat die IT-Landschaft grundlegend verändert, indem es Unternehmen weltweit skalierbare, flexible und kosteneffiziente Lösungen bietet. Doch mit diesen Vorteilen gehen auch erhebliche Sicherheitsherausforderungen einher. In diesem Kapitel werden wir die Beweggründe für die Einführung der Public Cloud, die erforderlichen Sicherheitsmaßnahmen für verschiedene Servicemodelle und die Strategien zur effektiven Bewältigung dieser Herausforderungen untersuchen.

Einführung in die Sicherheit in der Public Cloud

Die ersten öffentlichen Cloud-Dienste wurden 2006 von Amazon durch Amazon Web Services (AWS) gestartet. Mit der Einführung von Diensten wie dem Simple Storage Service (S3) und der Elastic Compute Cloud (EC2) markierte AWS einen signifikanten Wandel in der Art und Weise, wie Unternehmen ihre IT-Infrastruktur gestalten. Diese beiden Dienste sind heute noch die beliebtesten öffentlichen Cloud-Dienste weltweit. Trotz der Verfügbarkeit öffentlicher Cloud-Dienste seit 2006 dauerte es jedoch weitere 7 bis 8 Jahre, bis Unternehmen begannen, eine Cloud-Strategie zu übernehmen und den Wechsel von der lokalen Infrastruktur zu einer öffentlichen Cloud-Infrastruktur zu vollziehen.

Motive und Treiber hinter der Einführung der Public Cloud

Es gibt mehrere Gründe, warum Unternehmen zunehmend Cloud-Strategien übernehmen. Ein wesentlicher Faktor ist die fortschreitende digitale Transformation, bei der immer mehr Geschäftsmodelle auf digitalen Leistungen basieren oder einen digitalen Anteil in ihr Geschäftsmodell aufnehmen wollen. Ein weiterer grundlegender Treiber für das Cloud-Computing ist der Wechsel von Kapitalaufwendungen (CapEx), bei denen Organisationen große Geldmengen in die Infrastruktur investieren mussten, hin zu Betriebsausgaben (OpEx). Dies ermöglicht es ihnen nun, nach Nutzung zu zahlen und von Preisstrukturen zu profitieren, die mit monatlichen oder vierteljährlichen Leasingvereinbarungen vergleichbar sind. In einigen Szenarien ist es einfach vorteilhafter, nur ein geringes Budget aufzuwenden, als direkt große Investitionen zu tätigen.

Zusätzliche Treiber für eine öffentliche Cloud-Infrastruktur sind die folgenden:

- Skalierbarkeit: Benutzer haben Zugriff auf eine große Sammlung von Ressourcen, die entsprechend der Nachfrage skalieren. Dies bietet eine kostengünstige, skalierbare Infrastruktur für Unternehmen jeder Größe.

- Elastizität: Basierend auf dynamisch wechselnden Bedürfnissen verwaltet der Anbieter transparent die Ressourcennutzung eines Benutzers. Daher läuft die Rechenleistung nur mit dem notwendigen Minimum, um die gewünschten Operationen auszuführen.

- Kosteneffizienz: Das Pay-per-Usage-Modell ermöglicht es Unternehmen, einfach für die benötigten Ressourcen zu zahlen, ohne oder mit nur geringem Investitionsaufwand in die physikalischen Ressourcen, die in der Cloud verfügbar sind. Ein weiterer Kostenvorteil ist, dass die Lizenzierung von Hardware-Appliances oder Servern anders gehandhabt wird und die Verbraucher nicht für den Hardware-Support bezahlen müssen.

- Mobilität: Benutzer können von überall auf der Welt auf Daten und Anwendungen zugreifen. Die Rechen- und Speicherkomponenten einer Cloud können ebenfalls weltweit verteilt werden, und ein Content Delivery Network (CDN) kann einfach bereitgestellt werden.

- Kollaboration: Benutzer beginnen, die Cloud als Werkzeug zur Zusammenarbeit an gemeinsamen Daten und Informationen gleichzeitig zu sehen. Dies steigert die Produktivität und die Arbeitsergebnisse der Mitarbeiter und Cloud-Nutzer.

- Risikoreduzierung: Risikoreduzierung umfasst zwei Aspekte. Einerseits bieten Public Cloud-Anbieter häufig übergreifende Sicherheitsmaßnahmen an und implementieren Richtlinien, um Kunden von vornherein sichere Dienste bereitzustellen. Andererseits können Unternehmen Ideen und Konzepte in der Cloud testen, bevor sie größere Investitionen in Technologie tätigen, was das finanzielle Risiko reduziert.

Trotz dieser Vorteile ist der Umstieg auf eine Public Cloud-Infrastruktur nicht ohne Herausforderungen. Eine der größten Bedenken bei der Einführung der öffentlichen Cloud ist der physische Verlust der Kontrolle über die Computer-, Netzwerk- und Speicherkomponenten eines Unternehmens. Unternehmen, die die öffentliche Cloud übernehmen, sind stark auf den Cloud-Anbieter angewiesen und fürchten oft das Risiko eines Vendor-Lock-ins. Ein weiteres Anliegen ist der Umgang mit Daten in einer öffentlichen Cloud-Umgebung. Insbesondere die Speicherung von personenbezogenen Daten (PII) oder kritischen internen Geschäftsdaten kann für Unternehmen eine Herausforderung darstellen. Es gibt mehrere Datenschutzvorschriften und Compliance-Regeln, die alle berücksichtigt werden müssen, wenn solche Daten bei einer anderen Organisation gespeichert werden. Dies erfordert häufig die Einbindung von Datenschutz- oder IT-Rechtsspezialisten, um die Risiken zu identifizieren, sowie von erfahrenen Ingenieuren, um diese zu mindern und die Infrastruktur gemäß den Compliance-Vorgaben bereitzustellen.

Aufgrund der hohen Sicherheitspriorität der Cloud-Anbieter sind öffentliche Cloud-Umgebungen im Allgemeinen sehr sicher. Allerdings können selbst die sichersten Systeme kompromittiert werden, wenn sie nicht mit einem korrekten Cloud-Sicherheitsansatz entworfen werden.

Sicherheitsherausforderungen in der Public Cloud

Die Einführung von Public-Cloud-Diensten bringt eine Reihe von erheblichen Sicherheitsherausforderungen mit sich, die Unternehmen bewältigen müssen, um ihre Daten zu schützen und die Einhaltung relevanter Vorschriften zu gewährleisten:

Verlust der physischen Kontrolle

Einer der gravierendsten Veränderungen beim Umstieg auf eine Public-Cloud-Umgebung ist der Verlust der direkten physischen Kontrolle über die IT-Infrastruktur. In einer traditionellen On-Premises-Umgebung haben Unternehmen die volle Kontrolle über ihre Server, Speichersysteme und Netzwerkausrüstung. Diese Elemente werden vor Ort verwaltet, was es den IT-Teams ermöglicht, Sicherheitsprotokolle und physische Schutzmaßnahmen direkt umzusetzen. In einer Public-Cloud-Umgebung hingegen werden diese Elemente vom Cloud Service Provider (CSP) verwaltet. Diese Entkoppelung von der physischen Infrastruktur kann zu erheblichen Bedenken hinsichtlich der Sicherheit und Integrität der Daten führen, sowie zu Unsicherheiten über die Zuverlässigkeit der gesamten Cloud-Infrastruktur. Unternehmen müssen sich darauf verlassen, dass der CSP robuste Sicherheitsmaßnahmen implementiert, was häufig zu einem Gefühl des Kontrollverlustes führen kann.

Datenschutz und Compliance

Die Speicherung sensibler Daten, wie beispielsweise personenbezogener Daten (Personally Identifiable Information, PII), in der Cloud erfordert eine strikte Einhaltung von Datenschutzvorschriften, wie der Datenschutz-Grundverordnung (DSGVO) in Europa oder dem Health Insurance Portability and Accountability Act (HIPAA) in den USA. Diese Vorschriften stellen sicher, dass personenbezogene Daten ordnungsgemäß geschützt und verarbeitet werden. Organisationen müssen sicherstellen, dass ihre Cloud-Anbieter diese Vorschriften einhalten, was oft die Zusammenarbeit zwischen Rechtsexperten und IT-Sicherheitsspezialisten erfordert. Diese Experten müssen die Fähigkeiten des Anbieters sorgfältig bewerten und geeignete Schutzmaßnahmen implementieren, um sicherzustellen, dass die Daten in Übereinstimmung mit den geltenden Vorschriften verarbeitet werden. Die Nichteinhaltung dieser Vorschriften kann zu schwerwiegenden rechtlichen und finanziellen Konsequenzen führen, einschließlich hoher Geldstrafen und Reputationsschäden.

Vendor Lock-In

Eine starke Abhängigkeit von einem einzelnen Cloud-Anbieter kann zu einem sogenannten Vendor Lock-In führen, bei dem die Kosten, die Komplexität und der Aufwand für den Wechsel zu einem anderen Anbieter oder die Migration von Daten zurück in eine lokale Umgebung so hoch sind, dass dies praktisch unmöglich wird. Dieses Phänomen kann die Flexibilität und Innovationsfähigkeit eines Unternehmens erheblich beeinträchtigen, da es schwierig wird, auf sich ändernde Geschäftsanforderungen zu reagieren oder von besseren Preisen oder Funktionen anderer Anbieter zu profitieren. Unternehmen sollten daher sorgfältig abwägen, wie sie ihre Cloud-Strategie gestalten, um die Risiken eines Vendor Lock-In zu minimieren. Dazu können Multi-Cloud-Strategien oder hybride Ansätze gehören, die eine größere Unabhängigkeit von einem einzelnen Anbieter gewährleisten.

Shared-Responsibility-Modell

Ein grundlegender Aspekt der Sicherheit in Public-Cloud-Umgebungen ist das Shared-Responsibility-Modell, bei dem die Verantwortung für die Sicherheit zwischen dem Cloud-Service-Anbieter (CSP) und dem Kunden (Cloud Service Consumer, CSC) aufgeteilt wird. In diesem Modell sichert der CSP in der Regel die zugrunde liegende Infrastruktur ab, einschließlich physischer Server, Netzwerke und Hypervisoren. Der Kunde ist hingegen dafür verantwortlich, seine eigenen Daten, Anwendungen und den Benutzerzugang zu sichern. Dies umfasst die Implementierung von Verschlüsselung, Zugangskontrollen, Firewalls und anderen Sicherheitsmaßnahmen auf Anwendungsebene. Das Verständnis und die effektive Verwaltung dieser geteilten Verantwortung sind entscheidend, um eine sichere Cloud-Umgebung aufrechtzuerhalten. Unternehmen müssen sicherstellen, dass sie ihre Rolle im Shared-Responsibility-Modell genau verstehen und geeignete Sicherheitsvorkehrungen treffen, um potenzielle Schwachstellen zu minimieren.

Sicherheitsverantwortlichkeiten und Maßnahmen für verschiedene Servicemodelle

Die Sicherheitsverantwortlichkeiten in einer Public-Cloud-Umgebung variieren je nach dem gewählten Servicemodell—Infrastructure as a Service (IaaS), Platform as a Service (PaaS) oder Software as a Service (SaaS). Jedes Modell erfordert einen spezifischen Sicherheitsansatz, der auf die jeweilige Struktur und die Art der Anwendung zugeschnitten ist. In den folgenden Abschnitten werden die Sicherheitsmaßnahmen detailliert erläutert, die für jedes dieser Modelle erforderlich sind.

Sicherheit in SaaS-Umgebungen

Im SaaS-Modell liegt die Verantwortung für die Sicherheit der zugrunde liegenden Software und Infrastruktur hauptsächlich beim Cloud-Service-Provider (CSP). Der Cloud-Service-Consumer (CSC), also der Kunde, hat keine direkte Verantwortung für die Sicherheit der genutzten Software oder der gespeicherten Daten. Dennoch bleibt der Kunde für mehrere sicherheitsrelevante Aspekte verantwortlich, insbesondere bei der Nutzung der SaaS-Lösung.

Beispielsweise muss der CSC sicherstellen, dass die Kommunikation zur SaaS-Plattform verschlüsselt ist, um die Integrität und Vertraulichkeit der übertragenen Daten zu gewährleisten. Hierbei ist es wichtig, dass kryptografische Mechanismen wie TLS (Transport Layer Security) genutzt werden. Ein weiteres Sicherheitsrisiko stellt das Phishing dar. Phishing-Webseiten versuchen, echte SaaS-Plattformen nachzuahmen, um Benutzeranmeldedaten zu stehlen. Daher sollten Benutzer nur vertrauenswürdige DNS-Server verwenden und auf die korrekte Schreibweise von Domainnamen achten.

Zudem sollte ein starkes Authentifizierungsverfahren implementiert werden, um zu verhindern, dass Passwörter durch Methoden wie Wörterbuchangriffe geknackt werden. Passwortmanager können hier nützlich sein, um sicherzustellen, dass für verschiedene Anwendungen unterschiedliche, starke Passwörter verwendet werden. Ergänzend dazu ist die Nutzung von Multi-Faktor-Authentifizierung (MFA) ratsam, um eine zusätzliche Sicherheitsebene zu schaffen. Mit diesen Sicherheitsvorkehrungen können SaaS-Nutzer sicher sein, dass ihre Daten und Zugänge gut geschützt sind, vorausgesetzt, der SaaS-Anbieter schützt die zugrunde liegende Software und Infrastruktur effektiv.

Sicherheit in PaaS-Umgebungen

In einem PaaS-Modell hat der CSC nicht nur die oben genannten Sicherheitsverantwortlichkeiten aus dem SaaS-Modell, sondern trägt zusätzlich die Verantwortung für die Sicherheit der entwickelten und bereitgestellten Anwendungen sowie der zugrunde liegenden Daten.

Sicherung von Anwendungen: Um eine Anwendung zu sichern, stehen dem CSC verschiedene Optionen zur Verfügung. Für Webanwendungen kann beispielsweise eine Web Application Firewall (WAF) eingesetzt werden. Diese speziellen Firewalls analysieren den Datenverkehr nach der TLS-Terminierung, wodurch der Verkehr im Klartext inspiziert werden kann. Eine WAF bietet Schutz vor gängigen Webangriffen, wie sie in den OWASP Top 10 beschrieben sind, einschließlich SQL-Injection und Cross-Site Scripting (XSS). Eine WAF kann entweder direkt auf dem Webserver als Modul implementiert werden oder durch einen dedizierten WAF-Dienst, etwa von AWS, bereitgestellt werden.

Ein weiterer wichtiger Aspekt der Anwendungssicherheit ist die Integration von Sicherheitsmaßnahmen in den Software Development Life Cycle (SDLC). Hierzu gehört die Schulung von Entwicklern in sicheren Codierungsmethoden sowie die regelmäßige Durchführung von Sicherheitsbewertungen. Dazu zählen auch statische (SAST) und dynamische Anwendungssicherheitstests (DAST).

- Software Composition Analysis (SCA): Diese Methode scannt den Code eines Projekts nach verwendeten Bibliotheken und Abhängigkeiten und identifiziert bekannte Sicherheitslücken in diesen Bibliotheken.

- Static Application Security Testing (SAST): Im Gegensatz zur SCA analysiert SAST den Quellcode auf unsichere Codierungsmuster, die potenzielle Sicherheitslücken darstellen können, wie z. B. SQL-Injections.

Darüber hinaus kann der CSC durch Black-Box-Tests die Anwendung auf unbekannte Schwachstellen untersuchen. Hierzu gehört die dynamische Anwendungssicherheitstests (DAST), bei der automatisierte Angriffe durchgeführt werden, um Schwachstellen zu identifizieren, und manuelle Penetrationstests, bei denen ethische Hacker versuchen, Sicherheitslücken in der Anwendung zu finden.

Sicherung von Daten/Datenbanken: Der CSC ist dafür verantwortlich, dass die in der Cloud gespeicherten Daten ausreichend geschützt sind. Dies umfasst die Verschlüsselung der Daten im Ruhezustand (Encryption at Rest) sowie die Implementierung eines rollenbasierten Zugriffsmanagements (RBAC), um sicherzustellen, dass nur autorisierte Anwendungen auf die Daten zugreifen können. Darüber hinaus muss der CSC sicherstellen, dass alle gespeicherten Daten den relevanten Compliance-Vorschriften und Datenschutzgesetzen entsprechen. Beispielsweise könnte eine Vorschrift verlangen, dass personenbezogene Daten (PII) nur innerhalb der Europäischen Union gespeichert werden dürfen.

Sicherheit in IaaS-Umgebungen

Im IaaS-Modell hat der CSC die größte Kontrolle über die IT-Umgebung, was jedoch auch die größte Sicherheitsverantwortung mit sich bringt. Zusätzlich zu den Maßnahmen, die für SaaS und PaaS beschrieben wurden, ist der CSC in der IaaS-Umgebung auch für die Sicherung der Laufzeitumgebung, Middleware und des Betriebssystems verantwortlich.

Netzwerksicherheit: Hier sind Netzwerk-Sicherheitsgruppen (NSGs) von entscheidender Bedeutung. Diese bieten eine grundlegende Firewall-Funktionalität auf Layer 4 des OSI-Modells, die den Zugriff auf virtuelle Maschinen und andere Cloud-Ressourcen einschränkt. Zum Beispiel kann der Zugriff auf eine VM über das Internet auf die TCP-Ports 443 (HTTPS) und 80 (HTTP) beschränkt werden, während der Verwaltungszugriff (z. B. über SSH) nur von einer bestimmten IP-Adresse aus erlaubt wird.

Betriebssystemsicherheit: Die Betriebssysteme aller virtuellen Maschinen müssen regelmäßig aktualisiert und gepatcht werden, um sicherzustellen, dass stets die neuesten Sicherheitsfixes installiert sind. Cloud-Anbieter bieten in der Regel Dienste an, die das Monitoring von Betriebssystemen übernehmen und den CSC bei Sicherheitswarnungen und Aktualisierungen unterstützen.

Container-Sicherheit: Für Organisationen, die Container verwenden, ist es entscheidend, Container-Images auf Sicherheitslücken zu scannen und ein umfassendes Container-Registry-Management durchzuführen. Dies gewährleistet, dass alle verwendeten Container den aktuellen Sicherheitsanforderungen entsprechen.

Erweiterter Schutz durch virtuelle Firewalls: Wenn diese Maßnahmen nicht ausreichen, kann der CSC virtuelle Cloud-Firewalls einsetzen, die tiefe Paketinspektionen (Deep Packet Inspection, DPI) durchführen und Sicherheitsmechanismen bis zur siebten Schicht (Layer 7) des OSI-Modells implementieren.

Migrationsstrategien und Sicherheitsüberlegungen

Die Migration in die Public Cloud erfordert eine sorgfältige Planung, insbesondere in Bezug auf die Sicherheit. Eine gut durchdachte Migrationsstrategie ist entscheidend, um potenzielle Risiken zu minimieren und eine sichere IT-Infrastruktur zu gewährleisten.

Bewertung und Planung: Vor der Migration sollte eine gründliche Bewertung der bestehenden Sicherheitsmaßnahmen erfolgen, um Schwachstellen zu identifizieren, die in der Cloud-Umgebung behoben werden müssen. Diese Analyse bildet die Grundlage für eine sichere Migration und die Anpassung der Sicherheitsstrategie an die Cloud-Umgebung.

Schrittweise Migration: Es empfiehlt sich, die Migration schrittweise durchzuführen, beginnend mit weniger kritischen Anwendungen. Diese Methode minimiert das Risiko und bietet dem Unternehmen die Möglichkeit, Erfahrungen im Umgang mit Cloud-Sicherheit zu sammeln, bevor komplexere und kritischere Systeme migriert werden.

Auswahl des Anbieters: Die Wahl eines Cloud-Anbieters sollte unter Berücksichtigung seiner Sicherheitsfunktionen und der Einhaltung relevanter Industriestandards und Vorschriften erfolgen. Ein Anbieter, der robuste Sicherheitsfunktionen bietet, ist entscheidend für den Schutz der in der Cloud gespeicherten Daten und Anwendungen.

Fortlaufende Überwachung und Verwaltung: Nach der Migration ist eine kontinuierliche Überwachung der Cloud-Ressourcen erforderlich, um auf Sicherheitsbedrohungen zu reagieren und Sicherheitsmaßnahmen bei Bedarf anzupassen. Cloud-Umgebungen sind dynamisch, und es ist unerlässlich, auf neue Bedrohungen schnell zu reagieren, um die Sicherheit dauerhaft zu gewährleisten.

Fazit

Public-Cloud-Computing bietet erhebliche Vorteile in Bezug auf Skalierbarkeit, Kosteneffizienz und Flexibilität, was es zu einer attraktiven Option für Unternehmen jeder Größe macht. Diese Vorteile gehen jedoch mit erheblichen Sicherheitsherausforderungen einher, die durch eine Kombination aus sorgfältiger Planung, robusten Sicherheitsmaßnahmen und fortlaufendem Management angegangen werden müssen. Es ist von entscheidender Bedeutung, dass Organisationen die Sicherheitsverantwortlichkeiten, die mit den verschiedenen Servicemodellen verbunden sind, genau verstehen und geeignete Sicherheitskontrollen implementieren. Eine gut geplante Migrationsstrategie und ein darauf abgestimmtes Sicherheitskonzept sind unerlässlich, um die Vorteile des Public-Cloud-Computings voll auszuschöpfen und gleichzeitig die Risiken zu minimieren.