Methoden der Datenanalyse - Varianzanalyse: Unterschied zwischen den Versionen

| Zeile 1: | Zeile 1: | ||

<math display="block"> | |||

\underbrace{\sum_{i=1}^{k} \sum_{j=1}^{n_{1}}\left(y_{i j}-\hat{\mu}\right)^{2}}_{\mathrm{QT}}=\underbrace{\sum_{i=1}^{k} \sum_{j=1}^{n_{1}}\left(y_{i j}-\hat{\mu}_{i}\right)^{2}}_{\mathrm{QI}}+\underbrace{\sum_{i=1}^{k} n_{i}\left(\hat{\mu}_{i}-\hat{\mu}\right)^{2}}_{\mathrm{QZ}} | |||

</math> | |||

QT…Quadratsumme „Total“ | |||

QI…Quadratsumme „Innerhalb“ | |||

QZ…Quadratsumme „Zwischen“ | |||

Die Gesamtvariabilität der Daten QT kann also in zwei additive Teile gespalten werden. Dadurch bietet sich als weitere deskriptive Größe analog zur Regressionsanalyse das Bestimmtheitsmaß an, welches als Quotient aus QZ und QT berechnet wird und wieder den Anteil an der durch das Modell erklärten Varianz an der Zielgröße angibt. | |||

{| | {| | ||

! width="100%" | '''Aufgabe | ! width="100%" | '''Aufgabe 4''' | ||

Denken Sie sich zwei Datensätze aus (je drei Gruppen mit je fünf Beobachtungen pro Gruppe). Einen, bei dem das Bestimmtheitsmaß 100% beträgt und einen, bei dem das Bestimmtheitsmaß 0% beträgt. Welche Charakteristik haben die Daten jeweils. | |||

|} | |} | ||

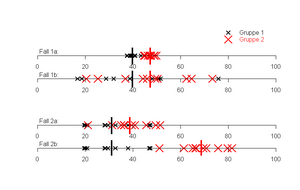

[[file:img1642169593358.png|300px|none|thumb|Vier Datenreihen mit je zwei Gruppen,<br class="mwt-preserveHtml" data-mwt-sameline="true" data-mwt-spaces="" /><span class="mwt-placeHolder mwt-singleLinebreak mwt-slbltr mwt-hidePlaceholder" title="Non-displayed single linebreak" contenteditable="false" draggable="true"> </span>die gut bzw. schlecht getrennt werden können]] | |||

Um nun inferenzstatistische Aussagen zu machen, wird nun die Quadratsumme „Zwischen“ nicht zur totalen Quadratsumme, sondern zur Quadratsumme „Innerhalb“ in Beziehung gesetzt. Dies liefert auch dann die Prüfgröße F <ref>Die Prüfgröße F bzw. die Prüfverteilung ist benannt nach Sir Ronald A. Fisher, der erstmals im Jahre 1935 mit Erscheinen seines Buches „The Design of Experiments“ eine ausführliche Darstellung von Varianzanalyse und Versuchsplanung veröffentlichte (Hartung, 1998, S.12).</ref> für unsere Hypothese: | |||

<math display="block"> | <math display="block"> | ||

F=\frac{M Q Z}{M Q I}=\frac{\frac{1}{k-1} Q Z}{\frac{1}{N-k} Q I}=\frac{(N-k) Q Z}{(k-1) Q I} \qquad | |||

{\left[N=n_{1}+n_{2}+n_{3}\right]} | |||

</math> | </math> | ||

Es kann gezeigt werden, dass <math>F</math> unter Gültigkeit der Nullhypothese (die Erwartungswerte aller Gruppen sind gleich) und den anderen vorher erwähnten Modellannahmen (Normalverteilung der Fehler) nach einer F-Verteilung mit <math>k-1</math> und <math>N-k</math> Freiheitsgraden verteilt ist. Dadurch werden Schranken definiert, bis zu welchen Werten von <math></math> eine Entscheidung für die Nullhypothese und ab wann eine Entscheidung für die Alternativhypothese erfolgt. Was man weiters wie bei jedem statistischen Test benötigt, ist <math>\alpha</math>, die “Irrtumswahrscheinlichkeit“ (=die Wahrscheinlichkeit, die <math>H_0</math> zu verwerfen, obwohl sie zutrifft). | |||

{| | |||

! width="100%" | '''Fortsetzung Beispiel 2''' | |||

<math display="block"> | |||

Q T=(9-11,717)^{2}+\cdots(14,1-11,717)^{2}=323,105 | |||

</math> | |||

<math display="block"> | |||

Q I=(9-8,771)^{2}+\cdots+(6,8-8,771)^{2}+\cdots+(14,1-14,950)^{2}=199,361 | |||

</math> | |||

<math display="block"> | |||

Q Z=Q T-Q I=323,105-199,361=123,744 | |||

</math> | |||

<math display="block"> | |||

F=\frac{\frac{1}{3-1} * 123,744}{\frac{1}{18-3} * 199,361}=\frac{61,872}{13,291}=4,655 | |||

</math> | |||

|- | |||

| | |||

<br> | |||

|} | |||

{| | |||

! width="100%" | '''Aufgabe 5''' | |||

Version vom 17. Jänner 2022, 11:45 Uhr

QT…Quadratsumme „Total“

QI…Quadratsumme „Innerhalb“

QZ…Quadratsumme „Zwischen“

Die Gesamtvariabilität der Daten QT kann also in zwei additive Teile gespalten werden. Dadurch bietet sich als weitere deskriptive Größe analog zur Regressionsanalyse das Bestimmtheitsmaß an, welches als Quotient aus QZ und QT berechnet wird und wieder den Anteil an der durch das Modell erklärten Varianz an der Zielgröße angibt.

| Aufgabe 4

Denken Sie sich zwei Datensätze aus (je drei Gruppen mit je fünf Beobachtungen pro Gruppe). Einen, bei dem das Bestimmtheitsmaß 100% beträgt und einen, bei dem das Bestimmtheitsmaß 0% beträgt. Welche Charakteristik haben die Daten jeweils. |

|---|

Um nun inferenzstatistische Aussagen zu machen, wird nun die Quadratsumme „Zwischen“ nicht zur totalen Quadratsumme, sondern zur Quadratsumme „Innerhalb“ in Beziehung gesetzt. Dies liefert auch dann die Prüfgröße F [1] für unsere Hypothese:

Es kann gezeigt werden, dass unter Gültigkeit der Nullhypothese (die Erwartungswerte aller Gruppen sind gleich) und den anderen vorher erwähnten Modellannahmen (Normalverteilung der Fehler) nach einer F-Verteilung mit Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle k-1}

und Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle N-k}

Freiheitsgraden verteilt ist. Dadurch werden Schranken definiert, bis zu welchen Werten von eine Entscheidung für die Nullhypothese und ab wann eine Entscheidung für die Alternativhypothese erfolgt. Was man weiters wie bei jedem statistischen Test benötigt, ist Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha}

, die “Irrtumswahrscheinlichkeit“ (=die Wahrscheinlichkeit, die Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle H_0}

zu verwerfen, obwohl sie zutrifft).

| Fortsetzung Beispiel 2

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle Q T=(9-11,717)^{2}+\cdots(14,1-11,717)^{2}=323,105 } Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle Q I=(9-8,771)^{2}+\cdots+(6,8-8,771)^{2}+\cdots+(14,1-14,950)^{2}=199,361 } Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle Q Z=Q T-Q I=323,105-199,361=123,744 } |

|---|

|

|

| Aufgabe 5 |

|---|

- ↑ Die Prüfgröße F bzw. die Prüfverteilung ist benannt nach Sir Ronald A. Fisher, der erstmals im Jahre 1935 mit Erscheinen seines Buches „The Design of Experiments“ eine ausführliche Darstellung von Varianzanalyse und Versuchsplanung veröffentlichte (Hartung, 1998, S.12).

![{\displaystyle F={\frac {MQZ}{MQI}}={\frac {{\frac {1}{k-1}}QZ}{{\frac {1}{N-k}}QI}}={\frac {(N-k)QZ}{(k-1)QI}}\qquad {\left[N=n_{1}+n_{2}+n_{3}\right]}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b0b6bd3cd08e37b656011f2cda41812198fde6e9)