KI in der Wirtschaft: Unterschied zwischen den Versionen

| Zeile 61: | Zeile 61: | ||

Aktuelle Entwicklungen und Trends | Aktuelle Entwicklungen und Trends | ||

Heute (2023) sind die Bedingungen für die KI-Forschung deutlich verbessert, weil die verfügbare Rechenleistung, die Datenmengen und die Investitionen erheblich gestiegen sind. Das hat zur Belebung der KI-Forschung geführt, die von beeindruckenden Fortschritten in Bereichen wie | Heute (2023) sind die Bedingungen für die KI-Forschung deutlich verbessert, weil die verfügbare Rechenleistung, die Datenmengen und die Investitionen erheblich gestiegen sind. Das hat zur Belebung der KI-Forschung geführt, die von beeindruckenden Fortschritten in Bereichen wie maschinellen Lernen und Deep Learning geprägt ist. | ||

KI-Technologien werden aktuell bereits in vielen Bereichen eingesetzt, darunter Gesundheitswesen, Finanzwesen, Logistik, Unterhaltung und mehr. Die Entwicklung von autonomen Robotern, fortgeschrittener Robotik und der Versuch, menschenähnliche Intelligenz zu erreichen, bleiben wichtige Ziele der KI-Forschung. | KI-Technologien werden aktuell bereits in vielen Bereichen eingesetzt, darunter Gesundheitswesen, Finanzwesen, Logistik, Unterhaltung und mehr. Die Entwicklung von autonomen Robotern, fortgeschrittener Robotik und der Versuch, menschenähnliche Intelligenz zu erreichen, bleiben wichtige Ziele der KI-Forschung. | ||

Die Entwicklung der Künstlichen Intelligenz hat eine faszinierende Geschichte von Theorie, Forschung, Fortschritten und Herausforderungen. Die heutige KI-Landschaft wird von Technologien wie maschinellen Lernen, Deep Learning und Big Data geprägt und hat das Potenzial, unser tägliches Leben und viele Branchen grundlegend zu verändern. | |||

<ol style="list-style-type: decimal;" start="2"> | <ol style="list-style-type: decimal;" start="2"> | ||

| Zeile 103: | Zeile 102: | ||

Ethik und Fairness | Ethik und Fairness | ||

Die Forschung im Bereich KI-Ethik und Fairness nimmt zu. Es wird daran gearbeitet, KI-Systeme gerechter und transparenter zu gestalten und sicherzustellen, | Die Forschung im Bereich KI-Ethik und Fairness nimmt zu. Es wird daran gearbeitet, KI-Systeme gerechter und transparenter zu gestalten und sicherzustellen, dass ethische Richtlinien eingehalten werden. | ||

Quanten-KI | Quanten-KI | ||

| Zeile 143: | Zeile 142: | ||

# Medizinische Diagnose: KI-Systeme können zur Identifizierung von Krankheiten anhand von medizinischen Bildern wie Röntgenaufnahmen oder zur Analyse von medizinischen Daten eingesetzt werden. | # Medizinische Diagnose: KI-Systeme können zur Identifizierung von Krankheiten anhand von medizinischen Bildern wie Röntgenaufnahmen oder zur Analyse von medizinischen Daten eingesetzt werden. | ||

# Naturkatastrophen-Vorhersage: KI kann verwendet werden, um Muster in meteorologischen Daten zu erkennen und Vorhersagen über Wetterereignisse wie Hurrikane oder Erdbeben zu treffen. | # Naturkatastrophen-Vorhersage: KI kann verwendet werden, um Muster in meteorologischen Daten zu erkennen und Vorhersagen über Wetterereignisse wie Hurrikane oder Erdbeben zu treffen. | ||

Diese spezialisierten KI-Systeme sind sehr leistungsfähig und können in ihren jeweiligen Aufgabenbereichen beeindruckende Ergebnisse erzielen. KI-Systeme basieren in der Regel auf | Diese spezialisierten KI-Systeme sind sehr leistungsfähig und können in ihren jeweiligen Aufgabenbereichen beeindruckende Ergebnisse erzielen. KI-Systeme basieren in der Regel auf maschinellen Lernen und können durch Training und Anpassung an neue Daten weiter verbessert werden. | ||

Es gibt jedoch auch Bestrebungen, auch eine „starke KI“ oder „allgemeine KI“ zu entwickeln, die über die Spezialisierung hinausgeht und die damit die Fähigkeit hat, eine breite Palette von Aufgaben zu lösen und menschenähnliches Verständnis und Lernen zu demonstrieren. Diese Art der KI ist jedoch noch in den Anfängen und stellt eine erhebliche Herausforderung dar, da diese ein tiefes Verständnis und eine kohärente Intelligenz erfordert, die über einzelne Aufgaben hinausgeht. | Es gibt jedoch auch Bestrebungen, auch eine „starke KI“ oder „allgemeine KI“ zu entwickeln, die über die Spezialisierung hinausgeht und die damit die Fähigkeit hat, eine breite Palette von Aufgaben zu lösen und menschenähnliches Verständnis und Lernen zu demonstrieren. Diese Art der KI ist jedoch noch in den Anfängen und stellt eine erhebliche Herausforderung dar, da diese ein tiefes Verständnis und eine kohärente Intelligenz erfordert, die über einzelne Aufgaben hinausgeht. | ||

| Zeile 161: | Zeile 160: | ||

# '''Allgemeines Verständnis und Intuition:''' KI-Systeme fehlt ein tiefes Verständnis der Welt und die Fähigkeit zur Intuition. KI-Systeme verarbeiten Informationen auf einer rein algorithmischen Ebene und verstehen nicht die Bedeutung oder den Kontext. | # '''Allgemeines Verständnis und Intuition:''' KI-Systeme fehlt ein tiefes Verständnis der Welt und die Fähigkeit zur Intuition. KI-Systeme verarbeiten Informationen auf einer rein algorithmischen Ebene und verstehen nicht die Bedeutung oder den Kontext. | ||

# '''Kreativität und Originalität:''' KI kann menschliche Kreativität nicht vollständig nachahmen. Obwohl KI-Systeme in der Lage | # '''Kreativität und Originalität:''' Kreativität und Originalität: KI kann menschliche Kreativität nicht vollständig nachahmen. Obwohl ein KI-Systeme in der Lage sind, auf der Grundlage von Daten und Mustern etwas Neues zu generieren, fehlt ihnen die Fähigkeit zur Originalität und zum kreativen Denken. | ||

# '''Ethik und Moral:''' KI-Systeme haben kein ethisches oder moralisches Verständnis und treffen keine moralischen Entscheidungen. KI-Systeme spiegeln lediglich die Daten wider, auf denen diese trainiert wurden. | # '''Ethik und Moral:''' KI-Systeme haben kein ethisches oder moralisches Verständnis und treffen keine moralischen Entscheidungen. KI-Systeme spiegeln lediglich die Daten wider, auf denen diese trainiert wurden. | ||

# '''Emotionen und Empathie:''' KI hat keine Emotionen und kann keine Empathie zeigen. KI-Systeme können Textanalysen verwenden, um menschliche Emotionen zu erkennen, aber KI-Systeme verstehen diese nicht in menschenähnlicher Art und Weise. | # '''Emotionen und Empathie:''' KI hat keine Emotionen und kann keine Empathie zeigen. KI-Systeme können Textanalysen verwenden, um menschliche Emotionen zu erkennen, aber KI-Systeme verstehen diese nicht in menschenähnlicher Art und Weise. | ||

| Zeile 210: | Zeile 209: | ||

'''Vorhersagen und Entscheidungen:''' KI-Modelle können verwendet werden, um Vorhersagen zu treffen oder Entscheidungen zu treffen. Beispielsweise können KI-Modelle dazu verwendet werden, die Wahrscheinlichkeit eines Ereignisses vorherzusagen, wie das Wetter oder den Erfolg einer Marketingkampagne. KI-Modelle können Entscheidungen treffen, wie beispielsweise autonome Fahrzeuge, die entscheiden, wann autonome Fahrzeuge bremsen oder beschleunigen sollen. | '''Vorhersagen und Entscheidungen:''' KI-Modelle können verwendet werden, um Vorhersagen zu treffen oder Entscheidungen zu treffen. Beispielsweise können KI-Modelle dazu verwendet werden, die Wahrscheinlichkeit eines Ereignisses vorherzusagen, wie das Wetter oder den Erfolg einer Marketingkampagne. KI-Modelle können Entscheidungen treffen, wie beispielsweise autonome Fahrzeuge, die entscheiden, wann autonome Fahrzeuge bremsen oder beschleunigen sollen. | ||

'''Interpretierbarkeit:''' In einigen Anwendungen ist es wichtig zu verstehen, wie ein KI-Modell zu seinen Entscheidungen gelangt. Die Interpretierbarkeit von Modellen ist ein aktives Forschungsgebiet, um sicherzustellen, dass KI-Entscheidungen nachvollziehbar und verständlich sind. Insbesondere wenn Entscheidungen einer KI hinterfragt werden müssen ist es von entscheidender Bedeutung, den Entscheidungspfad der KI analysieren zu können, um Fehlentscheidungen im Vorhinein vermeiden zu können. | '''Interpretierbarkeit:''' In einigen Anwendungen ist es wichtig zu verstehen, wie ein KI-Modell zu seinen Entscheidungen gelangt. Die Interpretierbarkeit von Modellen ist ein aktives Forschungsgebiet, um sicherzustellen, dass KI-Entscheidungen nachvollziehbar und verständlich sind. Insbesondere wenn Entscheidungen einer KI hinterfragt werden müssen, ist es von entscheidender Bedeutung, den Entscheidungspfad der KI analysieren zu können, um Fehlentscheidungen im Vorhinein vermeiden zu können. | ||

'''Skalierbarkeit:''' KI-Modelle können in der Regel auf große Datensätze und komplexe Aufgaben skaliert werden, vorausgesetzt, es stehen ausreichend Rechenressourcen zur Verfügung. | '''Skalierbarkeit:''' KI-Modelle können in der Regel auf große Datensätze und komplexe Aufgaben skaliert werden, vorausgesetzt, es stehen ausreichend Rechenressourcen zur Verfügung. | ||

| Zeile 229: | Zeile 229: | ||

Es gibt spezialisierte KI-Modelle. Ein bestimmtes KI-Modell, wie zum Beispiel ein Modell für die Bilderkennung, ist darauf spezialisiert, Bilder zu analysieren und Muster darin zu erkennen. Es wird nicht in der Lage sein, Textübersetzungen oder andere Aufgaben zu bewältigen, für die es nicht entwickelt wurde. | Es gibt spezialisierte KI-Modelle. Ein bestimmtes KI-Modell, wie zum Beispiel ein Modell für die Bilderkennung, ist darauf spezialisiert, Bilder zu analysieren und Muster darin zu erkennen. Es wird nicht in der Lage sein, Textübersetzungen oder andere Aufgaben zu bewältigen, für die es nicht entwickelt wurde. | ||

Die breite Palette von KI-Anwendungen | Die breite Palette von KI-Anwendungen besteht aus den in der Praxis vorhandenen, verschiedenen KI-Modellen, die für spezifische Aufgaben entwickelt wurden. Wenn all diese Modelle und Systeme zusammen betrachtet werden, kann dadurch eine breite Palette von Anwendungen abgedeckt werden. | ||

Das Transferlernen kann in einigen Fällen verwendet werden, um ein KI-Modell, das für eine Aufgabe trainiert wurde, auf eine ähnliche, aber leicht unterschiedliche Aufgabe anzuwenden. Das ermöglicht eine gewisse Flexibilität, ist jedoch begrenzt und erfordert in der Regel immer noch spezielle Anpassungen. | Das Transferlernen kann in einigen Fällen verwendet werden, um ein KI-Modell, das für eine Aufgabe trainiert wurde, auf eine ähnliche, aber leicht unterschiedliche Aufgabe anzuwenden. Das ermöglicht eine gewisse Flexibilität, ist jedoch begrenzt und erfordert in der Regel immer noch spezielle Anpassungen. | ||

| Zeile 272: | Zeile 272: | ||

<ol style="list-style-type: decimal;" start="2"> | <ol style="list-style-type: decimal;" start="2"> | ||

<li><p>''' | <li><p>'''Neuronale Netze im maschinellen Lernen'''</p></li> | ||

</ol> | </ol> | ||

Die Schlüsselkonzepte von Künstlicher Intelligenz (KI) umfassen Ideen, Techniken und Methoden, die darauf abzielen, Maschinen die Fähigkeit zu verleihen, intelligentes Verhalten zu zeigen. Maschinelles Lernen dabei ein zentraler Bestandteil der KI. Maschinelles Lernen ermöglicht es Computern, Muster aus Daten zu lernen und Vorhersagen oder Entscheidungen zu treffen, ohne explizit programmiert zu werden. Dazu gibt es verschiedene Ansätze, wie überwachtes Lernen, unüberwachtes Lernen und bestärkendes Lernen. | Die Schlüsselkonzepte von Künstlicher Intelligenz (KI) umfassen Ideen, Techniken und Methoden, die darauf abzielen, Maschinen die Fähigkeit zu verleihen, intelligentes Verhalten zu zeigen. Maschinelles Lernen ist dabei ein zentraler Bestandteil der KI. Maschinelles Lernen ermöglicht es Computern, Muster aus Daten zu lernen und Vorhersagen oder Entscheidungen zu treffen, ohne explizit programmiert zu werden. Dazu gibt es verschiedene Ansätze, wie überwachtes Lernen, unüberwachtes Lernen und bestärkendes Lernen. | ||

i | |||

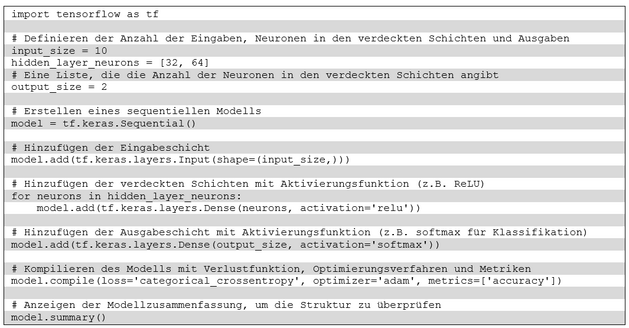

Neuronale Netzwerke werden für viele maschinelle Lernanwendungen verwendet. Neuronale Netzwerke bestehen aus miteinander verbundenen Neuronen, die in Schichten organisiert sind. Maschinelles Lernen nutzt Daten, um daraus Muster zu erkennen, die komplexe Entscheidungsprozesse ermöglichen. In der Folge werden die wichtigsten Merkmale, Begriffe und Techniken diskutiert. | Neuronale Netzwerke werden für viele maschinelle Lernanwendungen verwendet. Neuronale Netzwerke bestehen aus miteinander verbundenen Neuronen, die in Schichten organisiert sind. Maschinelles Lernen nutzt Daten, um daraus Muster zu erkennen, die komplexe Entscheidungsprozesse ermöglichen. In der Folge werden die wichtigsten Merkmale, Begriffe und Techniken diskutiert. | ||

| Zeile 412: | Zeile 412: | ||

<li><p><span id="_Toc151986924" class="anchor"></span>'''Begriff „Modell“'''</p></li> | <li><p><span id="_Toc151986924" class="anchor"></span>'''Begriff „Modell“'''</p></li> | ||

</ol> | </ol> | ||

Im | Im Zusammenhang mit KI und maschinellen Lernen bezieht sich der Modellbegriff auf die zentralen Bausteine eines Systems, das Daten analysiert, Muster erkennt und Vorhersagen trifft. Solche Modelle werden mit Hilfe der höheren Mathematik in Formeln gefasst und beschrieben. In diesem Text wird auf mathematische Zusammenhänge nicht im Detail eingegangen. Folgende Aspekte des Modellbegriffs in der KI werden für das Verständnis benötigt: | ||

Im Zusammenhang mit KI und maschinellem Lernen bezieht sich der Modellbegriff auf die zentralen Bausteine eines Systems, das Daten analysiert, Muster erkennt und Vorhersagen trifft. Solche Modelle werden mit Hilfe der höheren Mathematik in Formeln gefasst und beschrieben. In diesem Text wird auf mathematische Zusammenhänge nicht im Detail eingegangen. Folgende Aspekte des Modellbegriffs in der KI werden für das Verständnis benötigt: | Im Zusammenhang mit KI und maschinellem Lernen bezieht sich der Modellbegriff auf die zentralen Bausteine eines Systems, das Daten analysiert, Muster erkennt und Vorhersagen trifft. Solche Modelle werden mit Hilfe der höheren Mathematik in Formeln gefasst und beschrieben. In diesem Text wird auf mathematische Zusammenhänge nicht im Detail eingegangen. Folgende Aspekte des Modellbegriffs in der KI werden für das Verständnis benötigt: | ||

| Zeile 418: | Zeile 419: | ||

Repräsentation von Wissen: In der KI können Modelle verwendet werden, um Wissen oder Informationen zu repräsentieren. Zum Beispiel können Modelle in der natürlichen Sprachverarbeitung (NLP) dazu verwendet werden, Wörter, Sätze oder Dokumente als Vektoren zu repräsentieren, um semantische Beziehungen zwischen Wörtern zu erfassen. | Repräsentation von Wissen: In der KI können Modelle verwendet werden, um Wissen oder Informationen zu repräsentieren. Zum Beispiel können Modelle in der natürlichen Sprachverarbeitung (NLP) dazu verwendet werden, Wörter, Sätze oder Dokumente als Vektoren zu repräsentieren, um semantische Beziehungen zwischen Wörtern zu erfassen. | ||

Abstraktion: Modelle abstrahieren komplexe Daten und Muster in einer Weise, die für maschinelle Algorithmen zugänglich | Abstraktion: Modelle abstrahieren komplexe Daten und Muster in einer Weise, die für maschinelle Algorithmen zugänglich sind. Das kann dazu beitragen, die Dimensionalität von Daten zu reduzieren und die Analyse zu erleichtern. | ||

Vorhersage und Entscheidungsfindung: KI-Modelle werden verwendet, um Vorhersagen über zukünftige Ereignisse oder Entscheidungen zu treffen. Zum Beispiel können neuronale Netzwerke in der Bildverarbeitung dazu verwendet werden, Bilder zu klassifizieren oder zu erkennen. | Vorhersage und Entscheidungsfindung: KI-Modelle werden verwendet, um Vorhersagen über zukünftige Ereignisse oder Entscheidungen zu treffen. Zum Beispiel können neuronale Netzwerke in der Bildverarbeitung dazu verwendet werden, Bilder zu klassifizieren oder zu erkennen. | ||

Lernen: | Lernen: Im maschinellen Lernen und tiefem Lernen werden Modelle trainiert, indem sie auf Trainingsdaten präsentiert werden. Sie passen ihre internen Parameter an, um Muster in den Daten zu erkennen und darauf zu reagieren. Das Ergebnis ist ein "trainiertes Modell", das zur Vorhersage oder Klassifikation von neuen, nicht gesehenen Daten verwendet werden kann. | ||

Generalisierung: Ein gutes KI-Modell sollte in der Lage sein, auf unbekannte Daten zu generalisieren, d.h. es sollte nicht nur die Trainingsdaten auswendig lernen, sondern auch auf neue Daten gut reagieren. | Generalisierung: Ein gutes KI-Modell sollte in der Lage sein, auf unbekannte Daten zu generalisieren, d.h. es sollte nicht nur die Trainingsdaten auswendig lernen, sondern auch auf neue Daten gut reagieren. | ||

| Zeile 443: | Zeile 444: | ||

Eingaben sind die Daten, die dem Neuron zugeführt werden. Die Linien, die von den Eingaben zu jedem Neuron führen, repräsentieren die Gewichtungen, die auf die Eingaben angewendet werden. Im Neuron selbst findet die Berechnung statt, indem die gewichteten Eingaben zusammengefasst und dann eine Aktivierungsfunktion angewendet wird. Die Ausgabe des Neurons wird dann an andere Neuronen oder Schichten im neuronalen Netzwerk weitergegeben. | Eingaben sind die Daten, die dem Neuron zugeführt werden. Die Linien, die von den Eingaben zu jedem Neuron führen, repräsentieren die Gewichtungen, die auf die Eingaben angewendet werden. Im Neuron selbst findet die Berechnung statt, indem die gewichteten Eingaben zusammengefasst und dann eine Aktivierungsfunktion angewendet wird. Die Ausgabe des Neurons wird dann an andere Neuronen oder Schichten im neuronalen Netzwerk weitergegeben. | ||

Die | Die grundlegende Funktion eines Neurons in einem neuronalen Netzwerk ist recht einfach. Jeder Eingang in ein Neuron wird gewichtet. Diese Gewichte sind das „Wissen“ eines Neurons, das im Training „angelernt“ wurde. In einem realen neuronalen Netzwerk gibt es viele Neuronen, die miteinander verbunden sind, um komplexe Berechnungen durchzuführen und Muster in den Daten zu erkennen. Eine solche Darstellung wird umso komplexer, je größer und tiefer das neuronale Netzwerk ist. | ||

Damit kann ein Neuron in einem neuronalen Netzwerk mathematisch durch eine Formel oder eine Gleichung dargestellt werden. Ein Neuron erhält je nach seiner Größe n Eingaben (x1, x2, ..., xn), multipliziert diese Eingaben mit Gewichtungen (w1, w2, ..., wn), summiert die gewichteten Eingaben und wendet dann eine Aktivierungsfunktion auf die resultierende Summe an. Die Ausgabe des Neurons (y) wird durch die Formel beschrieben: | Damit kann ein Neuron in einem neuronalen Netzwerk mathematisch durch eine Formel oder eine Gleichung dargestellt werden. Ein Neuron erhält je nach seiner Größe n Eingaben (x1, x2, ..., xn), multipliziert diese Eingaben mit Gewichtungen (w1, w2, ..., wn), summiert die gewichteten Eingaben und wendet dann eine Aktivierungsfunktion auf die resultierende Summe an. Die Ausgabe des Neurons (y) wird durch die Formel beschrieben: | ||

| Zeile 508: | Zeile 509: | ||

Gewichtungen zwischen erster und zweiter verdeckter Schicht: | Gewichtungen zwischen erster und zweiter verdeckter Schicht: | ||

Für | Für jedes Neuron in der ersten verdeckten Schicht gibt es 64 Gewichtungen (eine pro Neuron in der zweiten verdeckten Schicht). | ||

Das ergibt: 32 Neuronen ∙ 64 Neuronen = 2048 Gewichtungen. | Das ergibt: 32 Neuronen ∙ 64 Neuronen = 2048 Gewichtungen. | ||

| Zeile 514: | Zeile 515: | ||

Gewichtungen zwischen der zweiten verdeckten Schicht und der Ausgabeschicht: | Gewichtungen zwischen der zweiten verdeckten Schicht und der Ausgabeschicht: | ||

Für | Für jedes Neuron in der zweiten verdeckten Schicht gibt es 2 Gewichtungen (eine pro Neuron in der Ausgabeschicht). | ||

Das ergibt: 64 Neuronen ∙ 2 Ausgabeneuronen = 128 Gewichtungen. | Das ergibt: 64 Neuronen ∙ 2 Ausgabeneuronen = 128 Gewichtungen. | ||

| Zeile 580: | Zeile 581: | ||

Diese Schlüsselkonzepte bilden das Fundament für das Verständnis des maschinellen Lernens. Schlüsselkonzepte sind essenziell, um die Funktionsweise von Supervised und Unsupervised Learning, den Umgang mit Daten und die Herausforderungen bei der Modellierung zu verstehen. Das Wissen über Überanpassung und Unteranpassung ist entscheidend, um Modelle so zu gestalten, dass Modelle neue Daten verallgemeinern können. | Diese Schlüsselkonzepte bilden das Fundament für das Verständnis des maschinellen Lernens. Schlüsselkonzepte sind essenziell, um die Funktionsweise von Supervised und Unsupervised Learning, den Umgang mit Daten und die Herausforderungen bei der Modellierung zu verstehen. Das Wissen über Überanpassung und Unteranpassung ist entscheidend, um Modelle so zu gestalten, dass Modelle neue Daten verallgemeinern können. | ||

Grundlegendes zum maschinellen Lernen | |||

Techniken im maschinellen Lernen | |||

Maschinelles Lernen (ML) umfasst verschiedene Techniken, um aus Daten Eigenschaften zu extrahieren und Klassifikationen durchzuführen. Grundlegende Arten vom maschinellen Lernen, die für die Extraktion von Merkmalen und Klassifikationen verwendet werden sind überwachtes Lernen, unüberwachtes Lernen, halbüberwachtes Lernen, verstärkendes Lernen, Transferlernen und die Reduktion der Dimensionalität. | |||

Beim überwachten Lernen (Supervised Learning) werden Modelle auf Grundlage von gelabelten Trainingsdaten trainiert, wobei jedem Datenpunkt eine Zielklasse zugeordnet ist. Die Modelle lernen, Muster in den Merkmalen zu erkennen, um Vorhersagen für neue, nicht gelabelte Daten zu treffen. Dabei wird das Modell darauf trainiert, Datenpunkte in vordefinierte Klassen oder Kategorien zu klassifizieren. | |||

Beim unüberwachten Lernen (Unsupervised Learning) werden Modelle auf nicht gelabelt Daten trainiert. Der Fokus liegt auf der Entdeckung von Mustern oder Strukturen in den Daten. Dazu werden Datenpunkte basierend auf gemeinsamen Merkmalen oder Ähnlichkeiten gruppiert, ohne dass vorher festgelegt ist, welche Klassen es gibt. Gesprochen wird in diesem Zusammenhang mit Clustering. | |||

Beim halbüberwachten Lernen (Semi-Supervised Learning) liegt eine Kombination aus überwachtem und unüberwachtem Lernen vor, bei dem das Modell sowohl gelabelte als auch nicht gelabelte Daten während des Trainings verwendet. | |||

Beim verstärkenden Lernen (Reinforcement Learning) lernt ein Modell durch Interaktion mit seiner Umgebung. Das Modell trifft Entscheidungen und erhält Feedback in Form von Belohnungen oder Bestrafungen. Es zielt darauf ab, eine Strategie zu erlernen, um maximale Belohnungen zu erzielen. | |||

Beim Transferlernen (Transfer Learning) werden Modelle auf einer Aufgabe trainiert. Die im Training gefundenen Parameter werden dann auf andere Modelle mit ähnlichen Aufgaben übertragen. Dies ermöglicht es, Wissen aus einer Domäne auf eine andere zu übertragen und den Trainingsaufwand zu reduzieren. | |||

Bei der Reduktion von Dimensionalitäten kommen Techniken wie Principal Component Analysis (PCA) oder t-Distributed Stochastic Neighbor Embedding (t-SNE) zum Einsatz, um die Anzahl der Merkmale zu reduzieren und wichtige Informationen zu bewahren. | |||

Diese Arten vom maschinellen Lernen können miteinander kombiniert oder angepasst werden, um den Anforderungen spezifischer Aufgaben gerecht zu werden. Es gibt viele Modelle und Algorithmen für die Extraktion von Merkmalen und Klassifikationen. Die Wahl der Art hängt von der Natur der Daten und den Zielen der Anwendung ab. | |||

Welche dieser Techniken werden mit neuronalen Netzen ausgeführt? | |||

Neuronale Netze werden in verschiedenen Techniken des maschinellen Lernens eingesetzt. Gängige Techniken beim überwachten Lernen mit Neuronalen Netzen sind Klassifikation und Regression. Sie werden für die Klassifikation von Datenpunkten in verschiedene Kategorien oder die Vorhersage von kontinuierlichen Werten eingesetzt. | |||

Beim unüberwachten Lernen mit neuronalen Netzen werden Autoencoder genutzt. Dabei wird ein neuronales Netzwerk dazu verwendet, um eine kompakte Darstellung der Daten zu lernen, was oft für die Dimensionsreduktion oder die Rekonstruktion von Daten genutzt wird. | |||

Beim verstärkenden Lernen mit neuronalen Netzen gibt es das Q-Learning und die Policy Gradient Methods. Neuronale Netze werden als Funktionsschätzer eingesetzt, um Richtlinien oder Q-Werte zu approximieren, die im verstärkenden Lernen verwendet werden. | |||

Beim Transferlernen mit neuronalen Netzen werden vortrainierte Modelle genutzt. Neuronale Netze werden auf großen Datensätzen oder Aufgaben vortrainiert und dann für spezifischere Aufgaben oder Domänen feinabgestimmt. | |||

Bei der Reduktion von Dimensionalitäten werden neuronale Netze für Autoencoder und Varianten eingesetzt. Neuronale Netze können für die Extraktion von Merkmalen und die Reduzierung der Dimensionalität von Daten eingesetzt werden. | |||

Neuronale Netze, insbesondere tiefe neuronale Netze (Deep Learning), haben in den letzten Jahren aufgrund ihrer Fähigkeit, komplexe Muster zu lernen, große Erfolge erzielt. Convolutional Neural Networks (CNNs) sind beispielsweise speziell für die Verarbeitung von Bildern optimiert, während Recurrent Neural Networks (RNNs) für die Verarbeitung sequenzieller Daten wie Texte oder Zeitreihen geeignet sind. | |||

Es steht fest, dass neuronale Netze nicht die einzige Methode im maschinellen Lernen sind. Neuronale Netze sind aber aufgrund ihrer Flexibilität und Leistungsfähigkeit in vielen Anwendungen weit verbreitet. | |||

Allerdings ist die Notwendigkeit der Verwendung von neuronalen Netzen nicht unbedingt Bedingung für das Lösen der genannten Aufgabenstellungen. Es gibt verschiedene Ansätze und Algorithmen, die für spezifische Aufgaben und Anwendungsfälle geeignet sind, und neuronale Netze sind nur eine von vielen Techniken. | |||

Einschub: Nicht-neuronale Ansätze für das Lernen | |||

Die Nutzung Neuronaler Netzen ist also nicht unbedingt eine Bedingung für das Lösen der oben genannten Aufgabenstellungen. Einige der genannten Aufgaben können auch mit einfacheren Algorithmen oder Methoden effektiv gelöst werden. | |||

Nicht-neuronale Ansätze für Überwachtes Lernen sind Entscheidungsbäume, Support Vector Machines (SVM), k-Nearest Neighbors (k-NN), lineare Regression usw. Diese können in vielen Fällen gute Ergebnisse erzielen, ohne auf neuronale Netze zurückzugreifen. | |||

Nicht-neuronale Ansätze beim Unüberwachten Lernen sind k-Means-Clustering, Hierarchisches Clustering, Gaussian Mixture Models (GMM) als Beispiele für nicht-neuronale Methoden zur Gruppierung von Datenpunkten. | |||

Nicht-neuronale Ansätze beim Verstärkenden Lernen sind Q-Learning, Monte-Carlo-Methoden, und Policy Iteration. Das sind klassische Verstärkungslernmethoden, die nicht auf neuronalen Netzen basieren. | |||

Auch beim Transferlernen gibt es nicht-neuronale Ansätze. Transferlernen kann auch z.B. durch Anpassung von Modellen mittels Feature-Extraktion oder dem Teilen von Gewichten zwischen Modellen bewerkstelligt werden. | |||

Nicht-neuronale Ansätze zur Reduktion von Dimensionalitäten sind PCA (Principal Component Analysis), t-SNE (t-Distributed Stochastic Neighbor Embedding), und LLE (Locally Linear Embedding) als Beispiele für nicht-neuronale Techniken zur Reduzierung der Dimensionalität. | |||

Ob neuronale Netze verwendet werden sollten, hängt von verschiedenen Faktoren ab, einschließlich der Komplexität der Daten, der Menge der verfügbaren Daten und der spezifischen Anforderungen der Aufgabe. In vielen Fällen bieten neuronale Netze Vorteile bei der Bewältigung komplexer Muster, aber für einfachere Probleme können auch nicht-neuronale Methoden effektiv sein. | |||

„Lernen“ in nicht-neuronalen Ansätzen | |||

In nicht-neuronalen Ansätzen im maschinellen Lernen erfolgt das „Lernen“ auf unterschiedliche Weise im Vergleich zu neuronalen Netzen. In diesen Kontexten bezieht sich der Begriff „Lernen“ darauf, dass ein Modell auf Grundlage von Daten oder Erfahrungen angepasst wird, um bessere Leistungen bei einer bestimmten Aufgabe zu erzielen. | |||

Im Wesentlichen geht es also darum, die Leistung von Modellen zu verbessern. Genutzt werden dazu Techniken wie Entscheidungsbäume, Support Vector Machines (SVM), k-Nearest Neighbors (k-NN), Lineare Regression und k-Means-Clustering. | |||

In Entscheidungsbäumen wird das Modell auf der Grundlage von Trainingsdaten erstellt, um Entscheidungsregeln zu lernen. Der Baum wird durch das Aufteilen der Daten in verschiedene Gruppen aufgebaut, wobei jeder Zweig eine Entscheidungsregel repräsentiert. | |||

SVM lernen, eine Entscheidungsgrenze zwischen verschiedenen Klassen zu ziehen, indem sie den Abstand zwischen den Datenpunkten maximieren. Dies geschieht durch Anpassung von Gewichten und Bias. | |||

k-NN basiert auf der Annahme, dass ähnliche Datenpunkte ähnliche Zielwerte haben. Es „lernt“, indem es den Zielwert eines Datenpunkts basierend auf den Werten seiner k nächsten Nachbarn vorhersagt. | |||

Bei der linearen Regression wird eine lineare Beziehung zwischen Eingabevariablen und der Zielvariable modelliert. Das Modell „lernt“, die besten Parameter (Gewichtungen) zu finden, um die Daten gut zu modellieren. | |||

K-Means-Clustering gruppiert Datenpunkte in k Cluster, wobei das Modell „lernt“, die Clusterzentren so zu platzieren, dass die Summe der quadratischen Abstände der Datenpunkte zu ihren jeweiligen Zentren minimiert wird. | |||

In nicht-neuronalen Ansätzen geht es also um die Anpassung von Parametern oder das Finden von Regeln, um aus den gegebenen Daten Muster zu erkennen oder Aufgaben zu erfüllen. Der Begriff „Lernen“ bezieht sich also darauf, dass das Modell aufgrund von Erfahrungen oder Daten angepasst wird, auch wenn dieser Anpassungsprozess nicht unbedingt mit den hochgradig gewichteten Verbindungen und Aktivierungsfunktionen von neuronalen Netzen vergleichbar ist. | |||

Lernen in neuronalen Netzen | |||

Steuergröße und Art des Lernens in neuronalen Netzen sind die Hyperparameter. Dazu stellt sich die Frage, welche Hyperparameter es gibt und wie diese im Zusammenhang mit der Lerntechnik stehen. Hyperparameter beeinflussen den Lernprozess und die Leistung des Modells. Die wichtigsten Hyperparameter sind die Lernrate, die Batch-Größe, die Anzahl der Epochen, die Anzahl der versteckten Schichten und Neuronen pro Schicht, die Aktivierungsfunktionen, die Dropout-Rate, Techniken der Regularisierung, Optimierungsalgorithmen, die Initialisierung der Gewichtungen und der Lernplan. | |||

Die Lernrate (Learning Rate) steuert die Größe der Schritte, die während des Gradienten-Abstiegs unternommen werden, um die Gewichtungen zu aktualisieren. Ihre Beziehung mit der Lerntechnik gilt, dass eine zu hohe Lernrate zu Divergenz führen kann, während eine zu niedrige Lernrate zu langsamem Lernen oder dem Steckenbleiben in lokalen Minima führen kann. | |||

Die Batch-Größe (Batch Size) gibt die Anzahl der Datenpunkte an, die in jedem Schritt des Trainingsprozesses verarbeitet werden. Bezogen auf die Lerntechnik gilt, dass kleine Batch-Größen zu stochastischem Verhalten und zu einer verbesserten Verallgemeinerung führen können während große Batch-Größen den Trainingsprozess beschleunigen. | |||

Die Anzahl der Epochen (Number of Epochs) gibt an, wie oft das gesamte Trainingsdatenset durch das Netzwerk geht. Zu viele Epochen können zur Überanpassung führen, während zu wenige möglicherweise nicht ausreichen, um das Netzwerk zu trainieren. | |||

Die Anzahl der versteckten Schichten und Neuronen pro Schicht bestimmt die Architektur des neuronalen Netzes. Die Netzwerktopologie beeinflusst die Fähigkeit des Netzwerks, komplexe Muster zu lernen. Tiefe Netzwerke können komplexe Hierarchien von Merkmalen erfassen. | |||

Aktivierungsfunktionen definieren die Form und Nichtlinearität der Ausgabe eines Neurons. Verschiedene Aktivierungsfunktionen beeinflussen die Fähigkeit des Modells, komplexe nichtlineare Muster zu lernen. | |||

Die Dropout-Rate kontrolliert den Prozentsatz der deaktivierten Neuronen während des Trainings. Dropout ist eine Technik der Regularisierung, die Überanpassung verhindern kann, indem sie zufällig Neuronen deaktiviert. | |||

Die Regularisierung (L1 oder L2) fügt zum Verlust eine „Strafe“ für große Gewichtungen hinzu. In Bezug auf die Lerntechnik bedeutet das, dass durch die Regularisierung Überanpassung verhindert werden kann, indem sie die Gewichte reduziert oder die so genannte „Sparsity“ fördern. Die Förderung von Sparsity kann dazu dienen unnötig komplexe Modelle zu vermeiden, insbesondere wenn nicht alle Merkmale (repräsentiert durch die Gewichtungen) gleichermaßen wichtig sind. In Anwendungen, bei denen viele Merkmale vorhanden sind und nur einige davon tatsächlich zur Lösung der Aufgabe beitragen, kann L1-Regularisierung dazu beitragen, das Modell zu vereinfachen, indem es einige Gewichtungen auf null setzt. | |||

Optimierungsalgorithmen bestimmen, wie die Gewichtungen des Netzwerks aktualisiert werden. Optimierungsalgorithmen wie Adam, RMSProp oder SGD beeinflussen die Konvergenzgeschwindigkeit und Stabilität des Trainingsprozesses. | |||

Initialisierung der Gewichtungen definieren, wie die Gewichtungen des Netzwerks zu Beginn initialisiert werden. Eine gute Gewichtsinitialisierung kann dazu beitragen, dass das Netzwerk schneller konvergiert und stabiler trainiert wird. | |||

Der Lernplan (Learning Schedule) bestimmt, wie die Lernrate im Laufe des Trainingsprozesses angepasst wird. Ein adaptiver Lernplan kann dazu beitragen, die Lernrate während des Trainings zu optimieren. | |||

Die richtige Auswahl und Anpassung dieser Hyperparameter sind entscheidend, um ein neuronales Netzwerk effektiv zu trainieren und gute Leistung zu erzielen. Dies erfordert oft Experimente und Hyperparameter-Optimierungstechniken, um die besten Konfigurationen zu finden. | |||

Anpassungen | |||

Die Anpassung von Modellen im maschinellen Lernen erfolgt durch die Veränderung der Werte für die Hyperparameter. Hyperparameter sind jene externen Konfigurationen, die vor dem Trainingsprozess festgelegt werden und die den Lernalgorithmus und das Modell beeinflussen. Die Anpassung dieser Hyperparameter dient, um die Leistung des Modells zu optimieren und sicherzustellen, dass es gut auf neue, nicht gesehene Daten generalisiert. | |||

Die Anpassung der Hyperparameter kann manuell durchgeführt werden, indem verschiedene Werte ausprobiert und die Auswirkungen auf die Leistung des Modells beobachtet werden. Es gibt jedoch auch automatisierte Techniken wie Grid Search, Random Search oder Bayesian Optimization, die verwendet werden können, um die besten Hyperparameter-Werte zu finden, ohne dass manuelle Experimente erforderlich sind. | |||

Ansätze für die Anpassung sind die Automatisierte Anpassung (Automatische Hyperparameteroptimierung), das Automatisiertes Modelltraining, die externe Anpassung durch Experten. die Feinabstimmung und Transferlernen. | |||

Die Entscheidung, ob Anpassungen automatisiert oder extern durchgeführt werden, hängt von verschiedenen Faktoren ab, darunter die Komplexität der Aufgabe, die Menge der verfügbaren Daten, die Erfahrung der Anwender und die spezifischen Anforderungen der Anwendung. In vielen Fällen werden moderne ML-Bibliotheken und Frameworks auch mit automatisierten Funktionen für die Modellanpassung und Hyperparameteroptimierung geliefert, um den Prozess zu erleichtern. | |||

Hyperparameter in nicht neuronalen Ansätzen | |||

Die Auswahl und Anpassung von Hyperparametern ist entscheidend für den Erfolg von nicht-neuronalen Ansätzen im maschinellen Lernen. Hyperparameter, die bei verschiedenen nicht-neuronalen sind Entscheidungsbäume, der C-Parameter, die Anzahl der Nachbarn, Regularisierungs-Parameter, die Anzahl der Cluster und die Initialisierungsmethode. | |||

Eine wichtige Rolle spielen bei Entscheidungsbäumen die Tiefe des Baumes (max_depth), die die die maximale Tiefe des Entscheidungsbaums kontrolliert, die minimale Anzahl der Datenpunkte in einem Blatt (min_samples_leaf), die festlegt, wie viele Datenpunkte mindestens in einem Blatt des Baums sein müssen. | |||

Bei den Support Vector Machines (SVM) beeinflusst der C-Parameter die Handelsabstimmung zwischen einer glatten Entscheidungsgrenze und der korrekten Klassifizierung der Trainingsdaten und der Kernel-Typ (z. B. linear, polynomial, radial basis function - RBF) die Art der Entscheidungsgrenze. | |||

Bei k-Nearest Neighbors (k-NN) gibt die Anzahl der Nachbarn (n_neighbors) an, wie viele Nachbarn für die Klassifikation oder Regression herangezogen werden sollen. Die Distanzmetrik (z. B. Euclidean, Manhattan) definiert die Art der Distanzberechnung zwischen Datenpunkten. | |||

Bei der Linearen Regression gibt es einen Regularisierungs-Parameter (alpha), der die Stärke der Regularisierung kontrolliert, um Überanpassung zu verhindern, während die Art der Regularisierung (L1 oder L2) die Art der Strafe für große Gewichtungen bestimmt. | |||

Beim k-Means-Clustering geht es um die Anzahl der Cluster und die Initialisierungsmethode, die die Auswahl der anfänglichen Clusterzentren bestimmt. | |||

Zu beachten ist, dass die Bedeutung und die Auswirkungen der Hyperparameter von Modell zu Modell variieren können. Die Wahl der richtigen Hyperparameter-Werte hat in der Regel einen erheblichen Einfluss auf die Leistung des Modells. Automatisierte Techniken wie Grid Search, Random Search oder Bayesian Optimization werden oft dazu verwendet, um die besten Hyperparameter-Werte zu finden, ohne dass manuelle Experimente erforderlich sind. | |||

Hyperparameter und Lerntechnik | |||

Die Hyperparameter bestimmen nicht die Lerntechnik selbst, sondern beeinflussen die Art und Weise, wie das Lernen in einem bestimmten maschinellen Lernalgorithmus oder Modell durchgeführt wird. Die Hyperparameter sind Einstellungen, die vor dem eigentlichen Lernprozess festgelegt werden und die den Trainingsprozess beeinflussen. | |||

Die Lerntechnik oder der Lernalgorithmus selbst ist durch die Architektur und die Prinzipien des verwendeten Modells bestimmt. In einem linearen Regressionsmodell ist die Lerntechnik die Anpassung einer linearen Funktion an die Trainingsdaten, um eine Vorhersage zu treffen. In einem Entscheidungsbaum besteht die Lerntechnik darin, Entscheidungsregeln zu erstellen, um die Trainingsdaten zu partitionieren. In einem k-NN-Modell erfolgt das Lernen durch das Speichern von Trainingsdaten, und Vorhersagen basieren auf den Nachbarn des Testdatenpunkts. | |||

Die Hyperparameter hingegen sind zusätzliche Einstellungen, die die Art und Weise beeinflussen, wie diese Modelle während des Trainings lernen. Die Lernrate in neuronalen Netzen beeinflusst, wie stark die Gewichtungen des Netzwerks bei jedem Update angepasst werden. Die Anzahl der Cluster in k-Means bestimmt, wie viele Cluster erstellt werden. Die Tiefe des Entscheidungsbaums beeinflusst, wie tief der Baum wachsen darf. | |||

Die Auswahl und Anpassung der Hyperparameter sind wichtige Schritte im Modelltrainingsprozess, da sie die Leistung, Konvergenzgeschwindigkeit und die Fähigkeit zur Verallgemeinerung des Modells beeinflussen können. Es ist üblich, dass diese Hyperparameter durch verschiedene Techniken wie manuelle Anpassung, Grid Search oder automatisierte Hyperparameter-Optimierung gefunden werden. | |||

Bestimmen der Lerntechnik | |||

Die Lerntechnik wird durch den spezifischen Algorithmus oder das Modell bestimmt, das für die gegebene Aufgabe verwendet wird. Jeder maschinelle Lernalgorithmus hat eine eigene Methode oder Technik, wie es aus den Trainingsdaten lernt und wie es die Aufgaben der Vorhersage oder Klassifikation durchführt. | |||

Bei der linearen Regression ist die Lerntechnik, dem Modell eine lineare Beziehung zwischen den Eingabevariablen und der Zielvariablen anzulernen, um Vorhersagen zu treffen. | |||

Beim Entscheidungsbaum lernt das Modell, Entscheidungsregeln auf Grundlage der Trainingsdaten zu erstellen, um die Zielvariablen zu klassifizieren oder vorherzusagen. Beim k-Nearest Neighbors (k-NN) speichert das Modell die Trainingsdaten und klassifiziert neue Datenpunkte anhand der Mehrheit der k nächsten Nachbarn im Merkmalsraum. Bei Support Vector Machine (SVM) erstellt das Modell eine Entscheidungsgrenze zwischen den Klassen, indem es versucht, den maximalen Abstand zwischen den Datenpunkten und der Grenze zu maximieren. Bei einem neuronalen Netzwerk besteht das Modell aus Neuronen und Schichten, die Gewichtungen anpassen, um komplexe Muster in den Trainingsdaten zu erkennen und Vorhersagen zu treffen. Bei k-Means-Clustering gruppiert das Modell Datenpunkte in k Cluster, indem es die Daten in Gruppen aufteilt, um die Ähnlichkeit zwischen den Datenpunkten in einem Cluster zu maximieren. | |||

Die Auswahl der Lerntechnik hängt von der Art der Aufgabe (z. B. Regression, Klassifikation, Clustering) und den Eigenschaften der Daten ab. Jede Lerntechnik hat ihre eigenen Stärken und Schwächen und eignet sich besser für bestimmte Arten von Problemen. Bei der Auswahl der Lerntechnik ist es wichtig, die Charakteristiken der Daten und die Anforderungen der spezifischen Aufgabe zu berücksichtigen. | |||

Daraus ergibt sich die Frage, wie die Lerntechnik zu konkreten Beispielen festgelegt werden könnte. Die Auswahl der geeigneten Lerntechnik für eine bestimmte Aufgabe erfordert eine sorgfältige Analyse der Charakteristiken der Daten und der spezifischen Anforderungen der Aufgabe. | |||

Schritte und Überlegungen, die das Festlegen auf eine konkrete Lerntechnik erfordern, sind | |||

ein Verständnis der Aufgabe. Zu klären ist zuerst die Art der Aufgabe, die gelöst werden soll. Gefragt wird dabei, ob es sich um eine Klassifikations-, Regressions- oder Clustering-Aufgabe handelt. Sollen Muster in den Daten erkannt werden, Vorhersagen getroffen werden oder Gruppen identifiziert werden? | |||

die Charakteristiken der Daten. Weiters ist eine Analyse der Struktur und dem Typ der Daten notwendig. Handelt es sich um strukturierte Daten (Tabellenformat) oder unstrukturierte Daten (Texte, Bilder, Audio)? Wie viele Merkmale sind vorhanden und wie sind die Daten verteilt? | |||

eine bestimmte Datengröße. Zu fragen ist, welche Menge der Daten zur Verfügung steht. Einige Modelle, insbesondere tiefe neuronale Netze, benötigen oft große Datensätze, um effektiv zu lernen. | |||

die Interpretierbarkeit. Zu überlegen ist, wie wichtig die Interpretierbarkeit des Modells ist. Ein einfacheres Modell wie lineare Regression oder Entscheidungsbaum kann leichter interpretiert werden als komplexe Modelle wie neuronale Netze. | |||

Anforderungen an die Vorhersagegenauigkeit. Grundsätzlich muss geklärt sein, welche Anforderungen an die Genauigkeit der Vorhersagen gestellt sind. Manchmal ist eine einfache Lerntechnik ausreichend, während in anderen Fällen komplexere Modelle erforderlich sind, um komplexe Muster zu erfassen. | |||

Kenntnis über vorhandene Ressourcen. Entscheidend sind auch die verfügbaren Ressourcen, einschließlich Rechenleistung, Zeit und Fachkenntnisse. Einige Modelle erfordern mehr Rechenleistung und Ressourcen für das Training und die Anpassung. | |||

Experimente und Vergleiche. Hilfreich ist auch zu experimentieren. Mit Hilfe solcher Experimente lassen sich verschiedene Modelle gut vergleichen. Durch das Training mehrerer Modelle mit verschiedenen Lerntechniken und Hyperparametern kann deren Leistung auf einem Validierungsdatensatz bestimmt und verglichen werden. | |||

Konkret eignen sich für die Klassifikation von Bildern die Verwendung von Convolutional Neural Networks (CNNs). Sollen z.B. Vorhersage von Hauspreisen basierend auf Merkmalen gemacht werden, ist die Verwendung von linearer Regression oder Entscheidungsbaumregression eine gute Wahl, da diese Modelle gut für Regressionsaufgaben geeignet sind. Für die Kundensegmentierung in einem E-Commerce-Unternehmen bietet sich die Anwendung von k-Means-Clustering an, um Kunden in verschiedene Segmente zu gruppieren. Bei der Erkennung von Spam-E-Mails ist die Verwendung von Support Vector Machines (SVM) oder Entscheidungsbäumen für die Klassifikation von E-Mails gut geeignet. | |||

Es gibt keine universelle Lösung, und die Auswahl der Lerntechnik sollte auf den spezifischen Kontext und die Anforderungen der Aufgabe abgestimmt sein. Experimentieren mit verschiedenen Ansätzen und das Sammeln Erfahrungen ist der Weg, um die beste Lerntechnik für konkrete Beispiele zu finden. | |||

Lern-Verfahren | |||

Es gibt verschiedene Lernverfahren im Bereich des maschinellen Lernens, die je nach Art der Aufgabe und des zugrunde liegenden Modells angewendet werden können. | |||

Beim überwachten Lernen (Supervised Learning) wird das Modell mit einem gelabelten Trainingsdatensatz trainiert, der Eingabe- und Zielvariablen enthält. Das Ziel besteht darin, eine Zuordnung oder Vorhersage für neue, nicht gesehene Datenpunkte zu erstellen. Beispiele dafür sind Klassifikation und Regression. | |||

Beim unüberwachten Lernen (Unsupervised Learning) wird das Modell mit einem nicht gelabelten Trainingsdatensatz trainiert. Das Ziel besteht darin, Muster, Strukturen oder Gruppierungen in den Daten zu erkennen. Beispiele dafür sind Clustering und die Reduktion der Dimensionalität. | |||

Beim halbüberwachten Lernen (Semi-Supervised Learning) wird eine Kombination aus gelabelten und nicht gelabelten Daten für das Training herangezogen. Das wird häufig dann verwendet, wenn es teuer oder zeitaufwändig ist, große Mengen von gelabelten Daten zu sammeln. | |||

Beim Verstärkenden Lernen (Reinforcement Learning) trifft das Modell, das hier Agent genannt wird, in einer bestimmten Umgebung Entscheidungen und lernt durch positive oder negative Rückmeldungen (realisiert durch „Belohnungen“ oder „Bestrafungen“). Das Ziel besteht darin, eine Strategie zu entwickeln, um die Gesamtbelohnung zu maximieren. Beispiele dafür sind die Wahl von Spielstrategien und Anwendungen in der Robotik. | |||

Beim Transfer-Lernen (Transfer Learning) wird das Modell, das auf einer bestimmten Aufgabe trainiert wurde, auf eine ähnliche Aufgabe angewendet. Dies ist besonders nützlich, wenn nicht genügend Trainingsdaten für die neue Aufgabe verfügbar sind. Beispiel dafür sind vortrainierte neuronale Netzwerke für Bildklassifikation, um diese auf eine ähnliche Aufgabe anzupassen. | |||

Beim Online-Lernen (Online Learning oder Inkrementelles Lernen) wird das Modell kontinuierlich mit neuen Daten aktualisiert, anstatt einmalig mit einem festen Datensatz trainiert zu werden. Beispiel dafür ist die Anpassung an sich ändernde Datenströme. | |||

Evolutionären Algorithmen (Evolutionary Algorithms) sind Algorithmen, die von der biologischen Evolution inspiriert sind, um eine Gruppe von Individuen (Modelle oder Lösungen) zu optimieren. Beispiele dafür sind genetische Algorithmen oder evolutionäre Strategien. | |||

Die genannten Lernverfahren können auch in verschiedenen Kombinationen und Kontexten angewendet werden, abhängig von den Anforderungen und der Natur der gegebenen Aufgabe. | |||

Lernprozess | |||

Der Lernprozess innerhalb der verschiedenen Verfahren im maschinellen Lernen kann je nach Lernparadigma unterschiedlich ablaufen. | |||

Allgemein wird beim überwachten Lernen das Modell mit einem gelabelten Trainingsdatensatz trainiert, der Eingabe- und Zielvariablen enthält. Der Algorithmus passt seine Gewichtungen an, um die Eingabevariablen mit den entsprechenden Zielvariablen zu verknüpfen. Der Lernprozess umfasst das Minimieren eines Fehlermaßes zwischen den vom Modell vorhergesagten Ausgaben und den tatsächlichen Zielwerten. | |||

Beim unüberwachtes Lernen wird hingegen ein nicht gelabelter Trainingsdatensatz genutzt mit dem Ziel, Muster oder Strukturen in den Daten zu erkennen. Der Lernprozess kann Clustering, die Reduktion der Dimensionalität oder andere Methoden zur Extraktion von Mustern und Strukturen umfassen. | |||

Halbüberwachtes Lernen nutzt eine Kombination aus gelabelten und nicht gelabelten Daten für das Training. Das Modell wird mit den gelabelten Daten trainiert, und die Informationen aus den gelabelten Daten werden verwendet, um eine bessere Repräsentation der nicht gelabelten Daten zu lernen. | |||

Beim verstärkenden Lernen trifft der Agent (das Modell) in einer bestimmten Umgebung Entscheidungen. Der Lernprozess umfasst das Erhalten von Rückmeldungen (Belohnungen oder Bestrafungen) basierend auf den getroffenen Entscheidungen, mit dem Ziel zur Entwicklung einer Strategie, um die Gesamtbelohnung im Laufe der Zeit zu maximieren. | |||

Bein Transfer-Lernen wird ein Modell, das auf einer bestimmten Aufgabe trainiert wurde, auf eine ähnliche Aufgabe angewendet. Hier umfasst der Lernprozess die Anpassung des vortrainierten Modells an die Anforderungen der neuen Aufgabe. | |||

Beim Online-Lernen wird das Modell kontinuierlich mit neuen Daten aktualisiert. Der Lernprozess kann inkrementell erfolgen, wobei das Modell schrittweise an neue Daten angepasst wird, um sich an sich ändernde Umgebungen anzupassen. | |||

Bei evolutionären Algorithmen wird eine Gruppe von so genannten Individuen (Modelle oder Lösungen) zufällig generiert. Solche Individuen, die gute Leistung auf der gegebenen Aufgabe zeigen, haben innerhalb dieses Algorithmus eine höhere Wahrscheinlichkeit, ihre „Gene“ in die nächste Generation weiterzugeben. Der Lernprozess umfasst die Evolution der Population über mehrere Generationen. | |||

Grundsätzlich gilt, dass der genaue Lernprozess stark von der spezifischen Aufgabenstellung, der verwendeten Methode und den Daten abhängt. In der Regel werden iterative Anpassungen an den Modellparametern vorgenommen, um die Leistung im Laufe der Zeit zu verbessern. | |||

In den meisten der genannten Lernprozesse werden die Gewichtungen (oder Parameter) eines Modells iterativ angepasst, um das Modell an die gegebenen Daten anzupassen und die gewünschte Aufgabe zu erfüllen. Die iterative Anpassung der Gewichtungen ist ein zentraler Bestandteil des Trainingsprozesses in maschinellen Lernverfahren. | |||

Die iterative Anpassung der Gewichtungen erfolgt normalerweise durch Optimierungsalgorithmen wie den Gradientenabstieg, genetische Algorithmen oder andere Methoden, die darauf abzielen, die Modellleistung schrittweise zu verbessern. Dieser iterative Lernprozess ermöglicht es dem Modell, sich an die Komplexität der Daten anzupassen und optimale oder zumindest bessere Leistungen auf der gegebenen Aufgabe zu erzielen. | |||

Optimierungsalgorithmen | |||

Optimierungsalgorithmen spielen hier die entscheidende Rolle, da sie die Gewichtungen oder Parameter eines Modells anpassen, um die Leistung eines Modells zu verbessern. | |||

Bei den Optimierungsalgorithmen ist zuerst der Gradientenabstieg (Gradient Descent) zu nennen. Gradientenabstieg ist der grundlegende Optimierungsalgorithmus im maschinellen Lernen. Der Algorithmus minimiert eine Kostenfunktion, indem er die Gewichtungen schrittweise in Richtung des negativen Gradienten der Kostenfunktion anpasst. Es gibt verschiedene Varianten, darunter den stochastischen Gradientenabstieg (SGD), den Mini-Batch-Gradientenabstieg und den Batch-Gradientenabstieg, je nachdem, wie viele Datenpunkte gleichzeitig für die Aktualisierung verwendet werden. Gradientenabstieg wird in vielen maschinellen Lernverfahren wie neuronalen Netzen, linearen Regressionen und Support Vector Machines verwendet. | |||

Ein weiterer Algorithmus ist Adam (Adaptive Moment Estimation). Adam ist ein adaptiver Optimierungsalgorithmus, der die Vorteile von SGD mit Momentum und RMSProp kombiniert. Adam passt die Lernrate für jedes Gewicht individuell an und berücksichtigt vorhergegangene Gradienteninformationen. Dieser Algorithmus ist robust gegenüber verschiedenen Lernraten und eignet sich gut für eine Vielzahl von Anwendungen. Adam wird häufig in der Optimierung von neuronalen Netzen verwendet. | |||

RMSProp (Root Mean Square Propagation) ist ein Optimierungsalgorithmus, der die Lernrate für jedes Gewicht basierend auf dem durchschnittlichen quadratischen Gradienten anpasst. Dies hilft, die Probleme von sich ändernden Lernraten in herkömmlichen Gradientenabstiegsalgorithmen zu überwinden. | |||

AdaGrad (Adaptive Gradient Algorithm) passt die Lernrate für jedes Gewicht basierend auf der kumulierten Summe der vorherigen Gradienten an. Es eignet sich gut für die so genannten „spärlichen“ Daten , da es die Lernrate für selten auftretende Merkmale erhöht. | |||

SGD mit Nesterov Momentum verbessert den traditionellen SGD durch die Verwendung von Momentum. Momentum ermöglicht eine schnellere Konvergenz, indem es die Gewichtungen basierend auf der Kombination von aktuellen und zukünftigen Gradienten aktualisiert. | |||

Adadelta ist eine Erweiterung von RMSProp, die das Problem der sinkenden Lernrate in RMSProp adressiert. Anstelle einer festen Lernrate verwendet Adadelta eine schätzungsweise Lernrate basierend auf vergangenen Gradienten. | |||

Diese Optimierungsalgorithmen variieren in ihrer Komplexität und Anwendungsbreite. Die Auswahl des geeigneten Algorithmus hängt oft von der spezifischen Aufgabe, den Daten und der Modellarchitektur ab. Es gibt ständige Forschungsbemühungen, um Optimierungsalgorithmen weiter zu verbessern und an verschiedene Herausforderungen im maschinellen Lernen anzupassen. | |||

Auswahl des Optimierungsalgorithmus | |||

Die Wahl des Lernprozesses und die Auswahl eines Optimierungsalgorithmus sind zwei verschiedene Aspekte im maschinellen Lernen, obwohl sie miteinander verbunden sind. Der Lernprozess bezieht sich auf das grundlegende Paradigma, das verwendet wird, um ein Modell auf eine bestimmte Aufgabe anzupassen, während der Optimierungsalgorithmus die Methode beschreibt, wie die Gewichtungen oder Parameter des Modells angepasst werden, um die Leistung zu verbessern. | |||

Die Wahl des Lernprozesses hängt von der Art der Aufgabe ab, die gelöst werden soll, und den verfügbaren Daten. Beispielsweise muss man sich entscheiden, ob überwachtes Lernen für eine Klassifikationsaufgabe oder unüberwachtes Lernen für eine Clustering-Aufgabe verwendet werden soll. | |||

Die Wahl des Optimierungsalgorithmus betrifft die Methode, mit der die Gewichtungen des Modells während des Trainingsprozesses aktualisiert werden. Die Auswahl eines Optimierungsalgorithmus hängt von verschiedenen Faktoren wie der Modellarchitektur, der Datenverteilung und den Trainingszielen ab. | |||

In vielen Fällen wird der Optimierungsalgorithmus im Rahmen des gewählten Lernprozesses spezifiziert. Zum Beispiel verwenden viele neuronale Netzwerke, die für Klassifikationsaufgaben im Rahmen des überwachten Lernens trainiert werden, den Adam- oder SGD-Optimierungsalgorithmus. Die Auswahl eines Optimierungsalgorithmus ist oft eine Entscheidung, die Anwender bzw. Entwickler basierend auf Erfahrung, Experimenten und Empfehlungen aus der Literatur. trifft | |||

Zusammenfassend kann man sagen, dass die Wahl des Lernprozesses und des Optimierungsalgorithmus voneinander abhängig ist, da der gewählte Lernprozess oft die Art der Aufgabe bestimmt und der Optimierungsalgorithmus im Rahmen dieses Lernprozesses ausgewählt wird, um das Modell zu trainieren. | |||

Es ist eine wichtige Entscheidung zu einer gegebenen Aufgabe aus der Wahlmöglichkeit für Optimierungsalgorithmen den – immer auf die konkrete Aufgabe bezogen - günstigsten auszuwählen. Die Frage wird also sein, wie man feststellen kann, welcher Algorithmus besser gewesen wäre, da die Wahl des Optimierungsalgorithmus einen erheblichen Einfluss auf die Konvergenzgeschwindigkeit und Leistung des Modells hat. Wenn ein weniger günstiger Algorithmus ausgewählt wird, kann dies zu langsamer Konvergenz, suboptimalen Modellgewichtungen oder sogar zu einem steckenbleibenden Trainingsprozess führen. In der Praxis kann dies zu längeren Trainingszeiten, schlechterer Modellleistung und höheren Ressourcenanforderungen führen. | |||

Um festzustellen, welcher Optimierungsalgorithmus besser gewesen wäre, können mehrere Ansätze verfolgt werden: Experimente und Vergleiche, Hyperparameter-Optimierung, Literaturrecherche und bewährte Verfahren, neuere Fortschritte und Beratung durch Fachleute. | |||

Zu Experimenten und Vergleichen ist anzumerken, dass man hier experimentiert, indem verschiedene Optimierungsalgorithmen auf dem gleichen Modell und Datensatz anwendet und die Ergebnisse verglichen werden. Dabei wird das Modell mit verschiedenen Algorithmen trainiert und die Konvergenzgeschwindigkeit und die Endleistung auf einem Validierungsdatensatz überprüft und verglichen. | |||

Bei der Hyperparameter-Optimierung werden Techniken angewendet, um automatisch die besten Hyperparameter-Werte, einschließlich des Optimierungsalgorithmus, zu finden. Methoden wie Random Search, Grid Search oder fortgeschrittenere Methoden wie Bayesian Optimization können hierbei hilfreich sein. | |||

Zur Literaturrecherche und bewährte Verfahren wird die Literatur und bewährte Verfahren in Bezug auf die spezifische Aufgabe durchsucht. Oft gibt es Empfehlungen und Erfahrungen für bestimmte Arten von Aufgaben und Modellen. | |||

KI entwickelt sich sehr schnell und es gibt laufend neuere Erkenntnisse und Entwicklungen in der Forschung. In einigen Fällen können neue Optimierungsalgorithmen oder Verbesserungen älterer Algorithmen verfügbar sein. | |||

Weiterhelfen kann auch eine Beratung durch Fachleute oder Experten auf dem Gebiet des maschinellen Lernens. | |||

Es ist dabei wichtig zu beachten, dass es keine Einheitslösung gibt, und die Wirksamkeit eines Optimierungsalgorithmus kann stark von der spezifischen Aufgabe, den Daten und der Modellarchitektur abhängen. Daher ist es oft ratsam, mehrere Optimierungsalgorithmen auszuprobieren und ihre Leistung empirisch zu vergleichen. Dieser iterative Prozess kann dazu beitragen, den am besten geeigneten Algorithmus für eine bestimmte Aufgabe zu identifizieren. | |||

| Zeile 590: | Zeile 730: | ||

Eine KI bietet eine breite Palette von Möglichkeiten, um in verschiedenen Geschäftsbereichen und Branchen signifikante Vorteile zu erzielen. KI-Systeme können große Datenmengen in kürzester Zeit analysieren, Muster erkennen, Vorhersagen treffen und Aufgaben automatisieren, was die Effizienz steigert und menschliche Arbeitskraft entlastet. In Bereichen wie natürlicher Sprachverarbeitung ermöglichen KI-Modelle die Verarbeitung und Übersetzung von Text und Sprache auf beeindruckende Weise. | Eine KI bietet eine breite Palette von Möglichkeiten, um in verschiedenen Geschäftsbereichen und Branchen signifikante Vorteile zu erzielen. KI-Systeme können große Datenmengen in kürzester Zeit analysieren, Muster erkennen, Vorhersagen treffen und Aufgaben automatisieren, was die Effizienz steigert und menschliche Arbeitskraft entlastet. In Bereichen wie natürlicher Sprachverarbeitung ermöglichen KI-Modelle die Verarbeitung und Übersetzung von Text und Sprache auf beeindruckende Weise. | ||

Allerdings hat die KI auch klare Grenzen. KI-Systeme sind emotionslos, haben keine Empathie und sind nicht kreativ. Sie basieren ausschließlich auf den ihnen zur Verfügung gestellten Daten. Weil eine auf spezifische Aufgaben und Anwendungen optimiert ist kann sie Schwierigkeiten haben, Aufgaben außerhalb ihres Trainingsbereichs zu bewältigen. Die Qualität und Repräsentativität der Daten, auf denen KI basiert, sind entscheidend für ihre Leistungsfähigkeit. Die Fähigkeit einer KI sich an sich ändernde Geschäftsanforderungen anzupassen ist begrenzt. | Allerdings hat die KI auch klare Grenzen. KI-Systeme sind emotionslos, haben keine Empathie und sind nicht kreativ. Sie basieren ausschließlich auf den ihnen zur Verfügung gestellten Daten. Weil eine KI auf spezifische Aufgaben und Anwendungen optimiert ist kann sie Schwierigkeiten haben, Aufgaben außerhalb ihres Trainingsbereichs zu bewältigen. Die Qualität und Repräsentativität der Daten, auf denen KI basiert, sind entscheidend für ihre Leistungsfähigkeit. Die Fähigkeit einer KI sich an sich ändernde Geschäftsanforderungen anzupassen ist begrenzt. | ||

Insgesamt ist die KI ein leistungsstarkes Werkzeug, das in vielen Bereichen nützlich sein kann, aber es ist auch notwendig, ihre Stärken und Grenzen zu verstehen, um sie effektiv einzusetzen zu können. | Insgesamt ist die KI ein leistungsstarkes Werkzeug, das in vielen Bereichen nützlich sein kann, aber es ist auch notwendig, ihre Stärken und Grenzen zu verstehen, um sie effektiv einzusetzen zu können. | ||

| Zeile 603: | Zeile 743: | ||

Eine KI kann dagegen keine '''Emotionen und Empathie''' empfinden. Der KI fehlt auch die Fähigkeit zur '''Kreativität und Innovation'''. Die KI kann zwar aufgrund von Daten Muster erkennen und Trends vorhersagen, aber sie ist nicht im menschlichen Sinne kreativ und kann deshalb auch nichts „Neues“ oder neuartiges erschaffen. Einer KI fehlt die Eigenschaft der '''Eigenständigkeit'''. Deshalb kann eine KI zwar aus Daten lernen und Muster anpassen, aber sie hat kein eigenständiges Denkvermögen oder die Fähigkeit, sich unabhängig von Daten weiterzuentwickeln. Eine KI hat auch keine '''Ethik und Moral'''. Ihre Entscheidungen basieren ausschließlich auf jenen Daten, auf denen sie trainiert wurde. Eine KI kann basierend auf ihrem Training vorhandene Daten analysieren, aber sie besitzt keine '''intuitive Einsicht''' in komplexe Probleme oder die Fähigkeit, '''abstrakte Konzepte''' zu verstehen. | Eine KI kann dagegen keine '''Emotionen und Empathie''' empfinden. Der KI fehlt auch die Fähigkeit zur '''Kreativität und Innovation'''. Die KI kann zwar aufgrund von Daten Muster erkennen und Trends vorhersagen, aber sie ist nicht im menschlichen Sinne kreativ und kann deshalb auch nichts „Neues“ oder neuartiges erschaffen. Einer KI fehlt die Eigenschaft der '''Eigenständigkeit'''. Deshalb kann eine KI zwar aus Daten lernen und Muster anpassen, aber sie hat kein eigenständiges Denkvermögen oder die Fähigkeit, sich unabhängig von Daten weiterzuentwickeln. Eine KI hat auch keine '''Ethik und Moral'''. Ihre Entscheidungen basieren ausschließlich auf jenen Daten, auf denen sie trainiert wurde. Eine KI kann basierend auf ihrem Training vorhandene Daten analysieren, aber sie besitzt keine '''intuitive Einsicht''' in komplexe Probleme oder die Fähigkeit, '''abstrakte Konzepte''' zu verstehen. | ||

Eine KI in vielen Bereichen nützlich sein, aber sie hat klare Grenzen in Bezug auf menschliche Emotionen, Kreativität, Ethik und menschliche Intuition. Es ist wichtig, diese Unterschiede zu verstehen. Nur dadurch ist es möglich die Stärken einer KI optimal zu nutzen und | Eine KI kann in vielen Bereichen nützlich sein, aber sie hat klare Grenzen in Bezug auf menschliche Emotionen, Kreativität, Ethik und menschliche Intuition. Es ist wichtig, diese Unterschiede zu verstehen. Nur dadurch ist es möglich die Stärken einer KI optimal zu nutzen und entsprechend einzusetzen. | ||

<span id="künstliche-intelligenz-und-ihre-datengrundlage"></span> | <span id="künstliche-intelligenz-und-ihre-datengrundlage"></span> | ||

| Zeile 628: | Zeile 768: | ||

KI-Modelle sind im Allgemeinen auf spezifische Aufgaben optimiert, für die sie trainiert wurden. Deshalb wird in der Regel jeder KI eine spezielle Aufgabenstellung zugeordnet. Genau diese Aufgabe wird die KI bestmöglich im Sinne ihres Trainings erfüllen können. KI-Modelle sind keine universelle Problemlöser, weil sie Schwierigkeiten haben können, Aufgaben außerhalb ihres Trainingsbereichs oder ihrer Fähigkeiten zu bewältigen. | KI-Modelle sind im Allgemeinen auf spezifische Aufgaben optimiert, für die sie trainiert wurden. Deshalb wird in der Regel jeder KI eine spezielle Aufgabenstellung zugeordnet. Genau diese Aufgabe wird die KI bestmöglich im Sinne ihres Trainings erfüllen können. KI-Modelle sind keine universelle Problemlöser, weil sie Schwierigkeiten haben können, Aufgaben außerhalb ihres Trainingsbereichs oder ihrer Fähigkeiten zu bewältigen. | ||

Anmerkung: Es wäre prinzipiell möglich, dass KI-Modelle auch Aufgaben außerhalb ihres Trainingsbereichs bewältigen sofern die Eingabeformate übereinstimmen, aber die Ergebnisse werden von Faktoren beeinflusst, wie z.B. der Fähigkeit der KI zur Generalisierung, der Wahl des genutzten Algorithmus und der Netzwerkarchitektur. Es würde deshalb einen zusätzlichen Aufwand und Ressourcen erfordern, um sicherzustellen, dass eine solche KI auch brauchbare Ergebnisse liefern kann. | Anmerkung: Es wäre prinzipiell möglich, dass KI-Modelle auch Aufgaben außerhalb ihres Trainingsbereichs bewältigen, sofern die Eingabeformate übereinstimmen, aber die Ergebnisse werden von Faktoren beeinflusst, wie z.B. der Fähigkeit der KI zur Generalisierung, der Wahl des genutzten Algorithmus und der Netzwerkarchitektur. Es würde deshalb einen zusätzlichen Aufwand und Ressourcen erfordern, um sicherzustellen, dass eine solche KI auch brauchbare Ergebnisse liefern kann. | ||

Die Qualität und Vielfalt der Daten, auf denen eine KI basiert, sind entscheidend für ihre Leistungsfähigkeit. Deshalb muss von Beginn ab sichergestellt sein, dass die Daten, die zur Schulung und Anwendung von KI-Systemen verwendet werden, genau, aktuell und repräsentativ für die Problemstellung sind, um qualitativ hochwertige Ergebnisse zu erzielen. | Die Qualität und Vielfalt der Daten, auf denen eine KI basiert, sind entscheidend für ihre Leistungsfähigkeit. Deshalb muss von Beginn ab sichergestellt sein, dass die Daten, die zur Schulung und Anwendung von KI-Systemen verwendet werden, genau, aktuell und repräsentativ für die Problemstellung sind, um qualitativ hochwertige Ergebnisse zu erzielen. | ||

| Zeile 676: | Zeile 816: | ||

'''Gewöhnungseffekte''' | '''Gewöhnungseffekte''' | ||

Insgesamt sollte Vertrauen in KI-Systeme gut abgewogen und mit Vorsicht behandelt werden. KI kann wertvolle Unterstützung und Automatisierung bieten, aber ihr sollte nicht blind vertraut werden. Menschliche Aufsicht, Ethik und ein umfassendes Verständnis der Funktionsweise und der Grenzen der KI sind entscheidend, um sicherzustellen, dass sie in Verbindung mit menschlichem Urteilsvermögen und Verantwortung genutzt wird. | |||

Insgesamt sollte Vertrauen in KI-Systeme gut abgewogen und mit Vorsicht behandelt werden. KI kann wertvolle Unterstützung und Automatisierung bieten, aber | |||

<span id="einführung-von-ki-anwendungen"></span> | <span id="einführung-von-ki-anwendungen"></span> | ||

== '''Einführung von KI-Anwendungen''' == | == '''Einführung von KI-Anwendungen''' == | ||

Die Planung und Einführung von KI-Anwendungen in einem Unternehmen erfordert grundlegende Überlegungen. Im Folgenden werden Schritte skizziert, die | Die Planung und Einführung von KI-Anwendungen in einem Unternehmen erfordert grundlegende Überlegungen. Im Folgenden werden Schritte skizziert, die sicherstellen sollen, dass eine Einführung erfolgreich ist und den gewünschten Nutzen bringt. | ||

'''Geschäftsziele''' | '''Geschäftsziele''' | ||

| Zeile 718: | Zeile 856: | ||

'''Schulung und Change-Management''' | '''Schulung und Change-Management''' | ||

Durch Schulungen der Beteiligten soll | Durch Schulungen der Beteiligten soll sichergestellt werden, dass neue KI-Anwendungen effektiv genutzt werden können. Zur Erleichterung des Übergangs kann Change-Management genutzt werden. | ||

<span id="messkriterien-für-den-erfolg-von-ki-anwendungen"></span> | <span id="messkriterien-für-den-erfolg-von-ki-anwendungen"></span> | ||

== '''Messkriterien für den Erfolg von KI-Anwendungen''' == | == '''Messkriterien für den Erfolg von KI-Anwendungen''' == | ||

Werden KI-Anwendungen in einem Unternehmen eingeführt, stellt sich auch die Frage nach Messkriterien | Werden KI-Anwendungen in einem Unternehmen eingeführt, stellt sich auch die Frage nach Messkriterien für den zu erwartenden Erfolg. Ziele und Messkriterien sollten bereits von Anfang an feststehen und darüber hinaus diese regelmäßig überwacht und anpasst werden. Die Kombination mehrerer dieser Metriken kann ein umfassendes Bild vom Erfolg einer KI-Anwendung im Unternehmen zeichnen. Der Erfolg kann auch über verschiedene Zeiträume hinweg bewertet werden. | ||

Die Messung des Erfolgs erfordert Metriken und Kriterien, die auf die spezifischen Ziele und den Anwendungsbereich abgestimmt sind. Gängige Messkriterien zur Bewertung sind: | Die Messung des Erfolgs erfordert Metriken und Kriterien, die auf die spezifischen Ziele und den Anwendungsbereich abgestimmt sind. Gängige Messkriterien zur Bewertung sind: | ||

| Zeile 729: | Zeile 867: | ||

'''Return on Investment (ROI)''' | '''Return on Investment (ROI)''' | ||

Der ROI zählt zu den wichtigsten Kriterien und misst die finanzielle Rendite einer KI-Investition. Dazu | Der ROI zählt zu den wichtigsten Kriterien und misst die finanzielle Rendite einer KI-Investition. Dazu werden die erzielten Gewinne oder Kosteneinsparungen mit den Investitionskosten verglichen. | ||

'''<br> | '''<br> | ||

| Zeile 760: | Zeile 898: | ||

'''Kundenzufriedenheit und -bindung''' | '''Kundenzufriedenheit und -bindung''' | ||

KI- | KI-Anwendungen, die auf Kunden ausgerichtet sind, bewerten, wie die Kundenzufriedenheit wächst, ob die Kundenbindung gestärkt wird und ob sich die Qualität des Kundensupports verbessert. | ||

'''Umsatzsteigerung''' | '''Umsatzsteigerung''' | ||

| Zeile 787: | Zeile 925: | ||

'''Zeitersparnis''' | '''Zeitersparnis''' | ||

Gemessen wird die Bearbeitungszeit von Abläufen und Vorgängen, die durch die KI-Anwendung in Prozessen | Gemessen wird die Bearbeitungszeit von Abläufen und Vorgängen, die durch die KI-Anwendung in Prozessen eingespart wird, insbesondere bei Aufgaben, die zuvor manuell erledigt wurden. | ||

'''Akzeptanz und Nutzerfeedback''' | '''Akzeptanz und Nutzerfeedback''' | ||

| Zeile 799: | Zeile 938: | ||

'''Weiterentwicklung und Anpassungsfähigkeit''' | '''Weiterentwicklung und Anpassungsfähigkeit''' | ||

Geschäftsprozesse | Geschäftsprozesse und Anforderungen können sich verändern. Aus diesem Grund muss die KI-Anwendung die Fähigkeit aufweisen, sich an veränderte Geschäftsanforderungen anzupassen und auf neue Herausforderungen zu reagieren. | ||

<span id="hindernisse-für-den-einsatz-von-ki"></span> | <span id="hindernisse-für-den-einsatz-von-ki"></span> | ||

| Zeile 808: | Zeile 947: | ||

'''Fachkräftemangel in der KI:''' Der Mangel an qualifizierten KI-Experten und Fachleuten kann den Einsatz von KI in Unternehmen behindern. Die Rekrutierung und Bindung von KI-Talenten ist eine Herausforderung. | '''Fachkräftemangel in der KI:''' Der Mangel an qualifizierten KI-Experten und Fachleuten kann den Einsatz von KI in Unternehmen behindern. Die Rekrutierung und Bindung von KI-Talenten ist eine Herausforderung. | ||

'''Datenschutz und Datenschutz:''' Datenschutzrichtlinien und -vorschriften, wie die DSGVO in der EU, können den Umgang mit Daten und die Implementierung von KI-Systemen stark beeinflussen. Unternehmen müssen sicherstellen, dass sie datenschutzkonform agieren. | '''Datenschutz und Datenschutz:''' Datenschutz: Datenschutzrichtlinien und -vorschriften, wie die DSGVO in der EU, können den Umgang mit Daten und die Implementierung von KI-Systemen stark beeinflussen. Unternehmen müssen sicherstellen, dass sie datenschutzkonform agieren. | ||

'''Hohe Implementierungskosten:''' Die Implementierung von KI-Systemen kann mit erheblichen Kosten verbunden sein, von der Entwicklung bis zur Infrastruktur. Das kann kleinere Unternehmen und Start-ups vor Herausforderungen stellen. | '''Hohe Implementierungskosten:''' Die Implementierung von KI-Systemen kann mit erheblichen Kosten verbunden sein, von der Entwicklung bis zur Infrastruktur. Das kann kleinere Unternehmen und Start-ups vor Herausforderungen stellen. | ||

| Zeile 831: | Zeile 971: | ||

== '''Zusammenfassung''' == | == '''Zusammenfassung''' == | ||

In diesem Kapitel wurde die Beziehung zwischen künstlicher Intelligenz und ihren Datenquellen sowie die erfolgreiche Einführung von KI-Anwendungen in Unternehmen behandelt. Besonders hervorgehoben wurde die Abhängigkeit von KI von qualitativ hochwertigen Trainingsdaten und erläutert, wie KI auf Grundlage dieser Daten Muster erkennt, Vorhersagen | In diesem Kapitel wurde die Beziehung zwischen künstlicher Intelligenz und ihren Datenquellen sowie die erfolgreiche Einführung von KI-Anwendungen in Unternehmen behandelt. Besonders hervorgehoben wurde die Abhängigkeit von KI von qualitativ hochwertigen Trainingsdaten und erläutert, wie KI auf Grundlage dieser Daten Muster erkennt, Vorhersagen macht und Entscheidungen trifft. Es wurde festgestellt, dass KI keine eigene „Intuition“ hat und deshalb einen Sachverhalt oder komplizierten Vorgang nicht erfassen kann. Von einer KI generierte Resultate basieren ausschließlich auf den ihr zur Verfügung gestellten Daten. | ||

Die Einführung von KI-Anwendungen in der Wirtschaft erfordert zuerst die Klarstellung, welche Geschäftsziele durch eine KI unterstützt werden können bzw. unterstützt werden sollen. Das Schaffen von Bewusstsein für die genutzten KI-Technologien im Unternehmen macht alle Beteiligten mit veränderten Arbeitsabläufen vertraut. Rein operativ ist es notwendig, konkrete Anwendungsfälle zu identifizieren, eine Datenstrategie zu entwickeln und den Zugang zu den erforderlichen Ressourcen und Fähigkeiten bereitzustellen oder zu schaffen. Danach kann die Auswahl der geeigneten KI-Technologie und Plattform erfolgen, Prototypen erstellt werden, diese in Pilotprojekten einzuführen, Skalierungen und die Integration in den Geschäftsprozess vorzunehmen sowie die notwendige Schulung im Rahmen des Change-Managements durchzuführen. | Die Einführung von KI-Anwendungen in der Wirtschaft erfordert zuerst die Klarstellung, welche Geschäftsziele durch eine KI unterstützt werden können bzw. unterstützt werden sollen. Das Schaffen von Bewusstsein für die genutzten KI-Technologien im Unternehmen macht alle Beteiligten mit veränderten Arbeitsabläufen vertraut. Rein operativ ist es notwendig, konkrete Anwendungsfälle zu identifizieren, eine Datenstrategie zu entwickeln und den Zugang zu den erforderlichen Ressourcen und Fähigkeiten bereitzustellen oder zu schaffen. Danach kann die Auswahl der geeigneten KI-Technologie und Plattform erfolgen, Prototypen erstellt werden, diese in Pilotprojekten einzuführen, Skalierungen und die Integration in den Geschäftsprozess vorzunehmen sowie die notwendige Schulung im Rahmen des Change-Managements durchzuführen. | ||

| Zeile 840: | Zeile 980: | ||

= '''KI im unternehmerischen Umfeld''' = | = '''KI im unternehmerischen Umfeld''' = | ||

Für den zielgerichteten Einsatz von KI in einem Unternehmen muss zuerst festgestellt werden, wo es ein (oder mehrere) Problem gibt, bei dem eine KI | Für den zielgerichteten Einsatz von KI in einem Unternehmen muss zuerst festgestellt werden, wo es ein (oder mehrere) Problem gibt, bei dem eine KI zur Hilfestellung genutzt werden kann. | ||

<span id="problemstellungen-und-anwendungsfälle"></span> | <span id="problemstellungen-und-anwendungsfälle"></span> | ||

| Zeile 848: | Zeile 988: | ||

# '''Geschäftsziele und -herausforderungen verstehen:''' Zuerst ist es notwendig, die Geschäftsziele und -herausforderungen im Unternehmen zu analysieren. In einer Bestandsaufnahme in den verschiedenen Abteilungen und Funktionen wird zu erheben sein, wo ineffiziente Prozesse, hohe Kosten oder ungenutzte Chancen bestehen. | # '''Geschäftsziele und -herausforderungen verstehen:''' Zuerst ist es notwendig, die Geschäftsziele und -herausforderungen im Unternehmen zu analysieren. In einer Bestandsaufnahme in den verschiedenen Abteilungen und Funktionen wird zu erheben sein, wo ineffiziente Prozesse, hohe Kosten oder ungenutzte Chancen bestehen. | ||

# '''Datenquellen identifizieren:''' Wie bereits erwähnt benötigt | # '''Datenquellen identifizieren:''' Wie bereits erwähnt benötigt jede KI zu den betreffenden Geschäftsprozessen passende Daten, um sich die notwendigen Fähigkeiten aneignen zu können. Dazu müssen die verfügbaren Datenquellen im Unternehmen gesammelt werden. Interne Daten können aus CRM-Systemen, IoT-Geräten, Finanzdaten oder auch externe Datenquellen stammen, wie z.B. Marktforschungsberichte oder soziale Medien. | ||

# '''Fachwissen einbeziehen:''' Durch Konsultationen mit Fachleuten im Unternehmen, die tiefes Wissen über bestimmte Geschäftsprozesse und -herausforderungen haben, können wertvolle Einblicke in mögliche Anwendungsfälle bestimmt werden. Fachleute in diesem Sinn ist auch jener Personenkreis, der operativ Tätigkeiten in den in Frage kommenden Bereichen durchgeführt hat. | # '''Fachwissen einbeziehen:''' Durch Konsultationen mit Fachleuten im Unternehmen, die tiefes Wissen über bestimmte Geschäftsprozesse und -herausforderungen haben, können wertvolle Einblicke in mögliche Anwendungsfälle bestimmt werden. Fachleute in diesem Sinn ist auch jener Personenkreis, der operativ Tätigkeiten in den in Frage kommenden Bereichen durchgeführt hat. | ||

# '''Brainstorming-Sitzungen:''' In Brainstorming-Sitzungen mit Teams aus verschiedenen Abteilungen | # '''Brainstorming-Sitzungen:''' In Brainstorming-Sitzungen mit Teams aus verschiedenen Abteilungen kann kreativ nach Problemstellungen gesucht werden, bei denen KI-basierte Lösungen sinnvoll wären. | ||

# '''Benchmarking und Wettbewerbsanalyse:''' Interessant ist auch, wie Wettbewerber oder Unternehmen in der gleichen Branche KI erfolgreich einsetzen. Das kann Hinweise auf potenzielle Anwendungsfälle geben. | # '''Benchmarking und Wettbewerbsanalyse:''' Interessant ist auch, wie Wettbewerber oder Unternehmen in der gleichen Branche KI erfolgreich einsetzen. Das kann Hinweise auf potenzielle Anwendungsfälle geben. | ||

# '''Analyse von Schmerzpunkten:''' Die Identifikation von „Schmerzpunkten“ oder Engpässe in den bisherigen Geschäftsprozessen, die Effizienzprobleme verursachen, liefert ebenfalls Ansatzpunkte. Eine KI kann dazu beitragen, diese Probleme zu beheben. | # '''Analyse von Schmerzpunkten:''' Die Identifikation von „Schmerzpunkten“ oder Engpässe in den bisherigen Geschäftsprozessen, die Effizienzprobleme verursachen, liefert ebenfalls Ansatzpunkte. Eine KI kann dazu beitragen, diese Probleme zu beheben. | ||

| Zeile 869: | Zeile 1.011: | ||

# '''Qualität der Daten bewerten:''' Wichtig ist auch die Beurteilung der Qualität der Daten. Eingeschlossen sind die Überprüfung von Datenintegrität, Vollständigkeit, Aktualität und Genauigkeit. Wenn die Datenqualität problematisch ist, müssen Maßnahmen zur Verbesserung ergriffen werden, bevor eine KI-Anwendungen in Betracht gezogen werden kann. | # '''Qualität der Daten bewerten:''' Wichtig ist auch die Beurteilung der Qualität der Daten. Eingeschlossen sind die Überprüfung von Datenintegrität, Vollständigkeit, Aktualität und Genauigkeit. Wenn die Datenqualität problematisch ist, müssen Maßnahmen zur Verbesserung ergriffen werden, bevor eine KI-Anwendungen in Betracht gezogen werden kann. | ||