Methoden der Datenanalyse - Varianzanalyse

Varianzanalyse

Die Varianzanalyse stellt nicht nur ein spezielles Analyseverfahren, sondern eine generelle Methode dar, um Zusammenhänge zwischen verschiedenen Merkmalen inferenzstatistisch zu beurteilen. Ziel der Lektion ist das Grundmodell der Varianzanalyse sowie die wichtige Idee der Quadratsummenzerlegung darzustellen. Die Durchführung der Analysen der Modelle mit einem bzw. zwei Faktoren sowie die Umsetzung in der Software R sind die weiteren zentralen Punkte.

Begriffsabgrenzung

Die (univariate) Varianzanalyse („ANOVA“ = „analysis of variance“) wird ebenfalls dazu verwendet, den Einfluss einer oder mehrerer unabhängiger Variablen auf eine zumindest intervallskalierte (metrische) Zielvariable zu untersuchen. Im Gegensatz zur Regression sind die hier vorkommenden unabhängigen Variablen kategoriell. Es wird daher nicht eine lineare Funktion als Zusammenhang unterstellt, sondern die Varianzanalyse stellt eine Methode zur Analyse von Mittelwertsunterschieden in verschiedenen Versuchsgruppen dar. Der Name „Varianzanalyse“ kommt daher, dass zur Beurteilung der Signifikanz solcher Mittelwertsunterschiede Varianzen berechnet werden.

Liegt eine erklärende Gruppenvariable (ein „Faktor“) vor, spricht man von einer „einfachen“ bzw. „einfaktoriellen“ Varianzanalyse, ansonsten von zwei- oder mehrfaktoriellen Varianzanalysen. Im Gegensatz zur Regressionsanalyse werden üblicherweise auch Interaktionen zwischen (zwei oder mehreren) erklärenden Variablen im Modell berücksichtigt.

Die verschiedenen Ausprägungen eines jeden Faktors werden „Faktorstufen“ genannt. Hat man in jeder Faktorstufe gleich viele Daten zur Verfügung, spricht man von einem „balancierten Design“, sonst von einem „unbalancierten Design“. Gibt es (bei zumindest zwei vorhandenen Faktoren) nicht in jeder Kombination von Faktoren Beobachtungen, heißt die Versuchsanordnung „unvollständiges Design“.

Hat man als erklärende Variablen sowohl metrische, als auch kategorielle Variablen, wird eine Kovarianzanalyse durchgeführt, die aber hier nicht weiter behandelt wird. Ebenfalls nicht behandelt wird der Fall der multivariaten Varianzanalyse („MANOVA“) bei der mehrere abhängige, korrelierte Variablen vorkommen.

Typische Fragestellungen der ANOVA können sein:

- Ob und wie unterscheiden sich Mietkosten einer Wohnung in Bezug auf die Lage (Innen- vs. Außenbezirke) bzw. in Bezug auf die Zimmeranzahl?

- Gibt es Unterschiede im Ertrag bei verschiedenen Getreidesorten?

- Hängt der Absatz eines Produktes von der Platzierung im Supermarkt ab?

- Ist ein bestimmtes Training für eine Leistung förderlich?

- Ist eine Therapie in Bezug auf ein Kriterium erfolgreich?

Hinweis: Die einfaktorielle Varianzanalyse kann auch als die Verallgemeinerung des schon bekannten t-Tests (zum Vergleich zweier Erwartungswerte aus normalverteilten Grundgesamtheiten) für eine beliebige Anzahl an Erwartungswerten (Gruppen) gesehen werden.

Die einfache Varianzanalyse für unabhängige Stichproben

Modell der einfachen Varianzanalyse für unabhängige Stichproben

Formal lautet das Modell der einfachen Varianzanalyse:

wobei die Werte der metrischen Variable sind (j-ter Wert in Gruppe i), der unbedingte Erwartungswert (ohne Kenntnis der Gruppe), der „Effekt“ von Gruppe ist (also der Unterschied des jeweiligen Gruppenerwartungswerts zu und der durch die Gruppenvariable nicht erklärte Teil der abhängigen Variable – analog zur Regression, der Fehler – ist. Die sind die Stichprobenumfänge der Gruppen.

Wie bei der Regression ist auch hier die Annahme, dass die Fehler normalverteilt mit Erwartungswert Null und Varianz und voneinander unabhängig sind (Varianzhomogenität und Unkorreliertheit der Fehler).

Schätzen und Testen bei der einfachen Varianzanalyse

| Beispiel 2

Es soll die Zugfestigkeit von drei Drahtsorten verglichen werden. Dazu werden von Sorte 1 sieben Proben, von Sorte 2 fünf Proben und von Sorte 3 sechs Proben auf ihre Zugfestigkeit überprüft. Es ergaben sich folgende Werte (in Newton/mm2):

|

|---|

Da in Beispiel 2 nur eine gruppierende Variable (in drei Ausprägungen) existiert, liegt eine einfache Varianzanalyse vor. Da nicht in jeder Gruppe gleich viele Beobachtungen sind, ist das Design unbalanciert.

Gemäß des Modells der einfachen Varianzanalyse haben wir also die Vorstellung: Die Zugfestigkeit einer Drahtsorte bei einem bestimmten Versuch setzt sich additiv zusammen aus

- einer mittleren Zugfestigkeit, die ein „durchschnittlicher“ Draht hat,

- einem Wert, um die die Zugfestigkeit einer speziellen Drahtsorte besser oder schlechter ist, als ein „durchschnittlicher“ Draht und

- einer Abweichung von der durchschnittlichen Zugfestigkeit dieser Drahtsorte, die in dem bestimmten Versuch beobachtet wurde und mangels anderer Erklärungsmöglichkeiten dem Zufall zugeordnet wird.

Dementsprechend werden auch die Parameter in diesem Modell geschätzt.

Schätzung der Zugfestigkeit eines durchschnittlichen Drahts durch

Schätzung des Effekts von Drahtsorte , , durch

Schätzung des Fehlers durch das Residuum

| Fortsetzung Beispiel 2

Kontrolle:

Residuum exemplarisch: |

|---|

| Aufgabe 3

Berechnen Sie für alle Beobachtungen aus Beispiel 2 die Residuen und bestimmen Sie jene Beobachtung, die durch das Modell am schlechtesten erklärt wird (d.h. das betragsmäßig größte Residuum aufweist). |

|---|

Die Schätzungen der einzelnen Parameter beschränken sich also immer nur auf die Berechnung von Mittelwerten und deren Differenzen. Aus den Berechnungen von Beispiel 2 wissen wir nun beispielsweise, dass Drahtsorte 3 eine um 3,233 Newton/mm2 größere Zugfestigkeit als der Durchschnitt aufweist. Das bezieht sich jedoch nur auf die beobachtete Stichprobe. Damit haben wir auf die ursprüngliche Frage „Unterscheiden sich die 3 Drahtsorten bezüglich der Zugfestigkeit“ nur eine deskriptivstatistische Antwort gegeben.

In der Regel ist aber von Interesse, ob wir durch die Daten genügend Evidenz dafür haben, dass sich auch die Mittelwerte der Grundgesamtheit (die Erwartungswerte) unterscheiden. Hier ist es nun wieder erforderlich, einen statistischen Test zu berechnen.

Das Hypothesenpaar bei der einfaktoriellen Varianzanalyse lautet folgendermaßen:

Getestet wird also, ob alle Erwartungswerte gleich sind, oder zumindest zwei Erwartungswerte existieren, die ungleich sind.

Beim t-Test (Anzur, 2007, S. 71) wurde als relevante Prüfgröße die Differenz der Mittelwerte der beiden Gruppen bezogen auf den Standardfehler der Mittelwertsdifferenz berechnet. Dieses Konzept ist nun nicht mehr möglich, da die Differenzen von mehr als zwei Gruppen berechnet werden müssten (die „mittlere“, die „maximale“, die „minimale“?). Anstelle der Differenz kommt nun das Konzept mit den Varianzen ins Spiel.

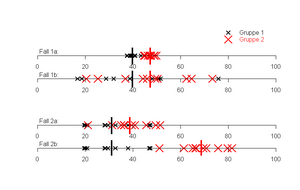

Abbildung 11 zeigt anhand von zwei Gruppen das Problem aber auch gleichzeitig die Lösung. Ziel der Varianzanalyse ist es, herauszufinden, ob die (durchschnittliche) Lage der Beobachtungen auf dem Zahlenstrahl in beiden Gruppen gleich ist. In Fall 1 besteht zwischen Gruppe 1 und Gruppe 2 bei a und b dieselbe Mittelwertsdifferenz. Es ist aber mit freiem Auge ersichtlich, dass in Fall 1a besser zwischen den beiden Gruppen getrennt werden kann, als in Fall 1b. Grund sind die größeren Varianzen innerhalb der beiden Gruppen im Fall 1b. Bei Fall 2 streuen nun die Werte aller Gruppen gleich um ihren Mittelwert. Demnach sind die Varianzen innerhalb der Gruppen jeweils gleich. Nun kann besser zwischen jenen Gruppen getrennt werden, die den größeren Mittelwertsunterschied haben. Zusammengefasst heißt das, dass umso mehr Evidenz für eine unterschiedliche Lage der Gruppen gegeben ist, je größer die Mittelwertsdifferenz ist und je kleiner die Streuung der Werte um ihren eigenen Mittelwert ist. Im Fall von mehr als zwei Gruppen wird die Mittelwertsdifferenz einfach durch die Streuung (Varianz) der Gruppenmittelwerte ersetzt.

Gegenübergestellt werden in der Varianzanalyse also die Varianzen (Quadratsummen [1] ) „innerhalb“ der Gruppen und „zwischen“ den Gruppen. Die Hilfsgrößen, um einen Test für oben genanntes Hypothesenpaar durchzuführen sind solche Quadratsummen. In der einfachen Varianzanalyse gilt immer folgende Quadratsummenzerlegung:

QT…Quadratsumme „Total“

QI…Quadratsumme „Innerhalb“

QZ…Quadratsumme „Zwischen“

Die Gesamtvariabilität der Daten QT kann also in zwei additive Teile gespalten werden. Dadurch bietet sich als weitere deskriptive Größe analog zur Regressionsanalyse das Bestimmtheitsmaß an, welches als Quotient aus QZ und QT berechnet wird und wieder den Anteil an der durch das Modell erklärten Varianz an der Zielgröße angibt.

| Aufgabe 4

Denken Sie sich zwei Datensätze aus (je drei Gruppen mit je fünf Beobachtungen pro Gruppe). Einen, bei dem das Bestimmtheitsmaß 100% beträgt und einen, bei dem das Bestimmtheitsmaß 0% beträgt. Welche Charakteristik haben die Daten jeweils. |

|---|

Um nun inferenzstatistische Aussagen zu machen, wird nun die Quadratsumme „Zwischen“ nicht zur totalen Quadratsumme, sondern zur Quadratsumme „Innerhalb“ in Beziehung gesetzt. Dies liefert auch dann die Prüfgröße F [2] für unsere Hypothese:

Es kann gezeigt werden, dass unter Gültigkeit der Nullhypothese (die Erwartungswerte aller Gruppen sind gleich) und den anderen vorher erwähnten Modellannahmen (Normalverteilung der Fehler) nach einer F-Verteilung mit und Freiheitsgraden verteilt ist. Dadurch werden Schranken definiert, bis zu welchen Werten von eine Entscheidung für die Nullhypothese und ab wann eine Entscheidung für die Alternativhypothese erfolgt. Was man weiters wie bei jedem statistischen Test benötigt, ist , die “Irrtumswahrscheinlichkeit“ (=die Wahrscheinlichkeit, die zu verwerfen, obwohl sie zutrifft).

| Fortsetzung Beispiel 2

|

|---|

|

|

| Aufgabe 5

Berechnen Sie für die Daten aus Beispiel 2 das Bestimmtheitsmaß. |

|---|

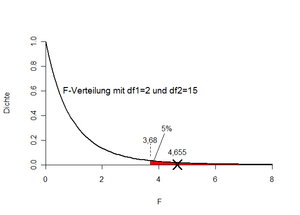

Soll bei nun für die H0 oder für die H1 entschieden werden? Bei kleinen Werten von F beobachten wir entweder kleine Werte für QZ und/oder große Werte für QI. Beides spricht eher für die H0. Umgekehrt sind große Werte für F eher Evidenz für H1. Um die Frage zu beantworten, wird nun der „kritische Wert“ in der Tabelle der F-Verteilung (oder z.B. in Excel) nachgeschlagen. Bei am oberen Ende der Verteilung suchen wir de facto das -Quantil der F-Verteilung mit und Freiheitsgraden. In Excel kann dies mit der Funktion „FINV“ berechnet werden („=FINV(0,05;2;15)“). Dies liefert als maximal zulässigen F-Wert 3,68. Unser aus den Daten beobachtete F-Wert beträgt 4,655. Diese ist größer als der kritische Wert und daher wird die Nullhypothese verworfen. Ergebnis: Die drei Drahtsorten unterscheiden sich (bei ) signifikant voneinander bezüglich ihrer Zugfestigkeit. Abbildung 12 veranschaulicht die Entscheidungssituation nochmals.

In der Praxis rechnet man die Varianzanalyse natürlich wieder mit Software. In R kann wieder die Funktion „lm“ verwendet werden. Die unabhängige Variable muss aber als „Faktor“ spezifiziert werden, da sonst ein linearer Zusammenhang mit der Gruppennummer geschätzt wird.

- ↑ Unter Quadratsumme wird die Summe von quadrierten Zahlen verstanden. In der Varianzanalyse geht es immer um die Summe von quadrierten Abweichungen von Mittelwerten. Im Prinzip ist eine Quadratsumme eine Varianz, die nicht durch den Stichprobenumfang dividiert wurde.

- ↑ Die Prüfgröße F bzw. die Prüfverteilung ist benannt nach Sir Ronald A. Fisher, der erstmals im Jahre 1935 mit Erscheinen seines Buches „The Design of Experiments“ eine ausführliche Darstellung von Varianzanalyse und Versuchsplanung veröffentlichte (Hartung, 1998, S.12).

![{\displaystyle F={\frac {MQZ}{MQI}}={\frac {{\frac {1}{k-1}}QZ}{{\frac {1}{N-k}}QI}}={\frac {(N-k)QZ}{(k-1)QI}}\qquad {\left[N=n_{1}+n_{2}+n_{3}\right]}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b0b6bd3cd08e37b656011f2cda41812198fde6e9)