Computer- und Netzwerksicherheit - Kryptograhpie

Kryptographie

Bei der Kryptographie handelt es sich um Methoden, Daten in eine Form zu bringen, in der Sie nur von denen gelesen werden können, die dazu berechtigt sind. Für alle anderen sollen die Daten während ihrer Übermittlung und Speicherung unlesbar sein.

Die Kryptographie hat ihren bekannten Ursprung in den Jahren um 2000 v. Chr. Die Ägypter nutzten Hieroglyphen um Grabkammern zu dekorieren und die Lebensgeschichte des Verstorbenen zu erzählen. Das Augenmerk lag dabei jedoch nicht in der Unkenntlichmachung der Informationen sondern darin, sie durch die bildhafte Darstellungsform zeremoniell und majestätisch wirken zu lassen. [Ha13, 760]

Eine der ersten Methoden mit der Absicht einen Text unkenntlich zu machen, war die hebräische Atbash Methode. Dabei wurde als Schlüssel jedem Buchstaben im Alphabet ein anderer Buchstabe zugewiesen. Ein Beispiel für einen Schlüssel wären demnach die folgenden beiden Zeilen [Ha13, 760]:

ABCDEFGHIJKLMNOPQRSTUVWXYZ

ZYXWVUTSRQPONMLKJIHGFEDCBA

Damit könnte nun beispielsweise der Text „KRYPTO“ zum Text „PIBKGL“ verschlüsselt werden, indem der Buchstabe des ursprünglichen Textes in der ersten Zeile des Schlüssels nachgesehen und dann durch den jeweiligen Buchstaben der zweiten Zeile ersetzt wird. Zur Entschlüsselung wird dieselbe Technik umgekehrt angewendet, indem der Buchstabe des verschlüsselten Textes in der zweiten Zeile gesucht und dann durch den jeweiligen Eintrag der ersten Zeile ersetzt wird.

Ein weiterer historisch erfolgreicher Algorithmus ist der Cäsar-Algorithmus. Er wurde in der Zeit der gallischen Kriege von Julius Cäsar entwickelt und eingesetzt um vertrauliche Nachrichten zu übermitteln, ohne dem Nachrichtenboten vertrauen zu müssen. Das Prinzip des Cäsar- Algorithmus ist simpel. Jeder Buchstabe der Nachricht wird um eine bestimmte Anzahl an Stellen im Alphabet nach hinten verschoben, wobei beim Erreichen des letzten Buchstaben Z wieder mit dem ersten Buchstaben A weitergezählt wird. Die Anzahl der Buchstaben, um die die Nachricht verschoben wird, wird dabei meist als Teil des Algorithmus Namens angegeben. So sind bei einer Cäsar 5 Verschlüsselung die Buchstaben der Nachricht um 5 Stellen verschoben und bei einer Cäsar 15 Verschlüsselung um 15 Stellen.

Der Text „KRYPTO“ wird durch Anwendung einer Cäsar 5 Verschlüsselung zu „PWDUYT“. Dabei wird auch deutlich, dass beim Verschieben des Buchstaben Y zum Buchstaben D, nach Erreichen von Z wieder mit A begonnen wird.

Der Cäsar-Algorithmus ist aus heutiger Sicht auch von Nicht-Kryptographen leicht zu knacken. Aus damaliger Sicht war es jedoch ein sehr sicheres Verfahren, da der Bildungsgrad der Bevölkerung nicht sehr hoch war und viele nicht schreiben und lesen konnten.

Eine deutliche Verbesserung des Cäsar-Algorithmus würde im 16. Jahrhundert von Blaise de Vigenere entwickelt und deshalb auch als Vigenere-Algorithmus bezeichnet. Dabei wird nicht mehr jeder Buchstabe um eine bestimmte Anzahl von Zeichen verschoben, sondern ein Schlüssel definiert, der die jeweilige Verschiebung der einzelnen Buchstaben bestimmt. Im nachfolgenden Beispiel wird ein Text mit Hilfe des Schlüssels „KRYPTO“ verschlüsselt.

Klartext: DIETAUBEISTAUFDEMDACH

Schlüssel: KRYPTOKRYPTOKRYPTOKRY

Verschlüsselt: NZCITILVGHMOEWBTFRKTF

Der Schlüssel wird für die gesamte Länge der Nachricht immer wieder wiederholt. Im Beispiel befindet sich der Buchstabe D bei seinem ersten vorkommen im Text unter dem Buchstaben K des Schlüssels und wird daher um 10 Zeichen verschoben und somit zu einem N. Bei seinem zweiten Vorkommen befindet sich das D der Nachricht jedoch unter dem Y des Schlüssels und wird daher zu einem B.

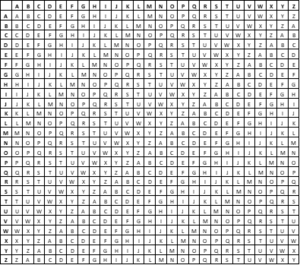

Um den Abstand zwischen dem Zeichen der Nachricht und dem Zeichen des Schlüssels schneller manuell ermitteln zu können wird oft eine Tabelle eingesetzt, in der alle möglichen Abstandskombinationen aufgelistet sind. Diese wird als Vigenere-Tabelle bezeichnet und ist in Abbildung 7 zu sehen.

In dieser Lektion werden nun weiter die Grundbegriffe der Kryptographie, ihre wesentlichen Methoden und mögliche Angriffsvektoren genauer behandelt.

Wesentliche Begriffe der Kryptographie

In der Kryptographie gibt es einige wichtige Grundbegriffe. Sie dienen der Beschreibung der Methoden und den unterschiedlichen Stadien von Ver- und Entschlüsselung. Diese Begriffe sind nun nachfolgend beschrieben.

Klartext (Plaintext)

Beim Klartext handelt es sich um die unverschlüsselte Nachricht, die übertragen werden soll. Solange sich die Nachricht in diesem Zustand befindet kann sie von jedem gelesen werden, der Zugriff auf sie hat.

Geheimtext (Ciphertext)

Dabei handelt es sich um eine verschlüsselte Klartext Nachricht. Sie ist in diesem Zustand nicht lesbar. Jeder, der in den Besitz des Geheimtextes kommt muss den zugehörigen Algorithmus und Schlüssel kennen um die Nachricht wieder in den Klartext umwandeln zu können.

Chiffre (Cipher / Algorithmus)

Die zur Ver- und Entschlüsselung eingesetzte Methode und der zugehörige Algorithmus werden als Chiffre (Cipher) bezeichnet. Sie verarbeitet einen Plaintext mit Hilfe des Keys zu Ciphertext und umgekehrt. Dabei handelt es sich um eine Ansammlung von Umwandlungen der Zeichen (oder Bits) des Textes.

Es gibt bekannte und unbekannte Chiffren. Alle gängig eingesetzten Chiffren sind hinlänglich ihrer genauen Funktionsweise bekannt. Die Stärke der Chiffre ist von wesentlicher Bedeutung für die Sicherheit. Die Unbekannte ist dabei immer der Schlüssel. Ein wesentlicher Vorteil von bekannten Chiffren ist die große Anzahl an Nutzern und der Möglichkeit sie öffentlich zu analysieren und zu testen. Damit werden gefundene Schwachstellen meist schnell veröffentlicht und behoben. Dass die Sicherheit eines kryptographischen Verfahrens im Wesentlichen in der Geheimhaltung des Schüssels und nicht in der des Ciphers liegt, ist die wesentliche Aussage von Kerckhoff‘s Prinzip (siehe auch Lektion 3.2).

Unbekannte Chiffren werden meist von Nachrichtendiensten eingesetzt. Ihr Vorteil liegt darin, dass ein möglicher Angreifer nicht nur den Schlüssel, sondern auch die Chiffre herausfinden muss, um die Nachricht lesen zu können. Der wesentliche Nachteil ist das Fehlen einer breiten Anwenderschicht und die damit verbundenen Reviews und Tests. Es muss daher sehr viel Aufwand in die Entwicklung und Testung der Chiffre gesteckt werden, um mögliche Sicherheitslücken identifizieren zu können.

Bei den Chiffren wird zwischen symmetrischen und asymmetrischen Algorithmen unterschieden. Diese sind weiter in Lektion 3.3 und 3.4 genauer beschrieben.

Schlüssel (Key) und Keyspace

Der Schlüssel wird von der Chiffre verwendet um Variabilität und Unregelmäßigkeiten in den Algorithmus zu bringen. Damit soll sichergestellt werden, dass dieselbe Chiffre, angewendet auf denselben Klartext, durch den Einsatz unterschiedlicher Schlüssel zu unterschiedlichen Geheimtexten führt. Somit ist der Schlüssel das wesentliche, geheim zuhaltende, Element.

Welche möglichen Schlüssel für eine Chiffre angewendet werden können, wird durch den Keyspace definiert. Dieser enthält alle möglichen Schlüssel. Je größer der Keyspace ist, desto mehr unterschiedliche Schlüssel existieren. Je mehr mögliche Schlüssel auf eine Chiffre anwendbar sind, desto aufwändiger wird es für einen Angreifer eine Nachricht durch bloßes Ausprobieren unterschiedlicher Schlüssel zu entschlüsseln.

Der Cäsar Algorithmus hat beispielsweise einen Keyspace von 26 möglichen Schlüsseln, da es genauso viele Buchstaben im lateinischen Alphabet gibt. Ein Angreifer würde durch einfaches durchprobieren daher maximal 26 Versuche benötigen, wobei die Verwendung des Schlüssels A sehr unwahrscheinlich ist, da der Text damit gleich bleiben würde.

Aktuelle Cipher haben hingegen wesentlich größere Keyspaces. Beispielsweise hat AES256 (siehe Lektion 3.3) eine Schlüssellänge von 256 Bit. Daraus ergibt sich ein Keyspace von 2256 möglichen Schlüsseln. Da ein Angreifer durch zufälliges durchprobieren einen Schlüssel in der Regel nach der Hälfte der möglichen Kombinationen errät, muss er hier ca. (2256)/2 = 2255 Versuche durchführen.

Verschlüsselung (Encryption) / Entschlüsselung (Decryption)

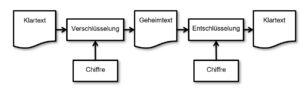

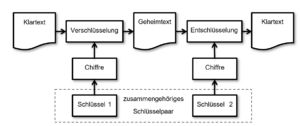

Bei der Verschlüsselung handelt es sich um die Umwandlung von Klartext in Geheimtext mittels zugehöriger Chiffre und Schlüssel und bei der Entschlüsselung um die Umwandlung des Geheimtextes zurück in den Klartext.

Der Ablauf eines Weges vom Klartext über den Geheimtext zurück zum Klartext ist in Abbildung 8 noch einmal grafisch dargestellt.

Security by Obscurity und das Kerckhoffs’sche Prinzip

Ein kryptographisches System lässt sich durch die bloße Geheimhaltung der zugehörigen Chiffre nicht gewährleisten. Dieser Versuch wird auch als Security by Obscurity bezeichnet, da hier davon ausgegangen würde, dass alleine die Unwissenheit über die Methodik der Chiffre zu mehr Sicherheit führt. Dadurch ergeben sich jedoch einige wesentliche Probleme. Die geringe Anzahl an eingeweihten Anwendern entdeckt Fehler des Ciphers spät bis überhaupt nicht. Sobald die geheime Chiffre jedoch bekannt wird, ist jede durch ihre Geheimhaltung erreichte Sicherheit gebrochen. Wurde dann nicht auf eine ausreichende Geheimhaltung und Komplexität der Schlüssel geachtet hat wird das gesamte System unbrauchbar.

Kerkhoff entwickelte 1883 die Grundprinzipien sicherer Verschlüsselung, welche bis heute Bestand haben. Einer dieser Grundsätze wird heute als das Kerhoffs‘sche Prinzip bezeichnet. Es besagt, dass nicht das System selbst, sondern der Schlüssel geheim sein muss, um eine maximale Sicherheit zu erreichen. Der Algorithmus soll immer öffentlich bekannt sein. Der Schlüssel muss dabei unbedingt geheim gehalten werden. Je mehr unterschiedliche Geheimnisse rund um ein kryptographisches System nötig sind, umso verwundbarer ist es gegenüber möglichen Angriffen, welche Teile der Geheimnisse herausfinden. [Ha13, 767]

Auch wenn das Kerhoffs‘sche Prinzip besagt, dass die Sicherheit alleinig in der Geheimhaltung des Schlüssels liegt, so hat Security by Obscurity doch auch manchmal ihre Berechtigung. So kann beispielsweise durch die Kombination mehrerer bekannter Verfahren eine Unregelmäßigkeit hergestellt werden, welche möglichen Angreifern eine Analyse erschwert und damit eine erste Hürde darstellt, die überwunden werden muss.

Eine bekannte Anwendung ist das sogenannte „Salzen“ von Hashwerten. Dabei wird dem Plaintext vor der Hashwertberechnung ein zusätzlicher Teil („Salt“) hinzugefügt. Gelingt es einem Angreifer nun anhand der Hashwerte mögliche Ausgangswerte zu konstruieren, kann er den Ursprungswert nur durch das zusätzliche Wissen des „Salts“ rekonstruieren. Die berechneten Werte sind somit unbrauchbar.

Symmetrische Verfahren

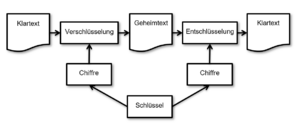

Bei einem symmetrischen kryptographischen Verfahren (Chiffre) wird ein Klartext mit ein und demselben Schlüssel verschlüsselt und auch wieder entschlüsselt (siehe Abbildung 9). Bei symmetrischen Verfahren werden Substitutions-Methoden und Transpositions-Methoden angewendet, um den Klartext unkenntlich zu machen. Diese können innerhalb der Chiffre natürlich auch beliebig kombiniert werden.

Substitutions-Methoden

Bei der Substitution handelt es sich um die Umwandlung eines Zeichens (oder Bits) durch ein anderes. Dies wären beispielsweise bei einem Cäsar 5 Algorithmus das Ersetzen des Zeichen K durch das Zeichen P zur Verschlüsselung und das Ersetzen des Zeichens P durch das Zeichen K zur Entschlüsselung. Der Schlüssel ist hierbei der Wert 5, welcher die Zuordnung des jeweiligen Zielzeichens ermöglicht.

Ein Beispiel auf Bit-Ebene ist die einfache XOR Verknüpfung des Schlüssels mit dem Text, welche ebenfalls in beide Richtungen anwendbar ist:

Klartext: 010010110101001001011001

Schlüssel: 010000010100001001000011

Geheimtext: 000010100001000000011010

Die Berechnung des Geheimtextes und des Klartextes ist dabei in beide Richtungen über die Verknüpfung mit dem Schlüssel möglich.

Ist der mittels XOR verknüpfte Schlüssel:

- gleich lang wie die Nachricht,

- zufällig generiert und

- wird dieser nur ein einziges Mal verwendet,

wird dies als One-Time-Pad bezeichnet. Diese Methode ist, ohne den Schlüssel in Besitz zu bekommen, definitiv unknackbar und damit die sicherste kryptographische Methode. Die Herausforderung besteht hierbei darin den Schlüssel sicher zu übermitteln, da dieser gleich lang wie die Nachricht sein muss. Dies ist meist nur sehr umständlich machbar und mit einem ähnlichen Aufwand verbunden, wie die Übermittlung der Nachricht selbst. One-Time-Pads werden daher eher zur Übermittlung kleinerer, hoch sensibler, Datenmengen eingesetzt. Sie könnten jedoch an Bedeutung gewinnen, da eine sichere Übermittlung von größeren Schlüsseln mittels Quantentechnologien immer praxistauglicher wird.

Transpositions-Methode

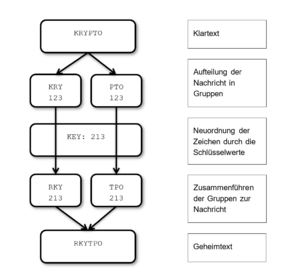

Bei der Transposition werden einzelne Teile des Textes mit anderen Teilen vertauscht. Der Schlüssel gibt dabei an, welcher Teil mit welchem vertauscht werden soll.

Ein Beispiel für eine einfache Transpositions-Methode ist in Abbildung 10 dargestellt. Dabei wird der Plaintext zuerst in Gruppen zerlegt. Diese Gruppen werden nun gemäß dem Schlüsselwert intern neu angeordnet und ergeben dann in Summe wiederum den Ausgabetext. Auch diese Methode ist in beide Richtungen – sowohl zur Ver-, als auch zur Entschlüsselung – anwendbar.

Aktuelle Kryptographie-Standards mit symmetrischen Methoden

In der nachfolgenden Tabelle 2 sind die aktuell gängigsten symmetrischen Chiffren und ihre Eckpunkte aufgelistet.

Tabelle : Gängige Standards mit symmetrischen Algorithmen

| Standard Name | Algorithmus | Schlüssellängen |

|---|---|---|

| Data Encryption Standard (DES) | Data Encryption Algorithm (DEA) | 56 Bit Schlüssel (+8 Bit Parität = 64Bit) |

| Triple-DES (3DES) | Triple Data Encryption Algorithm (TDEA) | 112 Bit |

| Advanced Encryption Standard (AES) | Rijndael |

128 Bit 192 Bit 256 Bit |

| International Data Encryption Algorithm (IDEA) | International Data Encryption Algorithm (IDEA) | 128 Bit |

| Blowfish | Blowfish | Variable Länge zwischen 32 und 448 Bit |

| RC4 | RC4 | Variable Länge |

Asymmetrische Verfahren

Bei asymmetrischen Verfahren werden zur Verschlüsselung und Entschlüsselung einer Nachricht zwei unterschiedliche Schlüssel verwendet. Die beiden Schlüssel gehören dabei immer zusammen und bilden ein Schlüsselpaar (siehe Abbildung 11). Es ist somit nicht möglich eine Nachricht mit demselben Schlüssel zu entschlüsseln, mit dem sie verschlüsselt wurde. Es kann dabei jeder der beiden Schlüssel zur Verschlüsselung einer Nachricht eingesetzt werden. Zur Entschlüsselung wird dabei immer der jeweils andere Schlüssel benötigt.

Dies ist auch vergleichbar mit einem Vorhängeschloss und einem Schlüssel. Das Schloss kann eingesetzt werden um eine Kiste zu versperren. Ohne den zugehörigen Schlüssel kann das Schloss jedoch nicht mehr geöffnet werden. Im Fall der asymmetrischen Verschlüsselung ist jeder der beiden Schlüssel gleichzeitig das Schloss des jeweils anderen Schlüssels:

- Key 1 = Schloss 2 (kann von Key 2 geöffnet werden)

- Key 2 = Schloss 1 (kann von Key 1 geöffnet werden)

Die beiden Schlüssel werden als Public-Key und Private-Key bezeichnet. Diese Bezeichnungen beruhen darauf, dass einer der beiden Schlüssel immer privat – also nur einer bestimmten Person bekannt – sein sollte. Der andere Schlüssel kann dann öffentlich an alle weitergegeben werden, die Nachrichten an den Besitzer des Private-Keys schicken wollen. Er ist somit public.

Will nun jemand eine Nachricht an den Besitzer des Private-Keys übermitteln kann er nun den dazu den Public-Key für die Verschlüsselung verwenden. Da die Nachricht nur mit dem zugehörigen Private-Key entschlüsselt werden kann, kann sie auch nur von dessen Besitzer gelesen werden. Der Public-Key ist zwar öffentlich verfügbar, jedoch zur Entschlüsselung der Nachricht nicht verwendbar.

Diese Methode kann nun auch umgekehrt verwendet werden um eine Nachricht durch den Besitzer des Private-Keys zu signieren. Dabei wird meist ein Hashwert (siehe Lektion 3.6) der Nachricht generiert, die signiert werden soll. Dieser Hashwert wird nun mit dem Private-Key verschlüsselt und an die Nachricht angehängt. Will nun ein Empfänger prüfen, ob die Nachricht tatsächlich vom Besitzer des Private-Keys stammt, muss er nur den Hashwert mit dem öffentlich verfügbaren Public-Key entschlüsseln und mit dem aktuellen Hashwert der empfangenen Nachricht vergleichen. Sind die beiden Hashwerte ident, ist somit sichergestellt, dass die Nachricht vom Besitzer des Private-Keys stammen muss, da nur er den Hashwert korrekt verschlüsseln konnte. Würde sie auf dem Weg zum Empfänger verändert worden sein, wären die Hashwerte unterschiedlich.

Asymmetrische Methoden basieren auf komplexen mathematischen Berechnungen und sind vergleichsweise langsam. Sie werden daher meist nicht für die Verschlüsselung der Nachricht, sondern nur für die Verschlüsselung eines Schlüssels für die Anwendung einer symmetrischen Methode verwendet. Damit ist sichergestellt, dass der Schlüssel sicher übertragen wird und gleichzeitig eine schnellere Ver- und Entschlüsselung der übrigen Nachricht, mittels symmetrischer Methoden, erfolgen kann.

Eine weit verbreitete asymmetrische Methode wurde 1977 von Ronald L. Rivest, Adi Shamir und Leonard Adleman entwickelt und trägt daher den Namen RSA. Sie ist eine Weiterentwicklung des Diffie-Hellmann Schlüsseltauschverfahrens (siehe Lektion 3.5). Genauso wie dieses basiert sie auf dem Einsatz von Einwegfunktionen (Einwegfunktionen ist in der nachfolgenden Lektion 3.5 genauer beschrieben). Das Schlüsselpaar wird bei RSA durch den Einsatz sehr großer Primzahlen generiert, wobei die Anwendung des ersten Schlüssels die Nachricht unkenntlich macht und die zusätzliche Anwendung des zweiten Schlüssels die Anwendung des ersten Schlüssels wieder aufhebt. Der zugehörige zweite Schlüssel der Einwegfunktion ist nur durch Primfaktorzerlegungen sehr großer Primzahlen berechenbar. Dies ist jedoch ein sehr rechen- und damit zeitaufwändiger Vorgang.

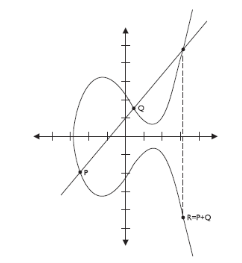

Eine weiter asymmetrische Methode ist die der Elliptic Curve Cryptographie (ECC). Sie basiert auf der Berechnung von Punkten entlang einer elliptischen Kurve in einem zweidimensionalen Koordinatensystem. Dabei werden eine bestimmte Kurve und ein Startpunkt angegeben. Das Schlüsselpaar ergibt sich dann durch die Koordinaten eines Zielpunkts und der Anzahl der nötigen Schritte, die nötig sind, um vom Startpunkt aus zu ihm zu gelangen. Ähnlich der Berechnung der Multiplikation zweier Primzahlen ist und der Schwierigkeit einer Rückrechnung mittels Primfaktorzerlegung ist es einfach einen Punkt auf der Kurve zu berechnen, jedoch schwierig die Anzahl der nötigen Schritte zu ermitteln, die nötig sind um zu diesem Punkt zu gelangen. Ein Beispiel einer solchen Elliptic Curve ist in Abbildung 12 dargestellt.

Die ECC Methoden sind stärker als die herkömmlichen asymmetrischen Methoden. Sie können sehr gut als performante Hardwarekomponenten implementiert werden und eignen sich daher besonders für den Einsatz in mobilen Endgeräten mit geringer Rechenleistung.

Schlüsseltauschverfahren

Eine wesentliche Herausforderung der verschlüsselten Datenübertragung ist der Schlüsseltausch. Es muss daher eine Methode gefunden werden den nötigen Schlüssel zur Entschlüsselung der Nachricht an den Empfänger zu übermitteln, ohne dass dieser abgefangen werden kann. Würde der Schlüssel einfach vor der Übermittlung einer Nachricht übertragen werden, dann könnte ein möglicher Angreifer sowohl den Schlüssel, als auch den verschlüsselte Nachricht abfangen und dann beides gemeinsam einsetzen und die Nachricht einfach entschlüsseln.

Um dieses Problem zu lösen gibt es einige Methoden, die daher auch als Schlüsseltauschverfahren bezeichnet werden.

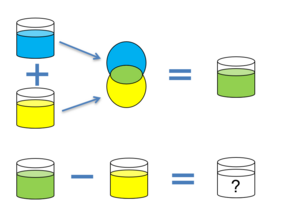

Die erste veröffentlichte mögliche Schlüsseltausch-Methode wurde 1976 von Diffie und Hellmann entwickelt. Sie basiert auf dem Einsatz von mathematischen Einwegfunktionen. Eine Einwegfunktion ist eine Funktion, welche leicht berechnet werden kann, deren Rückrechnung jedoch sehr schwierig ist. Dies lässt sich mit dem Mischen zweier Farbkübel zu vergleichen: Es ist zwar leicht zwei Farben zu mischen, jedoch enorm aufwändig sie wieder in ihre ursprünglichen Farbtöne aufzuteilen (vgl. Abbildung 13) und manuell nur durch ausprobieren möglich.

Dies macht sich der Diffie-Hellmann Schlüsseltausch nun zu Nutze, indem er mathematische Einwegfunktionen verwendet um einen gemeinsamen und geheimen Schlüssel über eine unsichere Leitung auszutauschen. Die Vorgehensweise ist nachfolgend durch ein Beispiel mit Farbkübeln beschrieben und dann anschließend mathematisch erklärt.

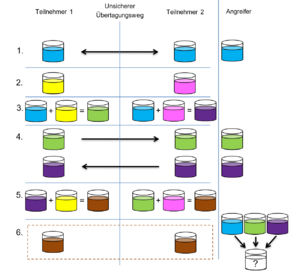

Der Ablauf ist dabei folgendermaßen:

- Beide Teilnehmer vereinbaren eine gemeinsame (nicht geheime) Farbe.

- Jeder Teilnehmer generiert eine eigene geheime Farbe, nur er selbst kennt.

- Nun mischen sie jeweils die geheime Farbe zur gemeinsamen Farbe.

- Danach übermitteln sie sich gegenseitig die Mischungen.

- Jeder Teilnehmer mischt seine eigene geheime Farbe zur empfangenen Mischung des anderen. Damit haben nun beide einen Farbkübel mit derselben Mischung aus: gemeinsame Farbe + eigene geheime Farbe + geheime Farbe des anderen.

- Die gemeinsame Mischung kann nun als Schlüssel für den geheimen Nachrichtenaustausch verwendet werden.

Die einzelnen Schritte des Schlüsseltauschs sind in Abbildung 14 noch einmal bildlich dargestellt. In der rechten Spalte ist ersichtlich welche Informationen ein möglicher Angreifer mithören kann. Er gelangt zwar an die gemeinsame Farbe und an die beiden Mischungen. Es ist ihm jedoch nicht möglich die geheimen Farben zu ermitteln. Damit fehlt ihm auch die Möglichkeit den gemeinsamen Schlüssel herauszufinden.

Mathematisch betrachtet basiert der Diffie-Hellmann Schlüsseltausch auf dem diskreten Logarithmus-Problem und wird mit Hilfe folgender Formel abgebildet:

n = gk mod p

Das diskrete Logarithmus-Problem beschreibt die Schwierigkeit für gegebene Werte der Variablen n, g und der Primzahl p den Wert der Variablen k zu finden. Bei kleinen Werten ist eine Berechnung von k noch machbar. Je größer sie jedoch werden, desto länger wird die dafür benötigte Zeit, da ein Rückrechnen nur durch Ausprobieren möglich ist. Für jedes zusätzliche Bit des Wertes müssen doppelt so viele Versuche angewendet werden.

Beim Schlüsseltausch sind g und p nun die gemeinsamen Werte (gemeinsame Farbe), welche öffentlich übermittelt werden und n das jeweilige Mischergebnis. k ist dabei der jeweils geheime Wert (eigene geheime Farbe), welcher niemals übermittelt wird.

Um zur gemeinsamen Farbmischung zu kommen macht sich der Schlüsseltausch nun zu Nutze, dass (x a) b gleich (x a) b und damit x a b ist. Sind a und b nun die beiden geheimen Zahlen können sie zum jeweils anderen Ergebnis hinzugefügt werden, ohne den jeweiligen Exponenten der anderen Seite zu kennen. Übermittelt wird hierbei immer nur das Ergebnis.

Angewendet auf die oben genannte Formel des diskreten Logarithmus-Problems ergibt sich nun folgender Ablauf des Schlüsseltauschs:

- Die gemeinsamen Werte für g und p werden übermittelt

- Beide Teilnehmer generieren eine geheime Zahl (Teilnehmer A: a; Teilnehmer B: b)

- Sie berechnen nun jeweils aus q, p und ihrer eigenen geheimen Zahl (a bzw. b) den Wert zur Übermittlung:

Teilnehmer A: A = ga mod p

Teilnehmer B: B = gb mod p

- Teilnehmer A übermittelt nun den Wert A an Teilnehmer B und Teilnehmer B den Wert B an Teilnehmer A.

- Nun können beide Teilnehmer mit ihrer eigenen geheimen Zahl den gemeinsamen Schlüssel K berechnen:

Teilnehmer A: K = Ba mod p

Teilnehmer B: K = Ab mod p

- Beide Teilnehmer können nun K zur Verschlüsselung ihrer geheimen Nachrichten verwenden.

Das Ba mod p gleich Ab mod p ist, kann mittels gegenseitigem Einsetzen bewiesen werden:

K = Ba mod p = (gb mod p)a mod p = gb a mod p

K = Ab mod p = (ga mod p)b mod p = ga b mod p

K = gb a mod p = ga b mod p

Da ein möglicher Angreifer jedoch nur in Besitz der Werte g, p, A und B kommt, kann er den Schlüssel K nur mit enorm hohem Aufwand ermitteln.

Auf dem Grundprinzip von Diffie-Hellmann wurde später mit RSA (siehe Lektion 3.4) die asymmetrischen Verschlüsselungsmethoden entwickelt. Die Diffie-Hellmann Methode wurde inzwischen auch um die verstärkte Sicherheit von Elliptic Curves erweitert und findet ihre diesbezügliche Verbreitung unter dem Namen Elliptic Curve Diffie-Helman (ECDH).

Hashing

Beim Hashing handelt es sich um die Anwendung einer nicht reversiblen Funktion, auf einen bestimmten Wert. Das Ergebnis einer Hash-Funktion ist somit nicht auf den Ausgangswert umkehrbar. Dabei wird meist ein Wert variabler Länge zu einem Wert fixer Länge umgewandelt, der dem Ursprungswert nicht mehr ähnelt.

Ein guter Hash-Algorithmus hat möglichst wenige Kollisionen. Das bedeutet, dass die Wahrscheinlichkeit bei unterschiedlichen Eingangswerten denselben Ausgangswert zu bekommen sehr gering ist.

Das nachfolgende Beispiel in Tabelle 3 zeigt mögliche Hashwerte einer fiktiven Hashfunktion HashMe(). Die letzten beiden Zeilen sind ein Beispiel einer Kollision.

Tabelle : Beispiel Hashfunktion HashMe()

| Eingangswert | Hashwert = HashMe(Eingangswert) | |

|---|---|---|

| Peter | 0c74c6051287c95d |

|

|

Guten Tag! Hiermit nehme ich Ihr Angebot mit der Nummer 12334 an. Mit freundlichen Grüßen, Miriam Muster |

878b87429ff50296 |

|

| Mich gibt es hoffentlich nur einmal! | ae4692a6f28a03cd | Kollision |

| 45667533423233467885354 |

ae4692a6f28a03cd |

Da ein Hashwert einer bestimmten Nachricht immer gleich ist, eignet er sich sehr gut zur Integritätsprüfung. Sobald sich ein Teil der Nachricht ändert, ändert sich auch der Hashwert. Das Vorhandensein einer Änderung der Nachricht kann somit einfach durch den Vergleich des Original-Hashwertes und des aktuellen Hashwertes aufgezeigt werden.

Dieses Prinzip wird auch bei digitalen Signaturen verwendet. Dabei wird ein Hashwert der zu signierenden Nachricht generiert und mit dem Private-Key (Siehe Lektion 3.4) des Absenders verschlüsselt. Dieser wird der Nachricht dann als Signatur beigefügt. Der Empfänger kann nun den Hashwert mit dem Public-Key entschlüsseln und mit dem aktuellen Hashwert der empfangenen Nachricht vergleichen. Sind die beiden Werte gleich ist sichergestellt, dass:

- sich der Inhalt der Nachricht nicht verändert hat und

- der Besitzer des Private-Key ist auch der Absender der Nachricht ist, da nur er eine Verschlüsselung durchführen kann, welche mit dem zugehörigen Public-Key korrekt entschlüsselt wird.

Da mit Hash-Werten die Integrität von Nachrichten geprüft werden kann, werden diese auch oft als Fingerprint oder Message-Digest bezeichnet.

Einige derzeit gängige Hash-Algorithmen sind in Tabelle 4 aufgelistet.

Tabelle : Gängige Hash-Algorithmen

| Standard Name | Länge des Hash-Wertes | Anmerkung |

|---|---|---|

| MD4 | 128 Bit | Optimiert für schnelle Berechnung |

| MD5 | 128 Bit | Komplexerer Algorithmus als MD4 und daher langsamere Berechnung |

| SHA | 160 Bit | Ähnlich wie MD4 |

| HAVAL | Variable Länge | Ähnlich wie MD5 |

| Tiger | 192 Bit |

Ähnlich wie MD4 Optimiert für 64 Bit Systeme |

Angriffsvektoren der Kryptographie

Die möglichen direkten Angriffsvektoren der Kryptographie teilen sich in die, nachfolgend beschriebenen, Kategorien:

- Brute-Force Angriffe,

- Kryptoanalyse und

- Angriffe gegen Hashwerte.

Um die genannten Angriffe ausführen zu können, ist es meist erforderlich den zugehörigen Datenverkehr abzuhören und gegebenenfalls auch zu manipulieren. Dazu werden oft Sniffing- und Man-in-the-Middle-Attacken genutzt, welche später in Lektion 5.6 genauer beschrieben werden.

Brute-Force Angriffe

Bei Brute-Force Angriffen wird versucht eine Verschlüsselung zu knacken, indem eine Vielzahl möglicher Schlüssel ausprobiert wird. Dabei steigt mit der Länge der Schlüssel auch die Anzahl der dazu nötigen Versuche (siehe auch Lektion 3.1.4).

Die Stärke einer Chiffre wird daher auch dadurch angegeben, wie lange es dauern würde, durch einen Brute-Force Angriff einen möglichen Schlüssel zu finden.

Um die Möglichkeiten einzuschränken wird daher oft die Methode des Wörterbuchangriffs eingesetzt. Dabei werden keine beliebigen Schlüssel generiert, sondern stattdessen Einträge eines Wörterbuches bzw. einer Liste häufig eingesetzter Schlüssel (bzw. Passwörter) verwendet. Diese Listen werden meist auch nach der statistischen Häufigkeit der Verwendung der Begriffe gereiht, um die am häufigsten genutzten Passwörter auch zuerst zu versuchen. Die zugehörigen Statistiken werden dabei aus bereits im Internet veröffentlichten oder gestohlenen Passwortlisten generiert.

Da der Aufwand eines Angriffes mit der Länge der verwendeten Schlüssel zunimmt, kann ihm besonders durch den Einsatz langer Schlüssel begegnet werden. Auch ist es wichtig Passwörter zu verwenden, welche nicht durch Wörterbücher und Passwortlisten generiert werden können.

Kryptoanalyse

Bei der Kryptoanalyse handelt es sich um ein Teilgebiet der Kryptographie. Sie hat zum Gegenstand aus möglichen bekannten Teilen eines kryptographischen Systems (Klartext, Geheimtext, Chiffre) nicht bekannte Teile herauszufinden.

Da der Algorithmus einer Chiffre in der Regel bekannt ist, kann die Kryptoanalyse diesen als Basis verwenden. Um nun den Schlüssel oder den Klartext rekonstruieren zu können, stehen dem Analytiker folgende Analysemethoden zur Verfügung:

- Ciphertext-Only (der Analyse steht nur der Geheimtext zur Verfügung),

- Known-Plaintext (der Analyse steht der Geheimtext und der Klartext zur Verfügung),

- Chosen-Plaintext (der Analyse steht der Geheimtext zur Verfügung und der Klartext kann für die Analyse frei gewählt werden) und

- Chosen-Ciphertext (der Analyse steht der Klartext zur Verfügung und der Geheimtext kann für die Analyse frei gewählt werden).

Angriffe gegen Hashwerte

Angriffe gegen Hashwerte haben das Ziel Kollisionen zu finden, die zu einem gesuchten Hashwert führen. Werden beispielsweise Passwörter als Hash gespeichert und kommt ein Angreifender in den Besitz dieser Daten, kann er die Passwörter nicht einfach aus den Werten berechnen, da Hashwerte nicht reversibel sind.

Es ist jedoch möglich (ähnlich wie einem Brute-Force Angriff 3.7.1) aus einer Liste von Passwörtern mögliche Hashwerte zu berechnen und diese dann mit den Hashwerten zu vergleichen.

Da diese Listen sehr groß (einige Terrabyte und mehr) werden können und damit auch nur sehr schwer zu durchsuchen sind, wurde die Methode der Rainbow-Tables entwickelt. Dabei handelt es sich um eine näherungsweise Suche, die mögliche Teilstücke des Hashwerts berechnet. Die Suche erfolgt damit in mehreren Schritten verknüpften Tabellen, ist jedoch wesentlich schneller als die Suche in einer enorm großen Liste. Der Name Rainbow-Tables kommt dabei von einer der ersten grafischen Darstellungen der zugehörigen Methode. Dabei wurden die einzelnen Schritte (Tabellen) in unterschiedlichen Farben dargestellt.

Diesem Angriff kann entgegengewirkt werden, indem die Passwortlänge erhöht wird und indem der Hashwert bei der Berechnung zusätzlich „gesalzen“ wird. Durch die Erhöhung der Länge wird die nötige Menge der vorausberechnenden Werte entsprechend höher, was einen Angriff auf lange Passwörter entsprechend erschwert. Beim Salzen wird dem Passwort vor der Hashwertberechnung ein zusätzlicher Wert hinzugefügt. Dieser Wert wird als „Salt“ bezeichnet. Kann dieser Ausgangswert nun mittels Rainbow-Tables ermittelt werden, handelt es sich um den gesalzenen Wert und nicht um das tatsächliche Passwort. Die Angreifenden müssten daher einerseits den Salt kennen und dann sehr aufwändig eine eigene Rainbow-Table generieren, die ebenfalls diesen Salt anhält.

Wiederholungsaufgaben/Übungen

3.8.1 Erklären Sie den Cäsar-Algorithmus anhand der Verschlüsselung des Wortes "WIBA" durch Cäsar 5.

3.8.2 Erklären Sie die Begriffe Klartext, Geheimtext, und Chiffre. Stellen Sie Ihre Zusammenhänge bei der Verschlüsselung und Entschlüsselung grafisch dar.

3.8.3 Erklären Sie den Begriff “Security by Obscurity“?

Welches Prinzip spricht dagegen?

3.8.4 Wodurch unterscheiden sich symmetrische und asymmetrische Kryptographie-Verfahren?

3.8.5 Wie läuft der Diffie-Hellmann Schlüsseltausch ab.

Erklären Sie ihn anhand eines einfachen Beispiels mit Farbkübeln ODER mathematisch.

3.8.5 Was ist Hashing und wozu wird es eingesetzt?

3.8.6 Was ist ein Brute-Force Angriff?

Zugriffssteuerung

Die Zugriffssteuerung (Access Control) regelt den Zugriff und die Kommunikation von IT-Systemen mit ihren Anwendern, Ressourcen und anderen IT-Systemen. Es handelt sich dabei um eine zentrales Element der meisten IT-Systeme, da davon alle Schutzziele (Vertraulichkeit, Integrität und Verfügbarkeit; siehe Lektion 1.3) betroffen sein können.

In dieser Lektion werden die grundlegenden Begriffe der Zugriffssteuerung erläutert und weiter die konkreten Techniken der Zertifikate und der Fernzugriffe sowie potentielle Angriffsvektoren näher behandelt.

Grundbegriffe der Zugriffssteuerung

Um die Schutzziele der Vertraulichkeit, Integrität und Verfügbarkeit des Datenaustausches mit IT-Systemen gewährleisten zu können müssen die jeweiligen Anforderungen an die Kommunikation definiert werden. Dabei gibt es einige wesentliche Begriffe, welche oft auch von Technikern falsch verwendet werden. Beispielsweise werden Identifikation, Authentifikation und Autorisation manchmal fälschlicherweise als Akronyme verwendet, obwohl es sich dabei um grundlegend unterschiedliche Begriffe handelt. Auch ist es wichtig zu wissen, wie bestimmte Anforderungen an die Zugriffssteuerung implementiert werden können.

Zugriff

Beim Zugriff handelt es sich um die Kommunikation mit einem IT-System. Diese kann sowohl mit einem Anwender, als auch mit einem anderen IT-System oder seiner Ressourcen stattfinden. In den meisten Fällen gibt es dabei Anforderungen an Identifikation, Authentifikation und Autorisation, sowie an die Nachverfolgbarkeit und Nichtabstreitbarkeit (siehe weiter auch 4.1.2, 4.1.3, 4.1.4 und 4.1.5).

Ressourcen können dabei alle Komponenten sein, welche einen Zugriff auf Daten ermöglichen oder diese beinhalten, wie beispielsweise: Datenbanken, Tabellen und Dateien. Die Zugriffe können dabei sowohl über lokale Verbindungen, als auch über das Netzwerk/Internet oder unterschiedliche Datenträger erfolgen.

Identifikation

Die Identifikation bezeichnet die Benennung eines bestimmten Systems oder einer Person, welche auf ein System zugreifen möchte. Dabei ist weder sichergestellt durch wen diese Benennung erfolgt ist, noch ob es sich bei der Benennung tatsächlich um das benannte System oder die benannte Person handelt.

Zur Identifikation dienen oft die eindeutige User-ID, die E-Mailadresse oder der Name.

Ein Beispiel ist eine Anwesenheitsliste: Die Protokollführung schreibt die Namen der anwesenden Personen auf, welche diese wiederum identifizieren. Dabei ist jedoch noch nicht sichergestellt, ob die jeweiligen Personen tatsächlich die sind, die sie vorgeben zu sein. Im schlechtesten Fall sind sie der Protokollführung nicht bekannt und identifizieren sich durch Nennung ihres Namens.

Authentifikation

Die eindeutige Identifikation einer Person oder eines Systems wird als Authentifikation bezeichnet. Erst dadurch wird sichergestellt, dass es sich dabei tatsächlich um die Identifizierten handelt.

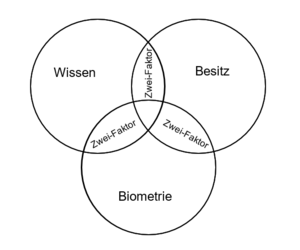

Es gibt drei unterschiedliche Kategorien von Authentifikationsmethoden und -merkmale:

- Wissen (was jemand weiß),

- Besitz (was jemand besitzt) und

- Biometrie (was jemand ist).

Die drei Merkmale Wissen, Besitz und Biometrie werden oft auch als „Wissen, Haben und Sein“ bezeichnet.

Eine häufig eingesetzte Methode ist das Passwort. Dieses ist in der Kategorie des Wissens eingeordnet, da es von jedem eingesetzt werden kann, der es kennt. Es kann daher auch weitergegeben oder ausgespäht werden. Je komplexer es ist, desto leichter kann es auch vergessen werden. Je häufiger es verwendet wird, desto schneller kann es herausgefunden werden. Zu komplexe Passwörter sind daher keine gute Lösung zur sicheren Authentifikation, da sie von vielen Usern vergessen oder aufgeschrieben werden. Dasselbe gilt für zu einfache Passwörter, da sie leicht erraten werden können.

Beim Merkmal des Besitzes wird die Authentifikation über etwas erreicht, dass nur der zu Authentifizierende besitzt. Beispiele dafür sind ein Personalausweis oder eine Chipkarte (z.B. eine Bankomatkarte). Damit die Weitergabe dieses Merkmals überhaupt nicht, oder nur sehr schwierig möglich ist, sollte es möglichst nicht vervielfältigt werden können.

Unter Biometrie werden Merkmale verstanden, die an eine bestimmte Person (oder ein bestimmtes System) gebunden sind. Sie sind öffentlich sichtbar oder beobachtbar, jedoch nicht leicht duplizierbar. Häufig bekannte Beispiele für biometrische Merkmale sind Fingerabdrücke, Venenmuster, die Iris-Muster der Augen und Stimmmuster. Weitere, oft weniger bekannte, Merkmale sind jedoch auch die Art des Ganges einer Person, ihre Tastenanschläge, ihr Schreibstil und aber auch die Art und Weise wie sie sich innerhalb eines Programmes oder einer Webseite bewegen.

Je nach Sicherheitsanforderungen können dabei auch mehrere Merkmale kombiniert werden um die Authentifizierungsqualität noch weiter zu verstärken. Ein bekanntes Beispiel dafür ist die zur Bargeldbehebung mittels Bankomatkarte notwendige Authentifizierung. Dabei wird ein Besitzmerkmal (Bankomatkarte) mit einem Wissensmerkmal (PIN-Code) kombiniert. Ist jemand im Besitz der Karte, benötigt er zusätzlich noch den PIN-Code und umgekehrt. Mit einem der beiden Merkmale allein kann keine gültige Authentifikation erfolgen und damit auch kein Geld behoben werden.

Werden zwei Merkmale kombiniert, wird dies auch als Zwei-Faktor-Authentifizierung bezeichnet. Wichtig ist dabei immer, dass zwei Merkmale unterschiedlicher Kategorien (Wissen, Besitz und Biometrie) kombiniert werden. Die Kombination zweier Merkmale derselben Kategorie, erhöht zwar die Sicherheit, gilt dabei jedoch nicht als Zwei-Faktor-Authentifizierung. Die einzelnen Merkmalskategorien und die sich daraus ergebenen Authentifizierungslevel sind weiter in Abbildung 15 dargestellt.

Ob die Authentifizierungsqualität durch den Einsatz von drei Faktoren weiter stark erhöht werden kann, ist umstritten. Dies ist stark von den jeweils eingesetzten Techniken, aber auch von deren Akzeptanz bei den Anwendern, abhängig.

Autorisation

Bei der Autorisation handelt es sich um die Berechtigung, die eine authentifizierte Person oder ein authentifiziertes System für einen bestimmten Zugriff hat. So können in einem System beispielsweise unterschiedliche Rollen existieren, welche wiederum unterschiedliche Zugriffe ermöglichen. Wie ein System unterschiedliche Autorisationen verwaltet und behandelt wird als Zugriffssteuerungsmodell bezeichnet. Die unterschiedlichen Arten von Zugriffssteuerungsmodellen sind nachfolgend in 4.1.6 genauer beschrieben.

Die Authentifikation stellt damit sicher, dass es sich um jemand bestimmten handelt und die Autorisation regelt wiederum welche bestimmten Rollen welche Zugriffe bekommen.

Nachverfolgbarkeit und Nichtabstreitbarkeit

Bei der Nachverfolgbarkeit und Nichtabstreitbarkeit handelt es sich um Zugriffsmerkmale, welche eine genaue Dokumentation der jeweiligen Systemkommunikation ermöglichen. Je nach Anforderung wird dabei dokumentiert, welche Zugriffe stattgefunden haben und unter welchen (Sicherheits-)Parametern diese aufgebaut wurden. Um eine lückenlose Nachverfolgbarkeit sicherzustellen, ist es erforderlich, den Erfolg der Authentifikation und die erteilte Autorisation zu dokumentieren.

In manchen Fällen ist es weiter erforderlich eine Nichtabstreitbarkeit von Zugriffen zu ermöglichen. Als Nichtabstreitbarkeit wird bezeichnet, das eine Person die Erstellung einer gesendeten Nachricht nicht mehr abstreiten kann. Dies beinhaltet auch automatisch die Integrität der Nachricht. Es muss daher für eine Nichtabstreitbarkeit auch sichergestellt sein, dass die Nachricht nicht mehr verändert wurde, da anderenfalls der Absender behaupten könnte, ursprünglich eine andere Nachricht erstellt zu haben.

Die Nichtabstreitbarkeit kann mit Hilfe asymmetrischer Kryptographie Methoden sichergestellt werden (siehe Lektion 3.4). Dabei wird der Hashwert einer Nachricht mit dem privaten Schlüssel des Absenders verschlüsselt. Zur Prüfung der Integrität (ob die Nachricht der abgesendeten Nachricht entspricht), muss nun nur noch der verschlüsselte Hashwert mit dem öffentlichen Schlüssel entschlüsselt und mit dem aktuellen Hashwert der Nachricht verglichen werden. Da die Verschlüsselung nur vom Besitzer des privaten Schlüssels durchgeführt werden kann, ist hier eine Nichtabstreitbarkeit gewährleistet.

Zugriffssteuerungsmodelle

Zugriffssteuerungsmodelle (Access Control Models) regeln die Art und Weise von Zugriffen. Sie definieren dabei die möglichen Regeln und Ziele der Zugriffe und stellen diese den jeweiligen Zugriffssteuerungstechnologien zur Verfügung. Die Modelle sind ein wesentlicher Bestandteil des jeweiligen Betriebssystems, da sie grundlegende Entscheidungen der internen Zugriffe beeinflussen. Sie sind daher direkt im Kern des Betriebssystems integriert. [Ha13, 219]

Es wird zwischen drei verschiedenen Kategorien von Zugriffssteuerungsmodellen unterschieden:

- Eigner-definierte Zugriffssteuerung (DAC: Discretionary Access Control),

- Obligatorische Zugriffssteuerung (MAC: Mandatory Access Control) und

- Rollenbasierte Zugriffssteuerung (RBAC: Role Based Access Control).

Da eine gleichzeitige Unterstützung mehrerer Modelle meist nicht sinnvoll realisierbar ist, ist die Modellauswahl eine grundlegende Entscheidung für das IT-System. Das am häufigsten anzutreffende Modell ist das der Eigner-definierten Zugriffssteuerung.

Eigner-definierte Zugriffssteuerung

Bei der Eigner-definierten Zugriffssteuerung haben alle Daten einen definierten Eigner (oft auch als Besitzer bezeichnet). Dieser ist fest mit den Daten oder der Datei verbunden. Der Eigner definiert, welche Personen oder Systeme Zugriff auf die Daten erhalten und in welcher Form (z.B.: lesen, schreiben, ändern, ausführen oder verweigern).

Die Zugriffsberechtigungen sind dabei meist über Access Control Lists (ACL‘s) definiert. Dabei handelt es sich um eine Auflistung aller Berechtigten und der jeweils zugeordneten Rechte.

Dieses Modell ist in aktuellen Windows-, Linux- und Mac-Systemen anzutreffen. In diesen Systemen hat jede Datei einen Besitzer und eine entsprechende ACL zugeordnet.

Einzelne User und Systeme können hier meist in Berechtigungsgruppen zusammengefasst werden. In diesem Fall können die ACL’s sowohl Zuordnungen einzelner User und Systeme, als auch Berechtigungsgruppen enthalten.

Obligatorische Zugriffssteuerung

Die obligatorische Zugriffssteuerung findet ihre Anwendung in Bereichen mit sehr hohem Sicherheitsbedarf. Sie kommt daher meist in behördlichen und militärischen Systemen zum Einsatz.

In diesem Modell ist keine individuelle Behandlung einzelner User und Dateien vorgesehen. Der Zugriff ist abhängig von unterschiedlichen Sicherheitsstufen, auf denen sich Daten und User befinden. Meist ist dabei eine Änderung von Dateiberechtigungen durch die User nicht möglich.

Die Umsetzung der Sicherheitsstufen erfolgt durch Vertrauens-Levels (Clearance) für User und Sensitivitäts-Labels für Dateien. Mögliche Sicherheitsstufen wären z.B.: nicht vertraulich, vertraulich, geheim und streng geheim.

Der Zugriff auf Daten erfolgt gemäß den jeweiligen Sicherheitsstufen. Sind die Stufe der Datei und die Stufe des Users ident, darf er auf die Daten zugreifen. Ob er auf Daten von darunterliegenden Stufen zugreifen darf, kann unterschiedlich implementiert sein. Meist dürfen Informationen nur von niedrigeren Levels zu höheren Levels übertragen werden und nicht umgekehrt. Zugriffe zwischen unterschiedlichen Levels werden dabei meist auch von eigenen Überwachungsdienstprogrammen gesteuert und genehmigt.

Zusätzlich werden meist hierarchische Zuordnungen vergeben, in denen sich sowohl Daten, als auch User befinden können. Die hierarchische Zuordnung steht dann nochmals über der Zuordnung des Sicherheitslevels. Damit ist sichergestellt, dass die Zugriffe nicht nur gemäß des Vertrauens-Levels, sondern auch gemäß der Zugriffs-Notwendigkeit erfolgen. Befindet sich ein User nicht in derselben hierarchischen Zuordnung, wie die jeweiligen Daten, wird davon ausgegangen, dass er keinen Zugriff benötigt und der Zugriff daher verweigert.

Ein frei verfügbares Betriebssystem, welches das Modell der obligatorischen Zugriffssteuerung einsetzt, ist beispielsweise SE Linux [Na09].

Rollenbasierte Zugriffssteuerung

Bei der rollenbasierten Zugriffssteuerung werden Organisationsrichtlinien und -abläufe in ein Zugriffsmodell übersetzt. Dabei werden einzelnen Usern oder Systemen bestimmte (Organisations-)Rollen zugeordnet. Der Zugriff auf Daten hängt dabei von der jeweiligen Rolle des Zugreifenden ab. Die Berechtigung wird bei jedem Zugriffsversuch überprüft und dann genehmigt oder abgewiesen.

Bei den hier eingesetzten Rollen handelt es sich nicht um Gruppen im Sinne der Eigner-definierten Zugriffssteuerung, sondern um Rollen innerhalb des jeweiligen Geschäftsprozesses bzw. einer Organisationseinheit. So kann ein User eine Rolle haben, die ihm aus einer Anwendung heraus Zugriff auf einen Datensatz gestattet und aus einer anderen Anwendung nicht mehr, obwohl es sich um denselben Datensatz handelt. Wichtig ist dabei immer die Betrachtung des aktuellen Zwecks des Zugriffes.

Die Implementierung rollenbasierter Zugriffssteuerungen ist daher auch komplexer als die der Eigner-definierten Zugriffssteuerung.

Passwortsicherheit

Wie bereits in Lektion 3 beschrieben, hat die sichere Speicherung von Passwörtern eine hohe Priorität und sollte in einer entsprechend sicheren Architektur erfolgen. Zusätzlich zur technischen Sicherheit ist eine entsprechende Passwortkomplexität von besonderer Relevanz. Ein noch so effizient abgesicherter Passwortspeicher verliert an Bedeutung, wenn das darin gespeicherte Passwort selbst unsicher ist.

Ein unsicheres Passwort hat entweder:

- eine zu geringe Komplexität und kann daher durch Bruteforce- oder Hash-Kollisions-Angriffe (siehe auch Kapitel 3.7.1 und 3.7.3) gefunden werden, oder

- kann durch Social Engineering (siehe auch Kapitel 2.3) herausgefunden werden (z.B.: Name des Kindes mit Jahreszahl, Anfangsbuchstaben des Titels des Lieblingsliedes, usw.).

Die Komplexität eines Passwortes ergibt sich aus der Entropie – also den möglichen unterschiedlichen Kombinationen bzw. dem Keyspace (siehe Kapitel 3.1.4). Daraus und an der Anzahl an Passwörtern, welche pro Sekunde geprüft werden können, ergibt sich dann wiederum die Dauer, in welcher das Passwort durch Ausprobieren (Bruteforce-Angriff) gefunden werden kann.

Für die Komplexität von Passwörter galt lange eine bestimmte Mindestlänge (meist 8 Zeichen) und eine Kombination aus den Merkmalen:

- Kleinbuchstaben,

- Großbuchstaben,

- Ziffern und

- Sonderzeichen

als ausreichender Schutz.

Beispielsweise ein Passwort „f9D22+P#“ mit 8 Zeichen und Erfüllung aller oben genannten Kriterien hat somit folgende Komplexität:

- 26 Kleinbuchstaben +

- 26 Großbuchstaben +

- 10 Ziffern +

- 36 Sonderzeichen (alle Sonderzeichen der deutschen Tastatur)

- = 98 Mögliche Zeichen pro Stelle.

- Bei 8 Zeichen sind das 98^8 Mögliche Passortkombinationen.

Ein Hochleistungs-PC, welcher 2.148.000.000 Passwörter in der Sekunde ausprobieren kann, benötigt somit durchschnittlich ca. 23 Tage um das Passwort herauszufinden.

Ein Problem solcher komplexen Passwörter ist, dass es für die meisten User schwierig ist, sie sich zu einzuprägen. Dadurch besteht ein erhöhtes Risiko, dass die Passwörter:

- vergessen werden,

- auf einem Zettel notiert werden,

- nicht ausreichend oft geändert werden oder

- nur minimal geändert werden – beispielsweise durch simple Variation einzelner Teile des Passwortes, wie einer Ziffer am Ende.

Aufgrund der oben genannten Schwächen und der dennoch geringen Entropie noch gut merkbarer Passwortlängen, können diese Passwortrichtlinien nicht mehr als Stand der Technik betrachtet werden. Eine wesentlich bessere Möglichkeit ist die Nutzung von zufälligen Wörtern aus dem Wörterbuch. [Ga17]

Bei der Nutzung von vier zufälligen Wörtern aus dem Wörterbuch (kein Satz, sondern tatsächlich zufällig gewählte Wörter), ergibt sich bei Nutzung der 100.000 unterschiedlichen Wörter des Österreichischen Wörterbuchs [AF20] folgende Komplexität:

- 100.000 mögliche Wörter pro „Stelle“ (ein Wort ist somit eine Stelle).

- Bei 5 Wörtern sind das 100.000^4 Mögliche Passortkombinationen.

Ein Hochleistungs-PC (der selbe PC wie im ersten Beispiel), welcher 2.148.000.000 Passwörter in der Sekunde ausprobieren kann, benötigt somit durchschnittlich ca. 738 Jahre um das Passwort herauszufinden.

Ein Beispiel für ein Passwort aus 4 unzusammenhängenden Wörtern aus dem deutschen Duden ist: „Dachs faul logisch Gerät“.

Das Passwort weißt somit eine wesentlich höhere Entropie auf und ist für einen Menschen gleichzeitig leichter merkbar.

Leider ist diese Form der Passwörter in vielen Systemen noch nicht implementiert und es werden noch die veralteten Komplexitätsmerkmale des ersten Beispiels abgerufen. Diese Hürde kann ganz einfach überwunden werden, indem am Ende des Passworts eine Ziffer und ein Sonderzeichen gestellt werden. Da diese keine wirkliche Relevanz für die genannte Passwortsicherheit haben, können hier auch Zeichen genutzt werden, die schnell zu tippen sind. Das oben genannte Passwort könnte damit dann einfach „Dachs faul logisch Gerät 9+“ lauten.

Zertifikate

Zertifikate dienen der Feststellung der Identitäten von Personen und Systemen auf digitalem Wege. Ein Zertifikat ist ein digitales Dokument, indem bestimmte Daten angegeben sind, welche eine Person oder ein System und optional auch zugehörige Eigenschaften identifizieren. Zertifikate sind wesentliche Bestandteile von Public-Key-Systemen und enthalten zusätzlich den jeweiligen Public-Key des Zertifikatsinhabers (siehe auch Lektion 3.4).

Um die Echtheit eines Zertifikats zu bestätigen, kann dieses von anderen Stellen signiert werden. Diese Stellen werden als Zertifizierungsstellen (CA: Certification Authority) bezeichnet. Die Signatur erfolgt dabei, wie in Lektion 3.4 beschrieben, durch hashen des Zertifikates und Verschlüsselung des Hashwertes durch den privaten Schlüssel der Zertifizierungsstelle. Da der öffentliche Schlüssel – wiederum durch das Zertifikat der Zertifizierungsstelle – bekannt ist, kann der Hashwert korrekt entschlüsselt, und die Signatur damit als gültig erkannt, werden.

Ob diese Echtheitsbestätigungen nun hierarchisch erfolgen (Public-Key-Infrastruktur, Lektion 4.3.1), oder über ein dezentral verteiltes Vertrauensmodell (Web of Trust, Lektion 4.3.2) ist von der jeweiligen Implementierung abhängig. Derzeit sind beide Modellvarianten im Einsatz und finden ihre Anwendung in einer Vielzahl von Systemen. Die Zertifikate der behördlich akzeptierten digitalen Signaturen basieren derzeit auf dem hierarchischen Modell der Public-Key-Infrastruktur.

Ein Zertifikat ist mit einem Ausweisdokument vergleichbar. Auf dem Ausweis befinden sich die Daten der Person und ein Verweis auf den Aussteller. Durch Sicherheitsmerkmale am Dokument (Wasserzeichen, Silberstreifen,…) wird dabei die Echtheitsprüfung ermöglicht. Der Aussteller (z.B. eine Behörde) bestätigt damit die Identität des Inhabers (z.B. Personalausweis) und gegebenenfalls auch bestimmte durch das Dokument erlaubte Tätigkeiten (z.B. Führerschein).

Die Echtheit eines Zertifikates kann von der jeweiligen Zertifizierungsstelle auch wieder zurückgezogen werden. Zu diesem Zweck werden Zertifikats-Sperrlisten (CRL: Certificate Revocation Lists) eingesetzt, welche Einträge der Seriennummern aller Zertifikate mit zurückgenommenen Echtheitsbestätigungen enthält. Die Sperrliste ist selbst wiederum von der jeweiligen Zertifizierungsstelle signiert, um ihre Echtheit zu bestätigen.

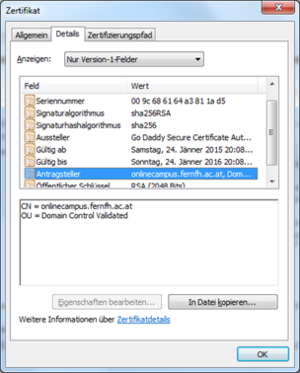

Der Aufbau und der mögliche Inhalt eines Zertifikates ist im X.509 Standard [Ne99] definiert. Ein entsprechendes Beispiel (das aktuelle Zertifikat des Online-Campus) ist in Abbildung 16 dargestellt.

Public-Key-Infrastruktur (PKI)

Bei der Public-Key-Infrastruktur (PKI) handelt es sich um ein hierarchisch aufgebautes System von Zertifizierungsstellen. Das bedeutet, dass jede Zertifizierungsstelle das in sie gesetzte Vertrauen an nachfolgende Stellen weiterverteilen kann, indem sie die zugehörigen Zertifikate signiert.

Daraus ergibt sich dann eine Hierarchie aus mehreren Zertifikaten, die bis zu einem Stammzertifikat rückverfolgt werden können sind. Durch das Vertrauen in das jeweilige Stammzertifikat wird auch den nachfolgenden Zertifikaten vertraut.

In den meisten Anwendungen, die PKI Zertifikate einsetzen (z.B. Internetbrowser für HTTPS Verbindungen), sind bereits einige gängige Stammzertifikate der großen Zertifizierungsstellen vorinstalliert. Es ist jedoch meist auch möglich weitere Stammzertifikate hinzuzufügen, denen dann ebenfalls vertraut wird. In Abbildung 17 ist die Hierarchie des Zertifikates des Online-Campus dargestellt. Die Stammzertifizierungsstelle ist in diesem Fall das Unternehmen Go Daddy.

Zusätzlich zu den Zertifizierungsstellen gibt es in der PKI noch weitere Instanzen, welche hautsächlich für den Zertifizierungsprozess verantwortlich sind. Die Hauptakteure der PKI sind:

- Zertifizierungsstelle (CA: Certification Authority),

- Registrierungsstelle (RA: Registration Authority) und

- Validierungsdienst (VA: Validation Authority)

Die Registrierungsstelle ist in der PKI dafür verantwortlich die Identität des Antragsstellers zu überprüfen und dies wiederum der Zertifizierungsstelle mitzuteilen. Die Validierungsstelle ist für die Gültigkeitsprüfung von bereits ausgestellten Zertifikaten verantwortlich. Sie verwaltet auch die Zertifikats-Sperrlisten und ihre Erreichbarkeit ist meist in einem Datenfeld in den Zertifikaten selbst angegeben.

Soll nun ein neues Zertifikat ausgestellt werden, muss folgender Zertifizierungsprozess durchlaufen werden:

- Der Antrag für das neue Zertifikat wird an die Registrierungsstelle (RA) geschickt

- Die Registrierungsstelle (RA) überprüft den Antrag und stellt sicher, dass es sich bei der Identität tatsächlich um die der antragstellenden Person oder des zugehörigen IT-Systems (z.B. bei einem Webserver-Zertifikat) handelt.

- Wenn die Registrierungsstelle die Identität bestätigen kann, sendet sie den Antrag weiter an die Zertifizierungsstelle (CA).

- Die Zertifizierungsstelle (CA) stellt nun das beantragte Zertifikat aus, generiert dafür einen privaten und einen öffentlichen Schlüssel und sendet diese an die antragsstellende Person.

Oft ist es auch möglich das Schlüsselpaar selbst zu generieren und dem Antrag nur den öffentlichen Schlüssel beizufügen. Dies ist für die Ausstellung des Zertifikates ausreichend, da der private Schlüssel für seine Signierung nicht benötigt wird (diese wird durch den privaten Schlüssel der CA durchgeführt). In diesem Fall ist zusätzlich sichergestellt, dass der private Schlüssel nur der antragsstellenden Person bekannt ist.

Gerade bei der Überprüfung durch die Registrierungsstelle gibt es unterschiedliche Qualitäten. Wird hier ungenau vorgegangen, kann dies zu Zertifikaten falscher Identitäten führen.

Web of Trust (WOT)

Das Modell des Web of Trust ist im Gegensatz zur PKI nicht hierarchisch, sondern dezentral aufgebaut. Es basiert auf einer dezentralen Vertrauensverteilung zwischen den Teilnehmern, ähnlich dem Freundes- und Bekanntenkreis einer Person. Die Schlüssel sind dabei nicht in einer hierarchischen Struktur zentral abrufbar und überprüfbar, sondern werden direkt von den Benutzern verwaltet. Jeder User hat seinen eigenen Schlüsselbund, wobei hier zwischen dem privaten und dem öffentlichen Schlüsselbund unterschieden wird.

Am privaten Schlüsselbund befinden sich die privaten Schlüssel des Users, mit denen Daten signiert und entschlüsselt werden können. Am öffentlichen Schlüsselbund befinden sich die eigenen öffentlichen Schlüssel, sowie die öffentlichen Schlüssel anderer User. Mit den öffentlichen Schlüsseln können Nachrichten verschlüsselt und Signaturen geprüft werden.

Die Vertrauensstufen werden über die öffentlichen Schlüssel der Teilnehmer ermittelt. Dazu gibt es im öffentlichen Schlüsselbund für jeden Schlüssel ein Key Legimitation Field, in dem der jeweilige Vertrauensgrad (Owner Trust) des Schlüssels angegeben wird.

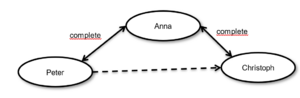

Im WOT gibt es folgende Vertrauensgrade:

- unknown: Personen über die keine Informationen bekannt sind,

- not trusted: Personen denen nicht vertraut wird,

- marginal: Personen denen nicht voll vertraut wird,

- complete: Personen denen voll vertraut wird und

- ultimate: eigener öffentlicher Schlüssel.

Wer als vertrauenswürdig eingestuft wird, liegt somit beim jeweiligen Schlüsselbund Inhaber.

Die Vertrauensgrade können an andere User (z.B. über einen Schlüsselserver) weitergegeben werden, indem die jeweiligen Schlüssel durch den eigenen privaten Schlüssel signiert werden. Dies wird auch als indirekte Zertifizierung bezeichnet.

Ist dem User, der einen dritten Schlüssel signiert hat, im eigenen Schlüsselbund einem Vertrauensgrad zugewiesen, so erhält der von ihm signierte Schlüssel je nach eigener Einstellung denselben Vertrauensgrad oder niedriger. Zusätzlich kann definiert werden, wie viele signierte Schlüssel eines niedrigeren Vertrauensgrades notwendig sind, um die Vertrauensstufe um eine Stufe aufzuwerten. Die Standartwerte hierfür sind 3 signierte Schlüssel anderer User für die Aufwertung und ein signierter Schlüssel eines anderen Users für dieselbe Stufe.

Diese Abhängigkeiten sind in Abbildung 18 ersichtlich: Peter kennt sowohl Anna, als auch Christoph persönlich und hat daher ihre öffentlichen Schlüssel in seinem öffentlichen Schlüsselbund abgelegt. Christoph hat nur eine direkte Beziehung zu Anna, nicht aber zu Peter. Da sich Christophs öffentlicher Schlüssel im öffentlichen Schlüsselbund von Anna befindet, erkennt Peter sein Zertifikat als gültig an.

Die erste Implementierung des WOT war Pretty Good Privacy (PGP) [Sy15]. Es ist ein Softwarepaket, welches die Sicherstellung der Authentizität, Integrität und Vertraulichkeit von E-Mails sowie beliebiger Dateien ermöglicht. GnuPG [Gn15] ist die frei verfügbare Version, die unter der GNU General Public License [Fr07] steht. Ein möglicher Windows Client für GnuPG ist beispielsweise Gpg4win [In15b].

Neue Zertifikatsmodelle und Erweiterungen

Sowohl im Bereich des PKI, als auch im WOT Modell, gibt es mittlerweile einige bekannte Sicherheitslücken und Protokollfehler. Weiter ist gerade im PKI Modell die Rolle der CA enorm wichtig. Werden hier nur schlechte Identitätskontrollen bei der Ausstellung von Zertifikaten durchgeführt, kann es zu falschen validen Identitäten kommen. Im Bereich des WOT können beispielsweise die Schlüsselserver zum Generieren von SPAM-Versandlisten genutzt werden, da die zugehörigen E-Mailadressen der Zertifikate dort frei verfügbar sein müssen. Weiter sind über die WOT soziale Netzwerke der User analysierbar, da die Trustlevel und ihre Abhängigkeiten leicht analysiert werden können. [Br14]

Um diese Schwachstellen zu beseitigen wird bereits an möglichen neuen Protokollen und Erweiterungen geforscht. Den meisten Ansätzen gemein ist, die Abhängigkeit von einzelnen CA’s zu verringern. Fehler einer CA sollen möglichst auf Seite der Endanwendung (wie z.B. im Browser oder Mail Client) frühzeitig erkannt und angezeigt werden. [Br14]

Einer dieser neuen Ansätze ist die Software Perspectives [Ca15]. Dabei handelt es sich um eine Browsererweiterung, die jedes Zertifikat zusätzlich mit einem sogenannten Notary-Server abgleicht. Damit können beispielsweise Man-in-the-Middle Angriffe frühzeitig erkannt werden.

Weitere aktuelle Erweiterungen sind [Br14]:

- Pinning [EPS14],

- Certificate Transparency [LLK13],

- Microsoft SmartScreen [Mi15] und

- DANE [HVS12].

Angriffsvektoren der Access Control

Die Angriffsmethoden der Access Control sind sehr vielfältig und haben oft Angriffsvektoren der Kryptographie (Lektion 3.7) und Datenübertragung (Lektion 5.6), sowie Social Engineering (Lektion 2.3) als Grundlage. Dies trifft insbesondere auf Angriffe gegen die Integrität und Authentizität zu.

Dazu bereits behandelte Angriffsvektoren sind:

- Brute-Force Angriffe (Lektion 3.7.1),

- Phishing (Lektion 2.3.1) und

- Angriffe gegen Hashwerte (Lektion 3.7.3).

Eine weitere wichtige Angriffsmethode ist die des Pharming. Dabei wird die Anfrage eines Users auf einen bösartigen Server umgeleitet. Er glaubt sich sicher und gibt dann dort seine geheimen Daten ( wie z.B.: Zugangsdaten und Transaktionsdaten) preis. Beim Pharming handelt es sich daher um einen Man-in-the-Middle Angriff (siehe Lektion 5.6.3).

Wiederholungsaufgaben/Übungen

4.4.1 Was ist der Unterschied zwischen Identifikation, Authentifikation und Autorisation?

4.4.2 Was ist eine Zwei-Faktor-Authentifikation?

4.4.3 Welche drei Zugriffssteuerungsmodelle gibt es?

4.4.4 Erklären Sie das Modell der Eigner-definierten Zugriffssteuerung.

4.4.5 Was sind Zertifikate und die damit verbundenen Vertrauensmodelle?

4.4.6 Was bedeutet PKI und wer sind ihre Hauptakteure? Wie hängen diese Akteure zusammen?

4.4.7 Eine Passwortrichtlinie fordert ein Passwort, bestehend aus Kleinbuchstaben, Großbuchstaben und Ziffern mit einer Länge von 10 Zeichen. Wie wird die Komplexität des Passworts berechnet (wie viele mögliche Passwörter gibt es)?

Netzwerksicherheit

Ein wesentlicher Aspekt der technischen Informationssicherheit ist die Netzwerksicherheit. Wenn Daten von einem Gerät zu einem anderen übertragen werden, muss die Einhaltung der Schutzziele (Vertraulichkeit, Integrität und Verfügbarkeit; siehe Lektion 1.3) weiter gewährleistet werden. Eine genaue Betrachtung der Übertragungsverfahren und Zugriffe ist daher unbedingt erforderlich, da aufgrund der standardmäßigen Offenheit der aktuellen Übertragungstechnologien meist auch eine Vielzahl von Angriffsvektoren möglich ist.

Sicherheitsaspekte der Netzwerkschichten

Die Betrachtung der Netzwerksicherheit bedarf einer gesonderten Betrachtung der einzelnen Netzwerkschichten. In jeder Schicht gibt es eigene Schwachstellen und mögliche Maßnahmen der Absicherung.

Ein Überblick der Netzwerkschichten des OSI-Referenzmodells ist in Tabelle 5 aufgelistet. Die Details dazu finden sich im Studienheft IT112 - Netzwerke und verteilte Systeme – von Univ.-Prof. DI Dr. Erich Schikuta, in Lektion 5.

Tabelle 5: OSI-Schichten und TCP/IP Modell

| OSI-Modell | Einordnung | Funktion | TCP/IP-Modell | |

|---|---|---|---|---|

| 7 | Anwendungsschicht (Application Layer) | Anwendungsorientiert | Netzwerkschnittstelle zur Anwendung | Anwendungs-Schicht |

| 6 |

|

Darstellungsschicht (Presentation Layer) |

|

Daten-Repräsentation und Verschlüsselung |

| 5 |

|

Sitzungsschicht (Session Layer) |

|

Kommunikation zwischen Rechnern |

| 4 | Transportschicht (Transport Layer) | Transportorientiert | Ende-zu-Ende Verbindungen und Verlässlichkeit | Host-zu-Host-Schicht |

| 3 |

|

Vermittlungsschicht (Network Layer) | Pfad Bestimmung und logische Adressierung | Internet-Schicht |

| 2 |

|

Sicherungsschicht (Data Link Layer) | Physische Adressierung | Netzzugangs-Schicht |

| 1 |

|

Übertragungsschicht (Physical Layer) |

|

Medium, Signal und binäre Übertragung |

Die Absicherung der einzelnen Schichten – zur Erreichung der Schutzziele – erfolgt nun durch den Einsatz der acht spezifischen Sicherheitsmechanismen [Ec09, 737]:

- Kryptografische Verfahren,

- Digitale Signaturen,

- Zugriffskontrollmechanismen,

- Datenintegritätsmechanismen,

- Austausch von Authentizitätsinformationen,

- Anonymisierung und Verschleierung von Verkehrsdaten,

- Mechanismen zur Kontrolle der Wegewahl und

- Notariatsmechanismen.

Transportorientierte Sicherheitsaspekte

Das Ziel der transportorientierten Netzwerkschichten ist die Übertragung von Daten zwischen zwei Geräten. Dabei ist es meist erforderlich, die Weiterübertragung durch dazwischen liegende Geräte und auch unterschiedliche Übertragungsmedien in Anspruch zu nehmen. Dabei kann es zu Datenverlust und Datenänderungen kommen. Auch muss die Möglichkeit der Abhörung des Datenverkehrs in berücksichtigt werden.

Durch manipulierte und fehlerhafte Pakete kann es ebenfalls zu Beeinträchtigungen der beteiligten IT-Systeme kommen. Daher ist es erforderlich die Weiterleitung und Verarbeitung des Netzwerkverkehrs zu limitieren und alle ungewollten Pakete zu filtern.

Zur Absicherung des Transports werden in den unteren Schichten meist Firewalls (siehe weiter 5.2) und in den oberen Schichten bestimmte Protokolle eingesetzt. Einige wichtige Absicherungstechnologien auf Protokollebene sind:

- TLS (Transport Layer Security),

- IPsec (Internet Protocol Security),

- PPTP (Point-to-Point Tunnelling Protocol),

- L2TP (Layer 2 Tunneling Protocol),

- PPP (Point-to-Point Protocol),

- PAP (Password Authentication Protocol),

- CHAP (Challenge Handshake Authentication Protocol),

- RADIUS (Remote Authentication Dial-In User Service),

- DIAMETER (keine Abkürzung; Bezug des Namens zu RADIUS),

- TACACS+ (Terminal Access Controller Access Control System) und

- WPA2 (Wi-Fi Protected Access 2).

Nicht vergessen werden darf dabei auch auf das Übertragungsmedium selbst. So können ungesicherte Netzwerkdosen und schlecht abgesicherte WLAN Verbindungen ein leichtes Eintrittstor in das interne Netzwerk sein. Auch gibt es Möglichkeiten den Netzwerkverkehr über die entstehenden elektromagnetischen Felder der Kabel und beteiligten Geräte abzuhören und natürlich können in der anderen Richtung auch Störungen durch elektromagnetische Felder im Kabelumfeld (z.B. durch Stromleitungen, Motoren oder Generatoren) entstehen.

In Tabelle 6 sind die wesentlichen Aufgaben der hier aufgezählten Protokolle, sowie ihre Einordnung in die Netzwerkschichten zusammengefasst.

Tabelle : Protokolle der transportorientierten Netzwerkschichten

| Protokoll | Netzwerk-schicht | Zweck |

|---|---|---|

| TLS (Transport Layer Security) | OSI Layer 4 | Neue Bezeichnung und Weiterentwicklung von SSL (Secure Socket Layer). Unterstützt Verschlüsselung und Authentifizierung mittels Zertifikaten. |

| IPsec (Internet Protocol Security) | OSI Layer 3 | Betrieb eines VPN Tunnels (siehe Lektion 5.3). |

| PPTP (Point-to-Point Tunnelling Protocol) | OSI Layer 2 | Betrieb eines VPN Tunnels (siehe Lektion 5.3). |

| L2TP (Layer 2 Tunneling Protocol) | OSI Layer 2 | Betrieb eines VPN Tunnels (siehe Lektion 5.3). |

| PPP (Point-to-Point Protocol) | OSI Layer 2 | Verbindungsaufbau über Einwahlleitungen (Modem). Nutzt PAP oder CHAP zur Authentifikation. |

| PAP (Password Authentication Protocol) | OSI Layer 2 | Authentifikation über das PPP. Passwörter werden unverschlüsselt übertragen. |

| CHAP (Challenge Handshake Authentication Protocol) | OSI Layer 2 | Authentifikation über das PPP. Keine Passwortübertragung, sondern Prüfung durch Hashwerte aus Passwort und gemeinsamer Zufallszahl. |

| RADIUS (Remote Authentication Dial-In User Service) | OSI Layer 2 | Authentifikation von Clients in Netzwerken. |

| DIAMETER (keine Abkürzung; Bezug des Namens zu RADIUS) | OSI Layer 2 | Weiterentwicklung von RADIUS mit größerem Funktionsumfang. |

| TACACS+ (Terminal Access Controller Access Control System) | OSI Layer 2 | Weiterentwicklung von RADIUS mit verschlüsselter Kommunikation. |

| WPA2 (Wi-Fi Protected Access 2) | OSI Layer 2 | Nachfolger von WEP (Wired Equivalent Privacy) und WPA. Authentifizierung und Verschlüsselung von WLAN-Verbindungen. |

Anwendungsorientierte Sicherheitsaspekte

Die Absicherung von Netzwerken auf Anwendungsebene geschieht durch Protokolle und ihre Implementierung in den jeweiligen Applikationen. Die häufigsten Anwendungsgebiete sind dabei die sichere Kommunikation mit Webseiten und über E-Mail, sowie der Dateitransfer und Serverzugriff.

Für eine sichere Kommunikation zwischen Webseiten und Browsern wurde das HTTP (Hypertext Transfer Protokoll) Protokoll um die Möglichkeit eines Transportes mittels TLS (Transport Layer Security, vormals SSL) erweitert. Das daraus entstandene HTTPS (HTTP over SSL) Protokoll kombiniert somit ein Protokoll der Anwendungsschicht mit einem Protokoll der Transportschicht.

Durch die Möglichkeiten von TLS, einer verschlüsselten Kommunikation und der zertifikatsbasierten Authentifizierung der Kommunikationspartner, werden sichere Verbindungen zwischen Webserver und Internetbrowser ermöglicht. Je nach Ausprägung wird es nur zur Verschlüsselung, zur Authentifikation des Servers gegenüber dem Client oder sogar zur Authentifikation des Clients gegenüber dem Sever (mittels Clientzertifikat) genutzt.

Auch das File Transfer Protokoll (FTP) ist in einer um TLS erweiterten Version FTPS (FTP over SSL) verfügbar.

Sowohl HTTP, als auch FTP übertragen ihre Daten ohne die genannten TLS Erweiterungen gänzlich unverschlüsselt. Die Daten sind in den Ursprungsversionen dieser Protokolle auch nicht vor Manipulationen geschützt.

Zur Absicherung von E-Mail-Kommunikation wurde der E-Mail-Standard MIME (Multipurpose Internet Mail Extensions), welcher den Aufbau von E-Mail-Nachrichten regelt, mit S/MIME (Secure MIME) um die Möglichkeit zertifikatsbasierter Verschlüsselung und Signierung der Nachrichten erweitert.

Um eine sichere Verbindung zu Serverkonsolen zu ermöglichen, kann das Secure Shell (SSH) Protokoll eingesetzt werden. Es basiert auf einer zertifikatsbasierten Authentifizierung und Verschlüsselung. Ähnlich wie bei TLS kann diese sowohl über Server-, als auch über Clientzertifikate erfolgen. Die Übertragung der Konsolendaten zwischen Server und Client erfolgt textbasiert. Weiter ist es möglich, Dateien zu übertragen. Diese Protokollform wird dann als SFTP (SSH File Transfer Protokoll) bezeichnet.

Firewalls

Der Begriff „Firewall“ kommt von der bildlichen Vorstellung einer brennenden Barriere, welche nicht überwunden werden kann. Eine bessere Darstellung wäre dafür jedoch eher eine mittelalterliche Zugbrücke mit Wachposten, da eine Firewall nicht für alle unüberwindbar sein soll und bestimmte Reisende ungehindert durchlassen muss. Ein weiterer, besserer, Vergleich ist der einer Brandschutzwand mit einer Türe, die zwar alle Personen durchlässt, jedoch das Feuer (unerwünschtes) blockiert.

Eine Firewall steht immer zwischen zwei getrennten Teilen eines Computernetzwerks. Sie kontrolliert den gesamten Datenverkehr und lässt nur jene Daten durch, die den vorgegebenen Regeln entsprechen (siehe Abbildung 19).

Eine Firewall kann dabei auf unterschiedlichen Netzwerkschichten aufsetzen und ist meist Teil eines Netzwerkgerätes der jeweiligen Schicht (Bridge, Switch, Router oder Server).

Aktuelle Firewall-Lösungen decken inhaltlich meist mehrere Firewall-Typen ab. So sind meist Packet-Filter-Firewalls und Stateful Firewalls kombiniert. Application Level Firewalls sind häufig auch, in Form von Modulen, in die jeweiligen Serverdienste integriert, die sie schützen sollen.

Im Bereich der zunehmenden Virtualisierung von Rechnernetzen ist es nötig, eine Absicherung durch virtuelle Netzwerkhardware zu gewährleisten. Dazu gehören auch virtualisierte Firewalls mit demselben Funktionsumfang.

Die unterschiedlichen Typen von Firewalls sind:

- Packet Filter Firewalls,

- Stateful Firewalls,

- Proxy Firewalls,

- Circuit-Level Proxy-Firewalls,

- Application-Level Proxy-Firewalls und

- Kernel Proxy-Firewalls.

Bei Packet Filter Firewalls handelt es sich um die Implementierung von Regeln der transportierenden Netzwerkschichten. Dabei werden bestimmte Pakettypen und die zugehörigen Paketheader überprüft. Eine inhaltliche Prüfung der Daten erfolgt hierbei nicht. Über die Paketheader können Daten wie Herkunftsadresse und Zieladresse, das verwendete Transport-Protokoll, sowie die zugehörigen Portnummern, geprüft werden.

Zusätzlich zu den Packet Filter Firewalls werden bei Stateful Firewalls die Pakete nicht nur einzeln, sondern im Zusammenhang der gesamten zugehörigen Verbindung betrachtet. Das bedeutet, dass der Verbindungsaufbau und die laufende Kommunikation erkannt werden. Dadurch ist es möglich, auf unterschiedliche Phasen einer Netzwerktransaktion unterschiedlich zu reagieren. Auch können ungültige Pakete erkannt werden, die in der aktuellen Phase der jeweiligen Verbindung nicht zulässig sind. Die einzelnen Verbindungen werden dabei in der State-Table der Firewall verwaltet.

Bei den Proxy-Firewalls handelt es sich um Firewalls der anwendungsorientierten Schichten. Je nach der zugehörigen Schicht untergliedern sie weiter sich in eigene Untertypen.

Die Circuit-Level Proxy-Firewall befindet sich auf Ebene der Sitzungsschicht. Sie unterstützt Regeln zu einem breiten Spektrum an Anwendungsprotokollen, kann jedoch nicht den Inhalt der Anwendungsschicht überprüfen. Sie prüft lediglich den Header der Pakete der Sitzungsschicht und leitet daraus ab, welche Anwendungskommunikationen stattfinden sollen.

Eine detaillierte Analyse des Netzwerkverkehrs ermöglicht hingegen die Application-Level Proxy-Firewall. Sie befindet sich auf Ebene der Anwendungsschicht und kann damit den Inhalt des Netzwerkverkehrs auf Anwendungsebene überprüfen. Dies ermöglicht eine Erkennung von unerwünschten Zugriffen auf Anwendungen durch Auswertung der direkten Anwendungskommunikation. Ein Beispiel für eine Application-Level Proxy-Firewall ist ein HTTP-Proxy-Server mit Content Filterung und Virenschutz. Er kann dabei unerwünschte Webinhalte und Schadcode erkennen und dem Anwender statt diesem eine Fehlermeldung senden.

Bei Kernel Proxy-Firewalls ist die gesamte Funktionalität direkt im Betriebssystem-Kernel implementiert. Sie verarbeiten die Pakete mittels virtueller Netzwerk-Stacks. Das bedeutet, dass für jedes Paket ein individueller virtueller Bereich angelegt wird, in dem dann seine Überprüfung stattfindet. In diesem virtuellen Stack gibt es dann je Netzwerkschicht eigene Regelwerke. Da die gesamte Verarbeitung direkt im Kernel erfolgt, sind Kernel Proxy-Firewalls performanter als Application-Level Proxy-Firewalls.

Eine weitere wichtige Funktionalität von Firewalls ist das IP-Masquerading und die damit verbundene Network Address Translation (NAT). Damit wird ermöglicht, eine einzelne öffentliche IP-Adresse durch mehrere Clients mit privaten IP-Adressen zu nutzen. Auch können damit Port-Weiterleitungen von der öffentlichen IP-Adresse zu dahinter liegenden Servern mit privaten IP-Adressen realisiert werden. Die Details zu öffentlichen und privaten IP-Adressen und die Funktionsweise des IP-Masquerading wurden bereits im Studienheft IT112 - Netzwerke und verteilte Systeme – von Univ.-Prof. DI Dr. Erich Schikuta genauer erläutert.

Im Zusammenhang mit Firewalls werden oft Intrusion Detection Systeme (IDS) eingesetzt. Dabei handelt es sich um Dienste, die den gesamten Netzwerkverkehr einer bestimmten Verbindung übermittelt bekommen und diesen analysieren. Sie erkennen dabei mögliche Angriffsmuster und Auffälligkeiten in den Verbindungsinformationen. Sobald ein IDS eine Auffälligkeit erkennt, kann es diese dokumentieren und melden. In bestimmten Fällen kann es auch so konfiguriert werden, dass es neue Firewall-Regeln hinzufügt, die die auffälligen Verbindungen blockiert.

Für den Betrieb von Servern, die von außen erreichbar sein sollen (z.B. Webserver und E-Mail-Server), wird meist ein gesondertes Netzwerksegment eingerichtet. Dieses hat dann eigene Firewall-Regeln, welche den Zugriff der Server auf das interne Netzwerksegment stark einschränken. Dadurch wird diese, risikoreichere Zone, von dem internen Netzwerk getrennt und kann auch gesondert überwacht werden. Da hierbei einzelne Zugriffe von außen in diese weniger sichere Zone durchgelassen werden, wird sie als De-Militarisierte-Zone (DMZ) bezeichnet.

Virtuelle Private Netze (VPN)

Ein Virtuelles Privates Netz (VPN) dient der Vernetzung mehrerer Standorte über unsichere Datenleitungen (z.B. über das Internet). Dies ist oft erforderlich, wenn ein Unternehmen mehrere Standorte hat, oder wenn Mitarbeiter mobil arbeiten und dabei Zugriff auf das interne Netzwerk benötigen.

Bei einem VPN werden die Daten einer kompletten Netzwerkschicht verschlüsselt übertragen. Dies geschieht oft direkt über VPN Dienste, welche in die jeweilige Firewall-Lösung integriert sind. In Abbildung 20 ist eine VPN Verbindung dargestellt, die zwei Bürostandorte über das Internet miteinander verbindet. Das VPN ist dabei auf den Firewalls installiert, die gleichzeitig Gateways ins Internet sind. Die verschlüsselte Verbindung zwischen den beiden VPN-Endpunkten (in diesem Fall die Firewalls) wird als VPN-Tunnel bezeichnet.

Wenn ein einzelner Computer an ein VPN angebunden ist, wird der VPN Tunnel durch einen lokalen VPN Dienst des Computers an das Unternehmensnetz angebunden. Die lokal installierte Software wird dabei als VPN-Client und der Einstiegspunkt in das Unternehmensnetz als VPN-Gateway bezeichnet.

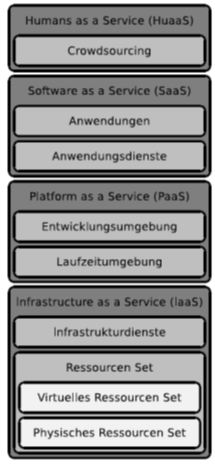

Wie der Schlüsseltausch und der Verbindungsaufbau für die gemeinsame Verbindung aussehen und welche Chiffren verwendet werden, hängt vom jeweiligen VPN Protokoll ab. Die meisten Protokolle unterstützen dabei mehrere unterschiedliche Chiffren um mit möglichst vielen Clients kompatibel sein zu können. Hier ist jedoch Vorsicht geboten, da diese großzügige Kompatibilität von Angreifern ausgenutzt werden kann, indem sie versuchen eine Verbindung mit einer möglichst schwachen Chiffre aufzubauen, um diese dann wiederum leichter analysieren zu können. Die verwendeten Chiffren sollten daher im VPN-Gateway sehr genau auf die Anforderungen möglichen VPN-Clients abgestimmt sein. Alle nicht benötigten Methoden sollten dann deaktiviert werden.