Optimierung - Optimierung unter Nebenbedingungen

Optimierung unter Nebenbedingungen

Häufig treten in ökonomischen Anwendungen Optimierungsprobleme auf, bei denen gewisse Nebenbedingungen erfüllt werden müssen. Das bedeutet, das nicht mehr der ganze Definitionsbereich einer Funktion betrachtet wird, sondern nur eine Teilmenge; deren genaue Gestalt hängt von den Nebenbedingungen ab; maximieren wir etwa eine Funktion unter der Nebenbedingung: , so wird das Maximum auf dem Kreis mit Radius 2 gesucht. Dieser ist die Höhenschichtline der Funktion zum Niveau 4. Wenn wir statt der Gleichung die Ungleichung als Nebenbedingung vorgeben, so wird das Maximum auf der ganzen Kreisscheibe gesucht (also auch im Inneren des Kreises). Für den Spezialfall der Optimierung von linearen Funktionen unter linearen Nebenbedingungen gibt es das sogenannte Simplex-Verfahren, das hier nicht behandelt wird; es gibt dafür inzwischen leicht auffindbare Internetresourcen (z.B. www.phpsimplex.com oder LINDO); wir behandeln die weitaus schwierigere Fragestellung der nichtlinearen Optimierung unter Nebenbedingungen, die selbst linear oder nichtlinear sein können. Die wichtigste Methode zur Behandlung von Optimierungsaufgaben unter Nebenbedingungen besteht darin, diese auf Optimierungsprobleme ohne Nebenbedingungen zurückzuführen. Der Einfachheit halber werden wir diese Theorie hier nur für Funktionen in zwei Veränderlichen vorstellen, die Verallgemeinerung auf mehrere Veränderliche erfordert zwar mehr Rechenaufwand, jedoch keine neuen Konzepte. Wir beschreiben nur die Suche nach einem lokalen Minimum, für Maxima läuft alles völlig analog, bzw. kann man das Minimum von suchen um das Maximum von zu erhalten.

Lagrange – Multiplikatoren – Gleichungen als Nebenbedingung

Wir wollen folgende Aufgabe lösen:Finde

unter

d.h., wir suchen das Minimum der Funktion über der Höhenschichtline zum Niveau der Funktion , wobei wir voraussetzen, dass sowohl als auch differenzierbar sind. Im ersten Schritt der Methode wird ein Lagrange-Multiplikator, zumeist mit bezeichnet (hat nichts mit den Eigenwerten einer Matrix zu tun!), eingeführt. Man definiert die Lagrange-Funktion als

und sucht jene Paare , für das es ein Lambda gibt, mit dem die Funktion in ein Minimum annimmt. Die Nebenbedingung steckt nun implizit in der Lagrange-Funktion. Falls die Nebenbedingung erfüllt ist so gilt . Falls die Nebenbedingung nicht erfüllt ist und zum Beispiel , so wird die Lagrange-Funktion für diesen Punkt für hinreichen kleines beliebig klein, und und die Lagrangefunktion kann in diesem Punkt für kein ein Minimum annehmen. Beachten Sie auch: das Kriterium ist etwas anderes als die Suche nach Tripeln , welche die Lagrangefunktion minimieren – solche wird man im Allgemeinen nicht finden: gilt nämlich , dann gibt es aus den genannten Gründen kein optimales !

Das Lagrange-Theorem besagt nun folgendes: falls ein lokales Minimum von unter der Nebenbedingung ist, und falls so gibt es eine eindeutige Zahl , für welche die Lagrange-Funktion einen stationären Punkt in hat, d.h. unter Beibehaltung der Nebenbedingung . Um Kandidaten zur Lösung der ursprünglichen Aufgabe zu erhalten, muss also das folgende System von Gleichungen gelöst werden:

Beispiel 11:

Ein Verbraucher habe die Nutzenfunktion

Maximiere die Nutzenfunktion unter der Budgetbeschränkung

Die Lagrange Funktion lautet:

Null setzen der partiellen Ableitungen gibt

Elimination von aus diese beiden Gleichungen liefert Und wir haben die Nebenbedingung

Dieses lineare Gleichungssystem mit zwei Variablen hat eine eindeutige Lösung:

und schließlich

An sich haben wir bisher nur eine notwendige Bedingung für ein lokales Extremum und es sollte noch gezeigt werden, dass es sich tatsächlich um ein Maximum handelt. Ähnlich wie im Falle der Optimierung ohne Nebenbedingung gibt es entsprechende Kriterien an die zweiten Ableitungen von und , anhand derer man entscheiden kann ob es sich um ein Maximum oder ein Minimum handelt. Wir wollen uns zunächst auf eine graphische Darstellung des Sachverhalts beschränken:

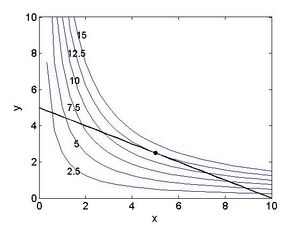

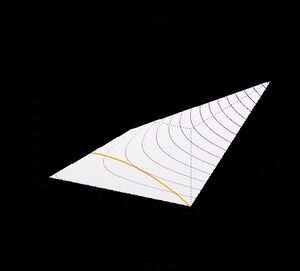

Abbildung 1.4 zeigt einerseits ausgewählte Niveaulinien der Zielfunktion , anderseits die Gerade welche gerade die Budget-beschränkung beschreibt. Sinnvoller weise sind beide Investitionen x und y positiv. Entsprechende Ungleichungs-Nebenbedingungen werden im nächsten Abschnitt besprochen. Am Punkt berührt die Gerade die Niveaulinie zum Wert . Es ist klar ersichtlich, dass an allen anderen Punkten die Gerade jene Niveaulinien schneidet, die einem geringeren Wert der Zielfunktion entsprechen. Daher handelt es sich bei dem Punkt um ein lokales Maximum der Zielfunktion unter der gegebenen Budgetbeschränkung. Dass an dieser Stelle die Nebenbedingungsgerade tangential an die Niveaulinie liegt ist typisch, und der geometrische Grund dafür, dass die Lagrange-Methode funktioniert. Abbildung 1.5 ist eine dreidimensionale Veranschaulichung des Sachverhaltes; die stark ausgezogene Kurve ist der Graph der Funktion unter der Nebenbedingung (der „Weg durch das hügelige Gelände“, um beim Bild zu bleiben). An seinem höchsten Punkt ist er tangential zum Graphen der Höhenschichtlinien, d.h., das Gelände fällt dort senkrecht zum Weg am steilsten ab.

Für eine allgemeine Klassifizierung von Punkten, die mithilfe der Lagrage Funktion gefunden wurden, steht die Methode der berandeten Hessematrizen zur Verfügung; im zweidimensionalen Fall: Sei

Ist die Determinante dieser Matrix positiv, so haben wir ein lokales Maximum, ist sie negativ, ein Minimum, ist die Determinante Null, so ist die Frage nicht entscheidbar.

Einen Sonderfall stellen Nebenbedingungen dar, die eine beschränkte Menge beschreiben – z.B. einen geschlossenen Kreis, eine Ellipse oder ein Streckenstück; auf einer solchen Menge können wir einfach alle kritischen Punkte der Reihe nach betrachten – der mit dem größten Funktionswert ist das Maximum, der mit dem kleinsten das Minimum.

Aufgabe 8:

Finde die beiden Extremstellen von

unter der Nebenbedingung

Die vorgestellte Theorie lässt sich weitgehend unverändert auf Funktionen mit mehr als zwei unabhängigen Variablen erweitern. Häufig gibt es in der Anwendung mehr als eine Nebenbedingung, und die Lagrange-Methode besteht dann darin, dass für jede Nebenbedingung ein eigener Lagrange-Multiplikator hinzugefügt wird. Bei einem Optimierungsproblem in n Variablen mit m Nebenbedingungen erhält man demnach eine Lagrange-Funktion L in n+m Variablen. Kandidaten für lokale Extrema erhält man wiederum indem man nach stationären Punkten von L sucht, wobei es nun gilt n+m Gleichungen in n+m Variablen zu lösen.

Karush Kuhn Tucker Bedingungen

Häufig tauchen Nebenbedingungen nicht in Gleichungsform, sondern in Ungleichungsform auf, z.B., dass eine Variable x nur positive Werte annehmen kann, also die Nebenbedingung erfüllen muss. Das allgemeine Problem in zwei Variablen mit einer Nebenbedingung hat die Form: Finde

unter

D.h., wir suchen das Minimum der Funktion über einem Bereich, der von der Höhenschichtline zum Niveau c der Funktion begrenzt wird, wobei wir wieder voraussetzen, dass sowohl f als auch g differenzierbar sind. Die Menge aller welche die Nebenbedingung erfüllen, wird als zulässige Menge bezeichnet. Im Prinzip kann dieses Problem mit den bereits gelernten Methoden behandelt werden, indem man einerseits nach lokalen Extremstellen im Inneren des zulässigen Bereichs sucht (Optimierung ohne Nebenbedingung), und andererseits den Rand des zulässigen Bereichs mit Hilfe der Lagrange-Methode untersucht. Unter gewissen Voraussetzungen an die Randbedingungen (den sogenannten constraint qualifications ) lassen sich allerdings notwendige Bedingungen für lokale Extremwerte im gesamten zulässigen Bereich angeben. Dazu wird wiederum die Lagrange-Funktion

definiert, allerdings gilt hier für die Lagrange Multiplikatoren . Entscheidend ist nun die sogenannte komplementäre Schlaffheitsbedingung (complementary slackness). Man fordert, dass entweder die Nebenbedingung exakt erfüllt ist (d.h. ), oder aber der Lagrange Multiplikator. Diese Bedingung ist erfüllt falls

Die complementary slackness Bedingung beinhaltet in sehr eleganter Form dass ein lokaler Extremwert direkt am Rande des zulässigen Bereiches andere Bedingungen erfüllen muss als im Inneren: für erhält man die lokalen Maxima im Inneren, diese sind die gleichen, die wir auch ohne Nebenbedingung gefunden hätte. Am Rand hingegen müssen die Gradienten von und (anti-) parallel sein, d.h., wenn wir der Richtung des steilsten Angstiegs der Zielfunktion folgen würden, würden wir den von der Nebenbedingung erlaubten Bereich verlassen. Zusammenfassend liefert dies die sogenannten Karush Kuhn Tucker (KKT) Bedingungen als notwendige Bedingungen für lokale Extrema unter Ungleichheits-Nebenbedingungen:

Beispiel 12:

Ein Unternehmen hat die Möglichkeit zwei Güter zu produzieren. Bei beiden Produkten ist der erzielbare Preis jeweils proportional zur Qualität x bzw. y, während der Aufwand zur Qualitätssteigerung quadratisch wächst. D.h.:

Produkt 1: Für Preis bedarf es Arbeitseinheiten

Produkt 2: Für Preis bedarf es Arbeitseinheiten

wobei alle Konstanten größer als 0 sein sollen.

Das Unternehmen hat insgesamt höchstens L Einheiten an Arbeit pro Woche zur Verfügung, die es der Produktion der beiden Güter zuordnen kann. Bestimme welche Qualität bzw. den Erlös maximiert, wenn der wöchentliche Absatz auf jeden Fall gewährleistet ist. Lösung: Der erzielbare Erlös beträgt

Die Gesamtarbeitsleitung ist beschränkt:

Die KKT Bedingungen lauten also:

Falls folgt aus den ersten beiden Gleichungen unmittelbar , im Widerspruch zur Angabe. Für folgt , und daher

Somit gilt auch

Andererseits muss gelten (complementary slackness)

und wir folgern, dass insgesamt die optimale Lösung erreicht wird für

Aufgabe 9: Untersuche die Funktion

auf Extremwerte unter der Nebenbedingung

Zusammenfassung

Wir haben einige Aspekte der nichtlinearen Optimierung kennen gelernt. Speziell wurden zur Lösung von mehrdimensionalen Optimierungsaufgaben als hinreichende Bedingungen für lokale Maxima und Minima die Definitheitseigenschaften der Hessematrix angegeben. Für Optimierungsaufgaben mit Nebenbedingungen wurden nur notwendige Bedingungen zum Finden von lokalen Extremstellen besprochen, und zwar die Lagrange-Methode im Falle von Gleichheits-nebenbedingungen, und die Karush-Kuhn-Tucker Bedingungen für Ungleichheits-nebenbedingungen. Als einfache Algorithmen zum Lösen von nichtlinearen Optimierungsaufgaben wurden das Newton-Verfahren und das Gradientenverfahren kurz diskutiert.

Optimierung ist ein weites Feld, und viele interessante Gebiete konnten hier nicht einmal kurz angerissen werden. Eine Liste von gängigen Fragestellungen umfasst Transportprobleme, Zuordnungsprobleme, Netzplantechnik oder das weitläufige Gebiet der ganzzahligen und kombinatorischen Optimierung. Die dort benötigten Techniken unterscheiden sich oft wesentlich von denen die in diesem Kapitel erwähnt wurden, und oftmals finden Konzepte der Graphentheorie Verwendung. Für eine elementare deutschsprachige Einführung sei etwa auf das Buch von Domschke und Drexl (1995) verwiesen.