Methoden der Datenanalyse - Varianzanalyse

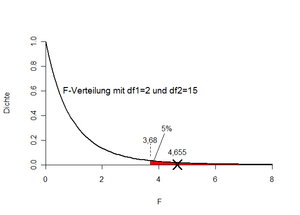

Berechnen Sie für die Daten aus Beispiel 2 das Bestimmtheitsmaß. |} Soll bei Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle F=4,655} nun für die H0 oder für die H1 entschieden werden? Bei kleinen Werten von F beobachten wir entweder kleine Werte für QZ und/oder große Werte für QI. Beides spricht eher für die H0. Umgekehrt sind große Werte für F eher Evidenz für H1. Um die Frage zu beantworten, wird nun der „kritische Wert“ in der Tabelle der F-Verteilung (oder z.B. in Excel) nachgeschlagen. Bei Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha=5%} am oberen Ende der Verteilung suchen wir de facto das Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle 1-\alpha=95%} -Quantil der F-Verteilung mit Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle k=1=3-1=2} und Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle N-k=18-3=15} Freiheitsgraden. In Excel kann dies mit der Funktion „FINV“ berechnet werden („=FINV(0,05;2;15)“). Dies liefert als maximal zulässigen F-Wert 3,68. Unser aus den Daten beobachtete F-Wert beträgt 4,655. Diese ist größer als der kritische Wert und daher wird die Nullhypothese verworfen. Ergebnis: Die drei Drahtsorten unterscheiden sich (bei Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha=5%} ) signifikant voneinander bezüglich ihrer Zugfestigkeit. Abbildung 12 veranschaulicht die Entscheidungssituation nochmals.

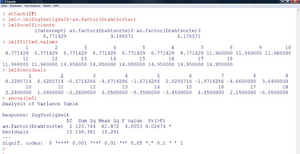

In der Praxis rechnet man die Varianzanalyse natürlich wieder mit Software. In R kann wieder die Funktion „lm“ verwendet werden. Die unabhängige Variable muss aber als „Faktor“ spezifiziert werden, da sonst ein linearer Zusammenhang mit der Gruppennummer geschätzt wird.

Abbildung 13 zeigt die Vorgehensweise in R, nachdem das csv-File eingelesen wurde (Name in R: „ZF“). Die geschätzten Koeffizienten sind hier nicht in der Effektkodierung angegeben (in Abschnitt 2.2.1), sondern in der sogenannten „Dummykodierung“. Die Mittelwerte der einzelnen Gruppen werden folgendermaßen reproduziert:

Da die Zugehörigkeit zu einer der drei Drahtsorten die einzige Information ist, die zur Prognose der Zugfestigkeit verwendet werden kann, entsprechen die geschätzten Werte für die einzelnen Daten („fitted values“) genau diesen Mittelwerten. Die „Tafel der Varianzanalyse“ liefert nun aus inferenzstatistischer Sicht die Kerninformation. Der p-Wert des Tests (siehe „Pr(>F); die Wahrscheinlichkeit, unter Gültigkeit der Nullhypothese den aus den Daten berechneten Wert für F oder einen noch größeren zu erhalten) ist kleiner als das üblicherweise gewählte Niveau des Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha}

-Fehlers (5%). Daher erfolgt auch mittels Software die Entscheidung für H1.

| Aufgabe 6

Abbildung 13 (unten) zeigt die typische „Tafel der Varianzanalyse“. Vergleichen Sie die darin vorkommenden Werte mit den bereits vorher berechneten, um die Berechnung nachzuvollziehen. In der Tafel ist statt des kritischen Wertes aus der F-Verteilung (3,68) der p-Wert ersichtlich. Versuchen Sie, die Berechnung des p-Werts in Excel mit der Funktion „FVERT“ nachzuvollziehen. Betrachten Sie dazu auch nochmals Abbildung 12. Argumentieren Sie, warum der p-Wert ausreichend ist, um für oder gegen H0 zu entscheiden und setzen Sie die Kriterien für die Testentscheidung, die in diesem Abschnitt auf zwei Wegen ermittelt wurde, zueinander in Beziehung. |

|---|

|

Aufgabe 7 Zu welcher Entscheidung würde man in Beispiel 2 bei Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha=1%} kommen? |

|

Aufgabe 8 In welchem Verhältnis müssten in Beispiel 2 (bei Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha=5%} bzw.Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha=1%} ) die Quadratsummen „Zwischen“ und „Innerhalb“ stehen, damit gerade noch für die H0 entschieden wird. Wie groß wäre dann jeweils das zugehörige Bestimmtheitsmaß? |

Prüfung der Modellvoraussetzungen, Residuenanalyse

Bei der Varianzanalyse beschränken sich die Prüfungen auf

- Ausreißer,

- Heteroskedastizität und

- Normalverteilung.

Diese werden gleich wie bei der Regressionsanalyse durchgeführt. Die Voraussetzung der Heteroskedastizität kann hier aber auch relativ einfach zusätzlich mit einem Test durchgeführt werden. Üblicherweise werden der Bartlett-Test (in R: Funktion „bartlett.test“) oder der Cochran-Test verwendet.

Multiple Mittelwertsvergleiche, Multiples Testen

Die Methode der einfaktoriellen Varianzanalyse liefert nur eine Antwort auf die Frage, ob es Unterschiede zwischen irgendwelchen zwei Gruppen gibt, aber nicht, zwischen welchen beiden Gruppen es diese Unterschiede gibt.

Um einzelne Unterschiede herauszufinden, müsste man theoretisch zwischen allen Gruppen paarweise t-Tests machen. Wie schon erwähnt, ist die einfaktorielle Varianzanalyse ja eine Verallgemeinerung des t-Tests. Man müsste dann allerdings Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \left(\begin{array}{l}k 2 \end{array}\right)} solche t-Tests berechnen. Bei Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle k=5} Gruppen wären das schon 10 t-Tests.

Die (neben der Notwendigkeit der zehnmaligen Durchführung eines Tests) auftretende Problematik ist, dass wenn bei jedem einzelnen Test eine 5%-Wahrscheinlichkeit besteht, einen Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha} -Fehler zu begehen (d.h. die Nullhypothese fälschlicherweise zu verwerfen), die Wahrscheinlichkeit, bei 10 Tests zumindest einmal einen Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha} -Fehler zu begehen, viel höher ist. Formal wäre diese Wahrscheinlichkeit

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha^{*}=1-(1-\alpha)^{m}=1-(1-0,05)^{10}=40,1 \% }

Man kann sich das auch so vorstellen: Spielt man einmal eine Runde im Lotto mit, besteht nur eine sehr kleine Chance, einen Gewinn zu erzielen. Jedoch ist die Wahrscheinlichkeit, in 100 Lottorunden zumindest einmal zu gewinnen schon relativ hoch (wenngleich das zumeist auch die entstandenen Einsätze nicht ausgleicht…).

Die Lösung zum Testproblem ist nun, entweder den Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha} -Fehler jedes einzelnen Tests derart zu reduzieren, dass Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha} dem ursprünglich beabsichtigten Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha} entspricht, oder die Methode der Varianzanalyse zu verwenden, bei der nur ein Test durchgeführt wird.

In der Praxis berechnet man bei derartigen Fragestellungen zuerst eine Varianzanalyse. Fällt diese signifikant aus, werden anschließend sogenannte Post-Hoc-Tests gerechnet, die herausfinden sollen, zwischen welchen Gruppen die Unterschiede bestehen. In diesen Prozeduren werden die Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha} -Fehler dann automatisch korrigiert.

Die zweifache Varianzanalyse für unabhängige Stichproben

| Beispiel 3

Der Marketingleiter eines Lebensmittelkonzerns steht vor der Frage, zu welchem empfohlenen Richtpreis eine neue Margarinemarke auf den Markt gebracht werden soll. Grundsätzlich stehen ihm drei Strategien zur Verfügung:

Neben der Preisstrategie (Faktor A) ist die Kommunikationsstrategie (Faktor B) von Interesse, und zwar in den alternativen Formen

Um die Wirkungen der Faktoren auf das Kaufverhalten zu untersuchen, wählt der Marketingleiter einen (3 x 2)-Versuchsplan, wobei auf die Kunden der ausgewählten Supermärkte jeweils eine unterschiedliche Kombination von Preis- und Kommunikationsstrategie wirken. An jeweils 10 zufällig ausgewählten Tagen werden die abgesetzten Mengeneinheiten der Margarine registriert. Die Resultate sind in der folgenden Tabelle wiedergegeben.

|

|---|

Modell der zweifachen Varianzanalyse für unabhängige Stichproben

Bei Vorliegen eines zweiten Faktors erweitert sich das einfaktorielle Modell zu

</math> Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle y_{i j l}=\mu+\alpha_{i}+\beta_{j}+\alpha \beta_{i j}+\varepsilon_{i j l} \qquad(i=1, \ldots, k ; j=1, \ldots, m ; l=1, \ldots n) }

wobei Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \varepsilon_{i j l} }

die Werte der metrischen Variable sind (Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle l}

-ter Wert bei Preispolitik Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle i}

und Kommunikationsstrategie Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle j}

), [Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \mu}

der unbedingte Erwartungswert (ohne Kenntnis der Gruppe), Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha}

der Effekt der jeweiligen Preispolitik, Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \beta_{j}}

der Effekt der jeweiligen Kommunikationsstrategie, Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha\beta_{j}}

jener Effekt ist, der sich aus der Kombination der Preispolitik Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle i}

mit der Kommunikationsstrategie Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle j}

zusätzlich ergeben könnte und Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \varepsilon_{i j l}}

der durch die drei Effektgruppen nicht erklärte Teil der abhängigen Variable ist. Die Annahmen für Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \varepsilon_{i j l}}

sind analog zum einfaktoriellen Modell.

Es kommen bei zwei erklärenden Faktoren also nicht zwei sondern drei Parametergruppen vor, weil es möglich ist, dass Kombinationen von Effekten andere Mittelwerte in der abhängigen Variable liefern. Dies wird im weiteren Verlauf der Analyse klarer.

Schätzen und Testen bei der zweifachen Varianzanalyse

Wie bei der einfachen Varianzanalyse können die einzelnen „Anteile“ an der Messung nun geschätzt werden.

Schätzung der durchschnittlichen Kaufmenge Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \mu} durch

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \hat{\mu}=\frac{1}{k * m * n} \sum_{i=1}^{k} \sum_{j=1}^{m} \sum_{l=1}^{n} y_{i j l} }

Schätzung des Effekts der Preispolitik i, Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle i, \alpha_i} , durch

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \widehat{\alpha_{i}}=\widehat{\mu_{l}}-\hat{\mu}=\frac{1}{m * n} \sum_{i=1}^{m} \sum_{l=1}^{n} y_{i j l}-\hat{\mu} }

Schätzung des Effekts der Kommunikationsstrategie j, Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle j, \beta_j} , durch

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \widehat{\beta_{j}}=\widehat{\mu_{j}}-\hat{\mu}=\frac{1}{k * n} \sum_{i=1}^{k} \sum_{l=1}^{n} y_{i j l}-\hat{\mu} }

Schätzung des Interaktionseffektes (Preispolitik vs. Kommunikationsstrategie) durch

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \widehat{\alpha \beta_{\imath \jmath}}=\widehat{\mu_{\imath j}}-\left(\hat{\mu}+\widehat{\alpha_{\imath}}+\widehat{\beta_{j}}\right)=\frac{1}{n} \sum_{l=1}^{n} y_{i j l}-\left(\hat{\mu}+\widehat{\alpha_{\imath}}+\widehat{\beta_{j}}\right) }

Schätzung des Fehlers Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \varepsilon_{i j l}} durch das Residuum

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \widehat{\varepsilon_{i j l}}=y_{i j l}-\widehat{y_{i j l}}=y_{i j l}-\left(\hat{\mu}+\widehat{\alpha_{l}}+\widehat{\beta_{j}}+\widehat{\alpha \beta_{l j}}\right) }

| Aufgabe 9

Berechnen Sie die Schätzungen für Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \hat{\mu}(1), \widehat{\alpha}_{i}(3) \widehat{\beta}_{j}(2) \text { und } \widehat{\alpha \beta_{i j}}\left(3^{*} 2=6\right) } |

|---|

Ob die in Aufgabe 9 berechneten deskriptiven Effekte signifikant sind, kann wieder analog obiger Vorgehensweise berechnet werden. Geprüft werden können nun drei Hypothesenpaare:

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \begin{array}{ll} H_{0}^{(1)}: \alpha_{1}=\alpha_{2}=\alpha_{3}=0 & \rightarrow \text { Kein Einfluss der Preispolitik auf den Absatz } \\ H_{1}^{(1)}: \exists \alpha_{i} \neq 0 & \rightarrow \text { Einfluss der Preispolitik auf die Absatz } \\ H_{0}^{(2)}: \beta_{1}=\beta_{2}=0 & \rightarrow \text { Kein Einfluss der Komm.-Strategie auf den Absatz } \\ H_{1}^{(2)}: \exists \beta_{j} \neq 0 & \rightarrow \text { Einfluss der Komm.-Strategie auf den Absatz } \\ H_{0}^{(3)}: \alpha \beta_{11}=\alpha \beta_{12}=\alpha \beta_{21}=\alpha \beta_{22}=\alpha \beta_{31}=\alpha \beta_{32}=0 \\ H_{1}^{(3)}: \exists \alpha \beta_{i j} \neq 0 & \end{array} }

Interaktionen (Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \left(H_{1}^{(3)}\right)} ) bzw. keine Interaktionen (Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \left(H_{0}^{(3)}\right)} ) zwischen Preispolitik und Komm.-Strategie in Bezug auf den Absatz.

Für jede Hypothese kann nun wieder eine Quadratsumme, eine daraus abgeleitete, unter H0 F-verteilte Prüfgröße Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle F} , sowie zur Bestimmung der Signifikanz ein p-Wert berechnet werden.

| Fortsetzung Beispiel 3

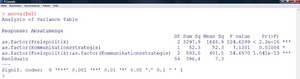

In R wird das lineare Modell nun so spezifiziert:

Man erhält dann folgende Tabelle (Abbildung 14): Alle p-Werte (Spalte rechts) sind kleiner als 5%. Daher wird in allen drei Fällen die Nullhypothese verworfen. Das Ergebnis ist (in Zusammenhang mit Aufgabe 9):

Die einzelnen Effekte (jene, die ausreichen, um das lineare Modell vollständig zu schätzen) können auch wieder mittels „lm1$coefficients“ ausgegeben werden. Folgender Befehl visualisiert diese Zusammenhänge schließlich noch in einem einfachen Liniendiagramm der Mittelwerte:

|

|---|

Ist ein balanciertes Design vorhanden (wie im Beispiel), macht es keinen Unterschied, in welcher Reihenfolge die Faktoren in die Gleichung eingegeben werden. Bei unbalancierten Designs ist die Interpretation der Signifikanzen schwieriger, da die Reihenfolge, in der die einzelnen Faktoren in die Gleichung eingehen, entscheidend ist.

Weitere Beispiele für varianzanalytische Designs

Varianzanalyse bei abhängigen Stichproben

Einfache Varianzanalyse für abhängige Stichproben

Wie beim t-Test für abhängige Stichproben kann auch eine Varianzanalyse für abhängige Stichproben berechnet werden. Beispielsweise, wenn Messung von Personen zu drei oder mehr Zeitpunkten vorliegen. In diesem Design können zwei Effekte geprüft werden: Unterschiede in der Versuchsbedingung (hier: Messzeitpunkt) und Unterschiede in den Versuchseinheiten (hier Personen).

Zweifache Varianzanalyse mit Messwiederholung

Hier können die Daten zum Beispiel zwei Gruppen von Personen (z.B. Männer und Frauen) sein, an denen je drei Messungen durchgeführt werden.

Unvollständige varianzanalytische Designs

Wenn nicht in allen Faktorkombinationen Daten erhoben werden, heißt das varianzanalytische Design „unvollständig“. Im folgenden werden zwei Beispiele für unvollständige Designs erwähnt.

Hierarchisches Design

Ein hierarchisches Design könnte sich beispielsweise dann ergeben, wenn man an der Wirkung eines Medikamentes, sowie am Behandlungserfolg verschiedener Spitäler interessiert ist. Sollen acht Medikamente und zwei Spitäler untersucht werden, ergibt sich ein Versuchsplan mit 2*8=12 Faktorkombinationen. Falls nun die Medikamente 1-4 nur in Spital 1 verwendet werden und die Medikamente 5-8 nur in Spital 2, dann können nicht wie in Beispiel 3 auch Wechselwirkungen auf Signifikanz getestet werden. Man sagt, dass der Faktor Medikament im Faktor Spital geschachtelt ist (auch „nested“). Dementsprechend müssen die Formeln der zweifaktoriellen ANOVA im vollständigen Design adaptiert werden.

Lateinisches Quadrat

Ein unvollständiges Design, das nicht durch mangelnde Verfügbarkeit der Daten, sondern vom Versuchsplaner selbst erzeugt wird, ist das „lateinische Quadrat“. Als Beispiel sei eine dreifaktorielle Varianzanalyse mit je drei Faktorstufen gegeben. Bei 10 Versuchseinheiten in jeder Kombination müsste man insgesamt 3*3*3*n Versuchseinheiten zur Verfügung haben. Stattdessen wird das Design auf z.B. 3*3 Faktorkombinationen gekürzt, sodass allerdings immer noch jede Faktorstufe und jede Kombination aus zwei Faktorstufen gleich oft vorkommt (Tabelle 1 und Tabelle 2). Der Vorteil dieses Designs liegt in der Kostenersparnis der Erhebung. Der Nachteil ist, dass nicht alle Hypothesen des vollständigen Designs prüfbar sind. Ist man ohnehin nur an den Einzelwirkungen der drei Faktoren und nicht an Interaktionen interessiert, fällt dieser Nachteil weg.

Tabelle 1: Übersicht über die gewählten Faktorkombinationen bei einer Kürzung

auf ein lateinisches Quadrat. Die Marker (X) geben an, welche Kombinationen tatsächlich gewählt werden

| B1 | B2 | B3 | |||||||

|---|---|---|---|---|---|---|---|---|---|

|

|

C1 | C2 | C3 | C1 | C2 | C3 | C1 | C2 | C3 |

| A1 | X |

|

|

|

|

X |

|

X |

|

| A2 |

|

X |

|

X |

|

|

|

|

X |

| A3 |

|

|

X |

|

X |

|

X |

|

|

Tabelle 2: Lateinisches Quadrat aus Tabelle 1 in Kurzschreibweise

| C1 | C2 | C3 | |

|---|---|---|---|

| A1 | B1 | B3 | B2 |

| A2 | B2 | B1 | B3 |

| A3 | B3 | B2 | B1 |

Wiederholungsaufgaben und Zusammenfassung

- Welche Bedeutung kommt der Quadratsummenzerlegung in der Varianzanalyse zu?

- Warum ist es wichtig, dass die Fehler normalverteilt sind?

- Sie erhalten bei einer einfaktoriellen Varianzanalyse mit Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha=5%} ein signifikantes Ergebnis. Wäre das Ergebnis auch signifikant, wenn Sie

- einen gleichgroßen Effekt (gleich große Mittelwertsdifferenzen) bei einem doppelt so großen Stichprobenumfang beobachten würden?

- einen gleichgroßen Effekt (gleich große Mittelwertsdifferenzen) bei einem halb so großen Stichprobenumfang beobachten würden?

- auf Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha=1%} testen?

Wie verändert sich der kritische Wert der F-Verteilung bei der Varianzanalyse, wenn Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha} von 5% auf 1% gesenkt wird?

Zusammenfassung

Der Begriff „Varianzanalyse“ steht für eine große Zahl an Verfahren, bei denen mithilfe der Berechnung von Varianzen bzw. Quadratsummen inferenzstatistische Aussagen über Beziehungen verschiedener Variablen gemacht werden können („Quadratsummenzerlegung“). Dabei ist die Modellvorstellung immer, dass es eine oder mehrere gruppierende Variablen gibt, die auf eine metrische Variable einwirken (univariate ANOVA). Die Gruppeneinteilung kann „randomisiert“ erfolgen (indem die Versuchseinheiten zu verschiedenen Gruppen zugeordnet werden “Experiment“; Kausalschluss möglich) oder schon vorgegeben sein („Kranke vs. Gesunde“, „Männer vs. Frauen“, „Raucher vs. Nichtraucher“ „Beobachtungsstudie“; Kausalschluss nicht möglich).

Die Rechenschritte im Zuge einer Varianzanalyse betreffen einerseits die Parameterschätzungen des Modells welche auf die Berechnung von Gruppenmittelwerten und deren Differenzen hinauslaufen. Andererseits geschieht die Beurteilung, ob die in der Stichprobe gefundenen Unterschiede für die Grundgesmtheit verallgemeinert werden können, erst jeweils mittels des F-Tests, mittels Verteilungsannahmen, die sich aus der Forderung von normalverteilten Daten ableiten. Grundsätzlich gilt, dass soviele Hypothesen wie Effektgruppen vorhanden sind, getestet werden können.

Die Ergebnisse der Hypothesenprüfung werden jeweils in einer „Tafel der Varianzanalyse“ übersichtlich zusammengefasst.