Lernunterlage - Objekte der Beschaffung betrieblicher Informationssysteme

Objekte der Beschaffung betrieblicher Informationssysteme

Im folgenden Kapitel werden die wesentlichsten Objekttypen, die bei der Beschaffung betrieblicher Informationssysteme relevant sind, mit ihren Eigenschaften und Besonderheiten näher vorgestellt:

- Computersysteme

- Software

- Netzwerkkomponenten

- Mobile Systeme

- Outsourcing von IT-Services

- Cloud-Computing

- Weitere Bereiche

Einführung

Die Beschaffung betrieblicher Informationssysteme wird durch eine Reihe von Besonderheiten – verglichen mit der Beschaffung anderer unternehmensrelevanter Objekte – gekennzeichnet. Dies beginnt bei der Komplexität der Beschaffungsobjekte selbst, die durch zahlreiche Parameter wie Leistungsdaten, Produktvarianten und Technologiestand gekennzeichnet sind und reicht über die Abstimmung mit den internen Anforderern in Bezug auf das genaue Einsatzszenario bis hin zum Abschluss eines Wartungsvertrags oder SLAs.

Ein wichtiger Aspekt ist in diesem Zusammenhang die Beachtung und Überwachung des Beschaffungsobjekt-Lifecycles, denn auch eine eventuelle rechtzeitige Wiederbeschaffung bei Erreichen des Endes der Nutzungsdauer ist eine wesentliche Aufgabe der Beschaffung betrieblicher Informationssysteme.

Computersysteme

Mainframe Computer

Unter Mainframe Computer oder Großrechnersystemen versteht man Computersysteme mit hoher Performanceleistung, die in Unternehmen typischerweise für den Betrieb einer oder mehrerer Kernprozess-Anwendungen dediziert sind.

Die Aufgabenstellungen für diese Systeme sind vornehmlich die hochzuverlässige Verarbeitung von Massendaten und die Fähigkeit, eine hohe Anzahl gleichzeitiger Transaktionen durchführen zu können. Sie sind redundant und damit ausfallsicher ausgelegt und die Wartung sowie ein eventuell erforderlicher Tausch von Hardwarekomponenten können typischerweise im laufenden Betrieb durchgeführt werden.

Da die Beschaffung eines solchen Großrechnersystems mit hohen Kosten und Aufwänden verbunden ist, erfolgt diese im Regelfall als Teilaufgabe eines größeren IT-Projekts, das ausgehend von einer strategischen Entscheidung zahlreiche zusätzliche Aufgaben und Rahmentätigkeiten umfasst – von der Anforderungsanalyse bis hin zur Datenübernahme und Einrichtung des Echtbetriebs.

Aufgrund der Bedeutung des Systems für die Kernprozesse des Unternehmens ist aus Beschaffungssicht besonderes Augenmerk auf die vertragliche Gestaltung zu legen, wobei speziell die Aspekte der Wartung und des Service im Vordergrund stehen.

Serversysteme

Unter einem Server (im älteren Sprachgebrauch auch „Host“ genannt) versteht man einen Computer, dessen Leistungsmerkmale darauf abgestimmt sind, Serveranwendungen zu betreiben. Typische Einsätze sind etwa als Mail-Server, File-Server, Web-Server oder Applikationsserver.

Ein Server ist darauf ausgelegt, mit mehreren Clients zu kommunizieren und je nach Anwendungsgebiet entsprechende Serverdienste anzubieten.

Grundsätzlich ist die Hardware eines Serversystems auf ausfallsicheren Dauerbetrieb ausgelegt und liefert typischerweise über Monitoring-Schnittstellen laufend Informationen über den Systemzustand, sodass eine vorbeugende Instandhaltung (z.B. Austausch einer Harddisk rechtzeitig vor Plattencrash) durchgeführt werden kann. Dadurch ist auch eine langfristige Planung der Ersatzteilbeschaffung möglich. Bei der Beschaffung von Serversystemen ist neben der Abstimmung der Leistungsparameter auf den jeweiligen Anwendungsfall auch darauf zu achten, eine passende Service- und Wartungsvereinbarung abzuschließen.

Der Trend der letzten Jahre weist in Richtung einer sogenannten Server-Konsolidierung, wobei einzelne dedizierte Server durch Virtualisierung auf einem einzelnen performanten Serverkomplex ersetzt werden. Diese Variante ermöglicht die rasche Anlage neuer Server-Images mit Standard-Betriebssystemen, auch eine Anpassung an geänderte Performanceanforderungen ist damit leichter möglich.

Bei der Beschaffung von Serversystemen ist neben der Abstimmung der Leistungs-parameter auf den jeweiligen Anwendungsfall auch darauf zu achten, eine passende Service- und Wartungsvereinbarung abzuschließen.

Der Trend der letzten Jahre weist in Richtung einer sogenannten Server-Konsolidierung, wobei einzelne dedizierte Server durch Virtualisierung auf einem einzelnen performanten Serverkomplex ersetzt werden. Diese Variante ermöglicht die rasche Anlage neuer Server-Images mit Standard-Betriebssystemen, auch eine Anpassung an geänderte Performanceanforderungen ist damit leichter möglich.

Arbeitsplatzrechner

Dabei handelt es sich um Computer, die im Unternehmenskontext in Bezug auf die Softwareausstattung meist standardisiert sind und neben den typischen Office-Aufgaben auch als Clients für die Serversysteme (z.B. Netzlaufwerke, E-Mail, Applikationen) fungieren.

Aus Beschaffungssicht ist bei der Bestellung auf eine passende Konfiguration zu achten, die einerseits eine gewisse Zukunftssicherheit (absehbare zusätzliche Leistungserfordernisse während des geplanten Lifecycles) und andererseits eine gute Kosten-Nutzen-Relation gewährleistet.

Um einen effizienten Betrieb und eine reibungslose Wartung der Systeme sicherzustellen, sollte eine gewisse Anzahl gleicher Systeme auf einmal bestellt werden. Neben der dadurch zu erzielenden Skaleneffekte (Rabattierung des Kaufpreises) kann auch, bedingt durch die identen Hardware-Komponenten, im Fehlerfall rascher reagiert werden. Dabei sollten auch einige zusätzliche Systeme beschafft und vorinstalliert bzw. im Update-Zyklus mitbetreut werden, um gegebenenfalls einen raschen Austausch eines Arbeitsplatzrechners zu ermöglichen.

Workstations

Unter Workstations versteht man Arbeitsplatzcomputer, die für besondere Aufgabenstellungen dediziert sind. Beispiele dafür sind etwa Spezialaufgaben wie Berechnungen und Auswertungen (z.B. Data Warehousing, Data Mining, Management-Informationssysteme, …), Laborsysteme, Grafikbearbeitung und CAD, CAM.

Die Beschaffung solcher Systeme muss in Abstimmung mit bzw. auf Anforderung von betroffenen Nutzergruppen durchgeführt werden und sich an den besonderen Erfordernissen (Leistungsparameter, Software, …) orientieren.

Eine besondere Herausforderung dieser Systeme ist das entsprechende Life-Cycle-Management, da diese Computer im Gegensatz zu normalen Arbeitsplatzcomputer eine typischerweise lange Lebensdauer besitzen und sich die Wiederbeschaffung u. U. als schwierig erweisen kann, etwa falls für den Betrieb der Workstation-Software eine darauf abgestimmte und maßgeschneiderte Hardware erforderlich ist.

Software

Bei der Beschaffung von Software im Unternehmenskontext müssen folgende unterschiedliche Kategorien von Softwaresystemen unterschieden werden:

Betriebssystem-Software

In diesem Kontext reicht der Bogen von proprietärer Systemsoftware (z.B. für Mainframes) über Standard- und Open-Source-Betriebssystemsoftware für Server und Clients bis hin zu maßgeschneiderter Betriebssystem-Software für Sonderbetriebs-umgebungen, die etwa eine Zertifizierung erfordern (z.B. Hochsicherheitsumgebungen, medizinische Laborsysteme, …).

Software für Office-Standardanwendungen

Darunter versteht man eine meist gebündelte Zusammenstellung von Software zur Unterstützung der typischen Büroaufgaben wie E-Mail, Textverarbeitung, Tabellenkalkulation, Präsentation und Visualisierung, wobei die einzelnen Teile über eine einheitliche Benutzeroberfläche verfügen.

Applikationssoftware

Diese Softwaresysteme decken einen ganz bestimmten Aufgabenbereich der unternehmerischen Datenverarbeitung ab und sind entweder branchenneutral oder branchenspezifisch ausgerichtet. Beispiele dafür wären etwa Produktions-planungs- und -steuerungssysteme (PPS), Finanzbuchhaltungssysteme, Vertriebs-lösungen (CRM-Systeme), Materialbestandsführungssysteme, ERP-Systeme u.v.a.m.

Je nach Anforderung kann es sich dabei um individualentwickelte oder vorgefertigte Software handeln, wobei auch im Falle der vorgefertigten Standardsoftware meist im Rahmen eines Implementierungsprojektes unternehmensspezifische Anpassungen vorgenommen werden. Im Folgenden werden die beiden Varianten mit ihren Vor- und Nachteilen gegenübergestellt.

Individualsoftware vs. Standardsoftware

Unter Individualsoftware werden Softwarelösungen verstanden, welche spezifisch für die jeweiligen Auftraggeber*innen entwickelt werden, um deren individuellen Anforderungen und Prozesse bestmöglich zu unterstützen und eventuelle Wettbewerbsvorteile, die in einem Standardsoftwaresystem nicht abgebildet werden können, abzusichern.

Unter Standardsoftware werden Softwarelösungen verstanden, welche für einen spezifischen Anwendungsbereich entwickelt wurden, um diesen mit einer Standardfunktionalität abzudecken. Anpassungen der Standardsoftware bzw. an den unterstützten Prozessen sind nur in einem beschränkten Maß über vordefinierte Schnittstellen und Optionen möglich und werden als Customizing bezeichnet. Es ist somit die Entscheidung zu treffen, auf welche Art und Weise die betrieblichen Prozesse von der IT unterstützt werden sollen.

Vorteile der Individualsoftware:

- Exakte Abbildung der vorliegenden betrieblichen Prozesse

- Effiziente Unterstützung der Mitarbeiter*innen am Prozess

- Keine organisationalen Veränderungsprozesse im Unternehmen notwendig

- Erhalt eventueller Wettbewerbsvorteile

Folgende Herausforderungen bestehen bei der Individualsoftware:

- Hohes Projektplanungs- und -abwicklungs-Know-how muss vorhanden sein

- Risiko des Projekterfolges der Entwicklung liegt im Unternehmen

- Kostenabschätzung der Gesamtentwicklung nur sehr schwer möglich

- Kein Knowhow-Transfer bezüglich optimierter Prozesse

- Erweiterung des Softwareumfangs teilweise nur schwer möglich

- Keine standardisierten Schnittstellen

- Abhängigkeit gegenüber dem extern beauftragten Softwarehersteller oder den eigenen Mitarbeiter*innen

- Oftmals unklare Wartungssituation

Bei Standardsoftware sieht die Situation diametral entgegengesetzt aus. Die Vorteile sind:

- Standardisierte und vom Hersteller gewartete Schnittstellen

- Automatisches und über einen Wartungsvertrag abgesichertes Bug-Fixing

- Neue Releases durch Hersteller

- Erweiterbarkeit gemäß den vorgesehenen Schnittstellen

- Prozessspezifisches Know-how wird zugekauft (Referenzprozesse, Best Practices)

- Möglichkeit des Business-Process-Reengineerings im Zuge des Implementierungsprozesses

- Typischerweise geringere Kosten als bei der Eigenentwicklung

Ein oft vom IT-Management stark unterschätzter Vorteil von Standardsoftware stellt der Knowhow-Transfer im Sinne von Referenzmodellen dar: durch die vorgegebenen und teilweise starren Prozessabläufe in der Standardsoftware wird den Unternehmen ein formal korrektes Vorgehen in Bezug auf IT-Governance und IT-Compliance vorgeschrieben, z.B. das Vier-Augen-Prinzip bei Freigabeprozessen.

Hierdurch findet ein Business-Process-Reengineering statt, das die Wertschöpfung im Unternehmen erhöhen kann, da die Prozesse, die in der Standardsoftware abgebildet sind, mit den größten Unternehmen der Branche entwickelt wurden. Zudem können jederzeit externe Spezialist*innen zugekauft werden, die Wartung und Erweiterung übernehmen können.

Die Nachteile sind ebenso klar: Die eigenen Prozesse werden abgeschafft, Wettbewerbsvorteile können verlorengehen, es erfolgt eine langfristige Bindung an einen Lieferanten, usw.

Abschließend sei angemerkt, dass es sich bei Standardsoftware ähnlich wie bei vielen anderen Produkten verhält: ein strategischer Einstieg in den ersten Jahren der Marktpräsenz eines Softwareproduktes (Wachstumsphase) gilt als risikoreich, da sich noch keine Stammkundenbasis gebildet hat, die dem Hersteller durch wiederkehrende Betreuungen konstante Einnahmen beschert – somit ist die Zukunft des Herstellers und seines Produktes nicht gesichert.

In Bezug auf die Funktionalität sind nach Sättigung des Marktes die marktführenden Lösungen in der Regel in der Lage, die grundlegenden Bedürfnisse abzudecken und bieten die Möglichkeit, fehlende Funktionalität mittels Schnittstellen anzubinden. Aktuelle Beispiele für gesättigte Märkte sind etwa CRM und ERP.

Open-Source vs. kommerzielle Software

Open-Source-Software ist gekennzeichnet durch die freie Nutzung und freie Verfügbarkeit des Source-Codes. Veränderung am Source-Code zur Weiterentwicklung und Abänderung an die spezifischen Anforderungen sind frei möglich, in Abhängigkeit der unterschiedlichen Lizenzen, unter der die Open-Source-Software entwickelt wurde, z.B. GNU GPL.

Freeware ist dadurch gekennzeichnet, dass nur eine kostenlose Nutzung vorliegt, jedoch der Source-Code nicht frei verfügbar ist.

Kommerzielle Software ist durch das Eigentum des Herstellers an der Software gekennzeichnet und der Source-Code steht dem/r Kund*in im Regelfall weder zur Verfügung noch dürfen Veränderungen am Source-Code vorgenommen werden.

In manchen Ausnahmefällen werden allerdings Sonderregelungen vertraglich vereinbart, z.B. wenn eine businesskritische Anwendung von einem „kleinen“ Hersteller individualprogrammiert wird. In solchen Fällen macht eine vertragliche Absicherung des Zugriffs auf den Source-Code bei Eintritt bestimmter Situationen Sinn (z.B. Lieferantenkonkurs). Hierbei wird der Source-Code etwa bei einem Notar hinterlegt („Escrow-Vereinbarung“).

In Abhängigkeit von der spezifischen Software ist jedoch eine Konfiguration im Rahmen der vom Hersteller gegebenen Möglichkeiten gemäß den spezifischen Anforderungen durchführbar (Customizing).

Für die Nutzung von Open-Source sprechen vor allem drei Faktoren:

- Kostenvorteile durch wegfallende Lizenzkosten.

- Unabhängigkeit von einzelnen Herstellern auf Basis des frei zugänglichen Source-Codes und Unterstützung von breit gefächerten Communities.

- Qualitäts- und Effizienzvorteile dank offenem Zugang zum Source Code.

Derzeit existiert für viele Geschäftsprobleme ein reichhaltiges Angebot an generischen Open-Source-Komponenten - wie z.B. Workflow-Engines, Rule-Engines, Business-Analytics und Web-Commerce-Engines. Für spezielle, branchenspezifische Anforderungen bestehen zumeist keine speziellen Open-Source-Lösungen, was aber nicht heißt, dass nicht durch eine individuelle Implementierung branchenspezifische Prozesse abgebildet werden können.

Besonders vorteilhafte Lösungen im Open-Source Bereich finden sich in jenen Teilgebieten, die bereits einen hohen Reifegrad aufweisen, von der Community stark unterstützt werden, einen oder mehrere strategische kommerzielle Partner haben, in vielen Unternehmen eingesetzt werden und schon lange auf dem Markt sind.

In folgenden Bereichen ist Open Source Software bereits seit vielen Jahren erfolgreich im Einsatz:

- ERP (z.B. Openbravo)

- Server Betriebssysteme (z.B. Linux, FreeBSD, Android)

- Network Management (z.B. OpenNMS)

- Web Server (z.B. Apache)

- Application Server (z.B. JBoss)

- Customer Relationship Management (z.B. SugarCRM)

- Document Management Systeme (z.B. LogicalDOC)

- Content Management Systeme (z.B. TYPO3)

- Enterprise Integration (z.B. MuleESB, FUSE ESB)

- Entwicklungsumgebungen (z.B. Eclipse)

Ein Kritikpunkt an Open-Source-Softwareprodukten ist das Fehlen einer verantwortlichen Person, die beim Auftreten grober Mängel die rechtlichen Konsequenzen trägt. Diesem Kritikpunkt begegnen die Investoren, die hinter den großen Open-Source-Softwareprodukten stehen, mit entsprechenden Wartungsverträgen.

Bei der Planung des Einsatzes von Open-Source-Softwareprodukten ist zu beachten, dass zusätzliche Kosten und anders gelagerte Abhängigkeiten entstehen können:

- Mitarbeiter*innen für Projektplanung, Customizing, Betrieb und Wartung können aufgrund der geringen Verfügbarkeit am Markt teurer sein als Personen mit Knowhow der kommerziellen Software.

- Die dadurch entstehende Abhängigkeit von diesen Mitarbeiter*innen.

- Migrationskosten durch Updates auf neue Releases, die in der Regel problembehafteter sind als bei kommerzieller Software.

- Mangelnder Support für notwendige Schnittstellen zu anderen Systemen.

- Höhere Schulungskosten für interne Mitarbeiter*innen, die diese Systeme nutzen.

Auch an dieser Stelle gilt, dass eine klare Aussage zugunsten einer der beiden Alternativen nicht möglich ist. Wie die Auflistung des erfolgreichen Einsatzes oben jedoch zeigt, sind mittlerweile Open-Source-Softwareprodukte in vielen Gebieten ernsthafte Konkurrenz für kommerzielle Anbieter geworden und dieser Trend scheint sich auch durch den Einstieg großer Investoren weiter fortzusetzen.

Relevante Kriterien für Anbieter von Standardsoftware

Eine solide Basis für den Vergleich der Fähigkeiten von Lieferant*innen und ihrer Lösungen stellt die aggregierte Sicht von Analyst*innen dar. Dies sind Marktanalysen, die von Expert*innen aufbereitet wurden und von diesen gegen Entgelt zur Verfügung gestellt werden.

An dieser Stelle seien etwa die Gartner Quadranten genannt, die es zu vielen verschiedenen Softwareprodukten gibt. Die Analyse der Gartner Quadranten umfasst eine Darstellung auf zwei Achsen:

- „Completeness of vision“ - frei übersetzt „Strategische Perspektive“, „Vollständigkeit der Vision“

- „Ability to execute“ - frei übersetzt „Aktueller Erfüllungsgrad“, „Fähigkeit zur Umsetzung der Vision“

Anhand dieser beiden aggregierten Kennzahlen werden die Anbieter, die eine relevante Marktstellung haben (ausreichende Anzahl von Kund*innen sowie relevante Umsatzzahlen in diesem Markt) in vier Kategorien eingeteilt:

| Niche Players: | niedrige Completeness of vision | niedrige Ability to execute |

| Visionaries: | hohe Completeness of vision | niedrige Ability to execute |

| Challengers: | niedrige Completeness of vision | hohe Ability to execute |

| Leaders: | hohe Completeness of vision | hohe Ability to execute |

Generell ist jeder Hersteller, der es in den Quadranten schafft, in seinem Markt in Bezug auf Langlebigkeit und finanzielle Situation soweit etabliert, so dass Support und unterstützende Dienstleistungen über Jahre hinaus garantiert sein sollten.

Es gilt jedoch zu bedenken, dass der Gartner Quadrant stark auf den US-amerikanischen Markt fokussiert ist und manche der dargestellten Anbieter in Europa nur begrenzt oder gar nicht tätig sind.

In der folgenden Abbildung "Gartner Quadrant für EMC Software" – als Beispiel für eine typische Quadrantendarstellung - wurden die Enterprise-Content-Management-Softwarehersteller durch die Gartner Group im Oktober 2015 eingeschätzt.

Software-Wartungsverträge

Ziel eines Software-Wartungsvertrags ist es, die Software für die geplante Einsatzzeit funktions- und einsatzfähig zu halten. „Funktionsfähig“ bedeutet, dass auch Fehler, die während der Nutzungszeit auftreten, unentgeltlich vom Softwarehersteller behoben werden, unter „einsatzfähig“ versteht man, dass die Software für den ursprünglichen Einsatzzweck auch unter geänderten Rahmenbedingungen (z.B. rechtlichen Änderungen) nutzbar bleibt.

Mit dem Abschluss eines solchen Software-Wartungsvertrag erwirbt man also üblicherweise die Verpflichtung des Softwareherstellers oder seines Vertreters, die eingesetzte Software betriebsbereit zu halten oder den Betrieb wiederherzustellen sowie das Anrecht auf unentgeltliche Updates der ursprünglichen Software während dessen Laufzeit. In diesem Vertrag kann auch das Anrecht auf funktionelle Neuerungen oder Verbesserungen enthalten sein.

Der Betrag, der für die Erbringung der Leistungen aus einem Wartungsvertrag von einem Softwarehersteller verlangt wird, liegt typischerweise pro Jahr zwischen fünf und 30 Prozent der ursprünglichen Lizenzkosten.

Darüberhinausgehend ist zu differenzieren, welche Bedeutung die betreffende Software für die Unternehmenstätigkeit besitzt und ob es sich um Individual- oder Standardsoftware handelt. Bei unternehmenskritischen Applikationen zur Unterstützung von Kernprozessen wird ein zusätzlicher Servicevertrag (SLA) abzuschließen sein, der genaue Vereinbarungen über Reaktions- und Behebungs- bzw. Wiederherstellungszeiten enthält. Näheres dazu siehe Kapitel 2 und weiter unten beim Abschnitt „IT-Outsourcing“.

Software-Lizenzmanagement

Jeder Hersteller, der eine Software entwickelt und verkauft, legt fest, unter welchen Nutzungsbedingungen diese verwendet werden darf. Die korrekte Lizenzierung der im Betrieb eingesetzten Software besitzt also für jedes Unternehmen rechtliche Folgewirkungen. Somit ist das damit verbundene Softwarelizenzmanagement – wie viele Lizenzen beschafft wurden und wie viele installiert wurden bzw. sich im Einsatz befinden – ein wichtiges Thema.

Neben den weiter unten beschriebenen Lizenzierungsformen der proprietären Software gibt es auch noch den Bereich der Open-Source-Lizenzen, wobei auch diese mit Lizenzbedingungen versehen sind, welche den Einsatz und die Weiterverbreitung der Software beschränken können (z.B. GNU GPL). Auf die weiteren Lizenzformen der Freeware, Shareware und Free Software wird an dieser Stelle nicht weiter eingegangen, da sie im Unternehmenskontext von geringerer Bedeutung sind.

Lizenzmodelle proprietärer Software, für deren rechtmäßige Nutzung ein einmaliges oder wiederkehrendes Entgelt zu bezahlen ist, können etwa durch folgende Faktoren charakterisiert werden:

- Lizenzart: Einzelplatzlizenz, Mehrbenutzerlizenz, unternehmensweite Lizenz, …

- Lizenzklasse: Vollversion, beschränkte Version, Upgrade-Lizenz, …

- Lizenzmetrik: legt die Grundlage fest, nach der lizenziert wird: Anzahl der Systeme, der Prozessoren, der Benutzer*innen, Größe des verwalteten Speicherplatzes, …

- Lizenz-Laufzeit: pro Jahr, unbeschränkt, …

Aus Unternehmenssicht gibt es zwei Arten von unerwünschtem Lizenzbestand, der Lizenzüber- und -unterdeckung:

Von Lizenzüberdeckung wird gesprochen, wenn die Anzahl der vorhandenen Lizenzen die Anzahl der installierten Lizenzen übersteigt. Der umgekehrte Fall, wenn die Anzahl der Lizenzen nicht ausreicht, um die Anzahl der installierten Softwarepakete zu decken, spricht man von Lizenzunterdeckung.

Der Grund für diese Fehlentwicklung liegt im Auseinanderklaffen der drei Lizenzzustände „gekaufte Lizenzen“, „installierte Lizenzen“ und „genutzte Lizenzen“. Sehr häufig wird auf Arbeitsplätzen ein lizenzpflichtiges Softwareprogramm „zur Sicherheit“ installiert, ohne den genauen Bedarf dafür im Vorfeld erhoben und einen Check mit der Anzahl der zur Verfügung stehenden, erworbenen Lizenzen gemacht zu haben.

Von den nun installierten Lizenzen wird nur ein Teil von den Mitarbeiter*innen tatsächlich genutzt, sodass eine gewisse Anzahl von installierten aber nicht genutzten Lizenzen auf den Arbeitsplatzrechnern vorhanden ist.

Um diesem Missstand zu begegnen ist es unbedingt erforderlich, ein professionelles Lizenzmanagement einzuführen.

Das Lizenzmanagement beginnt mit klassischen Inventuren:

Zuerst wird eine Inventur der installierten Software durchgeführt: Dazu werden alle Laptops, PCs und Server in eine Datenbank aufgenommen und die installierte Software pro Einheit genau dokumentiert, da sich die Software durch Unterschiede in den Versionen (z.B. Microsoft Office Professional oder Microsoft Office Small Business) sowie in den Releases (z.B. Service Pack 1 oder 2) unterscheiden können. In der Praxis muss dafür von Gerät zu Gerät gegangen werden, um sicherzustellen, dass keine Geräte und auch keine installierte Software übersehen werden.

Im Zuge dessen wird auch über die an diesem Gerät vorgesehenen Tätigkeiten im Gespräch mit dem/r betroffenen Mitarbeiter*in bzw. der betroffenen Organisationseinheit festgestellt, ob alle installierten lizenzpflichtigen Softwaresysteme tatsächlich auch erforderlich sind und aktiv genutzt werden. Falls dies nicht der Fall ist, wird die entsprechende lizenzpflichtige Software vom Gerät gelöscht.

In einem zweiten Schritt wird eine Inventur der vorhandenen (= erworbenen) Lizenzen vorgenommen, d.h. alle im Unternehmen befindlichen Lizenzen werden erhoben und dokumentiert.

Im dritten Schritt erfolgt die Zusammenführung der Daten der beiden ersten Schritte in der Lizenzbilanz. In ITIL wird dieser Vorgang über die Definitive Media Library (DML) in Verknüpfung mit der Configuration Management Database (CMDB) abgehandelt.

Nun wird situationsbedingt gehandelt: bei Lizenzüberdeckung werden überflüssige Lizenzen verkauft oder gekündigt, bei Lizenzunterdeckung die notwendigen Lizenzen nachgekauft. Nach dieser Analyse beginnt der rollierende Prozess des Lizenzmanagements. Die IT-Abteilung dokumentiert jede Veränderung der installierten Software. Dadurch kann auf neue Gegebenheiten flexibel reagiert werden.

Auch bietet dieser Prozess den Unternehmen die Möglichkeit, den Ankauf von Software zu planen. Somit kommen der IT-Beschaffung auch die zur Erzielung eines günstigen Preises notwendigen Informationen zu. Neben den oben erwähnten Einzelplatzlizenzen, bei der jede Installation auf einem Computer als Lizenz zählt („per seat“), gibt es noch weitere Sonderformen von Lizenzvereinbarungen, die in erster Linie bei unternehmensweiten oder zumindest arbeitsplatzübergreifenden Server-Softwaresystemen zum Einsatz kommen:

Softwarelizenz nach Concurrent Users: nicht die Anzahl der im System registrierten Benutzer legt die zulässige Anzahl an Lizenzen fest, sondern die maximale Anzahl an gleichzeitig auf die Ressource zugreifenden Clients („Floating Licences“). Diese Lizenzform wird z.B. für Systeme angewendet, die nur punktuell, aber von einer hohen Anzahl von Usern verwendet werden können sollen (Beispiel: Auskunfts- und Auswertungsfunktionen, temporär genutzte Arbeitsplätze).

Softwarelizenz nach Registered Users (oder Named Users): dies entspricht der oben beschriebenen Lizenzierungsform, umgelegt auf Server-Softwaresysteme: jeder User, der im System registriert ist, zählt als Lizenzverbrauch.

Ebenfalls von Bedeutung sind die beiden Lizenzierungsformen Prozessor-Lizenz, bei der ein Hersteller die Erlaubnis einräumt, die Software auf einer bestimmten Hardware zu nutzen und die Company-Lizenz, bei der die Lizenzierung für den unternehmensweiten Gebrauch der Software ohne Überprüfung der tatsächlichen Anzahl der Nutzer gilt.

Immer weniger genutzt wird die Sicherstellung der korrekten Lizenzierung durch Hardware, etwa einem USB-Stick oder einem Dongle, der an eine Schnittstelle des PC angeschlossen wird.

Das Lizenzmanagement sollte durch ein entsprechendes Software-Tool, das einen einfachen Abgleich des Ist- mit dem Soll-Zustand ermöglicht, unterstützt werden.

Netzwerkkomponenten

Die Aufgaben im Rahmen der Beschaffung von Netzwerkkomponenten zerfallen in zwei Bereiche: die Bereitstellung von Hardware für die Instandhaltung und Instandsetzung bestehender Netzwerke und Netzwerksysteme sowie die Neuanschaffung im Rahmen eines Netzwerkaufbau- oder -erweiterungsprojekts.

Instandhaltung und Instandsetzung: hier gilt es dafür zu sorgen, dass eine ausreichende Menge an Ersatzmaterialien und -komponenten vor Ort vorgehalten wird, da ein Ausfall von Netzwerken oder Netzwerkbereichen von gravierenden Folgewirkungen für das Unternehmen sein kann. Der entsprechende Sicherheitsbestand an Komponenten und Materialien leitet sich aus den jeweiligen MTBF-Daten ab. Unter MTBF – Mean Time Between Failures – versteht man die Betriebsdauer, die im Mittel vergeht, bis eine Störung an einem reparierbaren Gerät auftritt.

Netzwerk-Neuaufbau: Hierbei handelt es sich um typisches IT-Projekt, bei dem die Beschaffung der Komponenten und Geräte eine Teilaufgabe darstellt, die detailliert mit den Projektverantwortlichen abgestimmt werden muss (Leistungsparameter, Hersteller, Bereitstellungzeitpunkt). Dass es gerade für den Aufbau und Veränderungen an Netzwerkkomponenten oder -bereichen von eminent wichtiger Bedeutung ist, diese umgehend und detailliert zu dokumentieren, versteht sich von selbst (Verzeichnis und Markierung aller Komponenten, Anschlüsse, Kabel, …).

Mobile Systeme

Besonders wichtig im Zusammenhang mit der Beschaffung mobiler Systeme ist die Einbettung dieses Vorgangs in einen strategischen und organisatorischen Rahmen. Diese Systeme (z.B. Smartphones, Laptops) werden ja im Regelfall auch außerhalb des Unternehmensnetzwerks – und damit auch außerhalb der Überwachungsmöglichkeit durch das Unternehmen – betrieben. Es versteht sich von selbst, dass deshalb entsprechende Rahmenbedingungen vor der Anschaffung von mobilen Systemen sichergestellt werden müssen. Zu diesen Rahmenbedingungen gehören:

Policies: Der/die Mitarbeiter*in, der/die die Verfügungsgewalt über das neu beschaffte mobile System erhält, muss einerseits in der Lage sein, die damit verbundenen Gefahren und Herausforderungen einzuschätzen und andererseits auch verpflichtet werden, sich bei der Nutzung des mobilen Systems entsprechend wohl zu verhalten. Dies geschieht durch die Definition und Unterfertigung einer „Mobile Policy“.

Network Access Control (NAC): Darunter versteht man eine Technik, um den Zugriff von mobilen Systemen auf ein Netzwerk zu kontrollieren. NAC prüft nach Anschluss des Gerätes an das Netzwerk während des Authentifizierungsvorgangs, ob das neu angeschlossene System den internen Richtlinien (Aktualität der Sicherheitsparameter wie Virenschutz, Patchstand, Betriebssystem-Updates, …) entspricht und erzwingt im Differenzfall deren Aktualisierung, bis das System den geltenden Richtlinien entspricht. Erst dann kann sich das mobile System einloggen und vom User im Netzwerk genutzt werden. Speziell im Fall von BYOD (siehe unten) oder einer häufigen Notwendigkeit, unternehmensfremde Systeme in das Unternehmensnetzwerk einzubinden (z.B. Dienstleister*innen, Partner*innen, Lieferant*innen oder Kund*innen) ist der Einsatz dieser Technik von großer Bedeutung.

Mobile Device Management (MDM): Dieser Begriff beschreibt die zentralisierte Verwaltung mobiler Geräte mit dem Ziel, das interne Netzwerk zu schützen und die Kontrolle über die Sicherheit und Verwendung dieser mobilen Geräte zu behalten. MDM-Systeme sind Software-Anwendungen, die einem Administrator mobiler Geräte folgende Funktionalitäten in die Hand geben:

- Datensicherung und Datensynchronisation der mobilen Geräte.

- Wiederherstellung von Daten, Programmen und Apps mobiler Geräte.

- Kontrolle über installierte Programme und Apps, Löschen unzulässiger Software.

- Updates von installierten Betriebssystemen, Programmen und Apps.

- Fernlöschung von mobilen Geräten (z.B. bei Diebstahl oder Verlust von Smartphones).

- Lokalisierung von mobilen Geräten (bei Smartphones mit GPS).

Optimaler Weise sollte die MDM-Software mit den gängigen Betriebssystemen und relevanten Anwendungen kompatibel sein, sodass auch Geräte verwaltet werden können, die z.B. im Rahmen einer „Bring Your Own Device“ (BYOD)-Regelung von Mitarbeitern im Unternehmensnetzwerk verwendet werden.

BYOD bezeichnet einen Trend, den Mitarbeiter*innen die Nutzung eigener Geräte (vornehmlich mobiler Geräte wie Smartphones) im Unternehmen zu erlauben. Aus leicht verständlichen Gründen kann allerdings eine solche Erlaubnis nur mit darauf abgestimmten Rahmenbedingungen erteilt werden (Sicherheitsrisiko). Dem Unternehmen müssen in diesem Kontext Rechte auf dem betreffenden Gerät eingeräumt werden, die im Anlassfall auch eine Kontrolle des Gerätes bis hin zum Fernlöschen erlauben (etwa zum Schutz unternehmensrelevanter Daten bei Verlust des Gerätes).

Auch sollte vorab geregelt werden, wer im Fall eines Schadens am Gerät, der während der betrieblichen Nutzung eintritt, haftet. Um diese und weitere Punkte zu regeln sollte vom Unternehmen eine entsprechende BYOD-Policy verfasst und durchgesetzt werden.

Outsourcing von IT-Services

Einleitung

Externe Dienstleistungen werden für Unternehmen immer wichtiger. Dabei spielen die Themen Innovationsdruck, Änderungen im wirtschaftlichen Umfeld und die zunehmende Digitalisierung auch in der Realwirtschaft eine immer größere Rolle. Die Komplexität und Heterogenität, der mit dem erfolgreichen Betrieb einer Unternehmens-IT verbundenen Aufgaben verlangt darüber hinaus nach Kompetenzen und Knowhow, die oft einfacher und rascher durch die Beauftragung externer Dienstleister abgedeckt werden können.

Das Outsourcing von IT-Services ist also mit besonderen Herausforderungen verbunden, die im folgenden Abschnitt dargelegt werden.

Grundsätzlich kann man als Leitlinie ansehen, dass in jenen Bereichen, in denen in der Vergangenheit im eigenen Unternehmen wichtiges Knowhow aufgebaut wurde, also in den „eigenen Stärken“ mit der Auslagerung von IT-Services vorsichtig umgegangen werden sollte, denn zu groß ist die Gefahr des Verlusts wesentlichen Unternehmens-wissens. Zahlreiche Unternehmen, die den Weg eines umfassenden Outsourcings beschritten haben, mussten zumindest in Teilbereichen reumütig wieder zurückkehren (Backsourcing), was mit großen Aufwänden und Reibungsverlusten verbunden war.

Das Schlagwort der „Konzentration auf die eigenen Stärken und Vermeiden von Schwächen“ trifft in diesem Bereich den Kern der Entscheidungsfindung – denn in vielen Fällen kann ein externer Dienstleister durch Skaleneffekte und Knowhow-Konzentration Standardthemen besser, effizienter und letztendlich günstiger übernehmen.

Vorgehensweise im IT-Outsourcing Prozess

Der Ablauf des Outsourcing Prozesses gliedert sich in verschiedene Phasen:

1. Outsourcing Entscheidung

Am Beginn steht die strategische Entscheidung, ob der Prozess outgesourct werden kann/soll, beispielsweise anhand strategischer Relevanz, Kernkompetenz, Kritikalität.

2. Partner Screening

Danach werden die potentiellen Partner nach vorab definierten Kriterien ausgewählt, kontaktiert und evaluiert, beispielsweise nach Sicherheit des Fortbestandes, Preisstabilität, Servicequalität, Skalierbarkeit.

3. Service Level Definition

Anschließend an die Entscheidung für einen Outsourcing-Partner folgt die Definition der Service Levels und die Etablierung von Kennzahlen zur Messung der Einhaltung dieser Service Levels. Eventuell werden noch Vereinbarungen zur Leistung von Pönalzahlungen bei Mindererfüllung abgeschlossen. Die Vertragsunterzeichnung beendet diese Phase.

4. Implementierung des Services

Der vertraglich vereinbarte Prozess wird implementiert.

5. Kontinuierlicher Verbesserungsprozess

Der Prozess wird überwacht, gesteuert und verbessert.

Im laufenden Betrieb gilt es, einerseits die Mitarbeiter im eigenen Unternehmen zum kostenbewussten Umgang mit der outgesourcten IT, sowie andererseits den externen IT Dienstleister zu kontinuierlich hohen Leistungen anzuspornen.

Kostenverlauf bei IT-Outsourcing

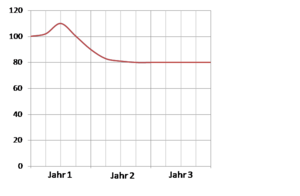

IT-Outsourcing zu einem spezialisierten IT Dienstleister bringt zumeist die Erwartung an Kosteneinsparungen mit sich. In vielen Fällen standardisierter Services entwickeln sich die Kosten jedoch wie in der Abbildung "Typische Kostenverläufe bei Outsourcing" dargestellt:

In der Übergangsphase steigen die Kosten, da Transparenz geschaffen werden muss (z.B. durch externe Berater*innen und durch den Aufbau eines internen Controllingsystems), sowie Transaktionskosten (durch die Übergabe der internen Ressourcen beim Start des Outsourcings), die an den externen Dienstleister anfallen. Erst in den Folgejahren schlägt die Einsparung merklich zu Buche, und es sind Einsparungen von durchschnittlich 20 % durch Effizienzsteigerungen erreichbar.

In der Abbildung "Typische Kostenverläufe bei Outsourcing" wird im Jahr 1 im ersten Quartal die Entscheidung getroffen, Outsourcing zu betreiben, da Benchmarks gezeigt haben, dass die Kosten der internen IT Abteilung über dem Marktwert liegen.

In Quartal 2-3 werden die Schnittstellen und der neue Prozess definiert; diese werden Mitte Q3 in Betrieb genommen. Nachdem der Prozess sich bei dem Dienstleister eingespielt hat, konnten schon im 2. Quartal des zweiten Jahres die Einsparungen realisiert werden.

Vertragsinhalte beim IT-Outsourcing

Ein IT-Outsourcing Vertrag besteht aus einem Rahmenvertrag und Einzelverträgen.

Im Folgenden werden die Inhalte dieser beiden Vertragswerke, welche die Basis für die Zusammenarbeit bilden, beschrieben.

Rahmenvertrag

Der Rahmenvertrag beinhaltet die grundlegenden Eigenschaften der Geschäftsbeziehung:

- Vertragspartner

- Vertragsgegenstand und -umfang

- Laufzeit und Kündigung

- Zusammenarbeitsregeln, Kommunikation

- Vergütung

- Datenschutz und -sicherheit

- Haftung

- Rückübertragungsregelung bei späterem Backsourcing

Der Rahmenvertrag gilt in der Regel unbegrenzt. Die Details der jeweiligen Outsourcing-Dienstleistung werden im Einzelvertrag geregelt.

Einzelvertrag / Service Level Agreement

Ein Einzelvertrag wird in der Regel für jedes IT-Service getrennt abgeschlossen. Er beinhaltet:

- Vertragsgegenstand und Geltungsbereich

- Laufzeit, Verlängerungsoptionen und Kündigung

- Genaue Leistungsbeschreibung

- Obligatorische und optionale Leistungen

- Mitwirkungspflichten des Auftraggebers

- Service-Level-Vereinbarungen, Messkriterien und Maßzahlen

- Vergütung und Pönalen

Der Einzelvertrag ist auf bestimmte Zeit abgeschlossen, damit beide Vertragsparteien bei gravierenden Änderungen des Wettbewerbsumfeldes die Preise anpassen können.

Controlling der Outsourcing-Leistung

Ein wesentlicher Aspekt eines erfolgreichen Outsourcings ist die Einrichtung eines entsprechenden Controllings, denn Verträge sind nur insofern zielführend, als deren Einhaltung (Parameter des vereinbarten SLAs) auch überprüft wird und eine eventuelle mangelhafte Erfüllung gemäß Vereinbarung auch Konsequenzen nach sich zieht.

Der damit verbundene organisatorische Aufwand darf jedoch nicht unterschätzt werden (Rollendefinition, Aufwand des Messens und Dokumentieren, Kommunikation mit dem Outsourcing-Partner).

Dieser Aufwand muss daher bereits in der Phase der Entscheidungsfindung für oder gegen ein Outsourcing-Projekt berücksichtigt werden, um eine Kostenwahrheit des Vergleichs mit der Beibehaltung einer Inhouse-Lösung sicherzustellen.

Cloud-Computing

Unter Cloud-Computing versteht man einen immer wichtiger werdenden Trend, der seit etwa 2011 Entscheidungsfindungen in der Beschaffung von IT-Systemen zunehmend beeinflusst. Zahlreiche IT-Dienstleister haben Cloud-Angebote in ihr Produkt-Portfolio aufgenommen, von lokalen Anbietern bis hin zu weltweit tätigen Großunternehmen wie IBM, amazon, Microsoft oder google.

Generell bezeichnet man mit Cloud-Computing die zur Verfügung Stellung von virtuellen IT-Ressourcen über eine Anbindung an das Internet. Um Cloud-Computing nutzen zu können, muss also naturgemäß ein breitbandiger und ausfallsicherer Netzwerkzugang verfügbar sein.

Cloud-Liefermodelle

Es gibt verschiedene Arten von Clouds, die je nach Implementierung eingeteilt werden:

Private Cloud

Bei diesem Szenario befinden sich sowohl Anbieter als auch Nutzer im selben internen Unternehmensnetzwerk, d.h. das Unternehmen betreibt die Cloud selbst, lediglich aus Mitarbeitersicht ändert sich die Nutzung: anstelle des auf seinem Arbeitsplatzcomputer installierten Programms bedient er nun ein Browser-GUI, das via Intranet oder VPN mit der Private Cloud verbunden ist. Datenschutz und Datensicherheit – eine wesentliche Herausforderung der Public Cloud – stellen in diesem Zusammenhang nur ein internes Thema dar.

Public Cloud

Die Public Cloud entspricht der allgemein bekannten Variante des „Cloud“-Sprachgebrauchs, wo ein Anbieter gegen Entgelt oder auch kostenlos Dienste per Internet der gesamten Öffentlichkeit zur Verfügung stellt. Dies ist auch jene Variante, auf die sich dieses Kapitel in erster Linie bezieht.

Hybrid Cloud

Darunter versteht man eine Kombination aus Public Cloud und Private Cloud, wobei typischerweise die Kernprozess-Applikationen in der Private Cloud vom Unternehmen selbst und die Supportsysteme in der Public Cloud eines Anbieters gehostet werden.

Cloud-Servicemodelle

Man unterscheidet grundsätzlich unter folgenden Arten von angebotenen (also Public-) Cloud-Computing-Servicemodellen:

Infrastructure-as-a-Service IaaS

Dabei wird dem Kunden IT-Infrastruktur über das Internet zur Verfügung gestellt. Beispiele wären Speicherkapazität (Storage) oder Rechnerleistung, die vom Kunden genutzt werden können. Der Kunde verwaltet die angemietete Hardware selbst, d.h. eventuelle Server-Instanzen, Softwareanwendungen sowie deren Wartung bleibt in der Hand des Kunden. Die vereinbarte Service-Dienstleistung lässt sich klar und einfach abgrenzen durch die Größe bzw. Leistungsparameter der gemieteten Hardware (z.B. 5 TB Speicherplatz).

Platform-as-a-Service PaaS

Mit diesem Begriff bezeichnet man die Bereitstellung von Plattformen zum Entwickeln und Deployment von Software. Ziel ist es, in einfacher Weise Anwendungen zu entwickeln und zu hosten. Dabei handelt es sich um Webserver, Middleware, Datenbanken und Entwickler-Werkzeuge wie Security-Komponenten, Dashboards, Reporting-Tools, Single-Sign-On-Dienste u.v.a.m. Die Nutzer eines PaaS-Dienstes sind also in erster Linie Entwickler und Systemarchitekten.

Software-as-a-Service SaaS

Das SaaS-Angebot ermöglicht Endanwendern – z.B. Büro-Mitarbeitern – die Nutzung von Software, die früher auf den PCs der User installiert werden musste über die Browseroberfläche. Der Cloud-Anbieter stellt die Software bereit, der Nutzer benötigt lediglich einen Internet-Zugang und einen Browser, der die Spezifikationen der Software-Clientanwendung (GUI) erfüllt.

Typische Angebote für SaaS sind z.B. die Nutzung von Büro-Software (Textverarbeitung, Tabellenkalkulation, E-Mail), ERP- und CRM-Systeme, Projektmanagement-Software u.v.a.m. Im Folgenden werden Vorteile und Herausforderungen des Cloud-Computings diskutiert.

Einige Vorteile, die damit verbunden sind:

- Investitionskosten: Wegfall von Investitionen für Dienste und Systeme, die nur selten genutzt werden.

- Personalkosten: Wegfall der Erfordernisse speziellen Knowhows und Personals für den Betrieb von Systemen

- Skalierbarkeit: Einfache Anpassung der genutzten IT-Kapazität an geänderte wirtschaftliche Rahmenbedingungen (Erhöhung und Verringerung der benötigten IT-Leistungen)

- Reduzierter Wartungsaufwand: Backup, Update und Versionsmanagement werden vom Cloud-Anbieter durchgeführt

- Schnelle Implementierung und Einführung, geringe Schulungskosten

- Nutzung des aktuellen Stands der Technik

- Risikotransfer zum Cloud-Anbieter, der sich an die Parameter des SLAs halten muss (Sicherheit und Verfügbarkeit)

Diesen Vorteilen stehen einige Herausforderungen und Nachteile gegenüber:

- Abhängigkeit vom Cloud-Anbieter, schwieriger Anbieterwechsel oder Backsourcing

- Hoheit über unternehmenskritische Daten

- Zuverlässigkeit der Internet-Anbindung

- Abbau eigener IT-Kompetenzen

- Integration von Systemen unterschiedlicher Anbieter oder mit Inhouse-Applikationen

- Möglicher Verlust von Wettbewerbsvorteilen durch Standardisierung von Prozessen und Anwendungen

- Einhalten rechtlicher Bestimmungen (z.B. Forderung nach Datenverarbeitung innerhalb der EU)

- Datensicherheit und Datenschutz

In jedem Fall ist beim Ersetzen von Inhouse-Kernprozess-Anwendungen durch einen SaaS-Anbieter äußerste Vorsicht geboten. Hier empfiehlt es sich, eine genaue Risikoevaluierung durchzuführen (Ausfallszenarien, Compliance) und gegebenenfalls ein laufendes Risikomanagement zu etablieren sowie die vertragliche Situation genau zu prüfen (Nutzungsbedingungen, Sicherheitsaspekte, Datenschutz).

Viele Unternehmen gehen deshalb in Richtung Hybrid Cloud, bei der die businesskritischen Anwendungen selbst betrieben werden und lediglich die Supportprozess-Unterstützung (z.B: Büro-Software) im SaaS-Modell betrieben werden.

Weitere Bereiche

Grundsätzlich fällt die Beschaffung aller technischer Systeme, die ins Netzwerk eingebunden werden – z.B. auch Produktionsanlagen, Laborsysteme, Telefonsysteme, u.v.a.m. – auch in den Kompetenzbereich der Beschaffung von Informationssystemen.

Wenn auch der Beschaffungsvorgang selbst meist durch die jeweiligen Fachabteilungen selbst angeregt und gemeinsam mit dem technischen Einkauf durchgeführt wird, ist eine Mitarbeit der IT-Abteilung zur Beratung, Steuerung und Veranlassung eventueller Begleitmaßnahmen zur Installation und Einbindung des jeweiligen Systems ins Unternehmensnetzwerk vonnöten.

Zusammenfassung dieser Lektion

In dieser Lektion wurden die wesentlichsten Objekttypen, die bei der Beschaffung von betrieblichen Informationssystemen relevant sind, kurz vorgestellt.

Die verschiedenen Arten von Computersystemen erfordern auch eine unterschiedliche Behandlung im Zuge ihrer Beschaffung. Der Bogen reicht von Mainframe Computer, und Serversystemen bis hin zu Arbeitsplatzrechnern und Workstations.

Besonderes Augenmerk verdient die Software-Beschaffung. Hier sind die unterschied-lichen Typen von Software zu beachten, die auch jeweils andere Erfordernisse bei der Beschaffung aufweisen und verschiedene Konsequenzen bei ihrem Einsatz nach sich ziehen. Individualsoftware und Standardsoftware wurden inklusive ihrer Vor- und Nachteile einander gegenübergestellt.

Open-Source-Software wurde als eine realistische Möglichkeit der Softwarebeschaffung angedacht und die Rahmenbedingungen diskutiert, unter denen eine solche Variante Sinn machen kann. Zwei weitere Themen, die im Zusammenhang mit der Softwarebeschaffung relevant sind – Wartungsverträge und Lizenzmanagement – wurden detailliert betrachtet.

Besonders die Beschaffung von mobilen Systemen ist mit einer Reihe an Erfordernissen verbunden, die beachtet werden müssen und in den Kompetenz- und Entscheidungsbereich der IT-Beschaffung fallen. Das Outsourcing von IT-Services wird von einem standardisierten Vorgehen begleitet, das von der Auswahl des Outsourcing-Partners hin zu einer Vertragsgestaltung und einem effizienten Controlling der outgesourcten Leistung führt.

Das Thema Cloud-Computing stellt einen immer wichtiger werdenden Bereich im Zusammenhang mit betrieblichen Informationsverarbeitung dar. Die grundlegenden Cloud-Computing-Varianten, Liefer- und Servicemodelle sowie die damit verbundenen Vor- und Nachteile wurden diskutiert.