Cloud Computing Security - Gesamt

Grundlagen und Architektur des Cloud Computing

Vor allem die Public Cloud wird zunehmend zu einem wesentlichen Bestandteil jedes modernen Unternehmens. Dies erfordert den Erwerb spezifischer Kenntnisse und betrieblicher Expertise, um Cloud-Infrastrukturen zu betreiben. Allerdings verfügt nicht jedes Unternehmen über das notwendige Wissen, insbesondere solche, die ohne ausreichende Expertise und Bewusstsein für Vorschriften und Sicherheitsbedenken in die Cloud migrieren. Laut Gartner werden bis 2025 mehr als die Hälfte der IT-Ausgaben von Unternehmen für Cloud-Infrastrukturen und -Dienste verwendet, die von großen Cloud-Service-Providern (CSP) bereitgestellt werden [1].

Der Hauptgrund für diesen Anstieg in den letzten Jahren liegt in der Tatsache, dass Cloud-Übergänge neue digitale Geschäftsmöglichkeiten bieten. Fast jedes Geschäftsmodell, das auf Künstlicher Intelligenz, maschinellem Lernen, Mikroservices und anderen modernen Technologien basiert, ist ein Beispiel dafür. Infolgedessen sind Unternehmen häufig gezwungen, die Public Cloud zu nutzen, um wettbewerbsfähig zu bleiben und ihren Marktanteil zu sichern. Dies zwingt die IT-Abteilungen dieser Unternehmen, Arbeitslasten, Dienste und Daten von traditionellen Rechenzentren oder Büros in die Public Cloud zu verlagern.

Das Problem bei diesem schnellen Übergang in die Cloud besteht darin, dass diese IT-Abteilungen, die an traditionelle Anforderungen und Bereitstellungen vor Ort gewöhnt sind, oft nicht gut darin geschult sind, die Cloud-Funktionen richtig zu nutzen. Neben der Verlagerung der Infrastruktur in die Cloud besteht eine weitere große Herausforderung darin, sie so abzusichern, dass Vorschriften eingehalten werden und Unternehmen vor Cyberangriffen geschützt sind.

Cloud Computing Konzepte

Geschichtlicher Background zu Cloud Computing

Die IT-Branche hat zahlreiche bedeutende Veränderungen durchlaufen auf ihrem Weg zum Cloud Computing. Es ist wichtig, zunächst die Geschichte des Cloud Computings zu verstehen, um zu begreifen, wo wir heute stehen. Dies wird verdeutlichen, wie die heutige Cloud entstanden ist und wie sich die cloudfähigen Technologien im Laufe der Zeit verändert haben. Wir sind durch eine Reihe von Cloud-Konzepten an diesen Punkt gelangt. Eines davon ist das Prinzip des Time-Sharing, das bis in die 1950er Jahre zurückreicht, als moderne Computer erfunden wurden. In den 1950er Jahren war das Time-Sharing besonders wichtig, weil Computer riesig, komplex und teuer waren. Es war nicht kosteneffektiv, einen Computer nur für ein Programm zu nutzen. Dank Time-Sharing-Schemata konnten mehrere Programme auf diesen leistungsstarken Computern laufen. Während das ursprüngliche Konzept manuell war und die Operatoren von einem Programm zum anderen wechselten, ist dies heute eines der Kernkonzepte jeder Arbeitslast in modernen Cloud-Infrastrukturen. Der Unterschied besteht nur darin, dass es heute hoch automatisiert ist und es ermöglicht, vorhandene Ressourcen effizient zwischen verschiedenen Rechenressourcen zu teilen. Ein weiteres Kernkonzept moderner Clouds ist die Fähigkeit, mit mehreren Netzwerken verbunden zu sein. Interconnected Networks (z.B. das Internet) entstanden Ende der 1960er und Anfang der 1970er Jahre und ermöglichten eine einfachere Methode zur weltweiten Informationsverteilung. Dies wurde zu einer Schlüsseltechnologie für alles in der IT-Branche. Insbesondere öffentliche Cloud-Ressourcen hängen stark von der Fähigkeit zur Interkonnektivität ab, da Ressourcen, die weit entfernt von den Unternehmen liegen, irgendwie erreichbar sein müssen. Die nächste große Innovation, die ein Kernkonzept jeder Cloud ist, ist die Virtualisierung. Virtualisierung existiert seit IBM in den 1970er Jahren ihr Virtual Machine (VM) Betriebssystem (OS) einführte, das es ermöglichte, dass mehrere virtuelle Systeme die zugrunde liegende physische Infrastruktur teilen. Virtuelle Maschinen wurden zu einem grundlegenden Bestandteil der IT. Ein Bare-Metal-Server war nun in der Lage, viele verschiedene Betriebssysteme zu hosten. Ein weiteres entscheidendes Element für das Cloud Computing, das zusätzlich zu Interkonnektivität und Rechenkapazität fehlt, ist Daten. Ohne Daten können weder Konnektivität noch Rechenleistung ihr volles Potenzial entfalten. Die Datenspeichertechnologien haben sich im Laufe der Jahre stetig weiterentwickelt, während andere Technologien voranschritten. Die Richtung ging dahin, den Speicher von der Arbeitslast zu entkoppeln und separat zu halten. Infolgedessen ist der Speicher zu einer der wichtigsten Komponenten und als Grundlage für Rechenleistung geworden. Technologien wie Datenbanken, RAIDs, Storage Area Networks (SAN) und Network Attached Storage (NAS) wurden entwickelt und sind noch heute in Gebrauch [2].

Cloud Computing Merkmale, Eigenschaften und Definition

Die Kombination dieser aus der Geschichte abgeleiteten Kernkonzepte führte zu verschiedenen Ansätzen im Cloud Computing und bot viele Lösungen für ein gegebenes Problem. Daher nahmen Unternehmen und Firmen unterschiedliche Strategien an. Sie bauten Rechenzentren, mieteten sie oder hatten alles in ihren Büros. Dies war lange bevor der Begriff "Cloud Computing" existierte. Das National Institute of Standards and Technology (NIST) definierte Cloud Computing wie folgt:

"Cloud computing is a model for enabling ubiquitous, convenient, on-demand network access to a shared pool of configurable computing resources (e.g., networks, servers, storage, applications, and services) that can be rapidly provisioned and released with minimal management effort or service provider interaction. This cloud model is composed of five essential characteristics, three service models, and four deployment models." [3]

Laut ihrer Definition gibt es beim Cloud Computing vier verschiedene Cloud-Bereitstellungstypen, drei verschiedene Cloud-Service-Modelle und fünf grundlegende Merkmale.

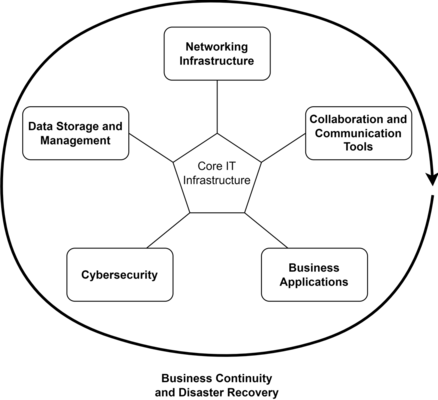

Der Kern des Cloud Computing wird durch die fünf wesentlichen Merkmale gebildet. Diese fünf Elemente umreißen die wesentlichen Merkmale einer Cloud. Im Kern bauen sie auf zwei Hauptkomponenten: physische Infrastruktur und eine Art Orchestrierungssystem. Die Infrastruktur einer Cloud-Umgebung besteht immer aus drei grundlegenden Komponenten: Speicher, Netzwerk und Rechenleistung. Diese drei Komponenten sind allein nicht ausreichend; die Nutzer müssen sie so konfigurieren können, dass sie ihren spezifischen Anforderungen entsprechen. Dies geschieht über Orchestrierungssoftware, die aus mehreren Teilen besteht, wobei eines davon immer eine Verwaltungsoberfläche für Kunden ist, die ihnen ermöglicht, ihre Cloud-Ressourcen zu steuern und zu überwachen.

Die fünf Kerneigenschaften sind folgende: [4]

On-demand Self-service

On-demand Self-Service bezieht sich auf einen Cloud-Dienst, der die Bereitstellung von Cloud-Ressourcen ermöglicht – wann und wo sie benötigt werden. Dies ist ein Verfahren, bei dem der Cloud-Kunde Cloud-Dienste ohne die Hilfe des Cloud-Anbieters bereitstellen, verwalten oder betreiben kann. Klassische Beispiele für diesen Self-Service sind die Webinterfaces bzw. anderen Schnittstellen von Cloud Service Providern oder auch von eigens gehosteten Cloud Umgebungen:

- Lokale Openstack Managment Plattform

- Lokale VMWare Management Plattform

- Container Management Plattformen mit Webinterface

- AWS Management Console: https://aws.amazon.com/console/

- GCP Management Console: https://console.cloud.google.com/

- Österreichisches Beispiel Anexia Console: https://www.anexia-engine.com/

Broad Network Access

Cloud-Ressourcen (Anwendungen, Rechenleistung, Verwaltungsoberflächen usw.) sollten über eine Netzwerkverbindung weitgehend zugänglich sein. Server, Personal Computer, Smartphones und nahezu jedes andere Gerät mit Internetzugang sollten in der Lage sein, sich mit den gegebenen Diensten zu verbinden. Die technische Grundlage dazu stellt das OSI-Referenzmodell. Mit diesem Standard ist es möglich, dass eigentlich viele unterschiedliche Endgeräte und Server miteinander kommunizieren können. (Nähere Erklärung)

Im Public Cloud Bereich bzw. bei größeren CSPs werden hier oft die Begriffe „Regions“ (Regionen) und „Availability Zones“ (Verfügbarkeitszonen) verwendet. In diesem Zusammenhang bedeutet es folgendes: Jede Cloud Region ist isoliert von einer anderen und kann z.B. EU-WEST heißen. In dieser Region gibt es dann noch mehrere Verfügbarkeitszonen. Diese Zonen sind geografisch voneinander getrennt, aber noch immer in derselben Region. In einer availability Zone sind dann meistens mehr als ein physisches Datacenter vorhanden. (Aufbau bei AWS: https://docs.aws.amazon.com/AWSEC2/latest/UserGuide/using-regions-availability-zones.html#concepts-regions)

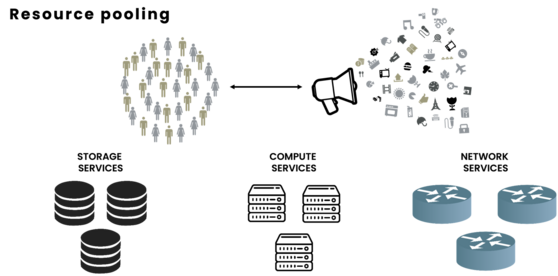

Resource Pooling

Alle Cloud-Kunden teilen sich die Ressourcen des Cloud-Service-Providers (CSP), zu denen mehrere Server, Netzwerkkomponenten und Speichergeräte gehören. Dies ermöglicht eine angemessene und gleichmäßige Verteilung der Ressourcenauslastung.

Diese Grafik sollte es veranschaulichen, dass Cloud Provider primär Storage, Compute und Networking Services bereitstellen und auf diese geteilten Ressourcen eben Menschenmassen und Unternehmen zugreifen um so Applikationen und Services zu konsumieren.

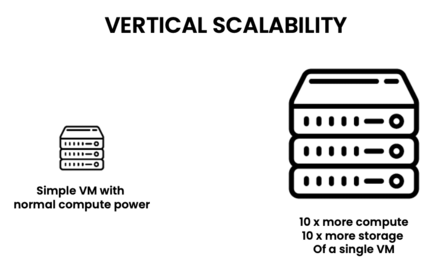

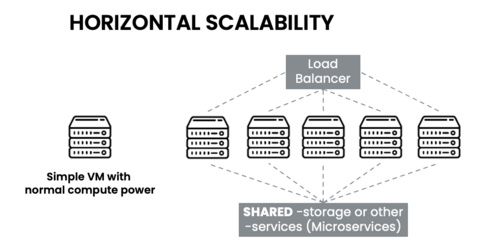

Rapid Elasticity

Die Infrastruktur der Kunden kann in einer Cloud-Umgebung elastisch bereitgestellt und freigegeben werden. Dieser Skalierungsprozess kann sogar vollständig automatisiert werden, sodass die Infrastruktur nur mit ihrem absoluten Minimum an Ressourcen arbeitet. Vertikale und horizontale Skalierbarkeit kann somit einfach in einer Cloud-Umgebung implementiert werden.

Vertikale Skalierbarkeit:

In einer Cloud Computing Plattform sollte es auf einfache Art und Weise möglich sein eine einfache VM mit mehr Compute/Storage/Networking Ressourcen auszustatten.

Horizontale Skalierbarkeit:

In einer Cloud Computing Plattform sollte es auch möglich sein dieselbe VM zu klonen und mehrfach zu betreiben. Wichtig hierfür ist, dass im Hintergrund auf geteilte Daten bzw. Applikationen zugegriffen wird und die Auslastung mittels Load Balancer auf die einzelnen Instanzen aufgeteilt wird.

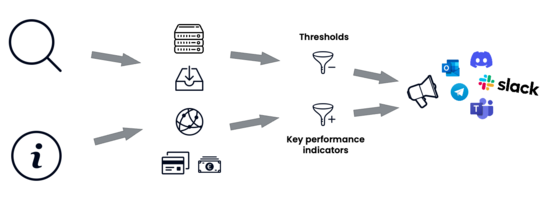

Measured Service

Cloud-Systeme optimieren und kontrollieren ihre Ressourcennutzung, um den Anforderungen der Anwendung und des Kunden gerecht zu werden. Darüber hinaus wird jede Cloud-Ressource ständig überwacht und ein automatisches Alarmsystem implementiert. Dies bietet den Kunden Transparenz und die Möglichkeit, Daten über Ressourcenauslastung, Kostenentwicklung, Netzwerkverkehr usw. für jeden Dienst zu generieren.

Eine Cloud-Plattform sollte es, da es sich um eine Software handelt, ermöglichen, auf jegliche Daten und Metriken der Auslastung/Benutzung zuzugreifen. Zum Beispiel: Traffic, verursachte Kosten, etc. Anhand dieser Daten sollte es dann auch noch die Möglichkeit geben, für sich selbst gewisse KPIs (Key Performance Indicators) bzw. Limits zu definieren und, wenn diese erreicht oder überschritten werden, ein entsprechendes Alarmsystem über ein Benachrichtigungssystem zu implementieren.

Cloud Referenzarchitektur

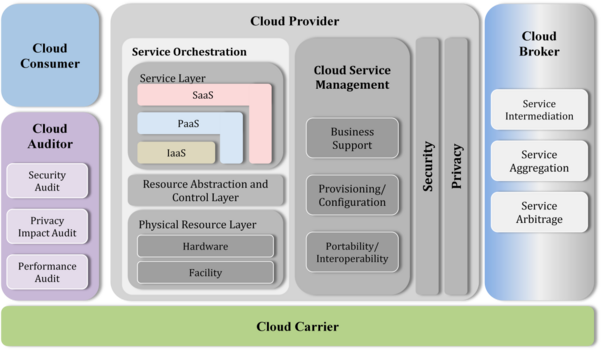

NIST Cloud Computing Reference Architecture

Die NIST Cloud Computing Reference Architecture bietet eine standardisierte Perspektive auf die verschiedenen Komponenten und Akteure in einem Cloud-Computing-Umfeld. Die Architektur identifiziert und beschreibt die Hauptrollen, Verantwortlichkeiten und Interaktionen der verschiedenen Akteure innerhalb des Cloud Computing-Ökosystems.

Hier sind die Rollen des NIST-Referenzmodells:

Cloud Consumer (Cloud-Kunde/Cloud Service Consumer - CSC):

Individuen oder Organisationen, die Cloud-Dienste nutzen.

Cloud Provider (Cloud-Anbieter/Cloud Service Provider - CSP):

Unternehmen, die Cloud-Dienste anbieten und verwalten.

Verantwortlich für die Bereitstellung von Infrastruktur, Plattformen und Software als Dienstleistung (IaaS, PaaS, SaaS).

Cloud Broker (Cloud-Broker):

Vermittler, die Cloud-Dienste von verschiedenen Anbietern zusammenfassen und an die Kunden weiterverkaufen.

Optimieren die Nutzung von Cloud-Diensten für den Kunden.

Cloud Auditor (Cloud-Auditor):

Unabhängige Stellen, die die Dienste und Sicherheit der Cloud-Anbieter überprüfen.

Stellen sicher, dass die Cloud-Dienste den gesetzlichen und geschäftlichen Anforderungen entsprechen.

Cloud Carrier (Cloud-Carrier):

Anbieter von Netzwerk- und Transportdiensten, die die Verbindung zwischen Cloud-Anbietern und Cloud-Kunden ermöglichen.

Diese Rollen beschreiben Abhängigkeiten und Akteure beim Einsatz von Cloud Computing Technologien. Demnach sind dies auch direkt die Abhängigkeiten entlang einer auf Cloud Computing basierten Wertschöpfungskette und müssen dementsprechend adressiert bzw. gepflegt werden.

In der NIST Definition sind dann des Weiteren noch die zwei Hauptkomponenten ausgeführt. Zum einen die Service Models (Dienstleistungsmodelle) und die Deployment Models (Bereitstellungsmodelle) die das Cloud Computing auszeichnen.

Cloud Computing Service Models

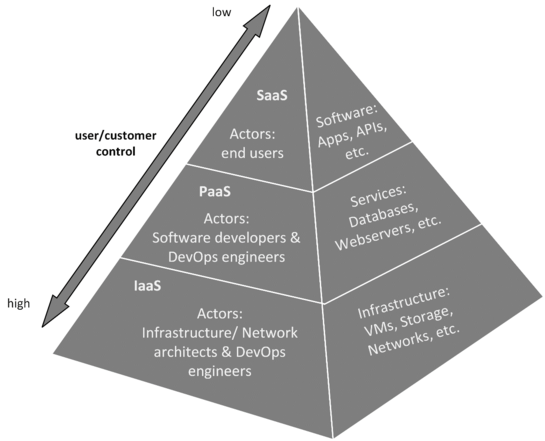

Cloud Service Models sind ein wesentlicher Bestandteil des Cloud-Computings, ebenso wie die fünf grundlegenden Merkmale. Laut der NIST-Definition von Cloud-Computing gibt es drei Cloud Service Models. Typischerweise werden diese Modelle als "* as a Service" bezeichnet, wobei das "*" für die Art der Bereitstellungsmethode steht [6], [7].

Folgende Dienstleistungsmodelle wurden offiziell definiert:

Software-as-a-Service (SaaS)

Das SaaS-Dienstmodell wird im Allgemeinen verwendet, um Software für Endbenutzer bereitzustellen. Diese können in zwei Zielgruppen unterteilt werden: entweder Business-to-Business-Software oder Business-to-Consumer-Software. SaaS-Anwendungen werden typischerweise über Web-, Desktop- oder mobile Anwendungen angeboten und sind weit verbreitet verfügbar. SaaS-Lösungen können auch nur als Application Programming Interfaces (APIs) angeboten werden, die von Kunden genutzt werden können, um ihre Dienste und Anwendungen zu erweitern. In einem SaaS-Umfeld wird alles vom Dienstanbieter verwaltet, die einzige Verantwortung des Kunden besteht in der Verwaltung von Authentifizierungsinformationen und benutzergenerierten Daten (z. B. Metadaten oder Anwendungsdaten). Die meisten modernen SaaS-Lösungen sind auch in der Lage, externe Identitätsanbieter wie Google, Microsoft, Meta usw. zu integrieren, um den Kunden integrierte Anmeldeoptionen zu bieten, die auch als Single Sign-On (SSO) bezeichnet werden. Dies ist ein Sicherheitsvorteil für SaaS-Anbieter, da sie keine Benutzerdaten speichern müssen. Typische SaaS-Lösungen sind Microsoft 365, Netflix, Spotify usw., die weltweit entweder von Unternehmen oder normalen Kunden genutzt werden. Im Allgemeinen bieten viele Softwareunternehmen ihre Dienste als SaaS-Lösungen für ihre Kunden an.

Platform-as-a-Service (PaaS)

Eine PaaS-Lösung ist eine Umgebung, in der Kunden in der Lage sind, einen bestimmten „Dienst“ wie einen On-Demand-Webserver oder eine vollständig verwaltete Datenbank bereitzustellen, ohne das zugrunde liegende Betriebssystem betreiben und unterstützen zu müssen. Daher sind die Anbieter, die PaaS-Lösungen anbieten, für das zugrunde liegende System verantwortlich, und die Benutzer konsumieren nur einen Dienst, den sie nach Belieben anpassen können. Dieses Konzept ist besonders beliebt für Systeme, die viele Patches und Wartung erfordern. Das am weitesten verbreitete Geschäftsmodell besteht darin, dass Anbieter eine Art von Managed Service anbieten, der sich auf Support und Service Level Agreements (SLAs) bezieht. Ein Beispiel ist eine Database-as-a-Service, bei der die Datenbank die Plattform ist, die vom Kunden konfiguriert und genutzt werden kann, während der Dienstanbieter alles rund um die Betriebszeit, das Patchen, das Clustering, die Sicherheit usw. verwaltet.

Infrastructure-as-a-Service (IaaS)

Eine IaaS-Umgebung ist ein Dienstmodell, das viele Arten von IT-Infrastrukturen anbietet. Daher liegt auch die größte Verantwortung beim Kunden. IaaS kann mit einer klassischen Virtualisierungsumgebung verglichen werden, in der Kunden in der Lage sind, VMs auf einem Hypervisor bereitzustellen und mit ihrem gewünschten Betriebssystem ihre Infrastruktur aufzubauen. Insbesondere in einer öffentlichen Cloud-Umgebung können Benutzer viele verschiedene Arten von Infrastrukturen bereitstellen, nicht nur die traditionelle VM. Grundsätzlich kann alles, was in einem traditionellen Rechenzentrum vorhanden ist, virtuell bereitgestellt werden: Virtuelle Netzwerke, Virtual Private Network (VPN)-Gateways, Netzwerksicherheitsgruppen und viele weitere Infrastrukturelemente können bereitgestellt werden. Dies bedeutet auch, dass typische Netzwerk-Infrastrukturen wie Router, Switches, Loadbalancer und Firewalls bereitgestellt werden können. Diese ganze Flexibilität bringt jedoch auch viel Aufwand mit sich. Jedes Infrastrukturelement muss betrieben, gewartet, gesichert und bei Bedarf gepatcht werden. Dies kann zu einer erheblichen Arbeitsbelastung führen, und In-Place-Upgrades werden für Cloud-Infrastrukturen oft nicht unterstützt, da die Infrastruktur auf einer Art Basis-Image beruht, das nicht leicht geändert werden kann. Anstatt die Infrastruktur inline zu aktualisieren, besteht auch die Möglichkeit, das Basis-Image der Infrastruktur zu ändern. Dies ist nur möglich, wenn die Infrastrukturkonfiguration nicht manuell erfolgt, sondern an einem anderen Ort gespeichert wird. Beispielsweise wird anstatt einer Aktualisierung einer VM eine neue VM mit dem neuesten Basis-Image und anderen anwendbaren Änderungen bereitgestellt und die alte später entfernt. Dieser Ansatz mag zunächst wie eine Verschwendung von Ressourcen erscheinen, doch mit einem aktuellen Werkzeug namens Infrastructure as Code (IaC), bei dem es sich um einen Bauplan der gesamten Infrastrukturkonfiguration handelt, kann der Upgrade-Prozess einer VM in weniger als einer Minute abgeschlossen werden.

IaaS ist die Grundlage für diese drei Diensttypen, die aufeinander aufbauen. Das bedeutet, dass ein PaaS-Dienstmodell auf einem IaaS-Modell aufgebaut werden kann und ein SaaS entweder auf einem IaaS- oder einem PaaS-Modell aufgebaut werden kann.

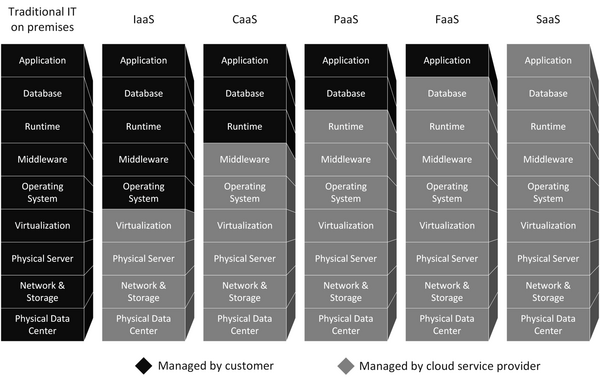

Diese Abbildung zeigt, wie die verschiedenen Cloud Service Models aufeinander aufbauen. Drei Aspekte jedes Dienstmodells werden dargestellt: die Akteure, die Komponenten, die ein Kunde nutzen kann, und das Maß an Kontrolle, das der Kunde hat. Das IaaS-Dienstmodell wird von Akteuren wie Netzwerkarchitekten und DevOps-Ingenieuren verwaltet. Sie sind verantwortlich für die bereitgestellte Infrastruktur wie VPN-Gateways, Netzwerke, Speichersysteme und virtuelle Maschinen. Auf der IaaS-Ebene pflegen Softwareentwickler und auch DevOps-Ingenieure normalerweise die PaaS-Schicht. Die Akteure dieser Schicht sind also dafür verantwortlich, die Datenbanken, Webserver und Webanwendungen zu betreiben und zu patchen, die auf den Servern laufen. Ein PaaS-Kunde nutzt folglich nur einen Dienst (z. B. eine von den Akteuren gepflegte Datenbank). SaaS ist in der Regel das Softwareprodukt oder der Dienst, der auf einer PaaS-Schicht läuft. Das bedeutet beispielsweise eine API oder Webanwendung, die über einen von den PaaS-Akteuren verwalteten Webserver zugänglich ist.

Es kann gesagt werden, dass es kein Softwareangebot (SaaS) ohne eine zugrunde liegende Plattform (PaaS) geben kann, auf der die Software läuft. Darüber hinaus kann eine Plattform nur auf Infrastruktur (IaaS-Komponenten) betrieben werden, die in einer öffentlichen Cloud bereitgestellt werden kann. CSPs (Cloud-Service-Provider) bieten in der Regel zwei der drei wichtigsten Dienstmodelle standardmäßig an. Diese sind IaaS (VMs usw.) und PaaS (verwaltete Dienste wie Datenbanken usw.). SaaS-Lösungen werden typischerweise nicht von CSPs bereitgestellt, sondern eher von Drittanbietern, die auf einen CSP hinter ihrem Dienst angewiesen sind.

Erweiterte Service Modelle

Laut der NIST-Definition von 2011 sind dies die wichtigsten Dienstmodelle. Heute ist diese Definition nicht mehr vollständig zutreffend, da aus diesen drei Modellen viele weitere *aaS-Dienstmodelle entstanden sind. Beispiele hierfür wären Artificial Intelligence-as-a-Service (AIaaS – zum Beispiel ChatGPT von OpenAI), Desktop-as-a-Service (DaaS – zum Beispiel eine Azure Virtual Desktop-Umgebung), Monitoring-as-a-Service (MaaS – zum Beispiel Software von Elastic NV) und viele mehr. All diese Dienstmodelle basieren in gewisser Weise auf den drei grundlegenden Dienstmodellen – die Basismodelle werden nur um einige Erweiterungen ergänzt und neue *aaS-Modelle werden veröffentlicht [4].

Neben den zahlreichen neuen Dienstmodellen stechen zwei hervor, da sie von Cloud-Ingenieuren umfassend genutzt werden: [8]

- Container-as-a-Service (CaaS) Das CaaS-Dienstmodell ermöglicht es den Kunden, Container bereitzustellen, die auf containerd oder einer anderen Container-Laufzeit in der öffentlichen Cloud ausgeführt werden. Dieses Dienstmodell wird häufig mit einem Container-Orchestrierungssystem wie Kubernetes oder Openshift und einer Container-Registry kombiniert, die oft von einem CSP bereitgestellt wird. Eine Container-Orchestrierung ermöglicht die Automatisierung der Bereitstellung und Verwaltung von Containern, während eine Container-Registry die Images speichert, die als Container bereitgestellt werden.

- Function-as-a-Service (FaaS) Das FaaS-Dienstmodell ist ebenfalls ein wesentlicher Bestandteil des Angebots jedes CSPs. Es ermöglicht den Kunden, Quellcode – sogenannte Funktionen – in der Cloud auszuführen. Das bedeutet, dass Kunden Code ausführen können, der beispielsweise eine E-Mail sendet, ohne ein Betriebssystem betreiben zu müssen, das den Code ausführt. Der Kunde zahlt also nur für die Rechenleistung, die zur Ausführung der Funktion benötigt wird.

Zusätzlich zu den drei wichtigsten Dienstmodellen sind diese beiden ebenfalls wesentlich und werden häufig von Unternehmen genutzt.

Cloud Computing Deployment Models

Cloud Computing Deployment Models definieren, wie Cloud-Infrastrukturen aufgebaut und genutzt werden. Diese Modelle bestimmen, wer Zugriff auf die Cloud-Ressourcen hat, wie diese verwaltet werden, und welche Vor- und Nachteile mit ihrer Nutzung verbunden sind. Es gibt mehrere etablierte Deployment-Modelle, die jeweils für unterschiedliche Anwendungsfälle geeignet sind. NIST in ihrem Standard spricht von 4 Bereitstellungsmodellen.

Diese Deployment-Modelle bieten Unternehmen unterschiedliche Möglichkeiten, Cloud-Technologien zu nutzen, je nach ihren spezifischen Anforderungen und Zielen. Jede Option bringt ihre eigenen Vor- und Nachteile mit sich, und die Wahl des richtigen Modells hängt von den individuellen Bedürfnissen des Unternehmens ab.

Im Folgenden werden die wichtigsten Deployment-Modelle vorgestellt: Private Cloud, Public Cloud, Hybrid Cloud, Community Cloud und Multi Cloud (Nicht im NIST Cloud Computing Standard enthalten, da sich diese Art erst über die Jahre „gebildet“ hat).

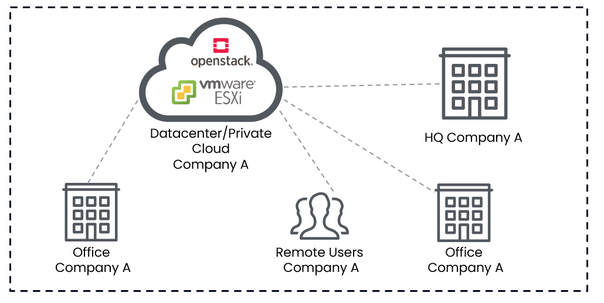

Private Cloud

Eine Private Cloud ist eine Cloud-Computing-Umgebung, die ausschließlich von einem einzigen Unternehmen genutzt wird. Die Ressourcen der Private Cloud werden entweder intern von der IT-Abteilung des Unternehmens oder durch einen externen Dienstleister betrieben, wobei die Infrastruktur vollständig auf die Bedürfnisse des Unternehmens zugeschnitten ist. Eine Private Cloud bietet ein hohes Maß an Sicherheit und Kontrolle, da das Unternehmen direkten Zugriff auf die Hardware und Software hat, die für die Bereitstellung der Cloud-Dienste verwendet werden.

Vorteile:

- Hohe Sicherheit und Kontrolle: Da die Infrastruktur isoliert ist, bietet die Private Cloud eine höhere Datensicherheit und ermöglicht die Einhaltung spezifischer Compliance-Anforderungen.

- Anpassbarkeit: Die Infrastruktur kann speziell an die Anforderungen des Unternehmens angepasst werden, was eine flexible und maßgeschneiderte Lösung ermöglicht.

Nachteile:

- Hohe Kosten: Die Implementierung und Wartung einer Private Cloud erfordert erhebliche Investitionen in Hardware, Software und Fachpersonal.

- Wartungsaufwand: Das Unternehmen ist für die gesamte Verwaltung und Wartung der Infrastruktur verantwortlich, was zusätzlichen Aufwand bedeutet.

Beispiel

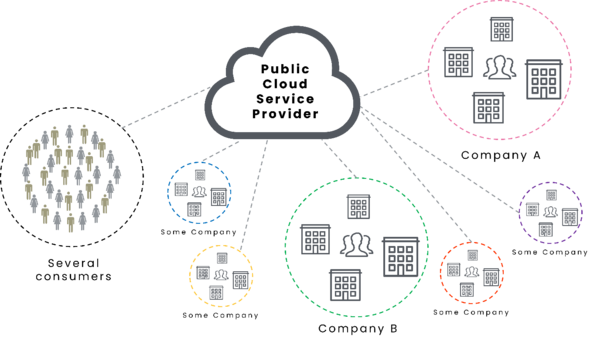

Public Cloud

Eine Public Cloud ist ein Cloud-Computing-Modell, bei dem Cloud-Dienste über das Internet von einem Cloud-Service-Provider (CSP) bereitgestellt werden. Diese Dienste stehen der Öffentlichkeit zur Verfügung, und die Ressourcen werden gemeinsam von mehreren Nutzern verwendet. Die Public Cloud ist in der Regel kostengünstiger, da die Kosten für Hardware und Wartung auf mehrere Nutzer verteilt werden.

Vorteile:

- Kosteneffizienz: Die Nutzung der Public Cloud ist meist günstiger, da keine eigenen Investitionen in Hardware erforderlich sind und die Kosten für Wartung und Betrieb vom CSP übernommen werden.

- Skalierbarkeit: Ressourcen können je nach Bedarf schnell und einfach skaliert werden, um den Anforderungen des Unternehmens gerecht zu werden.

Nachteile:

- Sicherheitsbedenken: Da die Ressourcen gemeinsam genutzt werden, können Sicherheitsrisiken höher sein, insbesondere wenn sensible Daten in der Cloud gespeichert werden.

- Abhängigkeit vom Anbieter: Unternehmen sind stark auf den CSP angewiesen, was zu einem Vendor-Lock-in führen kann.

Beispiel

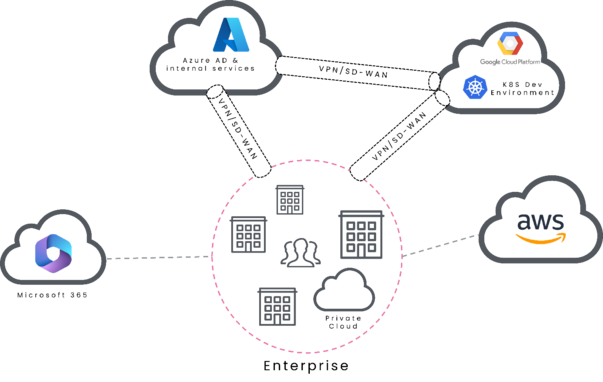

Hybrid Cloud

Die Hybrid Cloud kombiniert Elemente der Private und Public Cloud, indem sie Daten und Anwendungen über beide Umgebungen hinweg integriert. Unternehmen können sensible Daten in der Private Cloud speichern, während weniger kritische Anwendungen in der Public Cloud gehostet werden. Diese Kombination bietet eine Balance zwischen Sicherheit, Flexibilität und Kosteneffizienz.

Vorteile:

- Flexibilität: Unternehmen können Workloads zwischen Public und Private Clouds verlagern, je nach Sicherheitsanforderungen und Kostenüberlegungen.

- Optimierte Ressourcen-Nutzung: Kritische Anwendungen können in einer sicheren Private Cloud laufen, während Public Clouds für weniger kritische Aufgaben genutzt werden.

Nachteile:

- Komplexität: Die Verwaltung einer Hybrid Cloud erfordert eine umfassende Strategie, um die Interoperabilität zwischen den verschiedenen Umgebungen zu gewährleisten.

- Kosten: Die Implementierung einer Hybrid Cloud kann teurer sein als die ausschließliche Nutzung einer Public oder Private Cloud.

Beispiel

Community Cloud

Eine Community Cloud ist eine spezielle Art von Cloud-Infrastruktur, die von mehreren Organisationen gemeinsam genutzt wird, die ähnliche Anforderungen haben, beispielsweise hinsichtlich Sicherheit, Compliance oder spezifischen Geschäftsanforderungen. Die Infrastruktur kann intern verwaltet oder von einem Drittanbieter betrieben werden, wobei die Kosten und Ressourcen zwischen den beteiligten Organisationen aufgeteilt werden.

Vorteile:

- Geteilte Kosten: Die beteiligten Organisationen teilen sich die Kosten für die Infrastruktur, was die Kosten für jeden Einzelnen reduziert.

- Gemeinsame Compliance: Die Cloud kann speziell an die gemeinsamen Compliance- und Sicherheitsanforderungen der beteiligten Organisationen angepasst werden.

Nachteile:

- Beschränkte Anpassungsmöglichkeiten: Da die Cloud von mehreren Organisationen genutzt wird, sind die Anpassungsmöglichkeiten eingeschränkt.

- Komplexe Verwaltung: Die Verwaltung der Cloud erfordert eine enge Zusammenarbeit zwischen den beteiligten Organisationen, was zu administrativen Herausforderungen führen kann.

Beispiel

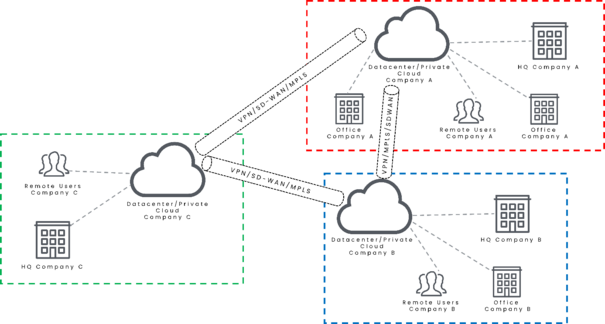

Multi Cloud

Das Multi-Cloud-Modell bezieht sich auf die Nutzung mehrerer Cloud-Dienste von verschiedenen Anbietern. Unternehmen nutzen mehrere Cloud-Plattformen, um von den jeweiligen Stärken und Funktionen der verschiedenen Anbieter zu profitieren und Abhängigkeiten von einem einzelnen CSP zu vermeiden.

Vorteile:

- Vermeidung von Vendor-Lock-in: Durch die Nutzung mehrerer Anbieter vermeiden Unternehmen die Abhängigkeit von einem einzigen CSP.

- Optimale Nutzung: Unternehmen können die besten Dienste verschiedener Anbieter kombinieren, um ihre spezifischen Anforderungen optimal zu erfüllen.

Nachteile:

- Komplexität: Die Verwaltung einer Multi-Cloud-Umgebung kann komplex und anspruchsvoll sein, insbesondere hinsichtlich der Integration und Datensicherheit.

- Kosten: Obwohl eine Multi-Cloud-Strategie Flexibilität bietet, können die Gesamtkosten durch die Nutzung mehrerer Anbieter steigen.

Beispiel

Das Shared Responsibility Model ist ein essenzielles Konzept im Cloud Computing, das die Aufteilung der Verantwortlichkeiten zwischen Cloud Service Providern (CSPs) und Cloud Service Kunden (CSCs) beschreibt. Dieses Modell dient als Grundlage dafür, wie Infrastruktur- und Sicherheitsaufgaben in einer Cloud-Umgebung gemeinsam verwaltet werden, und verdeutlicht, welche Aufgaben vom CSP übernommen werden und welche in der Verantwortung des Kunden liegen. Es fungiert als eine Art Verantwortungsmatrix, die je nach gewähltem Cloud-Anbieter, den genutzten Produkten, den Service-Modellen und den Bereitstellungsmodellen variiert.

Das Shared Responsibility Model bildet das Fundament dafür, wie ein CSP agiert und seine Dienste bereitstellt, unabhängig davon, ob es sich um eine private, öffentliche, hybride oder Multi-Cloud-Umgebung handelt. Je nach verwendetem Cloud-Service-Modell – sei es Infrastructure as a Service (IaaS), Platform as a Service (PaaS) oder Software as a Service (SaaS) – müssen sich die Kunden darüber im Klaren sein, welche Verantwortlichkeiten in den Händen des CSP liegen und welche Aufgaben sie selbst übernehmen müssen. So bestimmt das Modell nicht nur die Effizienz und Sicherheit der Cloud-Nutzung, sondern auch die Art und Weise, wie Unternehmen ihre internen IT-Ressourcen und -Prozesse organisieren und verwalten.

Das Shared Responsibility Model variiert je nach gewähltem CSP. Im Allgemeinen umfassen sie drei Service-Modelle sowie einen Vergleich mit einem standardmäßigen Rechenzentrum. Dies wird erreicht, indem jede Komponente, die zur Bereitstellung einer Anwendung oder eines Dienstes erforderlich ist (z. B. ein physischer Server), untersucht und anschließend die Pflichten des CSP und des CSC basierend auf dem jeweiligen Service-Modell aufgezeigt werden.

Eine erweiterete Version des Shared Responsibility Models (inkl. CaaS und FaaS) sieht wie folgt aus:

Das Shared Responsibility Model besteht aus neun Schichten, von denen jede einen anderen Aspekt repräsentiert, der benötigt wird, um einen Dienst für Endbenutzer in der Cloud bereitzustellen. Diese Schichten bauen aufeinander auf und würden ohne die darunterliegenden Schichten nicht funktionieren. Daher hat jedes Servicemodell unterschiedliche Anforderungen an den CSP. Dieses Modell verdeutlicht auch, dass die Bereitstellung einer IaaS-Lösung für Endverbraucher auf vielen zugrunde liegenden Komponenten und Fachwissen beruht, die benötigt werden, um die ersten vier Schichten bereitzustellen. Die Schichten und ihre Funktionen von unten nach oben sind die folgenden:

Physisches Rechenzentrum

Das physische Rechenzentrum ist der Standort Ihrer Rechen-, Speicher- und Netzwerkkomponenten. Beim Bau eines Rechenzentrums müssen viele Aspekte berücksichtigt werden (z. B. physisches Design, Umweltgestaltung usw.), die alle in der ISO/IEC 22237 aufgeführt sind. Dieser Standard berücksichtigt alle Rechenzentren, auch solche, die vollständig privat sind. Betrachtet man das physische Rechenzentrum eines öffentlichen Cloud-Service-Providers, ist es unmöglich, nur ein einziges Rechenzentrum zu betrachten. Öffentliche Cloud-Anbieter verfügen über Rechenzentren auf der ganzen Welt in sogenannten Regionen, die in Verfügbarkeitszonen unterteilt sind. Eine Region könnte beispielsweise als „Europa-Nord (Irland/Dublin)“ definiert sein. Diese Regionen bestehen in der Regel aus mindestens zwei Verfügbarkeitszonen. Eine Verfügbarkeitszone selbst ist ein realer physischer Rechenzentrumsstandort. Daher ist ein CSP mit fünf Regionen, die jeweils drei Verfügbarkeitszonen haben, für insgesamt 15 physische Rechenzentren verantwortlich und für deren Verfügbarkeit und Funktionsfähigkeit zuständig.

Netzwerk und Speicher

Netzwerk- und Speicherkomponenten sind zwei der drei Kernkomponenten des Cloud-Computing (Netzwerk, Speicher und Rechenleistung). Betrachtet man die Netzwerkkonfiguration eines Rechenzentrums, so müssen der Betrieb von Datacenter-Switches, Loadbalancern, Firewalls und Core-Routern für mehrere öffentliche Internetverbindungen berücksichtigt werden. Diese Netzwerkkomponenten müssen jederzeit in einer hochverfügbaren und fehlertoleranten Umgebung betrieben werden.

Ein Rechenzentrum enthält oft viele Speicherkomponenten, die für verschiedene Zwecke verwendet werden. Diese Speicherkomponenten werden in drei Typen unterteilt:

- Direct Attached Storage (DAS) Dieser Speichertyp wird nicht für große Datenmengen verwendet. Er wird üblicherweise nur für das Betriebssystem der physischen Server und anderer Geräte wie Firewalls und Loadbalancer verwendet. Dieses direkt angeschlossene Speichersystem ist in der Regel als RAID 1 für Server konfiguriert, die als Typ-1-Hypervisor, Firewalls und Loadbalancer fungieren. Eine gespiegelte Festplatte ist in diesem Szenario sinnvoll, da diese Betriebssysteme nicht viel Speicher benötigen und fehlertolerant sein müssen.

- Network Attached Storage (NAS) Ein netzwerkgebundenes Speichersystem ist in einem Rechenzentrum häufiger anzutreffen. Es fasst viel Speicherplatz auf mehreren Speicherknoten zusammen, die über mehrere Netzwerkprotokolle zugänglich sind. NAS-Systeme und deren Speicher nutzen auch RAID-Mechanismen, um ein fehlertolerantes System bereitzustellen. Um auf ein NAS zuzugreifen, muss es auf einem Netzwerk-Laufwerk oder einem Netzwerk-Standort des Betriebssystems eingebunden werden. NAS-Systeme haben jedoch Einschränkungen, da sie auf dem zugrunde liegenden Netzwerk basieren und das Netzwerk möglicherweise nicht in der Lage ist, große Datenmengen zu übertragen.

- Storage Area Network (SAN) Ein Storage Area Network ist ein separates Netzwerk, das von normalen TCP/IP-Netzwerken getrennt ist. Es verwendet spezielle Hardware (Switches und Speicherknoten), die für hohe Datenraten im Netzwerk optimiert sind. Es fasst im Wesentlichen viele Speicherknoten in einem separaten Netzwerk zusammen und stellt den Speicher über eine Schnittstelle für andere Dienste bereit. Aus der Sicht eines Servers, der Speicher von einem SAN nutzt, sieht es so aus, als hätte der Server Zugriff auf eine physische Festplatte, die tatsächlich vom SAN bereitgestellt wird.

Diese Netzwerk- und Speicherkomponenten müssen vom Rechenzentrumsbetreiber ordnungsgemäß gewartet und gesichert werden, damit die Komponenten im Katastrophenfall wiederhergestellt werden können.

Physischer Server

Physische Server liegen über den Netzwerk- und Speicherkomponenten und bilden den Rechenteil eines Rechenzentrums. Diese Server sind normalerweise für den 24/7-Betrieb ausgelegt und in verschiedenen Formfaktoren erhältlich. Der gängigste Formfaktor ist der Rackmount-Server. Diese verfügen über spezielle Mainboards, die den Einbau mehrerer CPUs und RAM-Sticks ermöglichen.

Virtualisierung

Virtualisierung ist eine wichtige Funktion in Rechenzentren. Sie ermöglicht eine bessere Auslastung der physischen Server, sodass diese nicht nur mit einer CPU-Auslastung von 10 % und nahezu ungenutztem RAM betrieben werden. Um Virtualisierung zu ermöglichen, wird ein Hypervisor benötigt. In Unternehmensumgebungen wird in der Regel ein Typ-1-Hypervisor verwendet. Ein Typ-1-Hypervisor ist eine Softwareebene, die auf einem physischen Server und dessen zugrunde liegender Hardware bereitgestellt wird. Es wird auch als Bare-Metal-Hypervisor bezeichnet, da keine zusätzliche Software zwischen der Hardware und dem Hypervisor ausgeführt wird. Der Hypervisor ermöglicht es den VMs, Netzwerken und anderen virtualisierten Komponenten, die darauf ausgeführt werden, mit der zugrunde liegenden Hardware zu kommunizieren. Er ist auch dafür verantwortlich, den virtualisierten Komponenten die Möglichkeit zu bieten, mit den Speicher- und Netzwerkkomponenten des Rechenzentrums zu kommunizieren.

Betriebssystem

Die gängigsten Betriebssysteme in einem Rechenzentrum sind Linux-basierte Systeme und Windows-Systeme. Ein virtualisiertes Betriebssystem wird auch als Gastbetriebssystem bezeichnet. Linux wird für die meisten Server verwendet, die in der Regel Webserver, Datenbanken oder andere Anwendungen hosten. Windows-Server werden für Unternehmensanwendungen wie Active Directory oder Exchange-Dienste verwendet. Administratoren neigen auch dazu, einen Hypervisor auf einem normalen Linux-Server zu installieren, um noch mehr aus einer einzelnen VM herauszuholen. Dies wird als geschachtelte Virtualisierung bezeichnet und ermöglicht eine weitere Segmentierung auf einem einzelnen Gastbetriebssystem.

Middleware

Die Middleware wird nicht für jede Anwendung benötigt, aber für einige ist sie unerlässlich. Es ist eine Orchestration-Schicht, die zwischen den Anwendungen und dem zugrunde liegenden Betriebssystem liegt. Ein häufiger Anwendungsfall ist beispielsweise eine PaaS-Hochverfügbarkeits-Datenbanklösung, die dem CSC einen einzelnen Datenbankendpunkt zur Verfügung stellt, während im Hintergrund viele Instanzen ausgeführt werden. Die Koordination der Interaktionen zwischen verschiedenen Datenbankinstanzen liegt in der Verantwortung der Middleware. Bei der Verwendung von Containern wird ebenfalls eine Middleware genutzt. Dies gilt sowohl für die direkte Bereitstellung einzelner Container in der Cloud (über den Container-Service eines CSP) als auch für die Bereitstellung mehrerer Container über ein Orchestration-Tool wie Kubernetes (die meisten CSPs bieten ihren Kunden einen verwalteten Kubernetes-Service an).

Runtime

Die Runtime ist in der Regel ein Softwarepaket (Anwendung + Bibliotheken + Umgebung), das im Hintergrund läuft, um die zugrunde liegenden Funktionen für die Anwendungen der Endbenutzer bereitzustellen. Typische Software, die als Runtime-Umgebung betrachtet werden kann, ist ein Webserver. Ein Webserver muss jedoch immer auf dem neuesten Stand sein und über die richtigen Funktionen für die Anwendung des Endbenutzers verfügen. Beispiele hierfür wären ein NGINX- oder ein Apache-Webserver, die in der Lage sind, TLS-Terminierung durchzuführen, um einen sicheren Datenaustausch zwischen Clients und Servern zu ermöglichen. Das Einrichten der Runtime auf eine ordnungsgemäße und skalierbare Weise erfordert viel Fachwissen, das Entwickler, die nur eine Webanwendung erstellen, in der Regel auslagern – entweder an den CSP oder an ein IT-Betriebsteam. CSPs bieten Runtime-Lösungen als PaaS-Angebote an und haben eine breite Palette von Managed Services, einschließlich Webservern und Datenbanken.

Datenbank

Daten werden in der Regel in verschiedenen Arten von Datenbanken gespeichert, entweder in SQL- oder NoSQL-Datenbanken. Der Kontext für die Geschäftslogik der Anwendungen, die in einer Cloud-Umgebung ausgeführt werden, wird durch die in den Datenbanken gespeicherten Daten bereitgestellt. Daten werden jedoch nicht immer in strukturierter Form wie in Datenbanken gespeichert. Einige Anwendungen müssen andere Arten von Daten speichern oder darauf zugreifen. CSPs bieten Objektspeicher an, die Daten in unstrukturierter Form als Objekte speichern. Daten aus Objektspeichern können über eine API abgerufen und ähnlich wie ein Objekt aus einer objektorientierten Programmiersprache behandelt werden. Eine Kombination aus vielen verschiedenen Datenquellen in einer Cloud (Datenbanken und Objektspeicher) wird als Data Lake bezeichnet. Ein Data Lake hat die Eigenschaft, verschiedene Datenquellen zu konsolidieren. Dies bildet die Grundlage für Anwendungen im Bereich des maschinellen Lernens und der Geschäftsanalyse.

Anwendung

Das Programm, auf das Endbenutzer zugreifen können, wird als Anwendung bezeichnet. Gängige Anwendungen umfassen Webanwendungen, Streaming-Endpunkte, API-Endpunkte und mehr. Um auf einen Cloud-Dienst zuzugreifen, benötigt der Endbenutzer lediglich eine Anwendung für sein Endgerät (Smartphone, Notebook usw.) oder einen Internetbrowser. Anwendungen sind auf alle zugrunde liegenden Komponenten des Shared Responsibility Models angewiesen.

Allgemeines zum Shared Responsibility Model

Wie in der Grafik von Vacca hervorgehoben, verschieben sich die Verantwortlichkeiten des CSC je nach gewähltem Servicemodell. Daher sollte das Servicemodell immer in Übereinstimmung mit dem Fachwissen und den Fähigkeiten des CSC ausgewählt werden. Es macht wenig Sinn, ein IaaS-Modell zu wählen, wenn kein Wissen über den Betrieb, die Unterstützung, das Patchen, das Monitoring und die Sicherung des gewählten Betriebssystems sowie der darüber liegenden Middleware, Laufzeit, Datenbank und Anwendung vorhanden ist.

Sicherheitsfragen bei der Nutzung von Cloud Diensten

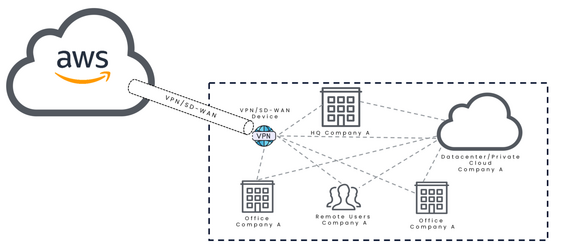

Bei den Sicherheitsfragen im Zusammenhang mit dem Einsatz von Cloud-Diensten stehen in erster Linie die Sicherheitsbedenken bei der Nutzung von Public-Cloud-Anbietern im Vordergrund. Dies liegt hauptsächlich daran, dass eine private Cloud in vielerlei Hinsicht gut mit einem traditionellen Rechenzentrum und dessen Sicherheitsmaßnahmen vergleichbar ist. Ähnliches gilt auch für Hybrid- und Community-Clouds, bei denen aus sicherheitstechnischer Sicht vor allem die sichere Verbindung zwischen dem eigenen Rechenzentrum und einer anderen Cloud-Umgebung, sei es ein anderes Rechenzentrum oder eine Public Cloud, im Mittelpunkt steht. Hierbei spielen bewährte Methoden der Netzwerksicherheit eine entscheidende Rolle.

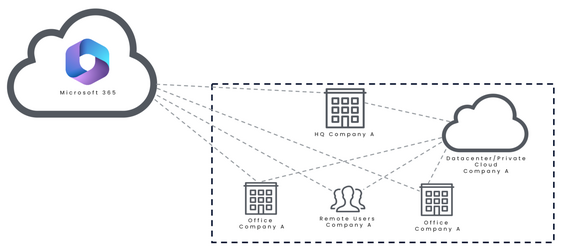

Der Fokus bei den Sicherheitsfragen liegt daher insbesondere auf dem Einsatz von Public-Cloud-Infrastrukturen sowie der Nutzung von Cloud-Diensten, die als Software-as-a-Service (SaaS) im Unternehmen implementiert werden, wie zum Beispiel Microsoft 365. Diese Dienste stellen besondere Herausforderungen an die Sicherheit, da sie von externen Anbietern betrieben werden und somit andere Kontroll- und Sicherheitsmechanismen erfordern als interne IT-Ressourcen.

Grundlegende Funktionsunterschiede bei Cloud Computing

Der wesentliche Unterschied zwischen On-Premises- und Cloud-Umgebungen liegt in der Art und Weise, wie Daten verarbeitet, der Datenverkehr gesteuert sowie Berechtigungen und Zugriffsrechte für Dienste und Benutzer gehandhabt werden. Diese Unterschiede sind insbesondere aus sicherheitstechnischer Sicht von großer Bedeutung.

Datenverarbeitung in der Cloud

Daten in der Cloud werden nicht auf herkömmlichen Festplatten oder Solid-State-Drives gespeichert. Für den Cloud Service Consumer (CSC) erscheint es zwar so, als wären Objektspeicher oder Datenbanken in einem Konto vorhanden, tatsächlich jedoch werden die realen Daten über hunderte bis tausende unterschiedliche Speichersysteme verteilt. Diese unterschiedlichen Systeme schaffen einen großen Speicherpool, aus dem der CSC virtuelle Festplatten beziehen kann. Dieses ungewöhnliche Verfahren der Datenspeicherung bietet einen bedeutenden Vorteil, der Cloud-Nutzern oft nicht bewusst ist. Zum Beispiel, wenn Daten in einem verschlüsselten Objektspeicher abgelegt werden, werden sie zunächst mit einem speziellen Schlüssel verschlüsselt und anschließend kryptografisch in Stücke gespalten. Diese Stücke werden dann über viele verschiedene Speichersysteme verteilt. Ein weiterer Unterschied zur herkömmlichen Datenverarbeitung besteht im Prozess des Datenzugriffs [6].

Um auf verschlüsselte Daten in der Cloud zuzugreifen, werden aus Sicht des Nutzers folgende Schritte überprüft und ausgeführt:

- Hat der Nutzer die Berechtigung, auf den Objektspeicher zuzugreifen?

- Hat der Objektspeicher Zugriff auf den Schlüssel zur Datenentschlüsselung?

- Der Objektspeicher sammelt alle verteilten Datenstücke.

- Nachdem alle Datenstücke zusammengetragen wurden, erfolgt die Entschlüsselung.

- Die angeforderten Daten oder die verfügbare Dateistruktur werden an den Benutzer gesendet, der die Anfrage initiiert hat.

Ein wichtiger Hinweis hierbei ist, dass jeder Datenzugriff auf einen Cloud-Dienst immer über eine API abgewickelt wird. Dies unterscheidet sich von On-Premises-Umgebungen, wo Dateidienste normalerweise über bestimmte TCP-Ports erreichbar sind (z.B. SMB, FTP, etc..

Datenverkehrsströme in der Cloud

Ein wesentlicher sicherheitstechnischer Unterschied zu einer On-Premises-Umgebung besteht darin, dass es in der Cloud keinen klar definierten Perimeter (die Unterscheidung zwischen öffentlichen und privaten Netzwerken) gibt. Alle Cloud-Dienste können sowohl privat als auch öffentlich sein. Zusätzlich verhält sich der Datenverkehr in der Cloud anders. In der Cloud existiert keine L2-Segmentierung, da diese Schicht abstrahiert wird. Es ist möglich, dass zwei virtuelle Maschinen (VMs) in unterschiedlichen Netzwerken direkt miteinander kommunizieren, ohne einen Standard-Gateway zu durchlaufen. Daher ist es in einer Cloud-Umgebung nicht nur schwierig, eine L2-, sondern auch eine L3-Segmentierung zu verwalten. Es hängt letztendlich davon ab, wie das Routing konfiguriert ist und welche Datenverkehrsströme entstehen. Anstatt verschiedene Netzwerksegmente wie in einem Rechenzentrum zu schützen, kommt es nun darauf an, die Datenverkehrsströme (insbesondere das dahinterliegende Routing) der Anwendungen zu verstehen und zu sichern. In Cloud-Begriffen gibt es im Allgemeinen drei Haupttypen von Datenverkehrsströmen, die adressiert werden müssen [10]:

- Northbound Traffic: Datenverkehr, der aus dem Internet stammt und versucht, auf eine öffentliche Anwendung eines Unternehmens zuzugreifen.

- Southbound Traffic: Datenverkehr, der aus dem internen Netzwerk eines Unternehmens auf eine Cloud-Umgebung zugreift (z. B. ein Benutzer aus einem Büro oder Home-Office).

- East-West Traffic: Datenverkehr, der innerhalb einer Cloud-Umgebung zwischen den Anwendungen und Diensten stattfindet. Diese Datenströme umfassen alle Kommunikationen, die innerhalb der Cloud-Umgebung eines Unternehmens stattfinden.

Alle diese drei Datenverkehrsströme sollten auf eine Weise geschützt werden, die den Sicherheitsanforderungen des Unternehmens entspricht. Beispielsweise sollte es nicht möglich sein, dass ein Dienst, der über Northbound Traffic erreichbar ist, die Berechtigung hat, auf interne Ressourcen des Unternehmens zuzugreifen (unabhängig davon, ob diese sich in der Cloud oder an einem anderen Ort befinden).

Berechtigungshandling für Dienste und Benutzer

Ein weiterer wesentlicher Unterschied in der Cloud besteht darin, wie der Zugriff zwischen Ressourcen gehandhabt wird. Für das Berechtigungsmanagement verlassen sich Cloud Service Provider (CSPs) stark auf ein Identity and Access Management (IAM\glsadd{iam}) System. Diese IAM-Lösungen verwalten alle Berechtigungen jeder Cloud-Ressource. Dies bedeutet, dass ein IAM als zentraler Regulator für alle Berechtigungen von Benutzern und Diensten fungiert. Es reguliert, welche Dienste miteinander kommunizieren können, welche spezifischen Diensttypen auf eine Datenbank oder einen Schlüssel für kryptografische Operationen zugreifen können und welche Benutzer die Berechtigung haben, auf Dienste zuzugreifen, sie zu ändern oder zu löschen. Dadurch ist es möglich, Berechtigungen auf granularer Ebene zu verwalten, und Unternehmen können eine Zero-Trust-Architektur sowie die Prinzipien des geringsten Zugriffsrechts umsetzen [11].

Allgemeine und rechtliche Aspekte bei der Nutzung von Cloud-Diensten

Unabhängig davon, ob ein Unternehmen eine Public, Private oder Hybrid Cloud nutzt, bleiben die allgemeinen und rechtlichen Aspekte bei der Nutzung von Cloud-Diensten weitgehend dieselben. Diese Aspekte betreffen alle Formen der Cloud-Nutzung und sind entscheidend, um die Sicherheit, den Datenschutz und die Einhaltung rechtlicher Vorgaben zu gewährleisten. Dabei müssen Unternehmen sicherstellen, dass die gewählten Cloud-Lösungen nicht nur technologisch, sondern auch rechtlich den Anforderungen entsprechen. Dies gilt gleichermaßen für die Speicherung und Verarbeitung sensibler Daten wie für die Verantwortung und Haftung im Falle von Sicherheitsvorfällen.

Datenschutzrechtliche Anforderungen

GDPR-Konformität:

Die Datenschutz-Grundverordnung (General Data Protection Regulation, GDPR) ist eine der wichtigsten rechtlichen Rahmenbedingungen für den Schutz personenbezogener Daten in der Europäischen Union. Sie legt strenge Regeln für die Erhebung, Verarbeitung, Speicherung und Weitergabe personenbezogener Daten fest. Für Unternehmen, die Cloud-Dienste nutzen, ist die Einhaltung der GDPR von zentraler Bedeutung, um hohe Bußgelder und rechtliche Konsequenzen zu vermeiden. Dies umfasst insbesondere die Verpflichtung, nur Daten zu verarbeiten, für die eine klare rechtliche Grundlage besteht, wie z. B. die Einwilligung der betroffenen Person, und sicherzustellen, dass die Daten nur für den vorgesehenen Zweck verwendet werden.

Ein wichtiger Aspekt der GDPR-Konformität bei der Cloud-Nutzung ist die Notwendigkeit, sicherzustellen, dass Cloud-Anbieter ausreichende technische und organisatorische Maßnahmen ergreifen, um die Sicherheit der verarbeiteten Daten zu gewährleisten. Dazu gehören Maßnahmen zur Verschlüsselung von Daten, die Implementierung von Zugriffssteuerungen und die Fähigkeit, die Integrität und Vertraulichkeit von Daten zu wahren. Unternehmen müssen sicherstellen, dass ihre Cloud-Anbieter GDPR-konform sind und entsprechende Datenverarbeitungsverträge (Data Processing Agreements, DPA) abschließen, um ihre rechtlichen Verpflichtungen zu erfüllen.

Datenlokalisierung und -souveränität:

Ein weiteres zentrales Thema im Rahmen der Datenschutzanforderungen ist die Datenlokalisierung und -souveränität. Datenlokalisierung bezieht sich auf die Pflicht, Daten innerhalb einer bestimmten geografischen Region zu speichern und zu verarbeiten. Dies kann durch gesetzliche Anforderungen oder durch unternehmensinterne Richtlinien vorgegeben sein, um sicherzustellen, dass Daten den lokalen Datenschutzgesetzen unterliegen und vor ausländischem Zugriff geschützt sind.

Für Unternehmen in der EU bedeutet dies, dass personenbezogene Daten bevorzugt innerhalb des Europäischen Wirtschaftsraums (EWR) gespeichert werden sollten, um sicherzustellen, dass sie den strengen europäischen Datenschutzstandards entsprechen. Werden Daten in Drittländer übertragen, müssen zusätzliche Schutzmaßnahmen, wie z. B. Standardvertragsklauseln oder Binding Corporate Rules (BCRs), implementiert werden, um den Schutz der Daten zu gewährleisten. Die Wahl eines Cloud-Anbieters, der mehrere Rechenzentren in verschiedenen geografischen Regionen anbietet, kann Unternehmen dabei helfen, den Anforderungen an die Datenlokalisierung gerecht zu werden und die Datenhoheit zu wahren.

Rechtliche Verantwortung und Haftung

Vertragsgestaltung:

Die rechtliche Verantwortung und Haftung bei der Nutzung von Cloud-Diensten hängen maßgeblich von den vertraglichen Vereinbarungen zwischen dem Cloud-Anbieter und dem Kunden ab. Eine sorgfältige Vertragsgestaltung ist entscheidend, um klar festzulegen, welche Partei für welche Aspekte der Sicherheit und des Datenschutzes verantwortlich ist. Dies ist insbesondere im Kontext des Shared Responsibility Models von Bedeutung, da sowohl der Cloud-Anbieter als auch der Kunde spezifische Pflichten übernehmen müssen.

Verträge sollten detaillierte Klauseln enthalten, die die Verantwortlichkeiten im Falle eines Sicherheitsvorfalls regeln, einschließlich der Pflicht zur Meldung von Datenschutzverletzungen und der Haftung für entstandene Schäden. Zudem sollten Service Level Agreements (SLAs) definiert werden, die die Leistungserwartungen, Verfügbarkeit und Reaktionszeiten des Cloud-Anbieters festlegen. Ein weiterer wichtiger Punkt ist die Regelung der Datenrückgabe und -löschung nach Vertragsende, um sicherzustellen, dass personenbezogene Daten ordnungsgemäß gelöscht und nicht unbefugt weiterverwendet werden.

Regulatorische Anforderungen:

Neben den allgemeinen datenschutzrechtlichen Vorgaben gibt es auch branchenspezifische regulatorische Anforderungen, die bei der Nutzung von Cloud-Diensten berücksichtigt werden müssen. Diese können je nach Branche und Art der verarbeiteten Daten stark variieren. Beispielsweise müssen Unternehmen im Finanzsektor besondere Vorschriften zur Datensicherheit und -integrität beachten, wie sie in Richtlinien wie der Payment Card Industry Data Security Standard (PCI DSS) oder den aufsichtsrechtlichen Anforderungen der Europäischen Bankenaufsichtsbehörde (EBA) festgelegt sind.

Auch der Gesundheitssektor unterliegt strengen regulatorischen Anforderungen, wie z. B. der Health Insurance Portability and Accountability Act (HIPAA) in den USA oder die EU-Verordnung über elektronische Gesundheitsdienste. Diese Vorschriften schreiben vor, wie sensible Gesundheitsdaten geschützt und verarbeitet werden müssen. Unternehmen, die Cloud-Dienste nutzen, müssen sicherstellen, dass ihre Cloud-Umgebung diese speziellen Compliance-Anforderungen erfüllt und entsprechende Zertifizierungen des Cloud-Anbieters vorhanden sind.

Vor allem in der Europäischen Union ändern sich aktuell die Cybersicherheitsanforderungen für Unternehmen enorm. Je nach Branche und Unternehmensgröße bzw. Unternehmensorientierung müssen gewisse Cybersicherheitsmaßnahmen umgesetzt werden. Das gilt natürlich auch für das Bereitstellen und Hosten von Infrastruktur und Services in einer Cloud Plattform.

Die Einhaltung dieser regulatorischen Vorgaben ist nicht nur eine rechtliche Notwendigkeit, sondern auch ein wesentlicher Bestandteil des Risikomanagements und der Vertrauensbildung gegenüber Kunden und Geschäftspartnern.

Wartbarkeit von Systemen

Die Wartbarkeit von Systemen ist ein zentraler Aspekt beim Betrieb von Cloud-Diensten und bezieht sich auf die Fähigkeit, Systeme effizient zu pflegen, zu aktualisieren und zu überwachen, um ihre kontinuierliche Verfügbarkeit und Leistungsfähigkeit sicherzustellen. In der dynamischen und komplexen Umgebung von Cloud-Architekturen ist die Wartbarkeit ein wesentlicher Faktor, der die Betriebsbereitschaft und Sicherheit von Anwendungen und Daten beeinflusst.

Regelmäßige Updates und Patch-Management

Ein wichtiger Aspekt der Wartbarkeit ist das regelmäßige Einspielen von Software-Updates und Sicherheitspatches. Cloud-Umgebungen sind ständig wechselnden Bedrohungen ausgesetzt, und Sicherheitslücken in Softwarekomponenten können schnell zu einem Risiko werden, wenn sie nicht zeitnah behoben werden. Unternehmen müssen sicherstellen, dass ihre Cloud-Umgebung durch automatisierte Update- und Patch-Management-Prozesse auf dem neuesten Stand gehalten wird, um potenzielle Angriffsvektoren zu minimieren.

Automatisierte Überwachung und Protokollierung

Eine effektive Überwachung ist entscheidend für die Wartbarkeit von Cloud-Systemen. Durch den Einsatz automatisierter Überwachungslösungen können Unternehmen kontinuierlich die Leistung und den Zustand ihrer Cloud-Infrastruktur überwachen. Dabei sollten auch umfangreiche Protokollierungsmechanismen eingerichtet werden, um im Falle von Störungen oder Sicherheitsvorfällen schnell reagieren zu können. Die Protokolle sollten regelmäßig überprüft und analysiert werden, um ungewöhnliche Aktivitäten oder potenzielle Probleme frühzeitig zu erkennen.

Skalierbarkeit und Ressourcenmanagement

Die Fähigkeit, Ressourcen in einer Cloud-Umgebung flexibel zu skalieren, ist ein weiterer wichtiger Aspekt der Wartbarkeit. Unternehmen müssen sicherstellen, dass ihre Cloud-Dienste auf wachsende Anforderungen reagieren können, ohne die Leistungsfähigkeit zu beeinträchtigen. Dies erfordert eine sorgfältige Planung und das Management von Ressourcen, um Über- oder Unterprovisionierung zu vermeiden und gleichzeitig die Kosten im Blick zu behalten. Ein effektives Ressourcenmanagement trägt auch dazu bei, die Effizienz und Nachhaltigkeit der Cloud-Nutzung zu verbessern.

Dokumentation und Wissensmanagement

Eine umfassende und aktuelle Dokumentation ist essenziell für die Wartbarkeit von Cloud-Systemen. Sie stellt sicher, dass alle relevanten Informationen über die Systemarchitektur, Konfigurationen, Prozesse und Verfahren leicht zugänglich sind. Dies ist besonders wichtig in Situationen, in denen schnelles Handeln erforderlich ist, etwa bei der Behebung von Störungen oder Sicherheitsvorfällen. Zudem erleichtert eine gute Dokumentation den Wissenstransfer innerhalb des Unternehmens und reduziert das Risiko von Wissensverlust, beispielsweise durch Personalwechsel.

Notfallplanung und Disaster Recovery

Ein weiterer wichtiger Aspekt der Wartbarkeit ist die Vorbereitung auf Notfälle und die Implementierung von Disaster-Recovery-Plänen. Unternehmen müssen sicherstellen, dass sie über robuste Strategien verfügen, um im Falle eines Ausfalls schnell wieder betriebsbereit zu sein. Dazu gehört die regelmäßige Überprüfung und Aktualisierung von Wiederherstellungsplänen sowie die Durchführung von Tests, um die Effektivität der Maßnahmen zu gewährleisten. Cloud-Anbieter bieten oft integrierte Tools und Dienste an, die Unternehmen dabei unterstützen, ihre Disaster-Recovery-Strategien zu implementieren und zu optimieren.

Compliance und Audits

Die Einhaltung von gesetzlichen und regulatorischen Anforderungen ist ein weiterer Aspekt, der die Wartbarkeit von Systemen beeinflusst. Unternehmen müssen sicherstellen, dass ihre Cloud-Infrastruktur den relevanten Compliance-Anforderungen entspricht und regelmäßig überprüft wird. Dies umfasst auch die Durchführung von internen und externen Audits, um Schwachstellen zu identifizieren und die Wirksamkeit der implementierten Sicherheits- und Wartungsmaßnahmen zu bewerten. Die Ergebnisse solcher Audits sollten genutzt werden, um kontinuierliche Verbesserungen in der Wartbarkeit der Systeme zu erzielen.

Das Shared Responsibility Model ist ein zentrales Konzept in der Cloud-Nutzung, dass die Aufteilung der Sicherheitsverantwortung zwischen dem Cloud-Anbieter (Cloud Service Provider, CSP) und dem Cloud-Kunden (Cloud Service Customer, CSC) regelt. Dieses Modell stellt sicher, dass beide Parteien klar verstehen, welche Sicherheitsmaßnahmen sie ergreifen müssen, um eine sichere Cloud-Umgebung zu gewährleisten. Ein umfassendes Verständnis des gewählten Service-Modells ist hierbei entscheidend, da die Verantwortlichkeiten stark variieren können.

Aufteilung der Sicherheitsverantwortung:

Im Rahmen des Shared Responsibility Models liegt die Verantwortung für die Sicherheit der zugrunde liegenden Cloud-Infrastruktur, einschließlich physischer Sicherheit, Netzwerkschutz und Virtualisierung, beim Cloud-Anbieter. Der Cloud-Kunde ist hingegen für alles verantwortlich, was er in die Cloud einbringt und wie er die Cloud-Dienste nutzt. Dies umfasst die Verwaltung und Sicherheit seiner Daten, die Implementierung von Sicherheitsprotokollen, die Konfiguration von Zugriffsrechten sowie die Überwachung und Wartung der Anwendungen und Betriebssysteme.

Abhängigkeit vom Service-Modell:

Die Verteilung der Sicherheitsverantwortlichkeiten variiert je nach dem gewählten Cloud-Service-Modell. Es ist essenziell, dass Unternehmen die spezifischen Sicherheitsanforderungen ihres genutzten Modells verstehen und entsprechend handeln.

Infrastructure as a Service (IaaS):

Beim IaaS-Modell bleibt die meiste Sicherheitsverantwortung beim Kunden. Während der Cloud-Anbieter die physische Infrastruktur, Virtualisierung, Netzwerke und Speicherressourcen sichert, ist der Kunde für die Sicherheit des Betriebssystems, der Anwendungen, der Daten sowie der Netzwerkkonfigurationen verantwortlich. Dies schließt regelmäßige Sicherheitsupdates, Patching, Firewall-Konfigurationen und den Schutz der Daten ein. Hier muss der Kunde auch sicherstellen, dass Betriebssysteme und Anwendungen stets auf dem neuesten Stand gehalten werden und dass Sicherheitslücken geschlossen werden.

Platform as a Service (PaaS):

Im PaaS-Modell übernimmt der Cloud-Anbieter zusätzlich die Verantwortung für das Betriebssystem, die Laufzeitumgebung und die Middleware. Der Kunde konzentriert sich auf die Sicherheit der Anwendungen, die er entwickelt und bereitstellt, sowie auf die Verwaltung der Daten. Hier spielen Sicherheitsmaßnahmen wie der Schutz vor unbefugtem Zugriff, Datenverschlüsselung und die Implementierung sicherer Entwicklungspraktiken eine zentrale Rolle. Auch das Testen von Anwendungen auf Schwachstellen und die Sicherstellung, dass sensible Daten geschützt sind, fällt in den Verantwortungsbereich des Kunden.

Software as a Service (SaaS):

Bei SaaS übernimmt der Cloud-Anbieter die meisten Sicherheitsverantwortungen, einschließlich der gesamten Infrastruktur, Anwendungen und Datenverwaltung. Der Kunde ist hauptsächlich für die Verwaltung von Benutzerzugriffen, die Konfiguration von Sicherheitseinstellungen innerhalb der Anwendung und die Sicherstellung der sicheren Nutzung verantwortlich. Hier sind die Implementierung von Multi-Faktor-Authentifizierung (MFA) und die Überwachung von Zugriffsmustern entscheidend, um unbefugten Zugriff zu verhindern.

Function as a Service (FaaS):

FaaS, auch bekannt als serverless computing, ist eine Erweiterung von PaaS, bei der der Kunde noch weniger Verantwortung trägt. Der CSP übernimmt hier die komplette Verwaltung und Sicherheit der Laufzeitumgebung und Infrastruktur. Der Kunde ist jedoch weiterhin für die Sicherheit des Codes, der in den Funktionen läuft, sowie für die Verwaltung der Zugriffsrechte und die Sicherstellung, dass sensible Daten geschützt sind, verantwortlich. Es ist auch wichtig, sicherzustellen, dass Funktionen sicher entwickelt und regelmäßig auf Schwachstellen überprüft werden.

Container as a Service (CaaS):

CaaS ermöglicht es Unternehmen, Container bereitzustellen, zu verwalten und zu orchestrieren. Der CSP sichert die zugrunde liegende Infrastruktur und die Container-Orchestrierung, während der Kunde für die Sicherheit der Container, der Anwendungen, die in diesen Containern laufen, und die Implementierung von Sicherheitsmaßnahmen wie Netzwerksegmentierung, Zugriffskontrolle und Container-Image-Scans verantwortlich ist. Es ist entscheidend, dass Container regelmäßig überprüft werden, um sicherzustellen, dass keine bekannten Sicherheitslücken vorhanden sind.

Evaluierung der notwendigen Sicherheitsmaßnahmen:

Ein wesentlicher Aspekt bei der Nutzung von Cloud-Diensten ist die Evaluierung und Implementierung von Sicherheitsmaßnahmen, die den jeweiligen Verantwortlichkeiten im Rahmen des gewählten Service-Modells entsprechen. Unternehmen müssen ihre Security-Strategie auf der Grundlage des Shared Responsibility Models anpassen und sicherstellen, dass alle Aspekte, für die sie verantwortlich sind, abgedeckt sind.

Sicherheitsbewertung je nach Service-Modell:

Um die richtigen Sicherheitsmaßnahmen zu identifizieren, sollten Unternehmen eine detaillierte Analyse der Service-Modelle durchführen, die sie nutzen. Diese Bewertung sollte sowohl die technischen als auch die organisatorischen Sicherheitsmaßnahmen umfassen. Bei IaaS müssen beispielsweise Maßnahmen zur Sicherung des gesamten Software-Stacks implementiert werden, während bei SaaS der Fokus auf der Verwaltung von Benutzerzugriffen und Daten liegt.

Best Practices:

Unabhängig vom Service-Modell sollten einige grundlegende Sicherheitspraktiken implementiert werden. Dazu gehören die Verschlüsselung von Daten sowohl bei der Übertragung als auch im Ruhezustand, die Implementierung von strengen Zugangskontrollen, die Nutzung von Multi-Faktor-Authentifizierung und regelmäßige Sicherheitsaudits. Zusätzlich sollten Unternehmen sicherstellen, dass sie über robuste Incident-Response-Pläne verfügen, um schnell auf Sicherheitsvorfälle reagieren zu können.

Zusammenfassend sollten Unternehmen ein tiefes Verständnis für das gewählte Cloud-Service-Modell entwickeln und ihre Sicherheitsmaßnahmen entsprechend den spezifischen Anforderungen und Verantwortlichkeiten anpassen. Nur so lässt sich eine effektive Sicherheitsstrategie entwickeln, die die Risiken bei der Nutzung von Cloud-Diensten minimiert.

Wichtigste Sicherheitsvorkehrung beim Verwenden von Cloud-Ressourcen

Eine der wichtigsten Sicherheitsvorkehrungen beim Einsatz von Cloud-Ressourcen, sei es in einer Public oder Private Cloud, ist der Schutz der Cloud Control Plane – also der Management-Plattform, über die die Cloud-Umgebung verwaltet wird. Der Zugriff auf diese zentrale Steuerungsebene muss besonders sorgfältig abgesichert werden, da hier sämtliche Berechtigungen und Zugriffsrechte verwaltet werden.

Absicherung des Root-Accounts und Berechtigungskonzept

In jeder Cloud-Umgebung ist der Root-Account oder ein Admin-Account das Herzstück der Sicherheitsarchitektur. Dieser Account besitzt umfassende Berechtigungen, die es ermöglichen, Cloud-Ressourcen zu erstellen, zu verändern oder zu löschen. In einer Public Cloud hat der Root-Account zudem Zugriff auf Zahlungsinformationen und kann somit auch finanzielle Entscheidungen beeinflussen, wie z. B. die Bereitstellung kostenintensiver Dienste. Daher ist es von entscheidender Bedeutung, diesen Account durch starke Authentifizierungsmethoden abzusichern, wie etwa Multi-Faktor-Authentifizierung (MFA).

Darüber hinaus sollte ein umfassendes Berechtigungskonzept (Permission Model) implementiert werden, das den Zugriff auf die Cloud-Ressourcen auf ein Minimum beschränkt. Das Prinzip der geringsten Privilegien (Least Privilege Principle) sollte konsequent angewendet werden, um sicherzustellen, dass Benutzer nur die Rechte erhalten, die sie für ihre Aufgaben benötigen. Durch die Einführung rollenbasierter Zugriffskontrollen (RBAC) können Unternehmen sicherstellen, dass verschiedene Benutzergruppen nur auf die für sie relevanten Teile der Cloud-Infrastruktur zugreifen können.

Überwachung und Auditing

Die Absicherung der Cloud Control Plane sollte durch kontinuierliche Überwachung und regelmäßige Audits ergänzt werden. Diese Maßnahmen helfen dabei, unbefugte Zugriffsversuche frühzeitig zu erkennen und mögliche Sicherheitslücken zu schließen. Logging und Monitoring der Aktivitäten auf der Management-Plattform sind unerlässlich, um ein hohes Sicherheitsniveau aufrechtzuerhalten und im Falle eines Sicherheitsvorfalls schnell reagieren zu können.

Schulungen und Sicherheitsbewusstsein

Zuletzt ist es wichtig, dass alle Mitarbeiter, die Zugriff auf die Cloud Control Plane haben, regelmäßig geschult werden. Sicherheitsbewusstsein und Kenntnisse über aktuelle Bedrohungen sind entscheidend, um menschliche Fehler zu minimieren, die oft das größte Risiko für die Sicherheit von Cloud-Ressourcen darstellen.

Private & Public Cloud Security

Der Unterschied zwischen der Sicherheit in privaten und öffentlichen Clouds kann im Wesentlichen auf die unterschiedlichen Rahmenbedingungen und Ansätze zurückgeführt werden. Während sich die Sicherheit in der Private Cloud stark an traditionellen Sicherheitskonzepten orientiert, die aus den Bereichen Rechenzentrums- und Netzwerksicherheit stammen, erfordert die Public Cloud einen anderen Ansatz. In der Public Cloud sind Ressourcen plötzlich bei einem fremden Unternehmen auf einer geteilten Plattform verfügbar. Aus Sicherheitsaspekten stehen hier Themen wie Vertrauen in den Cloud Service Provider (CSP), das Sicherheitsniveau des CSP, die klare Abgrenzung der Ressourcen in der Cloud (Schaffung eines „Perimeters“) und das Bewusstsein darüber, welche Cloud-Service-Modelle im Einsatz sind und wie diese bestmöglich abgesichert werden können, im Vordergrund.

Private Cloud Security

Um eine sichere Private Cloud zu betreiben, ist es entscheidend, sich über den hohen Aufwand bewusst zu sein, der mit dem Betrieb verbunden ist. Es erfordert die Bereitstellung, Konfiguration, Instandhaltung, den Betrieb und regelmäßige Aktualisierung der notwendigen Komponenten in einem Rechenzentrum. Das OSI-Referenzmodell kann hier als Leitfaden dienen, denn alle sieben Schichten dieses Modells müssen vom Betreiber der Private Cloud adressiert und konfiguriert werden. Dies umfasst nicht nur die Netzwerkinfrastruktur, sondern auch physische Aspekte wie die Stromversorgung und die physische Sicherheit des Rechenzentrums. Für den weiteren Verlauf nehmen wir an, dass die Private Cloud in einem sicheren, vorhandenen oder angemieteten Rechenzentrumsbereich aufgebaut wird. Der Betrieb des Rechenzentrums selbst wäre ansonsten ebenfalls Teil der Verantwortung.

Technische Grundlage

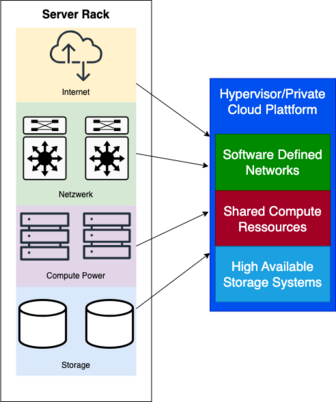

Diese Grafik veranschaulicht den grundlegenden Aufbau eines Rechenzentrums für eine Private Cloud-Infrastruktur. Im vereinfachten Modell bilden mehrere zentrale Komponenten das Fundament für den Betrieb einer Private Cloud:

- Internetzugang: Dieser ermöglicht die Anbindung des Rechenzentrums an externe Netzwerke, einschließlich der öffentlichen Cloud und des Internets.

- Netzwerkinfrastruktur: Hierzu gehören wesentliche Netzwerkkomponenten wie Switches, Firewalls und Router, die den Datenverkehr innerhalb des Rechenzentrums steuern und absichern.

- Rechenressourcen (Compute Power): Mehrere Server, auch als Compute Nodes bezeichnet, stellen die benötigte Rechenleistung zur Verfügung.

- Speicherlösungen: Hochverfügbare Speichersysteme gewährleisten die sichere und effiziente Speicherung und Verwaltung von Daten.

Auf dieser physischen Infrastruktur wird ein Hypervisor installiert, der als zentrale Verwaltungsschicht fungiert. Der Hypervisor bietet Zugriff auf die gesamten Rechenressourcen, das Speichersystem und die Netzwerkinfrastruktur. Dadurch ermöglicht er die Virtualisierung und Verwaltung der verschiedenen Komponenten, die für den Betrieb einer Private Cloud notwendig sind.

Storage

Die Grundlage jeder Cloud-Infrastruktur ist ein zuverlässiges und skalierbares Speichersystem. In einer Private Cloud muss der Speicher lokal verwaltet werden, was bedeutet, dass alle Sicherheitsmaßnahmen wie Datenverschlüsselung, Zugriffskontrollen und regelmäßige Backups intern organisiert werden müssen. Der Speicher muss nicht nur sicher, sondern auch performant sein, um die Anforderungen der Virtualisierung und der Workloads in der Cloud zu erfüllen.

Beispiele für Speichertechnologien in der Private Cloud sind Network Attached Storage (NAS) und Storage Area Networks (SAN). Diese Technologien ermöglichen es Unternehmen, große Mengen an Daten effizient zu speichern und gleichzeitig die Verfügbarkeit und Sicherheit dieser Daten zu gewährleisten. Eine typische Herausforderung bei der Verwaltung von Speicherressourcen in einer Private Cloud besteht darin, eine Balance zwischen Performance und Sicherheit zu finden. So müssen Unternehmen sicherstellen, dass sensible Daten verschlüsselt und vor unberechtigtem Zugriff geschützt sind, während sie gleichzeitig dafür sorgen, dass die Performance nicht durch übermäßige Sicherheitsmaßnahmen beeinträchtigt wird.

Ein weiteres Beispiel ist die Implementierung von dedizierten Backup-Systemen innerhalb der Private Cloud. Diese Systeme müssen so konzipiert sein, dass sie nicht nur regelmäßige Backups erstellen, sondern auch schnelle Wiederherstellungszeiten bieten, um im Falle eines Datenverlusts oder einer Sicherheitsverletzung den Betrieb schnell wieder aufnehmen zu können. Hierbei kann die Kombination von lokalen und cloud-basierten Backup-Lösungen (Hybrid Backup) dazu beitragen, die Datensicherheit zu erhöhen und das Risiko eines vollständigen Datenverlusts zu minimieren.

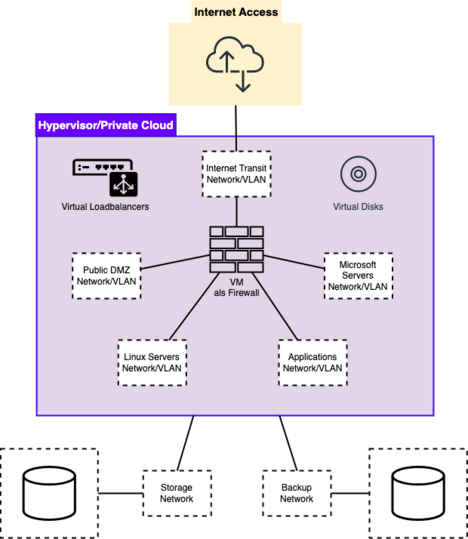

Software Defined Networking

Software Defined Networking ist ein essenzieller Bestandteil moderner Private Clouds. SDN ermöglicht eine flexible, zentrale Steuerung des Netzwerks, was eine dynamische Anpassung der Netzwerkkonfigurationen an sich ändernde Anforderungen erlaubt. Im Kontext der Sicherheit bedeutet dies, dass Netzwerksicherheitsrichtlinien zentral implementiert und durchgesetzt werden können. Dies ermöglicht eine schnellere Reaktion auf Bedrohungen und eine bessere Kontrolle über den Netzwerkverkehr.

In einer Private Cloud bietet SDN die Möglichkeit, Netzwerkressourcen unabhängig von der physischen Infrastruktur zu konfigurieren und zu verwalten. Dies ist besonders wichtig, wenn es darum geht, verschiedene Sicherheitszonen innerhalb des Netzwerks zu erstellen und zu verwalten. Beispielsweise können über SDN spezifische Sicherheitsrichtlinien für den Datenverkehr zwischen verschiedenen Abteilungen innerhalb eines Unternehmens festgelegt werden, sodass sensible Datenströme streng überwacht und geschützt werden können.

Ein praktisches Beispiel für den Einsatz von SDN in der Private Cloud ist die Implementierung von dynamischen Firewalls und Intrusion Prevention Systems (IPS), die in Echtzeit auf Sicherheitsvorfälle reagieren können. Durch die zentrale Verwaltung dieser Sicherheitslösungen über SDN kann das Netzwerk schnell an neue Bedrohungen angepasst werden, ohne dass umfangreiche manuelle Konfigurationsänderungen erforderlich sind. SDN ermöglicht es auch, schnell auf Änderungen im Netzwerkverkehr zu reagieren, wie z.B. bei einem plötzlichen Anstieg des Datenverkehrs, der auf einen DDoS-Angriff hinweisen könnte. In solchen Fällen kann das SDN die Netzwerkkapazität automatisch anpassen und den verdächtigen Datenverkehr isolieren, um die Auswirkungen auf die Gesamtinfrastruktur zu minimieren.

Hypervisor

Der Hypervisor ist die Schicht, die die Virtualisierung in der Private Cloud ermöglicht. Er sorgt dafür, dass mehrere virtuelle Maschinen (VMs) auf einem physischen Server sicher und effizient betrieben werden können. Die Sicherheit des Hypervisors ist von größter Bedeutung, da eine Kompromittierung dieser Schicht zu einem unkontrollierten Zugriff auf alle virtuellen Maschinen führen könnte. Daher müssen Hypervisoren regelmäßig gepatcht und nach bewährten Sicherheitspraktiken konfiguriert werden.

Es gibt zwei Haupttypen von Hypervisoren: Typ-1-Hypervisoren (Bare-Metal) und Typ-2-Hypervisoren (Hosted). Typ-1-Hypervisoren, wie VMware ESXi oder Microsoft Hyper-V, werden direkt auf der Hardware installiert und bieten dadurch eine höhere Performance und Sicherheit, da sie weniger Angriffsflächen bieten als Typ-2-Hypervisoren. Typ-2-Hypervisoren, wie VMware Workstation oder Oracle VirtualBox, laufen auf einem bestehenden Betriebssystem und sind daher in der Regel weniger sicher und performant.

Ein wesentlicher Sicherheitsaspekt bei der Verwendung von Hypervisoren in einer Private Cloud ist die Isolation der VMs. Durch die strikte Trennung der Ressourcen zwischen verschiedenen VMs kann verhindert werden, dass ein Angriff auf eine VM auf andere VMs oder die darunterliegende Hardware übergreift. Dies wird durch Funktionen wie Virtual Machine Introspection (VMI) erreicht, die es ermöglichen, das Verhalten von VMs in Echtzeit zu überwachen und verdächtige Aktivitäten zu erkennen.

Ein weiteres Beispiel für den Einsatz von Hypervisoren in der Private Cloud ist die Nutzung von Snapshots und Cloning-Funktionen. Diese ermöglichen es, Zustände von VMs zu einem bestimmten Zeitpunkt zu speichern und bei Bedarf wiederherzustellen. Dies ist besonders nützlich für die Durchführung von Updates oder Konfigurationsänderungen, da im Falle eines Fehlers die VM schnell in ihren vorherigen Zustand zurückversetzt werden kann. Solche Funktionen tragen zur erhöhten Betriebszeit und Sicherheit der Cloud-Umgebung bei.

Security Maßnahmen

Die Sicherheitsmaßnahmen in einer Private Cloud umfassen verschiedene Technologien und Strategien, um die Integrität, Verfügbarkeit und Vertraulichkeit der Ressourcen zu gewährleisten. Diese Maßnahmen müssen sorgfältig implementiert und kontinuierlich überwacht werden, um den spezifischen Sicherheitsanforderungen einer Private Cloud gerecht zu werden.

Macro Segmentation (Layer 3 Segementation)

Die Macro-Segmentierung, auch bekannt als Layer-3-Segmentierung, ist eine Technik zur Unterteilung des Netzwerks in größere, logisch getrennte Subnetze. Diese Segmente isolieren unterschiedliche Netzwerkzonen, wie zum Beispiel Entwicklungs-, Test- und Produktionsumgebungen, voneinander. Der Hauptvorteil der Macro-Segmentierung besteht darin, dass sie den Datenverkehr zwischen verschiedenen Netzwerkzonen kontrolliert und begrenzt. Dadurch wird das Risiko eines seitlichen (lateralen) Bewegens eines Angreifers innerhalb des Netzwerks erheblich verringert.

In einer Private Cloud ist dies besonders wichtig, da verschiedene Anwendungen und Workloads oft unterschiedliche Sicherheitsanforderungen haben. Durch die Aufteilung in separate Subnetze können Organisationen sicherstellen, dass sensible Daten und kritische Systeme von weniger geschützten oder potenziell gefährdeten Bereichen getrennt bleiben. Ein praktisches Beispiel wäre die Trennung von Finanzdatenbanken von allgemeinen Webanwendungen, um zu verhindern, dass ein Angreifer, der eine Webanwendung kompromittiert, auf die Finanzdaten zugreifen kann.

Macro-Segmentierung hilft auch bei der Einhaltung von Compliance-Anforderungen, indem sie klare Grenzen für den Datenfluss zwischen verschiedenen Systemen zieht. Zum Beispiel könnte ein Unternehmen, das Kreditkartendaten verarbeitet, ein separates Subnetz für diese Daten einrichten, um die Einhaltung von PCI-DSS-Standards sicherzustellen. In diesem Subnetz könnten dann strengere Sicherheitskontrollen und Zugriffsrichtlinien angewendet werden, um die sensiblen Daten besser zu schützen.

Micro Segmentation (Layer 2 Segementation)

Micro-Segmentierung geht einen Schritt weiter als die Macro-Segmentierung, indem sie Sicherheitsrichtlinien auf einer noch feiner abgestimmten Ebene durchsetzt – nämlich auf der Ebene der virtuellen Maschinen oder sogar einzelner Anwendungen. Im Gegensatz zur Macro-Segmentierung, die große Netzwerkbereiche voneinander trennt, sorgt die Micro-Segmentierung dafür, dass jeder Host, jede Anwendung oder jede Instanz innerhalb eines Segments individuell abgesichert ist.

Diese feinkörnige Kontrolle über den Datenverkehr innerhalb des Netzwerks ist besonders effektiv, um die seitliche Bewegung von Angreifern zu verhindern. Selbst wenn ein Angreifer in eine VM oder eine Anwendung eindringen kann, wird es ihm durch die Micro-Segmentierung extrem erschwert, sich weiter im Netzwerk zu bewegen oder auf andere Ressourcen zuzugreifen.

Ein Beispiel für die Implementierung von Micro-Segmentierung in einer Private Cloud könnte die Nutzung von VMware NSX oder Cisco ACI sein, die es ermöglichen, detaillierte Sicherheitsrichtlinien für jede einzelne VM festzulegen. Diese Richtlinien könnten den Datenverkehr auf Basis von Anwendungstyp, Nutzerrollen oder sogar spezifischen Sicherheitsanforderungen der jeweiligen VM steuern. So könnte beispielsweise eine Regel festlegen, dass eine Web-Server-VM nur mit einem bestimmten Datenbankserver kommunizieren darf, und jede andere Kommunikation blockiert wird.