Kryptographie und Zugriffskontrolle - Gesamt

Thomas Krabina, geboren 1983, startete seine berufliche Laufbahn im Jahr 2003 als IT Freelancer neben einem Bachelor der Informatik an der TU-Wien. 2007 begann er in der Abteilung Informationstechologie und Service des Österreichischen Roten Kreuzes. Dort war er verantwortlich für den IT-Betrieb und entwickelte dort ¨auch die Security Maßnahmen weiter. 2009 wechselteer, aufgrund der besseren beruflichen Vereinbarkeit, von der TU-Wien auf ein berufsbegleitendes Bachelor Studium an der FH Technikum Wien, welches er 2011abschloss. Anschließend absolvierte er 2013 das Masterstudium Information Management and IT-Security ebenfalls an der FH Technikum Wien. Seit 2013 ist Thomas Krabina als Senior Security Consultant bei CoreTEC ITSecurity Solutions GmbH tätig, welche vollständig im ¨Bereich der Informationssicherheit und IT-Sicherheit tätig ist. Seine Schwerpunkte liegen dabei auf Firewall- und E-Mail Security Systemen, sowie der Multi-Faktor Authentifizierung. Bei CoreTEC leitet er auch die Managed Security Services.

Grundlagen der Kryptographie

Einleitung

Kryptographie ist an sich keine moderne Wissenschaft, sondern spielte schon in der Antike eine Rolle. Schon damals wurden vor allem im militärischen Bereich Nachrichten mit einfachen Methoden verschlüsselt. Mit Beginn des digitalen Zeitalters und durch starkes Vorantreiben durch militärische Organisationen entwickelte sich die Kryptographie zu einem der zentralen Themen in der heutigen Informationstechnologie.

Unter Kryptographie versteht man die Lehre der Methoden des Ver- und Entschlüsseln von Nachrichten . Als primäres Ziel gilt es, den Inhalt einer übertragenen Nachricht vor Dritten zu schützen. Die Kryptoanalyse beschäftigt sich hingegen mit der Entschlüsselung von Nachrichten ohne dabei Zugriff auf den verwendeten Schlüssel zu haben. Sie befasst sich somit mit dem Knacken von verschlüsseltem Text, der Aufdeckung von Schwachstellen und trägt somit dazu bei kryptographische Verfahren und Algorithmen sicherer zu machen. Kryptographie und Kryptoanalyse lassen sich zur Kryptologie zusammenfassen und sind eng miteinander verbunden. Ein weiterer Teilbereich der Kryptologie stellt die Steganografie dar. Diese zielt darauf ab eine geheime Nachricht zu verbergen. Sie teilt sich in die technische Steganographie, welche sich zum Beispiel mit verborgenen Copyright-Informationen innerhalb von digitalen Medien beschäftigt, und der linguistischen Steganographie die Geheimschriften und Semagramme im Fokus hat. Auf den Teilbereich der Steganographie wird allerdings nicht weiter eingegangen.

Begriffserklärungen

Um Verschlüsselungsverfahren zu erklären, bedarf es zunächst einiger Begriffserklärungen und Definitionen. Diese richten sich primär nach dem von der Internet Engineering Task Force (IETF) publiziertem RFC 4949 (Internet Security Glossary, Version 2) . In Fachbüchern, wie auch im Internet, werden oft unterschiedliche Begriffe und Nomenklaturen verwendet. Auch unterscheiden sich manchmal die deutschen Übersetzungen der englischen Begriffe. In der nachfolgenden Arbeit, wird versucht auf unterschiedliche Nomenklaturen und Bedeutungen hinzuweisen, sowie die englischen Begriffe ebenfalls anzuführen.

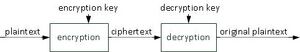

Die originale Nachricht, die es verschlüsselt zu übermitteln gilt, wird als Klartext (engl. Plaintext) bezeichnet. Im mathematischen Kontext wird die unverschlüsselte Nachricht auch als Message tituliert. In Kapitel [hashing], geht es nicht direkt darum Daten zu verschlüsseln, sondern ein Abbild der Daten zu generieren, daher einen sogenannten Hashwert (engl. Message Digest) zu bilden. Die verschlüsselte Nachricht nennt man Geheimtext (engl. Ciphertext). Plaintext und Ciphertext setzen sich aus Zeichen aus zwei endlichen Zeichenmengen, den sogenannten Alphabeten (engl. alphabets) zusammen. Daher existiert ein Klartext-Alphabet und ein Geheimtext-Alphabet.

Der Vorgang, welcher den Klartext in den Geheimtext überführt, wird als Verschlüsselung (engl. Encryption) bezeichnet. Der umgekehrte Vorgang, welcher wiederum Geheimtext lesbar macht, heißt Entschlüsselung (engl. Decryption). Der mathematische Vorgang welcher in umwandelt, wird als Verschlüsselungs-Funktion (eng. Encryption Function) bezeichnet. Daher muss gelten . Die Entschlüsselungs-Funktion (engl. Decrypt Function) wandelt wieder um C in M um, daher Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle D(C)=M}

. Für einen Algorithmus muss also gelten Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle D(E(M))=M}

, ansonsten könnte man den ursprünglichen Klartext nicht mehr herstellen.

Der geheime Schlüssel (engl. Secret Key) ist eine entscheidende Variable eines Ver- beziehungsweise Entschlüsselungs - Algorithmus. Im Speziellen bezeichnet man den Encryption Key als Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle K_E} und den Decryption Key als Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle K_D} . Bei manchen Verfahren, wie vor allem bei den symmetrischen Verfahren (siehe Kapitel [symmetrischeVerfahren]), stellt der Decryption Key sogleich den Encryption Key dar. Bei anderen Verfahren können sich die Schlüssel natürlich auch unterscheiden. Der sogenannte Schlüsselraum (eng. keyspace) beinhaltet alle möglichen zur Verfügung stehenden Schlüssel. Die verwendete Methode zur Ver- und Entschlüsselung wird als Chiffre (engl. Cipher) bezeichnet.

Alice, Bob und Eve

Um Protokolle und Verfahren zu erklären werden im Security Umfeld die fiktiven Personen Alice, Bob und Eve herangezogen . Im Normalfall wird Alice als jene Person beschrieben, von welcher ein Anfrage ausgeht beziehungsweise die eine Verbindung aufbaut. Bob ist die Person die auf diese Anfrage antwortet. Eve (von Eavesdropper) stellt die dritte Partei dar, welche Interesse an der Kommunikation von Alice und Bob hat. Sie stellt den Angreifer dar. Mit Hilfe dieser drei Personen werden in den nachfolgenden Kapiteln Sachverhalte dargestellt und Protokolle und Verfahren erklärt.

Kryptoanalyse

Die Kryptoanalyse befasst sich, wie schon bereits in Kapitel 1 erwähnt, mit Methoden um Informationen aus verschlüsselten Texten zu extrahieren. Angriffsszenarien gegen Verschlüsselungsmethoden liegen meist 4 grundlegenden Klassen zugrunde . Natürlich kann sich ein Angriff beziehungsweise eine Kryptoanalyse auch aus mehreren dieser Klassen zusammensetzen. Vorausgesetzt wird dabei das Kerckhoff’ sche Prinzip, welches in Kapitel [moderncrypto] vorgestellt wird.

- Ciphertext-Only-Attack: Wird eine Attacke genannt, bei welcher der Angreifer oder Kryptoanalyst im Besitz eines oder mehrerer verschlüsselten Texte oder eines Auszuges davon ist. Die Beschaffung eines Ciphertexts ist in der Regel relativ leicht zu erhalten. Für einen erfolgreichen Angriff bedarf es allerdings einen großen Auszug des verschlüsselten Textes.

- Known-Plaintext-Attack: Bei einer Known-Plaintext-Attack ist ein Angreifer sowohl im Besitz eines oder mehrerer Ciphertexte als auch des dazugehörigen Plaintextes.

- Chosen-Plaintext-Attack: Bei der Chosen-Plaintext-Attack wird davon ausgegangen, dass sich der Angreifer zufällige Auszüge des Klartexte aussuchen kann, zu welchen er die entsprechenden verschlüsselten Texte erhält.

- Chosen-Ciphertext-Attack: Im Gegensatz zu Chosen-Plaintext, kann sich der Angreifer hier verschlüsselte Auszüge des Textes aussuchen zu welchen er den Klartext erhält.

klassische Verschlüsselungsverfahren

Klassische Verschlüsselungsverfahren gelten heutzutage als nicht sicher. Dennoch sind sie hilfreich um die grundlegenden Attribute und Eigenschaften eines kryptographischen Systems darzustellen. Sie lassen sich in zwei Verfahren aufteilen, dem Substitutions-Verfahren und dem Transpositions-Verfahren. Bessere Verschlüsselungsverfahren kombinieren diese beiden Methoden miteinander und führen diese auch mehrmals hintereinander aus.

Substitutions-Verfahren

Beim Substitutions-Verfahren wird jedes Klartext-Zeichen durch ein Geheimtext-Zeichen ersetzt. Die Reihenfolge der einzelnen Zeichen bleibt dabei bestehen. In der klassischen Kryptographie gibt es vier Arten der Substitution :

- monoalphabetische Substitution: Jedem Klartextzeichen wird genau ein Zeichen im Ciphertext zugeordnet. Das bekannteste Beispiel für eine monoalphabetische Substitution ist die Cäsar-Verschiebung, siehe dazu Kapitel 1.5.1.

- homophone Substitution: Ein Zeichen im Klartext kann auf verschiedene Zeichen im Ciphertext abgebildet werden. Damit wird versucht Häufigkeitsverteilungen in der Sprache zu verschleiern. Häufig vorkommende Zeichen, wie zum Beispiel E und A, können jeweils einem anderen Zeichen im Ciphertext zugeordnet werden. Die homophone Substitution stellt somit eine Weiterentwicklung der monoalphabetischen Substitution dar.

- polygraphische Substitution: Wie bei der homophonen Substitution wird versucht die Anfälligkeit für eine Häufigkeitsanalyse zu umgehen. Bei der polygraphischen Substitution werden allerdings gleich ganze Buchstabengruppen, sogenannte Polygramme, durch andere getauscht.

- polyalphabetische Substitution: Wie der Name schon sagt, verwendet die polyalphabetische Substitution mehrere Geheimtext-Alphabete um den Klartext abzubilden. Das berühmteste Beispiel dafür ist die Viginière Verschlüsselung, siehe dazu Kapitel 1.5.3.

Cäsar-Verschiebung

Die Cäsar-Verschiebung (engl. Caesar Code) ist auch als Cäsar-Verschlüsselung oder als Cäsar-Chiffre bekannt. Er wurde von Julius Cäsar zur Verschlüsselung militärischer Nachrichten verwendet. Der Cäsar-Code gilt als einer der am Einfachsten zu knackenden Algorithmen. Trotzdem war er damals sehr wirksam, da ein Großteil der Bevölkerung nicht lesen und schreiben konnte.

Der Algorithmus basiert darauf, dass jeder Buchstabe um eine bestimmte Anzahl an Stellen im Alphabet zyklisch verschoben wird. Eine zyklische Verschiebung bedeutet an dieser Stelle, dass nach dem letzten Buchstaben im Alphabet wieder mit dem Ersten begonnen wird. Cäsar selbst verwendete eine Verschiebung um 3 Stellen.

| plaintext | A | B | C | D | E | F | .. | U | V | W | X | Y | Z |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| ciphertext | D | E | F | G | H | I | .. | X | Y | Z | A | B | C |

Der Cäsar-Code basiert auf einem einzigen festgesetzten Alphabet (monoalphabetisch). Jedes Zeichen des Klartext-Alphabets wird genau auf ein Zeichen im Geheimtext-Alphabet abgebildet (bijektiv). Somit wird jedes Zeichen mit einer Permutation von sich selbst ausgetauscht. Dies wird als einfache Substitution bezeichnet. Der Cäsar-Code ist somit eine monoalphabetische Substitution.

Ein mathematische Darstellung des Cäsar-Codes lässt sich wie folgt darstellen . Beachtet man Groß- und Kleinschreibung, sowie Sonderzeichen und Leerzeichen nicht, handelt es sich beim Cäsar-Code um ein Alphabet mit Länge 26, den Buchstaben von A bis Z. Die Buchstaben (A bis Z) werden durch ihre entsprechenden Stellen im Alphabet (0 bis 25) beschrieben. Da das Geheimtext-Alphabet ebenfalls aus den Buchstaben A bis Z besteht ist das Klartext-Alphabet Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle A_1}

mit dem Geheimtext-Alphabet Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle A_2}

ident. Daher Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle A_1 = A_2 = \{ 0, 1, .., 25\}}

. Der geheime Schlüssel stellt die Anzahl der Verschiebungen dar. Der Decryption Key Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle K_D}

und auch der Encryption Key Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle K_E}

kann daher nur einen Wert innerhalb der Alphabete annehmen, daher Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle K_D = K_E = \{1,..,26\}}

. Das Verfahren zur Verschlüsselung kann daher als Addition mit Modulo dargestellt werden. So sei Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle x}

ein Klartext-Buchstabe, Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle y}

ein Geheimtext-Buchstabe und Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle K_E}

der Encryption Key beziehungsweise Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle K_D}

der Decryption Key.Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle Encrypt: y = ( x + K_E) \mod 26}

Eine Verschiebung ist einfach wieder rückgängig zu machen durch das umgekehrte Verfahren.Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle Decrypt: x = ( y - K_D ) \mod 26}

Um einen Ciphertext, der mit Cäsar-Code verschlüsselt wurde, zu knacken, ist natürlich die einfachste Variante alle verfügbaren Möglichkeiten zu probieren. In unserem Alphabet ist dies noch Recht überschaubar mit 26 möglichen Lösungen. Allerdings lässt auch ein Ausprobierenmöglicherweise Interpretationsspielraum besonders bei kurzen Nachrichten zu. So kann ein Ciphertext in mehrere mögliche Klartext-Nachrichten übersetzt werden.

| ciphertext | D | S | P |

|---|---|---|---|

| shift by 2 | F | U | R |

| shift by 8 | L | A | X |

| shift by 15 | S | H | E |

Die möglichen Lösungen machen für Außenstehende wenig Sinn, allerdings können auf diesem Weg zum Beispiel Codeworte übermittelt werden.

Ein besondere Form des Cäsar-Code wird sogar heute noch eingesetzt. ROT13 (Rotate by 13) stammt ursprünglich aus dem Usenet und wird dazu verwendet um Texte zu verschleiern beziehungsweise unlesbar zu machen, zum Beispiel für obszöne Witze oder sogenannten Spoilern. ROT13 verwendet eine Cäsar Verschiebung um 13 Stellen. Die Verwendung von 13 Stellen hat die Eigenschaft, dass eine Ver- beziehungsweise Entschlüsselung genau ident verläuft. Bei einer zweimaligen Verschlüsselung findet eine doppelte Verschiebung um 13 Stellen statt. In einem Alphabet mit 26 Buchstaben bringt dies wiederum den Klartextbuchstaben zum Vorschein. Zudem existieren weitere Versionen von ROT, bei welchen Sonderzeichen oder Zahlen miteinbezogen werden.

einfache Substitution

Eine einfache Substitution (engl. Simple Substitution) ersetzt einen Buchstaben des Klartext-Alphabets mit einer Permutation von sich selbst. Ein Buchstabe wird somit mit dem Buchstaben des Substitutions-Alphabets, dass an derselben Stelle steht, ersetzt. Ein Beispiel dafür ist in Tabelle [table: substitution] ersichtlich.

Ein Ausprobieren, wie beim Cäsar-Code, ist diesmal nicht so einfach möglich, da Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle 26!} Möglichkeiten bestehen um alle Permutationen abzudecken. Die einfache Substitution ist noch immer monoalphabetisch und basiert daher auf einem einzigen festgelegten Alphabet. Jeder Buchstabe für sich selbst verschlüsselt. Aus diesem Grund ist es möglich einen Ciphertext anhand statistischer Angriffe zu entschlüsseln . Die Buchstaben natürlicher Sprachen weisen unterschiedliche Häufungs-Verteilungen auf. Diese Häufungen können auf den Ciphertext umgelegt werden. Die Häufungen der deutschen Sprache sind in Tabelle [table: haeuffigkeiten] dargestellt.

Erforderlich für einen statistischen Angriff ist, dass der Klartext in einer natürlichen Sprache verfasst ist und ein genügend langer Ciphertext zur Verfügung steht, um die Buchstaben des Geheimtextes laut Statistik und Häufigkeitsverteilung einem Buchstaben im Klartextalphabet zuordnen zu können.

Um die Kryptoanalyse einer monoalphabetischen Verschlüsselung zu erschweren, können unterschiedliche Techniken angewendet werden. So wurden im ersten Weltkrieg Codebücher verwendet, um gebräuchliche Wörter mit einer Kunstsprache zu verschleiern. Außerdem wurden Homophone verwendet, sinnlose Zeichen eingefügt um Häufigkeiten zu verschleiern oder einem Klartextbuchstaben gleich eine Reihenfolge von Buchstaben zugeordnet.

Viginière-Verschlüsselung

Die Vigenière-Verschlüsselung ist eine polyalphabetische Verschlüsselung. Ein Buchstabe wird dabei nicht immer auf denselben Geheimtextbuchstaben abgebildet. Als Schlüssel wird ein Schlüsselwort gewählt, welches wiederholend über den Klartext gelegt wird . Im Beispiel der Tabelle 1.3 wird als Secret Key "BLAU" verwendet, welcher sich immer wiederholt.

| plaintext | D | A | S | I | S | T | G | E | H | E | I | M | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| key | B | L | A | U | B | L | A | U | B | L | A | U |

|

| ciphertext | E | L | S | C | T | E | G | Y | I | P | I | G |

|

Dies macht statistische Angriffe wie bei der einfachen Substitution in Kapitel 1.5.2 schwieriger aber nicht unmöglich. Der Knackpunkt der Vigenère-Verschlüsselung ist die Länge des eingesetzten Schlüssels. Es treten auch hier im Ciphertext Wiederholungen auf, welche auf die Länge des Schlüssels schließen lassen. Ist die Länge des Schlüssels wiederum bekannt, kann zur weiteren Kryptoanalyse ein statistischer Angriff erfolgen.

Theoretisch wäre die Vigenère-Verschlüsselung sicher, wenn die Länge des Keys gleich lang wie der Plaintext, nur einmalig verwendet wird und der Secret Key zufällig zusammengestellt ist. Somit gäbe es keine Wiederholungen und jeder Buchstabe wäre zufällig auf eine andere abgebildet. Dies wäre ein sogenanntes One Time Pad, siehe Kapitel 1.5.4. Dies ist natürlich nicht praktikabel, da bei einer Verschlüsselung von einem 1GB großen File, der Secret Key ebenfalls 1GB sein müsste und man unterschiedliche Keys jedes mal aufs Neue mit seinem Kommunikationspartner austauschen müsste.

One-Time Pad

Das One-Time Pad (OTP) [1] ist ein Theorem aus der Informationstheorie und wurde von Gilbert Vernam patentiert . Das OTP wird daher auch manchmal als Vernam Cipher bezeichnet. Ein One-Time Pad gilt als die perfekte Verschlüsselung da sie als beweisbar sicher gilt. Mehr zu beweisbarer Sicherheit ist in Kapitel [cryptoSec] zu finden.

OTP verwendet einen Secret Key, welcher gleich lang ist wie der Plaintext. Der Key wird nur einmal verwendet und ist durch einen echten Zahlenzufallsgenerator generiert (mehr zu Zufallsgeneratoren siehe Kapitel [moderncrypto]). Das OTP ist perfekt sicher. Das OTP kann nur durch Kenntnis des Secret Keys entschlüsselt werden. Diesen Secret Key zu erraten oder zu errechnen ist unmöglich, da jeder mögliche Schlüssel mit der selben Wahrscheinlichkeit auftreten kann. Leider ist ein OTP nicht praktikabel beziehungsweise durchführbar.

Transpositions-Verfahren

Bei der Transposition wird die Reihenfolge der Zeichen vertauscht, nicht aber die Zeichen selbst. Die Zeichen des Klartext bleiben somit an sich erhalten, sie werden nur an eine andere Stelle gesetzt. Somit bleibt auch die Anfälligkeit gegenüber Häufigkeitsanalysen bestehen. Die Sicherheit lässt sich etwas erhöhen, indem eine erneute Transposition durchgeführt wird.

Skytale

Das Skytale (oder auch Scytale) wurde ca. 500 vor Christus von den Spartanern entwickelt und verwendet um geheime Botschaften zu übermitteln . Das Skytale war ein einfacher Holzstab eines bestimmten Durchmessers. Um diesen Holzstab wurde ein Streifen Pergament gewickelt. Die Botschaft wurde längsseitig des Stabes auf das Pergament geschrieben und danach wieder abgewickelt. Um die Nachricht lesen zu können wurde daher ein Stab mit demselben Durchmesser benötigt. Der Durchmesser des Stabes stellt somit den Secret Key dar.

Spaltentransposition

Bei der (einfachen) Spaltentransposition (engl. Simple Transposition) wird der Klartext in eine Tabelle eingetragen . Die Anzahl der Spalten wird durch die Länge des Schlüssels (oder der Keywords) bestimmt. Die Anzahl der Zeilen richtet sich nach der Länge des Klartextes.

| key | 2 | 4 | 5 | 1 | 3 |

|---|---|---|---|---|---|

|

|

D | A | S | T | R |

|

|

E | F | F | E | N |

|

|

F | I | N | D | E |

|

|

T | A | M | F | R |

|

|

E | I | T | A | G |

|

|

S | T | A | T | T |

Beispiel: Als Secret Key wird 2-4-5-1-3 verwendet. Der zu übertragende Klartext ist: "DASTREFFENFINDETAMFREITAGSTATT’. Die Anzahl der Spalten ist 5, da der Key die Länge 5 hat. Der Klartext wird nun, wie in 1.4 dargestellt in die Tabelle geschrieben:

Danach werden die Spalten aufgrund des Schlüssels in Blöcken dargestellt. Daher wird, wie in Tabelle 1.5 ersichtlich, bei Spalte 1 begonnen:

| ausgelesene Spalte | 1 | 2 | 3 | 4 | 5 |

|---|---|---|---|---|---|

|

|

TEDFAT | DEFTES | RNERGT | AFIAIT | SFNMTA |

Um die Länge des Schlüssels nicht zu verraten können die Blöcke auch in Gruppen vorgegebener Länge eingeteilt werden. Die einfache Spaltentransposition kann durch die doppelte Spaltentransformation (engl. Double Transposition) erweitert werden. Hierzu wird der erhaltene Geheimtext erneut in eine neue Tabelle anderer Spaltengröße eingetragen.

Moderne Kryptographie

Mit moderner Kryptographie sind jene Methoden gemeint, welche nicht auf der Geheimhaltung des Verschlüsselungsverfahren beruhen um sicher zu sein. Sicherheit, welche durch Geheimhaltung der Funktionsweise erreicht wird, wird auch Security by Obscurity genannt. Im Gegensatz dazu steht das Kerckhoffs’sche Prinzip (engl. Kerckhoffs’ Maxime). Auguste Kerckhoff veröffentlichte im Jahr 1883 eine Arbeit über vertrauliche militärische Kommunikation (damals noch über Telegraphenleitungen), welche auch heute noch anwendbar sind. So besagt Kerckhoff’s zweite Regel:

The cipher method must not be required to be secret, and it must be able to fall into the hands of the enemy without inconvenience. [2]

Sinngemäß fordert diese Regel, dass die Sicherheit eines kryptographischen Systems nicht von der Geheimhaltung der Funktionsweise, sondern nur von der Geheimhaltung der verwendeten Schlüssel abhängen darf.

Es gibt immer wieder Diskussionen darüber ob Security by Obscurity einen validen Ansatz für ein sicheres kryptografisches System darstellt. Oft wird dies auch immer wieder so praktiziert. So konnte zum Beispiel die VoIP Software Skype aufgrund seines proprietären Protokolls und nicht zugänglichem Source Code lange seine Funktionsweise und Verschlüsselungsmethoden geheim halten. Durch Reverse Engineering gelang es aber die verwendeten Verschlüsselungsmethoden zu identifizieren. So wurde der VoIP Signaling Datenverkehr mittels einer abgewandelten RC4-Verschlüsselung versehen, die zum damaligen Zeitpunkt als nicht mehr sicher galt . Ein anderes Beispiel sind Mifare - Chipkarten, welche als kontaktloses Zahlungsmittel verwendet wurden und auf einem geheimen Algorithmus basierten. Nach Reverse-Engineering der Hardware wurden eklatante Sicherheitsmängel festgestellt .

Der bekannte Security Experte Bruce Schneier hat zum Thema Security by Obscuritybeziehungsweise Open Source / Closed Source auch folgende Argumentation:

"cryptography is hard to do right, and the only way to know if something was done right is to be able to examine it.. [..] .. Public algorithms are designed to be secure even though they are public; that’s how they’re made. So there’s no risk in making them public. If an algorithm is only secure if it remains secret, then it will only be secure until someone reverse-engineers and publishes the algorithms."

Weitere Herausforderungen der Kryptographie sind zum einen das Mooresche Gesetz (engl. Moore’s Law) und zum anderen das Problem der Zufallsgeneratoren, mit welchem sich Kapitel 1.3 befasst. Das Mooersche Gesetz besagt, dass sich die Rechenkraft von Computern (je nach Quelle) alle 12 bis 24 Monate verdoppelt. Dies wirkt sich auch auf kryptographische Systeme aus . Werden beispielsweise heute noch Jahre für die Entschlüsselung eines Verfahrens benötigt, könnte man dafür in einigen Jahren nur noch kurze Zeit benötigen. Die Bit Anzahl für Verfahren müssen demnach regelmäßig erhöht werden beziehungsweise bessere Verfahren entwickelt werden, um weiterhin sicher zu sein.

Ziele und Anforderungen moderner Verfahren

Moderne kryptographische Systeme haben 4 fundamentale Ziele, die sie zu erreichen versuchen . Nicht jedes kryptographische System erreicht alle diese Ziele. Dies ist auch oft nicht notwendig, je nachdem für welchen Zweck das kryptographische System geschaffen wurde:

- Vertraulichkeit (engl. Confidentiality): Die Information darf nur für berechtigten Personen zugänglich sein. Es soll sichergestellt sein, dass nur der die Nachricht empfangen und lesen kann, für den sie auch bestimmt war.

- Integrität (engl. Integrity): Der Empfänger einer Nachricht muss feststellen können, ob die Nachricht nach der Erzeugung verändert worden ist. Somit muss die Nachricht vor Veränderungen geschützt sein. Beispiele hierfür sind die Integrität von Backups oder die Kommunikation von zwei Parteien.

- Authentizität (engl. Authentication): Aus der Information oder Nachricht muss der Autor eindeutig hervorgehen. Dies muss für den Empfänger eindeutig nachprüfbar sein.

- Nichtabbstreitbarkeit (engl. Non-repudiation): Wird auch als Verbindlichkeit bezeichnet. Der Autor einer Nachricht soll nicht abstreiten können, dass dieser auch die Nachricht verfasst hat. Dies ist vor allem wichtig beim Abschluss von elektronischen Verträgen. So soll für eine Nachricht weder der Versand für den Sender, noch der Erhalt für den Empfänger im Nachhinein bestreitbar sein.

Das Kapitel [Grundlagen] zeigte, dass klassische Verschlüsselungsverfahren wesentliche Nachteile aufweisen. So wird der Klartext zum einen nur zeichenweise in Ciphertext transformiert. Das Problem dabei ist, dass sich bei Änderung eines Klartextzeichens auch nur das entsprechende Zeichen im Ciphertext ändert, nicht aber der ganze oder zumindest ein Teil des Ciphertextes. Zweitens, sind klassische Verfahren durch Häufigkeitsverteilungen der Buchstaben und Worte vorhersagbar, auch wenn es Techniken gibt diese zu verschleiern. Aufgrund dieser Nachteile forderte Claude Shannon im Jahr 1949, dass ein guter Verschlüsselungsalgorithmus zwei grundlegende Eigenschaften erfüllen muss:

- Diffusion: Jede noch so kleine Veränderung des Plaintext und / oder des Secret Keys sollen eine möglichst große Auswirkung auf den Ciphertext mit sich bringen. Damit verteilen sich die Redundanzen des Plaintexts über den Ciphertext.

- Konfusion: Um eine Kryptoanalyse so schwer wie möglich zu machen, sollen Plaintext, Ciphertext und der Secret Key möglichst komplex sein um Zusammenhänge schwer erkennen zu können. Dies verkompliziert die Suche nach Redundanzen und statistischen Mustern im Ciphertext.

Moderne Verfahren erfüllen beide Eigenschaften. Diffusion und Konfusion werden dabei mehrmals hintereinander ausgeführt.

kryptographische Sicherheit

Eine absolute Sicherheit bietet nur das One-Time-Pad, welches in Kapitel [vernam] vorgestellt wurde. Das OTP bietet absolute Sicherheit, durch seine zwei grundlegenden Eigenschaften:

- echte zufällig gewählte Schlüsselzeichen

- der Schlüssel hat dieselbe Länge wie der Klartext

Dies allerdings nur, wenn das OTP nicht mehrmals verwendet wird und für jede Verschlüsselung ein neuer zufälliger Secret Key verwendet wird. Dann gilt das OTP als beweisbar sicher, da jeder mögliche Schlüssel mit der selben Wahrscheinlichkeit auftreten kann. Zur beweisbaren Sicherheit schreiben Paar und Pelzl:

A cryptosystem is unconditionally or information-theoretically secure if it cannot be broken even with infinite resources

Genau dies erfüllt das One-Time-Pad mit seinen Eigenschaften. Aber auch genau aufgrund dieser Eigenschaften ist es in der Praxis nicht tauglich. Stellen Sie sich vor Sie müssten ein 1GB größes File verschlüsseln. Hierzu müssten Sie einen Secret Key erzeugen und zum Empfänger bringen, der ebenfalls 1GB groß ist. Für jeden weiteren Empfänger müsste der Vorgang wiederholt werden. Somit ist das One-Time-Pad zwar perfekt sicher, aber untauglich in der Praxis. Es wird allerdings versucht sich diesen zwei Eigenschaften anzunähern.

Zufallszahlen

Zufallszahlen spielen eine große Rolle in der Kryptographie. Sei es beispielsweise ein Key Stream einer symmetrischen Chiffre (siehe Kapitel [symmetrischeVerfahren]) oder der Initialisierungsvektor eines Algorithmus. Leider sind Zufallszahlengeneratoren oft gar nicht so zufällig wie sie sein sollten und sehr einfach zu berechnen, da diese auch nur einem Algorithmus folgen. So schreibt Bruce Schneier folgende Erklärung:

"A computer can only be in a finite number of states (a large finite number, but a finite number nonetheless), and the stuff that comes out will always be a deterministic function of the stuff that went in and the computer’s current state. That means that any random-number generator on a computer (at least, on a finite-state machine) is, by definition, periodic. Anything that is periodic is, by definition, predictable. And if something is predictable, it can’t be random. A true random-number generator requires some random input; a computer can’t provide that."

Daher werden die meisten auf Software basierten Generatoren Pseudo - Zufallszahlen Generatoren (engl. Pseudo-Random Sequence Generator oder PRNG) genannt, welche eigentlich nur die Eigenschaft haben, dass sie zufällig aussehen. Sie erfüllen die Eigenschaft, dass die produzierten Zahlen statistisch gesehen zufällig sind. Für einen Angreifer beziehungsweise Kryptoanalysten stellen diese allerdings einen möglichen Angriffsvektor dar.

Ein kryptographisch sicherer Zufallszahlen - Generator (engl. Cryptographically Secure Pseudo-Random number generator oder CSPRNG) muss zudem die Anforderung erfüllen, dass die generierten Zahlen unvorhersagbar sind . Die erzeugten Zahlen dürfen nicht vorhersagbar sein, selbst wenn Algorithmus und/oder Hardware bekannt sind auf welcher sie generiert worden sind. Nur durch den initialen Seed [3] ist ein kryptographisch sicherer Zufallsgenerator kompromittierbar.

Ein echter Zufallszahlengenerator erfüllt noch eine dritte Eigenschaft. Die generierte Zahlenfolge kann nicht reproduziert werden . Wird unter gleichen Bedingungen und Startwerten eine weitere Folge an Zufallszahlen erzeugt, muss dieser eine komplett unabhängige zweite Zahlenfolge generieren. Natürlich ist es schwer zu sagen, was genau echter Zufall ist und was nicht. Zur Überprüfung von PRNGs existieren jedenfalls standardisierte Testverfahren.

Schlüsselmanagement

Der Secret Key ist einer der wichtigsten Bestandteile eins kryptographischen Verfahrens. Im Detail werden von einem Algorithmus allerdings noch andere Schlüssel benötigt, wie beispielsweise Rundenschlüssel oder Initialisierungsvektoren. Diese werden, wie in Kapitel 1.3 beschrieben, zumeist von einem Pseudo-Zufallszahlen Generator erzeugt . Je zufälliger Zahlen von einem Generator erzeugt werden, desto sicherer ist der Algorithmus. Beispielsweise verwendet /dev/random unter Linux zum einen Teil einen PRNG. Zum anderen Teil wird das Rauschen der Gerätetreiber addiert, um echte Zufallszahlen zu erhalten. Andere Möglichkeiten für die Schlüssel Generierung sind zum Beispiel die Messung der Zeitabstände von Tastaturanschlägen oder eine Analyse von Mausbewegungen. Meist wird eine Kombination mehrerer Komponenten, in welche zum Beispiel auch die aktuelle Systemzeit oder Teile der Hardware Identifikation mit einfließen, verwendet. Über teure und spezielle Hardware könnten Zufallszahlen auch über den radioaktiven Zerfall, Widerstandsrauschen oder Entladung von Kapazitäten generiert werden

Oft von Vorteil ist auch die Verwendung von kurzlebigen Schlüsseln, welche in regelmäßigen abständen erneuert werden müssen . Solche Schlüssel werden als Sitzungsschlüssel (engl. Session Keys) oder temporäre Schlüssel (engl. Ephemeral Keys) bezeichnet. Die Verwendung von zeitlich begrenzten Schlüsseln hat den Vorteil, dass bei Verlust eines Schlüssel nur ein begrenzter Teil des Ciphertextes betroffen ist.

Viele Protokolle und Verfahren erneuern in regelmäßigen Abständen den verwendeten Schlüssel. Dies ist am besten durch eine Einwegfunktion zu realisieren. Eine wichtige Anforderung für die Schlüsselerneuerung ist, dass der neue Secret Key nicht vom alten Key abhängen darf. Dies wird als perfekte Vorwärtssicherheit (engl. Perfect Forward Secrecy) (PFS) bezeichnet. Ansonsten wäre es bei Kompromittierung eines Secret Keys möglich, alle davor verwendeten Keys zu berechnen und damit die bisher stattgefundene Kommunikation zu entschlüsseln.

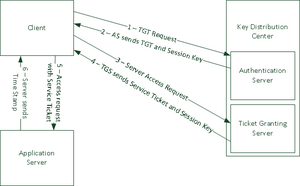

Um die generierten Schlüssel mit den Kommunikationsteilnehmern auszutauschen kann natürlich der Postweg verwendet werden, was in der Praxis natürlich nicht sehr praktisch ist. Vom Problem des sicheren Schlüssel Austausches sind vor allem symmetrische Verfahren betroffen. Um das Problem zu lösen, werden Schlüsselaustausch Protokolle verwendet, wie zum Beispiel das Diffie-Hellman Verfahren, welches in Kapitel [DH] vorgestellt wird. Verwendet ein Protokoll ein asymmetrisches Verfahren für den Austausch des Secret Keys, welcher dann in weiterer Folge für eine schnellere symmetrische Verschlüsselung verwendet wird, spricht man von einem hybriden Verfahren. Eine andere Möglichkeit um Schlüssel auszutauschen beziehungsweise zu Verwalten ist die Verwendung von zentralen Schlüsselservern (engl. Key Distribution Center) (KDC). Als Beispiel sei hier Kerberos angeführt, welches in Kapitel [Kerberos] beschrieben ist.

Angriffsvektoren

Bei kryptographischen Verfahren, gibt es natürlich auch immer Angriffspunkte, die für Kryptoanalysten beziehungsweise Angreifer besonders erfolgversprechend sind. Bei der klassischen Kryptoanalyse unterscheidet man einerseits zwischen einer vollständigen Schlüsselsuche, also dem Ausprobieren aller möglichen Schlüssel im Keyspace . Diese Methode ist besser bekannt als Brute-Force Angriff. Das Angriffsziel wird dabei als Blackbox betrachtet. Zweitens, werden analytische Angriffe verwendet. Diese betrachten die interne Struktur des Algorithmus um dessen Schwachstellen auszunutzen. Bekannte Angriffe sind zum Beispiel Side-Channel Attacks, also Seitenkanal Angriffe. Bei diesen wird anhand des Stromverbrauchs oder anhand der elektromagnetischen Abstrahlung und mit Hilfe der Signalverarbeitung versucht, den Schlüssel zu berechnen.

Eines der größten Risiken ist und bleibt immer der Mensch. Dies versuchen Angreifer durch Social Engineering Angriffe auszunutzen. Es wird versucht, unter Vortäuschung falscher Tatsachen und mittels der Gutgläubigkeit des Menschen, diesen geheime Informationen zu entlocken. Zu den klassischen Methoden des Social Engineering zählen Phishing oder Baiting. Unter Baiting wird das Platzieren von manipulierten Datenträgern verstanden, mit dem Ziel, dass Personen diese an ihren Computer öffnen.

Ein anderer Angriffsvektor sind sogenannte Protokollangriffe, die besonders bei RSA interessant sind. Bei Protokollangriffen werden Schwachstellen in der Implementierung des Verfahrens ausgenutzt. Beispielsweise, wenn die RSA Implementierung zu kleine oder zu nahe aneinander liegende Primzahlen verwendet und eine Berechnung der RSA Module ermöglicht, siehe dazu Kapitel [RSA]

Ein Angriff, der vor allem asymmetrische Verfahren trifft, ist die Man-in-the-Middle Attack. Die zu Grunde liegende Idee ist, dass ein Angreifer die öffentlichen Schlüssel von einem oder zwei Teilnehmern abfängt und gegen seine(n) eigenen tauscht. Dies ist möglich, wenn die Schlüssel nicht ausreichend geschützt sind. Als Gegenmaßnahme können die Public Keys mittels digitaler Signatur geschützt werden. Der Empfänger muss daher die Signatur auf Authentizität überprüfen bevor er den Public Key seines Kommunikationspartners verwendet.

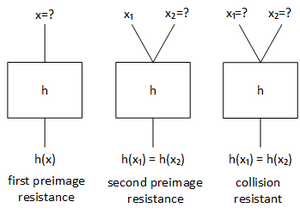

Bei Hash - Verfahren stellen Angriffe vor allem Kollisionsattacken und Urbild Angriffe (engl. Preimage Attacks) dar. Die Attacken zielen daher auf die Kollisionsresistenz des Algorithmus ab, siehe dazu Kapitel [collision-resistance]. Bei Kollisionsattacken (engl. Collision Attack) wird versucht zwei Dokumente zu finden, die denselben Hashwert bilden. Eine First Preimage Attack hingegen versucht zu einem vorgegebenen Hashwert eine Nachricht zu finden, die denselben Hashwert erzeugt. Eine Second Preimage Attack wiederum versucht zu einer gegebenen Nachricht eine zweite zu finden, die denselben Hashwert produziert. Der Vorteil den Kryptoanalysten beziehungsweise Angreifer auszunutzen zu versuchen ist das Geburtstagspradoxon aus Kapitel [geburtstagsparadoxon]. Solche Angriffe werden auch als Birthday - Attack bezeichnet.

Symmetrische Verfahren

Die wichtigste Eigenschaft eines symmetrischen Verfahrens ist, dass der Secret Key bei der Verschlüsselung gleich dem Key bei der Entschlüsselung ist, daher gilt Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle K_E=K_D} . Für die Entschlüsselung, benötigt der Empfänger den Secret Key des Absenders bzw. Erstellers. Daher muss der Schlüssel über einen sicheren Kanal zwischen Sender und Empfänger ausgetauscht werden.

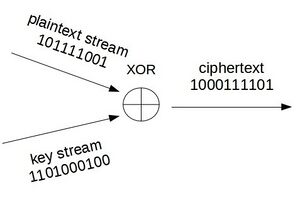

Symmetrische Algorithmen basieren auf einfachen Operationen wie Shifts oder Exclusive OR - Verknüpfungen (XOR) und sind somit dementsprechend schnell, da sie auch gut in Hard- und Software implementierbar sind. Sie treten entweder als Block- oder als Stromchiffren auf, die in den nachfolgenden Kapiteln 1.1 und 1.2 im Detail behandelt werden. Stromchiffren verschlüsseln jedes Bit des Plaintext Streams einzeln und kontinuierlich mit dem Key Stream. Blockchiffren hingegen verschlüsseln einen ganzen Block des Plaintextes mit dem Secret Key beziehungsweise einem Rundenschlüssel.

Stromchiffren

Bei Stromchiffren (engl. Stream Cipher) wird der Klartext als Stream kontinuierlich verschlüsselt. Das heißt, dass Klartext in der Größe von, zum Beispiel, 1-Bit, zeichenweise verschlüsselt wird. Der Klartext wird sequentiell abgearbeitet. Die Verschlüsselung geschieht anhand eines pseudozufälligen Bitstroms der mit dem Plaintext verknüpft wird (zum Beispiel durch XOR).

Nach Verschlüsselung eines Zeichens kann dieses sofort an den Empfänger weitergeleitet werden. Daher eignen sich Stromchiffren auch sehr gut für Übertragungen die in Echtzeit ablaufen müssen, wie beispielsweise Telefonie.

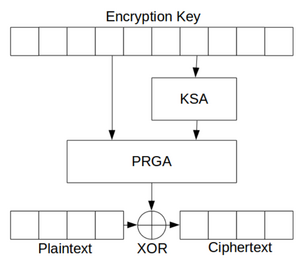

RC4

Die RC4-Cipher (Ron’s Code 4) wurde im Jahr 1987 von Ronald Rivest, einem Mitarbeiter von RSA Data Security, entwickelt. Die Funktionsweise von RC4 wurde lange geheimgehalten. Aufgrund dessen konnte die Sicherheit von RC4 lange nicht geprüft werden. Um RC4 verwenden zu dürfen mussten auch Lizenzkosten an RSA gezahlt werden. 1994 fand der Algorithmus über eine anonyme Veröffentlichung in einer Mailingliste seinen Weg an die Öffentlichkeit. Um Streitigkeiten mit RSA zu vermeiden wurde der veröffentlichte Algorithmus ARCFOUR genannt. RC4 ist sehr einfach implementierbar und schnell. Sie erfreute sich hoher Beliebtheit und fand früher Anwendung im SSH, SSL beziehungsweise TLS und WEP Protokoll. Sie gilt aber mittlerweile als unsicher und von ihrer Verwendung wird abgeraten .

Funktionsweise:

RC4 hat besteht aus zwei Elementen, dem Key - Scheduling Algorithm (KSA) und dem Pseudo Random Generation Algorithm (PRGA).

Der KSA befüllt ein Array von 0 bis 255. Anhand des Secret Keys mit variabler Länge (40 bis 256-Bit) wird dieses Array in eine pseudo-zufällige Reihenfolge gebracht. Dies geschieht anhand von Substitution, daher die Elemente innerhalb des Arrays werden untereinander vertauscht. Das Array wird auch als S-Box beziehungsweise Substitutions-Box bezeichnet. Ist die S-Box vollständig befüllt wird durch den PRGA eine weitere Substitution vorgenommen. Dabei werden die Elemente in der S-Box erneut mittels einem Array, das anhand des Secret Keys generiert wird, vertauscht. Als letzter Schritt wird der Cipherstream mit dem Plaintext bitweise XOR verknüpft.

Blockchiffren

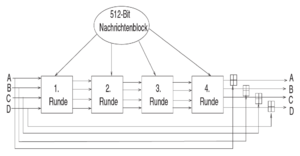

Bei Blockchiffren (engl. Block Cipher) wird der Klartext vor der Verschlüsselung in Blöcke fester Größe eingeteilt. Typische Blockgrößen sind zum Beispiel 64-Bit, 128-Bit, etc. Die Größe des Blocks gibt der verwendete Algorithmus vor. Die Verschlüsselung findet dann blockweise und in mehreren Runden statt. Für eine Runde wird üblicherweise ein eigener Rundenschlüssel verwendet, um Konfusion zu erreichen. Außerdem wird innerhalb einer Runde eine Substitutions-Box (S-Box) verwendet. Dies erzeugt die gewünschte Diffusion. Der letzte Block wird dann mittels eines Füllmuster auf die entsprechende Blockgröße gefüllt. Dies wird als Padding bezeichnet. Der Paddingbereich wird durch eine definierte Bitfolge als solches gekennzeichnet, sonst gäbe es bei der Entschlüsselung Probleme. Blockchiffren können nur dann eingesetzt werden, wenn der gesamte Plaintext bereits vor der Verschlüsselung vorliegt. Anwendungsbereiche für Blockchiffren sind zum Beispiel Datei- oder E-Mail Verschlüsselung.

Betriebsmodi

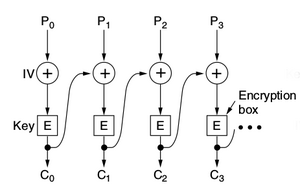

Der Betriebsmodus (engl. Mode of Operation) gibt das Verfahren an, welches auf einen einzelnen Block angewendet wird. Die meisten der Betriebsmodi verwenden einen sich abwechselnden Initialisierungsvektor (IV) der in den Verschlüsselungsprozess einfließt . Damit wird sichergestellt, dass ein und der selbe Plaintext immer einen anderen Ciphertext ergibt.

Electronic Code Book (ECB): Dies ist der einfachste Modus. Jeder Block wird auf dieselbe Art und Weise verschlüsselt. Daher ergibt ein und derselbe Plaintext auch immer den selben Ciphertext. ECB ist für die kryptographische Anwendung nicht empfohlen.

Cipher Block Chaining Mode (CBC): Bei CBC wird jeder Block der Reihe nach verschlüsselt. Vor der Verschlüsselung wird jedoch noch der Plaintext mit dem Ciphertext der letzten Runde XOR verknüpft. Für den ersten Block beziehungsweise die erste Runde wird ein Initialisierungsvektor verwendet. Dieser kann aus einem Zeitstempel oder einer zufälligen Zahlenfolge generiert werden.

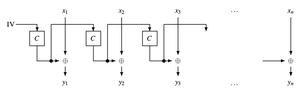

Output Feedback Mode (OFB): Beim OFB wird eine Blockchiffre dazu verwendet eine Stromchiffre zu erzeugen. Der Schlüsselstrom wird allerdings nicht Bit für Bit, sondern als Block generiert. Zu Beginn wird dafür ein Initialisierungsvektor mittels Blockchiffre verschlüsselt. Der Ausgabeblock dient als Stream und wird wieder als Eingangswert für die Blockchiffre verwendet (daher der Name Output Feedback). Der als Stream verwendete Block wird dann mit dem Plaintext XOR verknüpft.

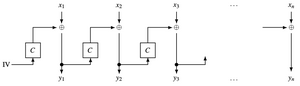

Cipher-Feedback Mode (CFB): Der CFB ist wieder ein Betriebsmodus, welcher sich einer Blockchiffre zur Hilfe nimmt. Er ist sehr ähnlich dem OFB. Der wesentliche Unterschied ist, dass beim CFB der bereits verschlüsselte Block (daher der Name Cipher Feedback) als Eingabewert für den nächsten Block dient.

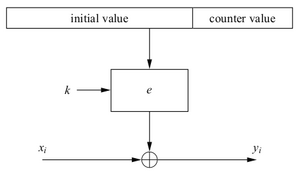

Counter Mode (CTR): Der CTR Modus, verwendet wie OFB und CFB eine Blockcipher als Stromchiffre. Für die Berechnung des neuen Schlüsselstroms wird ein Zähler verwendet. Für die erste Runde dient wiederum ein Initialisierungsvektor.

Galois Counter Mode (GCM): Der GCM hat neben seiner Verschlüsselungs - Funktion als Betriebsmodus auch die Möglichkeit einen MAC zu generieren (siehe Kapitel [MAC]). Mithilfe des MAC kann der Empfänger überprüfen, ob die Nachricht wirklich vom Absender stammt und ob die Nachricht manipuliert wurde. Mit anderen Worten, kann daher die Authentizität und die Integrität der Nachricht überprüft werden. Der GCM verschlüsselt die Daten nach dem Counter Mode (siehe oben). Anschließend wird der MAC berechnet. Dafür wird eine Blockgröße von 128-Bit verwendet. Somit könnte beispielsweise AES als AES-CGM verwendet werden. Der Berechnung des MAC liegt die Multiplikation im Galois Körper (endliche Körper) zugrunde.

Eine Variante von GCM wird als GMAC zur Berechnung von Hashwerten verwendet . Beim GMAC wird auf die Verschlüsselung verzichtet und nur der MAC berechnet. Durch die hohe Geschwindigkeit vom GMAC wird er oft in Bereichen eingesetzt in welchen eine schnelle Überprüfung der Datenintegrität zu gewährleisten ist, beispielsweise bei IPSec oder Fehlererkennungsverfahren.

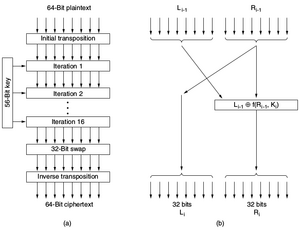

Data Encryption Standard

Der Data Encryption Standard Algorithmus (DES) wurde in den 1970er Jahren von IBM, dem National Bureau of Standards (NBS) [4] und der NSA entwickelt . DES wurde nach seiner Veröffentlichung im Jahr 1977 zum Standard für alle US-Behörden erklärt. Durch die geringe Schlüssellänge von nur 56-Bit wurde vermutet, dass die NSA zu diesem Zeitpunkt bereits über ausreichend Rechenkapazität verfügte um DES durch einen Brute-Force Angriff zu entschlüsseln. Dazu müsste man alle möglichen Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle 2^{56}} (entspricht etwa 72 Billiarden) Schlüssel ausprobieren.

Funktionsweise:

DES arbeitet mit einer Blockgröße von 64-Bit. Allerdings wird jedes achte Bit als Paritätsbit verwendet. Als reale Blockgröße bleiben daher 56-Bit übrig. Der Algorithmus durchläuft insgesamt 16 Runden. Zuerst wird auf den gesamten 64-Bit Block wird eine initiale Substitution durchgeführt und anschließend der Block in zwei 32-Bit Hälfte aufgeteilt. Auf der rechten Hälfte wird die sogenannte Feistel-Funktion angewandt und anschließend mit der linken Hälfte XOR verknüpft. Das Ergebnis wird für die nächste Runde in der rechten Hälfte gespeichert. Die linke Hälfte der nächsten Runde beinhaltet die ursprüngliche rechte Hälfte. So werden alle 16 Runden durchlaufen. Nach der letzten Runde werden die beiden Hälften wieder zusammengeführt und eine finale Substitution durchgeführt. Im Jahr 1994 wurde eine theoretischer Angriff zu DES veröffentlicht, welcher auch 1998 praktisch durch Brute-Force nachgewiesen werden konnte . Dabei wurde DES in wenigen Stunden gebrochen.

3DES stellt eine Weiterentwicklung von DES dar. Bei 3DES wird DES dreimal, allerdings mit unterschiedlichen Schlüsseln durchgeführt.

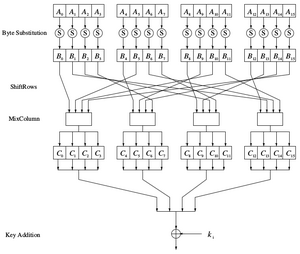

Advanced Encryption Standard

DES wurde im Jahr 2001 durch den Advanced Encryption Standard (AES) durch die NIST abgelöst . Entwickelt wurde AES von den Belgiern Joan Daemon und Vincent Rijmen und wird deswegen auch als Rijndael-Cipher bezeichnet. Die Blockgrößen beziehungsweise Schlüssellängen bei AES sind variabel und voneinander unabhängig. Prinzipiell ist der Algorithmus so entworfen worden, dass die Blockgröße und die Schlüssellänge voneinander unabhängig die Werte 128, 160, 192, 224 oder 256-Bit annehmen können . Bei AES wurde die Blocklänge selbst wird auf 128-Bit beschränkt, die Schlüssellänge hingegen kann 128-, 192- oder 256-Bit lang sein.

| rounds | b(128) | b(192) | b(256) |

|---|---|---|---|

| k(128) | 10 | 12 | 14 |

| k(192) | 12 | 12 | 14 |

| k(256) | 14 | 14 | 14 |

Funktionsweise:

AES basiert auf einem Prinzip, dass als Substitutions-Permutations-Netzwerk (SPN, engl. Substitution Permutation Network) bezeichnet wird . Zuerst werden die einzelnen Blöcke in zweidimensionale Tabellen mit 4 Zeilen geschrieben. Je nach Blockgröße variiert die Anzahl der Spalten von 4 (bei 128-Bit) und 8 (bei 256-Bit). In Runden werden nun Teile des Secret Keys mittels Transformationen auf den Klartextblock angewendet. Die Anzahl der Runden ist wiederum abhängig von der Schlüssellänge und der Blockgröße, siehe Tabelle 1.1. AES hat im Vergleich zu DES weniger Runden, da bei AES in jeder Runde die gesamte unterstützte Blockgröße von 128-Bit verschlüsselt wird. AES besteht aus 3 Schichten, die (mit Ausnahme der letzten, bei welcher MixColumns nicht durchgeführt wird) in jeder Runde angewendet werden.

Die Schichten die pro Runde durchlaufen werden, sind folgende:

- Key-Addition-Layer: Ein Rundenschlüssel mit 128-Bit wird mittels XOR auf die Daten angewendet. Der Rundenschlüssel wird aus dem Hauptschlüssel generiert.

- Byte-Substitution-Layer: Hierbei handelt es sich um eine Substitutions-Box. Dabei wird jedes byte über eine nicht lineare Transformation durch ein anderes ersetzt. Es entsteht dadurch die gewünschte Konfusion.

- Diffusion-Layer: Diese Schicht besteht aus zwei Elementen. Mittels ShiftRow werden die Daten permutiert. Mit MixColumn werden jeweils 4 bytes mittels einer Matrixoperation durchgewürfelt.

Asymmetrische Verfahren

Mitte der 1970er Jahre hatten Whitfield Diffie und Martin Hellman sowie Ralph Merkle unabhängig voneinander die Idee eines asymmetrischen Verfahrens beziehungsweise Public Key Systems . Das Prinzip beruht darauf, dass jeder Kommunikationspartner ein eigenes Schlüsselpaar besitzt, welches sich aus einem privaten und einem öffentlichen Schlüssel zusammensetzt. Der öffentliche Schlüssel kann natürlich öffentlich zugänglich gemacht werden. Der Plaintext wird vom Sender mit dem öffentlich zugänglichen Schlüssel des Empfängers verschlüsselt. Nur der Empfänger selbst ist mit seinem privaten Schlüssel in der Lage den Ciphertext wieder zu entschlüsseln. Die wesentlichen Vorteile und Nachteile von asymmetrischen Verfahren sind :

- Es ist kein aufwendiger Schlüsselaustausch über unsichere Kanäle notwendig. Der öffentliche Schlüssel ist ohnehin nicht geheim. Es muss nur sichergestellt werden, dass der öffentliche Schlüssel auch nur jenem zuzuordnen ist, der auch im Besitz des privaten Schlüssels ist. Siehe dazu auch Kapitel [PGP].

- Bei einem symmetrischen Verfahren musste mit jedem Kommunikationspartner ein eigener Schlüssel vereinbart beziehungsweise ausgetauscht werden. Mittels eines Public Key Verfahrens müssen keine geheimen Schlüssel verwaltet werden. Es ist ausreichend den öffentlichen Schlüssel des Kommunikationspartners zu kennen.

- Asymmetrische Verfahren bieten eine relativ hohe Stufe der Sicherheit. Sie basieren auf einer sogenannten Falltür-Funktion. Diese sind in angemessener Zeit nicht invertierbar, außer man kennt den geheimen Schlüssel. Da es allerdings keinen mathematischen Beweis für Falltür-Funktionen gibt, wäre es aber in der Zukunft theoretisch möglich, dass ein schnelles Verfahren gefunden wird, welches eine Umkehrung ermöglicht.

- Durch die Funktionsweise mit privaten und öffentlichen Schlüsseln bieten diese Verfahren auch die Möglichkeit für digitale Unterschriften beziehungsweise Signaturen, siehe dazu Kapitel [certificates].

- Asymmetrische Verfahren sind durch den hohen Aufwand beim Ver- beziehungsweise Entschlüsseln im Gegensatz zu symmetrischen Verfahren sehr langsam. In der Praxis wird daher oft ein hybrider Ansatz gewählt. Der Schlüsselaustausch erfolgt asymmetrisch, die weitere Kommunikation wird symmetrisch verschlüsselt.

Diffie-Hellman Schlüsselaustausch

Der Diffie-Hellman Schlüsselaustausch (DH) (engl. Diffie Hellman Key Exchange, DHKE) ist ein Protokoll zum Austausch beziehungsweise zur Vereinbarung eines Secret Keys. Das Protokoll adressiert das Problem von symmetrischen Verfahren, dass zuerst ein gemeinsamer Schlüssel ausgetauscht werden muss, siehe Kapitel [symmetrischeVerfahren]. Mit dem DH - Verfahren ist es möglich einen Secret Key zwischen zwei Kommunikationspartnern über einen unsicheren Kanal hinweg auszutauschen. Das Verfahren wurde von 1976 von Diffie und Hellman veröffentlicht. Da auch Ralph Merkle Vorarbeit geleistet hat, wird es auch manchmal als Diffie-Hellman-Merkle Schlüsselaustausch (DHM) bezeichnet

Funktionsweise:

Der Diffie-Hellman Schlüsselaustausch verwendet eine Einweg-Funktion (ohne Falltür), welche auf dem diskreter Exponentialfunktion basiert. Für eine Umkehrung ist der diskrete Logarithmus notwendig, der dieses Problem allerdings nicht in polynomialer Laufzeit (und damit schnell genug) lösen könnte. Die Funktionsweise wird anhand eines Beispiels in Tabelle 1.1 erläutert.

|

|

Alice und Bob haben gemeinsames Wissen über eine Primzahl Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle p=23} |

|

|

|

und eine natürliche Zahl Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle g} , wobei Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle g<p} ist |

|

|

|

|

|

|

|

Alice | Bob |

|

|

|

|

| 1. | Alice sucht sich eine geheime | Bob sucht sich eine geheime |

|

|

zufällige Zahl aus: Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle a=6} |

zufällige Zahl aus: Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle b=5} |

|

|

|

|

| 2. | Alice berechnet A: | Bob berechnet B: |

|

|

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle A = g^a \mod p} | Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle B = g^b \mod p} |

|

|

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle A = 11^6 \mod 23 = 9} | Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle B = 11^5 \mod 23 = 5} |

|

|

|

|

| 3. | Alice übermittelt Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle A = 9} an Bob | Bob übermittelt Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle B=5} an Alice |

|

|

|

|

| 4. | Alice berechnet den secret key: | Bob berechnet den secret key: |

|

|

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle K = B^a \mod p} | Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle K=A^b \mod p} |

|

|

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle K = 5^6 \mod 23 = 8} | Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle K = 9^5 \mod 23 = 8} |

RSA-Verfahren

Nachdem das Konzept zu asymmetrischen Verfahren von Whitfield Diffie und Martin Hellman beziehungsweise Ralph Merkle veröffentlicht wurde, wurde RSA als erstes Verfahren dazu entwickelt. Es wurde von Ronald Rivest, Adi Shamir und Leonard Adleman im Jahr 1978 publiziert. RSA ist mittlerweile defacto Standard und weit verbreitet.

RSA basiert auf dem Faktorisierungsproblem [5] großer natürlicher Zahlen. Es gilt als mathematisch sehr schwierig das Produkt zweier Primzahlen zu faktorisieren. Genau diese Tatsache macht man sich bei RSA zum Vorteil. Ein solches Problem wird auch als Einweg-Funktion mit Falltür oder Falltür-Funktion bezeichnet (engl. Trapdoor One Way Function). Um die Funktionsweise von RSA zu verstehen werden folgende mathematische Grundlagen benötigt:

- Der Modulo Operator beziehungsweise das Rechnen mit Restklassen.

- Die Eulersche Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \varphi} - Funktion einer Zahl Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle N} , welche angibt wie viele natürliche es gibt die kleiner als Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle N} und teilerfremd zu Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle N} sind.

- Der Satz von Euler - Fermat, welcher besagt, dass Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle a^{\varphi(N)} \equiv 1 \mod N}

Funktionsweise:

Die Funktionsweise wird anhand eines Beispiels mit kleinen Zahlen erklärt. Angenommen Bob will Alice eine Nachricht zukommen lassen, wird bei RSA vereinfacht wie folgt vorgegangen:

Alice wählt zwei Primzahlen Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle p} und Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle q} aus und ermittelt deren Produkt Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle n} :

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle n=p*q} Angenommen Alice wählt für Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle p=5} und für Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle q=13} aus, dann ist:

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle n=5*13=65}

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle n} wird auch als RSA-Modul bezeichnet. In der Praxis verwendet man natürlich möglichst große und unterschiedliche Primzahlen.

Alice berechnet für Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle n} die Eulersche Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \varphi} - Funktion mit der Formel:

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \varphi(n) = m = (p-1) * (q-1)} Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle m = (5-1) * (13-1) = 48}Alice sucht sich nun eine zu Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle m} teilerfremde Zahl

Daher der größte gemeinsame Teiler ist 1

a aus, welche größer als 1 ist, daher Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle 1< a < m} . Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle a} wird auch als Verschlüsselungsexponent bezeichnet. In diesem Beispiel wählt Alice Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle a = 7}Die Zahlen Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle n = 65} und Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle a = 7} stellen den öffentlichen Schlüssel von Alice dar. Diese kann sie nun Bob zur Verfügung stellen.

Bob möchte nun eine Nachricht an Alice schicken. Seine Nachricht ist eine Zahl kleiner als Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle n} , daher Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle x = 19} .

Bob verschlüsselt seine Nachricht gemäß der Formel:

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle y = x^a \mod n} Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle y = 19^7 \mod 65} Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle y = 59}Bob sendet seinen ciphertext Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle y = 59} an Alice.

Alice berechnet mit Hilfe des erweiterten euklidischen Algorithmus das modulare Inverse, die Zahl Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle b} :

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle b = a^{-1} \mod m} Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle b = 7^{-1} \mod 48} Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle b= 7}Nun kann Alice die Nachricht von Bob mit dem Satz von Euler entschlüsseln:

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle x = y^b \mod n} Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle x = 59^7 \mod 65} Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle x = 19}

Kennt ein Angreifer nur den öffentlichen Schlüssel bestehend aus den Zahlen Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle n} und Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle a} , müsste dieser aus diesen zwei Zahlen den privaten Schlüssel errechnen. Das einzig bekannte Verfahren zurzeit ist die Primfaktorenzerlegung, mit welchem dies prinzipiell machbar wäre, allerdings nicht in angemessener Zeit. Zu beachten sind bei einer RSA Implementierung allerdings 2 Punkte:

- die Wahl auf entsprechend große Primzahlen Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle p} und Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle q} .

- Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle p} und Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle q} sollen möglichst weit auseinander liegen. Eine sequentielle Suche nach Primzahlen kann auch bei hohen Primzahlen starten und rückwärts laufen. Ein klassischer Ausgangspunkt ist Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \sqrt[]{n}} . Je näher sich die Zahlen Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle p} und Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle q} sind, desto näher befinden sie sich auch bei Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \sqrt[]{n}} und desto kürzer wäre eine systematische Suche nach Primzahlen.

In der Praxis sollte auch sichergestellt werden, dass nach Generierung des RSA Moduls, die Variablen welche Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle p} und Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle q} enthalten, gelöscht werden. Sie werden in der weiteren Berechnung nicht mehr benötigt.

Für RSA beziehungsweise auch andere Verschlüsselungs-Verfahren, welche auf mathematischen Falltür-Funktionen basieren, ist zu beachten, dass es theoretisch auch Gefahren gibt. Zum einen könnte ein Algorithmus entwickelt werden, der ohne große Mühen das Problem der verwendeten Falltür-Funktion löst. Zum anderen auch technische Aspekte, wie die Entwicklung von Quantencomputern, für welche diese mathematischen Probleme wahrscheinlich weniger Aufwand bedeuten.

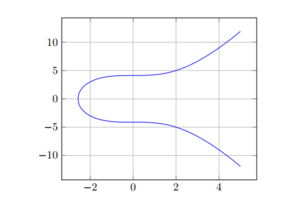

Elliptic Curve Cryptography

Im Bereich der Primfaktorenzerlegung wurden bessere und schnellere Verfahren entwickelt und auch die Hardware wurde schneller. So wurde klar, dass nach alternativen Falltür-Funktionen gesucht werden musste, falls eines Tages eine effiziente Umkehrfunktion gefunden wird. Im Jahr 1985 wurden von Victor Miller und Neil Koblitz unabhängig voneinander Elliptische Kurven über endlichen Körpern vorgeschlagen.

Eine elliptische Kurve ist ein Menge an Punkten die eine spezielle mathematische Funktion erfüllen. Über diese Punkte lässt sich eine additive zyklische Gruppe bilden [6] . Innerhalb dieser Gruppe gelten bestimmte Rechenregeln. Die Verfahren aus dem diskreten Logarithmus lassen sich auf die Punkte einer elliptischen Kurve übertragen. Hier ist die nicht umkehrbare Funktion allerdings die Division eines Punktes.

Bei wesentlich kürzeren Operanden und Schlüsseln bietet ECC die gleiche Sicherheit wie bei Verfahren welche auf dem diskreten Logarithmus oder RSA beruhen . Als Vergleich, ein Verfahren mit 1024 bis 3072-Bit basierend auf dem diskreten Logarithmus oder RSA ist äquivalent mit ECC von 160 bis 256-Bit.

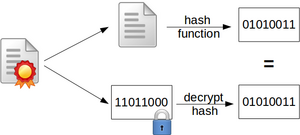

Hash - Verfahren

Mit Hash - Verfahren ist es möglich die Integrität von Daten zu überprüfen . Eine große Anzahl an Eingabe - Zeichen (engl. Message) wird dabei auf eine fixe Anzahl an Ausgabe - Zeichen, dem Hashwert (engl. Message Digest) abgebildet. Daher ist eine Hash - Funktion eine nicht injektive Abbildung. Eine wichtige Voraussetzung ist, dass Hashwerte schnell und einfach zu berechnen sind, damit diese auch auf embedded devices lauffähig sind. Außerdem soll eine einige Änderung an einem Dokument eine größtmögliche Auswirkung auf den Hashwert haben, wie in Tabelle 1.1 ersichtlich.

| Eingabe | md5sum |

|---|---|

| das ist ein test | babcdad51f89050112c127e206cddc3e |

| das ist ein test! | 0c4fff19d6bd9dff8d43c8d113b80a1c |

Anwendungsbereiche von Hash - Verfahren sind sehr vielfältig:

- Überprüfung der Datenintegrität anhand eines Fingerabdrucks (sogenannte Prüfsummen)

- Überprüfung der Authentizität des Datenursprungs

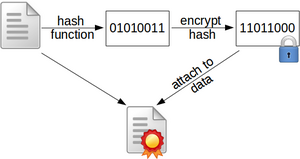

- digitale Signaturen

- digitale Zertifikate

- Abbildung von Passwörtern

- Such- und Zugriffsverfahren im Datenbankumfeld

- Memory Adressierungs-Funktionen im Betriebssystem

- Versionskontrollsysteme

- Anti-Virus Signaturen, ..

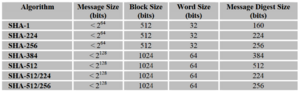

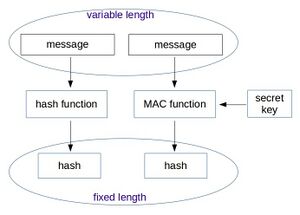

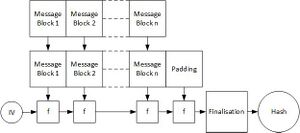

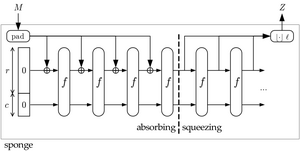

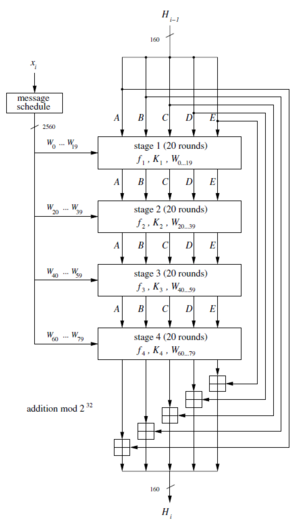

Hash - Verfahren können in zwei generelle Klassen unterteilt werden, siehe dazu auch Abbildung 1.1:

- Schlüssellose Hash - Verfahren (engl. Hash Functions): Hierbei handelt es sich um jene Verfahren, welche rein die Überprüfung der Datenintegrität ermöglichen. Beispiele dafür sind in den nachfolgenden Kapitel 1.4 und 1.3 dargelegt.

- Schlüsselabhängige Hash - Verfahren (engl. Message Authentication Codes beziehungsweise Keyed Hash Functions): Bei Message Authentication Codes (MAC) wird ein zusätzlicher Secret Key in den Algorithmus eingefügt. Damit ist es möglich neben der Integrität der Daten auch die Authentizität des Absenders zu überprüfen. Siehe dazu auch das Kapitel 1.5

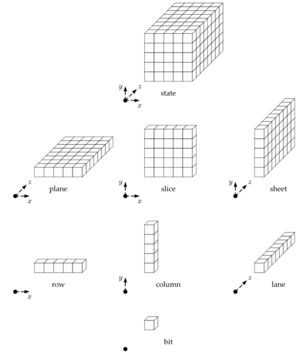

Anforderungen an kryptographische Hash - Verfahren

Es muss zwischen herkömmlichenund kryptographischen Hash - Verfahren unterschieden werden. Herkömmliche Hash - Verfahren sind kryptographisch nicht sicher und werden in Anwendungsgebieten verwendet in denen diese Sicherheit auch nicht erforderlich ist. Diese sind zum Beispiel, CRC Überprüfungen (Cyclic Redundancy Check), Kompressionsfunktionen, Caches, Hash Tabellen, etc.. Hingegen haben kryptographische Hash - Verfahren folgende Anforderungen an die Sicherheit :