Maschinelles Lernen Vorwort

Vorwort

Der Stand der Forschung im Bereich der künstlichen Intelligenz (AI) ist dynamisch und entwickelt sich ständig weiter. Es gibt viele Argumente sowohl für als auch gegen die Anwendung von AI in verschiedenen Bereichen. In der Folge werden einge dieser Argumente diskutiert, die für oder gegen den Einsatz und die Nutzung von künstlicher Intelligenz sprechen. Der Begriff AI bezieht sich auf ein breites Spektrum von Technologien und Anwendungen, beginnend bei spezialisierten Systemen bis hin zu hypothetischen, allgemeinen Intelligenzen. In der Praxis sind die meisten AI-Anwendungen jedoch auf spezifische Aufgaben oder Aufgabenbereiche ausgerichtet. Die Entwicklung von starken KI-Systemen, die auch in der Lage sind ein breiteres Spektrum von Aufgaben zu bewältigen, ist ein langfristiges Ziel in der KI-Forschung und -Entwicklung.

Aus der Sicht von heute (2023) spricht für die Nutzung von AI:

Die Effizienz und Automatisierung: AI kann dazu beitragen, Prozesse und Aufgaben in vielen Bereichen zu automatisieren, was zu erhöhter Effizienz und Produktivität führt, zum Beispiel in der Fertigungsindustrie, im Gesundheitswesen und im Kundenservice.

Die Verbesserung der Genauigkeit: AI-Systeme können komplexe Datenanalysen durchführen und Muster erkennen, die für menschliche Analysten schwer zu erkennen sind. Dies kann die Qualität von Vorhersagen und Entscheidungen verbessern.

Die Skalierbarkeit: AI kann problemlos auf große Datenmengen skalieren und gleichzeitig konsistente Leistung erbringen. Dies ist besonders nützlich in Big-Data-Anwendungen.

Die schnelle Innovation: AI treibt Innovationen in verschiedenen Branchen voran, von autonomem Fahren bis zur medizinischen Diagnose. Neue Anwendungen und Technologien entstehen kontinuierlich.

Die Personalisierung: AI kann personalisierte Erfahrungen und Empfehlungen liefern, sei es in der Werbung, im E-Commerce oder im Gesundheitswesen, indem es das Verhalten und die Vorlieben von Nutzern analysiert.

Als Gegen-Argumente gelten:

Mögliche Arbeitsplatzverluste: Die Automatisierung durch AI kann zu Arbeitsplatzverlusten in vielen Branchen führen, was soziale und wirtschaftliche Auswirkungen haben kann.

Bias und Diskriminierung: AI-Modelle können Vorurteile aufgrund von ungleichen oder voreingenommenen Trainingsdaten aufweisen und dazu führen, dass bestimmte Gruppen benachteiligt werden.

Datenschutz und Sicherheit: Die Verwendung von AI zur Sammlung und Analyse von Daten wirft Datenschutz- und Sicherheitsfragen auf. Missbrauch von AI-Systemen oder Datenlecks können erhebliche Folgen haben.

Der Mangel an Transparenz: In vielen Fällen sind AI-Modelle „Black Boxes“, deren Entscheidungsprozesse schwer oder sogar gar nicht nachvollziehbar sind, was das Vertrauen in ihre Ergebnisse beeinträchtigen kann.

Ethische Bedenken: Die Entwicklung von AI-Systemen, die moralisch und ethisch akzeptabel sind, stellt eine Herausforderung dar. Fragen der Verantwortlichkeit und der Kontrolle über autonom handelnde Systeme sind noch nicht vollständig geklärt.

Bei der Entwicklung und der Nutzung von AI ist es deshalb besonders wichtig zu beachten, dass die Anwendung von AI stark von der spezifischen Anwendung und den Rahmenbedingungen abhängt. Es gibt Bereiche, in denen AI bereits einen erheblichen Nutzen bringt, und andere, in denen noch viel Forschung und Diskussion erforderlich ist, um die Herausforderungen zu bewältigen. Die Zukunft der AI wird wahrscheinlich von der Fähigkeit der Gesellschaft abhängen, die Vorteile zu nutzen und gleichzeitig die Risiken und Herausforderungen angemessen anzugehen.

Vorbemerkungen

Man kann sagen, dass Künstliche Intelligenz (AI) in erster Linie auf mathematischen Prinzipien und Algorithmen basiert, und daher hat Mathematik eine zentrale Rolle in der Entwicklung und Anwendung von AI. Aus der Mathematik werden die Teildisziplinen Statistik und Wahrscheinlichkeit benötigt, weil viele AI-Techniken, einschließlich maschinelles Lernen und neuronale Netzwerke, statistische Modelle und Wahrscheinlichkeitstheorie dazu verwenden, um Muster in Daten zu erkennen und Vorhersagen zu treffen.Die Optimierung wird benötigt, um Modelle zu trainieren und Parameter anzupassen, um die Leistung zu maximieren oder Fehler zu minimieren. Die Linearen Algebra spielt eine Schlüsselrolle bei der Verarbeitung von Vektoren und Matrizen, die in vielen AI-Anwendungen, einschließlich neuronaler Netzwerke, verwendet werden. Auch Differentialgleichungen weden in in einigen AI-Anwendungen, insbesondere in der Robotik und in autonomen Systemen verwendet, um die Bewegung und das Verhalten von Systemen zu modellieren. Die Informationstheorie liefert wichtige Konzepte zur Messung von Unsicherheit, Entropie und Informationsgewinn, die in der Entscheidungsfindung und im maschinellen Lernen eine Rolle spielen.Die Entwicklung von AI-Algorithmen erfordert oft mathematische Analyse und Beweise zur Gewährleistung der Korrektheit und Effizienz dieser Algorithmen

Obwohl Mathematik eine zentrale Rolle in der AI spielt, ist AI selbst ein interdisziplinäres Feld, das auch Erkenntnisse aus Bereichen wie Informatik, Psychologie, Linguistik und Ingenieurwissenschaften integriert. Mathematik dient als Werkzeug zur Formalisierung von Problemen, zur Modellierung von Daten und zur Entwicklung von Algorithmen, die in AI-Anwendungen eingesetzt werden.

Begriff „Modell“

Im Allgemeinen bezieht sich der Begriff "Modell" auf eine vereinfachte Darstellung oder Repräsentation eines realen Systems. Modelle werden verwendet, um komplexe Phänomene zu erklären, vorherzusagen oder zu simulieren, indem sie wichtige Merkmale oder Aspekte eines Systems erfassen, während sie unwichtige Details vereinfacht oder vernachlässigt. Modelle können in verschiedenen Bereichen und Kontexten eingesetzt werden, von der Wissenschaft über die Ingenieurwissenschaften bis zur künstlichen Intelligenz (AI).

Im Zusammenhang mit AI und maschinellem Lernen bezieht sich der Modellbegriff auf die zentralen Bausteine eines Systems, das Daten analysiert, Muster erkennt und Vorhersagen trifft. Solche Modelle werden mit Hilfe der höheren Mathematik in Formeln gefasst und beschrieben. In diesem Text wird auf mathematische Zusammenhänge nicht im Detail eingegangen. Folgende Aspekte des Modellbegriffs in der AI werden für das Verständnis benötigt:

Repräsentation von Wissen: In der AI können Modelle verwendet werden, um Wissen oder Informationen zu repräsentieren. Zum Beispiel können Modelle in der natürlichen Sprachverarbeitung dazu verwendet werden, Wörter, Sätze oder Dokumente als Vektoren zu repräsentieren, um semantische Beziehungen zwischen Wörtern zu erfassen.

Abstraktion: Modelle abstrahieren komplexe Daten und Muster in einer Weise, die für maschinelle Algorithmen zugänglich ist. Dies kann dazu beitragen, die Dimensionalität von Daten zu reduzieren und die Analyse zu erleichtern.

Vorhersage und Entscheidungsfindung: AI-Modelle werden verwendet, um Vorhersagen über zukünftige Ereignisse oder Entscheidungen zu treffen. Zum Beispiel können neuronale Netzwerke in der Bildverarbeitung dazu verwendet werden, Bilder zu klassifizieren oder zu erkennen.

Lernen: In maschinellem Lernen und tiefem Lernen werden Modelle trainiert, indem sie auf Trainingsdaten präsentiert werden. Sie passen ihre internen Parameter an, um Muster in den Daten zu erkennen und darauf zu reagieren. Das Ergebnis ist ein „trainiertes Modell“, das zur Vorhersage oder Klassifikation von neuen Daten verwendet werden kann.

Generalisierung: Ein gutes AI-Modell sollte in der Lage sein, auf unbekannte Daten zu generalisieren, d.h. es sollte nicht nur die Trainingsdaten auswendig lernen, sondern auch auf neue Daten gut reagieren.

Optimierung: Modelle können optimiert werden, um ihre Leistung zu verbessern. Dies kann die Anpassung der Modellparameter oder die Auswahl geeigneter Hyperparameter umfassen.

Insgesamt ist ein Modell in der AI ein abstraktes Konzept oder eine mathematische Struktur, die dazu verwendet wird, Daten zu analysieren, Muster zu lernen, Vorhersagen zu treffen und letztendlich komplexe Aufgaben zu automatisieren. Die Entwicklung und Verfeinerung von AI-Modellen ist ein wichtiger Schwerpunkt in der Forschung und Anwendung der künstlichen Intelligenz.

Was sind Neuronen

Elemente der neuronalen Netze sind die Neuronen. Ein Neuron in einem neuronalen Netzwerk ist eine grundlegende Einheit, die Informationen verarbeitet. Neuronen der AI sind inspiriert von den Neuronen im menschlichen Gehirn, aber in diesem Kontext handelt es sich um mathematische Funktionen, die dazu dienen, Informationen durch das Netzwerk zu übertragen, zu verarbeiten und zu transformieren.

Ein Neuron in einem neuronalen Netzwerk nimmt Eingaben (Daten) auf, führt eine Berechnung durch und gibt eine Ausgabe weiter. Die Eingaben werden mit Gewichtungen multipliziert, um ihre Bedeutung zu steuern. Dann wird eine Aktivierungsfunktion angewendet, um die Ausgabe des Neurons zu erzeugen. Dieser Prozess wiederholt sich für viele Neuronen im Netzwerk, wobei die Ausgaben von einem Neuron zu den Eingängen anderer Neuronen weitergeleitet werden, um komplexe Berechnungen durchzuführen.

Die Verbindungen zwischen den Neuronen und die Gewichtungen spielen eine entscheidende Rolle bei der Bestimmung, wie Informationen im Netzwerk fließen und wie Muster erlernt werden. Die Aktivierungsfunktion sorgt dafür, dass Neuronen auf bestimmte Muster oder Merkmale in den Daten reagieren.

<Eingabedaten> → <Neuron + Aktivierungsfunktion> → <Ausgabedaten>

Eingaben sind die Daten, die dem Neuron zugeführt werden. Die Linien, die von den Eingaben zu jedem Neuron führen, repräsentieren die Gewichtungen, die auf die Eingaben angewendet werden. Im Neuron selbst findet die Berechnung statt, indem die gewichteten Eingaben zusammengefasst und dann darauf eine Aktivierungsfunktion angewendet wird. Die Ausgabe des Neurons wird dann an andere Neuronen oder Schichten im neuronalen Netzwerk weitergegeben.

Die grundlegende Funktion eines Neurons in einem neuronalen Netzwerk ist recht einfach. Jeder Eingang in ein Neuron wird gewichtet. Diese Gewichte sind das „Wissen“ eines Neurons, das im Training „angelernt“ wurde. In einem realen neuronalen Netzwerk gibt es viele Neuronen, die miteinander verbunden sind, um komplexe Berechnungen durchzuführen und Muster in den Daten zu erkennen. Eine solche Darstellung wird umso komplexer, je größer und tiefer das neuronale Netzwerk ist.

Damit kann ein Neuron in einem neuronalen Netzwerk mathematisch durch eine Formel oder eine Gleichung dargestellt werden. Ein Neuron erhält je nach seiner Größe n Eingaben (x1, x2, ..., xn), multipliziert diese Eingaben mit Gewichtungen (w1, w2, ..., wn), summiert die gewichteten Eingaben und wendet dann eine Aktivierungsfunktion auf die resultierende Summe an. Die Ausgabe des Neurons (y) wird durch die Formel beschrieben:

y = Aktivierungsfunktion∙(w1∙x1 + w2∙x2 + ... + wn∙xn + b)

In dieser Formel bedeuten:

- x1, x2, ..., xn: Die Eingaben (Input-Werte) für das Neuron.

- w1, w2, ..., wn: Die Gewichtungen, die den einzelnen Eingaben zugeordnet sind.

- b: Ein Bias-Term, der die Verschiebung oder den Schwellenwert des Neurons steuert.

- Aktivierungsfunktion: Eine mathematische Funktion, die auf die gewichtete Summe der Eingaben und des Biases angewendet wird, um die Ausgabe des Neurons zu erzeugen.

Neuronales Netzwerk

Mit dieser Beschreibung der Neuronen ist ein neuronales Netzwerk als eine Ansammlung von Neuronen, die in Schichten organisiert sind, zu verstehen. Jedes Neuron in einem neuronalen Netzwerk verarbeitet Informationen und führt Berechnungen durch. Es folgt eine Beschreibung eines einfachen neuronalen Netzwerks:

Eingabeschicht (Input Layer): Die Eingabeschicht ist die erste Schicht des neuronalen Netzwerks. Hier werden die Rohdaten oder Features eingegeben, die das Netzwerk verarbeiten soll. Jedes Neuron in dieser Schicht entspricht einem einzelnen Feature oder einer Dimension der Eingabedaten.

Verdeckte Schichten (Hidden Layers): Nach der Eingabeschicht können eine oder mehrere verdeckte Schichten folgen. In diesen Schichten sind die Neuronen miteinander verbunden. Jedes Neuron in einer verdeckten Schicht empfängt Informationen von allen Neuronen in der vorherigen Schicht. Diese Schichten sind für die Verarbeitung und Extraktion von Merkmalen aus den Eingabedaten verantwortlich. Die Gewichtungen und Aktivierungsfunktionen in diesen Neuronen ermöglichen es dem Netzwerk, komplexe Muster in den Daten zu erkennen.

Ausgabeschicht (Output Layer): Die Ausgabeschicht ist die letzte Schicht des neuronalen Netzwerks. Sie erzeugt die endgültige Ausgabe des Netzwerks, die je nach Anwendung variieren kann. Die Anzahl der Neuronen in dieser Schicht hängt von der Art der Aufgabe ab. Zum Beispiel könnte es in einem Klassifikationsproblem eine Ausgabe pro Klasse geben, während es in einer Regressionsaufgabe nur eine Ausgabe geben könnte.

Die Verbindungen zwischen den Neuronen in benachbarten Schichten werden durch Gewichtungen repräsentiert, die während des Trainingsprozesses angepasst werden, um das Netzwerk auf eine spezifische Aufgabe anzupassen. Während der Berechnung durchläuft ein Datenelement das Netzwerk von der Eingabeschicht bis zur Ausgabeschicht, wobei die Neuronen in jeder Schicht ihre Berechnungen durchführen.

Das Training eines neuronalen Netzwerks besteht darin, die Gewichtungen der Verbindungen zwischen den Neuronen derart anzupassen, dass das Netzwerk die gewünschte Aufgabe, wie zum Beispiel Klassifikation oder Vorhersage, optimal ausführt. Dies erfolgt in der Regel durch Verwendung von Trainingsdaten und einem Optimierungsalgorithmus.

Beispiel eines einfachen neuronalen Netzes

Die Programmstruktur für ein neuronales Netzwerk hängt stark von der verwendeten Deep-Learning-Bibliothek

Ein Deep-Learning-Modell oder Netzwerk wird in der Regel dann als „tief“ bezeichnet, wenn es aus mehreren Schichten (auch als Schichten oder Ebenen bezeichnet) von Neuronen oder Knoten besteht. Diese Schichten können als Stapel oder Hierarchie von Verarbeitungsebenen betrachtet werden, wobei jede Schicht Informationen auf verschiedene Weisen verarbeitet und abstrahiert. Typischerweise besteht ein tiefes neuronales Netzwerk (Deep Neural Network oder DNN) aus mindestens drei Schichten: der Eingabeschicht (Input Layer), (mehrere) Verdeckte Schichten (Hidden Layers) und der Ausgabeschicht (Output Layer).

Je mehr solcher Schichten vorhanden sind, desto „tiefer“ ist das Netzwerk.

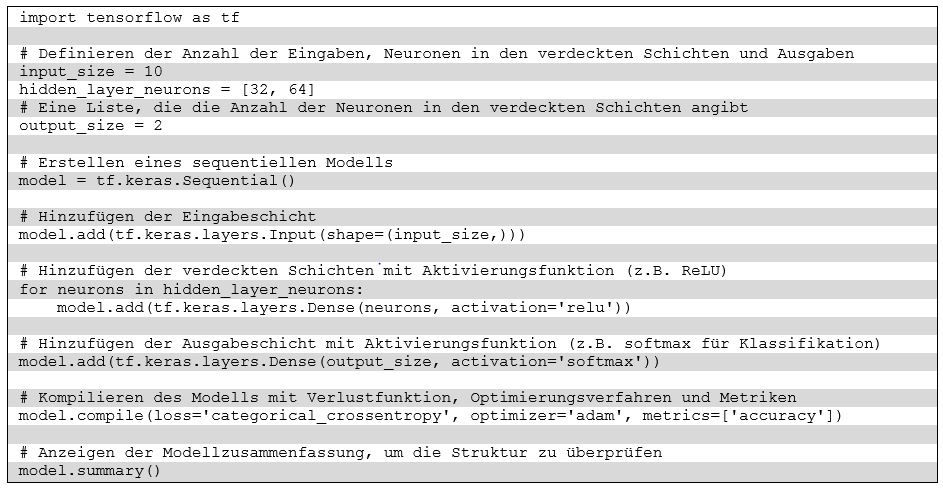

oder dem Framework ab. Diese Bibliotheken bieten bereits viele Funktionen und Abstraktionen, um den Aufbau und das Training von neuronalen Netzen zu erleichtern. Eine einfache beispielhafte Struktur in Python mit der beliebten Deep-Learning-Bibliothek TensorFlow kann mit wenigen Befehlszeilen wie folgt codiert werden:

Die Kommentierungen erleichtern die Lesbarkeit. In diesem Code-Beispiel wird in Python ein sequenzielles Modell mit einer Eingabeschicht, verdeckten Schichten (hier 2 Schichten) und einer Ausgabeschicht erstellt. Die Anzahl der Eingaben, Neuronen in den verdeckten Schichten und Ausgaben wird zu Beginn festgelegt. Die Aktivierungsfunktionen für die verdeckten Schichten und die Ausgabeschicht können je nach Aufgabe ausgewählt werden.

Die Struktur des Modells wird schichtweise definiert, und die compile-Methode wird verwendet, um das Modell für das Training vorzubereiten. Dabei werden die Verlustfunktion, das Optimierungsverfahren und Metriken festgelegt. Um es von Anfang an klar zu stellen: die compile-Methode ist eine in diesem Codebeispiel implementierte Methode. Der Programmcode von Python selbst wird nicht kompiliert, sondern zur Laufzeit Befehl für Befehl interpretiert.

Diese Beispielstruktur ist sehr einfach. In der Praxis wird eine Struktur für ein neuronales Netzwerk je nach seiner speziellen Aufgabe und den zur Verfügung stehenden Daten angepasst. Im Beispiel wird die TensorFlow-Bibliothek verwendet. Andere Deep-Learning-Frameworks wie PyTorch oder Keras bieten ähnliche Ansätze zur Definition von Netzwerkstrukturen.

Das im Beispiel gezeigten neuronalen Netzwerk hat insgesamt drei Schichten: eine Eingabeschicht, zwei verdeckte Schichten und eine Ausgabeschicht. Die Anzahl der Neuronen in den verdeckten Schichten beträgt 32 und 64.

hidden_layer_neurons = [32, 64]

Die Eingabeschicht benötigt so viele Neuronen, wie es Eingabevariablen gibt

input_size = 10

Die Ausgabeschicht hat hier nur 2 Neuronen, womit die Anzahl der Ausgaben festgelegt werden.

output_size = 2

Damit lässt sich die Anzahl der zu trainierenden Parameter berechnen. Die Anzahl der Parameter in einem neuronalen Netzwerk hängt von den Gewichtungen (oder Koeffizienten) zwischen den Neuronen ab.

Gewichtungen zwischen Eingabe- und erster verdeckter Schicht:

Für jede Eingabe gibt es 32 Gewichtungen (eine pro Neuron in der ersten verdeckten Schicht).

Das ergibt: 10 Eingaben ∙ 32 Neuronen = 320 Gewichtungen.

Gewichtungen zwischen erster und zweiter verdeckter Schicht:

Für jedes Neuron in der ersten verdeckten Schicht gibt es 64 Gewichtungen (eine pro Neuron in der zweiten verdeckten Schicht).

Das ergibt: 32 Neuronen ∙ 64 Neuronen = 2048 Gewichtungen.

Gewichtungen zwischen der zweiten verdeckten Schicht und der Ausgabeschicht:

Für jedes Neuron in der zweiten verdeckten Schicht gibt es 2 Gewichtungen (eine pro Neuron in der Ausgabeschicht).

Das ergibt: 64 Neuronen ∙ 2 Ausgabeneuronen = 128 Gewichtungen.

Zusammen gibt es also 320 + 2048 + 128 = 2496 Gewichtungen, die trainiert werden müssen.

Zu beachten ist, dass diese Berechnung nur die Anzahl der Gewichtungen betrachtet. Die Anzahl der zu trainierenden Parameter kann je nach Modell und den verwendeten Schichten variieren, da zusätzliche Parameter wie Bias-Terme und die spezifische Aktivierungsfunktion auch berücksichtigt werden müssen. Der hier ermittelte Wert dient als Anhaltspunkt für die Größenordnung der Parameter in diesem „Mini“-Netzwerk. Bemerkung: Allgemein sieht man bereits in diesem einfachen Beispiel, dass ohne größeren Aufwand ein neuronales Netzwerk mit einer höheren Anzahl von Neuronen nur durch das durch Verändern von Zahlenwerten an Erfordernisse von Aufgabenstellungen angepasst werden kann.

Netzwerkarchitektur

In Zusammenhang mit neuronalen Netzwerken wird von einer „Netzwerkarchitektur“ gesprochen. Der Begriff Netzwerkarchitektur bezieht sich dabei auf die spezifische Struktur und Organisation eines künstlichen neuronalen Netzes. Die Architektur bestimmt, wie die Neuronen oder Knoten im Netzwerk miteinander verbunden sind, wie die Informationen durch das Netzwerk fließen und wie die Parameter des Netzwerks während des Trainings angepasst werden. Die Wahl der richtigen Netzwerkarchitektur ist entscheidend für die Leistung eines Modells bei einer bestimmten Aufgabe.

Lernen bzw. Training

Das Lernen oder Training eines neuronalen Netzwerks (NN) ist der Prozess, bei dem das Netzwerk seine Gewichtungen und Bias-Terme anpasst, um aus den Trainingsdaten Muster und Zusammenhänge zu erlernen. Dieser Prozess ermöglicht es dem NN, seine Leistung bei der Lösung einer spezifischen Aufgabe zu verbessern.

Normalerweise läuft das Training eines neuronalen Netzwerks schrittweise wie folgt ab:

- Initialisierung: Zu Beginn werden die Gewichtungen und Bias-Terme im NN zufällig oder mit bestimmten Startwerten initialisiert. Diese Parameter sind wichtig, da sie die Transformation von Eingabedaten in Ausgaben steuern.

- Vorwärtsdurchlauf (Forward Pass): Während des Trainingsprozesses wird jeder Datensatz aus dem Trainingsdatensatz durch das neuronale Netzwerk geleitet. Dies erfolgt durch Berechnungen von Neuronen in den Schichten des Netzwerks von der Eingabeschicht bis zur Ausgabeschicht. Die Berechnungen erfolgen mithilfe der Gewichtungen und Bias-Terme.

- Berechnung des Fehlers: Nachdem das neuronale Netzwerk eine Vorhersage für einen Datensatz gemacht hat, wird der Fehler oder Verlust (Loss) zwischen der Vorhersage und dem tatsächlichen Wert berechnet. Dieser Fehler dient als Maß dafür, wie gut oder schlecht das Netzwerk in Bezug auf die Aufgabe abgeschnitten hat.

- Rückwärtsdurchlauf (Backward Pass) und Gradientenabstieg: Der Hauptteil des Trainingsprozesses besteht darin, die Gewichtungen und Bias-Terme so anzupassen, dass der Fehler minimiert wird. Dies geschieht mithilfe des Gradientenabstiegsverfahrens. Der Gradient des Fehlers in Bezug auf die Gewichtungen und Bias-Terme wird berechnet. Dieser Gradient gibt an, wie sich der Fehler ändert, wenn die Gewichtungen und Bias-Terme leicht verändert werden.

- Aktualisierung der Gewichtungen: Basierend auf dem Gradienten werden die Gewichtungen und Bias-Terme angepasst, um den Fehler zu verringern. Dies erfolgt durch Multiplikation des Gradienten mit einer Lernrate (Learning Rate) und Subtraktion des Ergebnisses von aktuellen Gewichtungen und Bias-Termen. Die Lernrate steuert, wie groß die Schritte bei den Anpassungen sind.

- Wiederholung: Die Schritte 2 bis 5 werden für jeden Datensatz im Trainingsdatensatz durchgeführt. Dieser Prozess wird über mehrere Epochen wiederholt, wobei ein Durchlauf durch den gesamten Trainingsdatensatz eine Epoche darstellt. Während des Trainings passt sich das neuronale Netzwerk allmählich an die Trainingsdaten an und minimiert den Fehler.

- Validierung und Test: Nach dem Training wird das neuronale Netzwerk normalerweise auf einem separaten Validierungsdatensatz getestet, um sicherzustellen, dass es nicht überangepasst (Overfitting) ist und in der Lage ist, allgemeine Muster zu erkennen. Schließlich wird es auf einem Testdatensatz ausgewertet, um seine Leistung auf neuen, unbekannten Daten zu bewerten.

Der Trainingsprozess kann je nach Netzwerkarchitektur, Aufgabe und Datenmenge lange dauern und erfordert oft die Feinabstimmung von Hyperparametern wie der Lernrate, der Batch-Größe und der Anzahl der Epochen. Das Ziel des Trainings besteht darin, ein neuronales Netzwerk zu erstellen, das in der Lage ist, Muster in den Daten zu generalisieren und nützliche Vorhersagen für neue, nicht bekannte Daten zu treffen.

Wie denkt ein neuronales Netzwerk eigentlich?

Ein neuronales Netzwerk denkt nicht im menschlichen Sinn, da es über keine bewussten Gedanken, Intentionen oder ein Bewusstsein verfügt. Stattdessen ist ein neuronales Netzwerk ein mathematisches Modell, das auf statistischen Berechnungen und Algorithmen basiert und dazu verwendet wird, Muster und Zusammenhänge in Daten zu erkennen und Aufgaben wie Klassifikation, Vorhersage oder Mustererkennung auszuführen.

Der Denkvorgang also die Funktionsweise eines neuronalen Netzwerks kann am besten als maschinelles Lernen oder Mustererkennung beschrieben werden:

- Verarbeitung von Eingabedaten: Ein neuronales Netzwerk nimmt Eingabedaten auf, die in Form von Zahlen oder Merkmalen vorliegen. Diese Eingabedaten werden durch das Netzwerk geleitet und von den Neuronen und Gewichtungen in den Schichten verarbeitet.

- Mustererkennung: Das Netzwerk passt seine Gewichtungen und Bias-Terme während des Trainingsprozesses an, um Muster und Zusammenhänge in den Eingabedaten zu erkennen. Diese Mustererkennung erfolgt aufgrund von mathematischen Operationen, die in den Neuronen und Schichten des Netzwerks stattfinden.

- Vorhersage oder Klassifikation: Nachdem das Netzwerk trainiert wurde, kann es verwendet werden, um Vorhersagen oder Klassifikationen für neue, unbekannte Daten zu treffen. Es wendet die gelernten Muster auf diese Daten an und generiert daraus eine Ausgabe, die je nach Aufgabe interpretiert werden kann. Zum Beispiel kann es Vorhersagen über zukünftige Werte treffen, Objekte in Bildern erkennen oder Texte übersetzen.

- Mathematische Berechnungen: Die „Gedanken“ oder „Entscheidungen“ eines neuronalen Netzwerks sind tatsächlich mathematische Berechnungen. Jedes Neuron führt eine mathematische Operation durch, indem es seine Eingaben gewichtet, summiert und dann eine Aktivierungsfunktion auf das Ergebnis anwendet. Diese Berechnungen erfolgen aufgrund der Parameter (Gewichtungen und Bias-Terme), die während des Trainings angepasst wurden.

Ein neuronales Netzwerk „denkt“, indem es mathematische Operationen auf Eingabedaten ausführt und Muster erkennt, die es in den Trainingsdaten gelernt hat. Es handelt sich jedoch um eine rein algorithmische Verarbeitung von Informationen, die auf mathematischen Grundlagen beruht und nicht mit menschlichem Denken oder Bewusstsein vergleichbar ist. Es ist ein Werkzeug, das zur Automatisierung von Aufgaben und zur Lösung von komplexen Problemen in großen Datensätzen eingesetzt wird.

Ablauf zun Erstellen einer KI-Lösung

Der Ablauf zur Erstellung einer KI-Lösung für eine Aufgabe folgt oft einem ähnlichen allgemeinen Muster. In der Folge ein grobes Schema. Die genauen Schritte können je nach Aufgabe und Umgebung variieren. Der Prozess oft iterativ und nicht selten müssen mehrere Iterationen durchlaufen werden, um die Leistung eines Modells kontinuierlich zu verbessern.

Zur Übersicht ein typischer Ablauf:

- Problemverständnis: Zuerst muss das Problem vollständig verstanden werden. Welche Art von Aufgabe? Welche Art von Daten stehen zur Verfügung? Welche Erfolgskriterien und Leistungsindikatoren sind wichtig?

- Datensammlung: Sammeln der benötigten Daten für die spezifizierte Aufgabe. Benötigt werden Rohdaten, das Erstellen von Datensätzen oder das Zugreifen auf vorhandene Datenbanken oder Datensätze.

- Datenbereinigung und -vorbereitung: Die Daten müssen bereinigt und formatiert sein, um sicherzustellen, dass sie für das Modelltraining geeignet sind. Das kann erfordern, aus den Daten Ausreißern zu entfernen, fehlende Werte aufzufüllen und Merkmalen zu skalieren.

- Feature Engineering: Wenn nötig, können Merkmale aus den Rohdaten extrahiert oder transformiert werden, um das Modell bei der Mustererkennung zu unterstützen.

- Datenaufteilung: Teilen der Daten in Trainingsdaten, Validierungsdaten und Testdaten. Die Trainingsdaten werden verwendet, um das Modell zu trainieren, die Validierungsdaten zur Modellauswahl und Hyperparameter-Tuning, und die Testdaten zur Evaluierung der endgültigen Modellleistung.

- Modellarchitektur festlegen: Auswahl einer geeigneten Netzwerkarchitektur oder eines Modells für die Aufgabe, z.B. Convolutional Neural Networks für Bildverarbeitung, Recurrent Neural Networks für Textverarbeitung oder andere Architekturen. Genaueres dazu wird in den folgenden Kapiteln behandelt.

- Modelltraining: Training des Modells mit den Trainingsdaten. Das beinhaltet das Anpassen der Modellparameter, um die vorhergesagten Ergebnisse den tatsächlichen Ergebnissen anzunähern.

- Modellvalidierung und -optimierung: Verwendung der Validierungsdaten, um die Modellleistung zu überwachen und gegebenenfalls Hyperparameter anzupassen oder die Architektur abzuändern, um die Leistung zu optimieren.

- Modellbewertung: Mittels der Testdaten wird die endgültige Leistung des Modells bewertet. Metriken wie Genauigkeit, Präzision, Rückruf, F1-Score oder andere relevante Bewertungskriterien werden dazu eingesetzt.

- Bereitstellung und Inbetriebnahme: Wenn das Modell zufriedenstellende Ergebnisse erzielt, kann es in eine Produktionsumgebung integriert werden, damit es in Echtzeit verwendet werden kann.

- Überwachung und Wartung: Nach der Bereitstellung muss das Modell überwacht und gegebenenfalls gewartet werden. Das kann durch die Aktualisierung des Modells mit neuen Daten erfolgen oder eine Anpassung an sich ändernde Anforderungen erfordern.

- Skalierung: Wenn das Modell erfolgreich ist und die Nachfrage steigt, muss gegebenenfalls auch die Infrastruktur skaliert werden, um die steigende Nutzerzahl zu unterstützen.

Was begründet nun das Wissen und die Fähigkeiten einer AI?

Man kann mit Recht behaupten, dass die trainierten Gewichte eines neuronalen Netzwerks zusammen mit seiner Architektur das Wissen und die Fähigkeiten des neuronalen Netzwerks repräsentieren. In der Welt des maschinellen Lernens und der künstlichen Intelligenz wird oft gesagt, dass das Modell sein „Wissen“ aus den Trainingsdaten lernt, indem es die Gewichte in den Neuronen und Verbindungen anpasst.

Genauer erläutert gilt für die Architektur des neuronalen Netzwerks, dass diese festlegt, wie die Neuronen miteinander verbunden sind, wie die Schichten angeordnet sind und welche Aktivierungsfunktionen verwendet werden. Es wird durch die Architektur bestimmt, wie das Netzwerk Informationen verarbeitet und durch die verschiedenen Schichten fließen lässt.

Die trainierten Gewichte in einem neuronalen Netzwerk sind jene Parameter, die während des Trainingsprozesses angepasst werden, um die Leistung des Modells auf den Trainingsdaten zu verbessern. Diese Gewichte bestimmen, wie stark die Signale zwischen den Neuronen gewichtet werden, was wiederum die Ausgaben des Netzwerks beeinflusst.

Zusammen repräsentieren die Architektur und die trainierten Gewichte des neuronalen Netzwerks das erlernte Wissen und die Fähigkeiten des Modells. Das Netzwerk lernt, wie es bestimmte Muster in den Trainingsdaten erkennen und auf neue Daten anwenden kann. Das gelernte Wissen kann vielfältig sein, je nach Aufgabe des Modells.

Festzuhalten ist jedoch, dass dieses „Wissen“ spezifisch für genau diejenige Aufgabe ist, für die das Modell trainiert wurde. So wird ein neuronales Netzwerk für die Bilderkennung nicht unbedingt Wissen über Sprache oder Musik besitzen. Eine Generalisierungsfähigkeit von Modellen hängt deshalb immer von der Qualität der Trainingsdaten, der speziellen Architektur eines Netzwerks und anderen Faktoren ab.