Methoden der Datenanalyse - Gesamt

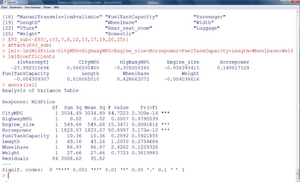

Multiple Regression

Ziel dieser Lektion ist die Erweiterung des Konzepts des in der induktiven Statistik vorgestellten Konzeptes der einfachen linearen Regression (Anzur, 2007) auf mehrere erklärende Einflussgrößen.

Einleitung

Wie auch schon die einfache lineare Regression, ist die multiple lineare Regression ein Verfahren, um die (lineare) Beziehung verschiedener statistischer Merkmale abzuschätzen. Während bei der einfachen Regression nur eine erklärende und eine abhängige Variable vorhanden sind (daher auch der Name „Zwei-Variablen-Modell“), steht bei der multiplen Regression ein Satz von mehreren potentiellen erklärenden Variablen zur Verfügung. Lässt man auch mehr als eine abhängige Variable zu, spricht man üblicherweise von multivariater Regression, die aber hier nicht behandelt wird.

| Beispiel 1

Es soll nun mittels statistischer Analyse festgestellt werden, welche Variablen den Kaufpreis am besten erklären und welcher Art der Zusammenhang ist. |

|---|

Die Fragestellung könnte dadurch beantwortet werden, dass mehrere lineare Einfachregressionen berechnet werden, jedoch hängen die verschiedenen Variablen auch untereinander zusammen. Man kann hierbei die Korrelationen der verschiedenen Variablen zueinander aber nicht berücksichtigen. Beispielsweise hängen der Hubraum und die PS-Zahl eines Motors positiv miteinander zusammen und es können in einer Einfachregression nicht die getrennten Anteile beider Größen bei der Erklärung des Kaufpreises eruiert werden. Man will nun ein möglichst sparsames Modell finden, dass die wichtigsten Variablen auswählt und deren einzelne Beiträge zur Zielgröße (dem Preis) darstellt.

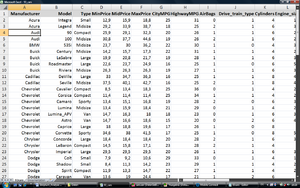

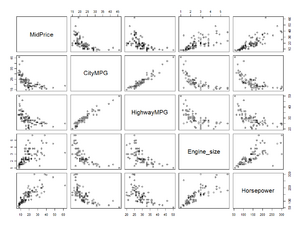

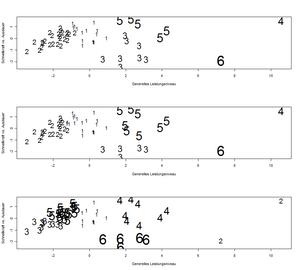

In einem ersten Schritt wird nun wie bei der Einfachregression versucht, die Zusammenhänge zwischen der Zielgröße und den verschiedenen erklärenden Variablen zu visualisieren.

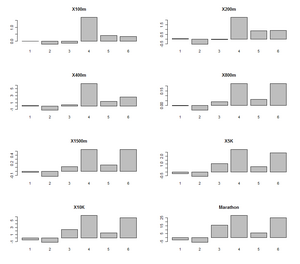

In Abbildung 2 und Abbildung 3 sind nun insgesamt acht Variablen ausgewählt, die einen mehr oder weniger inhaltlich begründeten Zusammenhang mit der Zielvariable „MidPrice“ [1] aufweisen. Der Scatterplot in Abbildung 3 rechts oben zeigt beispielsweise den Zusammenhang zwischen dem Preis und dem Gewicht des Wagens. Es zeigen sich mehrere einigermaßen lineare, jedenfalls monotone Zusammenhänge zur Zielvariable.

Modell und Schätzung der multiplen Regression

Das Modell der Daten lautet bei der multiplen Regression folgendermaßen:

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle y_{i}=\beta_{0}+\beta_{1} x_{i 1}+\beta_{2} x_{i 2}+\cdots \beta_{k} x_{i k}+\varepsilon_{i}, (i=1, \ldots, n ; j=1, \ldots, k) ; }

wobei Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle y_{i}} die Werte der abhängigen Variablen, Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle y_{i,j}} die Werte der erklärenden Variablen und Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \beta_{j}} die Regressionsparameter, die das Ausmaß des Einflusses der Variablen kennzeichnen, sowie Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle +\varepsilon_{i}} die durch das lineare Modell nicht erklärten „Reste“ (=Fehler) sind.

Es wird üblicherweise angenommen, dass die Fehler Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle +\varepsilon_{i}} normalverteilt sind mit Erwartungswert gleich Null und Varianz Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \sigma^2} . Das bedeutet einerseits, dass das Modell verlangt, dass die Varianzen für alle Fehler gleich groß sind. Andererseits ist die Verteilungsannahme notwendig, um statistische Tests über die geschätzten Parameter durchführen zu können. Weiters wird auch noch angenommen, dass es keine Zusammenhänge (Korrelationen) zwischen beliebigen Fehlern gibt.

Wie im einfachen Modell werden die Werte für die Regressionsparameter Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \beta_{j}} ermittelt, indem das Kriterium der kleinsten Quadrate angewandt wird.

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle F\left(\beta_{0}, \beta_{1}, \ldots \beta_{k}\right)=\sum_{i=1}^{n}\left(y_{i}-\beta_{0}-\beta_{1} x_{i 1}-\beta_{2} x_{i 2}-\cdots \beta_{k} x_{i k}\right)^{2} \rightarrow \operatorname{Min} ! }

Die Lösung dieses Optimierungsproblemes sind nun die geschätzten Regressionsparameter Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \widehat{\beta_{0}}, \widehat{\beta}_{1}, \ldots \widehat{\beta_{k}}} .

Geometrisch bedeutet dies im Falle einer erklärenden Variable, dass die Gerade solange gedreht und verschoben wird, bis die Summe der Quadrate der vertikalen Abstände der Punkte zur Gerade im Scatterplot minimal wird. Im Falle zweier erklärender Variablen wird eine Ebene im dreidimensionalen Raum gedreht, bis sie „ideal passt“. Bei mehr als zwei erklärenden Variablen wäre es eine Hyperebene im Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle k} -dimensionalen Raum.

Auch hier ist es nun einfach, die durch die erklärenden Variablen prognostizierten Werte („fitted values“) Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \widehat{y_{i}}} zu berechnen:

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \widehat{y_{i}}=\widehat{\beta_{0}}+\widehat{\beta_{1}} x_{i 1}+\widehat{\beta_{2}} x_{i 2}+\cdots \widehat{\beta_{k}} x_{i k} }

Die nicht erklärten Differenzen Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \widehat{\epsilon_{i}}= y_{i}- \widehat{y_{i}}} werden als „Residuen“ bezeichnet. Die Optimierungsaufgabe kann daher auch als Minimierung der Residuenquadratsumme bezeichnet werden.

| Fortsetzung Beispiel 1

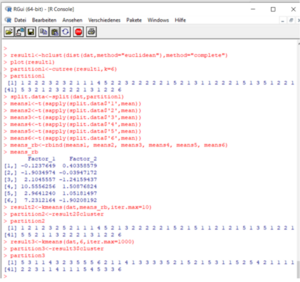

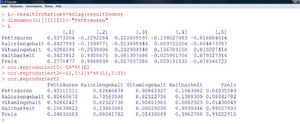

In R können die Koeffizienten folgendermaßen berechnet werden:

|

|---|

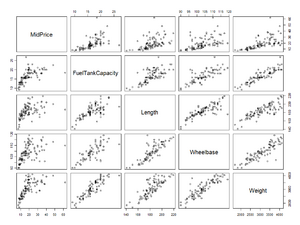

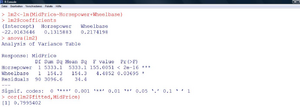

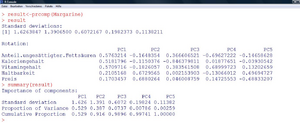

| Die Fortsetzung und die geschätzten Parameter sind nun in Abbildung 4 ersichtlich. |

Die erhaltene Gleichung zur Prognose des mittleren Preises eines Wagens lautet also folgendermaßen:

MidPrice (in T$)=

- 27,99 T$

- + Spritverbrauch in der Stadt (in “Miles“/Gallon) * 0,0865 T$

- - Spritverbrauch auf der Autobahn (in “Miles“/Gallon) * 0,3050 T$

- - Hubraum (in l) * 0,9364 T$

- + PS * 0,1498 T$

- - Tankgröße (in gallons) * 0,0043 T$

- + Länge (in inch) * 0,0181 T$

- + Radstand (in inch) * 0,4287 T$

- - Gewicht (in Pfund) * 0,0040 T$

Der prognostizierte Preis eines Buick Century Midsize wäre dann beispielsweise:

-27,99 T$ + 22 * 0,0865 T$ - 31 * 0,3050 T$ - 2,2 * 0,9364 T$ + 110 * 0,1498 T$ - 16,4 * 0,0043 T$ + 189 * 0,0181 T$ + 105 * 0,4287 T$ - 2880 * 0,0040 T$ =

-27,99 T$ + 1,90 T$ - 9,46 T$ - 2,06 T$ + 16,48 T$ - 0,07 T$ + 3,42 T$ + 45,01 T$ -11,52 T$ =15,71 T$

Der tatsächliche Preis dieses Wagens beträgt 15.700 $. Damit ist die Prognose auf 10 $ genau.

Das ausgewählte Beispiel vermittelt jedoch einen falschen Eindruck, da hier jener Wagen ausgewählt wurde, für den die Prognose am besten zugetroffen hat. Um einen Eindruck zu bekommen, wie gut das Modell zu den Daten passt, müssen nun verschiedene andere Kriterien herangezogen werden.

Interpretation und Beurteilung der Güte des Regressionsmodells

Korrelation und Bestimmtheitsmaß

Ein notwendiges, aber nicht hinreichendes Kriterium für ein gut passendes Regressionsmodell ist – wie schon im Zwei-Variablen-Modell – das Bestimmtheitsmaß.

Dieses ist definiert als Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle R_{X, Y}^{2}=\frac{\sum_{i=1}^{n}\left(\hat{y}_{1}-\bar{y}\right)^{2}}{\sum_{i=1}^{n}\left(y_{i}-\bar{y}\right)^{2}}} .

Es sagt also aus, welcher Anteil an der Variabilität der Zielvariable einzig durch die erklärenden Variablen erklärt wird. So wie bei jedem Anteil errechnet sich hier eine Zahl zwischen 0 und 1 (=100%).

In Beispiel 1 kann man das Bestimmtheitsmaß aus der Aufstellung der Quadratsummen in der „Analysis of Variance“-Tabelle berechnen:

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \sum_{i=1}^{n}\left(y_{i}-\bar{y}\right)^{2}=3034,49+0,02+549,68+1823,07+10,36+43,16+86,97+27,66+3008,62=8584,33 } Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \sum_{i=1}^{n}\left(\widehat{y_{i}}-\bar{y}\right)^{2}=3034,49+0,02+549,68+1823,07+10,36+43,16+86,97+27,66 =5575,71 } Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle R_{X, Y}^{2}=\frac{5575,71}{8584,33}=65 \% }

Generell kann man sagen, dass eine Varianzerklärung von über 50% ganz gut ist. Das Bestimmtheitsmaß ist aber auch aus einer zweiten Sicht interessant, da es das Quadrat der linearen Korrelation der prognostizierten Werte mit der abhängigen Variable ist.

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle R_{X, Y}^{2}=[\operatorname{cor}(\hat{Y}, Y)]^{2} }

Daher kann der Betrag dieser Korrelation ebenfalls errechnet werden. Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \operatorname{cor}(\hat{Y}, Y)=\sqrt{R_{X, Y}^{2}}=\sqrt{0,65}=0,81 }

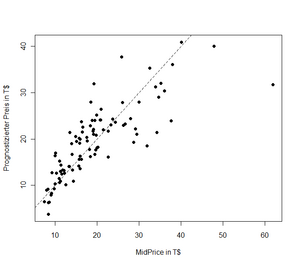

In der Gegenüberstellung der prognostizierten zu den tatsächlichen Preisen (Abbildung 5) kann man erkennen, welche Beobachtungen gut oder weniger gut geschätzt werden können. Hier sieht man auch beispielsweise sehr schön, dass der „Mercedes Benz 300E Midsize“ (ganz rechts) um ca. 30.000 $ teurer ist, als aufgrund seiner Leistungsdaten in diesem Beispiel prognostiziert.

Multikollinearität und Variablenselektion

Weder an der Tabelle in Abbildung 4, noch an den $-Beiträgen zum Gesamtpreis ist es aber möglich, festzustellen, welche Variablen nun die für den Preis wichtigsten sind. Die Komponenten der Varianz („Sum Sq“) sind davon abhängig, in welcher Reihenfolge das Modell spezifiziert wird. Es wird der Reihe nach untersucht, welchen Varianz-Anteil die jeweiligen Variablen an der Zielgröße haben. Nimmt man beispielsweise die „engine_size“ zuerst in das Modell, bleibt für die Variablen zum Spritverbrauch nicht mehr viel an Erklärung über, da dieser einigermaßen stark mit dem Motorvolumen korrelieren. Weiters führen viele hoch korrelierte Variablen dazu, dass schwerer bestimmbar ist, welchen Beitrag die einzelnen Variablen haben – die Varianzen dieser Schätzungen werden größer.

Gibt es potentielle erklärende Variablen, die sehr stark miteinander korrelieren (z.B. Spritverbrauch in der Stadt und auf der Autobahn), spricht man in diesem Zusammenhang von „beinaher Multikollinearität“, bei perfekter linearer Korrelation von „exakter Multikollinearität“. Ein Satz von erklärenden Variablen, der Multikollinearität aufweist, ist daher problematisch.

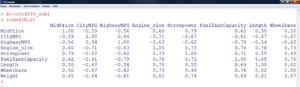

| Aufgabe 1

Berechnen Sie mit der Funktion „cor“ in R alle paarweisen Korrelationen der neun ausgewählten Variablen im obigen Regressionsmodell. |

|---|

Wie kann nun ein „brauchbarer“ Satz von Variablen zusammengestellt werden?

Besteht bei allen acht Variablen die Möglichkeit, ins Modell aufgenommen zu werden oder nicht, müssten 28-1=255 verschiedene Modelle miteinander verglichen werden (gegeben es wird zumindest eine Variable aufgenommen). Um diesen enormen Rechenaufwand zu vermindern gibt es nun verschiedene Methoden, die sich einer schrittweisen Vorgehensweise bedienen.

Ein weit verbreitetes Kriterium, dass die erklärte Varianz der Anzahl auf die Anzahl der verwendeten Variablen bezieht, ist das sogenannte „Akaike Information Criterion“ (AIC) von Akaike (1973, 1974, zitiert in Ripley, 1996, S. 34).

Fortsetzung Beispiel 1

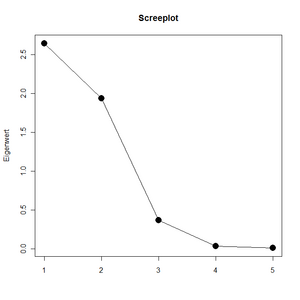

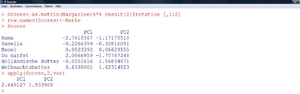

Als Ergebnis erscheint nun eine Prozedur, die, ausgehend vom Modell mit allen acht erklärenden Variablen jeweils einzelne Variablen entfernt, solange das AIC vermindert werden kann. Im konkreten Fall ergeben sich nur mehr die „Horsepower“ und die „Wheelbase“ als relevante Einflussgrößen. |

|---|

Die erhaltene Gleichung zur Prognose des mittleren Preises eines Wagens lautet also nun:

MidPrice (in T$)= - 22,01 T$ + PS * 0,1316 T$ + Radstand (in inch) * 0,2174 T$

Der prognostizierte Preis des Buick Century Midsize wäre dann:

-22,01 T$ + 110 * 0,1316 T$ + 105 * 0,2174 T$ =15,30 T$

Wir erhalten also eine auf 400$ genaue Prognose, obwohl nun lediglich zwei statt acht Einflussgrößen im Modell sind.

Akzeptiert man dieses Modell, bedeutet dass, das ein Wagen mit 100 PS und 100 Inch Radstand im Mittel -22,01 T$ + 100 * 0,1316 T$ + 100 * 0,2174 T$ =12,89 T$ kostet. Jedes PS mehr oder weniger kostet/bringt im Mittel 131,6$ und jedes Inch mehr oder weniger beim Radstand kostet/bringt im Mittel 217,4$.

Abbildung 6 zeigt auch, dass die Korrelation zwischen dem Preis und der Prognose ebenfalls kaum merkbar gesunken ist (0,80 statt 0,81). Es findet daher quantitativ immer noch eine gute Erklärung durch das neue, deutlich sparsamere Modell statt.

Andere Variablenselektionskriterien nehmen, beginnend mit einem leeren Modell, die mit dem Zielkriterium jeweils am besten korrelierende Variable auf und prüfen, ob der Erklärungszuwachs noch statistisch signifikant ist („Vorwärtsselektion“; im Sinne eines statistischen Signifikanztests). Wieder andere Eliminieren aus dem vollen Satz an Variablen schrittweise jene, die nicht statistisch signifikant sind („Rückwärtsselektion“; ähnlich dem hier verendeten Verfahren). Das vorliegende Modell wäre auch mit den Standardeinstellungen der Vorwärts- und Rückwärtsselektion gewählt worden. Da die Korrelation zwischen Preis und PS-Stärke schon allein 0,79 beträgt, kann allerdings die PS-Stärke als weitaus wichtigere der beiden Variablen für die Erklärung des Preises identifiziert werden.

Residuenanalyse

Neben dem Bestimmtheitsmaß und der Sparsamkeit des Modells, ist es weiters bedeutend, die einzelnen Residuen der Regression zu untersuchen, und zwar in Hinblick auf

- Trend

- Ausreißer

- Heteroskedastizität

- Autokorrelation und

- Normalverteilung (NV)

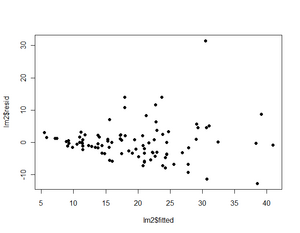

Eine Darstellung um die ersten vier genannten Punkte zu überprüfen ist in Abbildung 8 ersichtlich.

Trend

Es ist kein Trend zu erkennen. Mit wachsenden Prognosewerten bleibt das Niveau der Residuen im Mittel durchgehend auf Null.

Ausreißer

Hier sieht man wieder den Mercedes Benz von vorhin als größtes der Residuen. Es empfiehlt sich, eine Analyse ohne diesen Datenpunkt zu machen um zu sehen, wie sehr die Schätzungen beeinflusst werden.

| Aufgabe 2

Schätzen Sie die Koeffizienten des linearen Modells (Horsepower und Wheelbase) in R ohne den Mercedes 300E Midsize (Hinweis: Der Datensatz ohne die 59. Zeile – der entsprechende Wagen – wird in R folgendermaßen generiert: „X92_sub <- X93_sub[-59,]“). Wie stark ändern sich die Regressionskoeffizienten? Wie groß ist die Korrelation zwischen Preis und prognostiziertem Preis? |

|---|

Heteroskedastizität

Es ist ersichtlich, dass die mittleren Abweichungen der Daten von der Prognose umso größer werden, je teurer der Wagen ist. Sind für ähnliche Prognosewerte die Abweichungen nicht im Mittel gleich, spricht man von Heteroskedastizität. So das Ausmaß dieser Heteroskedastizität quantifiziert werden kann, sollte diese in die Modellschätzung einfließen. Die Schätzungen für die Regressionskoeffizienten unterliegen dann einer geringeren Variabilität.

Autokorrelation

Autokorrelation besteht dann, wenn Residuen von ähnlichen Datenpunkten in etwa gleich groß sind. Zum Beispiel ist die Abweichung der Temperatur am 26. und am 27. Juli von der Jahresdurchschnittstemperatur jedes Jahr in etwa gleich. Umgekehrt ist die Abweichung von der Durchschnittstemperatur im Jänner immer genau umgekehrt. Bei anderen Zeitreihen hat man ebenfalls solche Saisoneffekte (z.B. die Arbeitslosenrate) und das Ausmaß solcher Korrelationen sollte dort ebenfalls in die Modellschätzung einfließen.

Abbildung 9 zeigt nun nochmals zusammengefasst Darstellungen des „Idealfalles“ und verschiedene Modellverletzungen.

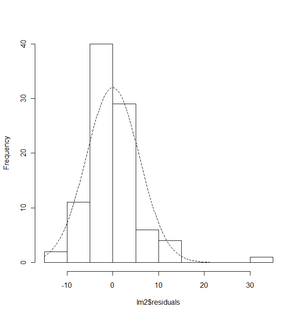

Die Annahme der Normalverteilung wird visuell mittels Histogramm (Abbildung 10) oder einem sogenannten Q-Q-Plot überprüft. Inferenzstatistisch wird der Kolmogorov-Smirnov-Anpassungstest verwendet.

Im Zuge der multiplen Regressionsanalyse können auch u.a. die einzelnen geschätzten Parameter auf Signifikanz geprüft werden, worauf aus Platzgründen hier verzichtet wird. Die Vorgehensweise ist in einführenden Büchern zu linearen Modellen beschrieben (z.B. Faraway, 2005, für eine Darstellung der Regressionsanalyse in R).

Fortsetzung Beispiel 1

Im vorliegenden Beispiel kann die NV-Annahme nicht widerlegt werden. |

|---|

Wiederholungsaufgaben und Zusammenfassung

- Sie haben in ihrer Regression ein Bestimmtheitsmaß von 10% erhalten. Die Modellvoraussetzungen sind alle erfüllt. Was können Sie mit dieser Information anfangen?

- Was sagt ein Bestimmtheitsmaß von 100% über

a) die Korrelation zwischen prognostizierten Werten und Zielvariable,

b) über die Varianz der Residuen, und

c) über die geometrische Lage der Beobachtungspunkte aus?

Sie ziehen drei Stichproben aus einer Population und berechnen jedesmal dasselbe multiple Regressionsmodell. Folgende Parameterschätzer ergeben sich:

| Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \widehat{\beta_{0}}} | Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \widehat{\beta_{1}}} | Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \widehat{\beta_{2}}} | Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \widehat{\beta_{3}}} | Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \widehat{\beta_{4}}} | |

|---|---|---|---|---|---|

| Stichprobe 1 | -0,3 | -0,07 | 18,1 | 44,5 | 2,2 |

| Stichprobe 2 | -0,29 | -0,09 | 22,4 | 21,9 | 1,7 |

| Stichprobe 3 | -0,32 | 0,04 | 19,3 | 2,6 | -2,5 |

Welche Variablen würden Sie aufgrund der Vorzeichen der Regressionskoeffizienten jedenfalls ausschließen? Welcher Koeffizient erscheint Ihnen weiters nicht statistisch bedeutsam?

Zusammenfassung

Die multiple Regressionsanalyse prüft das Vorhandensein einer linearen Beziehung zwischen einer abhängigen Größe und einem Satz erklärender Einflussvariablen. Es wird zunächst unterstellt, dass diese abhängige Größe von allen gewählten Einflussvariablen linear abhängt und es werden durch Optimierung jene Regressionsparameter ermittelt, welche die Summe der Quadrate der Differenzen zwischen beobachteten Werten und durch das Modell geschätzten Werten kleinstmöglich machen.

In weiteren Schritten muss nun analysiert werden, ob wirklich jede Variable für sich einen von den anderen Variablen unabhängigen Beitrag liefert. Falls dies nicht der Fall ist, wird diese eliminiert. Dazu bedient man sich neben inhaltlichen Überlegungen auch automatisierten Ansätzen, den verschiedenen statistischen Methoden der Variablenselektion.

Ist schließlich ein Modell gefunden, in dem jede Variable einen wichtigen linearen Beitrag zur Zielgröße liefert, wird üblicherweise mittels visueller Verfahren untersucht, ob Modellverletzungen vorliegen (Heteroskedastizität, Autokorrelation, Ausreißer oder nicht normalverteilte Residuen). Je nach Art einer gefundenen Modellverletzung müssen entweder komplexere Modelle mit weiteren Spezifikationen (Heteroskedastizität, Autokorrelation) gerechnet, Daten ausgeschlossen werden (Ausreißer) oder Transformationen in den Daten geschehen (nicht normalverteilte Residuen).

Varianzanalyse

Die Varianzanalyse stellt nicht nur ein spezielles Analyseverfahren, sondern eine generelle Methode dar, um Zusammenhänge zwischen verschiedenen Merkmalen inferenzstatistisch zu beurteilen. Ziel der Lektion ist das Grundmodell der Varianzanalyse sowie die wichtige Idee der Quadratsummenzerlegung darzustellen. Die Durchführung der Analysen der Modelle mit einem bzw. zwei Faktoren sowie die Umsetzung in der Software R sind die weiteren zentralen Punkte.

Begriffsabgrenzung

Die (univariate) Varianzanalyse („ANOVA“ = „analysis of variance“) wird ebenfalls dazu verwendet, den Einfluss einer oder mehrerer unabhängiger Variablen auf eine zumindest intervallskalierte (metrische) Zielvariable zu untersuchen. Im Gegensatz zur Regression sind die hier vorkommenden unabhängigen Variablen kategoriell. Es wird daher nicht eine lineare Funktion als Zusammenhang unterstellt, sondern die Varianzanalyse stellt eine Methode zur Analyse von Mittelwertsunterschieden in verschiedenen Versuchsgruppen dar. Der Name „Varianzanalyse“ kommt daher, dass zur Beurteilung der Signifikanz solcher Mittelwertsunterschiede Varianzen berechnet werden.

Liegt eine erklärende Gruppenvariable (ein „Faktor“) vor, spricht man von einer „einfachen“ bzw. „einfaktoriellen“ Varianzanalyse, ansonsten von zwei- oder mehrfaktoriellen Varianzanalysen. Im Gegensatz zur Regressionsanalyse werden üblicherweise auch Interaktionen zwischen (zwei oder mehreren) erklärenden Variablen im Modell berücksichtigt.

Die verschiedenen Ausprägungen eines jeden Faktors werden „Faktorstufen“ genannt. Hat man in jeder Faktorstufe gleich viele Daten zur Verfügung, spricht man von einem „balancierten Design“, sonst von einem „unbalancierten Design“. Gibt es (bei zumindest zwei vorhandenen Faktoren) nicht in jeder Kombination von Faktoren Beobachtungen, heißt die Versuchsanordnung „unvollständiges Design“.

Hat man als erklärende Variablen sowohl metrische, als auch kategorielle Variablen, wird eine Kovarianzanalyse durchgeführt, die aber hier nicht weiter behandelt wird. Ebenfalls nicht behandelt wird der Fall der multivariaten Varianzanalyse („MANOVA“) bei der mehrere abhängige, korrelierte Variablen vorkommen.

Typische Fragestellungen der ANOVA können sein:

- Ob und wie unterscheiden sich Mietkosten einer Wohnung in Bezug auf die Lage (Innen- vs. Außenbezirke) bzw. in Bezug auf die Zimmeranzahl?

- Gibt es Unterschiede im Ertrag bei verschiedenen Getreidesorten?

- Hängt der Absatz eines Produktes von der Platzierung im Supermarkt ab?

- Ist ein bestimmtes Training für eine Leistung förderlich?

- Ist eine Therapie in Bezug auf ein Kriterium erfolgreich?

Hinweis: Die einfaktorielle Varianzanalyse kann auch als die Verallgemeinerung des schon bekannten t-Tests (zum Vergleich zweier Erwartungswerte aus normalverteilten Grundgesamtheiten) für eine beliebige Anzahl an Erwartungswerten (Gruppen) gesehen werden.

Die einfache Varianzanalyse für unabhängige Stichproben

Modell der einfachen Varianzanalyse für unabhängige Stichproben

Formal lautet das Modell der einfachen Varianzanalyse:

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle y_{i j}=\mu+\alpha_{1}+\epsilon_{i j}, \qquad\left(i=1, \ldots, k ; j=1, \ldots, n_{i}\right) ; }

wobei Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle y_{i j}}

die Werte der metrischen Variable sind (j-ter Wert in Gruppe i), Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \mu}

der unbedingte Erwartungswert (ohne Kenntnis der Gruppe), Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha_i}

der „Effekt“ von Gruppe Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle i}

ist (also der Unterschied des jeweiligen Gruppenerwartungswerts Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \mu_i}

zu und Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \epsilon_{i j}}

der durch die Gruppenvariable nicht erklärte Teil der abhängigen Variable – analog zur Regression, der Fehler – ist. Die Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle n_i}

sind die Stichprobenumfänge der Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle k}

Gruppen.

Wie bei der Regression ist auch hier die Annahme, dass die Fehler Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \epsilon_{i j}} normalverteilt mit Erwartungswert Null und Varianz Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \sigma^2} und voneinander unabhängig sind (Varianzhomogenität und Unkorreliertheit der Fehler).

Schätzen und Testen bei der einfachen Varianzanalyse

| Beispiel 2

Es soll die Zugfestigkeit von drei Drahtsorten verglichen werden. Dazu werden von Sorte 1 sieben Proben, von Sorte 2 fünf Proben und von Sorte 3 sechs Proben auf ihre Zugfestigkeit überprüft. Es ergaben sich folgende Werte (in Newton/mm2):

Es soll die Frage untersucht werden, ob sich die einzelnen Drahtsorten hinsichtlich ihrer Festigkeit unterscheiden. |

|---|

Da in Beispiel 2 nur eine gruppierende Variable (in drei Ausprägungen) existiert, liegt eine einfache Varianzanalyse vor. Da nicht in jeder Gruppe gleich viele Beobachtungen sind, ist das Design unbalanciert.

Gemäß des Modells der einfachen Varianzanalyse haben wir also die Vorstellung: Die Zugfestigkeit einer Drahtsorte bei einem bestimmten Versuch setzt sich additiv zusammen aus

- einer mittleren Zugfestigkeit, die ein „durchschnittlicher“ Draht hat,

- einem Wert, um die die Zugfestigkeit einer speziellen Drahtsorte besser oder schlechter ist, als ein „durchschnittlicher“ Draht und

- einer Abweichung von der durchschnittlichen Zugfestigkeit dieser Drahtsorte, die in dem bestimmten Versuch beobachtet wurde und mangels anderer Erklärungsmöglichkeiten dem Zufall zugeordnet wird.

Dementsprechend werden auch die Parameter in diesem Modell geschätzt.

Schätzung der Zugfestigkeit Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \mu} eines durchschnittlichen Drahts durch

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \hat{\mu}=\frac{1}{\sum_{i=1}^{k} n_{i}} \sum_{i=1}^{k} \sum_{j=1}^{n_{i}} y_{i j} }

Schätzung des Effekts von Drahtsorte Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle i} , Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha_i} , durch

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \hat{\alpha}_{i}=\hat{\mu}_{i}-\hat{\mu}=\frac{1}{n_{i}} \sum_{j=1}^{n_{i}} y_{i j}-\hat{\mu} }

Schätzung des Fehlers Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \epsilon_{i j}} durch das Residuum

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \widehat{\epsilon_{i j}}=y_{i j}-\widehat{y_{i j}}=y_{i j}-\left(\hat{\mu}+\hat{a_{i}}\right) }

| Fortsetzung Beispiel 2

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \hat{\mu}=\frac{1}{7+5+6}(9+15,4+\cdots+6,8+7,3+\cdots+9,7+18+\cdots+14,1)=11,717 } Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \widehat{\alpha_{1}}=\widehat{\mu_{1}}-\hat{\mu}=\frac{1}{7}(9+15,4+\cdots+6,8)-11,717=8,771-11,717=-2,945 } Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \widehat{\alpha_{2}}=\widehat{\mu_{2}}-\hat{\mu}=\frac{1}{5}(7,3+15,6+\cdots+9,7)-11,717=11,960-11,717=0,243 } Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \widehat{\alpha_{3}}=\widehat{\mu_{3}}-\hat{\mu}=\frac{1}{6}(18+9,6+\cdots+14,1)-11,717=14,950-11,717=3,233 } Kontrolle:Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle n_{1} \widehat{\alpha_{1}}+n_{2} \widehat{\alpha_{2}}+n_{3} \widehat{\alpha_{3}}=0 ? \rightarrow 7 *(-2,945)+5 * 0,243+6 * 3,233=0} Residuum exemplarisch:Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \widehat{\varepsilon_{15}}=y_{15}-\widehat{\mu_{1}}=7,3-8,771=-1,471} |

|---|

| Aufgabe 3

Berechnen Sie für alle Beobachtungen aus Beispiel 2 die Residuen und bestimmen Sie jene Beobachtung, die durch das Modell am schlechtesten erklärt wird (d.h. das betragsmäßig größte Residuum aufweist). |

|---|

Die Schätzungen der einzelnen Parameter beschränken sich also immer nur auf die Berechnung von Mittelwerten und deren Differenzen. Aus den Berechnungen von Beispiel 2 wissen wir nun beispielsweise, dass Drahtsorte 3 eine um 3,233 Newton/mm2 größere Zugfestigkeit als der Durchschnitt aufweist. Das bezieht sich jedoch nur auf die beobachtete Stichprobe. Damit haben wir auf die ursprüngliche Frage „Unterscheiden sich die 3 Drahtsorten bezüglich der Zugfestigkeit“ nur eine deskriptivstatistische Antwort gegeben.

In der Regel ist aber von Interesse, ob wir durch die Daten genügend Evidenz dafür haben, dass sich auch die Mittelwerte der Grundgesamtheit (die Erwartungswerte) unterscheiden. Hier ist es nun wieder erforderlich, einen statistischen Test zu berechnen.

Das Hypothesenpaar bei der einfaktoriellen Varianzanalyse lautet folgendermaßen:

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle H_{0}: \mu_{1}=\mu_{2}=\cdots=\mu_{k} \Leftrightarrow \alpha_{1}=\alpha_{2}=\cdots=\alpha_{k}=0 } Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle H_{1}: \exists(i, j): \mu_{i} \neq \mu_{j} \Leftrightarrow \exists \alpha_{i} \neq 0 }

Getestet wird also, ob alle Erwartungswerte gleich sind, oder zumindest zwei Erwartungswerte existieren, die ungleich sind.

Beim t-Test (Anzur, 2007, S. 71) wurde als relevante Prüfgröße die Differenz der Mittelwerte der beiden Gruppen bezogen auf den Standardfehler der Mittelwertsdifferenz berechnet. Dieses Konzept ist nun nicht mehr möglich, da die Differenzen von mehr als zwei Gruppen berechnet werden müssten (die „mittlere“, die „maximale“, die „minimale“?). Anstelle der Differenz kommt nun das Konzept mit den Varianzen ins Spiel.

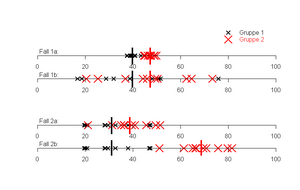

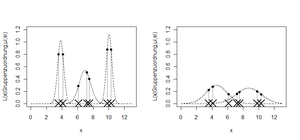

Abbildung 11 zeigt anhand von zwei Gruppen das Problem aber auch gleichzeitig die Lösung. Ziel der Varianzanalyse ist es, herauszufinden, ob die (durchschnittliche) Lage der Beobachtungen auf dem Zahlenstrahl in beiden Gruppen gleich ist. In Fall 1 besteht zwischen Gruppe 1 und Gruppe 2 bei a und b dieselbe Mittelwertsdifferenz. Es ist aber mit freiem Auge ersichtlich, dass in Fall 1a besser zwischen den beiden Gruppen getrennt werden kann, als in Fall 1b. Grund sind die größeren Varianzen innerhalb der beiden Gruppen im Fall 1b. Bei Fall 2 streuen nun die Werte aller Gruppen gleich um ihren Mittelwert. Demnach sind die Varianzen innerhalb der Gruppen jeweils gleich. Nun kann besser zwischen jenen Gruppen getrennt werden, die den größeren Mittelwertsunterschied haben. Zusammengefasst heißt das, dass umso mehr Evidenz für eine unterschiedliche Lage der Gruppen gegeben ist, je größer die Mittelwertsdifferenz ist und je kleiner die Streuung der Werte um ihren eigenen Mittelwert ist. Im Fall von mehr als zwei Gruppen wird die Mittelwertsdifferenz einfach durch die Streuung (Varianz) der Gruppenmittelwerte ersetzt.

Gegenübergestellt werden in der Varianzanalyse also die Varianzen (Quadratsummen [2] ) „innerhalb“ der Gruppen und „zwischen“ den Gruppen. Die Hilfsgrößen, um einen Test für oben genanntes Hypothesenpaar durchzuführen sind solche Quadratsummen. In der einfachen Varianzanalyse gilt immer folgende Quadratsummenzerlegung:

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \underbrace{\sum_{i=1}^{k} \sum_{j=1}^{n_{1}}\left(y_{i j}-\hat{\mu}\right)^{2}}_{\mathrm{QT}}=\underbrace{\sum_{i=1}^{k} \sum_{j=1}^{n_{1}}\left(y_{i j}-\hat{\mu}_{i}\right)^{2}}_{\mathrm{QI}}+\underbrace{\sum_{i=1}^{k} n_{i}\left(\hat{\mu}_{i}-\hat{\mu}\right)^{2}}_{\mathrm{QZ}} }

QT…Quadratsumme „Total“

QI…Quadratsumme „Innerhalb“

QZ…Quadratsumme „Zwischen“

Die Gesamtvariabilität der Daten QT kann also in zwei additive Teile gespalten werden. Dadurch bietet sich als weitere deskriptive Größe analog zur Regressionsanalyse das Bestimmtheitsmaß an, welches als Quotient aus QZ und QT berechnet wird und wieder den Anteil an der durch das Modell erklärten Varianz an der Zielgröße angibt.

| Aufgabe 4

Denken Sie sich zwei Datensätze aus (je drei Gruppen mit je fünf Beobachtungen pro Gruppe). Einen, bei dem das Bestimmtheitsmaß 100% beträgt und einen, bei dem das Bestimmtheitsmaß 0% beträgt. Welche Charakteristik haben die Daten jeweils. |

|---|

Um nun inferenzstatistische Aussagen zu machen, wird nun die Quadratsumme „Zwischen“ nicht zur totalen Quadratsumme, sondern zur Quadratsumme „Innerhalb“ in Beziehung gesetzt. Dies liefert auch dann die Prüfgröße F [3] für unsere Hypothese:

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle F=\frac{M Q Z}{M Q I}=\frac{\frac{1}{k-1} Q Z}{\frac{1}{N-k} Q I}=\frac{(N-k) Q Z}{(k-1) Q I} \qquad {\left[N=n_{1}+n_{2}+n_{3}\right]} }

Es kann gezeigt werden, dass Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle F}

unter Gültigkeit der Nullhypothese (die Erwartungswerte aller Gruppen sind gleich) und den anderen vorher erwähnten Modellannahmen (Normalverteilung der Fehler) nach einer F-Verteilung mit Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle k-1}

und Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle N-k}

Freiheitsgraden verteilt ist. Dadurch werden Schranken definiert, bis zu welchen Werten von eine Entscheidung für die Nullhypothese und ab wann eine Entscheidung für die Alternativhypothese erfolgt. Was man weiters wie bei jedem statistischen Test benötigt, ist Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha}

, die “Irrtumswahrscheinlichkeit“ (=die Wahrscheinlichkeit, die Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle H_0}

zu verwerfen, obwohl sie zutrifft).

| Fortsetzung Beispiel 2

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle Q T=(9-11,717)^{2}+\cdots(14,1-11,717)^{2}=323,105 } Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle Q I=(9-8,771)^{2}+\cdots+(6,8-8,771)^{2}+\cdots+(14,1-14,950)^{2}=199,361 } Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle Q Z=Q T-Q I=323,105-199,361=123,744 } Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle F=\frac{\frac{1}{3-1} * 123,744}{\frac{1}{18-3} * 199,361}=\frac{61,872}{13,291}=4,655 } |

|---|

|

|

| Aufgabe 5

Berechnen Sie für die Daten aus Beispiel 2 das Bestimmtheitsmaß. |

|---|

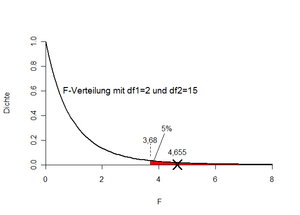

Soll bei Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle F=4,655} nun für die H0 oder für die H1 entschieden werden? Bei kleinen Werten von F beobachten wir entweder kleine Werte für QZ und/oder große Werte für QI. Beides spricht eher für die H0. Umgekehrt sind große Werte für F eher Evidenz für H1. Um die Frage zu beantworten, wird nun der „kritische Wert“ in der Tabelle der F-Verteilung (oder z.B. in Excel) nachgeschlagen. Bei Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha=5%} am oberen Ende der Verteilung suchen wir de facto das Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle 1-\alpha=95%} -Quantil der F-Verteilung mit Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle k=1=3-1=2} und Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle N-k=18-3=15} Freiheitsgraden. In Excel kann dies mit der Funktion „FINV“ berechnet werden („=FINV(0,05;2;15)“). Dies liefert als maximal zulässigen F-Wert 3,68. Unser aus den Daten beobachtete F-Wert beträgt 4,655. Diese ist größer als der kritische Wert und daher wird die Nullhypothese verworfen. Ergebnis: Die drei Drahtsorten unterscheiden sich (bei Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha=5%} ) signifikant voneinander bezüglich ihrer Zugfestigkeit. Abbildung 12 veranschaulicht die Entscheidungssituation nochmals.

In der Praxis rechnet man die Varianzanalyse natürlich wieder mit Software. In R kann wieder die Funktion „lm“ verwendet werden. Die unabhängige Variable muss aber als „Faktor“ spezifiziert werden, da sonst ein linearer Zusammenhang mit der Gruppennummer geschätzt wird.

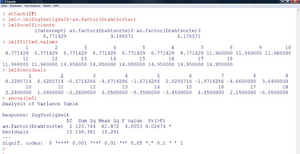

Abbildung 13 zeigt die Vorgehensweise in R, nachdem das csv-File eingelesen wurde (Name in R: „ZF“). Die geschätzten Koeffizienten sind hier nicht in der Effektkodierung angegeben (Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha1, \alpha2, \alpha3} in Abschnitt 2.2.1), sondern in der sogenannten „Dummykodierung“. Die Mittelwerte der einzelnen Gruppen werden folgendermaßen reproduziert:

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \widehat{\mu_{1}}=8,771 } Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \widehat{\mu_{2}}=8,771+3,189=11,960 } Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \widehat{\mu_{3}}=8,771+6,179=14,950 }

Da die Zugehörigkeit zu einer der drei Drahtsorten die einzige Information ist, die zur Prognose der Zugfestigkeit verwendet werden kann, entsprechen die geschätzten Werte für die einzelnen Daten („fitted values“) genau diesen Mittelwerten. Die „Tafel der Varianzanalyse“ liefert nun aus inferenzstatistischer Sicht die Kerninformation. Der p-Wert des Tests (siehe „Pr(>F); die Wahrscheinlichkeit, unter Gültigkeit der Nullhypothese den aus den Daten berechneten Wert für F oder einen noch größeren zu erhalten) ist kleiner als das üblicherweise gewählte Niveau des Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha}

-Fehlers (5%). Daher erfolgt auch mittels Software die Entscheidung für H1.

| Aufgabe 6

Abbildung 13 (unten) zeigt die typische „Tafel der Varianzanalyse“. Vergleichen Sie die darin vorkommenden Werte mit den bereits vorher berechneten, um die Berechnung nachzuvollziehen. In der Tafel ist statt des kritischen Wertes aus der F-Verteilung (3,68) der p-Wert ersichtlich. Versuchen Sie, die Berechnung des p-Werts in Excel mit der Funktion „FVERT“ nachzuvollziehen. Betrachten Sie dazu auch nochmals Abbildung 12. Argumentieren Sie, warum der p-Wert ausreichend ist, um für oder gegen H0 zu entscheiden und setzen Sie die Kriterien für die Testentscheidung, die in diesem Abschnitt auf zwei Wegen ermittelt wurde, zueinander in Beziehung. |

|---|

|

Aufgabe 7 Zu welcher Entscheidung würde man in Beispiel 2 bei Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha=1%} kommen? |

|

Aufgabe 8 In welchem Verhältnis müssten in Beispiel 2 (bei Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha=5%} bzw.Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha=1%} ) die Quadratsummen „Zwischen“ und „Innerhalb“ stehen, damit gerade noch für die H0 entschieden wird. Wie groß wäre dann jeweils das zugehörige Bestimmtheitsmaß? |

Prüfung der Modellvoraussetzungen, Residuenanalyse

Bei der Varianzanalyse beschränken sich die Prüfungen auf

- Ausreißer,

- Heteroskedastizität und

- Normalverteilung.

Diese werden gleich wie bei der Regressionsanalyse durchgeführt. Die Voraussetzung der Heteroskedastizität kann hier aber auch relativ einfach zusätzlich mit einem Test durchgeführt werden. Üblicherweise werden der Bartlett-Test (in R: Funktion „bartlett.test“) oder der Cochran-Test verwendet.

Multiple Mittelwertsvergleiche, Multiples Testen

Die Methode der einfaktoriellen Varianzanalyse liefert nur eine Antwort auf die Frage, ob es Unterschiede zwischen irgendwelchen zwei Gruppen gibt, aber nicht, zwischen welchen beiden Gruppen es diese Unterschiede gibt.

Um einzelne Unterschiede herauszufinden, müsste man theoretisch zwischen allen Gruppen paarweise t-Tests machen. Wie schon erwähnt, ist die einfaktorielle Varianzanalyse ja eine Verallgemeinerung des t-Tests. Man müsste dann allerdings Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \left(\begin{array}{l}k 2 \end{array}\right)} solche t-Tests berechnen. Bei Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle k=5} Gruppen wären das schon 10 t-Tests.

Die (neben der Notwendigkeit der zehnmaligen Durchführung eines Tests) auftretende Problematik ist, dass wenn bei jedem einzelnen Test eine 5%-Wahrscheinlichkeit besteht, einen Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha} -Fehler zu begehen (d.h. die Nullhypothese fälschlicherweise zu verwerfen), die Wahrscheinlichkeit, bei 10 Tests zumindest einmal einen Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha} -Fehler zu begehen, viel höher ist. Formal wäre diese Wahrscheinlichkeit

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha^{*}=1-(1-\alpha)^{m}=1-(1-0,05)^{10}=40,1 \% }

Man kann sich das auch so vorstellen: Spielt man einmal eine Runde im Lotto mit, besteht nur eine sehr kleine Chance, einen Gewinn zu erzielen. Jedoch ist die Wahrscheinlichkeit, in 100 Lottorunden zumindest einmal zu gewinnen schon relativ hoch (wenngleich das zumeist auch die entstandenen Einsätze nicht ausgleicht…).

Die Lösung zum Testproblem ist nun, entweder den Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha} -Fehler jedes einzelnen Tests derart zu reduzieren, dass Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha} dem ursprünglich beabsichtigten Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha} entspricht, oder die Methode der Varianzanalyse zu verwenden, bei der nur ein Test durchgeführt wird.

In der Praxis berechnet man bei derartigen Fragestellungen zuerst eine Varianzanalyse. Fällt diese signifikant aus, werden anschließend sogenannte Post-Hoc-Tests gerechnet, die herausfinden sollen, zwischen welchen Gruppen die Unterschiede bestehen. In diesen Prozeduren werden die Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha} -Fehler dann automatisch korrigiert.

Die zweifache Varianzanalyse für unabhängige Stichproben

| Beispiel 3

Der Marketingleiter eines Lebensmittelkonzerns steht vor der Frage, zu welchem empfohlenen Richtpreis eine neue Margarinemarke auf den Markt gebracht werden soll. Grundsätzlich stehen ihm drei Strategien zur Verfügung:

Neben der Preisstrategie (Faktor A) ist die Kommunikationsstrategie (Faktor B) von Interesse, und zwar in den alternativen Formen

Um die Wirkungen der Faktoren auf das Kaufverhalten zu untersuchen, wählt der Marketingleiter einen (3 x 2)-Versuchsplan, wobei auf die Kunden der ausgewählten Supermärkte jeweils eine unterschiedliche Kombination von Preis- und Kommunikationsstrategie wirken. An jeweils 10 zufällig ausgewählten Tagen werden die abgesetzten Mengeneinheiten der Margarine registriert. Die Resultate sind in der folgenden Tabelle wiedergegeben.

|

|---|

Modell der zweifachen Varianzanalyse für unabhängige Stichproben

Bei Vorliegen eines zweiten Faktors erweitert sich das einfaktorielle Modell zu

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle y_{i j l}=\mu+\alpha_{i}+\beta_{j}+\alpha \beta_{i j}+\varepsilon_{i j l} \qquad(i=1, \ldots, k ; j=1, \ldots, m ; l=1, \ldots n) }

wobei Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \varepsilon_{i j l} }

die Werte der metrischen Variable sind (Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle l}

-ter Wert bei Preispolitik Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle i}

und Kommunikationsstrategie Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle j}

), [Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \mu}

der unbedingte Erwartungswert (ohne Kenntnis der Gruppe), Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha}

der Effekt der jeweiligen Preispolitik, Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \beta_{j}}

der Effekt der jeweiligen Kommunikationsstrategie, Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha\beta_{j}}

jener Effekt ist, der sich aus der Kombination der Preispolitik Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle i}

mit der Kommunikationsstrategie Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle j}

zusätzlich ergeben könnte und Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \varepsilon_{i j l}}

der durch die drei Effektgruppen nicht erklärte Teil der abhängigen Variable ist. Die Annahmen für Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \varepsilon_{i j l}}

sind analog zum einfaktoriellen Modell.

Es kommen bei zwei erklärenden Faktoren also nicht zwei sondern drei Parametergruppen vor, weil es möglich ist, dass Kombinationen von Effekten andere Mittelwerte in der abhängigen Variable liefern. Dies wird im weiteren Verlauf der Analyse klarer.

Schätzen und Testen bei der zweifachen Varianzanalyse

Wie bei der einfachen Varianzanalyse können die einzelnen „Anteile“ an der Messung nun geschätzt werden.

Schätzung der durchschnittlichen Kaufmenge Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \mu} durch

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \hat{\mu}=\frac{1}{k * m * n} \sum_{i=1}^{k} \sum_{j=1}^{m} \sum_{l=1}^{n} y_{i j l} }

Schätzung des Effekts der Preispolitik i, Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle i, \alpha_i} , durch

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \widehat{\alpha_{i}}=\widehat{\mu_{l}}-\hat{\mu}=\frac{1}{m * n} \sum_{i=1}^{m} \sum_{l=1}^{n} y_{i j l}-\hat{\mu} }

Schätzung des Effekts der Kommunikationsstrategie j, Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle j, \beta_j} , durch

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \widehat{\beta_{j}}=\widehat{\mu_{j}}-\hat{\mu}=\frac{1}{k * n} \sum_{i=1}^{k} \sum_{l=1}^{n} y_{i j l}-\hat{\mu} }

Schätzung des Interaktionseffektes (Preispolitik vs. Kommunikationsstrategie) durch

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \widehat{\alpha \beta_{\imath \jmath}}=\widehat{\mu_{\imath j}}-\left(\hat{\mu}+\widehat{\alpha_{\imath}}+\widehat{\beta_{j}}\right)=\frac{1}{n} \sum_{l=1}^{n} y_{i j l}-\left(\hat{\mu}+\widehat{\alpha_{\imath}}+\widehat{\beta_{j}}\right) }

Schätzung des Fehlers Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \varepsilon_{i j l}} durch das Residuum

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \widehat{\varepsilon_{i j l}}=y_{i j l}-\widehat{y_{i j l}}=y_{i j l}-\left(\hat{\mu}+\widehat{\alpha_{l}}+\widehat{\beta_{j}}+\widehat{\alpha \beta_{l j}}\right) }

| Aufgabe 9

Berechnen Sie die Schätzungen für Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \hat{\mu}(1), \widehat{\alpha}_{i}(3) \widehat{\beta}_{j}(2) \text { und } \widehat{\alpha \beta_{i j}}\left(3^{*} 2=6\right) } |

|---|

Ob die in Aufgabe 9 berechneten deskriptiven Effekte signifikant sind, kann wieder analog obiger Vorgehensweise berechnet werden. Geprüft werden können nun drei Hypothesenpaare:

Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \begin{array}{ll} H_{0}^{(1)}: \alpha_{1}=\alpha_{2}=\alpha_{3}=0 & \rightarrow \text { Kein Einfluss der Preispolitik auf den Absatz } \\ H_{1}^{(1)}: \exists \alpha_{i} \neq 0 & \rightarrow \text { Einfluss der Preispolitik auf die Absatz } \\ H_{0}^{(2)}: \beta_{1}=\beta_{2}=0 & \rightarrow \text { Kein Einfluss der Komm.-Strategie auf den Absatz } \\ H_{1}^{(2)}: \exists \beta_{j} \neq 0 & \rightarrow \text { Einfluss der Komm.-Strategie auf den Absatz } \\ H_{0}^{(3)}: \alpha \beta_{11}=\alpha \beta_{12}=\alpha \beta_{21}=\alpha \beta_{22}=\alpha \beta_{31}=\alpha \beta_{32}=0 \\ H_{1}^{(3)}: \exists \alpha \beta_{i j} \neq 0 & \end{array} }

Interaktionen (Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \left(H_{1}^{(3)}\right)} ) bzw. keine Interaktionen (Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \left(H_{0}^{(3)}\right)} ) zwischen Preispolitik und Komm.-Strategie in Bezug auf den Absatz.

Für jede Hypothese kann nun wieder eine Quadratsumme, eine daraus abgeleitete, unter H0 F-verteilte Prüfgröße Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle F} , sowie zur Bestimmung der Signifikanz ein p-Wert berechnet werden.

| Fortsetzung Beispiel 3

In R wird das lineare Modell nun so spezifiziert:

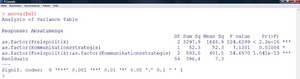

Man erhält dann folgende Tabelle (Abbildung 14): Alle p-Werte (Spalte rechts) sind kleiner als 5%. Daher wird in allen drei Fällen die Nullhypothese verworfen. Das Ergebnis ist (in Zusammenhang mit Aufgabe 9):

Die einzelnen Effekte (jene, die ausreichen, um das lineare Modell vollständig zu schätzen) können auch wieder mittels „lm1$coefficients“ ausgegeben werden. Folgender Befehl visualisiert diese Zusammenhänge schließlich noch in einem einfachen Liniendiagramm der Mittelwerte:

|

|---|

Ist ein balanciertes Design vorhanden (wie im Beispiel), macht es keinen Unterschied, in welcher Reihenfolge die Faktoren in die Gleichung eingegeben werden. Bei unbalancierten Designs ist die Interpretation der Signifikanzen schwieriger, da die Reihenfolge, in der die einzelnen Faktoren in die Gleichung eingehen, entscheidend ist.

Weitere Beispiele für varianzanalytische Designs

Varianzanalyse bei abhängigen Stichproben

Einfache Varianzanalyse für abhängige Stichproben

Wie beim t-Test für abhängige Stichproben kann auch eine Varianzanalyse für abhängige Stichproben berechnet werden. Beispielsweise, wenn Messung von Personen zu drei oder mehr Zeitpunkten vorliegen. In diesem Design können zwei Effekte geprüft werden: Unterschiede in der Versuchsbedingung (hier: Messzeitpunkt) und Unterschiede in den Versuchseinheiten (hier Personen).

Zweifache Varianzanalyse mit Messwiederholung

Hier können die Daten zum Beispiel zwei Gruppen von Personen (z.B. Männer und Frauen) sein, an denen je drei Messungen durchgeführt werden.

Unvollständige varianzanalytische Designs

Wenn nicht in allen Faktorkombinationen Daten erhoben werden, heißt das varianzanalytische Design „unvollständig“. Im folgenden werden zwei Beispiele für unvollständige Designs erwähnt.

Hierarchisches Design

Ein hierarchisches Design könnte sich beispielsweise dann ergeben, wenn man an der Wirkung eines Medikamentes, sowie am Behandlungserfolg verschiedener Spitäler interessiert ist. Sollen acht Medikamente und zwei Spitäler untersucht werden, ergibt sich ein Versuchsplan mit 2*8=12 Faktorkombinationen. Falls nun die Medikamente 1-4 nur in Spital 1 verwendet werden und die Medikamente 5-8 nur in Spital 2, dann können nicht wie in Beispiel 3 auch Wechselwirkungen auf Signifikanz getestet werden. Man sagt, dass der Faktor Medikament im Faktor Spital geschachtelt ist (auch „nested“). Dementsprechend müssen die Formeln der zweifaktoriellen ANOVA im vollständigen Design adaptiert werden.

Lateinisches Quadrat

Ein unvollständiges Design, das nicht durch mangelnde Verfügbarkeit der Daten, sondern vom Versuchsplaner selbst erzeugt wird, ist das „lateinische Quadrat“. Als Beispiel sei eine dreifaktorielle Varianzanalyse mit je drei Faktorstufen gegeben. Bei 10 Versuchseinheiten in jeder Kombination müsste man insgesamt 3*3*3*n Versuchseinheiten zur Verfügung haben. Stattdessen wird das Design auf z.B. 3*3 Faktorkombinationen gekürzt, sodass allerdings immer noch jede Faktorstufe und jede Kombination aus zwei Faktorstufen gleich oft vorkommt (Tabelle 1 und Tabelle 2). Der Vorteil dieses Designs liegt in der Kostenersparnis der Erhebung. Der Nachteil ist, dass nicht alle Hypothesen des vollständigen Designs prüfbar sind. Ist man ohnehin nur an den Einzelwirkungen der drei Faktoren und nicht an Interaktionen interessiert, fällt dieser Nachteil weg.

Tabelle 1: Übersicht über die gewählten Faktorkombinationen bei einer Kürzung

auf ein lateinisches Quadrat. Die Marker (X) geben an, welche Kombinationen tatsächlich gewählt werden

| B1 | B2 | B3 | |||||||

|---|---|---|---|---|---|---|---|---|---|

|

|

C1 | C2 | C3 | C1 | C2 | C3 | C1 | C2 | C3 |

| A1 | X |

|

|

|

|

X |

|

X |

|

| A2 |

|

X |

|

X |

|

|

|

|

X |

| A3 |

|

|

X |

|

X |

|

X |

|

|

Tabelle 2: Lateinisches Quadrat aus Tabelle 1 in Kurzschreibweise

| C1 | C2 | C3 | |

|---|---|---|---|

| A1 | B1 | B3 | B2 |

| A2 | B2 | B1 | B3 |

| A3 | B3 | B2 | B1 |

Wiederholungsaufgaben und Zusammenfassung

- Welche Bedeutung kommt der Quadratsummenzerlegung in der Varianzanalyse zu?

- Warum ist es wichtig, dass die Fehler normalverteilt sind?

- Sie erhalten bei einer einfaktoriellen Varianzanalyse mit Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha=5%} ein signifikantes Ergebnis. Wäre das Ergebnis auch signifikant, wenn Sie

- einen gleichgroßen Effekt (gleich große Mittelwertsdifferenzen) bei einem doppelt so großen Stichprobenumfang beobachten würden?

- einen gleichgroßen Effekt (gleich große Mittelwertsdifferenzen) bei einem halb so großen Stichprobenumfang beobachten würden?

- auf Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha=1%} testen?

Wie verändert sich der kritische Wert der F-Verteilung bei der Varianzanalyse, wenn Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\displaystyle \alpha} von 5% auf 1% gesenkt wird?

Zusammenfassung

Der Begriff „Varianzanalyse“ steht für eine große Zahl an Verfahren, bei denen mithilfe der Berechnung von Varianzen bzw. Quadratsummen inferenzstatistische Aussagen über Beziehungen verschiedener Variablen gemacht werden können („Quadratsummenzerlegung“). Dabei ist die Modellvorstellung immer, dass es eine oder mehrere gruppierende Variablen gibt, die auf eine metrische Variable einwirken (univariate ANOVA). Die Gruppeneinteilung kann „randomisiert“ erfolgen (indem die Versuchseinheiten zu verschiedenen Gruppen zugeordnet werden “Experiment“; Kausalschluss möglich) oder schon vorgegeben sein („Kranke vs. Gesunde“, „Männer vs. Frauen“, „Raucher vs. Nichtraucher“ „Beobachtungsstudie“; Kausalschluss nicht möglich).

Die Rechenschritte im Zuge einer Varianzanalyse betreffen einerseits die Parameterschätzungen des Modells welche auf die Berechnung von Gruppenmittelwerten und deren Differenzen hinauslaufen. Andererseits geschieht die Beurteilung, ob die in der Stichprobe gefundenen Unterschiede für die Grundgesmtheit verallgemeinert werden können, erst jeweils mittels des F-Tests, mittels Verteilungsannahmen, die sich aus der Forderung von normalverteilten Daten ableiten. Grundsätzlich gilt, dass soviele Hypothesen wie Effektgruppen vorhanden sind, getestet werden können.

Die Ergebnisse der Hypothesenprüfung werden jeweils in einer „Tafel der Varianzanalyse“ übersichtlich zusammengefasst.

Clusteranalyse

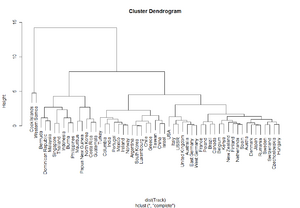

Das Verständnis der Idee, die hinter clusteranalytischen Verfahren steckt, der Grundbegriffe und der Basis-Algorithmen, sowie die Durchführung einer Clusteranalyse in R sind die wesentlichen Ziele von Lektion 3.

Einführung und Beispielfragestellungen

Während in den beiden vorangegangenen Kapiteln jeweils untersucht wurde, in welcher Form eine oder mehrere Merkmale von einer Reihe von weiteren Merkmalen abhängen, ist man bei der Clusteranalyse daran interessiert, die unterschiedlichen Beobachtungseinheiten (Personen, Unternehmen, Produkte,usw.) in einzelne Gruppen – die sogenannten „Cluster“ – zu teilen. Die Einteilung soll jeweils Beobachtungseinheiten zusammenfassen, die untereinander recht ähnlich und von Einheiten anderer Gruppen recht unterschiedlich sind.

Die Clusteranalyse untersucht nun im Wesentlichen,

- ob und wie gut eine solche Einteilung möglich ist,

- in wieviele Gruppen die beobachtete Stichprobe geteilt werden soll und

- wie die verschiedenen gefundenen Gruppen charakterisiert werden können.

Ziel ist es also, die Daten derart zu strukturieren, damit die einzelnen Merkmalsträger mit verschiedenen „Etiketten“ versehen werden können (“Typenbildung“). Während insbesondere mit der Varianzanalyse, aber auch mit der Regressionsanalyse bestehende Hypothesen geprüft werden können, wird die Clusteranalyse zu den hypothesengenerierenden („exploratorischen“) Verfahren gezählt. Die Daten werden hier meistens ohne Vorstellungen über die statistische Verteilung der einzelnen Gruppen analysiert. Auch können die Variablen der Clusteranalyse beliebiges Skalenniveau aufweisen.

Im folgenden einige Beispiele für den Einsatz von Methoden zur Cluster-Bildung:

- Klassifikation von Verkehrsunfällen anhand von 20 binären Merkmalen (Vogel, 1975), die zum jeweiligen Unfall erhoben wurden, unter anderen anhand der Merkmale „Werktag vs. Wochenende“, „Autobahn vs. Stadtgebiet“, „Alkoholeinfluss ja/nein“,usw..

- Ein Marktforschungsinstitut analysiert Lifestyle und Konsumentenprofile und ermittelt daraus verschiedene Kundensegmente. Die Personen werden dann beispielsweise in „Weltoffene Etablierte“, „Konsumeinsteiger“, „Bodenständige“, usw. eingeteilt. Weiters werden die Marktanteile der einzelnen Segmente berechnet.

- „Semantisches Differential“: Es kann bestimmt werden wie ähnlich sich bestimmte Worte bezüglich ihrer konnotativen Bedeutung sind. Die verschiedenen Dimensionen, die die konnotative Bedeutung beschreiben, werden mittels faktorenanalytischer Methoden (Lektion 5) anhand einer Stichprobe von wertenden Personen bestimmt.

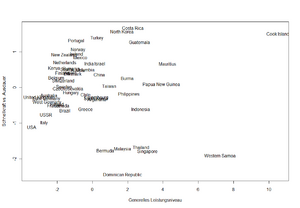

- Klassifikation verschiedener europäischer Länder nach Anteil der Angestellten in Landwirtschaft, Bauwirtschaft, Sozialarbeit, Finanzektor, usw..

- Biologie: Gruppierung von Bakterien und Mikroorganismen

Weitere Bezeichnungen für die Clusteranalyse sind „Klassifikationsverfahren“, „Unsupervised Learning“ oder auch „Pattern Recognition“.

Grundlagen der Clusteranalyse

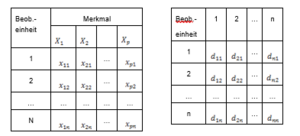

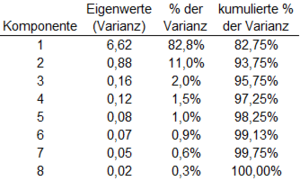

Ähnlichkeit und Distanzmaße