WI411 - Wissenschaftstheorie und -praxis in der Wirtschaftsinformatik

Wissenschaftstheorie

Ziele der Lektion

Ziel dieser Lektion ist es, sich mit den grundlegenden Begriffen der Wissenschaften auseinanderzusetzen. Einerseits soll erörtert werden, was eine Wissenschaft erst zu einer Wissenschaft macht, andererseits sollen verschiedene erkenntnistheoretische Positionen vorgestellt werden.

Verständnis für die Verortung der eigenen wissenschaftlichen Arbeit im System der Wissenschaft soll geweckt werden.

Wieso Wissenschaftstheorie?

Für jeden Wissenschaftler, jede Wissenschaftlerin ist es wichtig, sich mit dem Konzept der Wissenschaften auseinandersetzen. Es ist weiters wichtig darüber nachzudenken, wie Wissen entsteht, das andere produzieren, aber auch wie Wissen entsteht, das wir selbst produzieren. WissenschaftlerInnen wollen, dass ihre eigenen Arbeiten an den wissenschaftlichen Diskurs anschließen. Um diese Anschlussfähigkeit zu garantieren, müssen bestimmte Grundbedingungen erfüllt sein. Für Ihre KollegInnen wird es mitunter wichtig sein, nachvollziehen zu können, von welcher wissenschaftstheoretischen Grundposition Sie in Ihren Arbeiten ausgehen. Andererseits ermöglicht ein Grundwissen in Erkenntnistheorie Kritikfähigkeit. Sich damit zu beschäftigen, wie und mit welchen Methoden andere ForscherInnen Wissen produzieren, heißt sich damit auseinanderzusetzen, ob die Ergebnisse und Forschungsbedingungen den wissenschaftlichen Gütekriterien entsprechen. Als Wissenschaftler, als Wissenschaftlerin ist es wichtig, sich mit den Spielregeln der eigenen Disziplin auseinanderzusetzen.

Was ist Wissenschaft?

Unter den Begriff der Wissenschaft fallen so unterschiedliche Disziplinen wie Informatik, Rechtswissenschaft, Soziologie, Religionswissenschaften, Mikrobiologie. Was haben alle diese Disziplinen gemeinsam?

Dass sich Wissenschaft mit Wissen beschäftig, lässt sich bereits aus dem Namen ableiten. Wissenschaft schafft Wissen, indem sie dieses produziert, sammelt und ordnet. Wissen wird somit zum Produkt der Wissenschaften. Es dient als Input in andere (soziale) Systeme, wie Technik, Wirtschaft, Politik oder die Medizin.

Aber was ist nun eigentlich Wissen in einem wissenschaftlichen Sinne? Wie lässt sich wissenschaftliches Wissen von Alltagswissen abgrenzen?

Zuerst wollen wir uns grundlegend überlegen, was Wissen bedeutet. Das Wort Wissen stammt vom althochdeutschen Wort „wissan“ ab, was so viel bedeutet wie etwas gesehen haben. Auch heute noch entsteht Wissen, indem Menschen empirisch etwas beobachten, sich darüber eine Meinung bilden, die Wahrheit beanspruchen und diese Wahrheit begründen müssen. Dass Wissen glaubhaft begründet werden muss, unterscheidet Wissen auch von Glauben und Intuition. Wenn diese Begründung hält, dann kann von Wissen gesprochen werden. Dennoch entsteht Wissen nicht nur aus empirischen Beobachtungen, sondern kann auch durch logisches Denken weiterentwickelt werden. Gemein ist dem Wissen, dass es aus wahren Sätzen besteht, die geglaubt werden und für deren Gültigkeit überzeugende Gründe sprechen.

Für wissenschaftliches Wissen bestehen jedoch strengere Richtlinien. Wissenschaft will dieses Wissen systematisch erfassen und ordnen. Die Grundprämisse von Wissenschaft ist die Erzeugung von wahrem Wissen. Die Unterscheidung zwischen wahr/falsch wird damit zur Leitdifferenz. Die Wissenschaften arbeiten mit an die Disziplinen angepassten Theorien und Methoden und mit dem Ziel, wahre – im Sinne von überprüften – Aussagen über die Welt oder über bestimmte Ausschnitte der Welt zu treffen. Wissenschaft gibt eine Struktur des wissenschaftlichen Beobachtens vor und Wissenschaft definiert die Elemente von Forschungsbedingungen.

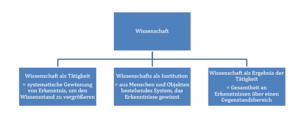

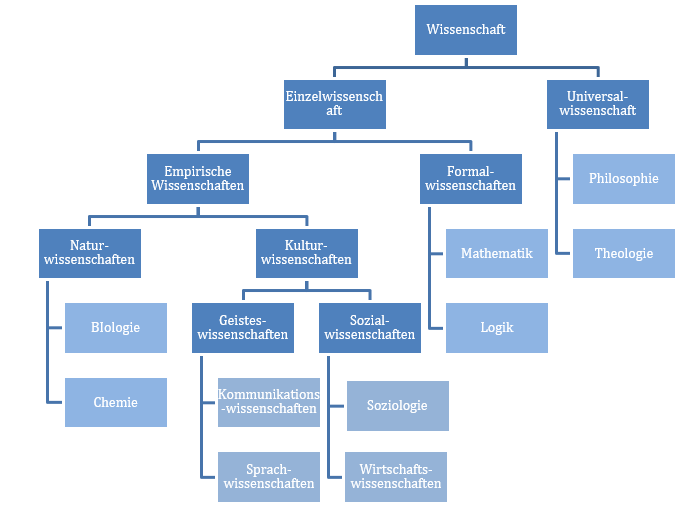

Wie folgende Grafik zeigt, kann unter dem Begriff der Wissenschaften Unterschiedliches verstanden werden.

- Wissenschaft als Tätigkeit

Wissenschaft kann als der Prozess gesehen werden, im Laufe dessen systematisch Erkenntnisse gewonnen werden und unser Wissen vergrößert wird. Genau diese systematische (einem vorgeschriebenen als wissenschaftlich definierten Prozess folgende) Vorgangsweise unterscheidet wissenschaftliche Wissensgewinnung von alltagswissenschaftlicher. Wichtig ist hierbei auch die intersubjektive Überprüfbarkeit: Andere WissenschaftlerInnen überprüfen, wie die eigenen Ergebnisse entstanden sind. Sie können damit den Weg der Erkenntnisgewinnung kritisieren.

- Wissenschaft als Institution

Der Ort der Wissenschaft ist institutionalisiert. Das heißt, Wissenschaft kann auch als ein aus Menschen und Objekten bestehendes System (nach der Systemtheorie) verstanden werden mit dem Ziel der Erkenntnisgewinnung mit der Leitdifferenz wahrfalsch. Wissenschaft geschieht in Universitäten, Akademien, Forschungsinstituten, Bücher, Zeitschriften, Kongressen etc.

- Wissenschaft als Ergebnis der Tätigkeit

Die Gesamtheit der Ergebnisse (basierend auf wissenschaftlichen Tätigkeiten) über einen Gegenstandsbereich (z.B. Wirtschaftsinformatik), die in einem Begründungszusammenhang, also eingebettet in einen theoretischen Rahmen, stehen. (Kornmeier, 2007, S. 4f.)

Wissenschaftstheorie, -philosophie

Die Wissenschaftstheorie will aufklären, wie Wissenschaft eigentlich funktioniert oder wie wissenschaftliches Wissen erzeugt wird. Sie setzt sich mit den Bedingungen auseinander, unter denen Wissenschaft entsteht und betrieben wird. Sie reflektiert systematisch wissenschaftliche Methoden, die begrifflichen Strukturen wissenschaftlicher Theorien oder die breiteren Konsequenzen wissenschaftlicher Lerninhalte. Sie klärt wissenschaftliche Begriffe und Aussagen, wissenschaftliche Methoden und Theorien (Carrier, 2006). Die Wissenschaftstheorie zählt im Gegensatz zu den Einzelwissenschaften zu den Meta-Wissenschaften. Sie will dazu beitragen, dass die einzelnen WissenschaftlerInnen sich im Klaren sind, welche (Vor-)Annahmen sie über die Welt und die Erkenntnis von Phänomenen haben.

Wissenschaftsgeschichte

Die Wissenschaftsgeschichte beschäftigt sich mit dem Wandel der wissenschaftlichen Lehrinhalte, der wissenschaftlichen Praxis und des wissenschaftlichen Institutionensystems. So beschäftigt sich die Wissenschaftsgeschichte mit den gegenwärtigen Entwicklungen im Wissenschaftssystem. Derzeit berichtet sie beispielsweise von der Entwicklung, dass die Wissenschaft in den vergangen Jahrzehnten verstärkt einem Anwendungsdruck aus Wirtschaft, Politik und Öffentlichkeit ausgesetzt ist. Die Gewinnung von praktischem, technisch verwertbarem Wissen steht vermehrt im Vordergrund.

Naturphänomene sollen kontrolliert werden. Erkenntnis der Erkenntnis willen reicht nicht mehr aus. Es entstehen Industrielabore und Forschungsverbünde zwischen den Universitäten. Erkenntnisse aus den Wissenschaften stehen vermehrt in einem wirtschaftlichen Verwertungszusammenhang (z.B. Patentierungen). Diese Veränderungen werden von der Wissenschaftstheorie und -geschichte thematisiert und kritisch hinterfragt. (Carrier, 2006, S. 10f.)

Wissenschaftliche Arbeit

Die Grundlage der wissenschaftlichen Arbeit bilden die beiden Säulen Theorie und Empirie (durch Experiment bzw. Beobachtung). Das Zusammenspiel dieser beiden Teilbereiche gab es nicht immer. So war Aristoteles (384¬–322 v.Chr.) beispielsweise davon überzeugt, dass Gesetzmäßigkeiten allein durch Denken, also nur durch die Theorie, eruiert werden können. Der logische Schluss (Syllogismus) des Aristoteles ist eine aus drei Urteilen bestehende Schlussfolgerung vom Allgemeinen zum Besonderen (eine besondere Form der Deduktion). Das heißt, nach der Grundhaltung von Aristoteles kann Erkenntnis allein durch den Intellekt erfolgen und es bedarf keiner Verifikation durch Beobachtungen der realen Welt. Erst zur Zeit der Aufklärung im 16. Jahrhundert, zur Zeit von Galileo Galilei (1564–1642) begann sich eine moderne, wissenschaftliche Methode zu entwickeln, bei der es Usus wurde Gesetze durch Beobachtung zu bestätigen (Müller, 2004). Unter anderem grenzte sich Francis Bacon (1561–1626) von der Scholastik des Mittelalters ab, die auf die begrifflich deduktive Logik von Aristoteles aufbaute und nicht durch Beobachtung, sondern allein durch die Vernunft, durch eine rein geistige Wesensschau zur Erkenntnis über Seinsgründe gelangen wollte.

Aufbauend auf Wissenschaftlerkollegen wie Galileo Galilei oder auch seinem Namensvetter Roger Bacon, der früher wirkte aber wieder in Vergessenheit geriet (1214–1292), stand Bacon für das Experiment und Naturbeobachtungen ein und baute seine Methodenlehre auf einem dreiphasigen Modell auf: die Ermittlung der Tatsachenbasis (Empirie), die Angabe induktiver Verallgemeinerung und die deduktive Prüfung von Wissensansprüchen. Bacon gilt daher als der Wegbereiter einer empirischen Wissenschaft, die auf präzisen Versuchen anstatt auf gelehrten Diskursen beruht (Carrier, 2006, S. 16ff.).

Das Experiment ist bis heute eine der wesentlichen Methoden (nicht nur) der Naturwissenschaften, wenn auch mit anderen Begründungen als unter Bacon, da das Experiment die einzige Methode ist, die haltbare Aussagen über Kausalbeziehungen zulässt. Es ist ein gezielter Eingriff in ein System zum Zweck der Erkenntnisgewinnung, behält aber dabei die Kontrolle über die Situationsumstände. Die Parameter können dabei systematisch variiert und einzelne Einflussfaktoren gezielt verändert werden (Carrier, 2006, S. 20f.).

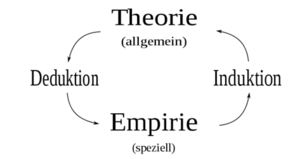

Theorie und Empirie

Was ist eine Theorie?

Theorien sind

- Erklärungsmodelle für Phänomene

- Annäherungen an die Wahrheit/Wirklichkeit

- Nur gültig, solange sie nicht widerlegt werden.

- Versuche, kausale Zusammenhänge herzustellen (Variable X Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \rightarrow} Variable Y)

Theorien sind systematisch geordnetes Wissen über die Wirklichkeit, das in Sprache ausgedrückt wird. Theorien sollen Komplexität reduzieren und Zusammenhänge (Kausalstrukturen) erklären oder dazu beitragen Wirklichkeit zu verstehen. Theorien leiten unseren Forschungsprozess an. Jede Theorie will beschreiben, verstehen, erklären oder prognostizieren.

Theorien stehen in einem Wechselspiel zur Empirie. Wir haben keinen direkten Zugang zur Wirklichkeit, sondern nur zu Manifestationen der Wirklichkeit (Empirie).

Was ist Empirie?

Das Wort Empirie stammt vom griechischen „Empireia“: Erfahrung, Erfahrungswissen. Empirische Wissenschaften (siehe oben) beschäftigen sich mit der Erklärung beobachtbarer Tatsachen (Naturwissenschaften, Sozialwissenschaften), im Gegensatz dazu stehen nicht-empirische Wissenschaften wie Mathematik, Logik und Philosophie. Unter Empirie werden Erfahrungen (oder auch Informationen bzw. Daten) verstanden, die basierend auf Beobachtungen von Sachverhalten und Objekten für die Bildung von Theorien (Induktion) oder Prüfung von Theorien (Deduktion) herangezogen werden.

Die Manifestationen der Wirklichkeit, z.B. ein Sachverhalt, werden beobachtet und systematisch dokumentiert. Empirie ist immer konkret. Aufgabe der Wissenschaft ist die Verallgemeinerung und damit die Entwicklung von Theorien aus dem konkreten, was in der Wirklichkeit passiert.

Beobachtungen zeichnen sich durch Stabilität, Kohärenz und Intersubjektivität aus. Das heißt, Beobachtungen vermitteln über größere Zeitspannen hinweg un-veränderte Eindrücke der Sachverhalte, die auch durch große willentliche Anstrengungen nur selten grundlegend zu beeinflussen sind. Die genaue Sach-angemessenheit von Beobachtungen ist nicht überprüfbar, wir können nicht die subjektiven Beobachtungen und Sachverhalt miteinander vergleichen, sondern nur Beobachtungen mit Beobachtungen. Dennoch ist bedingt durch die Stabilität, Kohärenz und Intersubjektivität von Beobachtungen davon auszugehen, dass Beobachtungen Aufschlüsse über Sachverhalte zulassen. (Carrier, 2006, S. 58f.)

Oftmals braucht es für die Beobachtung von Sachverhalten eigens entwickelte Beobachtungs- und Messverfahren, also wissenschaftliche Methoden, die mittels klarer Anwendungskriterien die Prüfbarkeit und die Objektivität der Prüfung stärken. Durch die Aufzeichnung von Empirie entstehen Daten. Empirische Daten können durch gezielte Beobachtungen, Experimente oder Befragungen erhoben werden.

Deduktion/Induktion

Erkenntnis baut auf logischen Schlüssen auf. Es wird unterschieden zwischen Induktion und Deduktion.

Induktion (Herbeiführen)

In der induktiven Sichtweise liegt der Schwerpunkt auf der Theoriegewinnung. Vom Besonderen, vom konkret Beobachteten wird auf das Allgemeine geschlossen und Theorien werden gebildet. Als Beispiel eines möglichen Induktionsschlusses gilt Folgendes: Prämissen: „Sokrates ist sterblich.“ und „Sokrates ist ein Mensch.“ Konklusion: „Alle Menschen sind sterblich.“

Beim Arbeiten mit Induktionen gilt es vorsichtig zu sein, denn durch Induktion können Zusammenhänge auch falsch bewertet werden. Bei dem zuvor genannten Beispiel wäre „Alles Sterbliche ist menschlich.“ ein induktiver Schluss mit offensichtlich falschem Ergebnis. Dennoch gehen ForscherInnen, die einem induktiven Ansatz folgen, ihr Forschungsvorhaben offener und theorieloser an als deduktiv arbeitende WissenschaftlerInnen. Die Anwendung von Induktion tritt besonders dann als Komponente des Denkens in den Vordergrund, wenn es darum geht, Hypothesen aufzustellen und zu überprüfen, Bedingungszusammenhänge aufzuspüren, Voraus¬sagen zu machen oder Wahrscheinlichkeiten für das Auftreten bestimmter Ereignisse festzulegen.

Deduktion (Ableiten)

Aus bereits bestehenden Theorien werden Aussagen abgeleitet, die wir in der Wirklichkeit beobachten können, vom Allgemeinen wird auf das Besondere geschlossen. Aus den bestehenden Theorien werden Aussagen gewonnen, die in der Wirklichkeit beobachtet werden können. Durch die Prüfung von bestehenden Theorien bzw. Hypothesen können Theorien falsifiziert werden. Auch in der deduktiven Sichtweise müssen Theorien aus der Empirie heraus entwickelt werden. Jedoch ist das für die AnhängerInnen einer deduktiven Vorgangsweise kein wissenschaftlicher Vorgang. Erst mit der Überprüfung der Theorien bzw. Hypothesen beginnt der eigentliche wissenschaftliche Vorgang.

Zur Anwendung kommt die Deduktion in der deduktiv-nomologischen Erklärungsmethode. Bei diesem Ansatz wird aus mindestens einer nomologischen Aussage (=Gesetzesaussage) und mindestens einer Randbedingung (=Antezendenz-bedingung) auf die zu erklärende Beobachtung geschlossen (Popper, 1935). Gesetzesaussage und Randbedingung werden als Explanans, der zu erklärende Sachverhalt als Explanandum bezeichnet. Die Gesetzmäßigkeit ist eine generelle Aussage. Die Randbedingung/Antezedenzbedingung ist eine singuläre Aussagen. Während die Sachlage der Randbedingung als Ursache bezeichnet wird, versteht man den Sachverhalt des Explanandum auch als Wirkung. Um das Prinzip der deduktiv-nomologischen Erklärungsmethode zu veranschaulichen, verwendet der österreichisch-britische Philosoph und Wissenschaftstheoretiker Karl Popper (1903-1994) folgendes Beispiel: Alle Menschen sind sterblich. Weil Sokrates ein Mensch ist (Ursache), ist er sterblich (Wirkung).

| Gesetzesaussage/ nomologische Aussage | Alle Menschen sind sterblich | Explanans |

|---|---|---|

| Randbedingung | Sokrates ist ein Mensch | Explanans |

| Schlussfolgerung | Sokrates ist sterblich | Explanandum |

Heutzutage gibt es in der Forschungspraxis oftmals eine Kombination aus einer deduktiven und einer induktiven Herangehensweise.

Falsifikation

Karl Popper (1935) hat dieses Prinzip der Falsifikation in die Wissenschaftstheorie eingebracht. Theorien müssen konkret genug sein, um empirisch überprüft und gegebenenfalls widerlegt (falsifiziert) werden zu können. Je häufiger eine Theorie einem Falsifikationsversuch widerstanden hat, desto eher kann sie als vorläufig wahr gelten. Popper selbst unter¬stützte deterministische Theorien. Diese sind aber häufig falsch und ein Anwenden von deterministischen Theorien kann zu einem unfruchtbaren Falsifikationismus führen.

Deterministische vs. Probabilistische Theorien

Deterministische Theorien beanspruchen immer Gültigkeit. Eine widersprüchliche empirische Beobachtung genügt, um eine Theorie zu widerlegen. Probabilistische Theorien hingegen geben lediglich eine starke Tendenz an. Diese Theorien sind weniger greifbar und schwieriger zu überprüfen.

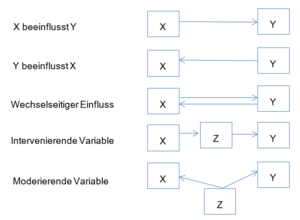

Kausalität

Theorien geben in der Regel Ursache-Wirkungs-Zusammenhänge an. Die Ermittlung von Kausalbeziehungen zählt zu den zentralen Herausforderungen der Wissenschaften. Dazu müssen die Ursachen- und Wirkungserscheinungen identifiziert werden. Das heißt Untersuchungsgegenstand ist, welche Variable/welches Merkmal der Ursache (unabhängige Variable) und welche Variable der Wirkung zugeordnet werden kann (abhängige Variable). Die Ursache muss immer vor der Wirkung eingetroffen sein.

Entdeckt man in einer empirischen Studie einen Zusammenhang zwischen zwei Variablen, ist es oftmals nicht möglich, die Richtung des Zusammenhangs zu bestimmen. Es stellt sich die Frage, welche Variable für die Wirkung verantwortlich ist und bei welcher Variable sich die Ursache widerspiegelt oder ob gar eine Wechselwirkung zwischen den Variablen vorherrscht. Besonders zu beachten sind auch mögliche Scheinkorrelationen. Das heißt, dass eine dritte (möglicherweise unbekannte) Variable auf die beiden korrelierenden Variablen Einfluss nimmt (mehr zu Korrelation siehe unten).

Die Wirtschaftsinformatik in der Landkarte der Wissenschaften

Um sich in seiner eigenen Disziplin bzw. Wissenschaftskultur zu platzieren, ist es notwendig, sich in der Landkarte der Wissenschaften zu orientieren. Gerade in Zeiten der zunehmenden Zergliederung und Spezialisierung der Wissenschaften, ist es wichtig, den Blick auf das Ganze zu bewahren. Wir wollen uns nun mit der Frage befassen, wie die Wirtschaftsinformatik in das System der Wissenschaften einzuordnen ist.

Die Beschreibung und Einordnung der verschiedenen Wissenschaften ist, wie uns die Wissenschaftsgeschichte zeigt, einem geschichtlichen Wandel unterworfen. Das weist darauf hin, dass die Einteilung der Wissenschaften nicht objektiv ist, sondern von den WissenschaftlerInnen selbst getroffen wird. Wir selbst sind es, die die Merkmale bestimmen, um die Trennlinie zwischen den Disziplinen zu schaffen (Foucault, 2009).

Unterscheidung nach Art der Erkenntnis

Unterschieden wird zuallererst zwischen Erfahrungswissenschaften (empirischen Wissenschaften) und nicht-empirischen Wissenschaften (siehe Empirie). Während die empirischen Wissenschaften durch gezielte Beobachtungen im Labor oder im Feld ihre Theorien weiterentwickeln, verifizieren oder falsifizieren die nicht-empirischen Wissenschaften ihre Erkenntnisse ohne solche Beobachtungen anhand von logischen Überlegungen (z.B. Beweisen).

Beispiele für empirische und nicht-empirische Wissenschaften:

- Empirische Wissenschaften: Biologie, Physik, Soziologie etc.

- Nicht-empirische Wissenschaften: Mathematik, Philosophie, Rechtswissenschaften etc.

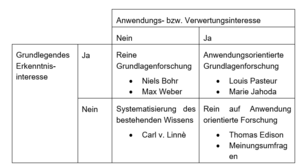

Unterscheidung nach Anwendung und Erkenntnis

Im deutschsprachigen Raum ist es durchaus üblich, zwischen anwendungsorientierter und Grundlagenforschung zu unterscheiden. Die Zuordnung zu einer der beiden Kategorien ist oftmals schwierig. Eine Definitionsmöglichkeit ist beispielsweise die Finanzierung des Forschungsvorhabens. Ist der Forscher, die Forscherin an einer Universität angestellt und kann er frei über sein Forschungsvorhaben entscheiden, kann er sich den Grundlagen seiner Wissenschaftsdisziplin widmen. Ist er jedoch von Auftraggebern abhängig und handelt im Auftrag von externen Geldgebern, wird seine Forschungsarbeit oftmals an der Anwendbarkeit seiner Ergebnisse orientiert sein. Donald Stroke (1997) argumentiert, dass es neben dieser Zweiteilung der Wissenschaft auch noch eine anwendungsorientierte Grundlagenforschung gibt.

Unterscheidung nach Wissensgebieten

Das wissenschaftliche System entwickelte sich im Laufe der Zeit zunehmend komplexer, so dass es notwendig wurde auf die zunehmende Spezialisierung mit einer Aufteilung der Wissenschaft in viele einzelne Disziplinen zu reagieren. Als grundlegende Unterscheidung gilt die Trennung von Universal- und Einzelwissenschaften. Als Universalwissenschaften gelten die Philosophie und die Theologie. Während letzterer oftmals die Wissenschaftlichkeit abgesprochen wird, zeichnet sich die Philosophie dadurch aus, dass sie sich nicht auf ein einzelnes Wissensgebiet beschränkt, sondern die Gesamtheit der Wirklichkeit betrachtet.

Die Einzelwissenschaften hingegen werden oftmals in drei grobe Bereiche eingeteilt: in die Natur-, Strukturwissenschaften, sowie Kulturwissenschaften (Anzenbacher, 1981). Innerhalb dieser verschiedenen Gruppen gibt es diverse Disziplinen. Durch Differenzierung entstehen neue Zweige von Wissenschaften. Naturwissenschaften untersuchen eine Wirklichkeit, deren Existenz an sich sie nicht beweisen, sondern voraussetzen, nämlich Naturerscheinungen und Naturgesetze. Das Kenntnisobjekt der Naturwissenschaften ist die Materie, also die Erforschung der belebten wie der unbelebten Natur. Naturwissenschaft versammelt jene Disziplinen, die sich mit Naturobjekten auseinandersetzen. Sie beschreiben die Eigenschaften dieser Objekte und erklären sie aus den gesetzmäßigen Verknüpfungen und Beziehungen der Dinge im Raum. Von der äußeren Wahrnehmung ausgehend und mit Hilfe der Grundbegriffe des logischen Denkens bestimmen die Naturwissenschaften den Inhalt der äußerlichen Erfahrung in begrifflicher, nach Möglichkeit mathematisch-quantitativer Weise. Zu den klassischen Methoden der Naturwissenschaften zählen das Experiment und die Modellbildung. Dabei greifen sie auf mathematische Methoden zurück. Unter die klassischen Naturwissenschaften fallen Biologie, Chemie, Physik und Geologie. (Eisler, 1904, S. 721f.)

Die Ingenieurwissenschaften versuchen Erkenntnisse aus den Naturwissenschaften praktisch anzuwenden und für die Lösung und Realisierung von technischen Problemen, Verfahren oder Produkten zu gebrauchen. Zu den Struktur- oder Formalwissenschaften zählen die Mathematik, Logik, theoretische Informatik, Systemtheorie. Der Gegenstandsbereich der Strukturwissenschaften ist die gesamte Wirklichkeit. Sie suchen nach Gesetzmäßigkeiten, denen abstrakte Strukturen unterliegen und zwar unabhängig davon, ob sich diese Strukturen in unbelebten oder belebten, natürlichen oder künstlichen Systemen wiederfinden.

Die Strukturwissenschaften, allen voran die Mathematik, bilden die Basiswissenschaften für das Verständnis schlechthin. Mittels strukturwissenschaftlicher Methoden wird von den qualitativen Eigenschaften eines Gegenstandes abstrahiert und die Wirklichkeit durch mathematische Begriffe, Symbole und deren Transformationen ersetzt. (Küppers, 2000)

Zu den Kulturwissenschaften zählen die Geisteswissenschaften und die Sozialwissenschaften. Zwischen diesen beiden Gebieten gibt es viele Überschneidungen. Die Sozialwissenschaften stehen aus ihrer geschichtlichen Entwicklung heraus den Naturwissenschaften näher. Sie wollen Phänomene gesellschaftlichen Zusammenlebens ursächlich erklären. Sie verwenden hierzu traditionell positivistische Ansätze, die Kausalzusammenhänge bestätigen wollen. Die Geisteswissenschaften wollen diese Phänomene hingegen verstehen, nachvollziehen und die Motivation der handelnden Individuen erfassen.

Zu den Geisteswissenschaften zählen u.a. die Philosophie, Kommunikationswissenschaft, Sprachwissenschaften, Geschichtswissenschaften, Kunstwissenschaften sowie die Rechtswissenschaften (Wissenschaftsrat, 2006, S. 17). Zu den Sozialwissenschaften zählen Disziplinen wie die Soziologie, Wirtschaftswissenschaften und die Politikwissenschaften. Disziplinen wie die Kommunikationswissenschaften oder die Rechtswissenschaften werden je nach Art ihres Empiriebezugs und der Ausrichtung entweder den Sozial- oder den Geisteswissenschaften zugeordnet. Da die Abgrenzung von Geistes- und Sozialwissenschaften immer schwieriger wurde, wurde mit Humanwissenschaften ein neuer Begriff geschaffen. Zu den Humanwissenschaften zählen alle Disziplinen, die sich mit dem Menschen und seiner Kultur beschäftigen.

Eine Aufstellung dieser Art, in der Geschichte auch oft Baum des Wissens genannt, ermöglicht einen Überblick. Sie wurde aber in den letzten Jahrzehnten oftmals hinterfragt. Es gibt zu viele Schnittstellen. Viele Wissenschaften lassen sich nicht klar einem Bereich zuordnen.

Interdisziplinarität

Die große Spannbreite an unterschiedlichen wissenschaftlichen Disziplinen ruft auch die Interdisziplinarität ins Leben. Interdisziplinarität ist die Zusammenarbeit von WissenschaftlerInnen aus unterschiedlichen Disziplinen, um gemeinsam an der Entwicklung und Umsetzung von Forschungsprojekten zu arbeiten. Dies betrifft auch die Wirtschaftsinformatik.

Transdisziplinarität

Neue Wege des Denkens gehen über die disziplinären Grenzen hinaus. Zeitgenössische Forschung findet zusehends in einem anwendungsorientierten Kontext statt. Die Problemformulierung wird dialogisch in einem Kommunikationsprozess mit verschiedenen Stakeholder ausgehandelt.

„Disziplinen sind nicht mehr die entscheidenden Orientierungsrahmen für die Forschung noch für die Definition von Gegenstandsbereichen. Statt dessen ist die Forschung durch Transdisziplinarität charakterisiert: Die Problemlösungen entstehen im Kontext der Anwendung, transdisziplinäres Wissen hat seine eigenen theoretischen Strukturen und Forschungsmethoden, die Resultate werden nicht mehr über die institutionellen Kanäle, sondern an die am Forschungsprozess Beteiligten kommuniziert (Gibbons et al., 1194, 5; Funtowicz/Ravetz, 1993, 109).“ (Weingart 1997)

Wirtschaftsinformatik

Die Wirtschaftsinformatik ist eine junge Wissenschaft, die ihre Systemgrenzen und -inhalte noch genau definieren muss. Sie ist eine interdisziplinäre Wissenschaft, die neben ihren eigenen Inhalten sehr stark auf Wissenschaften wie Informatik, Mathematik, Betriebswirtschaft und Kommunikationswissenschaft Bezug nimmt. Die Informatik oder Computerwissenschaft selbst ist im Vergleich zu den traditionellen Wissenschaftsdisziplinen wie Physik, Medizin oder Rechtswissenschaft eine relativ junge Wissenschaftsdisziplin. Erste Ausbildungsprogramme gab es erst seit den 1950er und 1960er Jahren. Gerade diese jungen Disziplinen haben oftmals ein starkes Bedürfnis nach Selbstreflexion und -positionierung. Schließlich hat die Informatik eine große gesellschaftliche Relevanz, schaut man sich die hohe Dichte an Nutzung von Informations- und Kommunikationstechnologien in professionellen wie privaten Lebensbereichen an. (Bruckner, 2007, S. 3)

Wesentliche erkenntnistheoretische Positionen

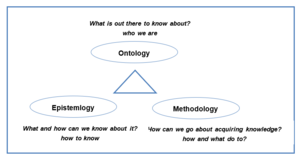

Bevor die wesentlichen erkenntnistheoretischen Positionen unserer Zeit diskutiert werden sollen, müssen vorab noch einige wichtige Begrifflichkeiten geklärt werden, wie die Unterscheidung zwischen Ontologie, Epistemologie und Methodologie.

Ontologie – Welt an „sich“: Wissenschaft vom Sein, vom Seienden als solchem, von den allgemeinsten, fundamentalen, konstitutiven Seinsbestimmungen (=allgemeine Metaphysik) (Eisler, 1904). Grundsätzliche Fragen der Ontologie als Disziplin der theoretischen Philosophie sind: „Gibt es eine reale Welt, die unabhängig von unserem Wissen über sie besteht?“, „Was existiert?“, „Was kann erforscht werden?“.

Epistemologie – Erfahrbarkeit der Welt: Die Epistemologie (Erkenntnistheorie) beschäftigt sich damit, wie Wissen zustande kommt. Die Grundfrage der Epistemologie ist, ob ein Beobachter, eine Beobachterin die Wirklichkeit erkennen kann oder nicht. Methodologie: Unter Methodologie wird die Lehre von den Methoden verstanden (Methoden siehe unten). Sie stellt sich die Fragen nach den Mitteln und Methoden, mit denen systematisch Wissen gewonnen werden kann.

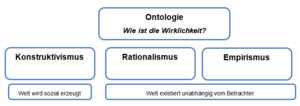

Erkenntnisfortschritt zählt zu den wesentlichen Aufgaben der Wissenschaften. Die Frage, die sich nun stellt, bezieht sich auf das „wie“ der Forschung, um an neue Erkenntnisse zu kommen. In den meisten wissenschaftlichen Disziplinen gibt es verschiedene Auffassungen von Erkenntnistheorie (=Epistemologie) bzw. Wissenschaftstheorie. Die erkenntnistheoretischen Positionen bestimmen auch, welche Rollen die jeweilige wissenschaftliche Disziplin erhält (Kornmeier, 2007). Von den meisten Menschen unbestritten ist, dass es Gegenstände gibt, die außerhalb des menschlichen Bewusstseins existieren. Die Menschen können auf die Existenz dieser Gegenstände nur bedingt einwirken sowie die Struktur dieser Welt nicht ändern (z.B. nicht durch eine Mauer gehen oder fliegen). Worüber es keine Einigkeit gibt, ist die Existenz von Allgemeinbegriffen, Eigenschaften, und Klassen. Gibt es eine über den einzelnen Dingen stehende Existenz (Essentialismus) oder nicht (Nominalismus).

Auf einer ontologischen Ebene, auf der Seinsebene, existieren Dinge unabhängig vom Menschen, aber die ontologische Ebene ist von der erkenntnistheoretischen zu unterscheiden, die die Vorstellung darüber wie Menschen die Realität wahrnehmen, betrifft.

(Naiver) Realismus VertreterInnen des Realismus gehen davon aus, dass die Realität unabhängig von der menschlichen Wahrnehmung existiert, also dass es eine denkunabhängige Wirklichkeit gibt. Die Realität ist der Maßstab dafür, ob Aussagen als wahr und falsch definiert werden. Die meisten WissenschaftlerInnen sind sich jedoch einig, dass die erkenntnistheoretische Position der Realisten nicht haltbar ist. Menschen nehmen selektiv wahr, das heißt nur einen Teil der Informationen, welche die Umwelt bereitstellt. Zusätzlich sind die Deutungsweisen für die Wahrnehmungen der Wirklichkeit nicht immer eindeutig, sondern anfällig für Täuschungen jeglicher Art.

(Radikaler) Konstruktivismus Die KonstruktivistInnen stehen in ihrer Position konträr den VertreterInnen des Realismus gegenüber. KonstruktivistInnen erkennen keine subjektunabhängige Realität an. Das heißt, die Wirklichkeit wird immer von den einzelnen Individuen selbst konstruiert. Dass die Realität bestimmte Eigenschaften und Charakteristika hat, wird nicht bestritten, aber sie ist nur über Beobachtungen von einzelnen Menschen zugänglich, die diese Beobachtungen zugleich interpretieren und auslegen. Menschen schreiben den Dingen damit ihre eigenen Bedeutungen zu, die im Rahmen eines sozialen Austauschs mit anderen geteilt werden. Auch die Wissenschaft ist daran gebunden. Das heißt, sie entwickeln keine objektiven Erkenntnisse, sondern entwickeln subjektive Konstrukte. Kritisiert wird am radikalen Konstruktivismus, dass, vorausgesetzt man bleibt konsequent, keine wissenschaftlichen Erkenntnisse gewonnen werden können, weil die Wirklichkeit nicht direkt wahrnehmbar ist.

(Klassischer) Rationalismus Vertreter des Rationalismus sehen ihre Erkenntnis auf Verstand und Vernunft gegründet. Einer Beobachtung muss immer eine Theorie vorausgehen, da es keine voraussetzungs- oder theoriefreien Erfahrungen gebe. Der Erkenntnisprozess des Rationalismus beruht auf der Deduktion (siehe oben). Das heißt die rationale Erkenntnis beruht immer auf einer vorhandenen Erkenntnis von der weitere Aussagen und Annahmen abgeleitet werden. Die deduktive-nomologische Erklärungsmethode ist von besonderer Bedeutung.

Empirismus Für die VertreterInnen des Empirismus ist die wichtigste Quelle der Erkenntnis die sinnliche Wahrnehmung. Eine wissenschaftliche Theorie entsteht durch Beobachtung, Befragung oder durch im Experiment gemachte Erfahrungen. Mit dem Aufkommen des Empirismus am Übergang vom Mittelalter in die Neuzeit kam es zu einem Aufschwung der Naturwissenschaften. Nicht mehr Deduktion, sondern Induktion wurde zum maßgeblichen Prinzip der Erkenntnisse. Von einer endlichen Zahl an Beobachtungen (Stichprobe, beschränkte Fallzahlen) wird auf das zugrundeliegende Gesetz geschlossen. Der Empirismus entwickelte sich mit den philosophischen Strömungen des Positivismus und Neopositivismus weiter. Diese akzeptieren im Gegensatz zum reinen Empirismus auch die Existenz des menschlichen Bewusstseins. Die PositivistInnen suchen nicht nach dem eigentlichen „Wesen“ einer Tatsache. Tatsachen werden als solche hingenommen. Jegliche Art von Metaphysik wird abgelehnt. Die NeoposivistInnen, die eng mit der Gruppe des „Wiener Kreises“ (Schlick, Carnap, Neurath) verbunden waren, stellten keine Überlegungen über Empfindungen und Bewusstsein an. Anstatt psychologischer Fragestellungen werden Aussagen über die reale Welt logisch untersucht (Logischer Empirismus, logischer Positivismus). Nur solche Aussagen werden als wissenschaftliche Aussagen zugelassen, die in sinnlich wahrnehmbare (naturwissenschaftlich beobachtbare) Gegebenheiten übersetzt werden können. Diese Aussagen werden Protokollsätze, Elementarsätze oder auch Beobachtungsaussagen genannt. (Behrens, 1993), (Kornmeier, 2007)

In derzeitigen Wissenschaften dominierende Ansätze

Obwohl sich Rationalismus und Empirismus nach Art der Erkenntnisquelle unterscheiden (Vernunft/Deduktion <-> Beobachtung/Induktion) gibt es dennoch einige Gemeinsamkeiten. Beiden gemein ist die Suche nach den letzten und sicheren Fundamenten des Wissens. Allgemein haben sich die beiden Strömungen aneinander angenähert. Es gibt weder Strömungen, die der „reinen Deduktion“ noch die der „reinen Induktion“ anhängen.

- Kritischer Rationalismus wurde entscheidend von Karl Popper geprägt und stellt eine Kombination und Weiterentwicklung von klassischem Rationalismus und Neopositivismus dar und beinhaltet Elemente der Deduktion und Induktion. Basierend auf der Annahme, dass menschliche Vernunft grundsätzlich fehlbar ist und damit auch die Ergebnisse rationalistischer Begründungen nicht unumstößlich sind, ist Wissen immer nur vorläufig gültig. Die Induktion alleine ist zur Erkenntnisgewinnung ungeeignet. Aus Beobachtungen und Experimenten können keine generalisierten Aussagen abgeleitet werden. Nur weil bislang nur weiße Schwäne beobachtet wurden, heißt das noch lange nicht dass alle Schwäne auf der Welt weiß sind. Eine Aussage kann niemals verifiziert werden (d.h. endgültig bestätigt werden), dennoch ist es möglich aus den eigenen Fehlern (falschen Annahmen) zu lernen. Die Aufgabe der Wissenschaft ist es nach der Wahrheit zu streben und falls sich eine Aussage als fehlerhaft erweist (=Falsifikation) diese zu korrigieren (=methodischer Rationalismus). Das heißt Aussagen müssen falsifizierbar sein, also grundsätzlich muss es möglich sein diese Sachverhalte empirisch zu überprüfen und auch zu widerlegen, und in einer logischen Prüfung widerspruchsfrei sein. Solange eine Theorie nicht widerlegbar ist, gilt die darauf aufbauende Idee als vorläufig bestätigt. Kritisch wird der Rationalismus deswegen genannt, da Aussagen durch die Falsifikation immer wieder hinterfragt werden. Rationalismus steht dafür, dass im Gegensatz zum Empirismus und Positivismus das theoretische Denken in den Vordergrund tritt. Der Kritische Rationalismus stellt methodologische Fragen in den Mittelpunkt (z.B. Wie können Theorien formuliert, geprüft bzw. geändert werden?). Es geht vor allem um die (modell-)theoretische Herleitung von Hypothesen und deren Überprüfung an der Realität.

- Unter Konstruktivismus werden unterschiedliche Strömungen zusammengefasst. Zu einem der Erlanger Konstruktivismus (Methodischer Konstruktivismus), der von dem Mathematiker Paul Lorenz begründet wurde. Die VertreterInnen dieser Richtung des Konstruktivismus betrachten Wissenschaft und Wissenschaftstheorie kritisch. Es geht ihnen um die Entwicklung einer intersubjektiv nachvollziehbaren Wissenschaftssprache, um sprachliche Missverständnisse zu vermeiden. Der Sozialkonstruktivismus, der sich auf die Soziologen Peter L. Berger und Thomas Luckmann (1980) und deren Hauptwerk „Die gesellschaftliche Konstruktion der Wirklichkeit“ beruft geht davon ausgeht, dass die wissenschaftliche Erkenntnis nicht unabhängig von den sozialen Situationen der ForscherInnen gesehen werden kann. Naturwissenschaftliche (vermeintlich objektive) Tatsachen sind vom sozialen Umfeld des Forschers geprägt. Die KonstruktivistInnen richtet ihr Hauptaugenmerk auf meta-theoretische Fragen, sowie deren Verbindungen zur Empirie. (Kornmeier, 2007, S. 29ff)

| Objektive Welterkennung möglich | Objektive Welterkennung nicht (vollständig) möglich | |

|---|---|---|

| Objektive Welterkennung nicht (vollständig) möglich Welt existiert unabhängig vom Beobachter (Essentialismus) | Positivismus | Kritischer Rationalismus |

| Diskursive/soziale Konstruktion der Wirklichkeit (Konstruktivismus) | Interpretative Sozialforschung | |

Kritische Betrachtung des Wissenschaftssystems

„Wissenschaft ist nicht das was wahr ist, sondern das was bewährt ist.“ Thomas Kuhn

Sehr lange glaubte man, dass sich wissenschaftlichen Wissen durch stetige Akkumulation von Wahrheiten ausdehnt. Dies widerlegte der Wissenschaftstheoretiker Thomas Kuhn. Kuhn begreift Wissenschaft nicht als kumulativen Fortschrittsprozess, sondern Wissenschaft ist von Diskontinuitäten und Brüchen gekennzeichnet. Er behauptete, dass Wissenschaft neue Erkenntnisse entwickeln kann, die jedoch auf falschen Annahmen basieren. Er stellte fest, dass es in jeder Wissenschaft eine herrschende Lehrmeinung gibt, die auch die zu verwendenden Leitbegriffe und Theorien bestimmt. Kuhn bezeichnet diese herrschende Lehrmeinung als Paradigma (griech. für Modell/Beispiel, in diesem Zusammenhang ein mehr oder weniger bewusstes Vorverständnis von einem wissenschaftlichen Gegenstand, bzw. von der zur Anwendung kommenden Forschungsmethode). Die meisten WissenschaftlerInnen bestätigen mit ihren Forschungen dieses Paradigma ohne die ihm zugrundeliegenden Grundannahmen zu hinterfragen. Immer wieder jedoch gibt es nonkonformistische WissenschaftlerInnen, die eine Gegenposition entwickeln und eine wissenschaftliche Revolution einläuten, sodass es zu einem Paradigmenwechsel kommt. Ein neues Paradigma entwickelt sich nicht jedoch nicht geradlinig aus dem bisherigen Paradigma. Einander ablösende Paradigmen sind miteinander unvergleichbar. Das heißt aber auch es findet kein kontinuierlicher Erkenntnisfortschritt statt. Thomas Kuhn sprengte selbst das alte Paradigma der Gradlinigkeit der wissenschaftlichen Entwicklung. Wissenschaft ist ein System in dem Konkurrenz zwischen verschiedenen WissenschaftlerInnen gibt, die im Kampf um das sich durchsetzende Paradigma stehen. (Kuhn, 2001)

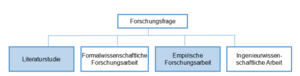

Formen des wissenschaftlichen Arbeitens

Das Ziel der unterschiedlichen Wissenschaften ist, Erkenntnis und Wissen systematisch zu gewinnen und zu ordnen. Wissenschafter*innen können grundsätzlich auf zwei Wegen neues Wissen erschließen, indem sie sich aus¬schließlich auf vorhandene Theorien beziehen, die bereits publiziert oder auf eine andere Art und Weise dokumentiert sind, oder indem sie versuchen, für wissenschaftliche Probleme und Fragestellungen innovative Lösungen und Antworten zu finden. Die literaturbasierte wissenschaftliche Arbeit steht damit einer wissenschaftlichen Arbeit gegenüber, die neue Erkenntnisse, aber auch den Prozess der Forschung oder Entwicklung dieser Erkenntnisse dokumentiert. In den folgenden zwei Abschnitten sollen die Literaturstudie sowie die empirische Forschungsarbeit genauer beschrieben werden.

Prinzipien für die wissenschaftliche Arbeit

Der bekannte Philosoph und Schriftsteller Umberto Eco beantwortet die Frage nach Prinzipien für das wissenschaftliche Arbeiten folgendermaßen. Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \lbrack} Ec03, 39ff.Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \rbrack}

- Die Untersuchung behandelt einen erkennbaren Gegenstand, der so genau umrissen ist, dass er auch für Dritte erkennbar ist.

- Die Untersuchung muss über diesen Gegenstand Dinge sagen, die noch nicht gesagt worden sind.

- Die Untersuchung muss für andere von Nutzen sein.

- Die Untersuchung muss jene Aufgaben enthalten, die es ermöglichen nachzuprüfen, ob ihre Hypothesen falsch oder richtig sind.

Wichtig ist hierbei auch, darauf zu achten, dass das Problem versachlicht wird. Das heißt, dass für die Beschreibung des Problems eine sachliche Fachsprache verwendet wird und das Problem theoretisch eingebettet ist, sei es nun durch Verwendung einer mathematischen Sprache oder durch eine Verknüpfung mit anderen in der Disziplin vorhandenen Theorien. Die Gütekriterien für wissenschaftliche Arbeiten müssen eingehalten werden.

Folgende Aufzählung von Aufgaben für Wissenschafter*innen ist praxis- und handlungsorientierter und bezieht die Arbeit in der und für die „Scientific Community“ mit ein:

- Hinterfragen und Überprüfen der eigenen Forschungs- und Auswertungsmethoden auf Zweckmäßigkeit, Wahrheitsgehalt und ethische Qualität;

- Aussagen, Hypothesen und Schlussfolgerungen müssen überprüfbar und widerlegbar sein;

- Beachtung der für das Wissensgebiet als „wissenschaftlich“ anerkannten Theorien, Methoden und der Fachsprache (Nomenklatur);

- Erbringen von Beiträgen zur Grundsubstanz des Wissens (z.B. durch Lehrbücher);

- Mitwirkung an fachtypischen Wissensvermittlungsmethoden (Lehre);

- Weiterentwicklung der akademischen Abschlüsse und Qualifikationen des Wissensbereichs;

- Teilnahme am Wissensaustausch zwischen Wissenschafter*innen des Fachbereichs und darüber hinaus („Scientific Community“, Publizieren, Konferenzen etc.). Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \lbrack} Ne03Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \rbrack}

Der Soziologe Max Weber stellte für die Wissenschaften das Postulat der Werturteilsfreiheit auf. Wissenschafter*innen haben frei von Werten zu sein. Sie sollen nichts als böse oder gut klassifizieren. Da aber jeder Mensch selbst Werte hat, müssen diese vorab klargelegt werden. Wichtig ist, dass die Erkenntnisse intersubjektiv überprüfbar sind, das heißt, dass andere die Erkenntnisschritte nachvollziehen können. Die Analyse muss immer wieder hinterfragt werden. Nun ist ein Wissenschaftler, eine Wissenschaftlerin nicht amoralisch, sondern positioniert sich, wie Max Weber unterscheidet, in einer Verantwortungsethik und nicht in einer Gesinnungsethik. Die Politik beispielsweise verpflichtet sich einer Gesinnungsethik und ist damit weltanschaulich gebunden.

Die Wissenschafter*innen sind der Rationalität verpflichtet.

Die Forschungsfrage

Aus den genannten Prinzipien leitet sich auch die Forschungsfrage ab. Sie ist der Ausgangspunkt jeglicher Art von Forschung. Es gibt keine wissenschaftlichen Methoden zur Auswahl einer Forschungsfrage. Sie kann entweder dem Interesse des/der einzelnen Wissenschafter*in entspringen oder als Auftrag an die Wissenschafter*innen ergehen.

Bevor sich Wissenschafter*innen einzelnen Forschungsfragen zuwenden, sollten sie jedoch einige Punkte berücksichtigen:

- gesellschaftliche Relevanz,

- wissenschaftliche Relevanz und

- kritische Überprüfung der Forschungsfrage auf ihre Herkunft.

Das wissenschaftliche Literaturstudium

Eine Literaturstudie befasst sich mit bereits publizierter wissenschaftlicher Literatur über ein bestimmtes Thema bzw. eine bestimmte Fragestellung. Im Rahmen des Studiums und auch bei Abschlussarbeiten[1] ist dies eine oft gewählte Form des wissenschaftlichen Arbeitens. Oft fällt es schwer, Methoden des Literaturstudiums zu finden, meistens sind Erklärungen auf die Beschaffung von Literatur beschränkt. Wie jedoch mit der vorhandenen Literatur umgegangen wird, wird methodisch von vielen Wissenschafter*innen nicht dokumentiert, sondern basiert auf informell (z.B. im Laufe des Studiums) erworbenem Erfahrungswissen.

Ein wichtiger Punkt bei der Bearbeitung von wissenschaftlichen Texten ist, zu welchem Zeitpunkt im Prozess des wissenschaftlichen Arbeitens diese stattfindet. Sinnvoll ist eine intensive Auseinandersetzung mit Literatur erst dann, wenn bereits eine Forschungsfrage formuliert wurde, also klar ist, welches Problem im Vordergrund steht und im Laufe der Arbeit beantwortet werden soll. Diese Forschungsfrage bildet sowohl den roten Faden für die Literaturrecherche als auch für die Bearbeitung der Literatur. Nur jene Literatur, die zur Beantwortung der Fragestellung beitragen kann, ist relevant. Das Literaturstudium kann also als die Bearbeitung relevanter wissenschaftlicher Literatur in Bezug auf die eigene Fragestellung bezeichnet werden.

Diese relevante Literatur wird im Forschungsstand bzw. State of the Art dargestellt. Mit dem Erfassen des Forschungsstandes wird ein Überblick über die Diskursträger*innen des gewählten Themas geschaffen, also über die Aussagen jener Autor*innen, die zum wissenschaftlichen Diskurs mit wesentlichen Erkenntnissen beigetragen haben. Sie können hierbei beschreibend vorgehen, verschiedene Beiträge zusammentragen und komprimieren oder diese vergleichen und kontrastieren und damit zur Verdichtung bisheriger Erkenntnisse beitragen und neue Erkenntnisse gewinnen.

Aufbauend auf diesem Fundament werden in einer Literaturstudie nun die eigenen Erkenntnisse, die neu erkannten Zusammenhänge, Interpretationen und mögliche Kritik formuliert. Eine Literaturstudie besteht somit darin, die eigene Fragestellung mit Hilfe von bereits publizierten wissenschaftlichen Texten zu bearbeiten und im Laufe der Arbeit zu beantworten.

Wissenschaftlich Forschen

Methode: logisches, planmäßiges, systematisches Verfahren wissenschaftlicher Forschung, Untersuchungsweise, Art der Wahrheitsfindung. Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \lbrack}

Ei04, 665-668Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \rbrack}

Das Wort Methode stammt aus dem Altgriechischen (methodos) und bedeutet so viel wie „Nachgehen“, „Verfolgen“ oder „der Weg zu etwas hin“. Eine Methode bietet uns die Möglichkeit, bei der Entwicklung wissenschaftlicher Probleme, Fragen, Aussagen sowie deren empirischer Überprüfung durch Realitätsanalysen einen bereits von anderen Forscher*innen entwickelten und erprobten Weg „nachzugehen“. Das heißt, eine Methode gibt ein systematisches Vorgehen bzw. Verfahren vor, um Informationen zu beschaffen und auszuwerten. Methoden helfen damit, zwischen Empirie und Theorie zu vermitteln. Methoden müssen wissenschaftlichen Kriterien entsprechen, um überzeugend zu sein. Sie helfen aber auch dabei, die Intersubjektivität des Forschungsprozesses sicherzustellen. Indem sich ein Forscher, eine Forscherin auf eine bestimmte Methode bezieht und zum Beispiel in der Einleitung seines/ihres Artikels angibt, welche Methode er/sie für das Forschungsvorhaben verwendet hat, können die Leser*innen des Artikels Rückschlüsse auf den Forschungsprozess des Autors, der Autorin ziehen. Zu unterscheiden sind besonders naturwissenschaftliche, sozialwissenschaftliche, formalwissenschaftliche und philosophische Methoden.

Überblick über die Methoden der Wirtschaftsinformatik

Die Wirtschaftsinformatik versteht sich als Wissenschaft mit einer methoden-pluralistischen Erkenntnisstrategie. Sie bedient sich der Instrumente der

Erfahrungs-, Formal- und Ingenieurwissenschaften.

Die Wirtschaftsinformatik arbeitet innerhalb zweier erkenntnistheoretischer Paradigmen. Einerseits will sie mit sozialwissenschaftlichen Methoden die Ausgestaltung und Wirkung verfügbarer IT-Lösungen, Unternehmen und Märkte analysieren. Neben rein an der Erkenntnis orientierten, sozialwissenschaftlichen Forschungsmethoden spielen in der Wirtschaftsinformatik vor allem auch konstruktionsorientierte Methoden (Erstellen und Evaluieren von Prototypen) und Methoden der Informationssystemgestaltung (Entwicklungsmethoden) eine wesentliche Rolle. Im Rahmen von „Design Science“ bzw. dem konstruktionswissenschaftlichen Paradigma will die Wirtschaftinformatik nützliche IT-Lösungen entwickeln, die durch das Schaffen und Evaluieren verschiedener Artefakte in Form von Modellen, Methoden oder Systemen untersucht werden sollen.

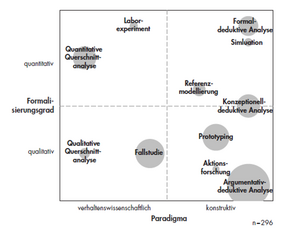

Grundsätzlich können wissenschaftliche Methoden in zwei Gruppen eingeteilt werden: in quantitative und qualitative Methoden. Die Unterscheidungsmerkmale sollen nachfolgend anhand der Methoden der Sozialforschung in ihren Grundzügen beschrieben werden. Diese können vor allem aufgrund ihres Formalisierungsgrades unterschieden werden. Wilde & Hess Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \lbrack}

WH07, 282Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \rbrack}

hingegen ergänzen diese zwei Kategorien um „semi-formale Gegenstandsrepräsentationen“, zu denen sie beispielsweise Petrinetze oder UML-Modelle zählen.

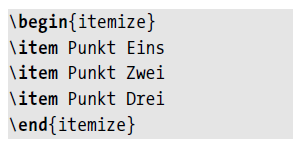

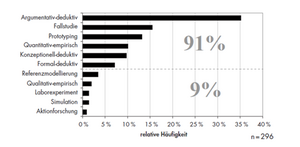

Einen ersten Einblick in die Vielfalt der Methoden der Wirtschaftsinformatik gibt folgende Tabelle, die auf Basis einer Inhaltsanalyse verschiedener facheinschlägiger Artikel in der Fachzeitschrift „Wirtschaftsinformatik“ erstellt wurde. Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \lbrack}

WH07Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \rbrack}

In dieser Auflistung sind sowohl formalwissenschaftliche, anwendungsorientierte technische Methoden als auch Methoden der empirischen Sozialforschung enthalten.

| Methode | Beschreibung |

|---|---|

| Formal-/konzeptionell- und argumentativ-deduktive Analyse | Logisch-deduktives Schließen kann als Forschungsmethode auf verschiedenen Formalisierungsstufen stattfinden: entweder im Rahmen mathematisch-formaler Modelle (z.B. in semi-formalen Modellen) oder rein sprachlich (argumentativ). |

| Simulation | Die Simulation bildet das Verhalten des zu untersuchenden Systems formal in einem Modell ab und stellt Umweltzustände durch bestimmte Belegungen der Modellparameter nach. Sowohl durch die Modellkonstruktion als auch durch die Beobachtung der endogenen Modellgrößen lassen sich Erkenntnisse gewinnen. |

| Referenz-modellierung | Die Referenzmodellierung erstellt induktiv oder deduktiv meist vereinfachte und optimierte Abbildungen von Systemen, um so bestehende Erkenntnisse zu vertiefen und daraus Gestaltungsvorlagen zu generieren. |

| Aktionsforschung | Es wird ein Praxisbeispiel durch einen gemischten Kreis aus Wissenschaft und Praxis gelöst. Hierbei werden mehrere Zyklen aus Analyse-, Aktions-, und Evaluationsschritten durchlaufen, die jeweils gering strukturierte Instrumente wie Gruppendiskussionen oder Planspiele vorsehen. |

| Prototyping | Es wird eine Vorabversion eines Anwendungssystems entwickelt und evaluiert. Beide Schritte können neue Erkenntnisse generieren. |

| Ethnographie | Die Ethnographie möchte durch partizipierende Beobachtung Erkenntnisse generieren. Der Unterschied zur Fallstudie liegt in dem sehr hohen Umfang, in dem sich ein Forscher bzw. eine Forscherin in das untersuchte soziale Umfeld integriert. Eine objektive Distanz ist kaum vorhanden. |

| Fallstudie | Die Fallstudie untersucht in der Regel komplexe, schwer abgrenzbare Phänomene in ihrem natürlichen Kontext. Sie stellt eine spezielle Form der qualitativ-empirischen Methodik dar, die wenige Merkmalsträger intensiv untersucht. Es steht entweder die möglichst objektive Untersuchung von Thesen (sozialwissenschaftlicher Zugang) oder die Interpretation von Verhaltensmustern als Phänotypen der von den Probanden konstruierten Realitäten (konstruktionsorientierter Zugang) im Mittelpunkt. |

| Grounded Theory | Die Grounded Theory zielt auf eine induktive Gewinnung neuer Theorien durch intensive Beobachtung des Untersuchungsgegenstandes im Feld ab. Die verschiedenen Vorgehensweisen zur Kodierung und Auswertung der vorwiegend qualitativen Daten sind exakt spezifiziert. |

| Qualitative/ Quantitative Querschnittsanalyse | Diese beiden Methoden fassen Erhebungstechniken wie Fragebögen, Interviews, Delphi-Methode, Inhaltsanalysen etc. zu zwei Aggregaten zusammen. Sie umfassen eine einmalige Erhebung über mehrere Individuen hinweg, die anschließend quantitativ oder qualitativ kodiert und ausgewertet werden. Ergebnis ist ein Querschnittsbild über die Stichprobenteilnehmer*innen hinweg, welches üblicherweise Rückschlüsse auf die Grundgesamtheit zulässt. |

| Labor-/Feldexperiment | Das Experiment untersucht Kausalzusammenhänge in kontrollierter Umgebung, indem eine Experimentvariable auf wiederholbare Weise manipuliert und die Wirkung der Manipulation gemessen wird. Der Untersuchungsgegenstand wird entweder in seiner natürlichen Umgebung (im „Feld“) oder in künstlicher Umgebung (im „Labor“) untersucht, wodurch wesentlich die Möglichkeiten der Umgebungskontrolle beeinflusst werden. |

Design Science

Wie bereits erwähnt bedient sich die Wirtschaftsinformatik als angewandte Forschungsdisziplin auch Methoden aus anderen Disziplinen, wie Wirtschaft oder Informatik um die Probleme an der Schnittstelle von IT und Unternehmen zu lösen. Allerdings ist die dominante Forschung weiterhin weitgehend diejenige der traditionellen deskriptiven Forschung, abgeleitet von der sozialen Forschung.

In den letzten Jahren hat sich in der Wirtschaftsinformatik jedoch Design Science immer mehr etabliert. Design Science dient dabei als Forschungsparadigma mit der tatsächlichen Integration von Design als einem der wichtigsten Faktoren.

Hevner et al. präsentierten 2004 erstmals sieben Richtlinien für eine designorientierte Forschung Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \lbrack}

Hev04Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \rbrack}

:

- Design als Artefakt: Design Science muss ein funktionsfähiges Artefakt in Form eines Konstrukts, eines Modells, einer Methode oder einer Instanziierung produzieren.

- Problemrelevanz: Ziel von Design Science ist es, technologiebasierte Lösungen für wichtige und relevante Geschäftsprobleme zu entwickeln.

- Designbewertung: Der Nutzen, die Qualität und die Wirksamkeit eines Design-Artefakts müssen durch gut ausgeführte Bewertungsmethoden rigoros nachgewiesen werden.

- Forschungsbeiträge: Effektive Design Science muss klare und nachprüfbare Beiträge in den Bereichen Design-Artefakt, Design-Fundamente und/oder Designmethoden liefern.

- Forschungsstrenge: Die Design Science beruht auf der Anwendung rigoroser Methoden sowohl bei der Konstruktion als auch bei der Bewertung des Design-Artefakts.

- Design als Suchprozess: Die Suche nach einem effektiven Artefakt erfordert die Nutzung der verfügbaren Mittel, um die gewünschten Ziele zu erreichen und gleichzeitig die Gesetze in der Problemumgebung zu erfüllen.

- Kommunikation der Forschung: Design Science muss sowohl dem technologie- als auch dem managementorientierten Publikum effektiv präsentiert werden.

Kernaspekt ist dabei das Artefakt, das geschaffen wurde, um ein Problem aus der Praxis zu lösen. Sein Nutzen, seine Qualität und Wirksamkeit müssen danach bewertet werden. Es reicht also nicht aus, das Artefakt zu erzeugen, auch der Test der Wirksamkeit spielt eine ebenso große Rolle.

In der Praxis wird der erste Punkt – das funktionsfähige Artefakt – oft in Form eines Prototyps oder eines Leitfadens umgesetzt. Fehlt jedoch der Test der Qualität und Wirksamkeit, dann entspricht dies nicht den wissenschaftlichen Ansprüchen an die designorientierte Forschung. Um eine wissenschaftliche Arbeit zu schaffen sollte man also die Punkte von Hevner als Checkliste abarbeiten. Betrachten wir die sieben Richtlinien etwas detaillierter:

Funktionsfähiges Artefakt

Das funktionsfähige Artefakt kann vom theoretischen Konzept bis zur praktischen Umsetzung alles beinhalten. Die Bandbreite reicht also von der Machbarkeitsstudie bis hin zum funktionierenden Prototyp eines Roboters.

Technologiebasierte Lösung

Die Entwicklung eines Prototyps birgt meist sowohl aus technologischer als auch aus wirtschaftlicher Sicht Potential in sich. Aus wissenschaftlicher Sicht ist es dabei wichtig sich erneut die Prinzipien von Umberto Eco in Erinnerung zu rufen. Die Untersuchung muss über diesen Gegenstand Dinge sagen, die noch nicht gesagt worden sind und die Untersuchung muss für andere von Nutzen sein. Speziell der Aspekt der Neuheit setzt für Forscher*innen voraus, sich zuvor mit vorhandener Literatur zu dem Thema auseinanderzusetzen, um den aktuellen Stand des Wissens zu ermitteln.

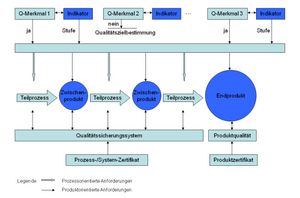

Qualität und Wirksamkeit

In der Softwareentwicklung dient unter anderem die ISO/IEC 250XX Software engineering – Software product Quality Requirements and Evaluation (SQuaRE) als Norm zur Qualitätssicherung. Sie beschreibt „Qualität ist die Gesamtheit von Eigenschaften und Merkmalen eines Produkts oder einer Tätigkeit, die sich auf deren Eignung zur Erfüllung gegebener Erfordernisse bezieht“ Fehler beim Parsen (MathML mit SVG- oder PNG-Rückgriff (empfohlen für moderne Browser und Barrierefreiheitswerkzeuge): Ungültige Antwort („Math extension cannot connect to Restbase.“) von Server „https://wikimedia.org/api/rest_v1/“:): {\textstyle \lbrack}

DIN08.

Neben dem Produkt liegt der Fokus auch auf dem Prozess der Entwicklung selbst, wie laut Mellis der Einhaltung bestimmter zeitlicher bzw. finanzieller Restriktionen und die Notwendigkeit der Einhaltung bestimmter Prozessrichtlinien Wer13. Das Zusammenspiel zeigt Abbildung 10.

Eine Möglichkeit zur Evaluation von Artefakten besteht nach Hevner auch darin, den erzeugten Nutzen der Artefakte mit dem Nutzen von anderen Artefakten, die das gleiche Problem lösen, zu vergleichen Hev04.

Nachprüfbare Beiträge

Methoden oder Artefakte innerhalb des Prozesses müssen eindeutig nachvollziehbar sein. Wenn man eine Blackbox mit einem Input und einem Output generiert, dann genügt dies nicht den Ansprüchen der Nachvollziehbarkeit. Dieser Aspekt ist aus den Naturwissenschaften bekannt, ein Experiment muss nachvollziehbar und auch reproduzierbar sein.

Rigorose Methoden

Die Qualität von Software und Software-Entwicklungsprozessen kann durch formale Entwicklungsmethoden deutlich gesteigert werden. Es gibt viele verschiedene formale Methoden, die unterschiedlich gut für bestimmte Projekttypen geeignet sind. Ein Kriterium kann die Benutzerfreundlichkeit oder die Skalierbarkeit sein. In der Entwicklung der Software werden diese Spezifikationen dann in einer logisch nachvollziehbaren, formalen Sprache notiert. Bestimmte Eigenschaften wie Fehlerfreiheit in manchen Aspekten können damit auch mathematisch bewiesen werden.

Design als Suchprozess

Eine Wissensbasis zu dem spezifischen Thema wird anhand eines fortlaufenden iterativen Entwicklungsprozesses aufgebaut. Entwicklungen werden umgesetzt und evaluiert. Die Suche nach einem bestimmten Prüfgegenstand erfordert die Ausnutzung der verfügbaren Möglichkeiten um einen bestimmten Nutzen zu erreichen und gleichzeitig die Regeln des Problemumfeldes einzuhalten. Die Evaluierung selbst kann in Form von sehr formalen heuristischen Methoden mit Checklisten wie der ISO 9241 (Mensch-Computer Interaktion) oder der ISO 14915 (Software-Ergonomie für Multimedia-Benutzungsschnittstellen) erfolgen. Aber auch Benutzerevaluationen in Form von Interviews oder Eyetracking sind möglich. Das Methoden-Spektrum richtet sich sehr stark nach dem Artefakt.

Kommunikation der Forschung

Letztlich muss das Ergebnis auch einem wissenschaftlichen Publikum präsentiert werden. Im Zuge des Studiums erfolgt hier der erste Kontakt mit dem Thema meist beim Verfassen der Bachelor- oder Masterarbeit. In der weiteren wissenschaftlichen Karriere gilt dies auch für das Verfassen von Fachbeiträgen oder der Formulierung von Forschungsvorhaben.

Beispiel zur Umsetzung in der Praxis anhand einer Masterarbeit

In der Praxis hat man als Forscher*in oder Studierende*r oft eine Idee im Kopf. Angenommen wir wollen als Masterarbeit eine Anwendung für ein Mobiltelefon schreiben, das uns via GPS den Weg weist. Natürlich gibt es schon unzählige Apps zu dem Thema am Markt und es wäre daher auch kein wirklicher Neuigkeitswert gegeben. Sehen wir uns dennoch die 7 Richtlinien nach Hevner für dieses einfache Beispiel an:

- Funktionsfähiges Artefakt

- Das funktionsfähige Artefakt kann vom theoretischen Konzept der Anbindung von GPS am Mobiltelefon, bis hin zu einem Prototyp zur einfachen Navigation reichen. Ein einfacher Prototyp der die GPS Koordinaten auf einer Karte aufzeichnet wäre ausreichend.

- Technologiebasierte Lösung

- Die Entwicklung des Prototyps birgt sowohl aus technologischer als auch aus wirtschaftlicher Sicht Potential in sich. Eine (wirtschaftliche) Welt ohne GPS wäre heute kaum mehr vorstellbar.

- Qualität und Wirksamkeit

- Das Artefakt wurde gemäß ISO/IEC 25010 auf dessen Usability überprüft. Besonderes Augenmerk wurde dabei auf den Schutz vor Fehlbedienung durch Nutzer*innen gelegt.

- Nachprüfbare Beiträge

- Der Quellcode steht in digitaler Form zur weiteren Verarbeitung zur Verfügung. Einzelne Schritte können so leicht nachvollzogen werden.

- Rigorose Methoden

- Besonderer Wert wird auch auf die Verlässlichkeit gelegt. Kritische Programmteile wurden daher unter Einsatz formaler Methoden entwickelt.

- Design als Suchprozess

- Die Usability wird durch Standardchecklisten geprüft und weiter durch Feldversuche validiert.

- Kommunikation der Forschung

- Die Masterarbeit ist sowohl für Wissenschafter*innen als auch für interessierte Laien geschrieben. Ein roter Faden ist erkennbar und erlaubt es die Arbeit ähnlich einem Buch zu lesen. Als Masterarbeit wird die Arbeit auch veröffentlicht und steht damit für weitere Forschung zur Verfügung.

Qualitativ/Quantitativ: Was ist der Unterschied?

Methodologien und Methoden sind stark mit erkenntnistheoretischen und philosophischen Denkpositionen verbunden. In der Sozialforschung wird vor allem zwischen quantitativen bzw. qualitativen Methoden unterschieden.

Welche Methode in einem speziellen Forschungsvorhaben angewandt wird, muss je nach der jeweiligen Forschungsfrage entschieden werden. Zuvor muss klar sein, auf welche Fragen man Antworten sucht. Dann kann über die Methode entschieden werden.

| Quantitativ | Qualitativ |

|---|---|

| Erklären | Verstehen |

| Deduktiv/Theorien prüfend | Induktiv/Theorien entwickelnd |

| Standardisiert/Geschlossen | Nicht standardisiert/Offen |

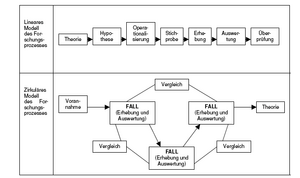

| Lineares Forschungsdesign | Zirkuläres Forschungsdesign |

| Hohe Fallzahl | Niedrige Fallzahl |

| Statistik | Offene Auswertungsverfahren |

| Zufallsstichprobe | Bewusste Auswahl der Fälle |

| Prädetermination der Forschenden | Relevanzsystem der Betroffenen |

| Objektiv | Subjektiv |

| Starres Vorgehen | Flexibles Vorgehen |

Quantitative Methoden sollen kausale Beziehungen, die zwischen Erscheinungen über die Gesetze entwickelt werden sollen, aufdecken. Qualitative Methoden sehen ausgehend von dem Prinzip der sozialen Konstruktion der Wirklichkeit Menschen als schaffende Wesen. Soziale Tatsachen werden durch Menschen konstruiert und immer wieder neu interpretiert. Phänomene sind von Menschen mit Bedeutung versehen. Mittels qualitativer Methoden wollen ForscherInnen den Sinn hinter sozialen Handlungen verstehen.

Während in der quantitativen Sozialforschung der Forschungsablauf standardisiert abläuft, wählt die qualitative Sozialforschung eine natürliche Befragungssituation; Befragte können selbst bestimmen, was sie sagen wollen. Oftmals sagen die gewählten Erzählungen viel aus.

Quantitative Sozialforschung glaubt, soziales Handeln objektiv erfassen zu können. Die Subjektivität des Forschers, der Forscherin wird möglichst zurückgenommen. Das Forschungsobjekt wird deterministisch als Manifestation verschiedener Kausal-zusammenhänge gesehen. Die Qualitative Sozialforschung geht davon aus, dass keine objektive Befragungssituation geschaffen werden kann. Es wird vom einzelnen Fall ausgegangen und dessen subjektive Wirklichkeitskonstruktion beobachtet.

Quantitative Methoden

Mittels quantitativer Methoden will man Rückschlüsse auf Kausalzusammenhänge zwischen unabhängigen und abhängigen Variablen gewinnen. Vieles in der Sozialwissenschaft ist nicht direkt beobachtbar oder messbar (Messen = Zahlen zuordnen) und zählt damit zu den latent vorhandenen Realitäten (Bildung, Lebensqualität, Akzeptanz von neuen Produkten). Theoretische Konstrukte dienen als Modelle für diese latenten Realitäten. Soll zum Beispiel der Bildungsstand der Bevölkerung festgestellt werden, muss auf verschiedene Indikatoren zurückgegriffen werden: z.B. höchster Schulabschluss, Anzahl der Schuljahre, Textverständnis, Anzahl der gelesenen Bücher. In der Anwendung der quantitativen Methoden sind immer die Gütekriterien zu beachten, um unsystematische wie auch systematische Messfehler zu reduzieren.

Objektivität

Objektiv ist eine Messmethode dann, wenn die Ergebnisse unabhängig von der Person sind, die das Messinstrument anwendet. Probleme gibt es bei quantitativen Methoden vor allem bei der Durchführungsobjektivität, da beispielsweise die interviewende Person Einfluss auf das Untersuchungsfeld nehmen kann.

Validität (Gültigkeit)

Von Validität kann dann gesprochen werden, wenn die Methode das misst, was sie vorgibt zu messen. Eine Messung ist dann valide, wenn es einen Zusammenhang zwischen dem zu messenden Konzept und den Indikatoren, anhand derer gemessen wird, gibt. Auf Validität ist während des gesamten Forschungsprozesses zu achten. Das beginnt bei der Operationalisierung der Forschungsfrage und betrifft aber auch die Beziehung des Forschers, der Forscherin zum Forschungsfeld und dessen Beeinflussung.

Reliabilität (Zuverlässigkeit) Die Reliabilität kontrolliert die Stabilität und Genauigkeit der Messung. Eine Wiederholung des Experiments und der Erhebung unter gleichen Rahmenbedingungen würde das gleiche Ergebnis erzielen. Die Zuverlässigkeit beruht auf der Standardisierung des Kontexts und der Isolierung der untersuchenden Variablen. Qualitative Methoden haben nicht den Anspruch das Gütekriterium der Reliabilität zu erfüllen, da die untersuchten Einzelfälle bei jeder erneuten Erhebungseinheit voneinander abweichen können. Di01, 216ff

Quantitatives Forschungsdesign Ein quantitatives Forschungsvorhaben geht immer von einer bereits bestehenden Theorie aus. Im idealtypischen Forschungsablauf ist es unwichtig, wie es zu dem Ausgangspunkt der Theorie kommt. Die Entstehung von Theorie ist vorwissenschaftlich. Das heißt, grundsätzlich können Theorien intuitiv entstehen, natürlich überprüft ein Forscher, eine Forscherin oftmals Theorien, die andere Forscher*innen bereits zuvor aufgestellt haben. Po35

Auf Basis dieser Theorie werden Hypothesen gebildet, deren Annahme folglich im Forschungsprozess bestätigt bzw. widerlegt werden soll. Dazu ist es notwendig, die Hypothesen zu operationalisieren. Unter Operationalisierung versteht man den Wechsel von der Theoriesprache zur „Empiriesprache“. Theoretische Konzepte sollen auf konkret beobachtbare (messbare) Phänomene heruntergebrochen werden. Dies wird zu einem insgesamt sehr wichtigen Schritt in der empirischen Forschung. Wenn man nicht überzeugend operationalisiert, kann das eigene Forschungsvorhaben dafür kritisiert werden, dass man gar nicht das gemessen hat, was von einer Theorie behauptet wird (Validität).

Mittels eines Messinstruments (z.B. Fragebogens) werden Daten erhoben. Diese Daten werden mittels statistischer Methoden ausgewertet. Nach der Beschreibung und Interpretation der Ergebnisse werden diese gemeinsam mit der Beschreibung des Forschungsprozesses (Messinstrument, Datenerhebung, Auswertungsschritte) oftmals im Rahmen eines Forschungsberichtes dokumentiert und damit die intersubjektive Nachvollziehbarkeit gewährleistet.

Qualitative Methoden

Qualitative Methoden wurden als Antwort auf die Defizite der quantitativen Sozialforschung entwickelt. Der markante Unterschied der zwei Forschungsparadigmen ist, dass die qualitativen Methoden nicht standardisiert vorgehen. Qualitativ forschende Wissenschafter*innen wollen das Subjekt und seine subjektiv konstruierte Welt in aller Komplexität erfassen. Das sie leitende Prinzip ist Offenheit. Qualitative Sozialforschung will nicht Hypothesen prüfen, sondern Hypothesen generieren (induktives Vorgehen). Dabei werden im Laufe des Forschungsprozesses immer neue Hypothesen entwickelt. Wichtig für die qualitative Sozialforschung ist die Orientierung am einzelnen Subjekt. Es geht nicht darum, eine möglichst hohe Fallzahl zu erheben, sondern den Einzelfall genau zu beschreiben und zu analysieren.

Forscher*innen, die im qualitativen Paradigma forschen, glauben nicht an unveränderbare Naturgesetze, die das menschliche Handeln anleiten. Wenn sich bestimmte Phänomene häufen, wird von Regeln bzw. Strukturen gesprochen, die jedoch immer mit dem Kontext verbunden und Veränderungen unterworfen sind. Menschen handeln nach Regeln bzw. orientieren sich in ihrem Handeln an Strukturen und nicht an Gesetzen.

Qualitative Methoden erheben nicht den Anspruch, repräsentative Ergebnisse zu liefern, das heißt, ausgehend von der Stichprobe sollen keine Aussagen über die Grundgesamtheit getroffen werden.

Sehr wohl gibt es aber Vorgangsweisen für eine Verallgemeinerung der entwickelten Ergebnisse hin zu Theorien (z.B. Typenbildung). Verallgemeinerbarkeit findet jedoch nur durch Begründung und nicht durch (statistische) Verfahren statt. Die Verallgemeinerung steht damit auf einer argumentativen und induktiven Ebene und stellt kontextgebundene Regeln (statt Gesetzmäßigkeiten) auf. Ma02

Theorieverständnis in der qualitativen Sozialforschung

Der Umgang mit Theorien und theoretischen Konzepten unterscheidet sich je nach dem angewandten Forschungsansatz.

- Ein Minimum an theoretischer Standortbestimmung ist die theoretische Einbettung des Forschungsvorhabens durch die Verwendung von Begrifflichkeiten, die von bestehenden Theorien abgeleitet wurden, sowie von sensibilisierenden Konzepten (z.B. interpretatives Forschungsparadigma).

- In anderen qualitativen Forschungsansätzen (z.B. Qualitative Inhaltsanalyse nach Mayring) werden aus vorab bestehenden Theorien Kategorien deduktiv abgeleitet. Dennoch werden Theorien durch induktive Kategorienbildung ergänzt.

- Schließlich gibt es auch qualitative Forschungsansätze, die ein theoretisches, variablenzentriertes Fallstudiendesign aufweisen.

Qualitative Erhebungsmethoden

- Interviews

- Einzelinterviews (Narrative Interviews, Expert*inneninterviews …)

- Gruppeninterviews (Fokusgruppe)

- Beobachtungen (Teilnehmende Beobachtung)

- Nicht reaktive Verfahren (Dokumente, Artefakte)

- Qualitatives Experiment

Die hier vorgestellten Erhebungsmethoden arbeiten zumeist auf sprachlicher Basis (Interviews, Gruppendiskussion), aber auch mit Beobachtung. In der qualitativen Forschung ist besonders der verbale Zugang, das Gespräch von großer Bedeutung. Subjektive Bedeutungen lassen sich nur schwer aus Beobachtungen ableiten. Die Subjekte können in Interviews etc. jedoch selbst zu Sprache kommen. Ma02, 66f.

Fallauswahl

- Theoretical Sampling: Das Konzept des Theoretical Sampling stammt aus der Grounded Theory. Die Stichprobe wird aufgrund von theoretischen Überlegungen gewonnen. Der Forscher, die Forscherin sammelt, kodiert und wertet Daten aus und trifft aus diesem Prozess heraus die Entscheidungen, welche Daten als nächste zu sammeln sind. Die qualitative Sozialforschung interessiert weniger, wie ein Problem statistisch verteilt ist, sondern welche Probleme es gibt und wie diese beschaffen sind. So können beispielsweise abweichende Beispiele sehr erkenntnisreich sein und interessante Aufschlüsse geben. Zu beachten ist, dass die Auswahl der Stichprobe bestimmt, was später gesagt werden kann.

- Qualitativer Stichprobenplan: Hier wird ein Sample (Stichprobe) selektiv gezogen. Es liegen bereits Informationen zu Merkmalen vor, die relevante Erkenntnisse versprechen. Wenn bereits quantitative Forschungsergebnisse vorliegen, können diese im Stichprobenplan berücksichtigt werden.

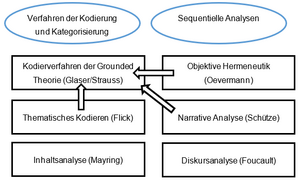

Qualitative Auswertungsverfahren im Überblick (interpretative Verfahren)

- Verfahren der Kodierung und Kategorisierung: Gegenstandsbezogen, Interpretation und Reduktion des Materials durch induktive Bildung von Kategorien, auch auf nicht-textliches Material und bei größeren Datenmengen anwendbar;

- Sequentielle Analysen: stärker fall- und subjektorientiert, größere Tiefenschärfe, eher für kleinere Datenmengen geeignet.

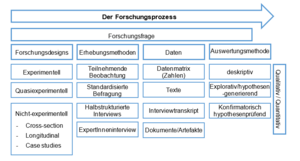

Ein Forschungsprozess in der Sozialwissenschaft kann wie folgt aussehen:

- Formulierung und Präzisierung des Forschungsproblems

- Auftragsklärung

- Forschungsfrage formulieren

- Theoretischen Rahmen festlegen

- Forschungsdesign konzipieren

- Entscheidung für ein Forschungsparadigma

- Welche Methode? Welche Daten?

- Auswahl und Erhebung der Daten

- Auswertung der Daten

- Durchführung

- Ergebnisdarstellung/Bericht

- Publikation

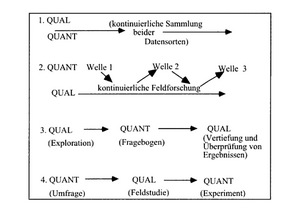

Methodentriangulation

In der wissenschaftlichen Praxis kommt es häufig zu einer Verknüpfung des quantitativen Ansatzes mit dem qualitativen Ansatz. Das wird als Methodentriangulation verstanden. Die Triangulation ist eine methodische Technik, um einen Untersuchungsgegenstand möglichst breit und tief erfassen zu können. Die Verknüpfung der verschiedenen Paradigmen kann in unterschiedliche Forschungsdesigns eingebettet werden (siehe Abbildung 14). Dabei können Vorteile beider Forschungsparadigmen verknüpft und Nachteile verringert werden.

Datenerhebung

In der Regel werden unabhängig von der verwendeten Methode Daten erhoben. Einige statistische Grundlagen der deskriptiven Statistik (sie beschreibt Merkmale wie beispielsweise die durchschnittliche Größe von Schüler*innen) und der Inferenzstatistik (sie untersucht Hypothesen) sollen hier gezeigt werden.

Skalen

Variablen-Ausprägungen werden auf Skalen gemessen.

- Skalenniveaus bestimmen, welche statistischen Maßzahlen zur Beschreibung eines Merkmals verwendet werden dürfen.

- Skalenniveaus bestimmen, mit welchen Methoden Zusammenhänge zwischen zwei Merkmalen bestimmt werden.

- Skalenniveaus geben an, welche statistischen Tests und Modelle verwendet werden dürfen.

| Beispiel | Rechen-operationen | ||

|---|---|---|---|

| Kategoriell | Nominalskala | Mann/Frau | A = B oder A B |

| Ordinalskala | Stimme sehr, ziemlich, wenig, gar nicht zu | Reihenfolge | |

| Metrisch | Intervallskala | IQ | A - B, B + C Abstände |

| Verhältnisskala | Einkommen in Euro, Alter | A / B, Verhältnisse (doppelt soviel etc). | |

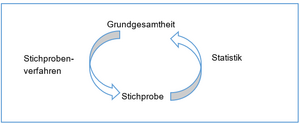

Grundgesamtheit und Stichprobe

Als Grundgesamtheit wird die Population verstanden, über die man eine Aussage treffen will. Ist eine Vollerhebung nicht möglich oder nicht sinnvoll, wird eine Stichprobe gezogen, aufgrund derer man mittels der Methoden der Statistik (Inferenzstatistik) repräsentative Aussagen über die Grundgesamtheit trifft. Durch die Art der Stichprobenziehung soll gewährleistet werden, dass die Stichprobe die Grundgesamtheit entweder in Bezug auf alle Merkmale oder auf ein bestimmtes Merkmal gut repräsentiert.

Als häufigste Arten der Stichprobenziehung gelten:

- die einfache Zufallsstichprobe: Die Wahrscheinlichkeit, in die Stichprobe aufgenommen werden, ist für jede Person gleich. Gängige statistische Verfahren basieren auf Zufallsstichproben.

- die geschichtete Stichprobe: mit Zufallsauswahl in jeder Schicht; Schichten sind vordefiniert (z.B. Bundesländer, Geschlecht, Alter).

Organisation der Daten

Für statistische Berechnungen werden die Daten in eine Datenmatrix eingefügt. Eine Datenmatrix ist die Darstellung von Daten in einer Tabelle. Die Erstellung der Datenmatrizen erfolgt entweder in eine Statistik-Software (z.B. R oder SPSS) oder in einem Tabellenkalkulationsprogramm (z.B. Excel).

In jeder Zeile befindet sich ein Merkmalsträger bzw. ein Fall. In den Spalten finden sich die Merkmale oder auch Variablen (z.B. Alter, Größe, Einkommen).

| Person | Alter | Größe | Einkommen |

|---|---|---|---|

| 1 | 24 | 1,63 | 3.250 |

| 2 | 57 | 1,55 | 0 |

| 3 | 43 | 1,80 | 2.300 |

Merkmale, die nicht in Zahlen ausdrückbar sind, wie zum Beispiel Geschlecht, Zufriedenheit mit einem Produkt, müssen umkodiert werden. Das heißt, den einzelnen Ausprägungen werden Zahlen zugeordnet. Zusätzlich gibt es eine Unterscheidung in „gültige Werte“ und „fehlende Werte“.

z.B. Variable Geschlecht

1 … Mann

2 … Frau

99 … keine Angabe/Angabe verweigert (fehlender Wert)

z.B. Zufriedenheit mit einem Produkt

1 … sehr zufrieden

2 … ziemlich zufrieden

3 … wenig zufrieden

4 … gar nicht zufrieden

99 … keine Angabe/Antwort verweigert (fehlender Wert)

Datenauswertung – Überblick über statistische Verfahren